正如我们使用 LMM 对具有相关观测值的正态数据进行建模一样,我们可以使用 GLMM 对非正态分布且具有相关观测值的数据进行建模。

响应变量通常是离散的或明显非正态的。 GLMM 允许响应数据来自指数族的任何其他分布,包括最常见的二项分布和泊松分布。因此,GLMM 是具有正态分布随机效应的广义线性模型。

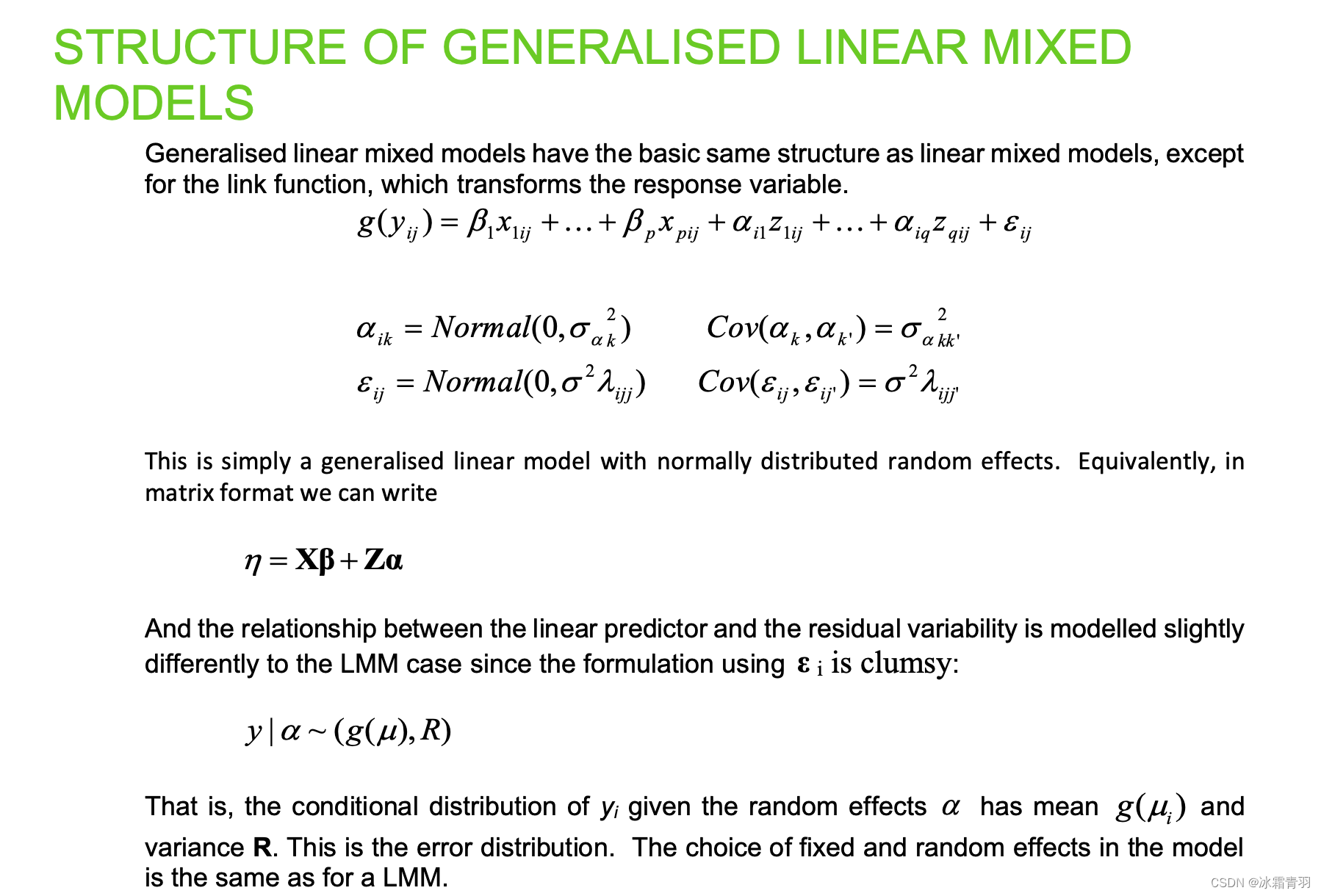

上图展示了广义线性混合模型(Generalized Linear Mixed Models, GLMMs)的结构。GLMMs是广义线性模型(GLMs)和线性混合模型(LMMs)的结合,通过引入随机效应来处理数据中的复杂依赖结构。下面我们详细解释其组成部分和工作原理。

模型结构

广义线性混合模型的基本形式可以表示为:

g ( y i j ) = β 1 x 1 i j + ⋯ + β p x p i j + α i 1 z 1 i j + ⋯ + α i q z q i j + ϵ i j g(y_{ij}) = \beta_1 x_{1ij} + \cdots + \beta_p x_{pij} + \alpha_{i1} z_{1ij} + \cdots + \alpha_{iq} z_{qij} + \epsilon_{ij} g(yij)=β1x1ij+⋯+βpxpij+αi1z1ij+⋯+αiqzqij+ϵij

其中:

y i j y_{ij} yij 是第 i i i 组第 j j j 个观测值的响应变量。

g ( ⋅ ) g(\cdot) g(⋅) 是链接函数,将响应变量的期望值转换为线性预测器。

x 1 i j , ⋯ , x p i j x_{1ij},\cdots,x_{pij} x1ij,⋯,xpij 是固定效应 的自变量。

β 1 , ⋯ , β p \beta_1,\cdots,\beta_p β1,⋯,βp 是固定效应的回归系数。

z 1 i j , ⋯ , z q i j z_{1ij},\cdots,z_{qij} z1ij,⋯,zqij 是随机效应 的自变量。

α i 1 , ⋯ , α i q \alpha_{i1},\cdots,\alpha_{iq} αi1,⋯,αiq 是随机效应的系数,假设为正态分布。

ϵ i j \epsilon_{ij} ϵij 是误差项,假设为正态分布。

随机效应和误差项

随机效应的系数 α \alpha α 和误差项 ϵ \epsilon ϵ 的分布假设如下:

α i k ∼ Normal ( 0 , σ α k 2 ) \alpha_{ik} \sim \text{Normal}(0, \sigma^2_{\alpha_k}) αik∼Normal(0,σαk2)

ϵ i j ∼ Normal ( 0 , σ 2 λ i j ) \epsilon_{ij} \sim \text{Normal}(0, \sigma^2 \lambda_{ij}) ϵij∼Normal(0,σ2λij)

它们的协方差矩阵为:

Cov ( α k , α k ′ ) = σ α k k ′ 2 \text{Cov}(\alpha_k, \alpha_{k'}) = \sigma^2_{\alpha kk'} Cov(αk,αk′)=σαkk′2

Cov ( ϵ i j , ϵ i j ′ ) = σ 2 λ i j j ′ \text{Cov}(\epsilon_{ij}, \epsilon_{ij'}) = \sigma^2 \lambda_{ijj'} Cov(ϵij,ϵij′)=σ2λijj′

矩阵形式

在矩阵形式下,模型可以表示为:

η = X β + Z α \eta = X\beta + Z\alpha η=Xβ+Zα

其中:

η \eta η 是线性预测器向量。

X X X 是固定效应的设计矩阵。

β \beta β 是固定效应的回归系数向量。

Z Z Z 是随机效应的设计矩阵。

α \alpha α 是随机效应的系数向量。

条件分布

广义线性混合模型的响应变量 y y y 的条件分布为:

y ∣ α ∼ ( g ( μ ) , R ) y\mid\alpha\sim(g(\mu),R) y∣α∼(g(μ),R)

这意味着给定随机效应 α \alpha α ,响应变量 y y y 的条件分布的均值为 g ( μ ) g(\mu) g(μ) ,方差为 R R R 。这种形式表示了模型中固定效应和随机效应的选择与线性混合模型相同。

总结

广义线性混合模型通过结合GLM和LMM的方法,引入了随机效应,使得模型能够处理更复杂的数据结构,特别是那些包含群组或层次结构的数据。理解GLMM的结构对于分析复杂数据和正确构建模型至关重要。

上图展示了如何估计广义线性混合模型(Generalized Linear Mixed Models, GLMMs)。由于GLMM需要评估高维积分,这些积分无法解析地完成,因此需要使用近似方法。在R语言中,有两种常见的近似方法:

1. 拉普拉斯近似法(Laplace Approximation)

拉普拉斯近似法是R语言中的默认方法。这个方法通过使用二阶泰勒展开式来直接近似积分。具体来说,它在积分的峰值附近进行二阶展开,以此来简化复杂的积分计算。

优点:

- 计算效率高。

- 通常对于简单的GLMM能够提供足够的精确度。

2. 自适应高斯-赫米特求积近似法(Adaptive Gauss-Hermite Quadrature Approximation, AGQ)

自适应高斯-赫米特求积法最近在R中得到了发展。这个方法比拉普拉斯近似更精确,因为它在积分计算中使用了更多的点和更复杂的权重调整。

优点:

- 精度高于拉普拉斯近似法。

缺点:

- 计算复杂度高,运行效率较低。

方法比较

对于相对简单的GLMM,使用这两种方法不会有明显的区别。通常情况下,拉普拉斯方法能够提供足够的精度,因此在大多数应用中,AGQ并不经常需要使用。

上图展示了层次广义线性模型(Hierarchical Generalized Linear Models, HGLMs)的概念和特点。HGLMs是广义线性混合模型(GLMMs)的推广,允许更灵活的随机效应分布。

HGLM的背景和动机

传统的GLMM假设随机效应总是正态分布,但这种假设并不总是最合适的。特别是,当响应变量具有非正态分布时,假设所有层次的数据只在最低层次上具有非正态分布显得不合理。因此,HGLM应运而生,提供了一种更灵活的方法来处理随机效应的分布。

HGLM的定义

HGLM通过使用h-似然(h-likelihood)作为费舍尔似然(Fisher likelihood)的扩展来定义。h-似然方法不仅应用于GLM模型,还引入了在线性预测器中的附加随机效应。通过HGLM,可以为每个随机效应定义分布,而不仅仅是残差的分布。

HGLM的优势

- 更灵活的随机效应分布:HGLM允许为每个随机效应定义不同的分布,而不仅仅局限于正态分布。这种灵活性使得模型能够更好地拟合具有复杂依赖结构的数据。

- 统一的分析框架:HGLM提供了一个统一的框架,通过h-似然方法来处理模型中的所有随机效应和残差。

HGLM与GLMM的关系

GLMM可以看作是HGLM的一个特例,其中所有随机效应都假设为正态分布。HGLM的广泛性和灵活性使得它能够覆盖更多的应用场景,但这种方法目前还不太普及,且理解和应用上也比较复杂。

实现与应用

虽然HGLM方法目前还没有广泛应用,但它为处理复杂数据提供了一种新的思路。在R语言中,目前主要的混合模型包如 lme4 主要还是使用GLMM的框架,对于HGLM的实现和应用仍在研究和发展中。

总结

HGLM作为GLMM的推广,提供了处理随机效应更灵活的方法。通过使用h-似然方法,HGLM允许为每个随机效应定义分布,而不仅仅局限于正态分布。虽然这种方法目前还未被广泛采用,但它为数据分析提供了一个更强大的工具。

理解HGLM的理论基础和应用前景,有助于研究者和数据分析师在处理复杂层次数据时,选择更加合适的模型和方法。