开源巨擘Llama 3.1崭露头角,性能卓越引发热议

在科技界的瞩目下,Llama 3.1系列模型以其卓越的性能脱颖而出,尤其是其405B超大杯版本,在微软Azure-ML GitHub平台的多项评测中展现出非凡实力,不仅超越了GPT-4o,就连70B版本也能与GPT-4o分庭抗礼。值得注意的是,这仅是base模型的初步表现,经过精细对齐训练的instruct模型预计将带来更为惊人的分数提升。

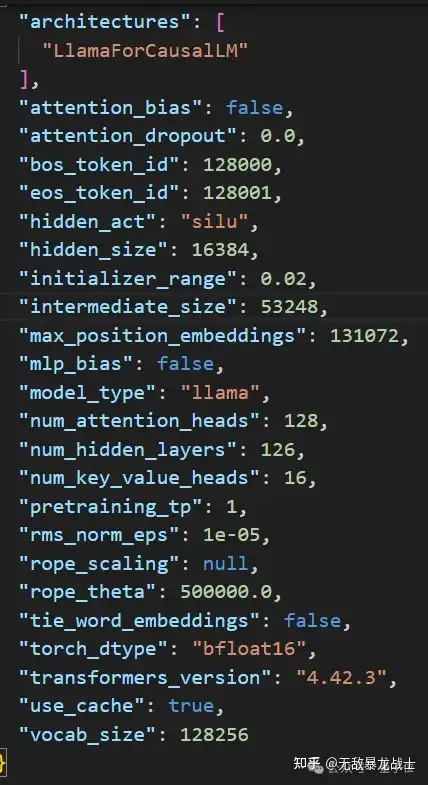

然而,近期发生的一系列泄露事件也为Llama 3.1增添了几分神秘色彩。下载链接、官方跑分结果的模型卡以及详细配置文件意外曝光,尽管尚未得到官方正式确认,但已在网络上掀起了轩然大波,激发了业界的广泛讨论与期待。

若泄露数据属实,Llama 3.1无疑将成为开源领域乃至整个AI大模型界的佼佼者,其影响力或将超越现有诸多闭源旗舰模型。

与此同时,从ICML现场传来振奋人心的消息,PyTorch创始人Soumith Chintala在演讲中正式宣布,Llama 3.1系列模型将于7月23日(北京时间7月24日)正式发布,为AI领域注入新的活力。

Llama 3.1亮点速递:

- 多语言对话优化:instruct模型针对多语言场景进行了深度优化,支持多语言文本及代码输出,满足全球用户需求。

- 上下文窗口大幅扩展:各版本模型的上下文窗口从8k激增至128K,提升了16倍,为用户提供更加流畅、连贯的对话体验。

- 海量训练资源:Llama 3.1在H100-80GB硬件上累计使用了3900万GPU时进行训练,其中405B版本独占3100万GPU时,确保了模型的强大性能。训练数据覆盖约15万亿tokens,并融入了丰富的微调数据集。

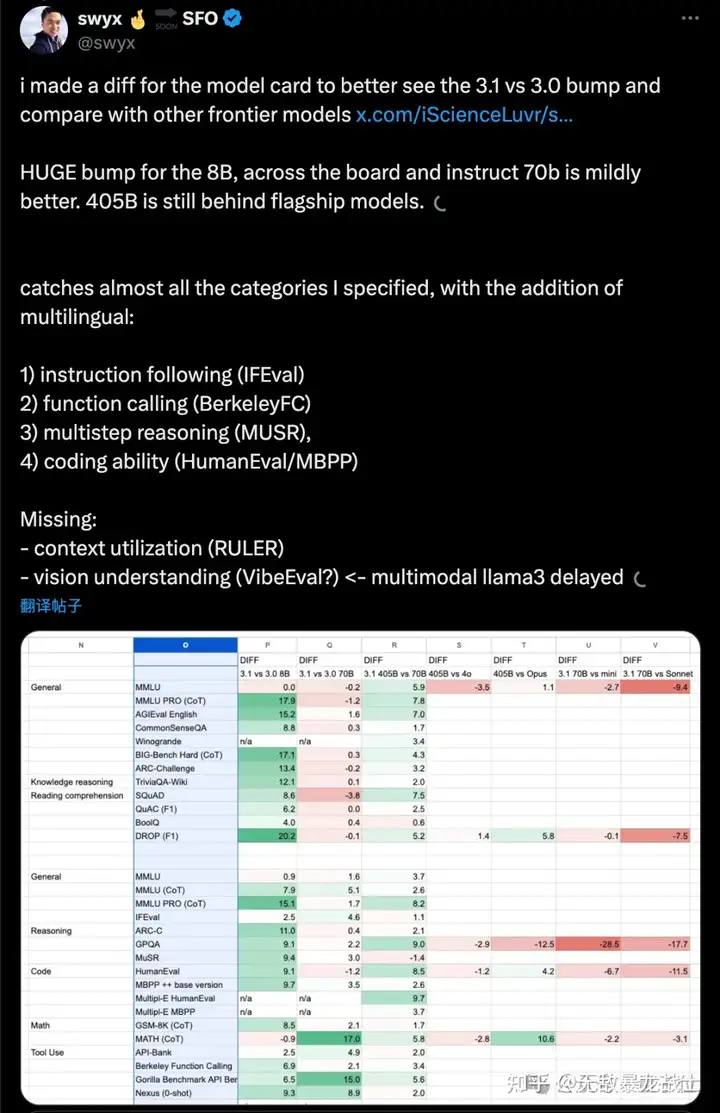

随着Llama 3.1版本的曝光,不仅405B超大杯版本备受期待,已发布的8B和70B型号也将迎来升级。Smol AI团队根据泄露版模型卡制作了对比表格,直观展示了各版本间的性能提升。特别是8B版本在更难任务上的显著提升,以及70B版本在数学和API调用方面的优势,均令人印象深刻。

此外,Llama 3.1的405B模型权重占据高达820GB硬盘空间,展示了其庞大的规模。同时,模型支持bf16原生精度,并有望推出FP8官方量化版,以减轻部署负担。

值得一提的是,Llama 3.1的新开源协议带来了重大变革,取消了禁止使用Llama 3改进其他模型的限制,鼓励开发者基于Llama进行二次创新。但同时规定,所有使用Llama输出结果进行训练的模型均需在名称中包含"Llama",以维护品牌一致性。

面对Llama 3.1的强劲挑战,OpenAI是否会推出新品以捍卫其市场地位成为业界关注的焦点。随着奥特曼个人账号的重新活跃,本周或将见证AI大模型领域的又一轮狂欢。

你好,我是lcab-ljj,如果你喜欢我的内容就点赞关注吧~我会持续为您呈上最前沿的报道,也欢迎您看看我的其他文章https://lcab-ljj.github.io/,开通GPT教程在https://lcab-ljj.github.io/2024/07/16/Fomepay/