- 发表时间:2024

- 期刊会议:arxiv

- 论文单位:Arizona State University

- 论文作者:Dawei Li, Bohan Jiang, Liangjie Huang, Alimohammad Beigi, Chengshuai Zhao, Zhen Tan, Amrita Bhattacharjee, Yuxuan Jiang, Canyu Chen, Tianhao Wu, Kai Shu, Lu Cheng, Huan Liu

- 论文链接

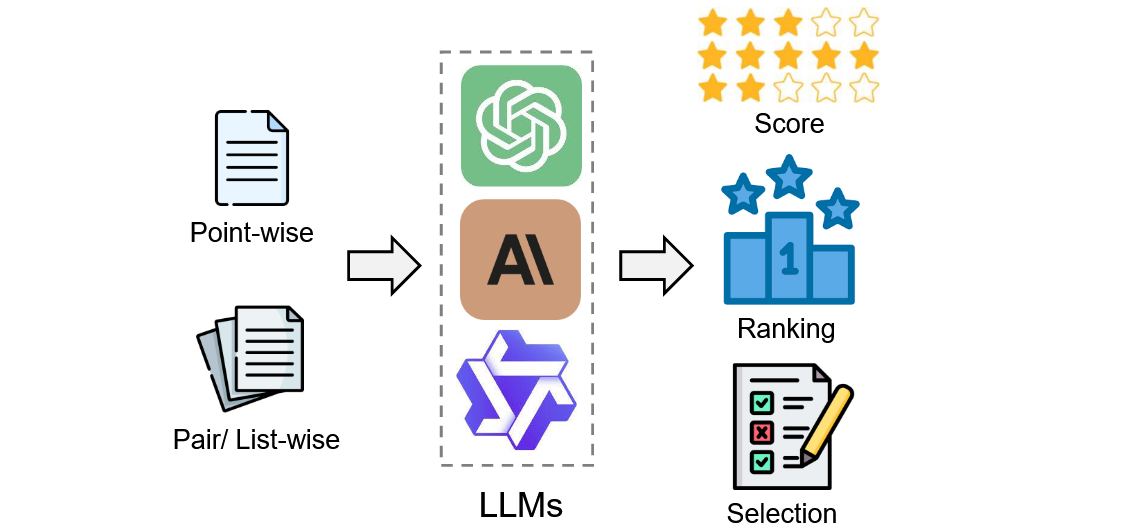

What is LLM-as-a-judge

定义:LLM-as-a-judge是指利用大型语言模型(LLM)的高级文本理解和生成能力,来评估、判断或决策特定任务或问题,类似于一个裁判在竞赛中的作用。

数学表达 :给定一名judge LLM \(J\),评估过程可以表述为:

\[R = J(C_1, \ldots, C_n) \]

这里,\(C_i\)是要判断的第\(i\)个候选,\(R\)是判断结果。

-

Input

-

Point-Wise

当n=1时,它变成了逐点判断,其中judge LLMs将只关注一个候选样本

-

Pair / List-Wise

当n≥2时,它变成pair(n=2)或list(n>2)判断,其中多个候选样本一起提供给judge LLM进行比较并做出综合评估

-

-

Output

-

Score

当每个候选样本被分配一个连续或离散的分数:\(R=\{C1:S1,...,Cn:Sn\}\)时,它就变成了基于分数的判断,这是最常见和最广泛使用的协议

-

Ranking

在基于排序的判断中,输出是每个候选样本的排序,表示为\(R=\{Ci>...>Cj\}\),这种比较方法在需要在候选人之间建立排名顺序的情况下非常有用

-

Selection

在基于选择的判断中,输出涉及选择一个或多个最佳候选,表示为\(R=\{Ci,...,Cj\}>\{C1,...Cn\}\),这种方法在决策或内容过滤环境中特别有用

-

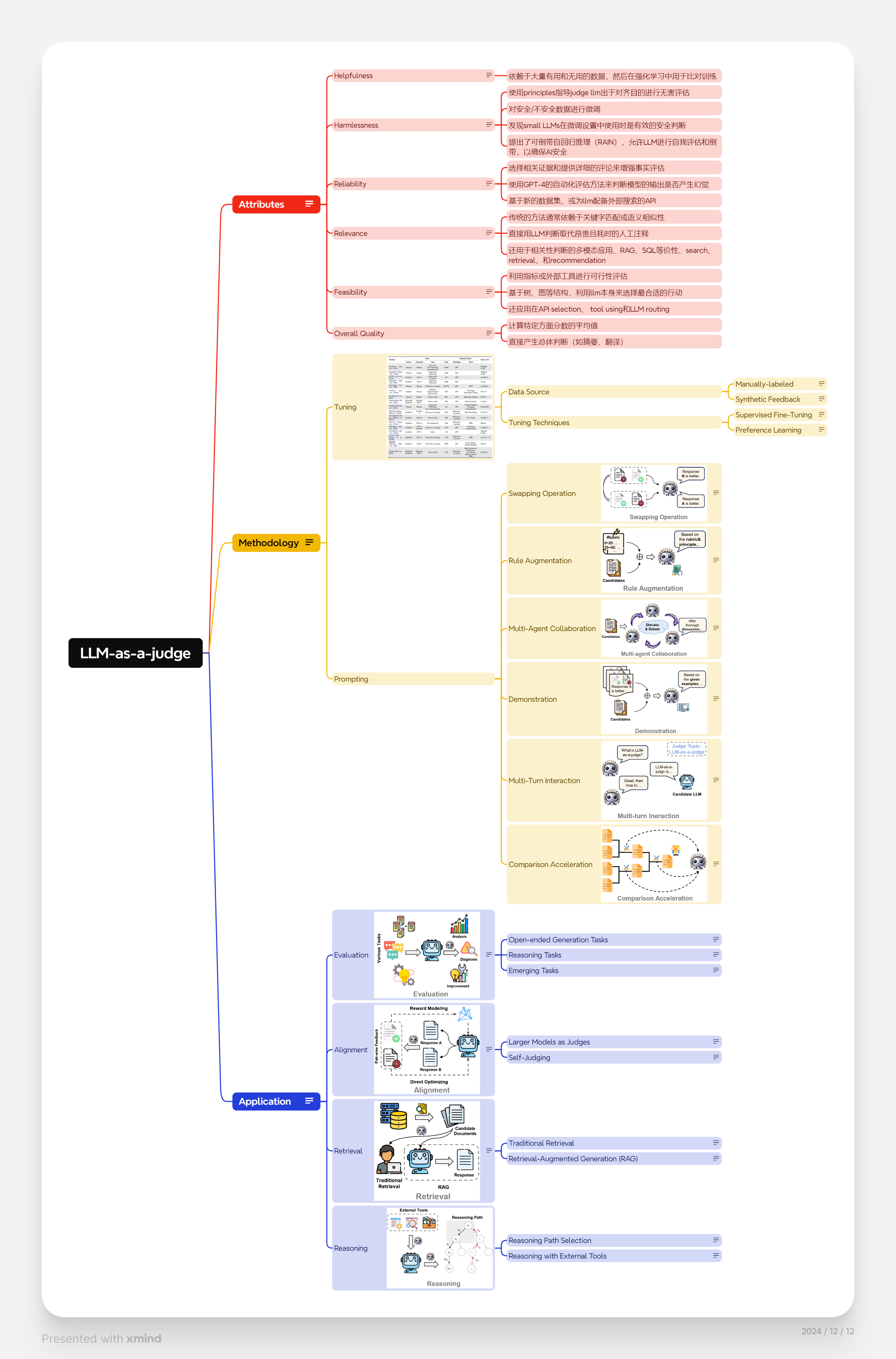

Taxonomy of research in LLM-as-a-judge

Attributes

What to judge? We delve into specific attributes assessed by the judge LLMs, including helpfulness, harmlessness, reliability, relevance, feasibility and overall quality.

Helpfulness

这一维度评估模型生成的响应是否对用户有帮助。换句话说,模型的回答是否能有效解决用户的问题或满足用户的需求。

- 依赖于大量有用和无用的数据,然后在强化学习中用于比对训练

Harmlessness

无害性指的是模型的回答是否避免产生负面影响或不良后果。模型应避免提供冒犯性的、误导性的信息或可能导致危险行为的建议。

-

使用principles指导judge llm出于对齐目的进行无害评估

-

对安全/不安全数据进行微调

-

发现small LLMs在微调设置中使用时是有效的安全判断

-

提出了可倒带自回归推理(RAIN),允许LLM进行自我评估和倒带,以确保AI安全

Reliability

可靠性评估模型生成的内容是否准确和可信。这包括信息的真实性、准确性以及模型在回答问题时的一贯性。

-

选择相关证据和提供详细的评论来增强事实评估

-

使用GPT-4的自动化评估方法来判断模型的输出是否产生幻觉

-

基于新的数据集、或为llm配备外部搜索的API

Relevance

相关性考察模型的回答是否与用户提出的问题直接相关。模型应避免偏离主题或提供不相关的信息。

-

传统的方法通常依赖于关键字匹配或语义相似性

-

直接用LLM判断取代昂贵且耗时的人工注释

-

还用于相关性判断的多模态应用、RAG、SQL等价性、search、retrieval、和recommendation

Feasibility

可行性衡量的是模型建议的实际可行性。也就是说,模型提供的解决方案或建议是否在现实世界中可行或可执行。

-

利用指标或外部工具进行可行性评估

-

基于树、图等结构,利用llm本身来选择最合适的行动

-

还应用在API selection、 tool using和LLM routing

Overall Quality

整体质量是一个综合性的指标,它通常基于多个具体维度的表现来衡量模型生成内容的总体优劣。

-

计算特定方面分数的平均值

-

直接产生总体判断(如摘要、翻译)

Methodology

Methodology: How to judge? We explore various tuning and prompting techniques for LLMas-a-judge systems, including manually-labeled data, synthetic feedback, supervised fine-tuning, preference learning, swapping operation, rule augmentation, multi-agent collaboration, demonstration, multi-turn interaction and comparison acceleration.

Tuning

-

Data Source

-

Manually-labeled

手动标记的数据:要用类似人类的标准训练法官LLM,一种直观的方法是收集手动标记的样本和相应的判断。

-

Synthetic Feedback

虽然手动标记的反馈是高质量的,并且准确地反映了人类的判断偏好,但它在数量和覆盖范围方面存在局限性。因此,一些研究人员转向综合反馈作为调整法官法学硕士的数据源。

-

-

Tuning Techniques

-

Supervised Fine-Tuning

Supervised fine-tuning (SFT) is the most commonly used approach to facilitate the judge LLMs to learn from pairwise or pointwise judgment data.

-

Preference Learning

Preference learning is closely aligned with judgment and evaluation tasks, especially comparative and ranking judgment. In addition to works that directly adopt or augment preference learning datasets for supervised finetuning judge LLMs, several studies apply preference learning techniques to enhance LLMs' judging capabilities.

-

Prompting

-

Swapping Operation

先前的研究表明,基于LLMbased的法官对候选人的位置很敏感,候选人回答的质量排名可以很容易地通过改变他们在上下文中的顺序来操纵。为了减轻这种位置偏差并建立一个更公平的LLM判断系统,交换操作已被引入并广泛采用。该技术涉及调用judge LLM两次,在每个实例中交换两个候选的顺序。在评估中,如果交换后结果不一致,则被标记为"平局",表明LLM无法自信地区分候选人的质量。

-

Rule Augmentation

规则增强提示包括嵌入一组原则、参考和评估规则直接在LLM法官的提示内。这种方法通常用于基于法学硕士的评估,以便更精确和有方向地比较两个候选人。

-

Multi-Agent Collaboration

由于法学硕士固有的各种偏见,从单个法学硕士法官那里获取结果可能不可靠。为了解决这一限制,引入了对等排名(PR)算法,该算法考虑每个对等LLM对所有答案对的成对偏好,并产生模型的最终排名。

-

Demonstration

情境样本或演示为法学硕士提供了具体的例子,并已被证明是法学硕士情境学习成功的关键因素。一些研究引入了人类评估结果作为法学硕士作为法官的演示,旨在指导法学硕士从一些具体的上下文示例中学习评估标准。

-

Multi-Turn Interaction

在评估中,单一的回答可能无法为LLM法官提供足够的信息来彻底和公平地评估每个候选人的表现。为了解决这一限制,通常采用多回合交互来提供更全面的评估。通常,该过程从初始查询或主题开始,然后是judge LLM和候选模型之间的动态交互。

-

Comparison Acceleration

在LLM-asa-judge中的各种比较格式(例如,Point-wise和Pair-wise)中,成对比较是直接比较两个模型或生成成对反馈的最常见方法。然而,当需要对多个候选人进行排名时,这种方法可能非常耗时。为了减轻计算开销,Zhai等人提出了一种排序配对方法,其中首先将所有候选对象与空白基线响应进行比较。然后,每个候选人的排名由他们与基线相比的表现来确定。

Application

Application: Where to judge? We investigate the applications in which LLM-as-a-judge has been employed, including evaluation, alignment, retrieval and reasoning.

Evaluation

NLP中的传统评估依赖于预定义的标准,通常通过度量来评估机器生成文本的质量。一些突出的指标,如BLEU、ROUGH和BERTScore已在该领域广泛使用。然而,基于度量的评估过分强调了词汇重叠和相似性,当需要考虑许多有效响应和更细微的语义属性时,这可能会有所欠缺。为了解决这些限制,LLM作为法官能够进行类似人类的定性评估,而不是简单的定量比较机器生成的输出与基本事实的匹配程度。

-

Open-ended Generation Tasks

开放式生成指的是这样的任务:生成的内容应该是安全、准确的,并且与上下文相关,尽管没有一个"正确"的答案。这些任务包括对话响应生成、总结、故事生成和创造性写作。

-

Reasoning Tasks

法学硕士的推理能力可以通过他们的中间思维过程和特定推理任务的最终答案来评估。最近,LLM-as-a-judge已被用于评估模型中间推理路径的逻辑进展、深度和连贯性。对于数学推理任务,Xia等人引入了一个自动评估框架,使用judge LLM,专门用于评估问题解决过程中推理步骤的质量。

-

Emerging Tasks

随着LLM能力的快速发展,机器越来越多地被用于以前被认为是人类独有的任务,尤其是在特定环境的领域。一个突出的任务是社会智能,其中模型呈现复杂的社会场景,需要理解文化价值观、伦理原则和潜在的社会影响。另一条研究方向是评估大型多模态模型(LMM)和大型视觉语言模型(LVLM)。最近,我们看到更多定制化地使用法学硕士作为法官来评估新兴任务,如代码理解、法律知识、游戏开发、海洋科学、医疗保健对话、辩论判断、检索增强生成等等。

Alignment

对于大语言模型,语言建模目标通过单词预测来预训练模型参数,而缺乏对人类价值观或偏好的考虑。为了避免这些意想不到的行为,有人提出了人类对齐以使大语言模型的行为符合人类的期望。然而,与最初的预训练和适应调优(例如,指令调优)不同,这种对齐需要考虑非常不同的标准(例如,乐于助人、诚实和无害)。已经表明alignment可能会在一定程度上损害大语言模型的综合能力,相关文献中称之为alignment tax。

Aligenment tuning是将LLM与人类偏好和价值观结合起来的重要技术。这一过程的一个关键组成部分是从人类收集高质量的成对反馈,这对于奖励建模或直接偏好学习至关重要。

-

Larger Models as Judges

在对齐调整中采用LLM作为判断的一个直观想法是利用来自更大、更强大的LLM的反馈来指导更小、能力较差的模型。Bai等人首次提出利用人工智能的反馈来构建无害的人工智能助手。他们使用基于预训练语言模型偏好的合成偏好数据来训练奖励模型。

-

Self-Judging

另一项工作旨在利用来自同一LLM的偏好信号进行自我改进。Yuan等人首先提出了自我奖励LLM的概念,其中通过让LLM本身作为判断来构建成对数据。

Retrieval

LLM作为法官在检索中的作用包括传统的文档排序和更动态的、上下文自适应的检索增强生成(RAG)方法。在传统检索中,LLM通过先进的提示技术提高了排名准确性,使它们能够用最少的标记数据按相关性对文档进行排序。作为补充,RAG框架利用法学硕士的能力,根据检索到的信息生成内容,支持复杂或不断发展的知识集成至关重要的应用程序。

-

Traditional Retrieval

最近的研究探索了法学硕士在信息检索中作为文档排序法官的作用,旨在提高排序精度并减少对大量训练数据的依赖。比如Sun等人探索了GPT-4等生成式法学硕士在信息检索中相关性排名的潜力。他们提出了一种基于排列的方法,通过相关性对段落进行排名,指示LLM输出段落的有序排列,从而提高排名精度。

-

Retrieval-Augmented Generation (RAG)

检索增强生成(RAG)的最新发展探索了LLM在不需要注释数据集或参数调整的情况下自我评估和自我改进的能力。Li and Qiu介绍了思维记忆(MoT)框架,这是一个两阶段的自我反思模型,可以自主增强法学硕士的推理能力。在第一阶段,模型在未标记的数据集上生成高置信度推理,并将其存储为内存。在测试阶段,模型通过判断它们中的每一个与当前问题的相关性来回忆这些记忆,并选择最相关的作为演示。

Reasoning

-

Reasoning Path Selection

魏等人引入了思维链(CoT)提示的概念,以鼓励模型生成逐步的推理过程。而其他更复杂的认知结构已经被提出来提高法学硕士的推理能力,一个关键的挑战是如何选择一个合理可靠的推理路径或轨迹供法学硕士遵循。为了解决这个问题,LLM-asa-judge已经被许多作品采用。

-

Reasoning with External Tools

Yao et al. (2023b) first propose to use LLMs in an interleaved manner to generate reasoning traces and task-specific actions. Reasoning traces help the model to judge and update action plans, while actions enable it to interact with external sources. Further, Auto-GPT was introduced by (Yang et al., 2023) to deliver more accurate information with LLM-as-a-judge for tool-using. By equipping with a range of external complex tools, LLMs become more versatile and capable, improving planning performance by judging and reasoning which tools to use. Sha et al. (2023) explore LLMs' potential in reasoning and judging, employing them as decisionmaking components for complex autonomous driving scenarios that require human commonsense understanding. Zhou et al. (2024b) utilize a selfdiscovery process where LLMs perform judgment based on the given query and select the most feasible reasoning structure for the following inference stage.

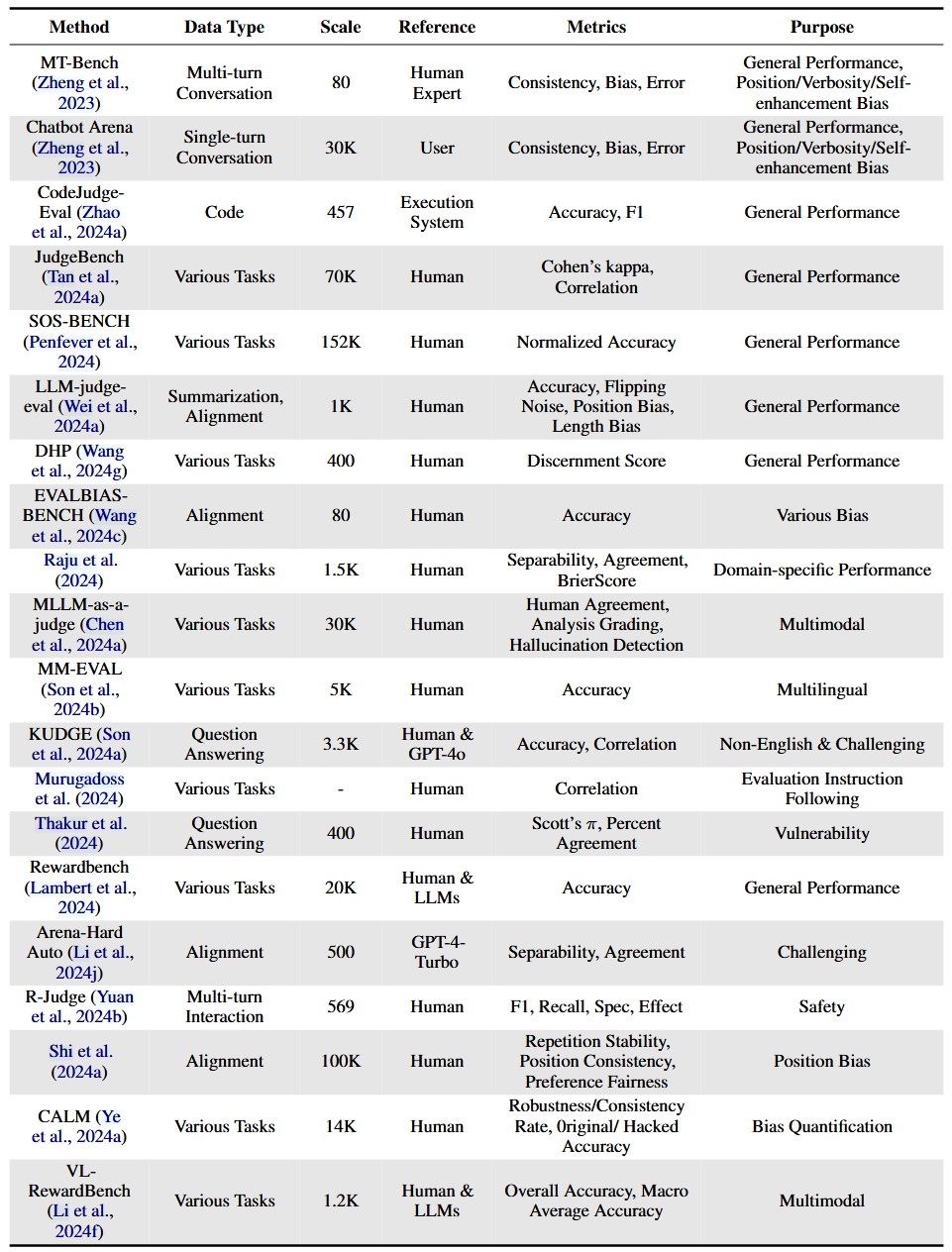

Benchmark: Judging LLM-as-a-judge

(1)General Performance

侧重于总体绩效的基准旨在评估法学硕士在各种任务中的整体能力。这些基准通常衡量与人类判断的一致性、准确性和相关性。

(2)Bias Quantification

减少LLM判断中的偏见对于确保公平性和可靠性至关重要。典型的基准包括EVALBIAS-BENCH(Wang等人,2024c)和CALM(Ye等人,2024a),明确侧重于量化偏差,包括在对抗条件下从比对和稳健性中出现的偏差。此外,石等人。(2024a)评估问答任务中的位置偏差和百分比一致性等指标。

(3)Challenging Task Performance、

为困难任务设计的基准推动了LLM评估的边界。例如,Arena-Hard Auto(Li等人,2024j)和JudgeBench(Tan等人,2024a)分别根据LLM在会话QA和各种推理任务中的表现选择更难的问题。CALM(Ye等人,2024a)探索了对齐和具有挑战性的场景,使用可分离性、一致性和被黑客攻击的准确性等指标来评估手动识别的硬数据集中的性能。

(4)Domain-Specific Performance

特定领域的基准提供以任务为中心的评估,以评估法学硕士在专门环境中的有效性。具体来说,Raju等人。(2024)衡量跨任务的可分离性和一致性,利用Brier分数等指标来洞察编码、医学、金融、法律和数学等特定领域。CodeJudgeEval(赵等人,2024a)专门评估LLM,用于通过以执行为中心的指标(如准确性和F1分数)来判断代码生成。这一思想也被以下几项代码总结和生成评估工作所采用(Wu et al.,2024b;Yang et al.,2024;Tong and Zhang,2024)

(5)Other Evaluation Dimensions

除了一般绩效和偏差量化之外,几个基准还解决了评估使用法学硕士作为法官的特定方面所必需的额外评估维度。

Challenges & Future Works

Bias & Vulnerability

使用LLM作为judge本质上将评估框定为一项生成任务,带来了与偏见和脆弱性相关的重大挑战。这些偏见通常源于模型的训练数据,这些数据经常嵌入与种族、性别、宗教、文化和意识形态等人口身份相关的社会刻板印象。当LLM被部署用于不同的判断任务时,这种偏差会显著损害公平性和可靠性。

Bias

(1)Order Bias是一个突出的问题,候选人的顺序影响偏好。这种偏差会扭曲评估结果,特别是在成对比较中,当竞争反应之间的质量差距很小时,这种偏差会更加明显。

(2)当LLM倾向于由同一模型生成的输出,损害客观性时,就会出现Egocentric Bias。当使用相同的模型设计评估指标时,这个问题尤其明显,导致原始模型输出的分数过高。

(3)Length Bias是另一个普遍的挑战,它通过不成比例地偏爱更长或更短的反应而扭曲了评估。

(4)其他bias,使LLM评估进一步复杂化。例如,Misinformation Oversight Bias 反映了忽视事实错误的倾向,Authority Bias ,倾向于来自感知权威来源的陈述,Beauty Bias 优先考虑视觉上吸引人的内容而不是实质性质量,Verbosity Bias 表现出对更长解释的偏好,通常将冗长等同于质量,这可能会误导判断过程,此外,Sentiment Bias扭曲了基于情绪语气的评估,有利于积极措辞的反应。

Vulnerability

(1)LLM judges也极易受到adversarial manipulations。例如JudgeDeceiver这样的技术强调了基于优化的提示注入攻击带来的风险,其中精心制作的对抗性序列可以操纵LLM判断以支持特定的响应。

Existing Solution

为了解决这些偏见和脆弱性,CALM(Ye等人,2024a)和BWRS(Gao等人,2024b)等框架为偏见量化和缓解提供了系统的方法。多证据校准(MEC)、平衡位置校准(BPC)和人在回路校准(HITLC)等技术已被证明可以有效地将模型判断与人类评估保持一致,同时减少位置和其他偏差(Wang等人,2023c)。此外,像COBBLER这样的认知偏差基准已经确定了六种关键偏差,包括显著偏差和跟风效应,需要在LLM评估中进行系统缓解(Koo等人,2023b)。

Future Direction

(1)一个有希望的方向是将检索增强生成(RAG)框架集成到LLM评估过程中(Chen等人,2024d)。通过结合生成和检索能力,这些框架可以通过将评估建立在外部、可验证的数据源中来减少偏见,如自我偏好和事实问题。

(2)另一个有前途的途径是使用偏见感知数据集,如OFFSETBIAS,来系统地解决LLM作为法官系统中的固有偏见(Park等人,2024)。将这样的数据集整合到训练管道中可以让法学硕士更好地区分表面质量和实质正确性,从而增强公平性和可靠性。以JudgeLM框架为例,探索微调的法学硕士作为可扩展的法官,代表了另一个有趣的方向。

(3)此外,advancing zeroshot comparative assessment frameworks提供了巨大的前景(Liusie等人,2023)。这些框架可以完善成对比较技术并实施去偏策略,提高不同评估领域的公平性和可靠性,而无需大量的即时工程或微调。

(4)最后,像JudgeDeceiver-resistant calibration 和adversarial phrase detection strategies这样的方法需要进一步探索,以保护LLM-as-a-judge框架免受攻击。

Dynamic & Complex Judgment

早期关于LLM作为judge的工作通常采用静态和直接的方法,直接提示法官LLM进行评估。最近,已经提出了更动态和复杂的判断流水线来解决各种限制,提高了LLM-as-ajudge的鲁棒性和有效性。

Existing Solution

(1)方向上的一种方法是遵循"LLM-as-a-examiner"的概念,其中系统根据候选的LLMs的表现动态和交互式地生成问题和判断。其他工作侧重于根据两个或更多候选法学硕士的战斗和辩论结果做出判断。这些动态判断方法在很大程度上提高了法官LLM对每个候选人的理解,并潜在地防止了数据污染问题在LLMs的评估中。

(2)此外,构建复杂和复杂的判断管道或代理是另一个热门的研究领域。这些方法通常涉及多智能体协作,以及精心设计的规划和记忆系统,使法官LLM能够处理更复杂和多样的判决场景。

Future Direction

(1)一个有希望的方向是让LLM具备类似人类的判断能力。这些设计在做出判断时可以借鉴人类行为的见解,如anchoring and comparing, hindsight and reflection, and meta-judgment。

(2)另一个有趣的途径是使用LLM开发一个adaptive difficulty assessment system。该系统将根据考生当前的表现调整问题的难度。这种自适应和动态系统可以解决LLM评估中的一个重大限制,因为静态基准通常无法准确评估具有不同能力的LLM。

Self-Judging

基于LLM的评估器,如GPT-4,被广泛用于评估输出,但面临重大挑战。

(1)特别是Egocentric Bias,其中模型更喜欢自己的响应而不是来自外部系统的响应。这种自我偏好破坏了公正性,并造成了"先有鸡还是先有蛋"的困境:强大的评估者对于发展强大的LLM至关重要,但推进LLM取决于公正的评估者。

(2)其他问题包括Self-Enhancement Bias ,其中模型高估了自己的输出,以及Reward Hacking,其中特定信号的过度优化导致评估不太通用。

(3)此外,对Static Reward Models 的依赖限制了适应性,而Positional and Verbosity Biases等偏差通过偏爱反应顺序或长度而不是质量来扭曲判断。

(4)人类注释的高成本和有限的可扩展性使动态和可靠的评估系统的创建进一步复杂化。

Future Direction

(1)未来研究的一个有希望的方向是开发协作评估框架,如Peer Rank and Discussion (PRD)。这些框架利用多个法学硕士来集体评估输出,使用加权成对判断和多回合对话来减少自我增强偏差,并使评估更接近人类标准。

(2)另一个有趣的途径是采用adoption of Self-Taught Evaluator frameworks,它生成合成偏好对和推理跟踪,以迭代地完善模型评估能力。这种方法消除了对昂贵的人工注释的依赖,同时确保评估标准适应不断发展的任务和模型。

(3)**Self-Rewarding Language Models (SRLM)**的整合提供了另一条有前途的道路。通过采用直接偏好优化(DPO)等迭代机制,这些模型不断提高其指令遵循和奖励建模能力,缓解奖励黑客和过度拟合等问题。

(4)在SRLM的基础上,Meta-Rewarding机制的使用引入了元法官角色来评估和完善判断质量。这种迭代过程解决了诸如冗长和位置偏差等偏差,增强了对齐和评估复杂任务的能力。

(5)最后,利用合成数据创建来生成对比响应为培训评估者提供了一个可扩展的解决方案。通过迭代地细化对合成偏好对的评估,模型可以逐步提高它们的鲁棒性和适应性。将这些方法与不同的基准相结合、多方面的评价标准、人类反馈可以确保评估是公平、可靠的,并符合人类在各个领域的期望。

Human-LLMs Co-judgement

如前所述,LLM-as-a-judge中的偏见和脆弱性可以通过人工参与判断过程来解决,以进行进一步的干预和校对。然而,只有少数研究关注这种方法。

Existing Solution

(1)Wang等人(2023c)引入了human-in-the-loop calibration,它采用平衡的位置多样性熵来测量每个示例的难度,并在必要时寻求人工帮助。

(2)在相关性判断的背景下,Faggioli等人(2023)提出了一种human-machine collaboration spectrum,根据人类对机器的依赖程度对不同的相关性判断策略进行分类。

Future Direction

(1)随着data selection(Xie等人,2023;Albalak等人,2024)成为提高LLM训练和推理效率的越来越受欢迎的研究领域,它也有可能增强LLM的评估。LLMas-a-judge可以从数据选择中获得洞察力,使judge LLMs能够充当关键样本选择器,根据特定标准(例如,代表性或难度)为人类注释者选择一小部分样本进行评估。

(2)此外,人类-LLM共同判断的发展可以受益于其他领域成熟的人类在环解决方案,如数据注释(Tan等人,2024b)和主动学习(Margatina等人,2023)。