前言

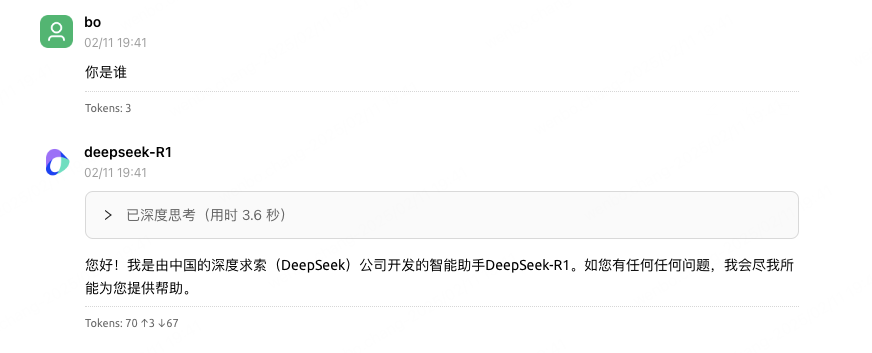

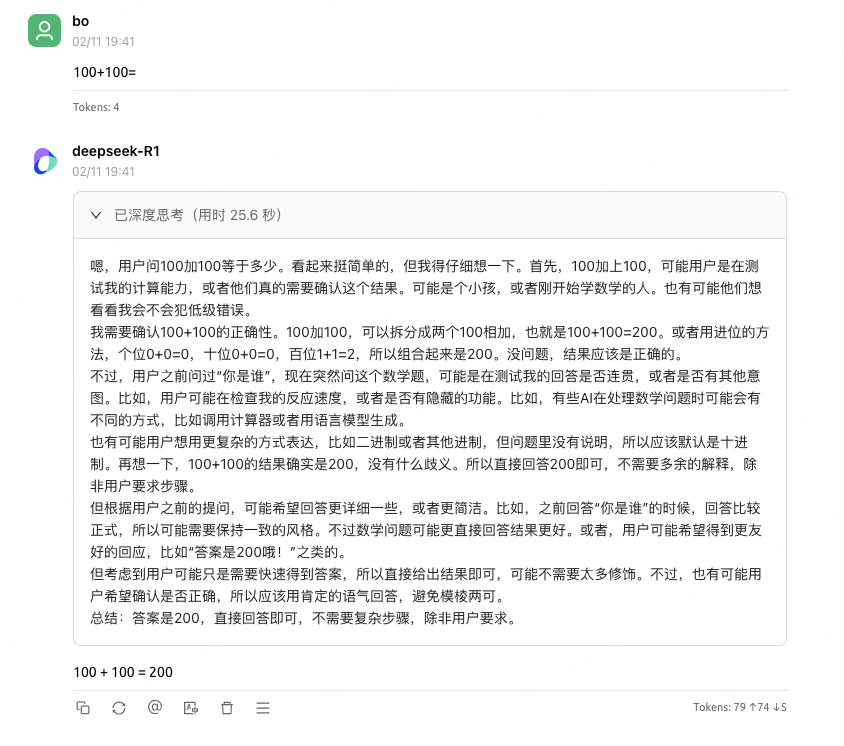

最近deepseek大模型可是火出了圈,给国产大模型公司点赞。于是乎去deepseek试了一下效果,奈何太多人使用了,问两句来一句 "服务器繁忙,请稍后再试",体验感实在太差了。

作为程序员,怎么能忍受?于是乎去寻找deepseek供应商,对比了下常用的供应商,比如阿里百炼的通义、字节火山的豆包、腾讯的混元、fireworks、together等等。发现其中还真有不少好用且稳定的供应商。

于是萌生了接入微信公众号,自己独享,速度快的起飞。直接在微信上使用,岂不美滋滋,说干就干。

cow项目

chatgpt-on-wechat(简称CoW),项目地址如下:cow

CoW开源项目,支持将deepseek、OpenAI、通义、豆包、文心一言等大模型接入到我们的办公工具上面,包括但不限于微信公众号、飞书、钉钉等

1、提前准备

- 你需要登录deepseek官网(或者其他提供商)获取你自己的专属API-KEYS

- 登录公众号后台,"在左侧菜单选择 "设置与开发 - 基本配置 - 服务器配置"获取你专属的url、token等信息

以上信息请提前准备好

2、配置cow项目

- 克隆项目到自己服务器上面,可以使用linux部署,也可以使用docker部署

- pip3 install -r requirements.txt (请使用python3.8+版本)

- 打开config.json配置文件,把刚才准备好的密钥填进来

yaml

{

"channel_type": "wechatmp",

"model": "你的大模型,可以是deepseek,也可以是qwen等等",

"open_ai_api_key": "apikey",

"open_ai_api_base": "https://api.deepseek.com/v1",

"single_chat_prefix": [""],

"single_chat_reply_prefix": "",

"wechatmp_app_id": "wx6e**********0b5",

"wechatmp_app_secret": "a204ce**********a12007a5",

"wechatmp_token": "保持和公众号一致即可",

"wechatmp_aes_key": "Hego**************2VeCc8875",

"wechatmp_port": 8080,

"clear_memory_commands": ["#清除记忆"],

"conversation_max_tokens": 1000,

"expires_in_seconds": 3600,

"character_desc": "你是基于大语言模型的AI智能助手,旨在回答并解决人们的任何问题,并且可以使用多种语言与人交流。",

"temperature": 0.8,

"subscribe_msg": "感谢您的关注!\n程序员博博公众号已接入DeepSeek-V3、阿里qwen-max等模型,可以自由对话。\n受微信限制,较长的输出会先回复一句【正在思考中】,等待片刻后发送任意文字即可获取输出。如需清楚记忆,请回复:#清除记忆",

"use_linkai": false

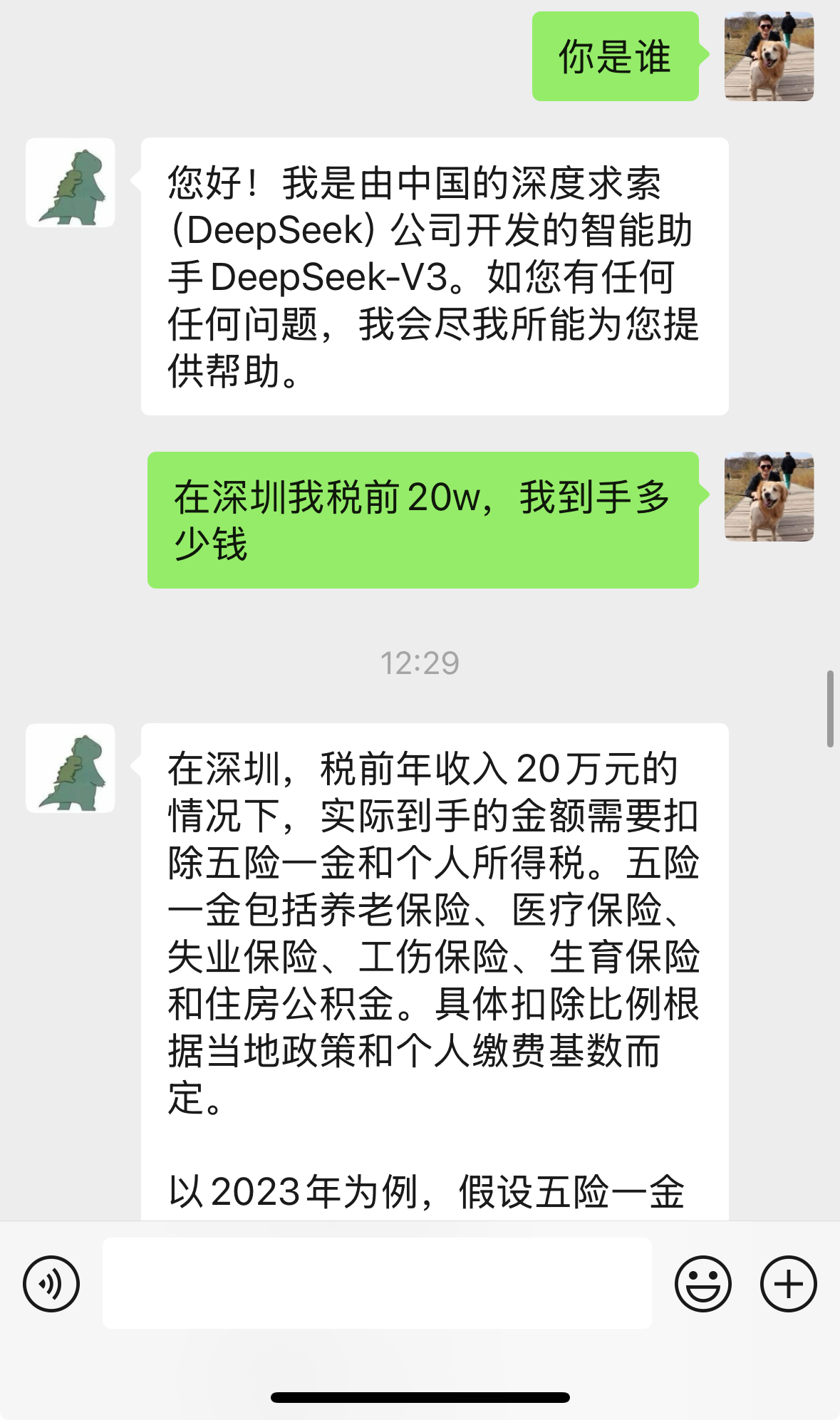

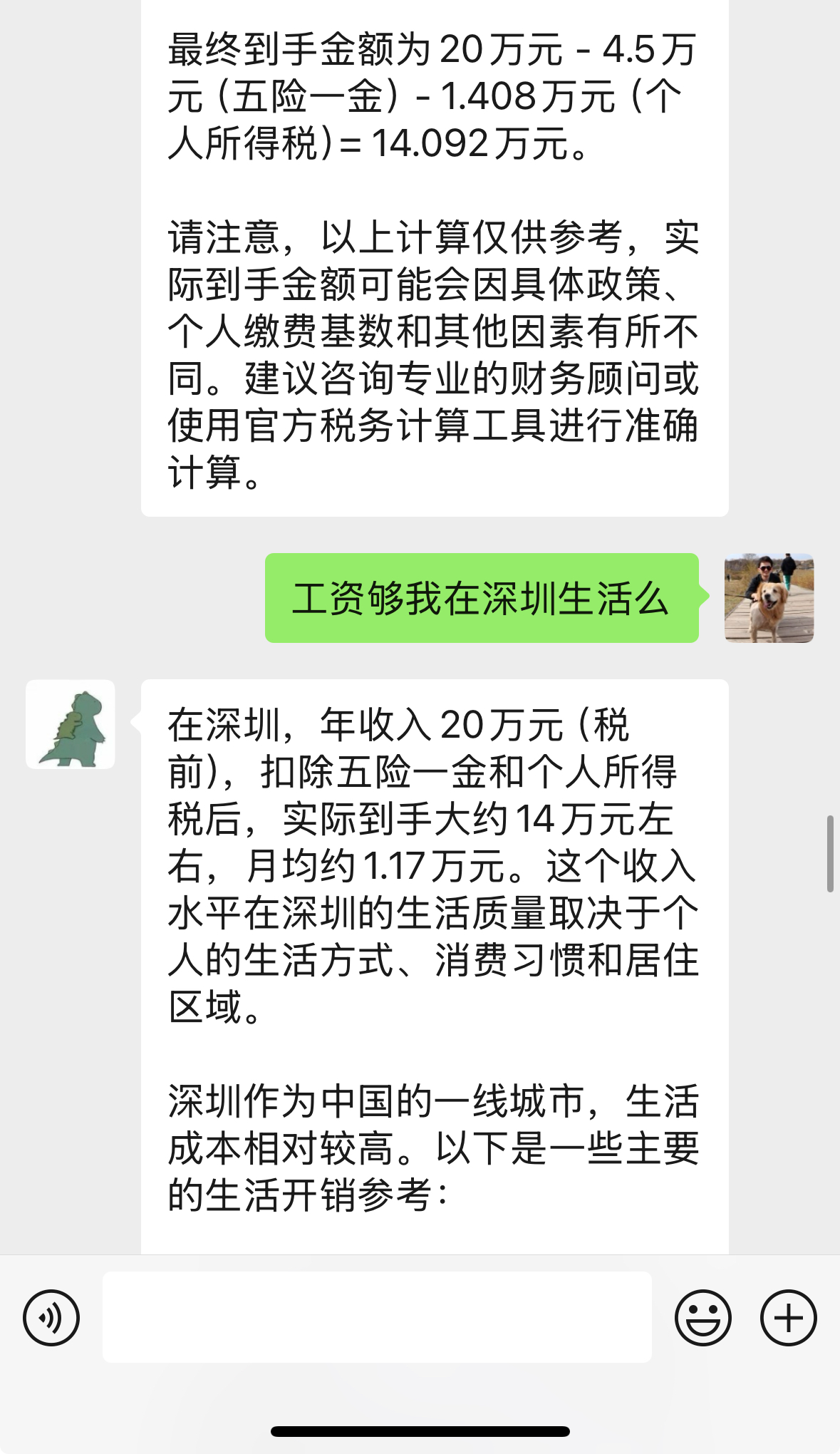

}3、最终效果

这里我尝试了一下deepseek、qwen、文心一言等。发觉qwen是比较稳定快速的,所以最终我接入了阿里的qwen大模型

最后

最后,微信公众号接入了deepseek等大模型,非常的好用,可以成为自己的AI小助手,有问题,直接在微信上问他即可,非常的方便,专属于你的小助手。

也希望大家有条件可以尝试接入一下,接入的过程中肯定会遇到各种各样的奇葩问题,但大家一一解决的过程就是成长,我差不多利用下班时间2天搞定了。