title: 异步日志分析:MongoDB与FastAPI的高效存储揭秘

date: 2025/05/22 17:04:56

updated: 2025/05/22 17:04:56

author: cmdragon

excerpt:

MongoDB与FastAPI集成构建日志分析系统,通过Motor驱动实现异步操作,提升数据处理效率。使用Pydantic进行数据验证,配置环境变量,创建REST API端点。聚合管道用于日志统计,如按级别分组计数。索引优化策略通过创建复合索引和文本索引,显著提升查询性能。完整案例实现错误追踪和日志搜索功能。常见报错包括422验证错误和连接超时,提供具体解决方案。课后Quiz强调索引优化、高效分页和写入可靠性。

categories:

- 后端开发

- FastAPI

tags:

- MongoDB

- FastAPI

- 日志分析

- 异步编程

- 聚合管道

- 索引优化

- 错误处理

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

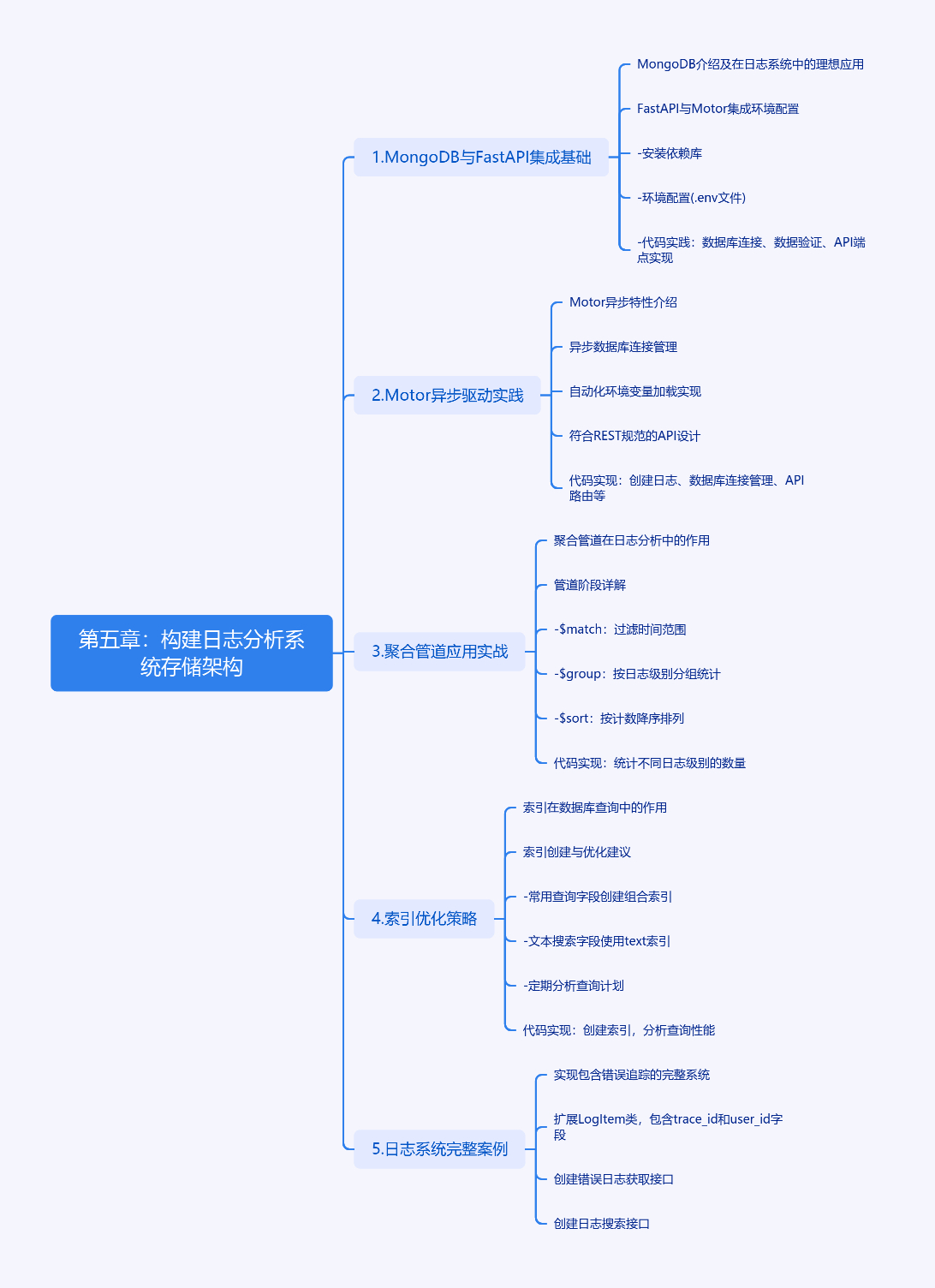

第五章:构建日志分析系统存储

1. MongoDB与FastAPI集成基础

MongoDB的非结构化数据存储特性使其成为日志系统的理想选择,如同收纳不同形状物品的智能储物柜。在FastAPI中,我们通过Motor驱动实现异步操作,这种组合就像为数据传输装上了涡轮增压引擎。

安装依赖库:

bash

pip install fastapi==0.103.2 motor==3.3.2 pydantic==2.5.3 python-dotenv==1.0.0环境配置(.env文件):

env

MONGODB_URL=mongodb://localhost:27017

DB_NAME=logs_db2. Motor异步驱动实践

Motor的异步特性如同高速公路上的应急车道,确保主线程畅通无阻。以下代码展示了高效连接方式:

python

from fastapi import FastAPI

from motor.motor_asyncio import AsyncIOMotorClient

from pydantic import BaseModel

import os

from dotenv import load_dotenv

load_dotenv()

app = FastAPI()

class LogItem(BaseModel):

level: str

message: str

timestamp: str

source: str

@app.on_event("startup")

async def startup_db_client():

app.mongodb_client = AsyncIOMotorClient(os.getenv("MONGODB_URL"))

app.mongodb = app.mongodb_client[os.getenv("DB_NAME")]

@app.on_event("shutdown")

async def shutdown_db_client():

app.mongodb_client.close()

@app.post("/logs/")

async def create_log(log: LogItem):

log_dict = log.model_dump()

result = await app.mongodb.logs.insert_one(log_dict)

return {"id": str(result.inserted_id)}此代码实现了:

- 使用Pydantic进行数据验证

- 异步数据库连接管理

- 自动化的环境变量加载

- 符合REST规范的API端点

3. 聚合管道应用实战

聚合管道如同数据加工流水线,这是分析日志的关键工具。以下示例统计不同日志级别的数量:

python

@app.get("/logs/stats/level")

async def get_log_level_stats():

pipeline = [

{"$match": {"timestamp": {"$gte": "2024-01-01"}}},

{"$group": {

"_id": "$level",

"count": {"$sum": 1},

"last_occurrence": {"$last": "$timestamp"}

}},

{"$sort": {"count": -1}}

]

results = []

async for doc in app.mongodb.logs.aggregate(pipeline):

results.append({

"level": doc["_id"],

"count": doc["count"],

"last_occurred": doc["last_occurrence"]

})

return results管道阶段说明:

$match:过滤时间范围,相当于SQL的WHERE$group:按日志级别分组统计$sort:按计数降序排列

4. 索引优化策略

索引如同图书馆的目录系统,合理使用可使查询速度提升10倍以上。为日志集合创建复合索引:

python

# 在启动时创建索引

@app.on_event("startup")

async def create_indexes():

await app.mongodb.logs.create_index([("timestamp", 1), ("level", 1)])

await app.mongodb.logs.create_index([("source", "text")])索引使用建议:

- 为常用查询字段创建组合索引

- 文本搜索字段使用text索引

- 定期使用explain()分析查询计划

python

# 分析查询性能

async def analyze_query():

explain_result = await app.mongodb.logs.find(

{"level": "ERROR"}

).explain()

print(explain_result["queryPlanner"]["winningPlan"])5. 日志系统完整案例

实现包含错误追踪的完整系统:

python

class EnhancedLogItem(LogItem):

trace_id: str | None = None

user_id: str | None = None

@app.get("/logs/errors")

async def get_error_logs(limit: int = 100):

error_logs = []

async for doc in app.mongodb.logs.find(

{"level": "ERROR"},

{"_id": 0, "message": 1, "timestamp": 1, "source": 1}

).sort("timestamp", -1).limit(limit):

error_logs.append(doc)

return error_logs

@app.get("/logs/search")

async def search_logs(keyword: str):

results = []

async for doc in app.mongodb.logs.find(

{"$text": {"$search": keyword}},

{"score": {"$meta": "textScore"}}

).sort([("score", {"$meta": "textScore"})]):

results.append({

"message": doc["message"],

"score": doc["score"]

})

return results6. 常见报错解决方案

问题1:422 Validation Error

json

{

"detail": [

{

"type": "missing",

"loc": [

"body",

"level"

],

"msg": "Field required"

}

]

}解决方法:

- 检查请求体是否包含所有必填字段

- 验证字段类型是否符合模型定义

- 使用Swagger文档测试API请求格式

问题2:Motor连接超时

TimeoutError: Timed out connecting to localhost:27017解决方法:

- 检查MongoDB服务是否运行

- 验证防火墙设置

- 增加连接超时配置:

python

AsyncIOMotorClient(os.getenv("MONGODB_URL"), serverSelectionTimeoutMS=5000)7. 课后Quiz

问题1:如何优化聚合查询的性能?

A) 增加服务器内存

B) 使用合适的索引

C) 减少返回字段数量

D) 所有选项都正确

正确答案:D

解析:索引能加速$match阶段,内存影响排序操作,减少返回数据量降低网络开销,三者都能提升性能。

问题2:处理百万级日志时,哪种分页方式最高效?

A) skip/limit

B) 基于时间范围查询

C) 使用最后ID的游标分页

D) 随机抽样

正确答案:C

解析:游标分页通过记录最后查询位置实现高效分页,避免skip带来的性能损耗,适合大数据量场景。

问题3:如何确保日志写入的可靠性?

A) 使用insert_many批量写入

B) 启用写确认机制

C) 添加唯一索引

D) 定期手动备份

正确答案:B

解析:写确认机制(write concern)能保证数据持久化到磁盘,搭配journaling功能可最大限度防止数据丢失。

余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:异步日志分析:MongoDB与FastAPI的高效存储揭秘 | cmdragon's Blog

往期文章归档:

- MongoDB索引优化的艺术:从基础原理到性能调优实战 | cmdragon's Blog

- 解锁FastAPI与MongoDB聚合管道的性能奥秘 | cmdragon's Blog

- 异步之舞:Motor驱动与MongoDB的CRUD交响曲 | cmdragon's Blog

- 异步之舞:FastAPI与MongoDB的深度协奏 | cmdragon's Blog

- 数据库迁移的艺术:FastAPI生产环境中的灰度发布与回滚策略 | cmdragon's Blog

- 数据库迁移的艺术:团队协作中的冲突预防与解决之道 | cmdragon's Blog

- 驾驭FastAPI多数据库:从读写分离到跨库事务的艺术 | cmdragon's Blog

- 数据库事务隔离与Alembic数据恢复的实战艺术 | cmdragon's Blog

- FastAPI与Alembic:数据库迁移的隐秘艺术 | cmdragon's Blog

- 飞行中的引擎更换:生产环境数据库迁移的艺术与科学 | cmdragon's Blog

- Alembic迁移脚本冲突的智能检测与优雅合并之道 | cmdragon's Blog

- 多数据库迁移的艺术:Alembic在复杂环境中的精妙应用 | cmdragon's Blog

- 数据库事务回滚:FastAPI中的存档与读档大法 | cmdragon's Blog

- Alembic迁移脚本:让数据库变身时间旅行者 | cmdragon's Blog

- 数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再"异步"混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- 深入解析事务基础与原子操作原理 | cmdragon's Blog

- 掌握Tortoise-ORM高级异步查询技巧 | cmdragon's Blog

- FastAPI与Tortoise-ORM实现关系型数据库关联 | cmdragon's Blog

- Tortoise-ORM与FastAPI集成:异步模型定义与实践 | cmdragon's Blog

- 异步编程与Tortoise-ORM框架 | cmdragon's Blog

- XML Sitemap