🎯 前言:为什么要自己搭建?

各位技术同学们,还在为ChatGPT的网络限制而苦恼吗?还在担心敏感数据泄露给第三方吗?今天给大家带来一个超级实用的解决方案------自部署AI提示词优化平台!

想象一下:

- ✅ 数据完全私有,不用担心泄露

- ✅ 无需FQ,本地运行如丝般顺滑

- ✅ 提示词优化+调试,一站式解决

- ✅ 支持多种开源大模型,想用啥用啥

听起来是不是很香?那就跟着我一起搭建吧!

🛠️ 技术栈介绍

核心组件

- auto-prompt:专业的AI提示词优化平台

- Ollama:本地大模型管理神器

- Docker:一键部署,环境隔离

- SQLite:轻量级数据库,开箱即用

为什么选择这个组合?

auto-prompt 是一个专业的提示词工程平台,具备:

- 🧠 智能提示词优化算法

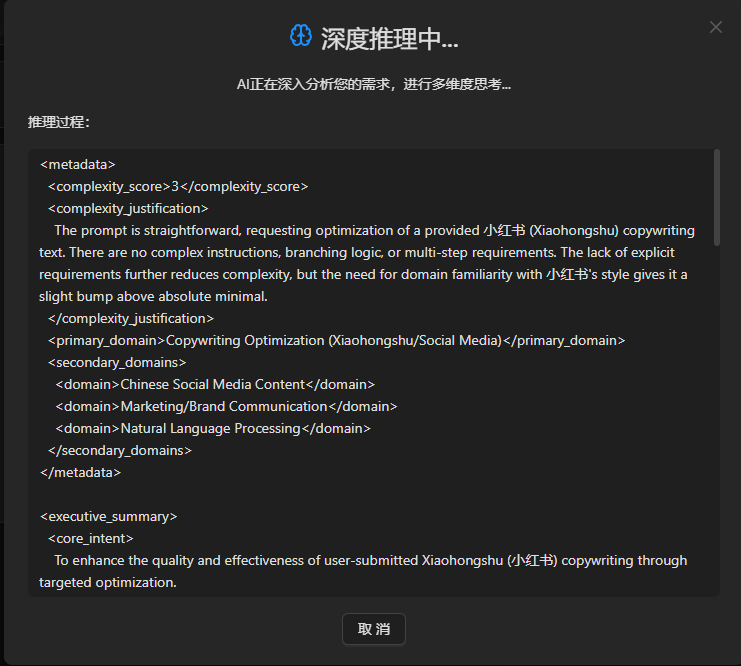

- 🔍 深度推理分析

- 🎨 可视化调试工具

- 👥 社区分享功能

Ollama 则是本地AI模型的管家:

- 📦 一键下载各种开源模型

- ⚡ 简单易用的API接口

- 🔧 灵活的模型管理

🚀 开始部署

第一步:准备环境

首先确保你的机器已经安装了Docker。如果没有,请先安装:

bash

# Linux用户

curl -fsSL https://get.docker.com | sh

# Windows/Mac用户请下载Docker Desktop第二步:启动Ollama

bash

# 创建数据卷

docker volume create ollama_data

# 启动Ollama容器

docker run -d \

--name ollama \

-p 11434:11434 \

-v ollama_data:/root/.ollama \

--restart unless-stopped \

ollama/ollama第三步:下载AI模型

bash

# 下载轻量级模型(推荐新手)

docker exec ollama ollama pull llama3.2:1b

# 或者下载更强大的模型(需要更多内存)

docker exec ollama ollama pull qwen2.5:7b小贴士:第一次下载模型可能需要一些时间,建议先去泡杯茶☕

第四步:部署auto-prompt平台

创建 docker-compose.yaml 文件:

yaml

version: '3.8'

services:

console-service:

image: registry.cn-hangzhou.aliyuncs.com/tokenai/auto-prompt:latest

container_name: auto-prompt-service

ports:

- "10426:8080"

environment:

# 配置Ollama API地址

- OpenAIEndpoint=http://host.docker.internal:11434/v1

# 使用SQLite数据库(默认配置)

- ConnectionStrings:Type=sqlite

- ConnectionStrings:Default=Data Source=/data/ConsoleService.db

- TZ=Asia/Shanghai

volumes:

- ./data:/data

depends_on:

- ollama

ollama:

image: ollama/ollama

container_name: ollama

ports:

- "11434:11434"

volumes:

- ollama_data:/root/.ollama

restart: unless-stopped

volumes:

ollama_data:第五步:一键启动

bash

# 启动所有服务

docker-compose up -d

# 查看服务状态

docker-compose ps🎉 验证部署

1. 检查Ollama是否正常

bash

# 测试API

curl http://localhost:11434/api/tags

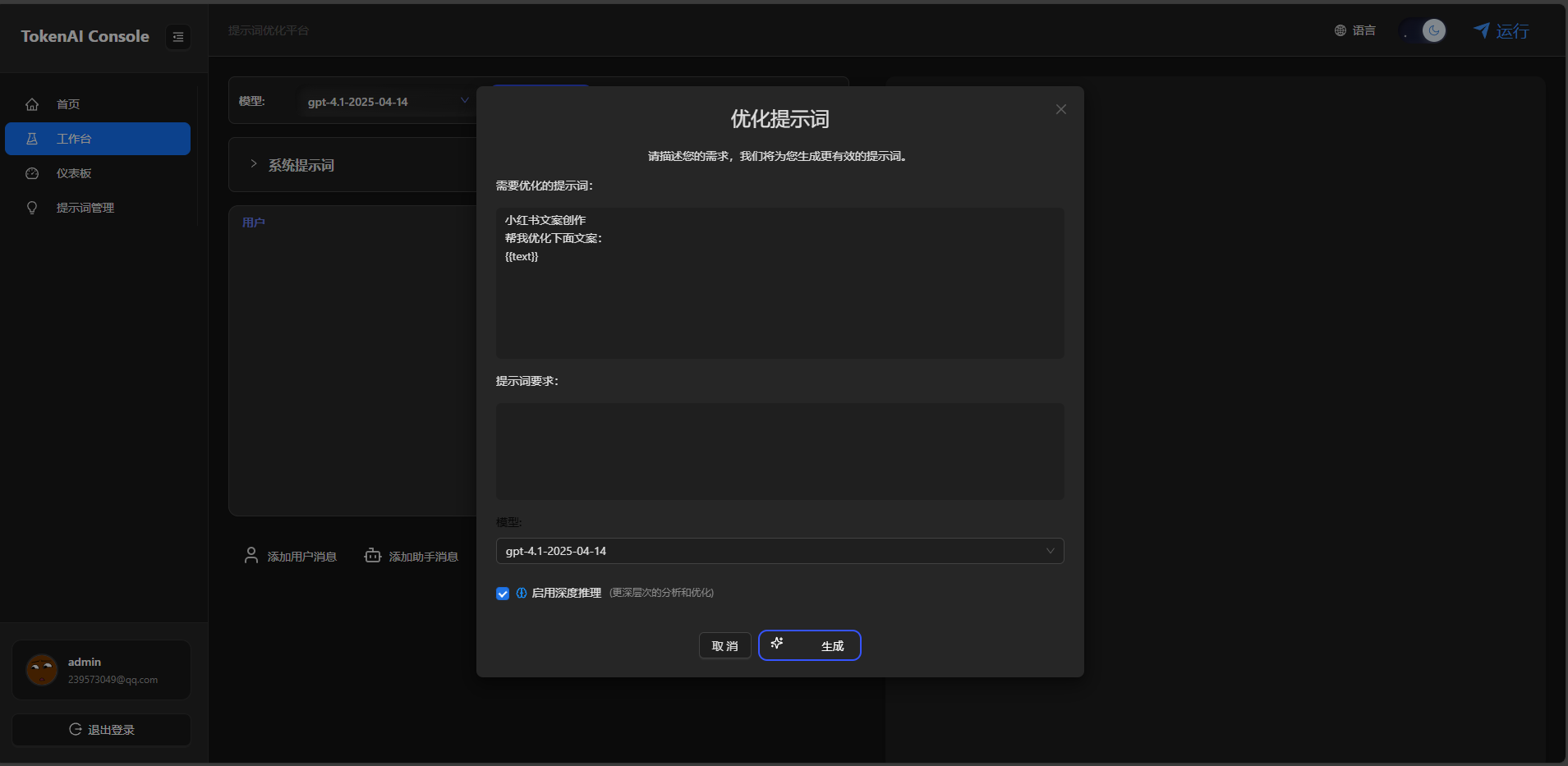

# 应该返回已安装的模型列表2. 访问auto-prompt平台

打开浏览器,访问:http://localhost:10426

你应该能看到一个漂亮的提示词优化界面!

3. 测试提示词优化

在平台中输入一个简单的提示词,比如:

你是python专家点击"优化"按钮!

🔧 高级配置

性能优化建议

- GPU加速(如果有NVIDIA显卡):

bash

# 修改Ollama启动命令

docker run -d --gpus all \

--name ollama \

-p 11434:11434 \

-v ollama_data:/root/.ollama \

ollama/ollama- 内存配置:

yaml

# 在docker-compose.yaml中添加资源限制

deploy:

resources:

limits:

memory: 4G

reservations:

memory: 2G模型推荐

| 模型 | 大小 | 适用场景 | 内存需求 |

|---|---|---|---|

| llama3.2:1b | 1.3GB | 轻量级任务 | 4GB |

| qwen2.5:7b | 4.4GB | 通用任务 | 8GB |

| deepseek-coder:6.7b | 3.8GB | 代码生成 | 8GB |

🐛 常见问题解决

Q1: Ollama连接失败?

A: 检查防火墙设置,确保11434端口开放

Q2: 模型下载很慢?

A: 可以配置国内镜像源:

bash

# 设置环境变量

export OLLAMA_HOST=0.0.0.0:11434Q3: 内存不够用?

A: 选择更小的模型,或者增加虚拟内存

🎊 总结

恭喜你!现在你已经拥有了一个完全私有化的AI提示词优化平台!

你现在可以:

- 🔒 在完全离线的环境中使用AI

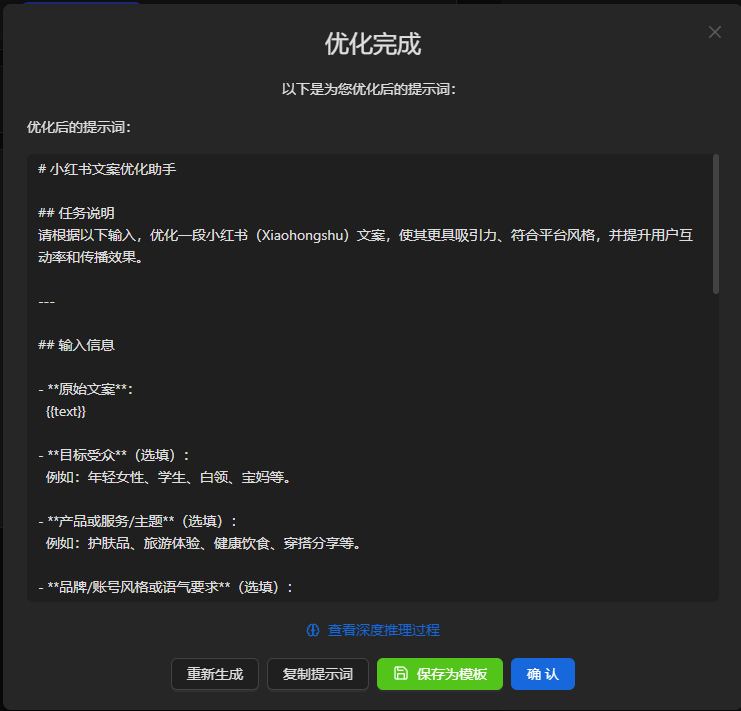

- 🎯 优化和调试你的提示词

- 📊 分析AI的推理过程

- 💾 保存和分享优质模板

下一步建议:

- 尝试不同的AI模型

- 探索平台的高级功能

- 分享你的优质提示词模板

📚 相关资源

- 项目地址 :https://github.com/AIDotNet/auto-prompt

- Ollama官网 :https://ollama.ai

- 模型库 :https://ollama.ai/library

最后的最后:如果这篇文章对你有帮助,别忘了点个赞👍,转发给更多需要的小伙伴!

有问题欢迎在评论区讨论,我会及时回复的~

#AI #Docker #Ollama #提示词工程 #私有化部署