一、视觉伺服控制的基本概念与定义

视觉伺服控制(Visual Servoing Control)是一种将计算机视觉与自动控制相结合的技术,通过相机获取环境图像信息,提取目标特征,再基于特征误差生成控制信号,驱动执行机构(如机器人手臂、无人机)完成目标跟踪、定位或操作任务。其核心思想是建立图像空间特征与机器人运动空间的映射关系,实现"感知-决策-控制"的闭环系统。

关键特点:

- 依赖视觉反馈,属于反馈控制的一种特例

- 需解决图像特征与三维空间运动的非线性映射问题

- 广泛应用于机器人、自动化、无人机等领域

二、视觉伺服控制的分类体系

根据反馈信息的表示形式,视觉伺服主要分为以下几类:

1. 基于位置的视觉伺服(Position-Based Visual Servoing, PBVS)

- 核心思想:将图像特征通过相机模型反投影到三维空间,计算目标在世界坐标系下的位置和姿态,与期望位置比较后生成控制量。

- 流程 :

- 图像特征提取(如角点、边缘)

- 三维重建或姿态估计(通过PnP问题求解)

- 计算三维空间误差(位置/姿态偏差)

- 基于误差生成机器人控制量

- 优点:控制量物理意义明确,便于结合传统控制理论

- 缺点:需精确的相机标定和三维模型,对噪声敏感

2. 基于图像的视觉伺服(Image-Based Visual Servoing, IBVS)

- 核心思想:直接在图像空间定义误差(如特征点像素坐标偏差),通过图像雅可比矩阵(Interaction Matrix)将图像误差映射为机器人运动速度。

- 数学表达 :

图像误差: e = s ( x ) − s ∗ \mathbf{e} = \mathbf{s}({\mathbf{x}}) - \mathbf{s}^* e=s(x)−s∗

控制律: q ˙ = − λ J i − 1 ( x ) e \dot{\mathbf{q}} = -\lambda \mathbf{J}_i^{-1}(\mathbf{x}) \mathbf{e} q˙=−λJi−1(x)e

其中 J i ( x ) \mathbf{J}_i(\mathbf{x}) Ji(x)为图像雅可比矩阵, x \mathbf{x} x为机器人状态, s ( ⋅ ) \mathbf{s}(\cdot) s(⋅)为图像特征函数。 - 优点:无需三维模型,对模型误差鲁棒性强

- 缺点:雅可比矩阵需实时计算,非线性映射可能导致局部极小值问题

3. 混合视觉伺服(Hybrid Visual Servoing)

- 结合PBVS和IBVS的优点,部分特征采用三维位置反馈,另一部分采用图像特征反馈。

- 典型应用:目标姿态控制(三维反馈)+ 精细定位(图像反馈)

4. 基于语义的视觉伺服(Semantic Visual Servoing)

- 引入深度学习语义分割、目标检测技术,使用"语义特征"(如物体类别、部件位置)作为反馈。

- 特点:适应复杂场景,无需人工设计特征,但需大量训练数据。

三、视觉伺服系统的核心组成模块

一个完整的视觉伺服系统包含以下关键部分:

1. 视觉感知模块

- 相机模型 :

- 针孔相机模型: s u = K [ R t ] X s\mathbf{u} = \mathbf{K}[\mathbf{R} \ \mathbf{t}]\mathbf{X} su=K[R t]X,其中 K \mathbf{K} K为内参矩阵, R , t \mathbf{R},\mathbf{t} R,t为外参。

- 畸变模型:径向畸变( k 1 , k 2 , k 3 k_1, k_2, k_3 k1,k2,k3)和切向畸变( p 1 , p 2 p_1, p_2 p1,p2)。

- 相机标定 :

- 内参与外参标定方法(如张正友标定法)

- 动态标定(解决运动中相机参数变化问题)

- 图像处理与特征提取 :

- 传统方法:SIFT、SURF、ORB特征点检测

- 深度学习方法:YOLO、SSD用于目标检测,DeepLab用于语义分割

2. 误差建模与雅可比矩阵

- 图像雅可比矩阵(Interaction Matrix) :

- 定义: J i = ∂ s ∂ ξ \mathbf{J}_i = \frac{\partial \mathbf{s}}{\partial \mathbf{\xi}} Ji=∂ξ∂s,其中 ξ = [ v x , v y , v z , ω x , ω y , ω z ] T \mathbf{\xi} = [v_x, v_y, v_z, \omega_x, \omega_y, \omega_z]^T ξ=[vx,vy,vz,ωx,ωy,ωz]T为相机六维速度。

- 推导示例(以二维特征点为例):

设三维点 X = [ X , Y , Z ] T \mathbf{X} = [X, Y, Z]^T X=[X,Y,Z]T,图像坐标 u = [ u , v ] T \mathbf{u} = [u, v]^T u=[u,v]T,则:

u = f X Z , v = f Y Z u = f\frac{X}{Z}, \ v = f\frac{Y}{Z} u=fZX, v=fZY

雅可比矩阵元素:

J i , u , v x = f Z , J i , u , ω z = − f X Z 2 J_{i,u,v_x} = \frac{f}{Z}, \ J_{i,u,\omega_z} = -\frac{fX}{Z^2} Ji,u,vx=Zf, Ji,u,ωz=−Z2fX(完整矩阵见经典教材)

- 误差定义 :

- 图像空间误差: e = [ u − u ∗ , v − v ∗ , ... ] T \mathbf{e} = [u - u^*, v - v^*, \ldots]^T e=[u−u∗,v−v∗,...]T

- 三维空间误差: e p = [ X − X ∗ , Y − Y ∗ , Z − Z ∗ , ... ] T \mathbf{e}_p = [X - X^*, Y - Y^*, Z - Z^*, \ldots]^T ep=[X−X∗,Y−Y∗,Z−Z∗,...]T

3. 控制算法模块

- 线性控制方法 :

- 比例控制(P控制): q ˙ = − λ J i − 1 e \dot{\mathbf{q}} = -\lambda \mathbf{J}_i^{-1} \mathbf{e} q˙=−λJi−1e

- 比例-微分控制(PD控制): q ˙ = − λ 1 J i − 1 e − λ 2 e ˙ \dot{\mathbf{q}} = -\lambda_1 \mathbf{J}_i^{-1} \mathbf{e} - \lambda_2 \dot{\mathbf{e}} q˙=−λ1Ji−1e−λ2e˙

- 非线性控制方法 :

- 基于李雅普诺夫稳定性的控制设计

- 滑模控制(Sliding Mode Control):提高抗干扰能力

- 自适应与鲁棒控制 :

- 自适应雅可比矩阵估计:解决模型不确定性

- 鲁棒控制:处理噪声、扰动(如H∞控制)

- 优化-based方法 :

- 迭代求解最小化误差问题: min q ∥ s ( q ) − s ∗ ∥ 2 \min_{\mathbf{q}} \|\mathbf{s}(\mathbf{q}) - \mathbf{s}^*\|^2 minq∥s(q)−s∗∥2

4. 执行机构与系统集成

- 机器人运动学模型:

- 正向运动学: x = f ( q ) \mathbf{x} = \mathbf{f}(\mathbf{q}) x=f(q)

- 逆向运动学: q = f − 1 ( x ) \mathbf{q} = \mathbf{f}^{-1}(\mathbf{x}) q=f−1(x)

- 控制周期与实时性:

- 典型控制频率:20-100Hz(取决于相机帧率和计算性能)

- 延时补偿:预测控制、模型预测控制(MPC)

四、视觉伺服的数学基础与关键理论

1. 坐标变换与投影理论

- 坐标系定义 :

- 世界坐标系( W \mathcal{W} W)、相机坐标系( C \mathcal{C} C)、图像坐标系( I \mathcal{I} I)

- 坐标变换链 :

X c = R X w + t \mathbf{X}_c = \mathbf{R}\mathbf{X}_w + \mathbf{t} Xc=RXw+t(世界→相机)

u = K X c / Z c \mathbf{u} = \mathbf{K}\mathbf{X}_c / Z_c u=KXc/Zc(相机→图像) - 齐次坐标表示 :

u ~ = K [ R t ] X ~ w \mathbf{\tilde{u}} = \mathbf{K}[\mathbf{R} \ \mathbf{t}]\mathbf{\tilde{X}}_w u~=K[R t]X~w,其中 u ~ , X ~ w \mathbf{\tilde{u}}, \mathbf{\tilde{X}}_w u~,X~w为齐次坐标。

2. 稳定性分析

- 李雅普诺夫稳定性理论 :

- 定义能量函数 V ( e ) = 1 2 e T e V(\mathbf{e}) = \frac{1}{2}\mathbf{e}^T\mathbf{e} V(e)=21eTe

- 证明 V ˙ ≤ 0 \dot{V} \leq 0 V˙≤0(渐近稳定)或 V ˙ < 0 \dot{V} < 0 V˙<0(指数稳定)

- IBVS的稳定性挑战 :

- 雅可比矩阵非满秩问题

- 局部极小值(如深度方向的歧义性)

- 解决方法:全局稳定控制设计、路径规划引导

3. 不确定性与鲁棒性

- 误差来源 :

- 相机标定误差

- 雅可比矩阵估计误差

- 图像处理噪声

- 机器人运动学模型误差

- 鲁棒性解决方案 :

- 自适应控制(在线估计参数)

- 卡尔曼滤波(融合视觉与编码器数据)

- 冗余传感器融合(如视觉+力传感器)

五、视觉伺服的典型应用场景

1. 工业机器人视觉抓取

- 传送带物体分拣:基于IBVS实现动态目标跟踪

- 精密装配:PBVS用于三维姿态对准

- 焊接与喷涂:视觉引导轨迹跟踪

2. 无人机视觉导航

- 自主着陆:基于图像特征的高度和水平位置估计

- 避障与跟随:语义视觉伺服识别障碍物和目标

- 空中抓取:多相机协同定位目标

3. 医疗机器人

- 微创手术:显微视觉伺服实现毫米级操作

- 骨科手术:三维视觉引导植入物定位

4. 服务机器人

- 物体拾取与递送:结合深度学习识别物体姿态

- 自主导航:视觉SLAM与伺服控制结合

六、视觉伺服的研究热点与挑战

1. 前沿技术方向

- 深度学习与视觉伺服融合 :

- 端到端视觉伺服:直接学习图像到控制量的映射(如Policy Gradient方法)

- 深度特征用于雅可比矩阵估计

- 动态视觉伺服 :

- 高速运动目标跟踪(如飞虫捕捉)

- 基于事件相机(Event Camera)的低延迟伺服

- 多传感器融合 :

- 视觉+激光雷达(LiDAR):提高三维定位精度

- 视觉+惯性测量单元(IMU):解决动态模糊问题

2. 关键挑战

- 实时性与计算效率 :

- 高分辨率图像的实时处理

- 嵌入式平台(如FPGA、GPU)的优化

- 复杂环境适应性 :

- 光照变化、遮挡、动态背景

- 非结构化环境中的特征鲁棒性

- 理论局限性 :

- IBVS的全局稳定性证明

- 三维重建与伺服控制的联合优化

七、视觉伺服系统设计流程与案例

1. 系统设计步骤

- 需求分析:确定任务类型(定位、跟踪、操作)、精度要求、环境条件

- 相机选型与标定:选择分辨率、帧率、视野合适的相机,完成内外参标定

- 特征选择:根据任务选择点、线、面或语义特征

- 误差模型建立:定义图像误差与控制量的映射关系

- 控制算法设计:选择线性/非线性方法,优化稳定性和响应速度

- 系统集成与调试:结合机器人平台,测试抗干扰能力和鲁棒性

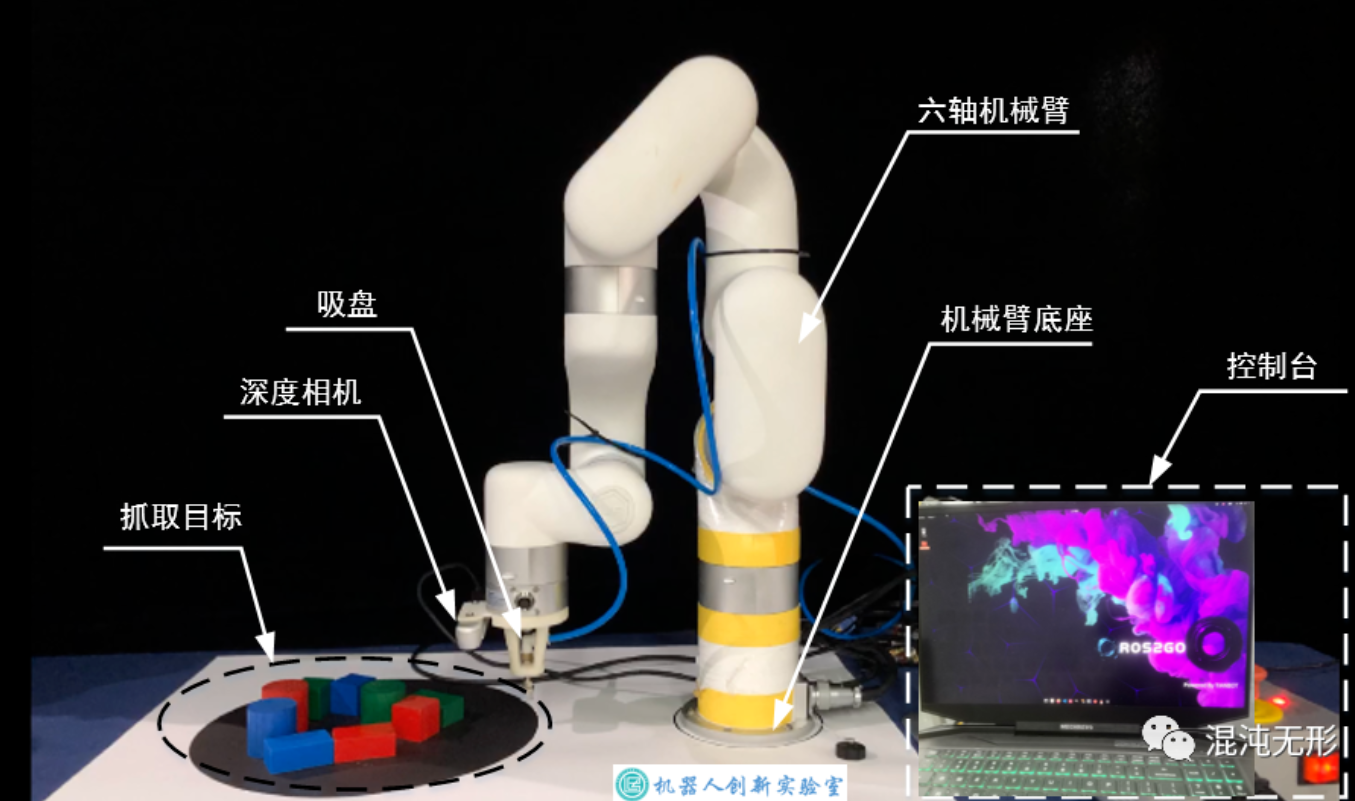

2. 案例:机械臂目标抓取

- 场景:机械臂抓取传送带上的工件

- 方案 :

- 采用IBVS,以工件角点为特征

- 相机固定安装,俯视传送带

- 控制律: q ˙ = − λ J i − 1 e \dot{\mathbf{q}} = -\lambda \mathbf{J}_i^{-1} \mathbf{e} q˙=−λJi−1e,其中 e \mathbf{e} e为角点像素偏差

- 难点解决 :

- 传送带速度估计:通过连续帧特征匹配

- 深度估计:双目视觉或结构光

八、经典文献与工具链

1. 理论奠基文献

- Hutchinson, R., et al. "A tutorial on visual servo control" (1996):视觉伺服经典综述

- Spong, M.W. "Robot Modeling and Control":机器人控制与视觉伺服数学基础

- Corke, P. "Robotics, Vision and Control":包含PBVS/IBVS的MATLAB实现

2. 常用工具与平台

- 机器人视觉库 :

- OpenCV:图像处理与特征提取

- PCL:点云处理与三维重建

- ROS(Robot Operating System):视觉伺服算法集成

- 仿真平台 :

- Gazebo:机器人与视觉系统联合仿真

- V-REP:视觉伺服算法验证

- 深度学习框架 :

- TensorFlow/PyTorch:语义视觉伺服模型训练

- Darknet:实时目标检测模型部署

九、总结:视觉伺服的技术脉络

视觉伺服控制的核心是建立"视觉感知-误差建模-运动控制"的闭环,其技术体系可概括为:

- 底层:相机模型、坐标变换、特征提取

- 中间层:雅可比矩阵建模、误差映射、稳定性分析

- 顶层:控制算法设计、任务规划、多传感器融合

未来发展将更注重与深度学习、动态系统理论的结合,以解决复杂环境下的实时性、鲁棒性问题,推动工业、医疗、服务机器人等领域的智能化升级。