目录

初识Elasticsearch

什么是elasticsearch

elasticsearch是一款非常强大的开源搜索引擎,可以帮助我们从海量数据中快速找到需要的内容。

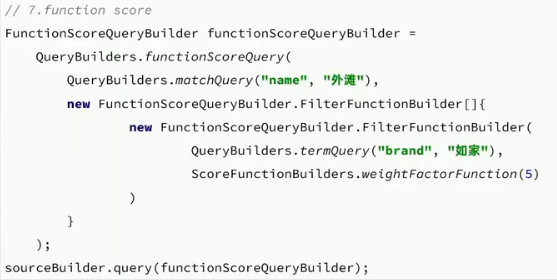

elasticsearch结合kibana、Logstash、Beats,也就是ELK。被广泛应用在日志数据分析、实时监控等领域。

elasticsearch的发展

Lucene是一个Java语言的搜索引擎类库,是Apache公司的顶级项目,由DougCutting于1999年研发。

Lucene的优势:

易扩展

高性能(基于倒排索引)

Lucene的缺点:

只限于Java语言开发

学习曲线陡峭

不支持水平扩展

elasticsearch就是基于Lucene的开发,优势:

支持分布式,可水平扩展

提供Restful接口,可被任何语言调用

正向索引和倒排索引

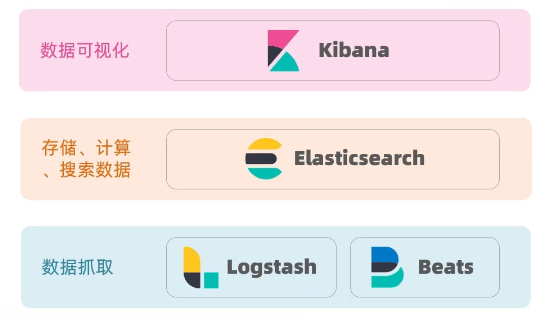

elasticsearch采用倒排索引:

文档:每条数据就是一个文档

词条:文档按照语义分成的词语

正向索引:基于文档id创建索引。查询词条时必须先找到文档,而后判断是否包含词条

倒排索引:对文档内容分词,对词条创建索引,并记录词条所在文档的信息。查询时先根据词条查询到文档id,而后获取到文档

与mysql进行对比

文档

elasticsearch是面向文档存储的,可以是数据库中的一条商品数据,一个订单信息。

文档数据会被序列化为json格式后存储在elasticsearch中。

索引

索引:相同类型的文档的集合

映射:索引中文档的字段约束信息,类似表的结构约束

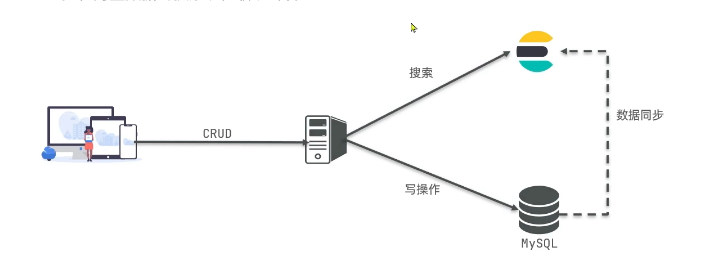

架构

MySQL:擅长事务类型操作,可以确保数据的安全和一致性

Elasticsearch:擅长海量数据的搜索、分析、计算

安装elasticsearch、kibana

建议以下连接

Elasticsearch集群和Kibana部署流程_kibana部署教程-CSDN博客

安装分词器IK

分词器的作用是什么?

创建倒排索引时对文档分词

用户搜索时,对输入的内容分词

IK分词器有几种模式?

ik_smart:智能切分,粗粒度

ik_max_word:最细切分,细粒度

es在创建倒排索引时需要对文档分词;在搜索时,需要对用户输入内容分词。但默认的分词规则对中文处理并不友好。

处理中文分词,一般回使用IK分词器。infinilabs/analysis-ik: 🚌 The IK Analysis plugin integrates Lucene IK analyzer into Elasticsearch and OpenSearch, support customized dictionary.

下载完将压缩包解压到es的plugins目录即可

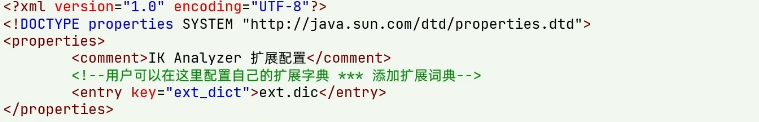

IK分词器的拓展和停用词典

ik分词器-拓展词库

要拓展ik分词器的词库,只需要修改一个ik分词器目录中的config目录中的 IkAnalyzer.cfg.xml文件:

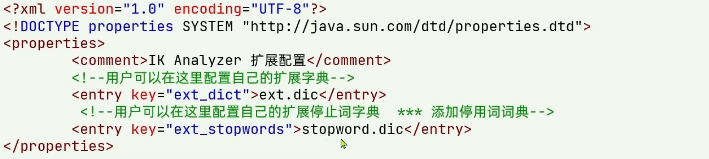

ik分词器-停用词库

要禁用某些敏感词条,只需要修改一个il分词器目录中的config目录中的IkAnalyzer.cfg.xml文件:

拓展和禁用词文件都必须在当前配置文件所在的目录

索引库操作

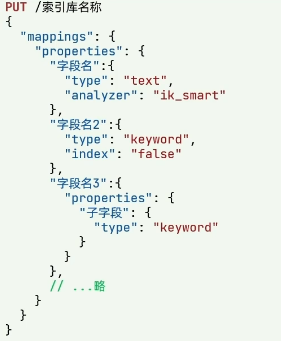

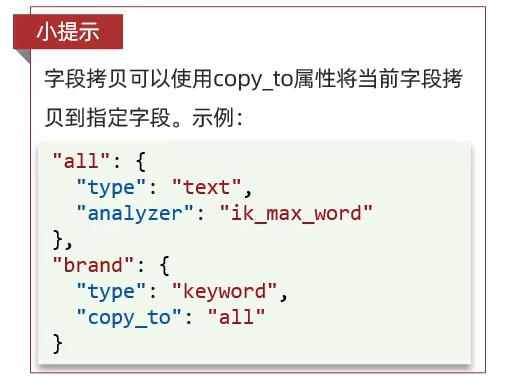

mapping映射属性

mapping是对索引库中文档的约束,常见的mapping属性包括:

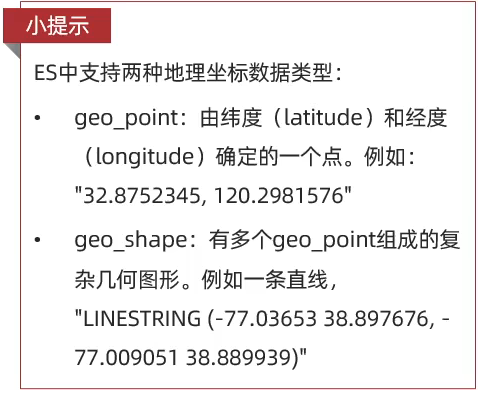

**type:字段数据类型,**常见的简单类型有

字符串 :text(可分词的文本)、keyword(精确值,例如:品牌、国家、IP地址)

数值 :long、integer、short、byte、double、float

布尔 :boolean

日期 :date

对象 :object

index:是否创建索引,默认为true

**ananlyzer:**使用哪种分词器

**properties:**该字段的子字段

索引库的CRUD

ES中通过Restful请求操作索引库、文档。请求内容用DSL语句来表示。

创建索引库和mapping的DSL语法如下:

XML

PUT /haha

{

"mappings":{

"properties":{

"info":{

"type":"text",

"analyzer":"ik_smart"

},

"email":{

"type":"keyword",

"index":false

},

"name":{

"type":"object",

"properties":{

"firstName":{

"type":"keyword"

},

"lastName":{

"type":"keyword"

}

}

}

}

}

}查看、删除索引库

查看索引库语法:

GET /索引库名

删除索引库的语法:

DELETE /索引库名

修改索引库

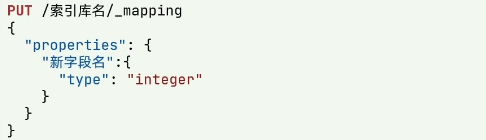

索引库和mapping一旦创建无法修改,但是可以添加新的字段,语法如下:

文档操作

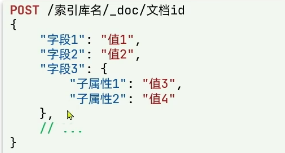

新增文档

查询文档

GET /索引库名/_doc/文档id

删除文档

DELETE /索引库名/_doc/文档id

修改文档

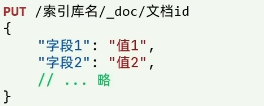

方式一:全量删除,会删除旧文档,添加新文档

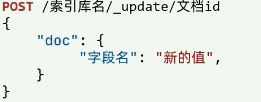

方式二:增量修改,修改指定字段

RestClient操作索引库

RestClient是ES官方提供了各种不同语言的客户端,用来操作ES。这些客户端的本质就是组装DSL语句,通过http请求发送给ES。官方文档地址:Elasticsearch clients | Elastic Docs

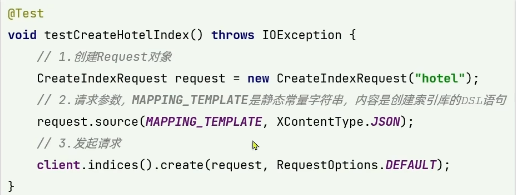

创建索引库

mapping要考虑的问题:

字段名、数据类型、是否参与搜索、是否分词、如果分词、分词器是什么

1.导入数据

2.编写mapping映射

id一般在ES中用keyword来表示

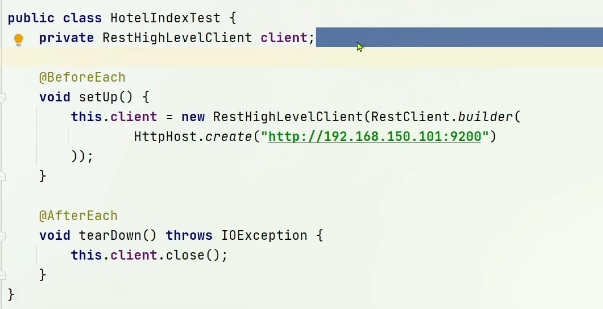

3.初始化JavaRestClient

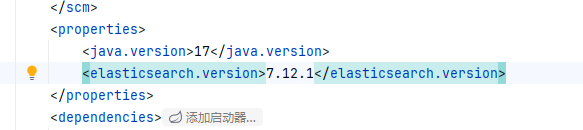

(1).引入es的RestHighLevelClient依赖:

XML

<dependency>

<groupId>org.elasticsearch.client</groupId>

<artifactId>elasticsearch-rest-high-level-client</artifactId>

<version>7.12.1</version>

</dependency>(2).配置版本

(3).初始化JavaRestClient

java

public class HotelIndex {

private RestHighLevelClient client;

@Test

void testInit(){

System.out.println(client);

}

@BeforeEach

public void setUp() throws Exception {

this.client = new RestHighLevelClient(RestClient.builder(HttpHost.create("http://localhost:9200")));

}

@AfterEach

public void tearDown() throws Exception {

this.client.close();

}

}4.创建索引库

java

@Test

void createHotelIndex() throws IOException {

CreateIndexRequest request = new CreateIndexRequest("hotel");

request.source("""

{

"mappings": {

"properties": {

"name": {

"type": "text"

},

"price": {

"type": "long"

},

"location": {

"type": "text"

},

"amenities": {

"type": "keyword"

}

}

}

}

""", XContentType.JSON);

client.indices().create(request, RequestOptions.DEFAULT);

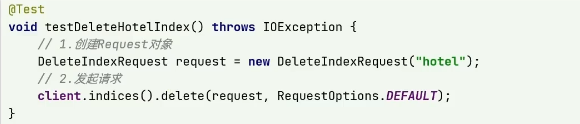

}删除索引库

java

@Test

void deleteHotelIndex() throws IOException {

client.indices().delete(new DeleteIndexRequest("hotel"), RequestOptions.DEFAULT);

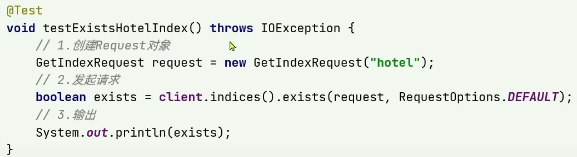

}判断索引库是否存在

java

@Test

void existsHotelIndex() throws IOException {

GetIndexRequest request = new GetIndexRequest("hotel");

boolean exists = client.indices().exists(request, RequestOptions.DEFAULT);

System.out.println(exists);

}RestClient操作文档

文档操作也同样需要初始化RestHighLevelClient

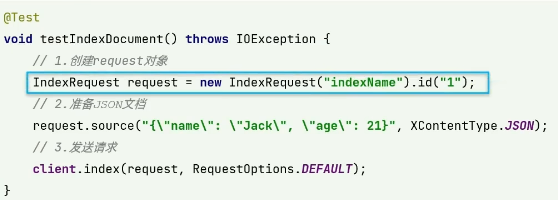

新增文档

从数据库中加载数据,并且转换为JSON格式

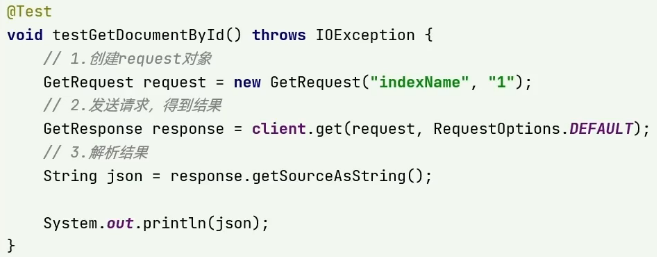

查询文档

直接解析的结果为json格式,记得将json格式反序列化

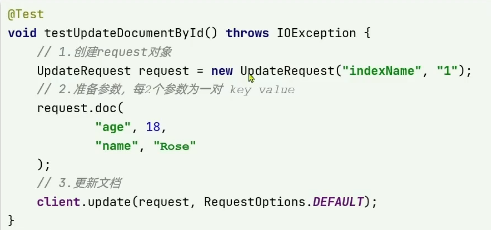

更新文档

方式一:

全量更新。再次学日语id一样的文档,就会删除旧文档,添加新文档

方式二:

局部更新。只更新部分字段

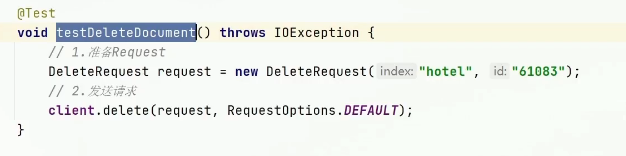

删除文档

批量导入文档

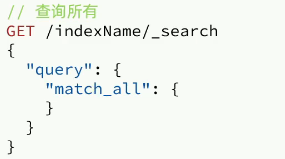

DSL查询文档

DSL查询分类

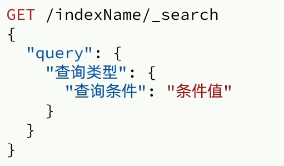

Elasticsearch提供了基于JSON的DSL(Domain Specific Language)来定义查询。常见的查询类型包括:

- 查询所有:查询出所有数据,一般测试用。例如:`match_all`

- 全文检索(full text)查询**:利用分词器对用户输入内容分词,然后去倒排索引库中匹配。例如:

-

`match_query`

-

`multi_match_query`

- 精确查询:根据精确词条值查找数据,一般是查找keyword、数值、日期、boolean等类型字段。例如:

-

`ids`

-

`range`

-

`term`

- 地理(geo)查询:根据经纬度查询。例如:

-

`geo_distance`

-

`geo_bounding_box`

- 复合(compound)查询:复合查询可以将上述各种查询条件组合起来,合并查询条件。例如:

-

`bool`

-

`function_score`

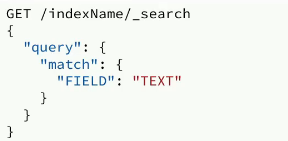

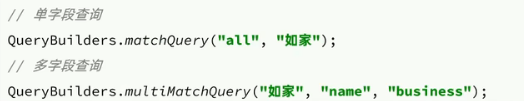

全文检索查询

match查询:全文检索查询的一种,会对用户输入内容分词,然后去倒排索引库检索,语法:

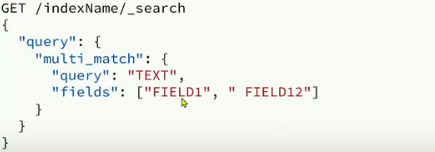

multi_match:与match查询类似,只不过允许同时查询多个字段,语法:

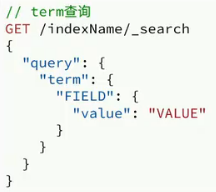

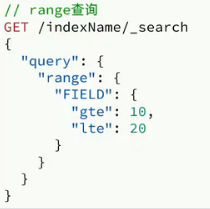

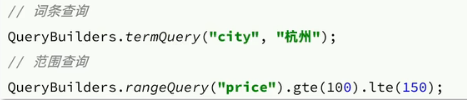

精准查询

精确查询一般是查找keyword、数值、日期、boolean等类型字段。所以不会对搜索条件分词。常见的有:

term:根据词条精确值查询

range:根据值的范围查询

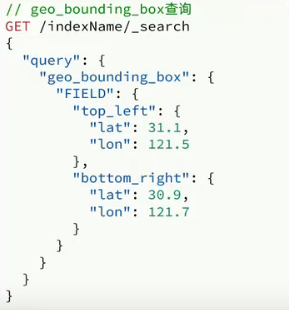

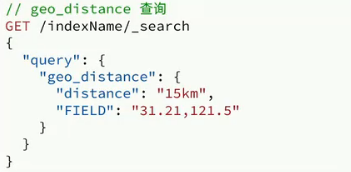

地理坐标查询

根据经纬度查询。常见的使用场景包括:

携程:搜索我附近的酒店

滴滴:搜索我附近的出租车

微信:搜索我附近的人

geo_bounding_box:查询geo_point值落在某个矩形范围的所以文档

geo_distance:查询到指定中心点小于某个距离值的所有文档

组合查询(复合查询)

复合查询:复合查询可以将其它简单查询组合起来,实现更复杂的搜索逻辑,例如:

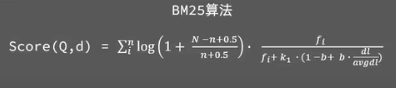

**fuction score:**算分函数查询,可以控制文档相关性算分,控制文档排名。例如百度竞价

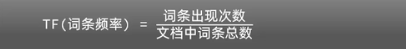

相关性算分

当我们利用match查询时,文档结构会根据与搜索词条的关联度打分(_score),返回结构时按照分值降序排列。

-

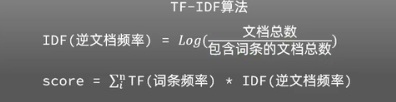

TF-IDF:

-

在Elasticsearch 5.0之前使用。

-

随着词频(Term Frequency)的增加,相关性分数会不断增大。

-

-

BM25:

-

从Elasticsearch 5.0开始采用。

-

随着词频的增加,相关性分数也会增大,但增长曲线会逐渐趋于平缓,避免过度偏向高频词

-

使用 fuction score query,可以修改文档的相关性算分,根据新得到的算分排序。

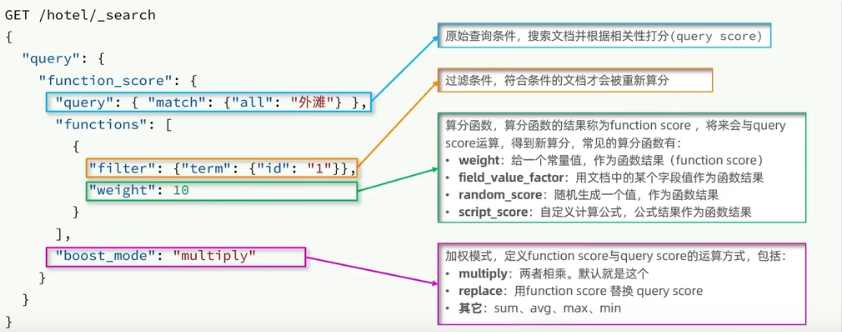

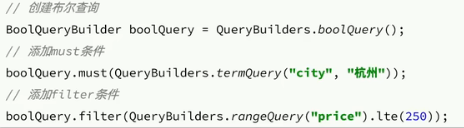

复合查询 Boolean Query

布尔查询是一个或多个查询子句的组合。子查询的组合方式有:

must:必须匹配每个子查询,类似"与"

should:选择性匹配子查询,类似"或"

must_not:必须不匹配,不参与算分,类似"非"

filter:必须匹配,不参与算分

搜索结果处理

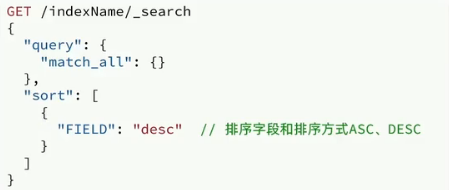

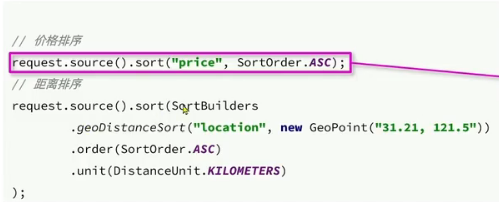

排序

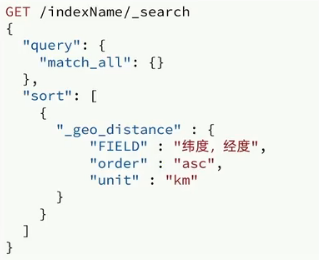

Elasticsearch支持对搜索结果进行排序,默认情况下是根据相关度算分(_score)进行排序。支持的排序字段类型包括:keyword类型 、数值类型 、地理坐标类型 、日期类型

获取经纬度的方式:高德开放平台 | 高德地图API

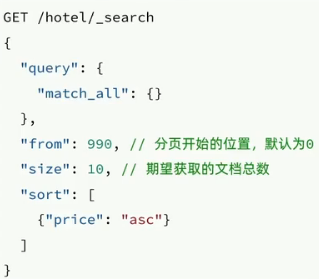

分页

elasticsearch默认情况下只返回top10的数据。而如果要查询更多数据就需要修改分页参数了。

elasticsearch中通过修改from、size参数来控制要返回的分页结果:

该方法限制了查询上限为10000条

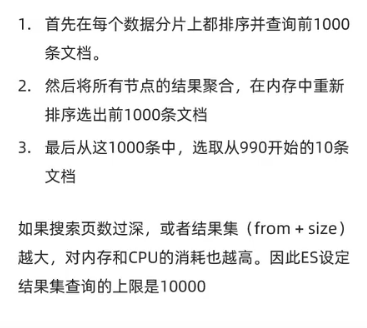

深度分页问题

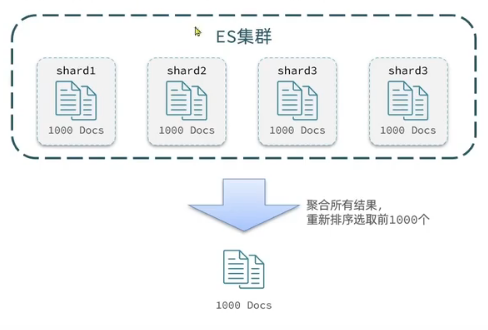

ES是分布式的,所以会面临深度分页问题。例如按price排序后,获取from=990,size=10的数据:

深度分页解决方案:

-

Search After

-

原理:基于上一页的排序值继续查询下一页数据,要求分页时必须指定排序规则。

-

特点:官方推荐的方式,适用于实时滚动查询,避免性能问题。

-

-

Scroll

-

原理:将排序数据生成快照并保存在内存中,适合大批量数据遍历。

-

特点:官方已不再推荐使用,因为会占用较多资源且数据可能不是最新的。

-

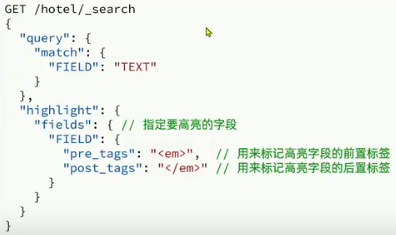

高亮

高亮:就是在搜索结果中把搜索关键字突出显示。

原理:

将搜索结果中的关键字用标签标记出来

在页面中给标签添加css样式

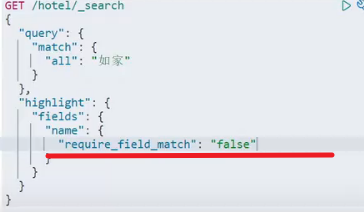

默认情况下,ES搜索字段必须与高亮字段一致

增加字段匹配即可

RestClient查询文档

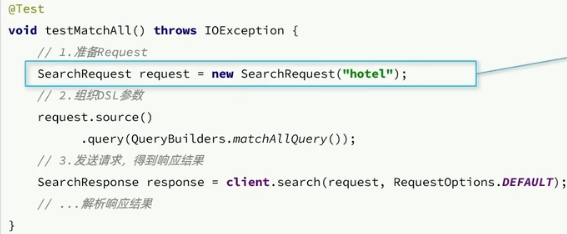

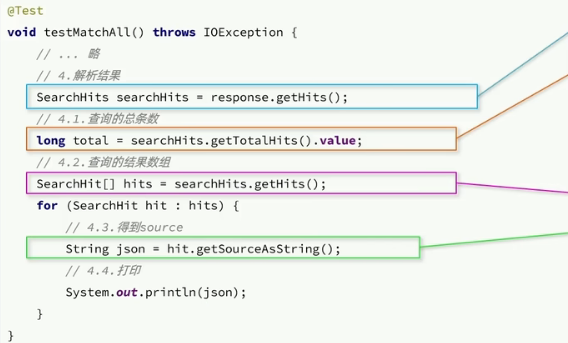

快速入门

1.创建SearchRequest对象

2.准备Request.source(),也就是DSL

3.发送请求,得到结果

4.解析结果

match查询

精确查询

复合查询

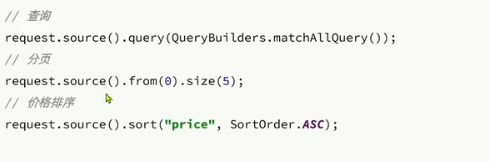

排序、分页、高亮

排序和分页

高亮

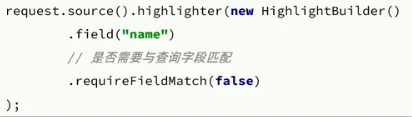

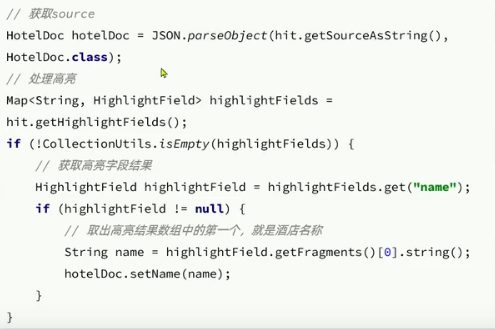

高亮API包括请求DSL构建和结果解析两部分。

DSL构建

高亮的结果处理

实例常用

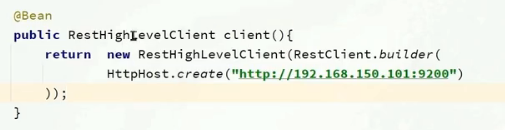

将Client注入到Bean对象中

距离排序

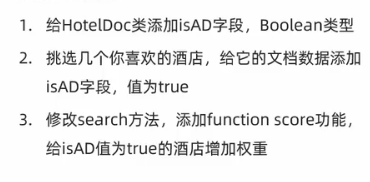

让指定内容在搜索结果中排名置顶

我们给需要置顶的文档添加一个标记。然后利用function score给带有标记的文档增加权重