⭐CVPR 顶会精读|无约束 3D 视线估计新框架 GA3CE

📄论文题目:GA3CE: Unconstrained 3D Gaze Estimation with Gaze-Aware 3D Context Encoding

✍️作者及机构:Yuki Kawana、Shintaro Shiba、Quan Kong、Norimasa Kobori(Woven by Toyota)

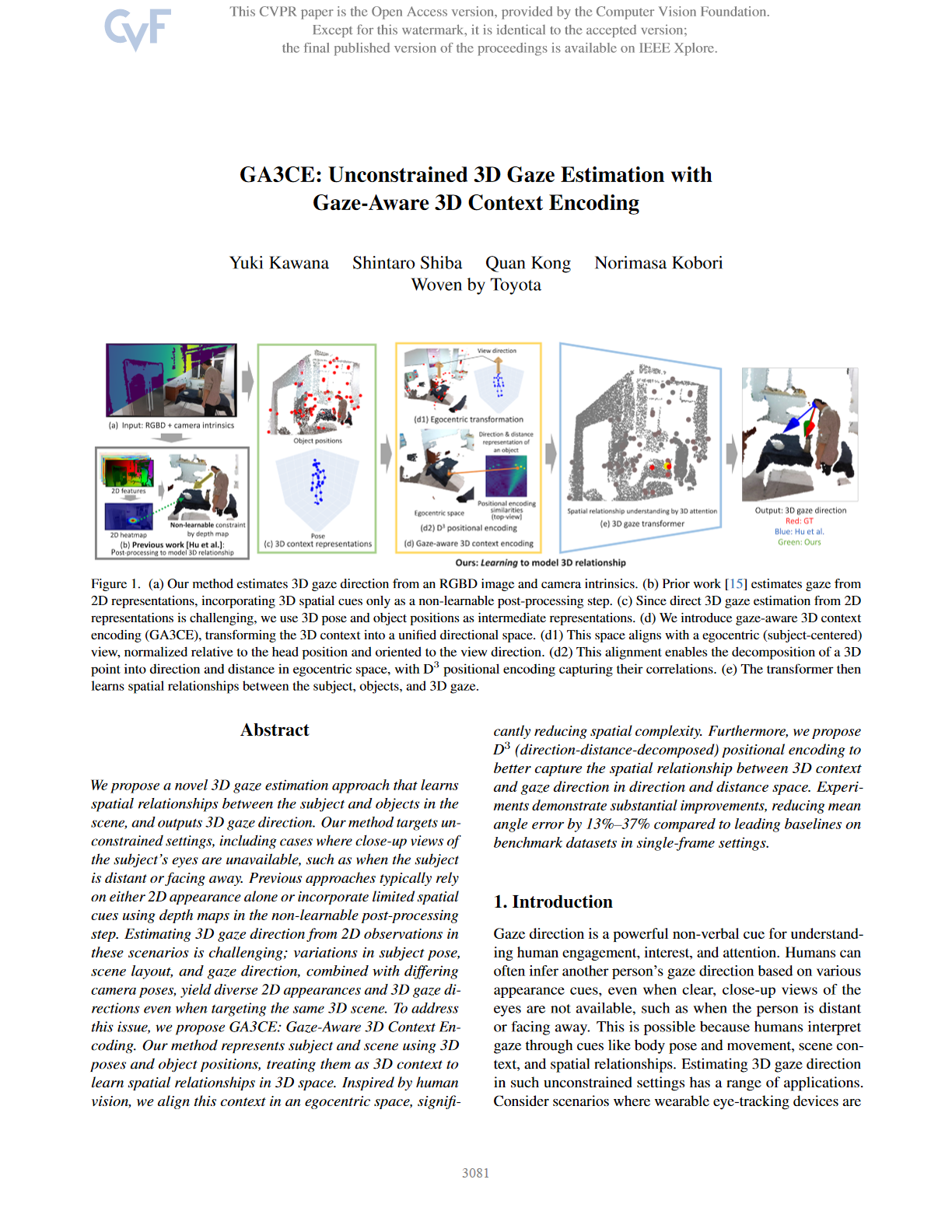

🧩面临问题:无约束场景下 3D 视线估计存在诸多挑战。一方面,受试者可能距离较远或背对镜头,导致眼睛特写不可得;另一方面,相机姿态变化会使相同 3D 场景的 2D 外观和 3D 视线方向产生差异,而传统方法要么依赖 2D 外观,要么仅在非学习型后处理中融入有限空间线索,忽略了受试者、场景与视线方向间的空间关系134。

🎯创新点及其具体研究方法:

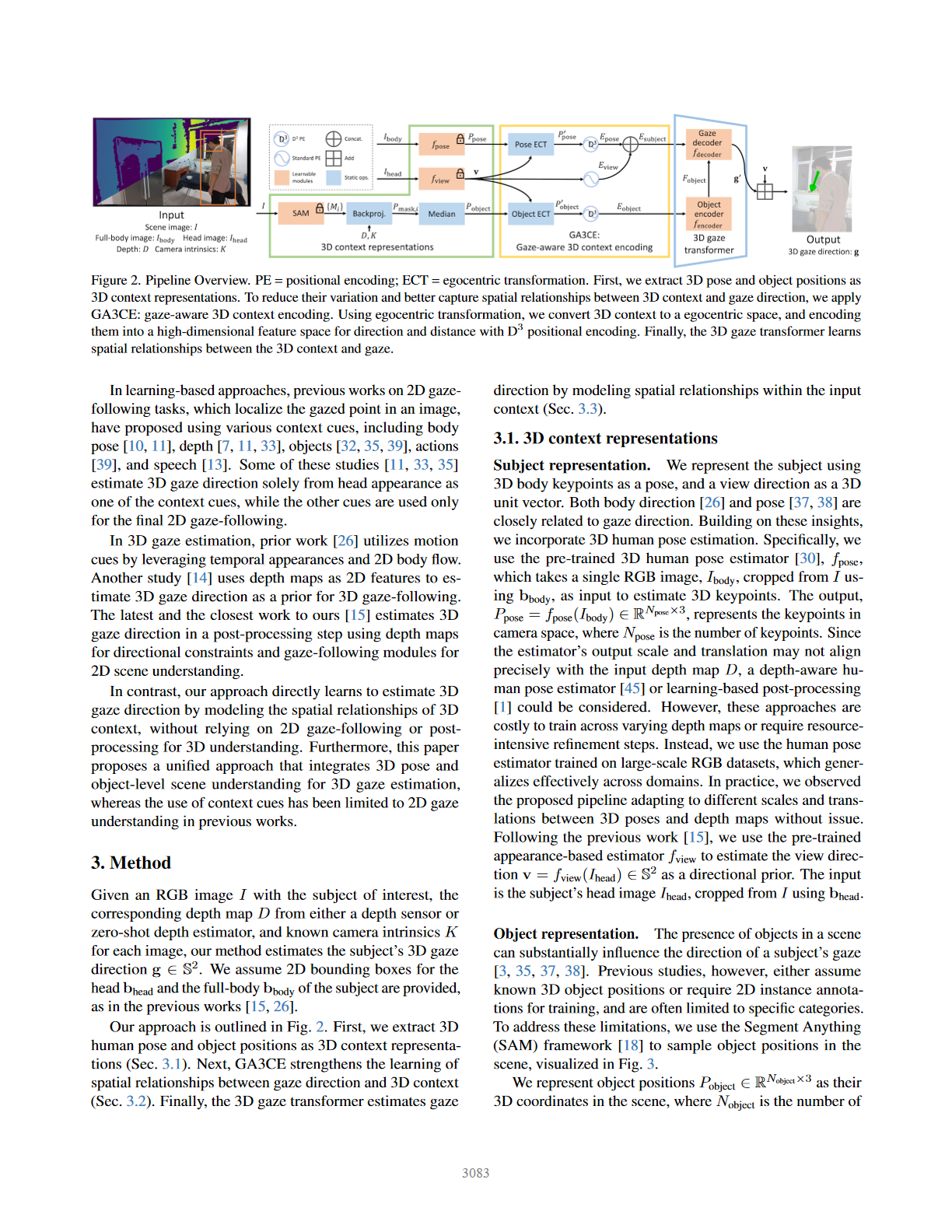

1️⃣ 提出基于 3D 空间关系理解的新方法:以 3D 姿态和物体位置作为中间表示,替代直接从 2D 外观估计 3D 视线方向,通过建模受试者与场景物体的空间关系实现估计25。

2️⃣ 提出 Gaze-Aware 3D Context Encoding(GA3CE):- egocentric transformation:将 3D 姿态和物体位置归一化到以受试者为中心的坐标空间,通过旋转使受试者视线方向与固定方向对齐,减少相机姿态带来的变化,还引入 cyclotorsion rotation 提升变换一致性789。- D³ positional encoding:将 3D 点分解为方向和距离组件,采用正弦函数分别编码后拼接,更好捕捉空间关系中方向和距离的相关性1011。

3️⃣ 设计 3D gaze transformer:编码器处理物体嵌入生成物体特征,解码器以受试者嵌入为查询,通过交叉注意力聚焦相关物体特征,学习空间关系并输出视线方向,最后反转归一化得到最终结果121314。

4️⃣ 在三个基准数据集上验证:在 GFIE、CAD-120 和 GAFA 数据集上进行实验,相比主流基线方法,将平均角度误差降低 13%-37%,展示了方法在不同场景下的有效性和泛化能力615🔷1-94🔷🔷1-98🔷。