在本篇博客中,我将分享如何在本地通过 Ollama 部署并运行 DeepSeek R1 1.5B 模型,并结合 Open WebUI 提供可视化交互界面,方便测试模型效果。

一、前置准备

请确保你已经具备以下环境:

-

Windows / macOS / Linux 系统

-

已经安装 Docker 与 Docker Desktop

-

已经安装 Ollama

安装 Ollama

-

Windows 用户可直接下载 Ollama 官方安装包 并运行安装程序。

-

macOS / Linux 用户可通过命令安装:

curl -fsSL https://ollama.com/install.sh | sh

安装完成后,执行:

ollama --version若能正常显示版本号,说明 Ollama 已成功安装。

二、运行 DeepSeek R1 1.5B 模型

Ollama 提供了直接拉取并运行模型的方式,只需执行:

ollama run deepseek-r1:1.5b首次运行时会自动拉取 deepseek-r1:1.5b 模型文件(可能较大,需耐心等待)。

如果希望以后台服务方式运行,可以执行:

ollama serve这会在本地启动 Ollama API 服务(默认地址为 http://localhost:11434)。

如果是在本地,直接安装完ollama之后,直接启动ollama就可以了。

三、结合 Open WebUI 本地测试

-

确保本地已经安装并运行 Docker Desktop。

-

在终端(Windows PowerShell / macOS / Linux Shell)中运行:

docker run -d

--name open-webui

-p 3000:8080

-e OLLAMA_HOST=http://host.docker.internal:11434

ghcr.io/open-webui/open-webui:latest

说明:

-

-p 3000:8080表示本地访问端口为http://localhost:3000 -

OLLAMA_HOST设置为 Ollama 本地服务地址

-

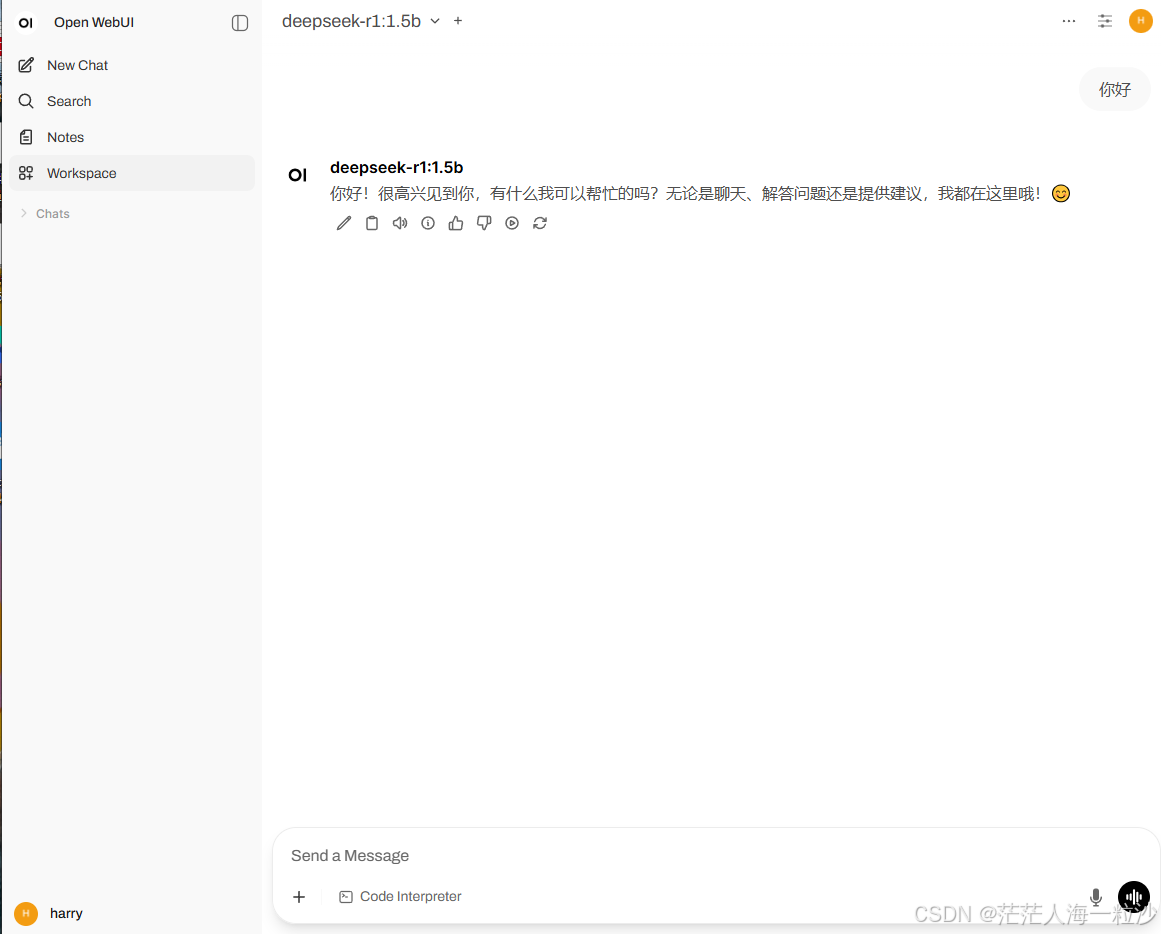

打开浏览器,访问:

如果你没有docker desktop

运行下面两个命令

pip install open-webui

open-webui serve即可进入 Open WebUI 界面。

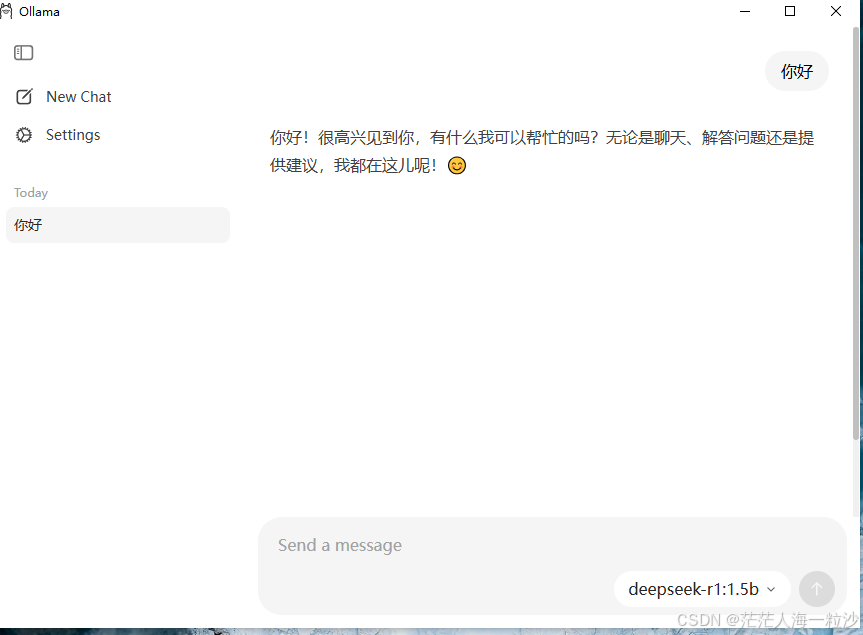

- 在设置中选择

deepseek-r1:1.5b,保存后即可直接与模型交互。

四、总结

通过以上步骤,你就可以在本地:

-

安装并运行 Ollama

-

拉取并启动 DeepSeek R1 1.5B 模型

-

部署 Open WebUI 提供可视化界面

这样,你可以轻松在 本地环境 中测试与使用大模型,无需依赖远程服务器,既安全又高效。