前言

上一篇文章解读了InternVLA-N1,本文则来解读下 同样来自上海AI LAB的InternVLA-A1

第一部分

1.1 引言与相关工作

1.1.1 引言

如原论文所述,VLA 模型构建在多模态大语言模型之上,并在海量真实世界机器人示范数据集上进行训练,在叠衣服、清理餐桌等日常任务中表现出色

然而,这些模型的泛化能力仍然难以满足实际应用需求。它们对场景变化的适应性依然不足,例如涉及工业传送带的动态环境

现有策略在泛化能力上的瓶颈主要源自两个问题:

-

对物理世界的认知不足

要解决这第一个挑战,需要引入基础模型,例如

多模态大语言模型MLLMs

Alayrac et al., 2022; Flamingo

Beyer et al., 2024; Paligemma

Chen et al., 2025a; Eagle 2.5

Touvron et al., 2023 Llama 2或世界模型

Assran et al., 2025; V-jepa 2

Blattmann et al., 2023b; 即Stable video diffusion: Scaling latent video diffusion models to large datasets

HaCohen et al., 2024; 即Ltx-video: Realtime video latent diffusion

Zheng etal., 2024,即Open-sora以增强认知能力

-

缺乏自适应操作能力

而要解决这第二个问题,则需要用于技能学习的大规模、多样化机器人数据集

因此,实现通用策略需要一种在模型架构与训练数据两个层面协同推进的综合策略

-

在模型架构方面

现有的通用策略,例如基于MLLMs 的π0(Black et al.,2024) 和GROOT N1 (Bjorck etal., 2025),通过将视觉数据映射到基于文本的特征空间来构建。尽管这赋予了它们强大的语义理解能力,但文本token 并不适合建模物理定律,导致其在物理动力学推理方面存在不足因此,这些策略更适合用于反应式的从感知到动作映射,而不是推理状态在运动和接触作用下将如何演化。这一局限性在动态环境中尤为明显,例如工业传送带场景 中,理解动量、惯性和接触动力学至关重要

近期的研究尝试通过World Models引入前瞻能力,尤其是通过诸如VPP (Hu et al., 2025) 和Genie Envisioner (Liao et al., 2025) 等视频预测范式。这些方法生成预期观测来引导决策,但往往存在语义基准较弱且对预测误差敏感 的问题

------------

因此,开发一种在语义理解与稳健预测动力学之间实现紧密耦合的统一架构,仍然是实现可扩展且可靠的、具备动力学感知能力操控的关键 -

在训练数据方面

现有的 VLA 模型通过扩展大规模真实机器人数据集来获得适应性,而当前的通用策略在很大程度上依赖于此类真实机器人数据(Bu et al., 2025; Walke et al.,2023; Wu et al., 2024b)。例如,开创性工作收集了 130,000 个 episode 来训练RT-1(Brohan et al., 2022)和 RT-2(Brohan et al., 2023),随后的项目又从 22 台异构机器人中聚合了超过一百万条示范,用于构建 Open X-Embodiment(O'Neill et al.,2024)

然而,仅依赖真实世界采集仍然具有挑战性:在大规模上覆盖长尾场景变化既昂贵又低效,而不同具身形式之间的高度异质性则进一步加剧了联合训练的复杂性

例如,尽管 π0 在来自七种机器人形态的 68 个任务上进行了合计 10,000 小时的训练,从而在灵巧操作方面表现出色,但其对场景变化的鲁棒性仍然有限

归根结底,在这一规模上进行端到端训练会带来极其高昂的成本,而在长尾场景泛化上的收益却不断递减,使得进一步扩大规模的代价高得难以承受相比之下,仿真提供了一种很有前景的互补方法。其丰富的场景和物体库增强了样本多样性,而域随机化通过模拟场景变化来提升策略在变化环境中的鲁棒性

此外,仿真通过剔除噪声数据,可以获得更可控的轨迹

例子,作者此前的工作 InternData-A1 证明,大规模且高保真度的仿真数据能够有效支撑 VLA 模型的预训练

然而,仿真数据不可避免地存在从仿真到现实(sim-to-real)的鸿沟,尤其是在接触密集的动力学场景中

因此,将仿真数据的多样性与真实世界数据的物理逼真度进行协同融合,为克服各自的局限性提供了一条极具前景的路径

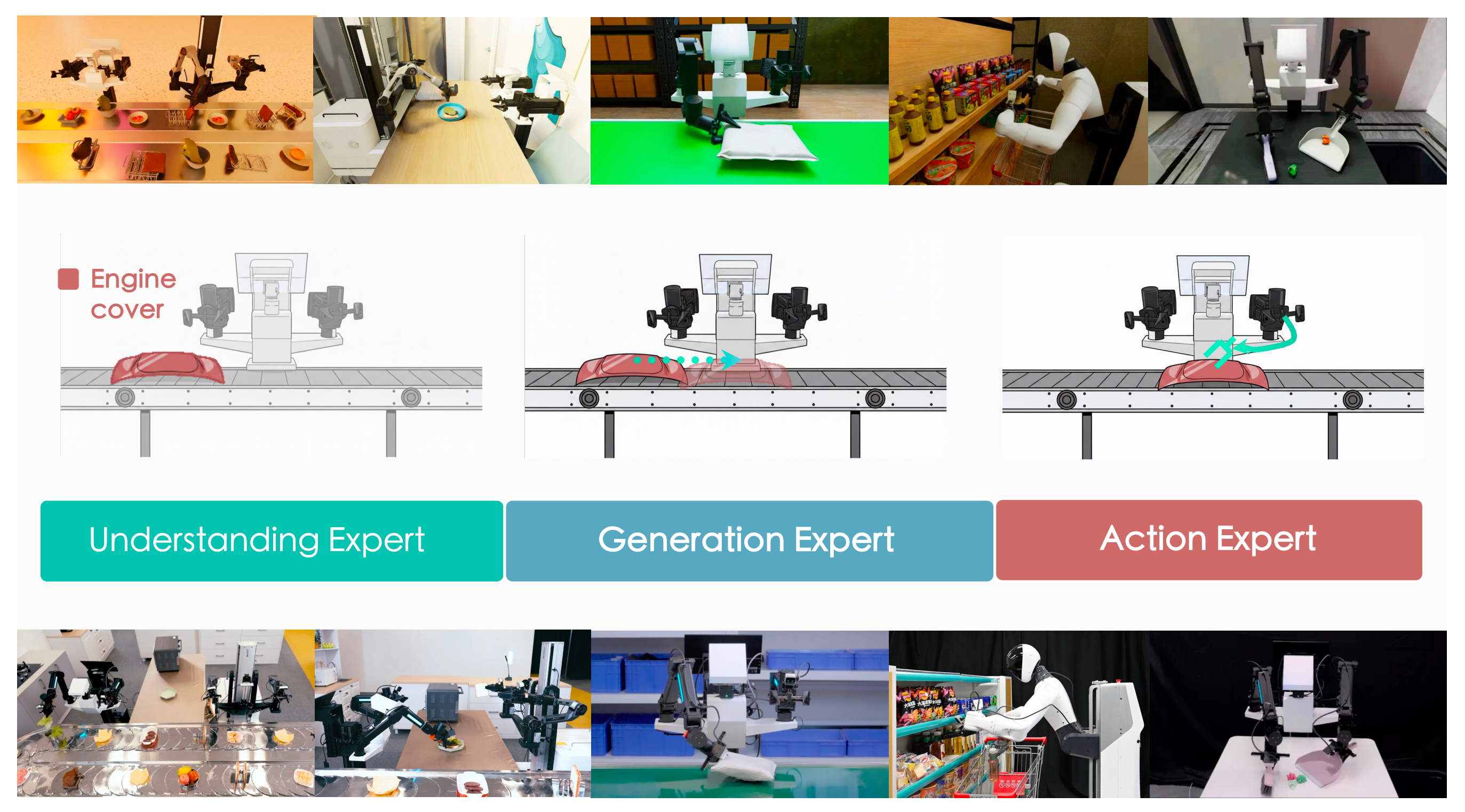

为了解决上述泛化挑战,特别是针对动态场景变化的鲁棒性问题,来自的研究者提出了InternVLA-A1『InternVLA-A1 将理解、生成和行动专家整合为一个统一的模型,通过协同语义推理与动态预测来指导行动执行』

如图1 所示,该模型具有一种融合了理解、想象和行动的新颖架构。InternVLA-A1 将多模态大模型MLLM的语义推理能力与类World Model 想象模块的预测能力相结合。这样的设计有效弥合了语义与物理动态之间的鸿沟,从而促进具备前瞻性的动作生成

此外,为了在场景变化下提供鲁棒性所需的多样性,作者构建了一个由互补数据源组成的数据金字塔:

- 大规模开源机器人数据,用于广泛的场景理解和物理先验;

- 模拟的合成数据,用于对多样场景进行可扩展且可控的覆盖;

- 以及少量专门的真实机器人数据,用于在真实世界中校准动作执行

通过将仿真作为一种可扩展的变化来源纳入训练,作者可以以较低成本扩展对长尾场景配置的覆盖。同时,通过真实机器人数据对策略进行锚定,从而避免仅依赖仿真学习的陷阱,这有助于纠正因真实世界感知和物理交互带来的迁移偏差

1.1.2 相关工作

在本节中,作者从模型架构和训练数据两个方面,将 InternVLA-A1 与当前方法进行对比

首先,在视觉-语言-行动模型中

该领域已转向将基础模型的多模态能力与机器人控制相结合

- RT-2(Brohan etal., 2023)率先在机器人轨迹和互联网规模数据上对MLLM 进行联合微调,从而实现了涌现的推理能力

- 有别于RT-2 基于离散token 的方法,π0(Black et al., 2024)将预训练的MLLM 与flow matching 相结合,以利用互联网规模的知识来控制多种不同形态的机器人

- 在此基础上,π0.5(Black et al., 2025)将预训练目标与动作预测(相当于子任务预测)相融合,从而提升了对长时任务的语义推理能力

- 为了更好地将MLLM 能力与实时控制协同起来

GR00T N1(Bjorck et al., 2025)提出了一种将推理与基于扩散的动作生成解耦的双系统架构

其后继模型GR00T N1.5 进一步改进了指令跟随能力和跨形态兼容性

不同于这些方法,InternVLA-A1 统一了MLLM 的语义理解能力与动力学预测能力,有效弥合了现有VLA 架构中普遍存在的语义-动力学鸿沟

其次,在视频预测和世界模型中

大量研究致力于在动作条件下模拟真实世界动力学,以促进机器人控制(Hunget al., 2025; Zhang et al., 2025; Zhu et al., 2025)

-

UniPi (Du et al., 2023) 训练了一个文本条件的视频生成器,并配合逆动力学模型来推导动作,而UniSim (Yang et al., 2024) 则采用生成式建模来构建一个通用模拟器,用于训练高层和低层策略

-

越来越多的视频预测策略------包括CLOVER (Bu et al., 2024b)、VPP (Hu etal., 2025)、GR-1 (Wu et al., 2024a)、GR-2 (Cheang et al., 2024) 和F1 (Lv et al., 2025),整合了未来状态建模或带动作预测的视频生成,旨在利用大规模视频预训练中学到的丰富表征

为了弥合动作空间与视觉空间之间的鸿沟,Seer(Tian et al., 2025a)提出了一种端到端的逆动力学模型,该模型根据预测的视觉状态生成动作

同时,Genie Envisioner(Liaoet al., 2025)通过采用多视角视频扩散模型来增强空间理解能力

尽管取得了这些进展,这类策略往往对视频生成质量十分敏感,并且缺乏多模态大语言模型(MLLMs)所固有的语义推理能力

相比之下,InternVLA-A1 将 MLLM 与未来状态预测相结合,从而内化动作与世界动力学之间的因果关系

最后,在机器人操作数据中,数据集可分为真实世界和仿真两大类

-

真实世界数据集(Bu etal.,2025; Khazatsky et al.,2024; Walke et al.,2023; Wu et al.,2024b)捕捉了实际环境中固有的物理复杂性,通过使模型能够端到端地学习行为,为当前的进展奠定了基石

例如,RT-1 和 RT-2 的训练流水线构建在约 130,000 段遥操作轨迹之上(Brohan etal.,2022,2023)

Open X-Embodiment 数据集(O'Neill et al.,2024)则汇集了来自多个来源的一百万段轨迹然而,这类数据内在的显著异质性,为训练具有良好泛化能力的VLA 模型带来了新的挑战

-

仿真数据(Chen et al.,2025c; Gao et al.,2025; Gu etal.,2023; Hua et al.,2024; Huang et al.,2025a; James et al.,2020; Lian et al.,2025;Mandlekar et al.,2023; Mees et al.,2022)则利用照片级真实感渲染、程序化场景生成以及域随机化等技术,高效扩展数据采集规模

例如,Robocasa(Nasiriany et al.,2024)通过将人类遥操作与轨迹增强相结合来生成示范,但对遥操作的依赖仍然需要大量人工投入

另一种方案 GraspVLA(Deng et al.,2025b)通过自动化流水线生成动作数据,不过其当前范围依然局限于抓取任务

新近提出的 InternData-A1(Tian et al.,2025b)引入了一个大规模仿真示范数据集,包含超过 63 万条轨迹和 7,433 小时的数据,覆盖多种具身形式、技能、任务和场景

值得注意的是,在 InternData-A1 上预训练的模型已经表现出与 π0 相当的性能

在本工作中,作者提出了一种将 InternData-A1 与真实世界数据集混合的数据配方,实证表明这一组合提高了数据多样性,并有效缩小了仿真到真实的差距

1.2 InternVLA-A1:统一的理解-生成-行动框架

本节介绍 InternVLA-A1 的设计,作者首先给出整体架构概览,随后依次描述其各个组件、优化目标以及实现细节

Mixture-of-Transformers(MoT)架构近年来被广泛应用于统一式多模态大语言模型中(Deng et al., 2025a),在理解与生成任务上都展现出强大性能

受这些统一范式的启发,InternVLA-A1 采用 MoT 架构,将场景理解、视觉前瞻与动作执行无缝整合于同一框架之中

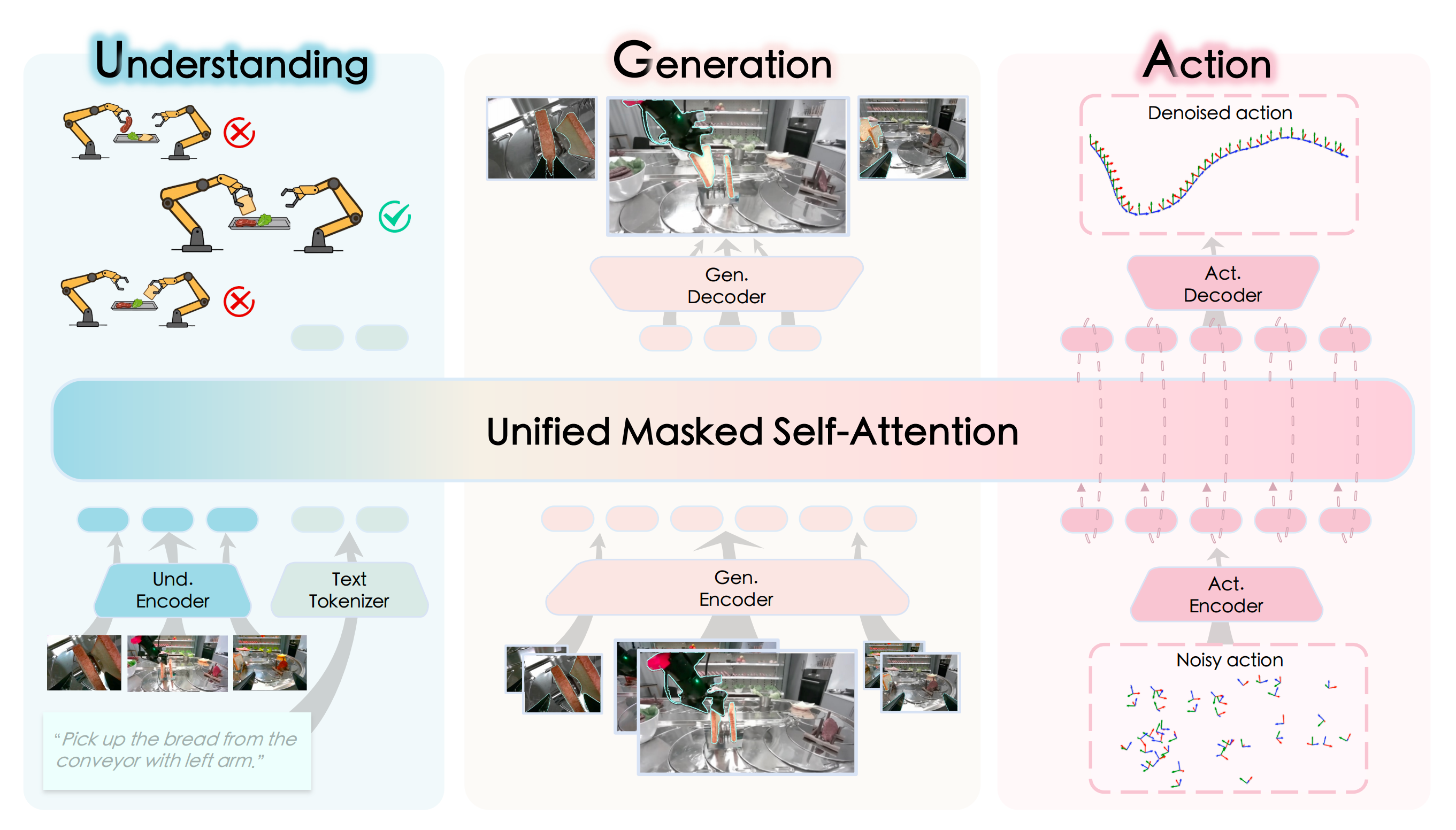

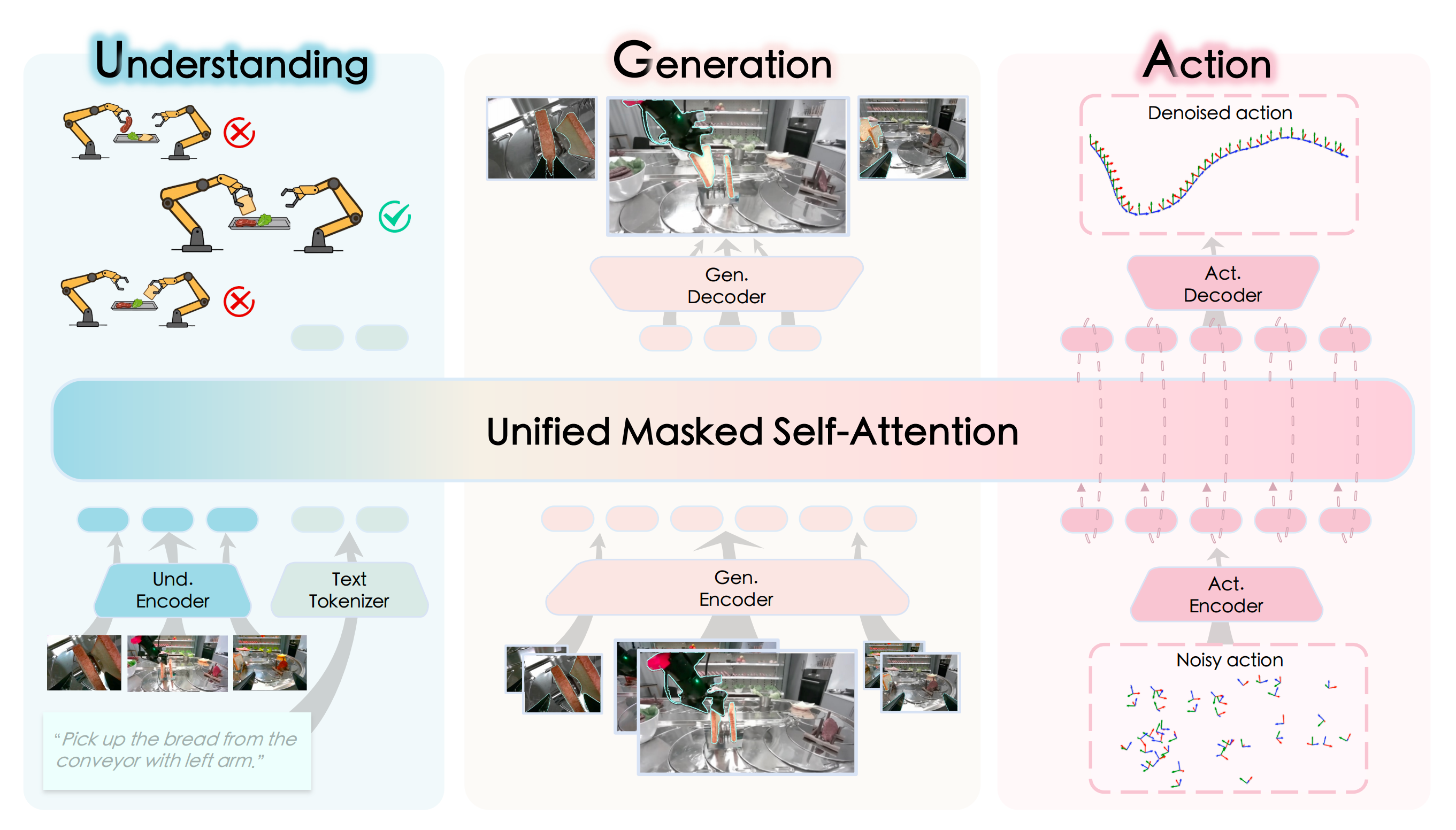

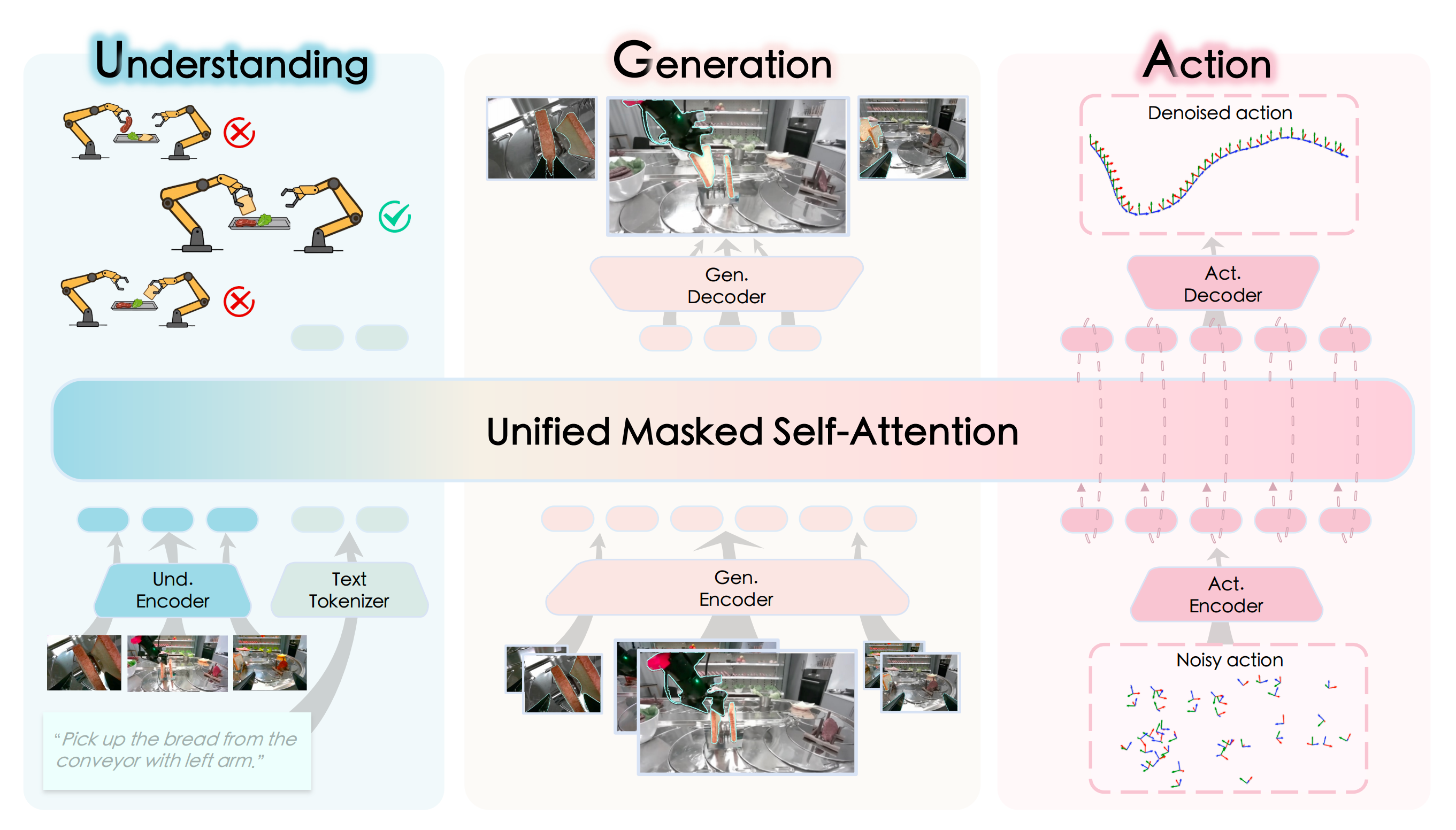

如图 2 所示

InternVLA-A1 在一个统一的流水线上采用了三个专家模块

- 理解专家首先处理多模态输入,以捕获环境上下文

即用于从图像和文本输入中编码场景上下文 - 这些表征随后用于指导生成专家,其通过预测未来状态 来模拟任务的演化

即用于预测未来的视觉状态和任务动力学 - 最后,动作专家将这些预测动态与语义上下文相结合,利用Flow Matching 生成精确的机器人控制指令

即通过 Flow Matching 将已编码的场景上下文与这些预测的动力学进行融合,从而合成控制指令

1.2.1 统一的理解-生成-行动 Transformer

受多模态大语言模型成功实践的启发,InternVLA-A1 中的三位专家均采用仅含解码器的 Transformer 架构

-

理解专家

理解专家直接采用现有MLLMs 的架构。在本实现中,作者采用InternVL3 或Qwen3-VL,它们以原生的多模态能力以及语言与视觉之间的强对齐而著称作者遵循基础MLLMs 的处理流程:在时间

的多视角观测,记作

,通过集成视觉编码器被编码为视觉token,而语言指令

通过文本分词器被转换为文本token

随后,这些视觉和文本token 被连接起来,形成用于约束下游专家的前缀token

-

生成专家

受统一多模态模型Janus Pro (Chen et al., 2025e) 的启发,作者采用了一种解耦的视觉编码策略,以应对理解与生成之间截然不同的需求

理解任务通常需要由基于ViT 的编码器捕获的高层语义抽象,而生成任务则要求保留精细的空间结构和像素级保真度为弥合这一差距,作者的生成专家采用了基于VAE 的分词器,该分词器广泛应用于图像和视频生成中,因其能够将视觉数据压缩到针对高质量重建而优化的潜在空间

具体而言,作者使用Cosmos CI8 × 8 连续VAE 分词器(Agarwal et al., 2025) 将输入图像编码为连续潜在特征,为后续的生成过程提供稠密且结构丰富的表示该分词器由编码器和解码器组成;即将其编码器记为

并使用解码器来从潜变量重建图像。令

表示在时间戳

的Cosmos 潜变量;

在给定和

的条件下,生成专家预测

尽管生成模型取得了显著进展,将其应用于VLA 领域仍然面临重大挑战:需要高频率的实时推理

传统的图像和视频生成模型

无论是基于扩散(Blattmann et al., 2023a; Rombach et al., 2022)

还是基于下一token预测(Sun et al., 2024)

通常都过于缓慢,难以满足这一需求即便是像SANA-Sprint (Chen et al., 2025b)这样的优化方案,每次生成也需要0.16 秒,将控制频率限制在低于6Hz 。这一限制阻碍了机器人的流畅运动,凸显了在具身智能中对更快速视觉生成机制的迫切需求

在作者之前的工作F1 (Lv et al., 2025) 中,作者采用了一种next-resolution 范式来生成视觉前瞻。尽管这一方法是有效的,但它需要迭代的前向传播,从而削弱了对VLA 任务至关重要的实时推理能力。因此,作者采用了更为激进的设计策略来优化性能

最终,作者使用Cosmos CI8 × 8 连续VAE 图像分词器,对来自两个时间戳(当前帧和一个历史帧)的三个视角图像进行处理

------------

将输入图像调整为256 × 256 后,每张图像首先被编码为32 × 32 的潜在特征图。若直接将这些潜在token 输入到生成专家中,将导致序列长度过长,从而影响推理效率和训练收敛

为此,作者应用一个卷积层将每个潜在特征的空间维度压缩到4 × 4(即每张图像仅用16 个token 表示),并使用一个投影器将其对齐到transformer 的隐藏维度

然后,这些压缩后的token 被输入到生成专家中,通过多层掩蔽自注意力机制,关注前缀token(在推理时缓存为K/V)

其隐藏状态在时间维度上进行池化,以形成预测的未来潜变量,并以第

帧的Cosmos 编码

作为监督信号

最后,预测的未来潜变量通过反卷积层和投影器上采样回原始VAE 潜在维度

这些还原后的特征随后被输入Cosmos 解码器,用于重建预测图像 -

动作专家

以语言目标、当前观测

(通过前缀token

)、本体感觉

以及生成专家预测的潜在token

为条件,动作专家预测目标动作片段

作者采用流匹配目标来训练VLA 模型

此外,作者在理解、生成和行动专家拼接后的token 序列上实现了块状注意力掩码。一个累积分段掩码强制严格的信息流为理解→生成→行动:

- 后续块中的token 可以注意到所有更早的块,而较早的块不能向前注意,前缀块(视觉+ 语言)是完全双向的

- 生成块同样是完全双向的,并且只接收来自帧

和

的Cosmos 潜在token

- 行动块被划分为一个状态token 和若干行动token:状态token 只关注自身和更早的块,而行动token 则关注状态token 以及彼此之间

// 待更