Tip: 如果你在进行深度学习、自动驾驶、模型推理、微调或AI绘画出图等任务,并且需要GPU资源,可以考虑使用UCloud云计算旗下的Compshare的GPU算力云平台。他们提供高性价比的4090 GPU,按时收费每卡2.6元,月卡只需要1.7元每小时,并附带200G的免费磁盘空间。通过链接注册并联系客服,可以获得20元代金券(相当于6-7H的免费GPU资源)。欢迎大家体验一下~

0. 简介

本文介绍了《P2O-Calib: Camera-LiDAR Calibration Using Point-Pair Spatial Occlusion Relationship》:利用点对空间遮挡关系的相机-激光雷达标定。传感器精确且鲁棒的标定结果被认为是自动驾驶和机器人领域中后续研究的一个重要组成部分。目前涉及3D激光雷达和单目相机之间外参标定的工作主要着重于基于目标和无目标的方法。基于目标的方法通常由于限制(例如额外的目标设计和目标放置限制)而离线使用。目前的无目标方法在各种环境中均存在特征不确定性和特征误匹配的问题。为了缓解这些限制,本文提出了一种新型的基于2D-3D边缘点提取的无目标标定方法,其使用3D空间中的遮挡关系。基于提取的2D-3D点对,我们进一步提出了一种遮挡引导的点匹配方法,其提升了标定精度并且降低了计算成本。为了验证本文方法的有效性,我们在KITTI数据集的现实图像上定性和定量地评估了方法的性能。结果表明,本文方法优于现有的无目标方法,实现了低误差和高鲁棒性,这有助于依赖高质量相机-激光雷达标定的实际应用。

1. 主要贡献

本文提出了一种新颖的无目标外部标定方法,该方法利用统一的2D-3D遮挡特征,在各种场景下实现了稳健的估计 。对于摄像头图像的特征提取,我们之前的工作[15]引入了像素对遮挡关系的概念,使我们能够提取带有空间遮挡信息的图像边缘点 。在这项工作中,我们利用遮挡关系的定义,在LiDAR点云上进行3D遮挡边缘提取 ,并开发了一种利用提取的2D-3D点对的新型标定方法。此外,遮挡关系为更稳健的跨模态特征关联提供了有益的指导,可以容忍来自摄像头-LiDAR外部参数初始猜测的更大误差。与在真实世界数据集KITTI上评估的先前工作相比,所提出的方法提高了摄像头-LiDAR外部标定的准确性和泛化能力。

这项工作的主要贡献包括:

- 基于遮挡关系设计了系统化的摄像头-LiDAR外部标定流程。它适用于在线现场标定,并且无需外部标定目标。

- 提出了一种新颖的点云特征提取方法及相应的2D-3D边缘特征匹配方法。所提出的方法利用定向遮挡信息减少了特征注册不匹配,并且对不完美的特征提取具有稳健性。

- 在合成和实际数据集上的实验验证了所提出方法的有效性,包括消融实验以及对准确性、稳健性和泛化能力的检验。我们将发布我们的代码和数据集。

2. 具体方法

这一部分详细阐述了提出的摄像头-LiDAR外参校准方法。该流程包括三个步骤:首先,我们训练了一个P2ORNet神经网络,用于在RGB图像上进行像素级遮挡边缘识别,并从给定的点云中提取3D遮挡边缘 。然后,我们提出了一种基于遮挡的匹配策略,用于在2D像素和3D点之间制定perspective-n-point(PnP)问题。随后,通过优化点到线的重投影误差,最终获得外参校准矩阵。图2勾勒了提出的框架,接下来的小节将详细介绍遮挡关系的定义以及每个组件中的方法。

图2. 所提出方法的架构。我们的方法首先从输入的2D-3D数据中提取2D-3D遮挡边特征点,然后应用遮挡引导的特征匹配来对齐它们。随后,对匹配的2D-3D点对进行优化,以恢复相机和激光雷达之间的外部参数。左右遮挡边点着以绿色和红色标记,而上下遮挡边点着以黄色和蓝色标记。为了清晰起见,在2D-3D特征匹配模块中仅可视化了左右遮挡边。最佳观看方式为数字版本。

3. 2D-3D点对定义

在本节中,我们正式定义了2D-3D遮挡边缘的概念,并使用遮挡关系来定义图像2D点和LiDAR 3D点之间的点对。如图3(a)所示,我们考虑一个位于 C C C处的摄像机和一个位于 L L L处的LiDAR,它们观察到3D场景的空间表面 ( S i , S j ) (S_i,S_j) (Si,Sj),参考世界坐标系 W W W。从LiDAR坐标系 L L L到摄像机坐标系 C C C的SE(3)变换是 T L C T^C_L TLC,而在本工作中,估计 T L C T^C_L TLC的任务被定义为外部标定 。我们注意到 q i q_i qi, q j q_j qj是3D点 P i P_i Pi, P j P_j Pj在表面 S i S_i Si, S j S_j Sj上的摄像机图像平面2D投影(像素) 。从 C C C和 L L L的角度来看, S i S_i Si在 S j S_j Sj的前面,遮挡边缘位于 S i S_i Si和 S j S_j Sj非遮挡部分的边界区域。在左侧遮挡边缘区域,我们将 q i q_i qi, q j q_j qj标记为2D遮挡边缘特征点 , P i P_i Pi, P j P_j Pj则是3D遮挡边缘特征点 。指向 q j q_j qj的黑色箭头表示 S i S_i Si在3D空间中从右到左遮挡 S j S_j Sj的边缘区域。通过为每个像素对分配这样的方向,遮挡边缘特征点可以进一步分为具有不同方向的特征点 (参见图3(b)),例如,在本示例中的左遮挡边缘特征点 q i q_i qi, q j q_j qj。从表面之间的遮挡关系开始,我们在这里正式定义每个2D-3D点对由LiDAR捕获的3D特征点和摄像机捕获的2D特征点组成 ,例如 ( q i , P i ) (q_i,P_i) (qi,Pi)和 ( q j , P j ) (qj,Pj) (qj,Pj)。

图3. 2D-3D遮挡边缘点对定义的示意图:(a) 图像左侧遮挡边缘区域标为绿色,对应的2D遮挡边缘点(例如, q i q_i qi, q j q_j qj)和3D遮挡边缘点(例如, P i P_i Pi, P j P_j Pj),(b):在存在三个物体1、2、3遮挡的情况下,图像左右遮挡边缘和上下遮挡边缘。

4. 图像中的遮挡边缘提取

- 图像连通性-8邻域:对于每个图像像素 q i q_i qi,它有8个直接相邻像素,包括4个水平/垂直相邻像素和4个对角线相邻像素。因此,一个图像像素可以与其8个相邻像素配对形成8个像素对。

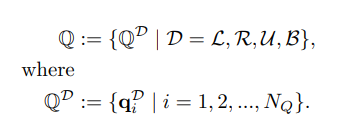

- 2D遮挡边缘估计:如第3节所介绍的,3D中的表面对遮挡关系可以表示为2D中的像素对遮挡关系 。对于每对有效的图像像素 ( q i , q j ) (q_i,q_j) (qi,qj),神经网络P2ORNet [15]对三种可能的遮挡关系状态进行分类 : q i q_i qi遮挡 q j q_j qj, q j q_j qj遮挡 q i q_i qi和( q i q_i qi和 q j q_j qj)之间没有遮挡。估计的图像遮挡边缘位于P2ORNet预测存在像素对之间遮挡的图像区域上。在本工作中,我们选择连接沿图像水平/垂直轴的像素对,并从预测结果中生成左右(L,R)和上下(U,B)遮挡边缘。我们将带有方向D的 Q D \mathbb{Q}^D QD图像2D遮挡边缘特征点集合,而 q i D q^D_i qiD是第 i i i个点。