一、基础信息

1、硬件环境:

CPU >= 2 Core

显存/RAM ≥ 16 GiB(推荐)

2、软件

(1)Ollama

Ollama 是一款跨平台的大模型管理客户端(MacOS、Windows、Linux),旨在无缝部署大型语言模型 (LLM),例如 DeepSeek、Llama、Mistral 等。Ollama 提供大模型一键部署,所有使用数据均会保存在本地机器内,提供全方面的数据隐私和安全性。

(2)Dify

Dify 作为同样开源的 AI 应用开发平台,提供完整的私有化部署方案。通过将本地部署的 DeepSeek 服务无缝集成到 Dify 平台,企业可以在确保数据隐私的前提下,在本地服务器环境内构建功能强大的 AI 应用。

(3)docker

需要使用docker拉取镜像并运行,简化部署逻辑

二、部署DeepSeek-R1

1、部署Ollama

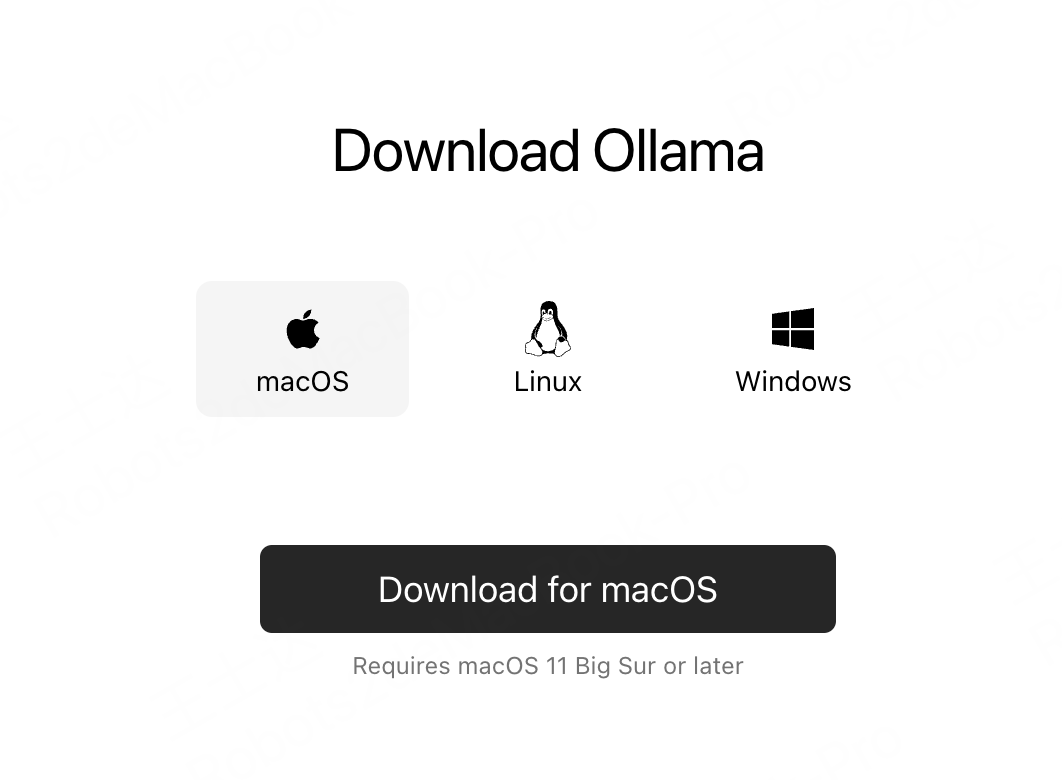

(1)打开官网

(2)下载对应系统的Ollama

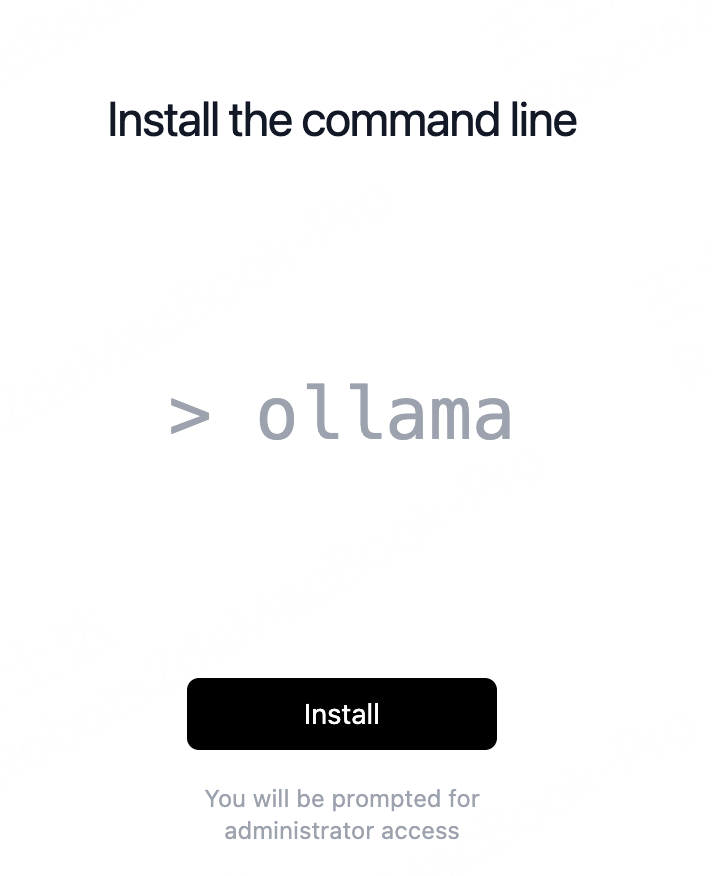

(3)安装

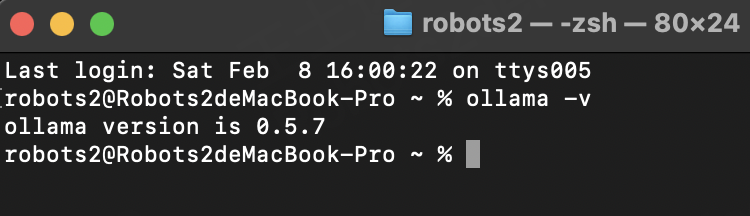

(4)验证--终端执行

ollama -v

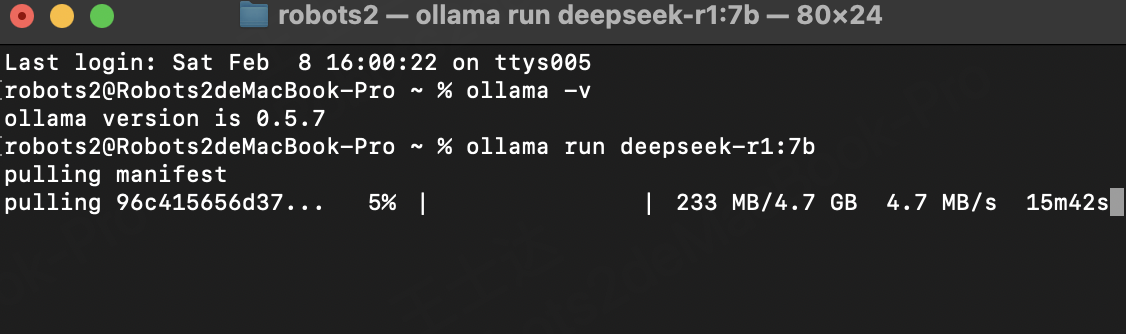

2、使用ollama安装DeepSeek-r1模型

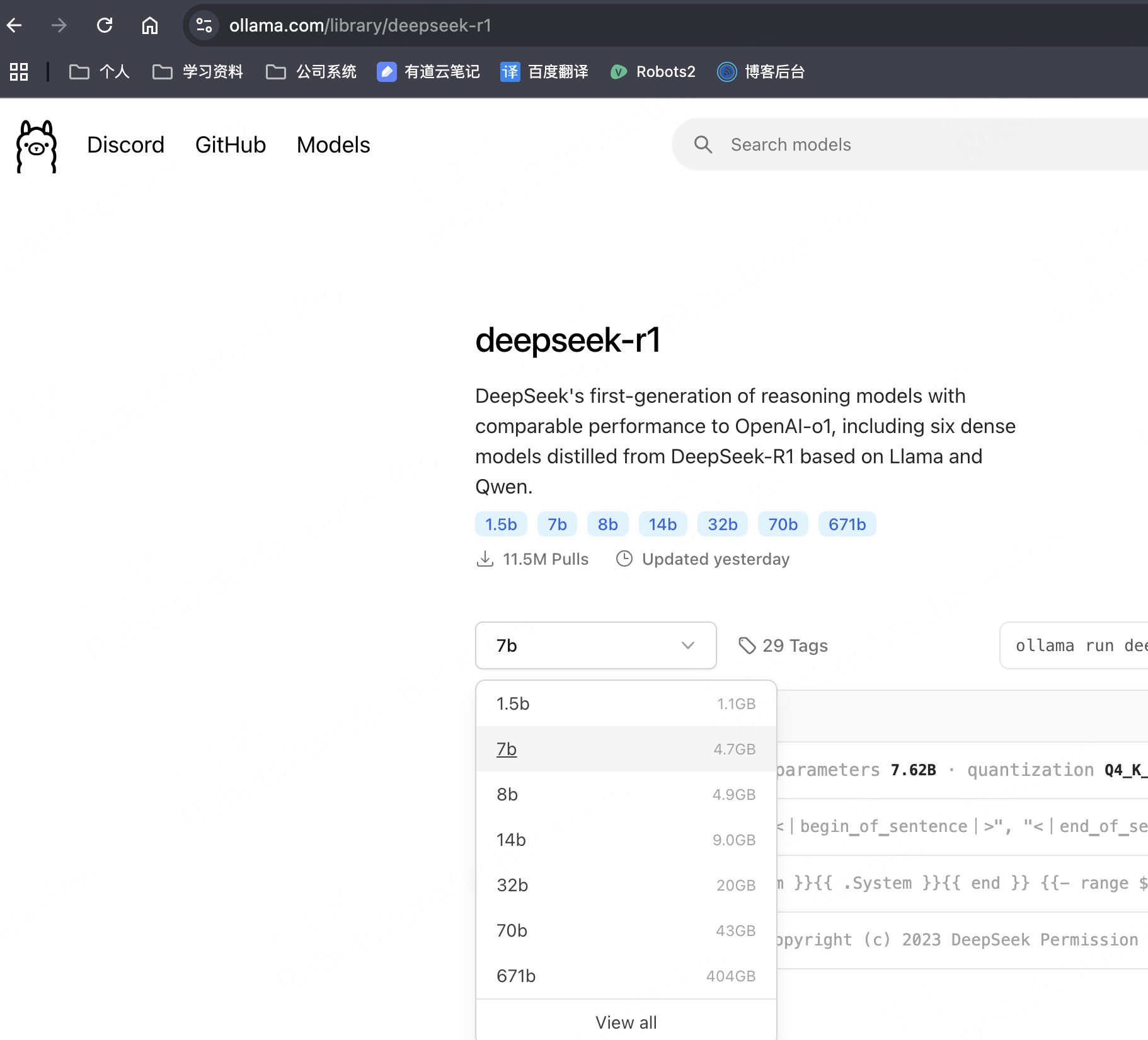

(1)ollama安装DeepSeek模型

ollama run deepseek-r1:7b

注:根据本机配置,选择合适的DeepSeek模型进行部署。本机推荐安装 7B 尺寸模型,大约需要拉取4.7GB数据,可以在ollama官网搜索模型,查看模型大小

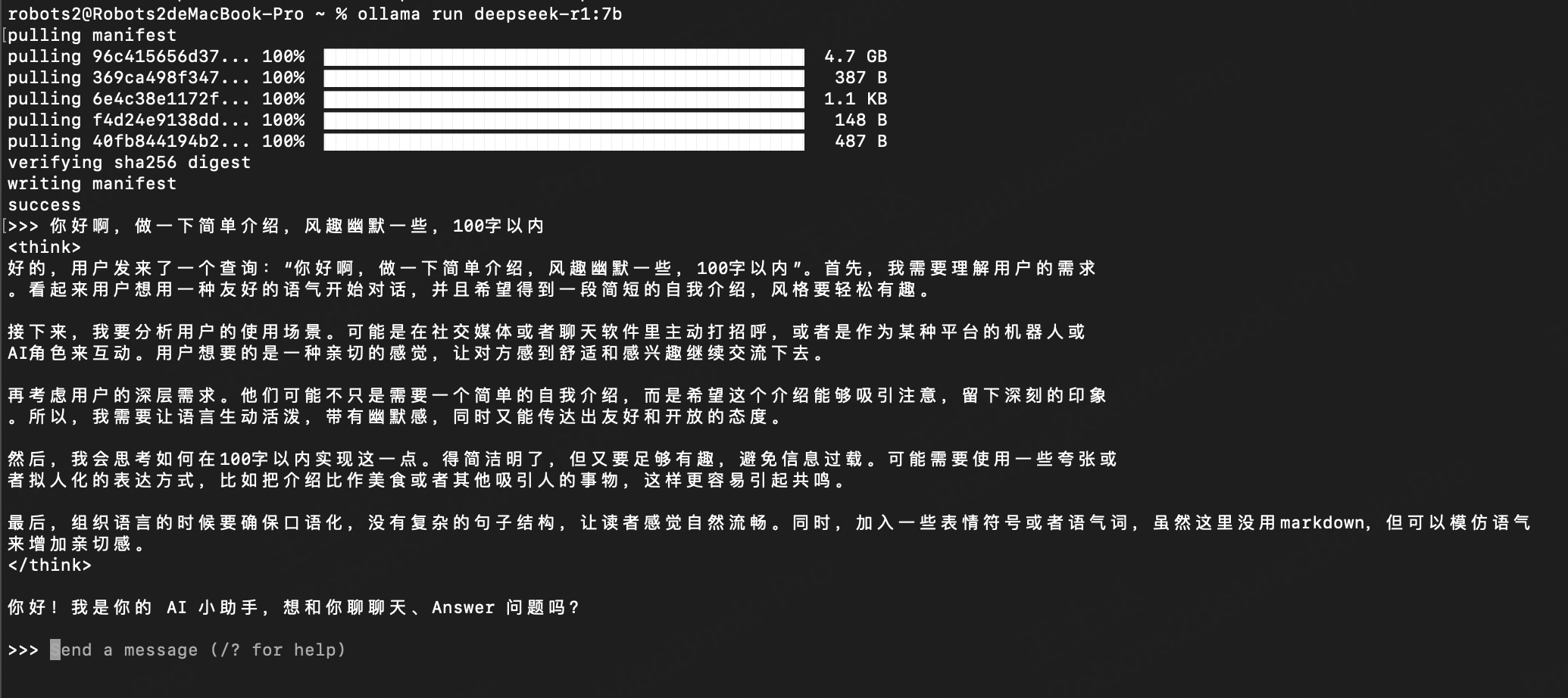

(2)安装后验证

安装完成,直接输入问题即可,可以看到回复信息

三、部署Dify社区版

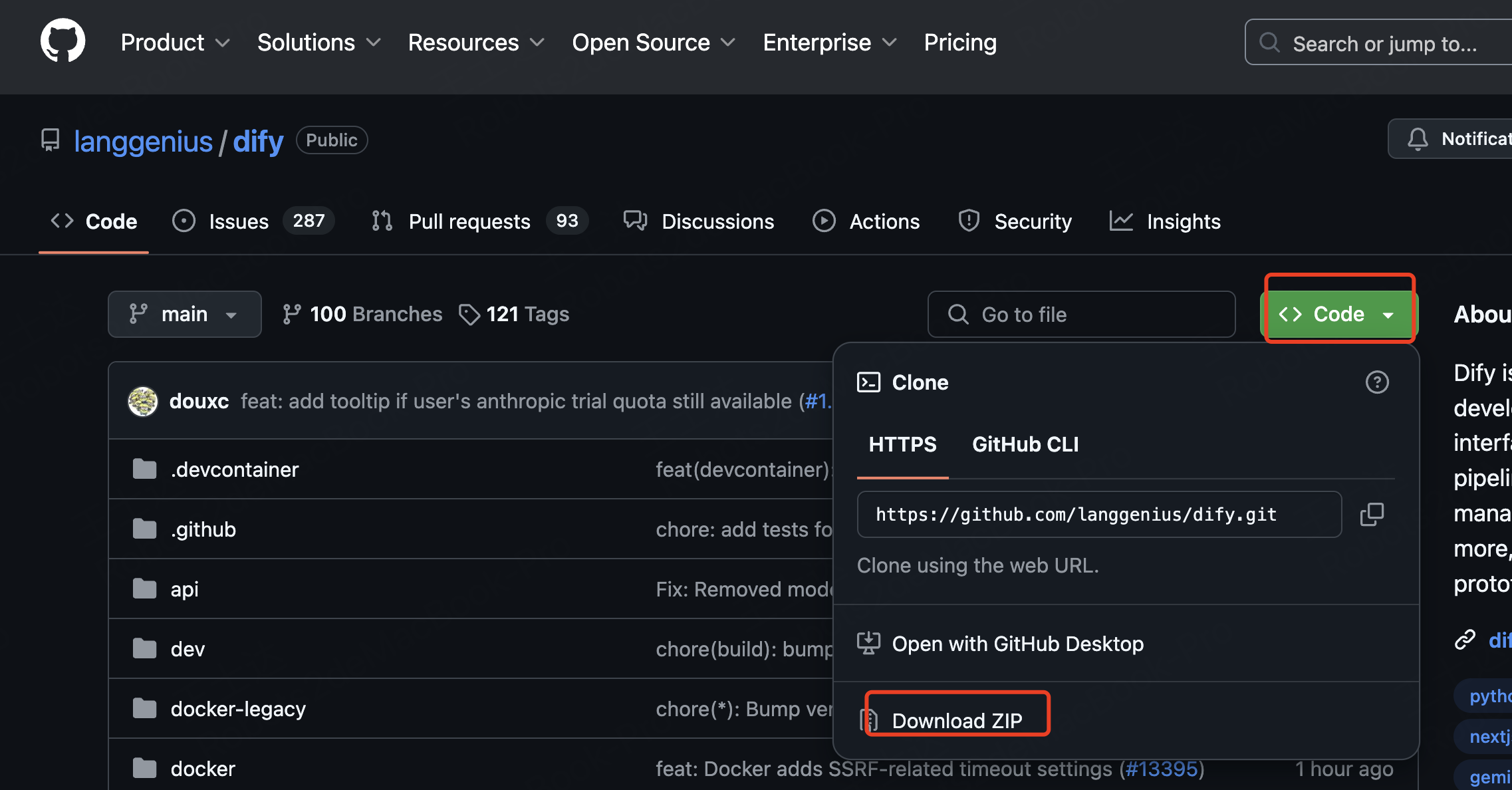

1、下载代码

(1)git方式下载

git clone https://github.com/langgenius/dify.git

(2)web方式下载

打开链接:https://github.com/langgenius/dify.git

2、进入目录

cd dify/docker

3、复制配置文件

cp .env.example .env

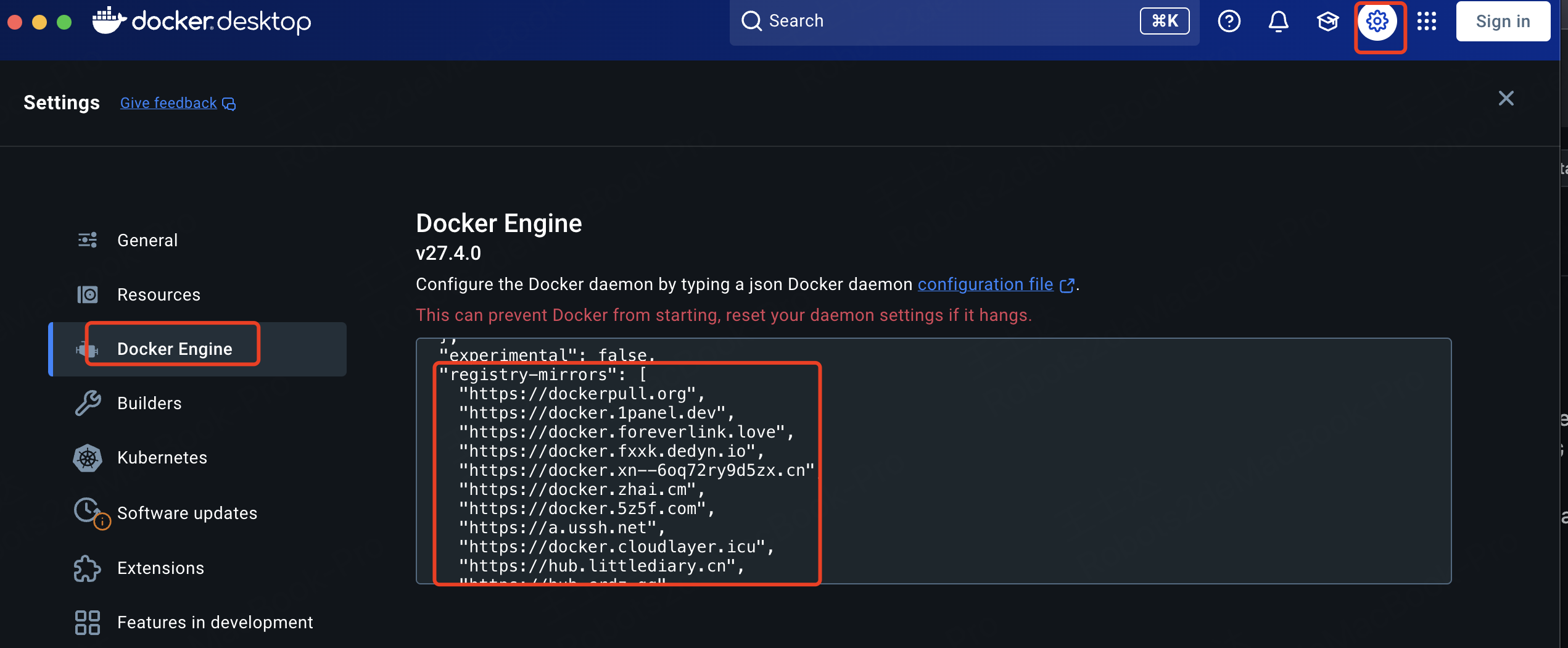

4、docker配置代理(已配置的话可以忽略该步骤)

内容如下:

"registry-mirrors": [

"https://dockerpull.org",

"https://docker.1panel.dev",

"https://docker.foreverlink.love",

"https://docker.fxxk.dedyn.io",

"https://docker.xn--6oq72ry9d5zx.cn",

"https://docker.zhai.cm",

"https://docker.5z5f.com",

"https://a.ussh.net",

"https://docker.cloudlayer.icu",

"https://hub.littlediary.cn",

"https://hub.crdz.gq",

"https://docker.unsee.tech",

"https://docker.kejilion.pro",

"https://registry.dockermirror.com",

"https://hub.rat.dev",

"https://dhub.kubesre.xyz",

"https://docker.nastool.de",

"https://docker.udayun.com",

"https://docker.rainbond.cc",

"https://hub.geekery.cn",

"https://docker.1panelproxy.com",

"https://atomhub.openatom.cn",

"https://docker.m.daocloud.io",

"https://docker.1ms.run",

"https://docker.linkedbus.com"

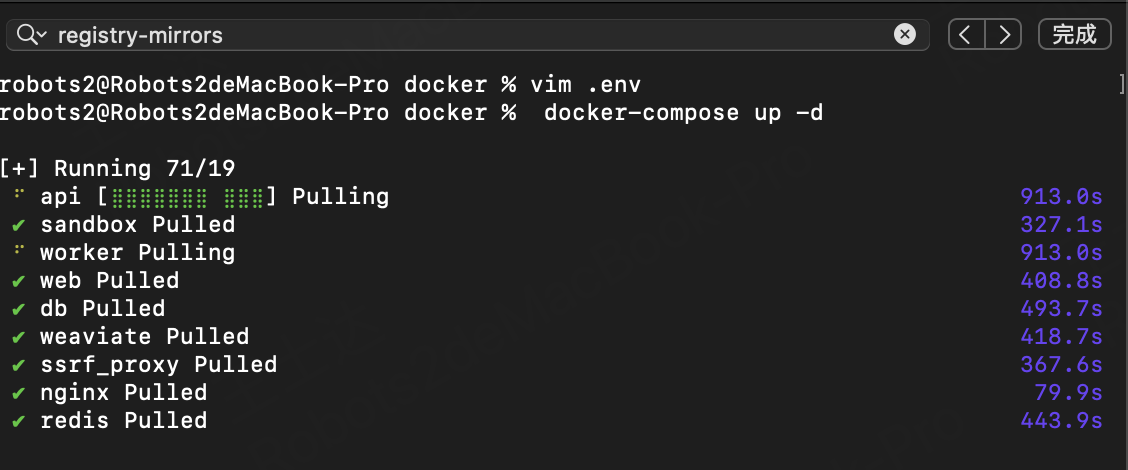

]5、使用docker拉取镜像并运行

docker compose up -d

四、设置 DeepSeek 接入至 Dify

1、浏览器打开dify,初始化管理员信息

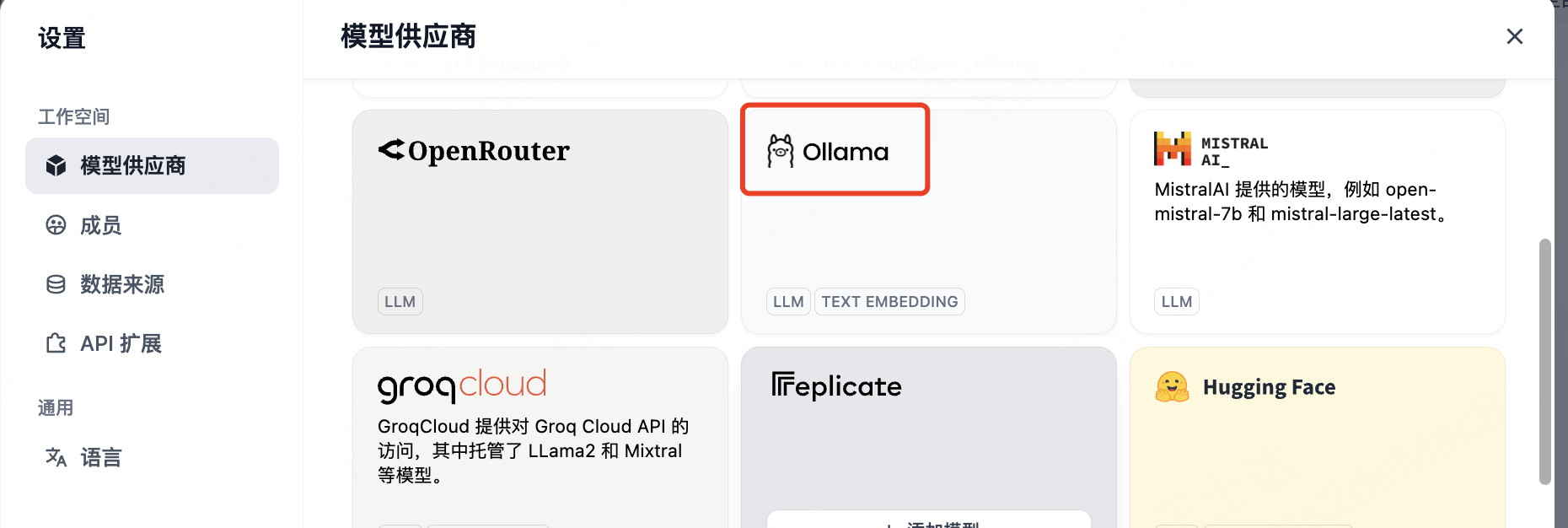

2、设置模型

右上角头像==》设置==》模型供应商==》Ollama

3、设置模型信息

基础url:http://127.0.0.1:11434

参考文章:

1、在MAC系统下安装Docker、Dify以及docker镜像加速

https://cloud.tencent.com/developer/article/2478585

2、本地搭建Dify