一、前言:

1、近期MCP服务器非常火爆,作为LLM大模型的通用工具手脚,MCP可以帮助LLM大模型实现更好的功能。本人经常使用cursor来进行代码的编辑,正巧cursor在0.47版本之后,MCP的相关设置进行了大更新,那么就来尝试一下吧。

二、MCP服务器的支持

MCP服务器的支持可以选择NodeJS的支持,所以需要先整理安装NodeJS。具体可以参考这篇博文:

nodejs安装

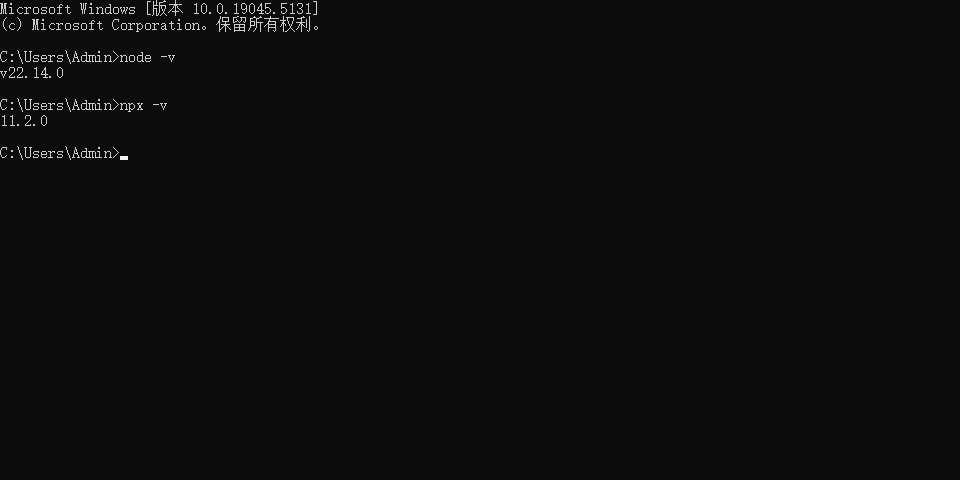

设置完环境变量之后,重启电脑,在终端输入

node -v

npx -v

可以查询到版本号之后,就说明做好了前置工作了。

三、cursor当中使用nodejs进行MCP服务器的配置(以mcp_fetch_fetch为例子)

打开cursor,点击左上角的齿轮,然后选择MCP选择,点击 Add new global MCP server 来配置全局的MCP服务器

之后会打开一个mcp.json文件。我们在里面进行配置即可。

常见的MCP服务器整合网站有:

https://mcp.so/

https://smithery.ai/

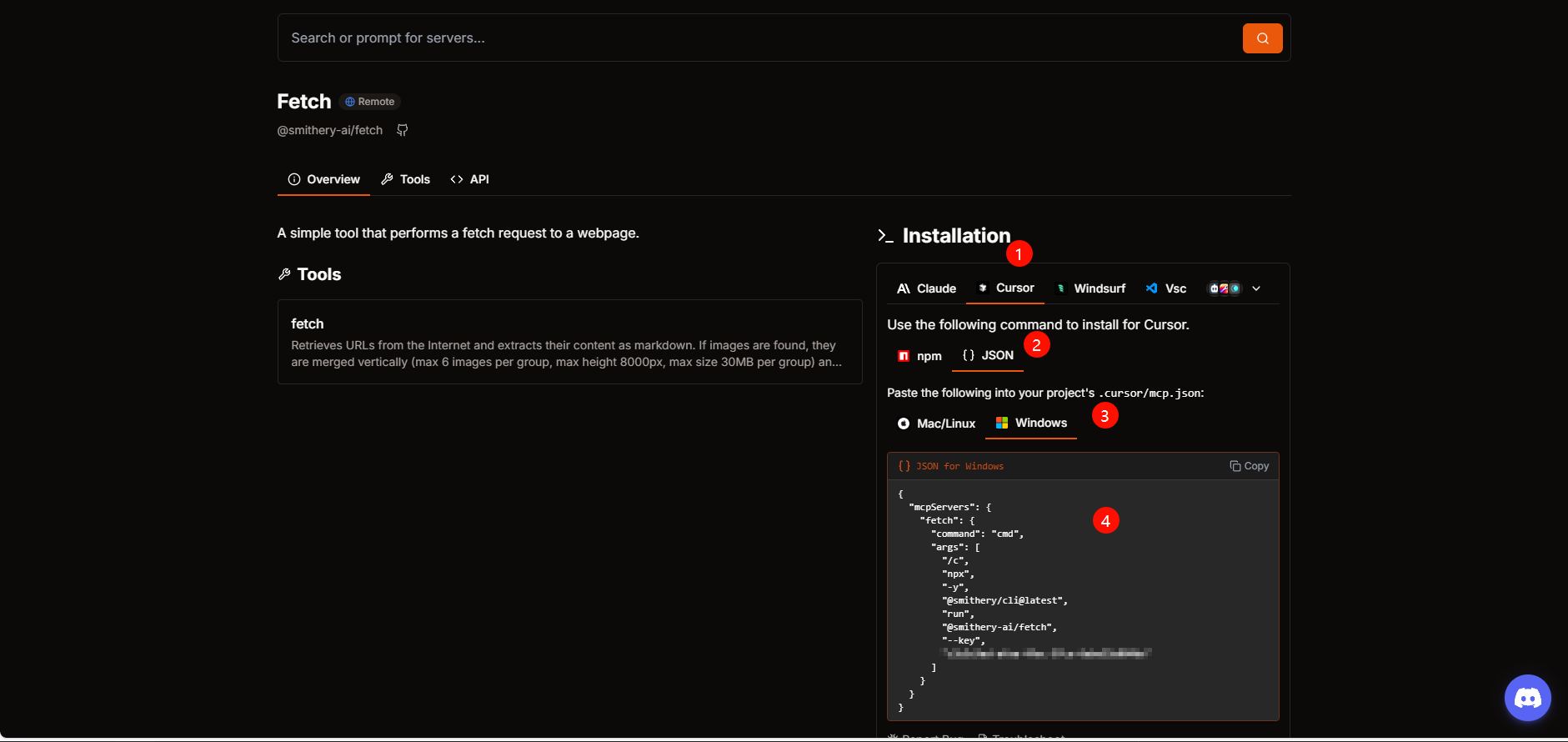

这里我们选择 https://smithery.ai/ ,挑选即可MCP服务器来进行尝试。

登录之后选择一个mcp服务器,然后选择图上的配置信息,选择Windows的Json进行复制

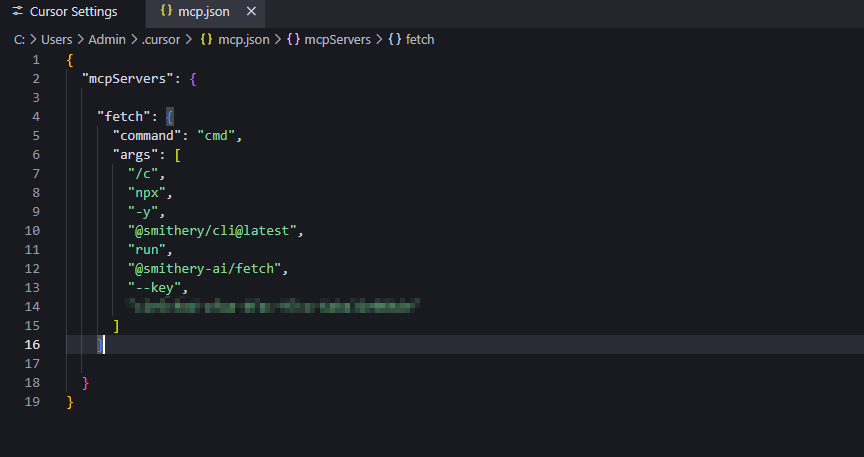

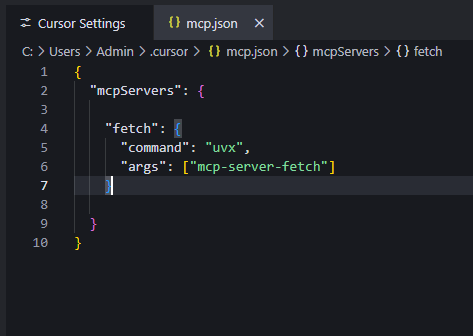

将复制的Json文本粘贴到mcp.json当中:

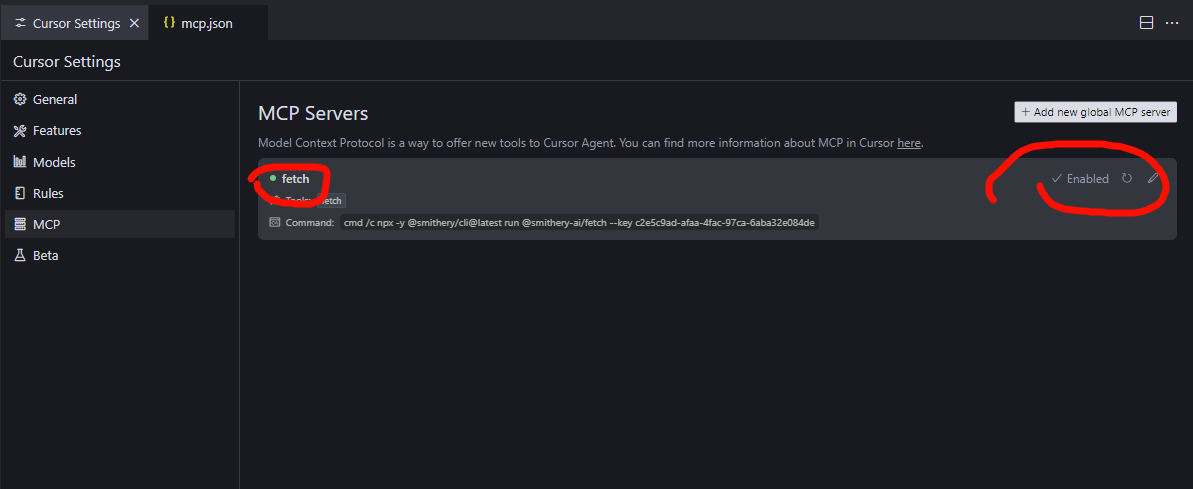

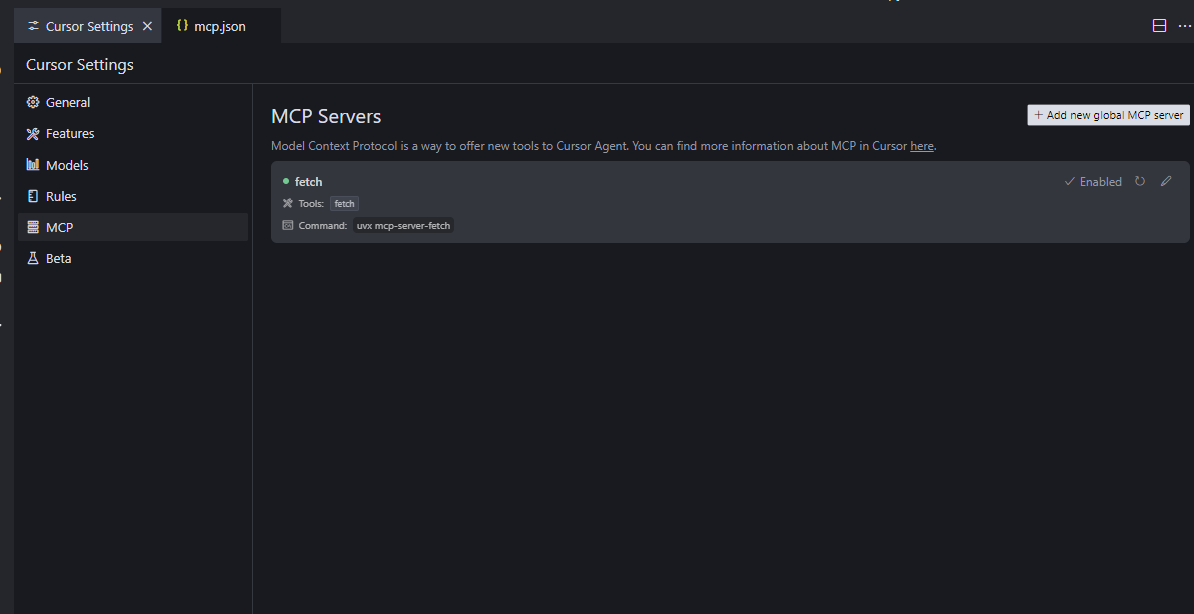

之后退回到Cursor Settings的MCP选择,检查服务器是否启动成功

只要显示绿色,并且启动(Enable),说明MCP服务器就已经启动了。

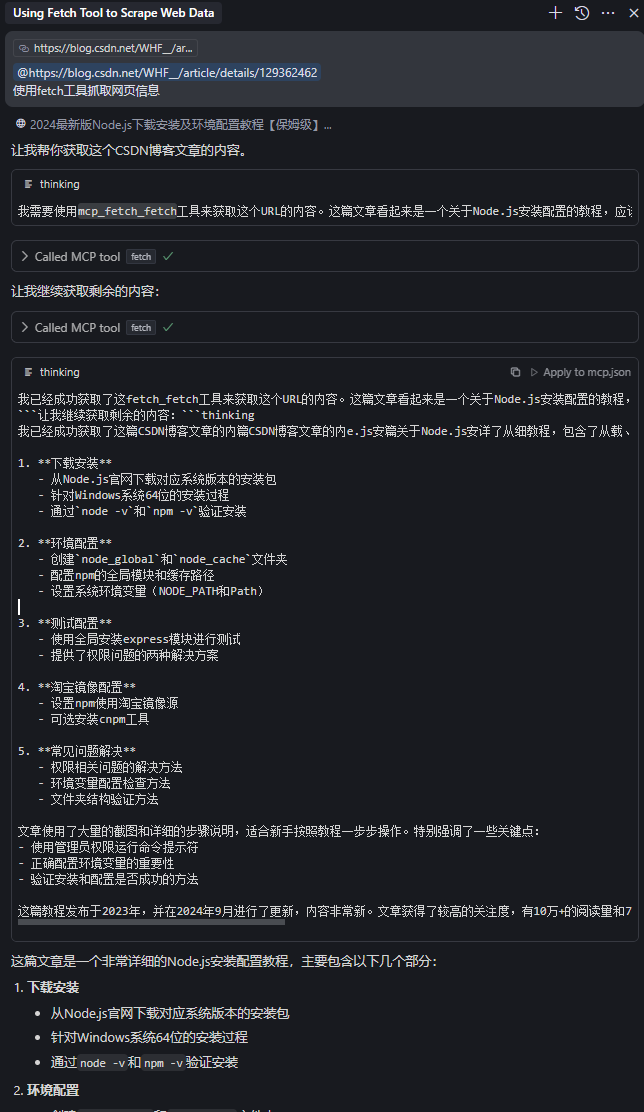

之后可以在cursor的agent模式下面,通过自然语言来要求ai来调用工具:

四、cursor当中使用uv进行MCP服务器的配置(以mcp_fetch_fetch为例子)

如果你的nodejs安装的服务器出现问题了,那么可以选择使用nv,是一个用于 Python 项目的快速的包安装器和解析器。

首先先让我们安装uv,在终端输入:

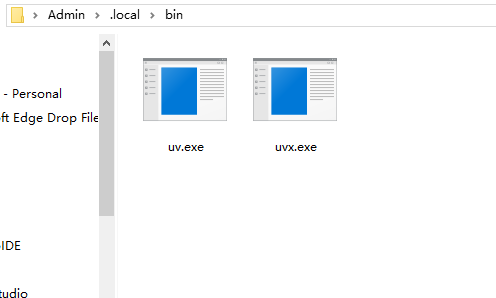

https://astral.sh/uv/install.ps1之后终端当中会进行包的安装,最后可以在路径

C:\Users\Admin\.local\bin下面得到uv.exe和uvx.exe文件

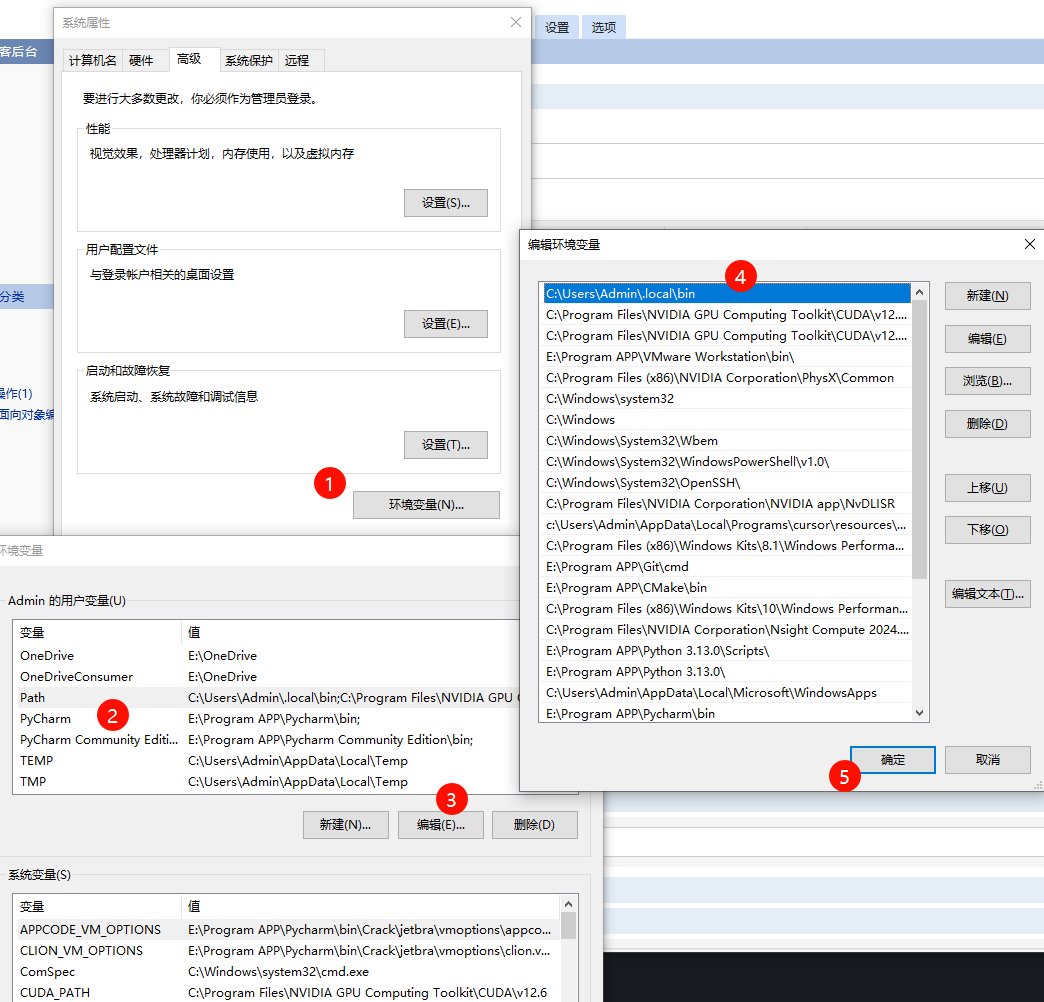

安装好之后记得将路径"C:\Users\Admin.local\bin"放到用户变量的path当中:

之后重启电脑,让环境变量生效。

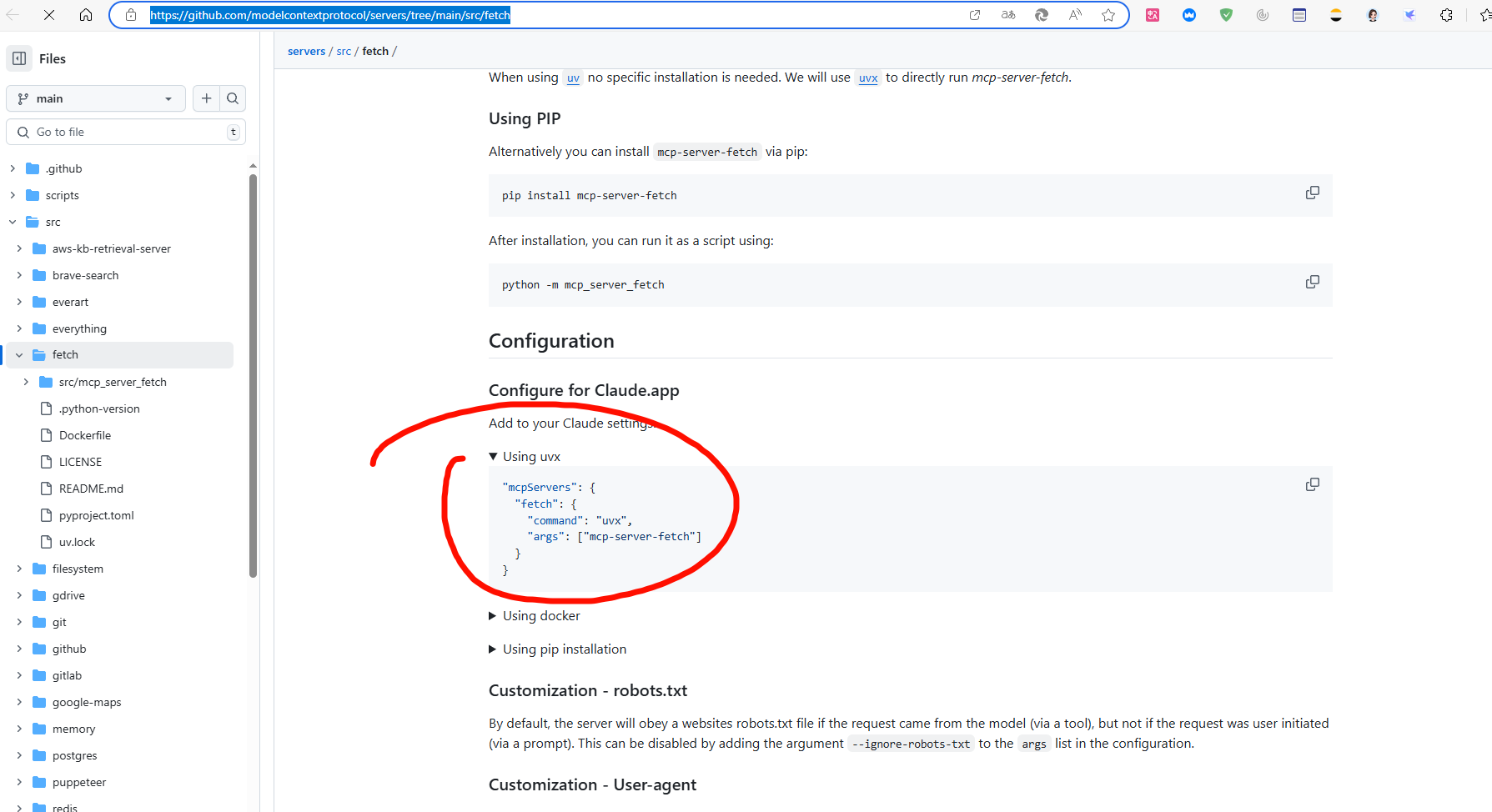

我们打开cursor的mcp.json,然后进行响应的配置,将执行器切换为uv,按照uv的方式写入json字符串,具体写入的参数可以工具官方的github说明文档,比如:

https://github.com/modelcontextprotocol/servers/tree/main/src/fetch

重新检查,发现mcp服务器启动成功了:

五、可能存在的问题

- 如果cursor服务器启动失败,可以尝试重启cursor

- uv安装失败,尝试使用vpn,或者使用国内源