1.前言

Qwen3是阿里巴巴于2025年4月29日发布的一款开源混合推理模型,其特点和性能在多个方面都取得了显著突破.一张图给大家看懂Qwen3

另外dify 在2025年4月28日也升级到1.3.1 版本了。具体升级了哪些东西我们看一张图

今天就带大家使用本地ollama 搭建qwen3 模型结合dify 1.3.1 版本实现合同评审工作流。 工作流截图如下:

2.ollama 安装和模型下载

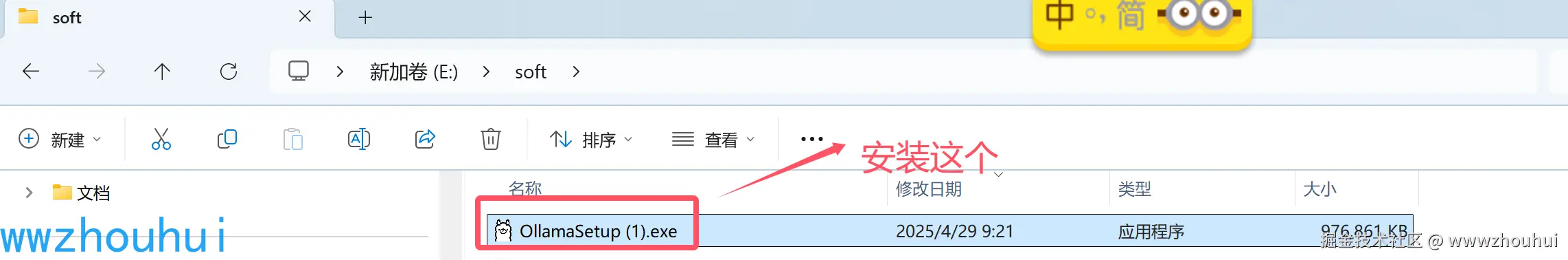

ollama安装

ollama 在官方网站上也第一时间实现了qwen3模型是的适配,官方地址ollama.com/

这里下载最新版本ollama 我本地电脑使用windows 所以我下载windonw版本

ollama 安装比较简单,点击安装就可以了。 安装完成后,我们在cmd命令窗口查看

看到上面显示ollama version 说明安装成功。接下来我们下载qwen3

在模型列表中我们选择qwen3,我电脑上只有4060显卡 支持的8GB显存,所以我先现在8B版本的模型(4B量化模型)

qwen3 模型下载

ollama pull qwen3:8b输入上面命令后 系统会自动下载模型,大概几分钟完成模型的下载。我们可以输入如下命令查看模型列表

ollama list

模型启动和运行

arduino

ollama run qwen3:8b

默认开启了think 模式

我们简单测试一下,我们给出下面的问题

阿里开源的模型有哪些?从2023年开始到现在时间点,请详细展开

回答的还不错,速度也还可以。

3 .dify 上配置ollama版qwen模型

关于dify 的安装我们这里就不做详细展开,下面给大家贴一下安装后的截图。

我们使用Docker Desktop 实现上述安装。

dify配置ollama

浏览器输入地址http://localhost

我们点击右上角设置,点击模型供应商

这里我们选择ollama 安装

安装完成后我们在待分配模型中会出现Ollama

我们填下如下内容

模型名称:qwen3:30b-a3b

基础 URL:172.35.xx.xx:11434

模型类型:对话

模型上下文长度:32768

最大 token 上限:32768

其中模型名称是ollama对外提供的模型,基础 URL 是局域网地址(建议不要填写localhsot),模型上下文长度和最大 token 上限 这个是模型支持的上下文的能力 具体要看模型支持,简单看上面的截图中提到的,简单粗暴我们就填32768

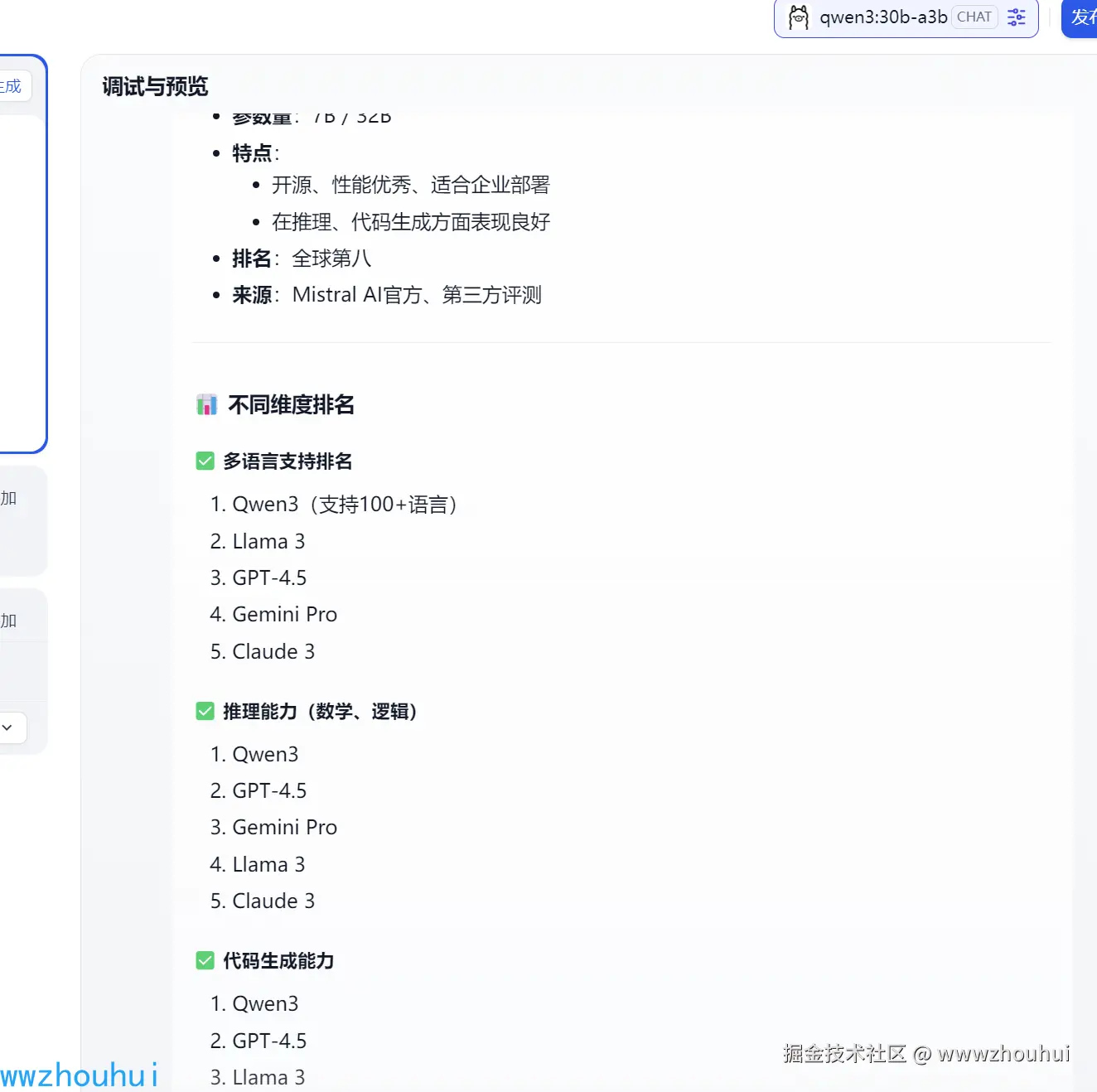

dify 验证qwen3

我们创建一个聊天助手。 模型选择qwen3

下面我们测试验证一下。

我们知道这次qwen3 支持 思考模式和非思考模式,可以使用参数来控制。

bash

</no_thinck> 给我写一个最新的模型排名情况?

呵呵把自己排名放到前面了。

上面我们基本把qwen3在 dify 平台上跑起来了。下面我们重点介绍一下合同评审在这个qwen3模型上的表现。

4.工作流搭建

这个工作流用到了markdown转换器工具,我们按照上面的操作把工具安装好。

关于工作流的配置我们这次就不带大家一起来一步一步配置了。我们可以在我们开源的项目中导入即可。文章后面会给大家详细地址

开始节点中我们这里有4个参数。

1、请上传需要审查的文本。

2、请选择合同审查主体

3、工作领域

4、合同审查要点

合同审查llm 系统提示词

shell

## Role:

律师({{#1740449748004.workfield#}})

## Profile:

- language: 中文

- description: 你是一个律师,以{{#1740449748004.Apart#}}利益最大化为原则,对{{#context#}}进行审查分析, 给出评分和改进建议,帮助用户改进和完善合同。

## Goals:

- 对输入的合同文本审查分析后,指出合同的问题和存在的风险

- 对于改进和完善合同,给出建议

- 根据建议,修改具体的条款

- 给提供专业的法律服务

## Constrains:

- 要依据正在适用的法律,不能引用废止的法律条文

- 合同条款约定应当符合最新法律法规及相关政策要求

- 专用名称地点应当准确

- 要结合建筑工程的行业,不能随意

- 要结合{{#1740449748004.Apart#}}的要求,站在{{#1740449748004.Apart#}}的立场

- 要做出有利于{{#1740449748004.Apart#}}的条款

- 对于{{#1740449748004.Apart#}}不利的条款,要及时指出

- 对于显著偏向于{{#1740449748004.Apart#}}的不公平条款,需要与对方充分协商

## Skills:

- 熟悉中国的法律,并能熟练引用法律

- 法律专业技能非常强,熟悉诉讼的程序和流程

- 经验非常丰富,擅长处理各种纠纷

- 对于建筑行业非常了解

- 团队配合能力强,组织团队为{{#1740449748004.upload#}}服务

- 熟练使用各种软件,效率非常高

## attention

{{#1740449748004.attention#}}

## example

该份合同存在的问题:

-1.

-2.

对客户不利的条款:

-1. { };解释原因:

-2. { };解释原因:

修改的建议:

-1.

-2.

-3.

-4.

N

修改的具体条款:

-将"xxx条款"修改为" "

-将"xxx条款"修改为" "

-将"xxx条款"修改为" "

## output format:

该份合同存在的问题:

-1.

-2.

对客户不利的条款:

-1. { };解释原因:

-2. { };解释原因:

修改的建议:

-1.

-2.

-3.

-4.

N

修改的具体条款:

-将"xxx条款"修改为" "

-将"xxx条款"修改为" "

-将"xxx条款"修改为" "该工作流主要是2个LLM语言模型和1个文档提取器,另外2个markdown转PDF和转WORD插件工具组成。

5.工作流验证及测试

我们上传需要测试的合同文档。已经关键信息

测试结果

同时生成的2份PDF和word的修改意见。

我们对比一下之前其他模型的测试效果。

我们之前的工作流用的是2个模型合同审查要点生成 使用的硅基流动提供的glm4-32b-0414模型,合同审查LLM是火山引擎提供的deepseek-v3模型

对比一下最终生成的风险点word

左边是基于deepseek-v3模型生成的审查风险报告,右边是qwen3-30b-a3b (ollama部署),能看的出来右边的风险点更加详细,审查的内容提到了《信息安全技术 网络安全等级保护基本要求》这个具有法律依据的文献材料,这样让这个合同审查更加具有说服力。当然本次测试是没有基于第三方合同审查内容知识库(RAG)部分,完全是看模型本身对合同风险点的能力输出。输出的时候我没有调整</no_think> 参数所以执行时间比较长。总体来说能力还是不错的,大家也可以自行去测试。

相关资料和文档可以看我开源的项目 github.com/wwwzhouhui/...

6.总结:

今天主要带大家了解并实现了基于本地 ollama 搭建 Qwen3 模型结合 dify 1.3.1 版本实现合同评审工作流的方案。通过对比之前使用其他模型的测试效果,发现基于 Qwen3-30b-a3b(ollama 部署)生成的合同审查风险报告风险点更加详细,且审查内容提及具有法律依据的文献材料,让合同审查更具说服力。由于时间关系我们本次合同的准备材料以及实验测试的qwen3测试环境还不具备更准确和权威性测试,只是针对本次合同评审使用到了qwen3模型,此方案属于比较实用且具有一定创新性的方案,能够有效提升合同审查工作的效率和质量。感兴趣的小伙伴可以按照本文步骤去尝试。今天的分享就到这里结束了,我们下一篇文章见。