Bolt DIY 是一个强大的开源AI辅助开发工具,允许用户在浏览器中进行全栈Web开发。它的核心特点是支持多种大型语言模型(LLM),包括OpenAI、Anthropic、Ollama、Google Gemini、Mistral等,让用户可以为每个提示选择最适合的AI模型。Bolt DIY在浏览器中创建了一个完整的开发环境,使用WebContainer技术运行NodeJS应用,让AI能够实时编写、调试和运行代码。

作为一个社区驱动的项目,Bolt DIY不断发展,添加新的功能和集成更多的AI提供商。它提供了图像上传、代码版本控制、项目导出/导入、一键部署等多种功能,是开发者与AI协作进行项目开发的理想工具。

为什么阅读这篇文章?

在使用Bolt DIY或类似的AI对话应用时,你是否曾好奇过从输入提示词到获得回答的整个过程是如何运作的?当你点击发送按钮那一刻,背后究竟发生了什么?为什么有时候响应快,有时候却很慢?不同的模型和提供商之间有什么区别?本文将揭开这一过程的神秘面纱,深入浅出地解析AI对话系统的核心技术架构。

了解这一流程将帮助你:

- 更好地选择模型:理解不同模型的初始化和响应过程,为你的特定任务选择合适的AI模型

- 优化使用体验:知道背后的工作原理,可以更有效地编写提示词,减少等待时间

- 解决常见问题:当遇到模型响应慢或失败等问题时,能够理解可能的原因并找到解决方案

- 深入了解技术:如果你是开发者,这将帮助你理解如何构建自己的AI应用或对Bolt DIY进行贡献

无论你是开发者、产品经理还是对AI技术感兴趣的用户,本文都会以图文并茂的方式,带你一步步了解从模型初始化到最终响应生成的完整流程,让你对AI对话系统有一个全面的理解。

模型初始化过程

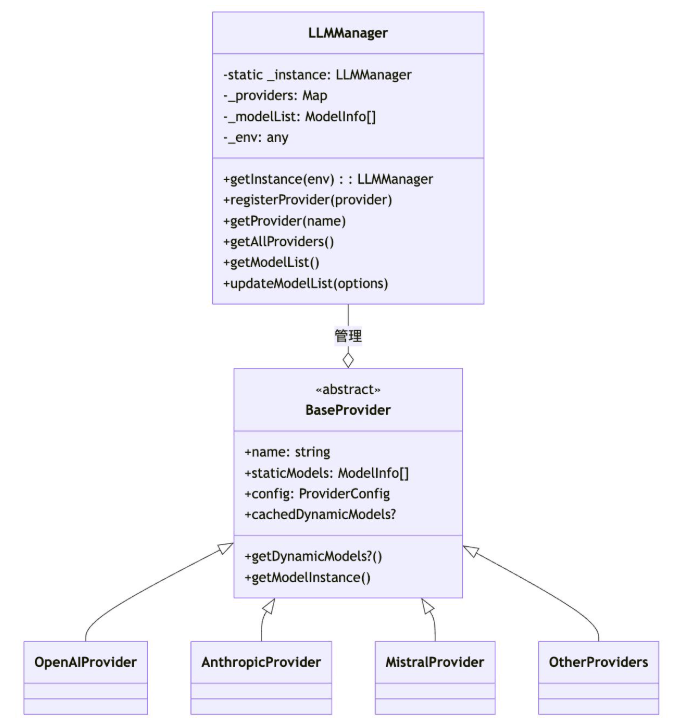

1. LLM 管理器架构

应用程序使用 LLM(大型语言模型)管理器系统来处理不同的 AI 模型提供商。核心组件是遵循单例模式的 LLMManager 类。

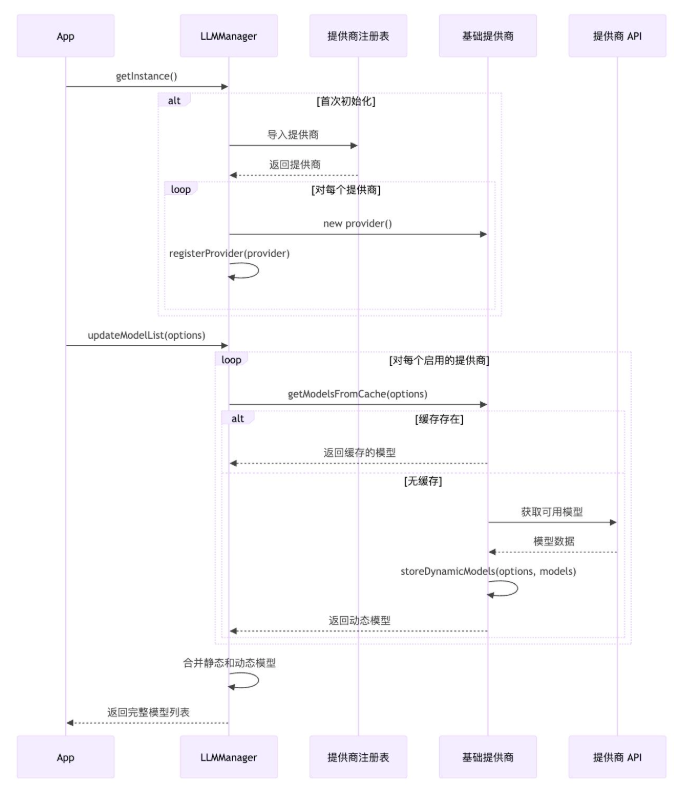

2. 初始化流程

模型初始化遵循以下步骤:

- 当首次通过

getInstance()访问时,LLMManager作为单例被初始化。 - 在初始化过程中,它通过调用

_registerProvidersFromDirectory()注册所有可用的提供商。 - 每个提供商(如 OpenAI、Anthropic、Mistral 等)从注册表中加载,并在继承

BaseProvider的情况下被注册。 - 提供商定义静态模型(硬编码)并可能实现

getDynamicModels()方法从其 API 获取模型。

3. 模型存储和缓存

系统通过以下方式高效管理模型:

- 静态模型:在每个提供商类中预定义(例如,OpenAI 的 GPT-4o、GPT-3.5 Turbo)

- 动态模型:从提供商 API 获取并缓存,以避免重复的 API 调用

- 提供商配置:每个提供商都有特定的配置,如 API 令牌密钥和基本 URL

用户交互和响应流程

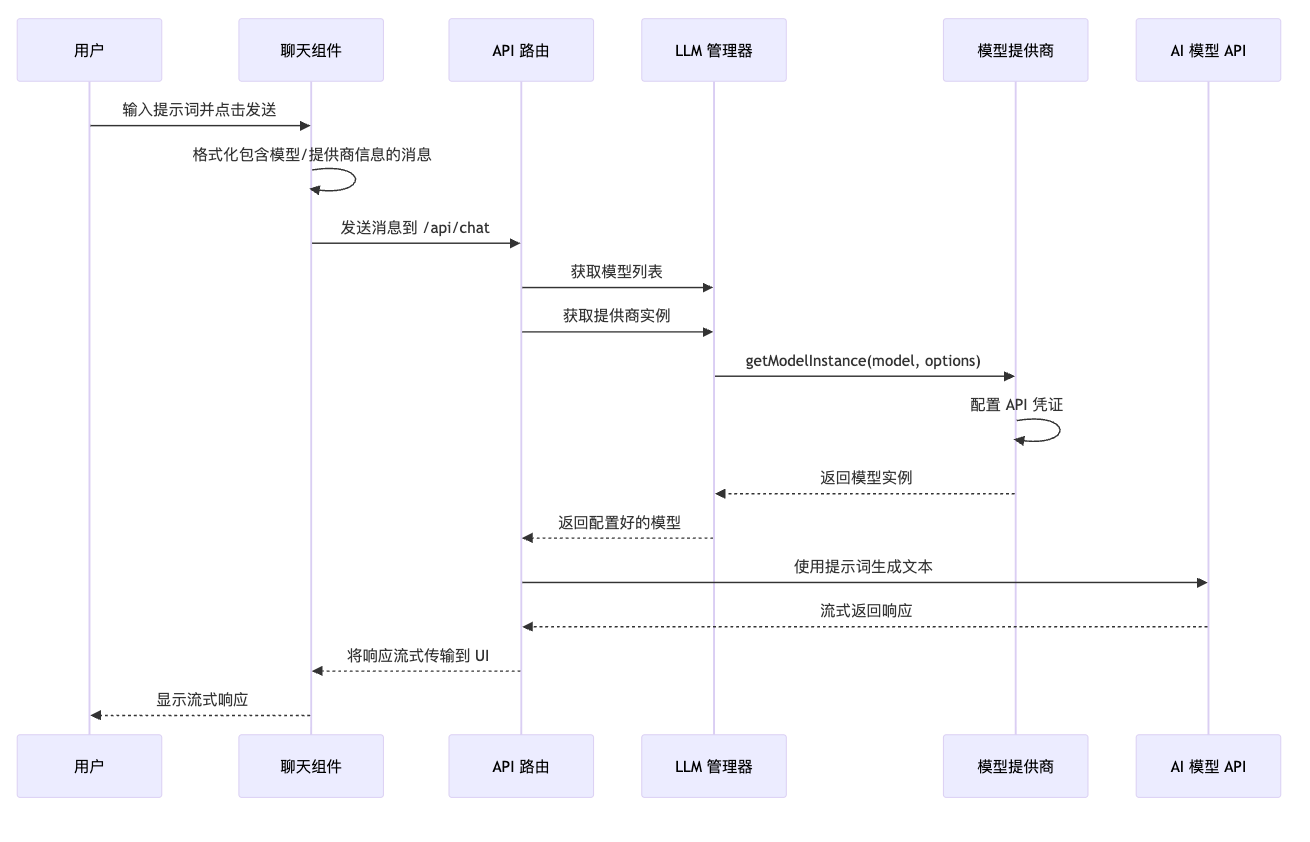

1. 聊天界面流程

当用户与聊天界面交互时,发生以下流程:

2. 详细处理步骤

-

用户输入捕获:

- 用户在聊天文本框中输入文本

- 输入保存在状态中并缓存在 cookies 中

- 可以将文件或图像附加到消息中

-

消息准备:

- 格式化输入以包含模型和提供商信息

- 如果用户正在开始新的聊天,系统可能会建议启动模板

-

API 请求处理:

- 格式化的消息发送到 API 端点

- LLM 管理器检索适当的提供商和模型

- 提供商使用 API 密钥和设置配置模型

-

模型交互:

- 使用配置好的模型实例生成文本

- 系统支持流式响应以提供实时反馈

- 管理令牌使用和约束

-

响应处理:

- 解析并显示流式响应

- 将消息存储在聊天历史记录中

- 记录令牌使用等统计数据

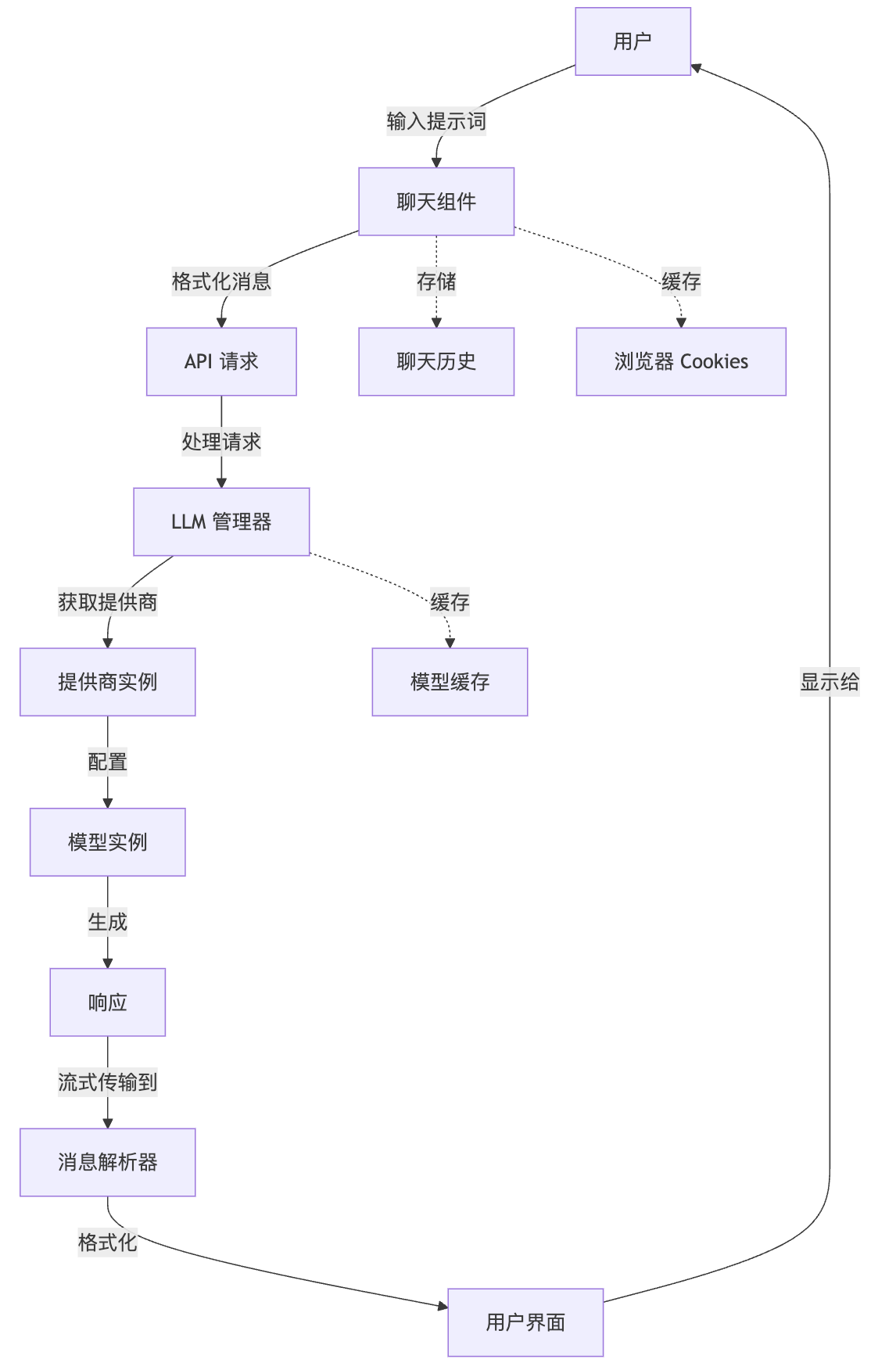

3. 流程中的关键组件

实现细节

1. 提供商实现

每个提供商(例如 OpenAI)实现:

- 静态模型信息:预定义的模型及其能力

- 动态模型获取:API 调用以获取可用模型

- 模型实例创建:使用凭证配置 API 客户端

- 缓存逻辑:存储模型信息以避免重复的 API 调用

2. 聊天组件集成

聊天 UI 组件:

- 管理输入、消息和流式响应的状态

- 处理用户交互,如发送消息和中止响应

- 使用模型和提供商信息格式化消息

- 通过适当的解析显示流式响应

3. API 路由处理

API 路由:

- 验证传入的请求

- 检索提供商和模型信息

- 使用适当的设置配置模型

- 处理流式和非流式响应模式

- 管理错误和身份验证问题

用户体验流程

从用户角度看,流程是:

- 用户选择模型和提供商或使用默认值

- 用户在聊天文本框中输入提示词

- 用户点击发送(或按 Enter 键)

- UI 在请求处理时显示加载指示器

- 响应开始实时流式传输

- 显示完整响应并保存在聊天历史记录中

- 用户可以通过其他提示词继续对话

总结与展望

本文深入剖析了Bolt DIY中AI对话系统的技术架构,从模型初始化到最终响应生成的完整流程。我们看到Bolt DIY采用了高度模块化的设计,通过LLM管理器实现了对多种AI模型提供商的无缝集成和高效管理。这种架构不仅支持静态预定义模型,还能动态获取和缓存模型信息,大大提升了系统性能和用户体验。

通过了解这一流程,Bolt DIY用户可以:

- 更明智地选择最适合特定开发任务的模型和提供商

- 理解模型响应时间差异的技术原因

- 在遇到问题时更容易排查和解决

- 优化提示词,获得更好的AI回应

对于希望贡献代码或基于Bolt DIY进行二次开发的开发者,本文提供了宝贵的架构洞察,有助于理解系统的核心组件及其交互方式。这种模块化、可扩展的设计也正是Bolt DIY能够不断集成新提供商和功能的关键所在。

随着AI技术的快速发展,Bolt DIY的架构也将持续演进。未来可能会引入更智能的模型选择机制、优化模型加载速度、增强多模态交互能力,以及提供更多针对不同开发任务的专业化提示模板。作为一个社区驱动的项目,Bolt DIY将继续依靠开发者社区的贡献,不断提升其作为AI辅助开发工具的能力和价值.