前沿 - 为什么要做这个开源软件

作为一个典型的前端开发者,去年在为公司调研Rust前端工具链、LLM应用开发技术体系的时候,对这类技术领域产生了浓厚的兴趣,也是出于早期曾经是一名Android移动应用个人开发者角色的经历,习惯性的给自己设定了一个工具主题的产品,用来练习使用Rust与AI的应用开发技术。

产品的用途(用户价值)还是从实际需求出发去做一个更通用化的专业软件:

- 及时获取情报的需求:在这个信息爆炸、各行各业发展飞快的时代,怎么能结合自己关注的领域,及时的获得信息?

- 阅读效率的需求:网上各类文章文风和水准千差万别,如何通过一个AI转述者用一套风格表达,并且希望看到的不仅有原文,还能直接看到提炼的核心观点、结论与逻辑。

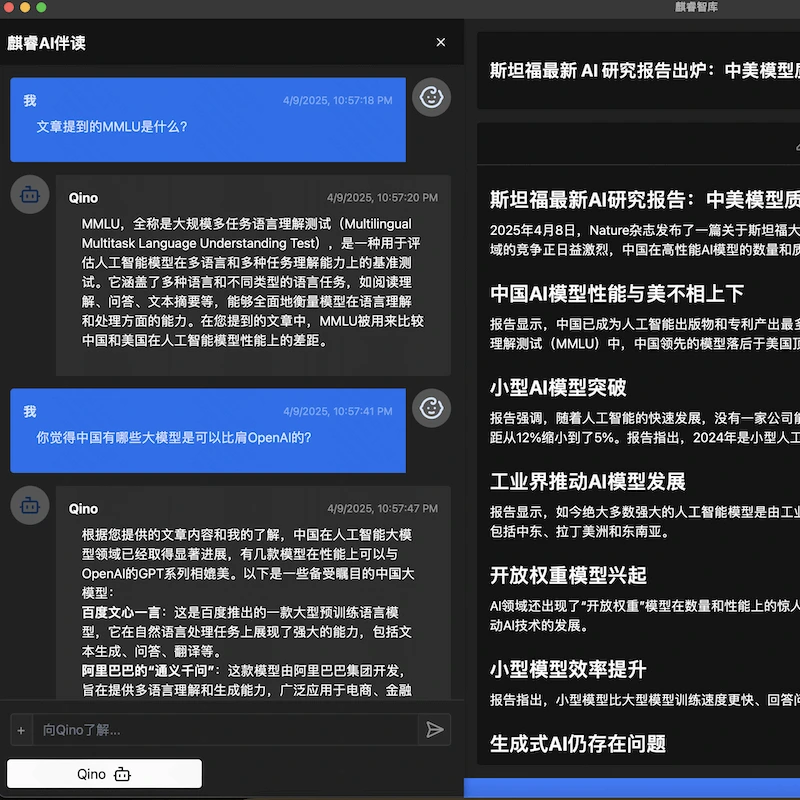

- 深度理解与讨论的需求:1个人看书总是太孤独,希望有个伴读功能,能和AI讨论一些文章中的内容,交换意见和看法。

- 不被打扰的需求:杜绝广告、推荐算法带来的水文,屏蔽各类媒体文章中的广告内容。

于是在平时用个人的周末闲暇时间做了一款软件,技术堆是Web 、Rust ,核心框架用到了Tauri 。用合适的技术解决对应的的问题,工具类软件就是要轻便好用、高性能、高能效、高安全。

- 💪🏻 由人工智能驱动的 速度极快 且 极其轻量 的互联网阅读器客户端

- 🛠️ 基于Rust 、Tauri 和Svelte构建的现代跨平台应用程序

这个项目我5月刚放到Github上(Github - Saga Reader),欢迎大家关注分享。

后面我也会有一个专题记录一下这个项目的技术点,以及把大模型应用开发、Rust开发以及个人软件运营方面的一些经验陆续分享出来,欢迎大家交流,你们的Star是我的强大动力。

麒睿智库是什么

麒睿智库(Saga Reader) 是一个AI驱动的智库式阅读器,根据用户指定的主题和偏好关键词自动从互联网上检索信息。它使用云端或本地大型模型进行总结和提供指导,并包括一个AI驱动的互动阅读伴读功能,允许您与AI讨论和交换阅读内容的想法。

麒睿智库 完全免费和开源,这意味着所有数据都安全地存储在您自己的计算机上,不受第三方服务提供商的控制。此外,您可以根据自己的兴趣和偏好管理订阅关键词,而不会受到广告和商业化内容的打扰。

开源地址:Github - Saga Reader

产品官网:官方网站下载!

截图

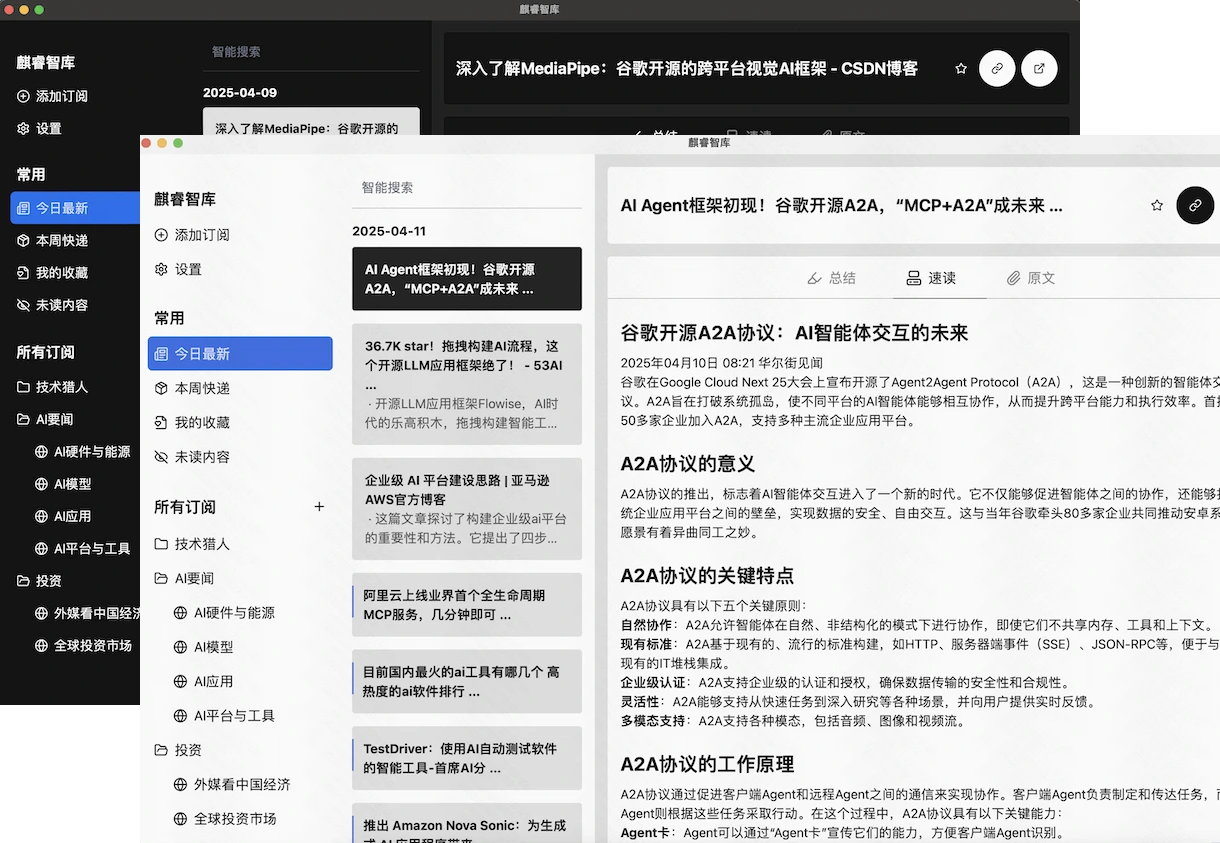

阅读器主界面,简洁大方,支持主题切换

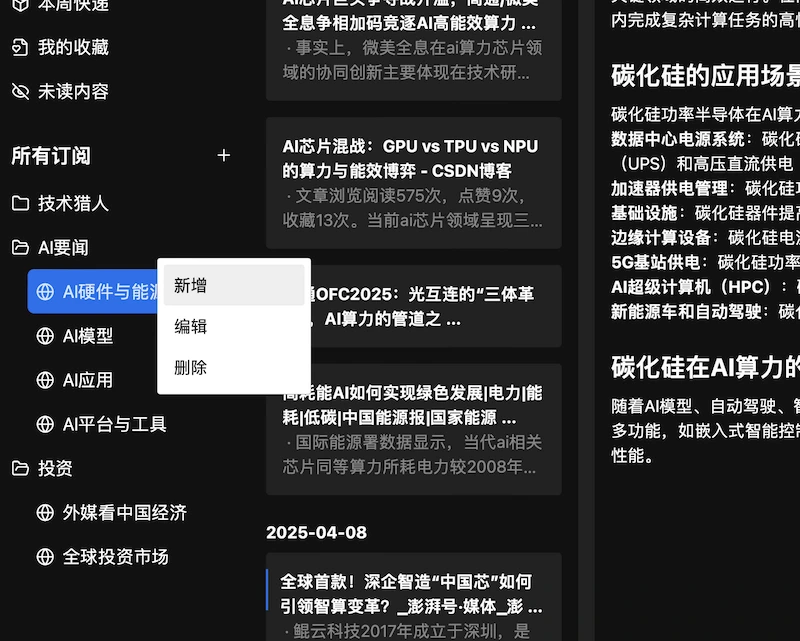

基于兴趣主题的内容订阅,自主灵活设定,网络全球互联网信息

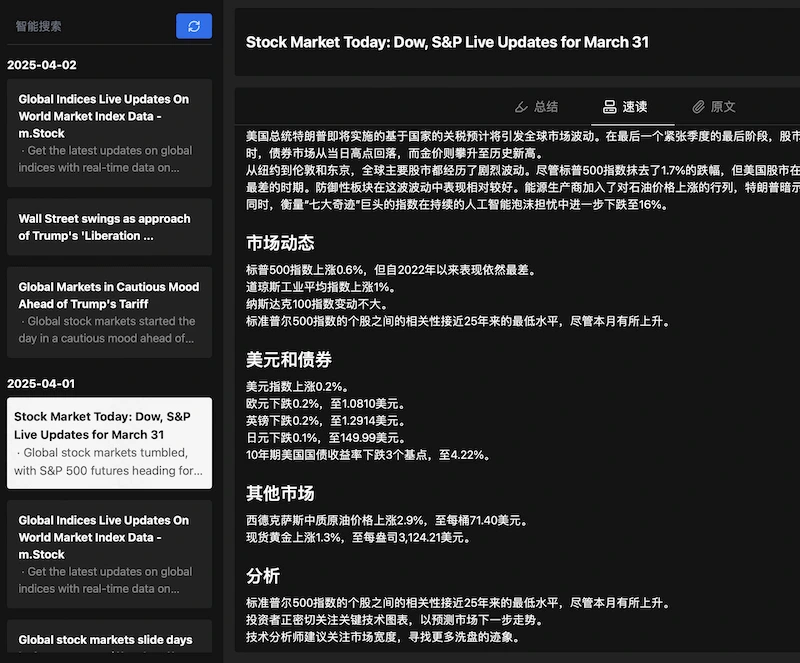

网罗多国语言信息,打造全中文阅读体验,并提供文章结构优化与自动总结、建议与提醒

AI伴读:与拟人化的 AI 助理,与AI基于文章内容深入探讨交流

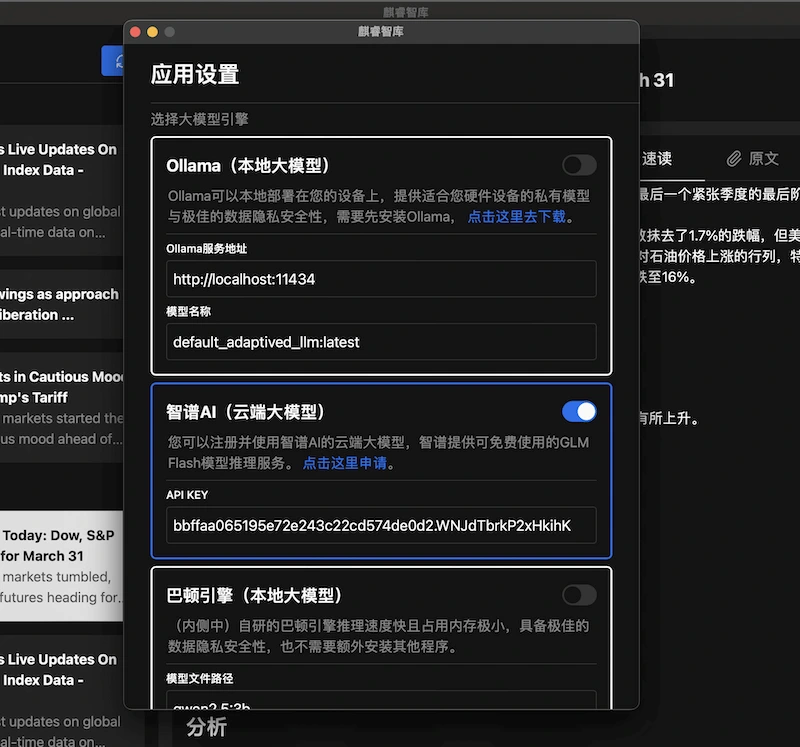

灵活的大模型选择:可选择云端大模型(如清华智谱),和你个人电脑上的本地大模型(支持 Ollama)

技术实现

整体工作流程

- Frontend:涉及多组件交互、状态管理、国际化处理,组件之间通过 Svelte Store 进行状态共享,国际化模块根据用户设置动态切换语言资源。

- Backend:tauri - plugin - feed - api 作为 Tauri 插件,与前端交互并协调其他业务模块。feed_api_rs 负责核心业务流程,串联 llm、recorder、scrap 等模块,处理复杂的业务逻辑。

- 跨模块协作:文章抓取后,scrap 模块将数据传递给 intelligent 模块,intelligent 调用 llm 进行内容处理,最终结果由 recorder 存储,整个过程涉及多个模块的协同工作。

核心模块

各个模块既相互独立又紧密协作,形成一个复杂且有序的整体。

intelligent: 文章优化工作流模块,提供文章优化过程和提示工程优化的抽象。scrap: 提供数据抓取功能,通过调用主流搜索引擎从互联网获取信息。此模块默认是完全本地化的,不依赖任何第三方服务。recorder: 提供本地存储功能,用户兴趣提示、原始文章和后处理优化文章保存在用户个人计算机存储中。llm: 提供内部的LLM Provider抽象,并适配各种云端和本地大型模型服务实现。ollama: 运行本地ollama,包括运行基本实例、模型更新和管理功能。feed_api_rs: 基于经典门面模式的核心能力API和实现。tauri-plugin-feed-api: 通过tauri命令调用前端的核心能力API。types: 共享基本类型模块。

内容订阅和更新流程

文章阅读和人工智能互动流程

关于我

🚀 通过 在 GitHub 上赞助我让这个软件更好的发展。

互联网老兵,经历PC互联网、移动互联网、AI应用三股浪潮,从早期的移动应用个人开发者角色入场,到现在的职场从业者角色,有丰富的产品设计与研发经验。现就职于快手,从事大前端体系以及AI探索方面的研发工作。

wx号:dokhell

用户群