目录

[下载 ollama](#下载 ollama)

[这里以 国产麒麟为例](#这里以 国产麒麟为例)

[简单来了,樱花 内网穿透一下](#简单来了,樱花 内网穿透一下)

[对接 Ollama 思路:](#对接 Ollama 思路:)

[对接 Ollama 思路:](#对接 Ollama 思路:)

[对接 Ollama 思路:](#对接 Ollama 思路:)

简介

从虚拟机中创建 国产银河麒麟操作系统,然后在里面部署国产的Qwen3 通义千问的开源大模型,下篇考虑用 open-webui去可视化使用。

开源模型选择列表

|---------------|------------|--------|

| 厂商 | 模型 | 免费 |

| 阿里-通义千问 | Free Qwen3 | 是 |

| 元宇宙平台公司(Meta) | llama2 | 是 |

| 谷歌 | gemma | 是 |

这里选择国内大模型 通义千问

阿里正式发布 Qwen3,这是 Qwen 系列大型语言模型的最新力作。其中,旗舰模型 Qwen3-235B-A22B 在代码、数学、通用能力等多维度基准测试中,与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 等顶尖模型展开激烈角逐,展现出极为出色且极具竞争力的卓越表现。与此同时,小型 MoE 模型 Qwen3-30B-A3B 的激活参数数量仅为 QwQ-32B 的 10%,却在性能上实现了超越,令人瞩目。而像 Qwen3-4B 这样相对较小的模型,也能够与 Qwen2.5-72B-Instruct 的性能相媲美,展现出强大的实力。

Qwen3 开源模型在思考模式下不支持非流式输出方式。

对于 Qwen3 模型,开启思考模式时如果没有输出思考过程,按非思考模式价格进行收费。

本地大模型虚拟机配置

CPU:i7-12

内存:8G

磁盘:100G

直通显卡:none

OS:银河麒麟桌面版 V10(SP1-2304)

ollama version:0.9.0

本地大模型:qwen3-0.6b

配置银河麒麟-虚拟机

一定要给足50G的空间,不然系统不给安装

Ollama模型

Ollama 是一个轻量级、用户友好的框架,旨在让用户在本地运行开源大型语言模型,如 Llama 3、DeepSeek-R1、Gemma、Mistral、Qwen 等。它通过 Modelfile 将模型权重、配置和数据打包成一个统一包,类似于 Docker 镜像的概念,优化了模型的设置和 GPU 使用。Ollama 的核心优势在于隐私性、灵活性和离线可用性,特别适合对数据安全有高要求的场景。

下载 ollama

可以访问 Ollama 官网 或 GitHub 页面,下载适用于您操作系统的安装包。

官网 :++https://ollama.com/download++

GitHub : ++https://github.com/ollama/ollama++

Linux 用户可通过以下命令快速安装:

curl -fsSL https://ollama.com/install.sh | shWindows 跟 mac OS 用户需下载安装程序并按提示操作。

这里以 国产麒麟为例

按 windows键 + T 打开命令终端,命令放进去

curl -fsSL https://ollama.com/install.sh | sh

到最后你会发现 安装不了

换成root 在操作一遍发现还是这样的,同时又是通网的,那就是防火墙问题了

先关闭防火墙

防火墙关闭后,就看继续安装了

等了好久.....终于快下好了/(ㄒoㄒ)/~

....

我以为能自动连接显卡

自动拉取跟下载大模型:

使用 run 拉取所需 qwen3-0.6b 模型,例如:

ollama run qwen3-0.6b

安装完成后就可以 进行简单对话了

响应还是很快很快的

如果想了解其他模型:

ollama官网模型仓库:++https://ollama.com/library++

这时候你会发现只能本地使用啊????

curl ://localhost:11434/api/generate -d '{"model":"qwen3:0.6b","prompt":"what is java?"}'

这时候你会发现 不是公网的IP,自己使用还行,那如果别人也想用模型呢?

更改一下配置吧

vi /etc/systemd/system/ollama.service

Environment="OLLAMA_KEEP_ALIVE=24h"Environment="OLLAMA_NUM_PARALLEL=4"Environment="OLLAMA_HOST=0.0.0.0:11434"

重启ollama

#重启ollama服务使生效systemctl daemon-reloadsystemctl restart ollama去物理机那边测试一下

那现在如果说 想其他人也访问的话

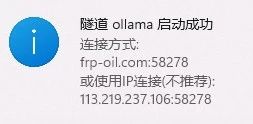

简单来了,樱花 内网穿透一下

简单测试一下功能

如下图所示:

-

具备记忆能力

-

具备思考

-

支持离线思考

扩展技术

AnythingLLM

- 定位:将本地文档或数据源整合进一个可检索、可对话的知识库,让 AI 助手 "懂你" 的资料。

主要功能:

-

文档管理:将 PDF、Markdown、Word 等多格式文件索引进系统。

-

智能检索:可基于向量数据库搜索相关文档片段,并在聊天时自动引用。

-

界面 +API:既提供用户友好的前端管理界面,也能通过 API 与其他系统集成。

对接 Ollama 思路:

-

在配置文件或启动脚本中,将 "语言模型推理" 后端地址指定为 Ollama 的本地服务。

-

当用户发起提问时,AnythingLLM 会先做知识检索,再将检索到的上下文发送给 Ollama 做语言生成。

适用场景:

- 企业内部文档问答、个人知识管理、高度依赖文本内容的问答场景。

Dify

- 定位:多功能的 AI 应用构建平台,支持多种大语言模型,方便开发者快速搭建 ChatGPT-like 服务或插件化应用。

主要功能:

-

对话管理:可自定义对话流或应用场景,为不同场景配置不同模型或工作流。

-

插件扩展:支持将其他第三方服务或插件加入对话流程中,提高可用性。

-

多模型兼容:除 Ollama 外,也兼容 OpenAI API、ChatGLM 等其他模型。

对接 Ollama 思路:

-

在 "模型管理" 或 "模型配置" 界面/文件中,添加对 Ollama 的引用,可能需要指定本地运行地址 (如 localhost:port)。

-

使用 Dify 的对话页面或 API 时,后台调用 Ollama 进行推理,再将结果返回前端。

适用场景:

- 多模型切换、多功能插件集成;需要可视化对话配置或工作流管理的团队与开发者。

Open-WebUI

- 定位:社区驱动的网页版用户界面,针对多种本地模型提供可视化使用入口,类似一个 "本地 ChatGPT 面板"。

主要功能:

-

浏览器聊天界面:在局域网或本机通过网页即可与模型交互。

-

支持多后端:LLaMA、GPT-NeoX 等,以及 CPU/GPU 等不同推理环境。

-

插件/扩展机制:在社区里可找到各式各样的扩展功能(如多语言 UI、模型切换、对话模板等)。

对接 Ollama 思路:

-

通常可在 Open-WebUI 的后台配置或启动脚本中,指定 Ollama 作为推理后端;

-

或使用适配 Ollama 协议的插件,让 Open-WebUI 调用 Ollama 进行对话。

适用场景:

- 需要 "纯聊天 + 模型管理" 界面的普通用户或开发者;想要单纯体验各种本地模型的人群。

* Thanks you *

如果觉得文章内容不错,随手帮忙点个赞 、在看 、转发 一下,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章。

* 往期推荐 *

Swagger | 手把手带你写自动生成接口文档的爽感(零基础亲测实用)

SpringBoot整合Openfeign接入Kimi Ai!!超简单,居然没多少行代码??(附加兜底教程)

Maven | 站在初学者的角度配置与项目创建(新手必学会)

Spring Ai | 极简代码从零带你一起走进AI项目(中英)

MongoDB | 零基础学习与Springboot整合ODM实现增删改查(附源码)

Openfeign | 只传递城市代码,即可获取该地域实时的天气数据(免费的天气API)

Mongodb | 基于Springboot开发综合社交网络应用的项目案例(中英)

感谢阅读 | 更多内容尽在公棕号 WMCode | CSDN**@小Mie不吃饭**