更多内容:XiaoJ的知识星球

目录

- [Gemini Robotics:将 AI 带入物理世界](#Gemini Robotics:将 AI 带入物理世界)

- [1. 介绍](#1. 介绍)

- [2. Gemini 2.0 的具身推理](#2. Gemini 2.0 的具身推理)

-

- [2.1. 具身推理问答(ERQA)基准测试](#2.1. 具身推理问答(ERQA)基准测试)

-

- 1)ERQA基准测试

- [2)增加思维链 (CoT)](#2)增加思维链 (CoT))

- [2.2. Gemini 2.0 具身推理能力](#2.2. Gemini 2.0 具身推理能力)

-

- [1)物体检测(Object Detection)](#1)物体检测(Object Detection))

- 2)指向(Pointing)

- [3)2D 轨迹(2D Trajectories)](#3)2D 轨迹(2D Trajectories))

- [4)自上而下抓取(Top-Down Grasps)](#4)自上而下抓取(Top-Down Grasps))

- [5)多视图对应(Multi-view Correspondence)](#5)多视图对应(Multi-view Correspondence))

- [6)3D检测(3D Detection)](#6)3D检测(3D Detection))

- [2.3. Gemini 2.0支持零样本和少样本机器人控制](#2.3. Gemini 2.0支持零样本和少样本机器人控制)

-

- [1)零样本控制(Zero-shot Control)------通过代码生成](#1)零样本控制(Zero-shot Control)——通过代码生成)

- [2)少样本控制(Few-shot Control)------通过上下文示例(In-Context Learning, ICL)](#2)少样本控制(Few-shot Control)——通过上下文示例(In-Context Learning, ICL))

- [3. Gemini Robotics 执行机器人动作](#3. Gemini Robotics 执行机器人动作)

-

- [3.1. Gemini Robotics 模型和数据](#3.1. Gemini Robotics 模型和数据)

- [3.2. Gemini Robotics 可开箱即用解决各种高精度操作任务](#3.2. Gemini Robotics 可开箱即用解决各种高精度操作任务)

- [3.3. Gemini Robotics 能准确遵循自然语言指令](#3.3. Gemini Robotics 能准确遵循自然语言指令)

- [3.4. Gemini Robotics 将 Gemini 的泛化能力带入物理世界](#3.4. Gemini Robotics 将 Gemini 的泛化能力带入物理世界)

- [4. Gemini Robotics 的专业化与适配:提升灵巧性、推理能力与新形态适应](#4. Gemini Robotics 的专业化与适配:提升灵巧性、推理能力与新形态适应)

-

- [4.1. 长距离高精度操作](#4.1. 长距离高精度操作)

- [4.2. 增强的推理和泛化](#4.2. 增强的推理和泛化)

- [4.3. 快速适应新任务](#4.3. 快速适应新任务)

- [4.4. 适配新机器人形态](#4.4. 适配新机器人形态)

- 其他

.

Gemini Robotics:将 AI 带入物理世界

.

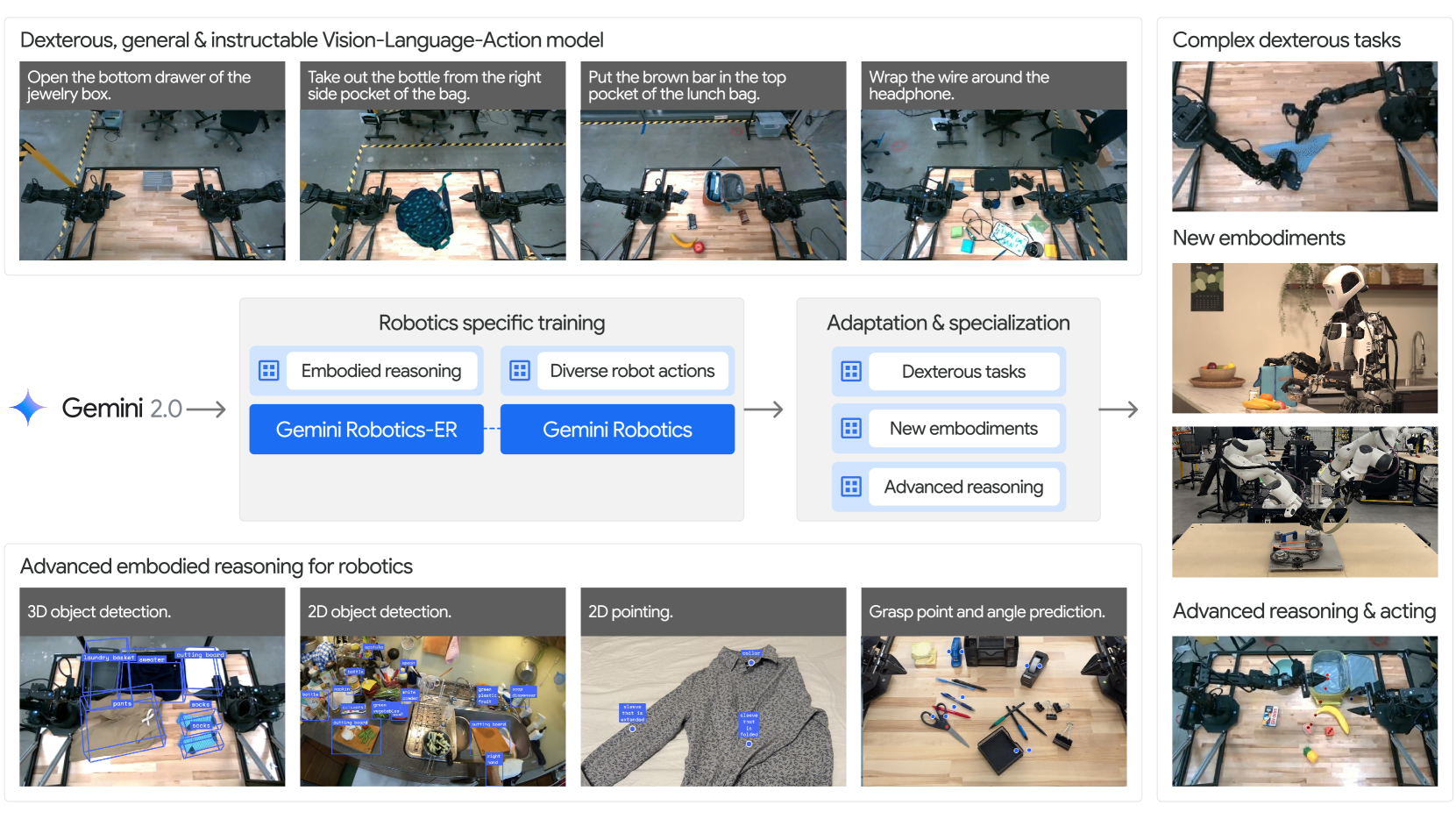

近期大型多模态模型在数字领域展现出卓越的通用能力,但将其迁移至机器人等物理实体仍面临挑战。本报告提出基于Gemini 2.0的Gemini Robotics家族模型,包含两个核心创新:

-

Gemini Robotics-ER(ER,Embodied Reasoning):一个有具身推理能力的VLM模型。将 Gemini 的多模态推理能力扩展到物理世界,增强了空间和时间理解。实现了与机器人相关的功能,包括对象检测、指向、轨迹和抓取预测,以及以多视图对应和3D理解等等。

-

Gemini Robotics :一个直接控制机器人的视觉-语言-动作 (VLA)通用模型,Gemini Robotics 建立在 Gemini Robotics-ER 模型之上。可执行复杂操作任务(如折纸狐狸、玩纸牌),适应未见过的环境和多样化指令,支持零样本(通过机器人代码生成)和少样本(通过上下文学习)迁移;

该模型通过微调可快速学习新任务(如100次演示内掌握短时任务),同时整合安全性设计,标志着通用机器人向现实世界落地的重要进展。

图 1:Gemini Robotics 系列嵌入式 AI 模型概述。Gemini 2.0 已经展示了与机器人相关的功能,例如语义安全理解和长上下文。机器人特定的训练和可选的专业化过程使 Gemini Robotics 模型能够展示各种机器人特定的功能。这些模型产生灵巧和反应性的运动,可以快速适应新的实施例,并使用高级视觉空间推理来通知动作。

.

.

1. 介绍

现代人工智能(AI)模型通过大规模数据预训练,在文本、图像、音频、视频等多种模态上展现出强大的通用能力和信息处理水平,推动了聊天机器人、虚拟助手等数字 交互系统的发展。然而,要让通用型AI在物理世界中实现自主智能,需要具备"具身推理"能力------即理解三维环境、物体关系和物理规律等现实世界的常识,并能将感知转化为实际动作,实现从被动理解到主动交互的跨越。这对构建真正能在物理环境中自主行动的AI系统至关重要。

随着机器人硬件的进步,构建能执行高精度操作的具身AI智能体展现出巨大潜力。本文探讨:如何让前沿数字AI模型,具备在物理世界中通用且灵活交互所需的具身推理能力?

本研究基于前沿视觉-语言模型(如Gemini 2.0)所具备的多模态理解和推理能力,构建具身智能体。这依赖两大核心:

-

一是让Gemini具备理解物理世界几何结构与时空关系的具身推理能力;

-

二是将其推理能力与物理动作结合,使其理解接触力学、动力学及现实交互机制,从而实现对机器人快速、安全且灵活的控制。

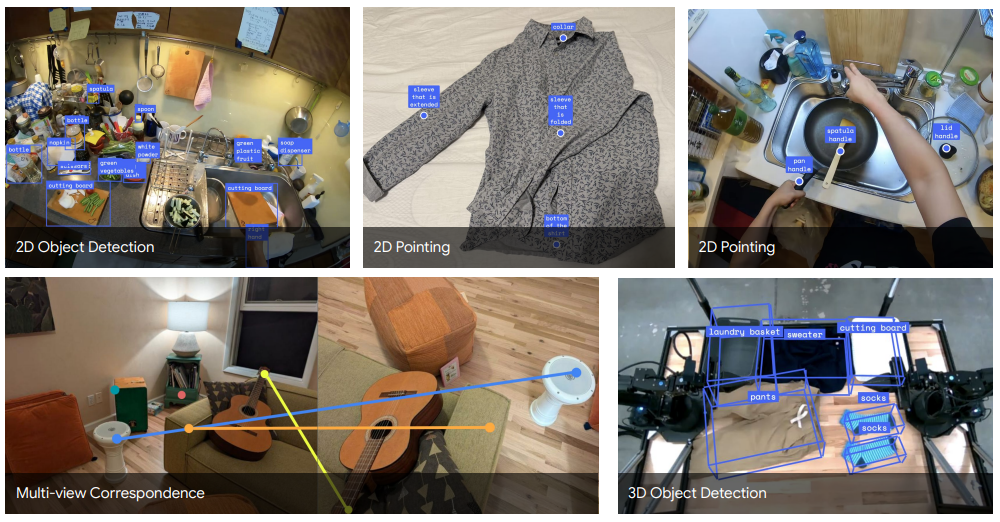

图 2:Gemini 2.0 擅长具身推理功能,即在 2D 中检测物体和点,利用 2D 指向进行抓取和轨迹,以及在 3D 中检测相应的点和物体。显示的所有结果均使用 Gemini 2.0 Flash 获得。

为此,我们基于最先进多模态基础模型Gemini 2.0,推出Gemini Robotics 系列具身AI模型。首先,我们通过新开源的具身推理基准ERQA验证Gemini 2.0在物理世界理解方面的能力与通用性。

我们提出两个核心模型:

-

Gemini Robotics-ER:具备强大具身推理能力的视觉-语言模型(VLM),在多种任务中展现泛化能力,如3D感知、精准指向、机器人状态估计和功能预测,同时保持原有基础模型的多模态优势。

-

Gemini Robotics:先进的视觉-语言-动作(VLA)模型,将具身推理能力与机器人底层控制结合,实现复杂操作任务的高效执行,支持多样化指令输入,并能适应任务环境的变化。

此外,我们引入可选的专业化阶段,展示Gemini Robotics如何适配高精度操作、复杂推理场景及新型机器人结构。

最后,我们探讨大规模机器人模型训练中的安全性问题,并为视觉-语言-动作模型(VLAs)相关研究提供指导建议。报告重点包括:

-

ERQA(Embodied Reasoning Question Answering):首个专注于评估多模态模型具身推理能力的开源基准;

-

Gemini Robotics-ER:具身推理能力显著增强的VLM;

-

Gemini Robotics:融合机器人动作数据的VLA模型,实现高频、灵巧的跨任务控制与快速适配;

-

负责任开发:遵循Google AI原则,审慎评估模型的社会影响与潜在风险,推动安全可控发展。

.

.

2. Gemini 2.0 的具身推理

Gemini 2.0 是一种视觉-语言模型(VLM),其能力不仅限于视觉理解和语言处理任务。特别是,该模型展现了先进的具身推理(ER)能力。我们将ER定义为视觉-语言模型在现实世界中对物体和空间概念进行落地的能力,以及综合这些信息以用于后续机器人应用的能力。

-

在2.1节,我们首先介绍用于评估广泛ER能力的基准测试,并展示Gemini 2.0模型在该领域的最先进表现。

-

在2.2节,我们演示Gemini 2.0所具备的一系列具体ER能力。

-

在2.3节,我们展示如何将这些能力应用于机器人系统,而无需对机器人动作数据进行微调,从而支持零样本代码生成控制和少样本的上下文学习机器人控制。

.

2.1. 具身推理问答(ERQA)基准测试

1)ERQA基准测试

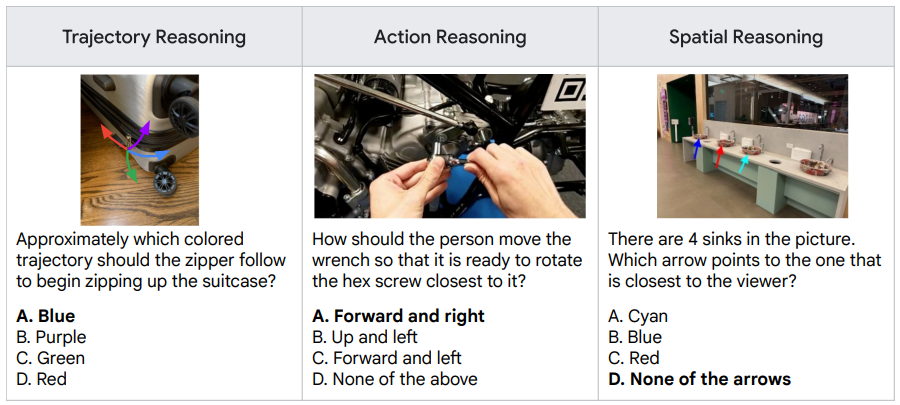

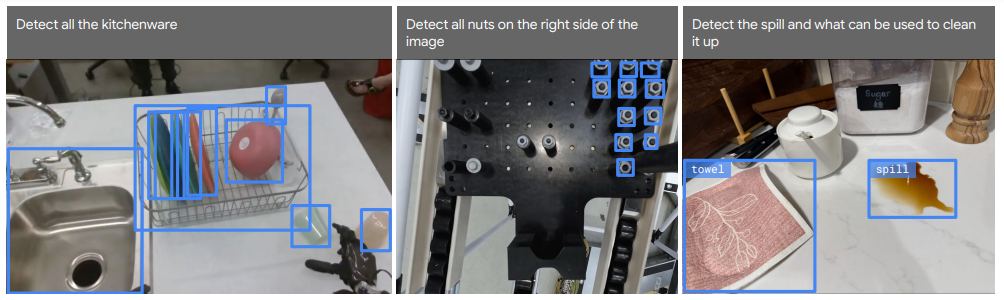

图 3:来自具身推理问答 (ERQA) 基准测试的示例问题,答案以粗体显示。

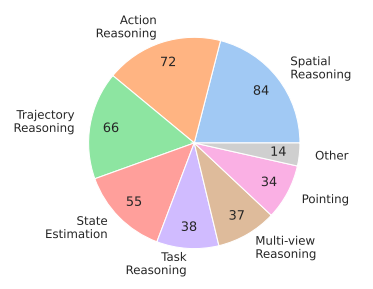

为衡量视觉-语言模型(VLM)在具身推理方面的能力,我们提出ERQA(Embodied Reasoning Question Answering)基准。该基准专注于评估具身智能体在物理世界中交互所需的能力,包含400道多选型视觉问答(VQA)题目,涵盖空间推理、轨迹预测、动作理解、状态估计、指向、多视角推理和任务规划等多个类别。

其中28%的题目提供多张图像,要求模型理解跨图像的对应关系,这类问题通常比单图问题更具挑战性。

图 4:ERQA 问题类别

ERQA补充了现有VLM评测基准的不足------传统基准多关注基础能力(如物体识别、计数、定位),而较少覆盖真实交互所需的综合能力。部分示例问题展示了模型需具备的多帧物体识别、功能理解和三维场景关系推理等能力。更多详情请访问:https://github.com/embodiedreasoning/ERQA。

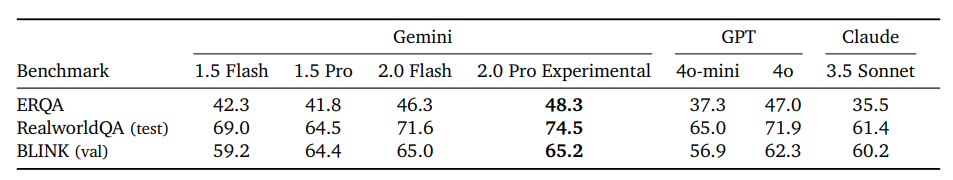

表 1:在多个基准测试上比较VLMs的具身推理能力评估,包括我们提出的新ERQA基准测试。基准测试通过多项选择题的准确率进行评估。结果采集于2025年2月。

为确保质量,我们对ERQA中的所有问题进行了人工标注。基准中的图像(非问题)由我们自行拍摄或来自以下数据集:OXE、UMI Data、MECCANO、HoloAssist 和 EGTEA Gaze+。表1中展示了Gemini系列模型及其他模型在ERQA、RealworldQA和BLINK三个基准上的表现。其中,Gemini 2.0 Flash 和 Gemini 2.0 Pro Experimental 在各自类别中均达到新的水平。值得注意的是,ERQA是三者中最具挑战性的基准,因此其上的优异表现尤为突出。

.

2)增加思维链 (CoT)

表 2:在有和没有思维链 (CoT) 提示的情况下在 ERQA 基准测试中的表现。

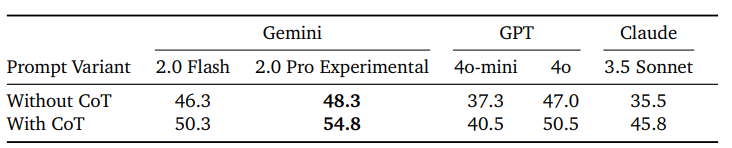

Gemini 2.0模型具备高级推理能力。我们发现,通过使用思维链(Chain-of-Thought, CoT)提示,可显著提升其在基准测试中的表现。CoT引导模型在选择答案前先输出推理过程,而非直接预测答案。我们在每个问题后添加如下指令作为CoT提示:"逐步推理答案,并展示每一步思考过程,之后再给出最终答案。"

结果显示(见表2),使用CoT后,Gemini 2.0 Flash的表现超过了未使用CoT的Gemini 2.0 Pro Experimental,而CoT也进一步提升了后者的表现。图5展示了两个案例:Gemini 2.0 Pro Experimental在无CoT时答错,但在使用CoT后正确作答。这些推理轨迹表明,Gemini 2.0能够:

-

精确地将空间理解与图像中的观察结果对应;

-

借助这种对应,进行复杂的、多步骤的具身推理。

图 5: Gemini 2.0 Pro Experimental 的问题和推理轨迹示例。在没有 CoT 提示的情况下获得红色答案;通过 CoT 提示获得绿色答案。

.

2.2. Gemini 2.0 具身推理能力

本节,我们更详细地介绍Gemini 2.0 的具身推理能力。同时,我们引入Gemini Robotics-ER,这是Gemini 2.0 Flash的一个版本,具备增强的具身推理能力。这些能力可以直接用于机器人应用,而无需额外的机器人专属数据或训练。

Gemini 2.0能够理解图像中的多种2D空间概念:

-

物体检测 (Object Detection):Gemini 2.0能够执行开放世界的2D物体检测,根据查询提供精确的2D边界框。这些查询可以是显式的(例如,指定物体名称)或隐式的(如类别、属性或功能)。

-

指向 (Pointing):给定任何自然语言描述,模型可以指向显式实体(如物体及其部件),也可以指向隐式概念(如可供性------"在哪里抓取""在哪里放置"),自由空间和空间概念。

-

轨迹预测 (Trajectory Prediction):Gemini 2.0能够利用指向能力生成基于观察结果的2D运动轨迹。例如,可以根据物理运动或交互描述生成轨迹。

-

抓取预测 (Grasp Prediction):Gemini Robotics-ER引入的新特性,扩展了Gemini 2.0的指向能力,可以预测自上而下的抓取点。

Gemini 2.0 还具备3D空间推理能力。凭借"3D视觉"能力,它能够更好地理解大小、距离、方向等概念,并利用这些理解推理场景状态及3D动作:

-

多视图对应 (Multi-View Correspondence):3D信息的自然表达方式是多视图(如立体视图)。Gemini 2.0能够从多视图图像中理解3D场景,并预测多个摄像机视角下的2D点对应关系。

-

3D边界框检测 (3D Bounding Box Detection):Gemini 2.0能够直接从单目图像预测3D边界框。与2D检测和指向能力类似,Gemini 2.0可以通过开放词汇描述检测物体。

虽然可以为每项任务单独构建专业模型,但将这些能力融合于一个基础模型(如Gemini 2.0)中,使模型能够根据开放世界的自然语言指令执行具身推理任务,响应反馈并进行多轮交互。尤其值得一提的是,Gemini 2.0 能结合场景理解与推理能力,完成更复杂的任务,例如生成机器人代码(见第2.3节)。

以下我们展示了Gemini 2.0模型(Flash和Pro Experimental)在这些能力上的定量与定性评估,并在适当情况下与其他视觉-语言模型(VLM)进行了比较。对于部分能力,我们也展示了Gemini Robotics-ER的实验结果。相关代码和提示示例在此处。

.

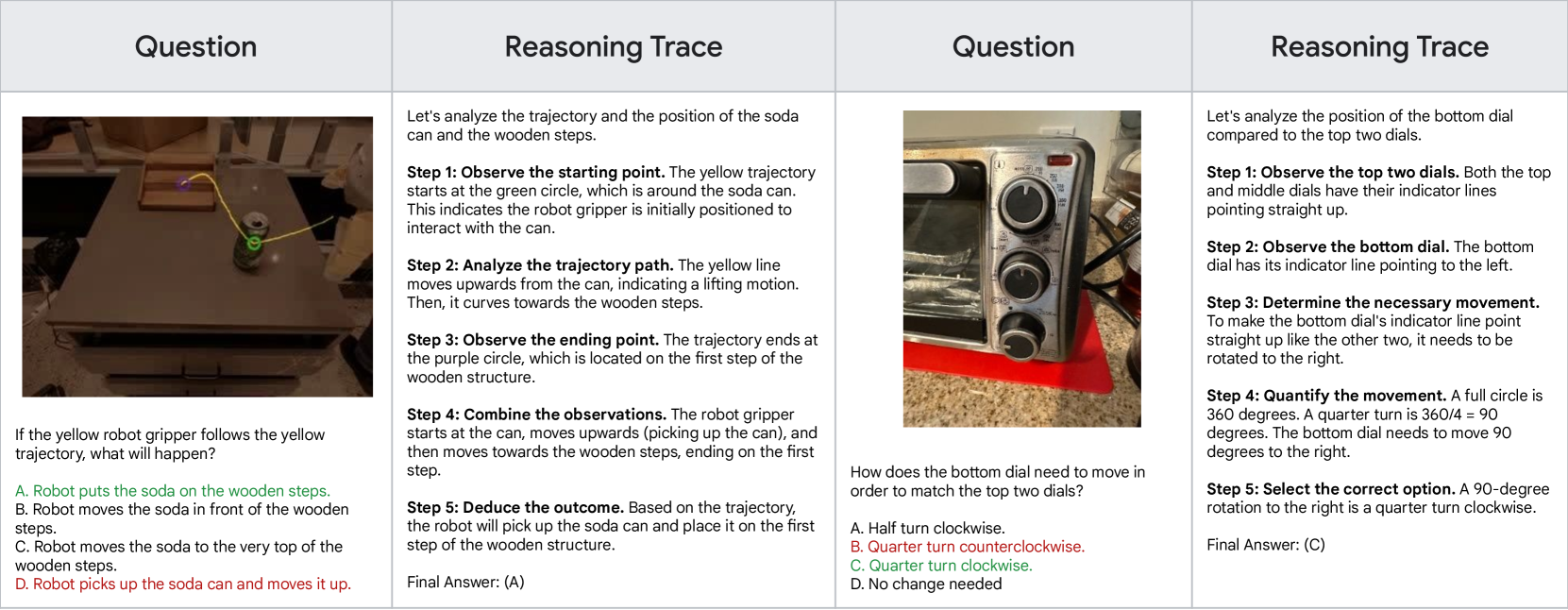

1)物体检测(Object Detection)

Gemini 2.0 可通过自然语言查询预测图像中的 2D 物体边界框。如图6所示,Gemini 2.0 Flash 能在机器人视角的图像上实现多目标检测。模型使用 [𝑦0, 𝑥0, 𝑦1, 𝑥1] 格式表示边界框。

Gemini 2.0 可以根据提示检测场景中所有物体(见图2),也可按描述识别特定对象,例如"检测所有厨具";描述中还可包含空间线索,如"检测图像右侧的螺母";甚至可根据功能进行检测,如要求检测"液体泼洒区域及其可用于清理的物品",模型会自动识别出液体和毛巾。

这些示例展示了将精准定位能力与通用视觉-语言模型结合的优势:Gemini 的开放词汇与开放世界推理能力,使其在语义泛化方面远超专用模型。

图 6: 使用 Gemini 2.0 Flash 的 2D 检测示例。左:按对象类别检测。中:通过空间描述进行检测。右:按可供性检测。左侧和中间图像不显示预测对象标签,以减少视觉混乱。

.

2)指向(Pointing)

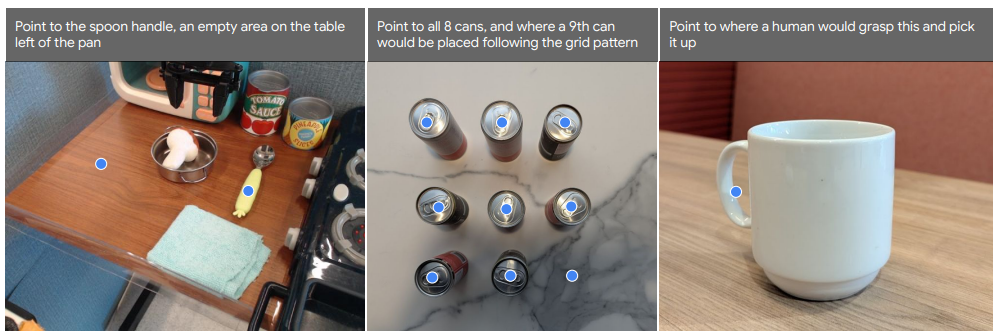

2D 指向能力:在某些场景中,点坐标比边界框更灵活精确,适用于图像理解和机器人控制。Gemini 2.0 能在多种机器人操作场景中实现精准指向(见图7),模型以 [𝑦, 𝑥] 格式表示点。

与 2D 检测类似,Gemini 2.0 可根据开放词汇语言描述指向任意物体,不仅能定位完整物体,还能识别物体部件(如勺柄)。此外,模型可理解空间概念,如"锅左侧桌面上的空位"或"按已有八个罐子的排列,指出新罐应放置的位置"。它还能推理功能,例如根据"人拿起这个物体时会抓哪里"的指令,正确指出杯子的手柄位置。

图 7:Gemini 2.0 可以从自然语言查询中预测 2D 点。示例是使用 Gemini 2.0 Flash 获得的。预测的点标签不会可视化。

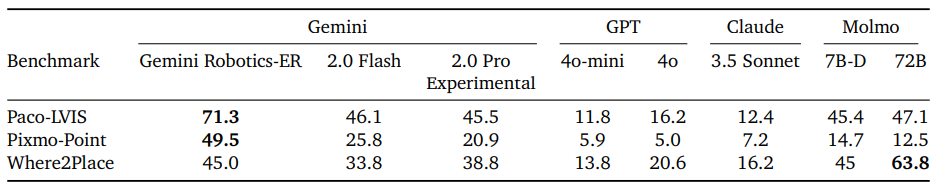

我们在表3中使用三个基准测试对Gemini 2.0的指向能力进行了定量评估:

-

Paco-LVIS:用于自然图像上的物体部件指向。

-

Pixmo-Point:用于网页图像上的开放词汇指向。

-

Where2place:用于室内场景的自由空间指向。

表 3:评估开放词汇指向功能的 2D 指向基准测试。分数为精度(如果预测点位于真实区域掩码内,则为 1,否则为 0)。

.

3)2D 轨迹(2D Trajectories)

2D 轨迹预测:Gemini 2.0 可基于指向能力,预测连接多个点的 2D 轨迹。虽然它无法进行复杂的避障运动规划,但能根据图像生成实用的运动路径。

如图8所示,模型可在第一视角视频中从人手位置插值到可能抓取的工具;也能预测一系列路径点,指导机器人擦拭托盘上的泼洒区域。

这些能力体现了Gemini 2.0 对运动和动力学的初步理解,为机器人技术提供了基础支持。这些能力将在第4.2节中与视觉和语言更紧密结合,用于动作控制。

图 8:Gemini 2.0 可以通过首先预测起点和终点来预测 2D 轨迹。示例是使用 Gemini 2.0 Flash 获得的。预测的点标签不会可视化。

.

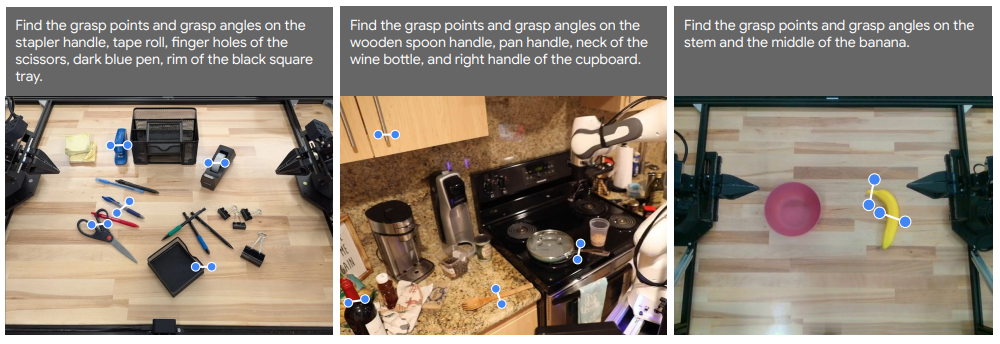

4)自上而下抓取(Top-Down Grasps)

自上而下的抓取预测:Gemini 2.0 的语义指向能力可自然扩展至自上而下的抓取姿态,表示为位置 (𝑦, 𝑥) 和旋转角度 𝜃。

这一能力在 Gemini Robotics-ER 中得到进一步提升(见图9)。例如,模型可根据提示选择抓取香蕉的"茎部"或"中心"。此类抓取预测可直接用于实际控制真实机器人。

图 9:Gemini Robotics-ER 可以利用 Gemini 2.0 的 2D 指向功能来预测自上而下的抓取。示例是使用 Gemini Robotics-ER 获得的。

.

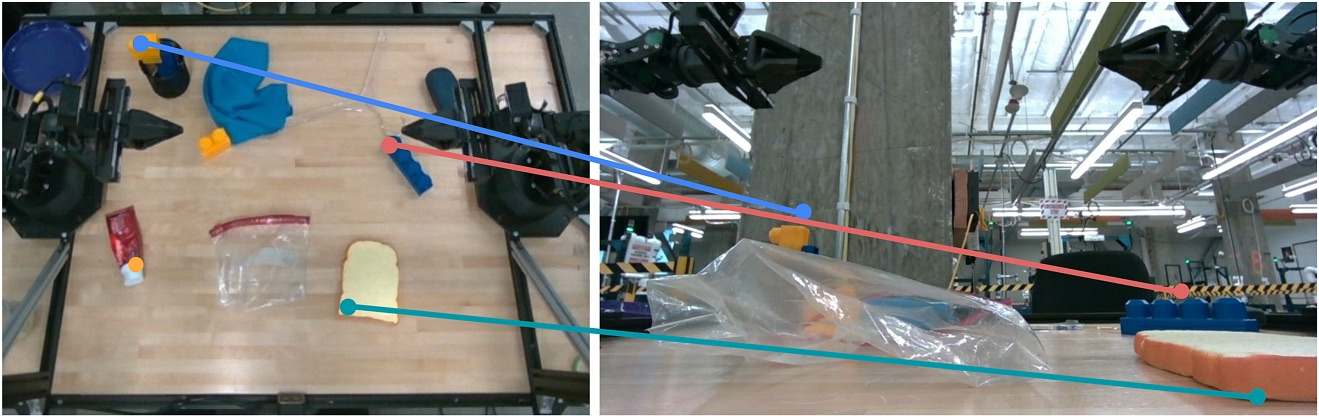

5)多视图对应(Multi-view Correspondence)

多视图对应:Gemini 能从多个视角理解同一场景的3D结构。

例如,给定一张标注了多个点的初始图像和另一张不同视角的图像,Gemini 2.0 可判断哪些点在新图像中仍然可见,并返回其坐标。如图10所示,即使视角发生显著变化,Gemini 2.0 仍能准确匹配关键点。

这种能力有助于机器人利用Gemini 2.0分析多视角图像流(如立体视觉、头戴与手腕视角),更准确地理解三维空间关系。

图 10: Gemini 2.0 可以通过关联不同视图中的 2D 点来理解 3D 场景。对于每个图像对,给出了带有点坐标的左图像和没有坐标的右图像,模型预测左图像中的哪些标记点在右图像中可见,以及右图像中可见点的坐标。示例是使用 Gemini 2.0 Flash 获得的。

.

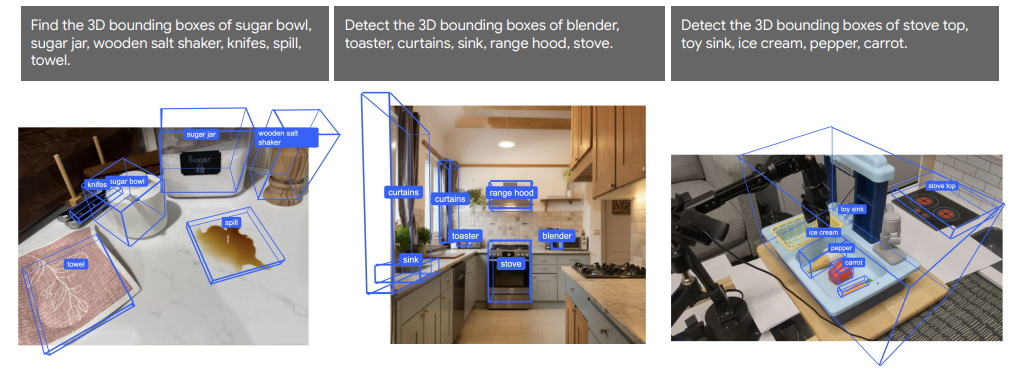

6)3D检测(3D Detection)

3D 检测:Gemini 2.0 可从单张图像中预测具有度量信息的 3D 边界框,支持开放词汇查询,如图11所示。

在 SUN-RGBD 数据集上(常用于 3D 物体检测与场景理解),我们将 Gemini 2.0 的表现与多个专家模型(ImVoxelNet、Implicit3D、Total3DUnderstanding)进行对比(见表4)。

结果显示,Gemini 2.0 的 3D 检测性能与当前最先进的专家模型相当,其中 Gemini Robotics-ER 更是在该基准上达到新的水平。相比仅支持固定类别的传统模型,Gemini 支持更灵活的开放词汇查询。

图 11:Gemini 2.0 可以直接预测开放词汇 3D 对象边界框。示例是使用 Gemini 2.0 Flash 获得的。

表 4: Gemini Robotics-ER 在 SUN-RGBD 3D 对象检测基准测试中实现了新的先进性能。(* ImVoxelNet (Rukhovich 等 人,2022 年)在一组更简单的 10 个类别上测量了性能)。

.

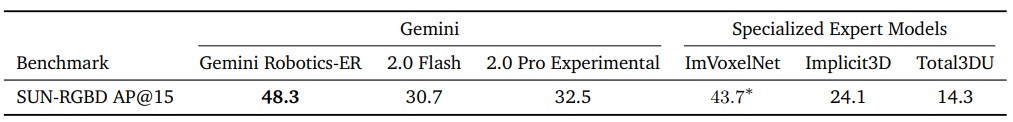

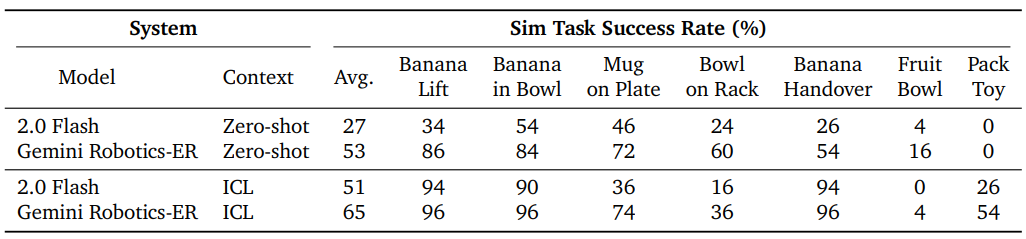

2.3. Gemini 2.0支持零样本和少样本机器人控制

Gemini 2.0 的嵌入式推理功能使其无需经过任何机器人动作数据训练即可控制机器人。它可以开箱即用地执行所有必要的步骤,包括感知、状态估计、空间推理、规划和控制。而以前的工作需要为此组合多个模型,Gemini 2.0 将所有需要的功能整合到一个模型中。

我们研究了两种机器人控制方法:

-

零样本控制:通过代码生成实现;

-

少样本控制: 通过上下文学习,即ICL。

Gemini Robotics-ER 在多种任务中均表现出色,尤其在零样本控制方面,其任务完成率比 Gemini 2.0 提升近两倍,表明更强的具身理解能力显著提升了零样本控制性能。

.

1)零样本控制(Zero-shot Control)------通过代码生成

通过代码生成实现零样本控制:为测试Gemini 2.0的零样本控制能力,我们将其代码生成能力与第2.2节所述的具身推理能力结合,在双臂ALOHA 2机器人上开展实验。Gemini 2.0通过一个API控制机器人,该API可移动夹爪、控制开合,并获取机器人当前状态。此外,Gemini 2.0还利用自身感知能力检测物体边界框、关键点,并生成俯视抓取姿态,无需调用外部模型。

在任务执行过程中,Gemini 2.0 首先接收系统提示、机器人API描述和任务指令。随后,模型在每一步接收展示场景状态、机器人状态及执行反馈的图像,输出控制机器人动作的代码。该代码通过API感知环境并操控机器人,形成一个可响应变化并重新规划的执行循环(如图34所示)。图12展示了API与任务执行流程的概览。

图12:感知与控制API的概览,以及在一个控制回合中的智能编排。该系统用于零样本控制。

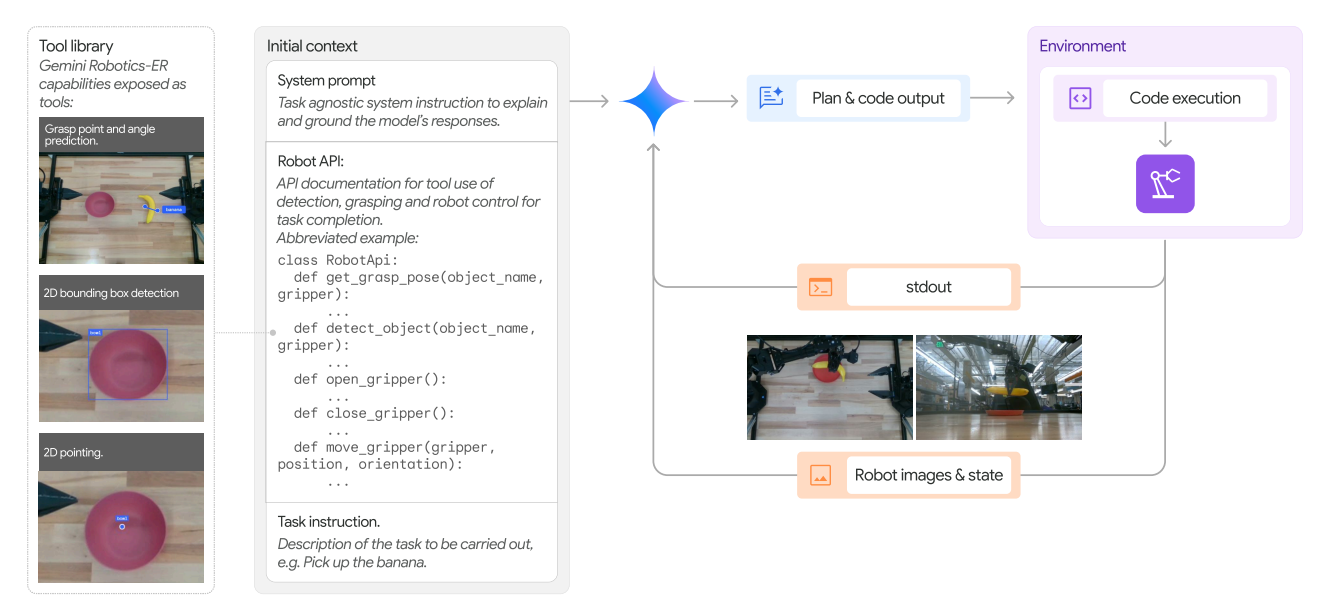

表5展示了在模拟环境中一系列操作任务的实验结果。任务难度从简单抓取(如拿起香蕉)到多步骤、多任务的复杂操作(如将玩具放入盒中并关闭盒子)不等(详见附录B.3.1)。

结果显示,Gemini 2.0 Flash 平均成功率为27%,在简单任务中最高可达54%;而具备更强具身推理能力的 Gemini Robotics-ER 表现接近其两倍,平均任务完成率达53%。这表明 Gemini Robotics-ER 的增强能力显著提升了机器人任务的执行效果。

表5:ALOHA 2模拟任务集(ALOHA 2 Sim Task suite)的成功率。数据为50次随机初始条件实验的平均成功率。

表 6 显示了真实 ALOHA 2 机器人的结果。与仿真相比,由于校准缺陷和现实世界中的其他噪声源,香蕉切换的成功率较低。对于更难、更灵巧的任务:Gemini Robotics-ER 目前无法进行裙子折叠,主要是因为它无法产生足够精确的抓取。

表6:Gemini Robotics-ER在真实ALOHA 2机器人任务中的成功率。香蕉传递任务的成功率取10次实验的平均值,折叠衣物和擦拭任务的成功率取9次实验的平均值。对于需要高度灵巧操作的任务,零样本成功率仍然较低,但在Gemini Robotics模型(见第3节)中将有显著提升。

.

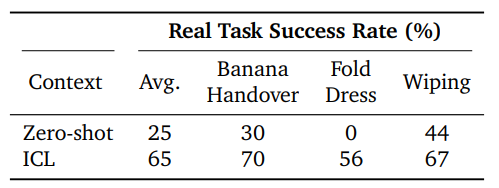

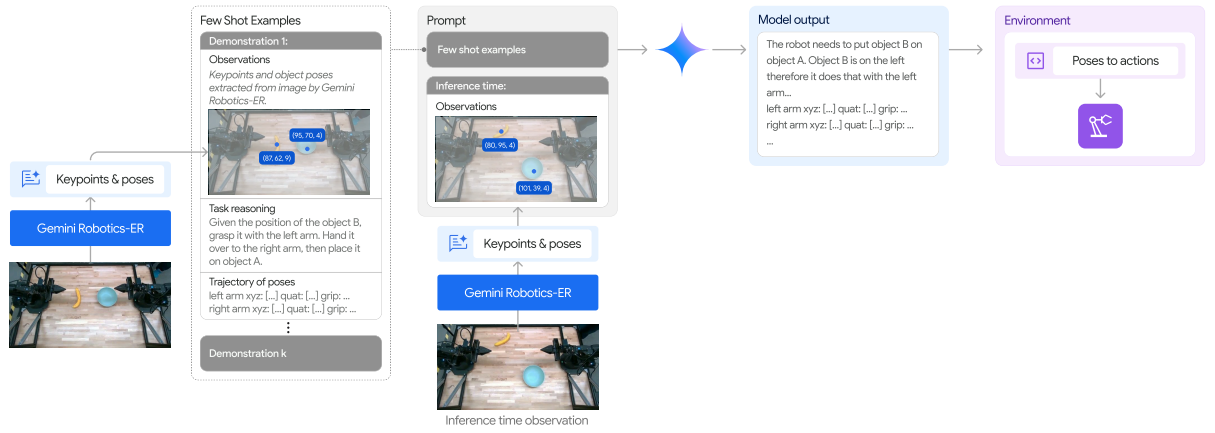

2)少样本控制(Few-shot Control)------通过上下文示例(In-Context Learning, ICL)

通过上下文示例实现少样本控制: 前述实验展示了Gemini Robotics-ER在零样本设置下完成任务的能力,但某些高精度操作任务仍超出Gemini 2.0的零样本控制范围。为此,我们探索了通过少量上下文演示引导模型模仿行为的方法。与之前生成代码不同,本方法引导模型直接生成末端执行器的运动轨迹。

我们扩展了Di Palo和Johns(2024)提出的方法,将k条遥操作轨迹转换为对象和末端执行器姿态的列表,并以文本形式加入提示(见图13)。得益于Gemini Robotics-ER的具身推理能力,无需依赖外部模型提取视觉关键点和物体姿态,模型自身即可完成。除了动作和观察信息,我们还在提示中加入语言描述,激发模型在推理时进行逻辑思考。通过这种方式,模型能更好地理解何时使用哪只机械臂、更准确地判断与物体交互的位置等。

图13:少样本上下文学习(Few-shot In-Context Learning, ICL)流程概览。Gemini可以接收观测信息、语言指令和轨迹示例,并在此基础上为新任务实例生成新的语言推理和轨迹。

采用该方法(使用10个演示示例)的实验结果见表5和表6。Gemini 2.0 Flash 和 Gemini Robotics-ER 均能有效利用上下文中的演示提升表现。Gemini 2.0 Flash 在模拟中达到51%的成功率,而 Gemini Robotics-ER 在模拟和真实世界中均达到65%。相比零样本代码生成方法,性能提升主要体现在高精度任务(如物体传递、折衣服、装盒)中,演示信息帮助模型生成更准确的双臂轨迹。

本组实验表明,Gemini 2.0 Flash 及其增强版 Gemini Robotics-ER 可直接用于机器人控制,作为感知模块(如物体检测)、规划模块(如轨迹生成),或通过生成和执行代码协调机器人动作。模型的具身推理能力与机器人控制表现密切相关。同时,实验也展示了模型可通过上下文学习,仅凭少量演示即可提升对高精度、双臂协作任务(如折衣服)的控制能力。

然而,作为视觉-语言模型(VLM),其在连接推理与动作之间仍需中间步骤,对高精度任务存在一定局限。下一节将介绍Gemini Robotics,一个端到端的视觉-语言-动作(VLA)模型,用于实现更通用、更灵巧的机器人控制。

.

.

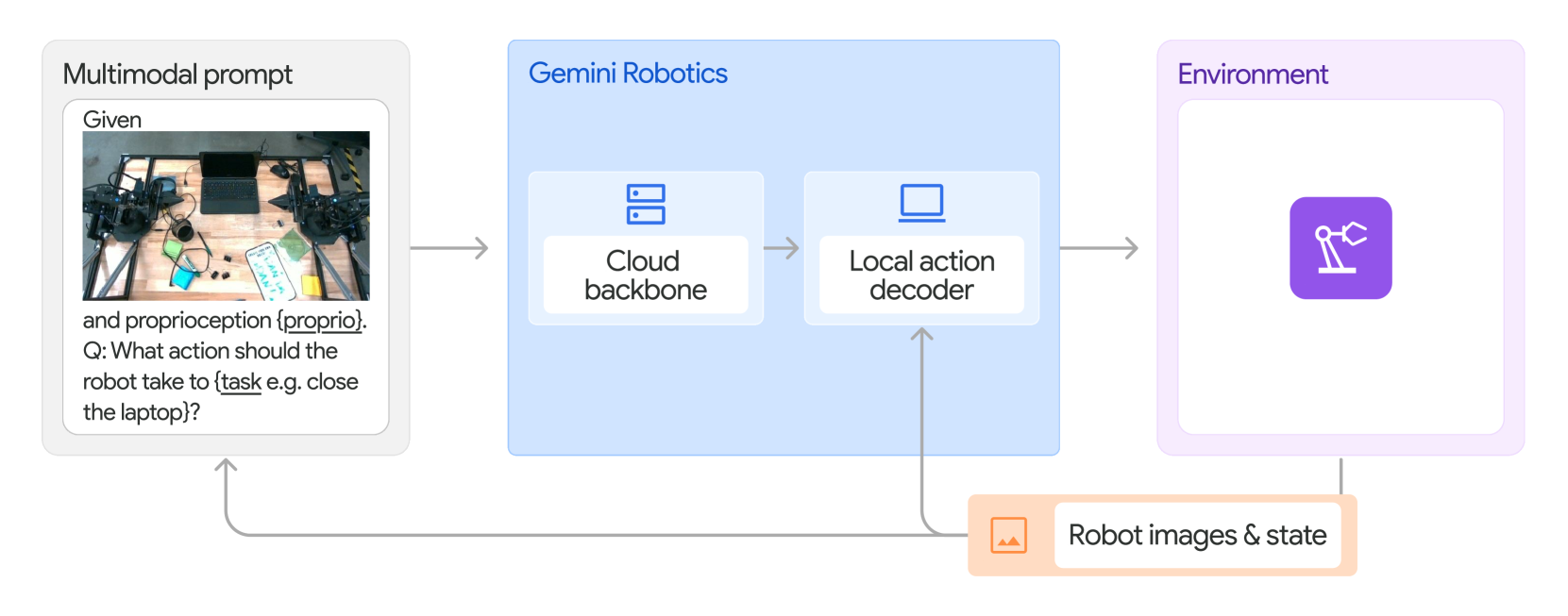

3. Gemini Robotics 执行机器人动作

图14:Gemini Robotics模型的架构、输入和输出概览。

Gemini Robotics 是 Gemini Robotics-ER 的一个衍生版本,经过微调以预测机器人动作。该模型接收多模态提示(multimodal prompt),该提示由一组场景当前状态的图像和要执行的任务的文本指令组成,并输出由机器人执行的动作块(action chunks)。

Gemini Robotics 由两个主要组件组成:

-

VLA主干 (Gemini Robotics backbone):在云端运行的视觉-语言-行动核心网络。

-

本地动作解码器 (Gemini Robotics decoder):在机器人板载计算机上运行的动作执行模块。

本节介绍Gemini Robotics,这是Gemini的衍生模型,经过微调可直接预测机器人动作。Gemini Robotics 是一个通用模型,能在不同环境中解决高精度操作任务,并支持多种机器人形态。

我们首先在包含动作标注的机器人数据及其他多模态数据的大规模数据集上训练该模型。训练后的模型可直接解决多种短时程高精度任务(第3.2节),能准确遵循自然语言指令(第3.3节),并继承Gemini Robotics-ER的泛化能力,对场景视觉变化、物体位置和种类具有鲁棒性(第3.4节)。

在第4节中,我们进一步探索Gemini Robotics的极限,将其专业化以应对高精度、长时程任务(第4.1节)和极端泛化场景(第4.2节),并研究其快速适应新任务(第4.3节)以及适配全新机器人形态(包括新的外观、动作和感知方式)的能力(第4.4节)。

.

3.1. Gemini Robotics 模型和数据

模型 :像Gemini Robotics-ER这样的大型视觉-语言模型(VLM)推理速度较慢,且需专用硬件,难以在机器人上实时运行,限制了其在实时控制中的应用。为此,我们设计了Gemini Robotics,采用云-端协同架构:

-

云端VLA主干网络(Gemini Robotics backbone):由Gemini Robotics-ER的轻量化版本构成,推理延迟从数秒优化至160毫秒以内;

-

本地动作解码器(Gemini Robotics decoder):运行在机器人端,补偿云端延迟。

两者结合后,从原始观测到低层动作输出的端到端延迟约250毫秒,通过动作块(action chunks)实现每秒50Hz的控制频率。该架构在保持模型泛化能力的同时,实现了流畅动作与实时响应。模型结构详见图14。

数据:我们通过多台 ALOHA 2 机器人收集了一个大规模遥操作机器人动作数据集,包含数千小时的真实专家演示,涵盖多样化的操作技能、物体、任务难度、时程长度和灵巧性要求。训练数据还包括非动作数据,如网页文本、代码、多模态内容(图像、音频、视频)以及具身推理与视觉问答数据,进一步提升了模型对各类机器人任务的理解、推理与泛化能力。

基线模型(Baselines):我们将 Gemini Robotics 与两个最先进的模型进行对比:

-

π₀ re-implement:我们对当前最先进的开源视觉-语言-动作(VLA)模型 π₀ 进行了复现,并在我们的多样化训练数据上进行了训练。该复现模型表现优于原作者发布的公开版本,因此作为我们实验中性能最强的VLA基线。

-

多任务扩散策略模型:受 ALOHA Unleashed 启发,该模型经过改进以支持任务条件控制,在从多模态演示中学习高精度技能方面表现出色。

两个基线模型均使用与 Gemini Robotics 相同的多样化数据集进行完整训练,并在本地配备 NVIDIA RTX 4090 GPU 的工作站上运行。Gemini Robotics 则主要部署在云端,搭配本地动作解码器运行。

.

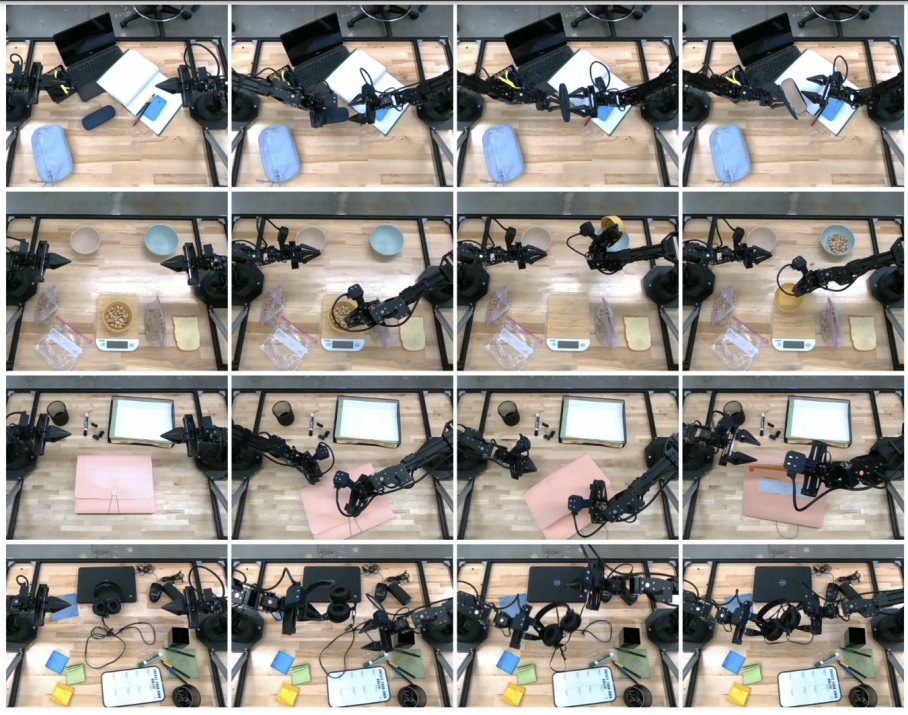

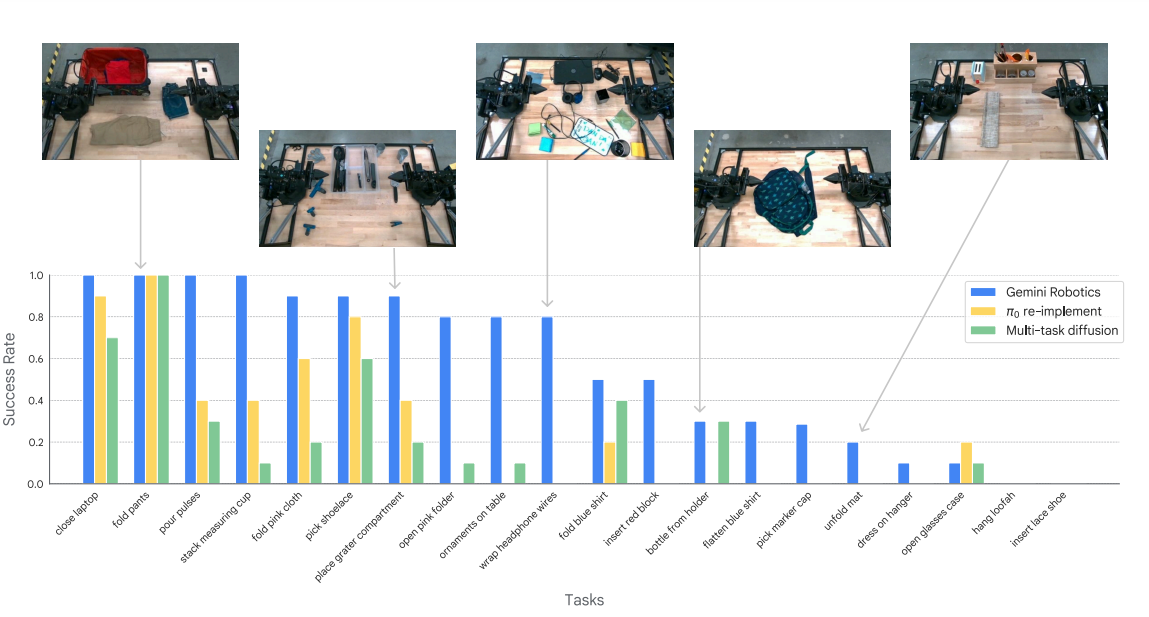

3.2. Gemini Robotics 可开箱即用解决各种高精度操作任务

在首轮实验中,我们验证了 Gemini Robotics 能够解决多种高精度任务。我们在20项短时程任务上评估其表现,并与当前最先进的多任务基线模型对比。所有模型均开箱即用 (即不进行任务微调或额外提示)。

任务场景多样,涵盖洗衣房(如"叠裤子")、厨房(如"叠放量杯")、杂乱办公桌(如"打开粉色文件夹")及日常操作(如"打开眼镜盒")。任务难度从简单的抓取(如"从桌中央拿起鞋带")到需双手协作的高精度操作(如"将电线绕在耳机上")不等。

图15展示了模型执行任务的示例。

图 15:机器人在一些示例任务中的移动,这些任务需要在杂乱的环境中进行灵巧的作。从上到下:"打开眼镜盒"、"倒脉冲"、"解开文件夹"、"缠绕耳机线"。

图 16:Gemini Robotics 可以解决各种开箱即用的任务。我们从数据集中抽取了 20 个任务,这些任务需要不同程度的灵巧性,并评估我们的模型和它们的基线。Gemini Robotics 的表现明显优于基线。

图16总结了Gemini Robotics与基线模型的表现。结果显示,Gemini Robotics在一半任务上开箱即用的成功率超过80% ,尤其在可变形物体操作任务(如"折叠粉布"、"将电线绕在耳机上")中表现优异,而基线模型在这些任务上表现较差。

对于更具挑战性的任务(如"打开粉色文件夹"、"插入红色积木"),Gemini Robotics是唯一能实现非零成功率的方法,表明高容量模型结构 与跨模态(视觉、语言、动作)高质量多样化数据对多任务策略学习至关重要。

尽管如此,部分高精度任务(如"穿鞋带")仍难以仅通过多任务设置学会,我们将在第4.1节中探讨通过专业化训练提升模型解决此类长时程、高精度任务的能力。

.

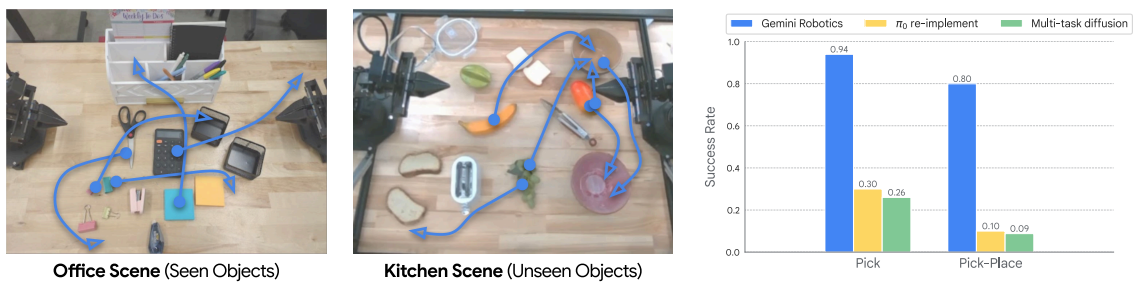

3.3. Gemini Robotics 能准确遵循自然语言指令

第二组实验测试了模型对自然语言指令的理解能力。我们在五个多样化场景中评估25条语言指令,包括训练中见过的场景和包含未见过物体与容器的新场景。评估重点是需精确执行的指令(如"将蓝色夹子放在黄色便签纸右侧"),而非开放性抽象指令(如"清理桌面")。图17展示了任务执行过程与二值任务成功率。

图 17:Gemini Robotics 可以在杂乱的场景中精确地遵循新颖的语言指令,这在训练中是从未见过的。左:包含训练期间看到的物体的场景。中间:包含新奇对象的场景。右图:"Pick"和"Pick and Place"任务的成功率,以及新对象的详细说明。

实验表明,出色的指令跟随能力源于高质量的多样化数据 与强大的视觉-语言主干网络的结合。Gemini Robotics 与 π₀ re-implement 在简单场景中均优于扩散策略基线模型,说明一个强大的语言编码器至关重要。

而在包含新物体 和细粒度指令的复杂场景中(如"将牙膏放入收纳盒的底层隔间"),Gemini Robotics 的表现明显优于两个基线模型(见图17)。相比之下,基于 PaliGemma 的 π₀ re-implement 虽能识别训练中见过的物体,但在理解描述性语言属性(如"顶部黑色容器"、"蓝色夹子")时表现较差,难以完成涉及新物体和语言描述的任务。

.

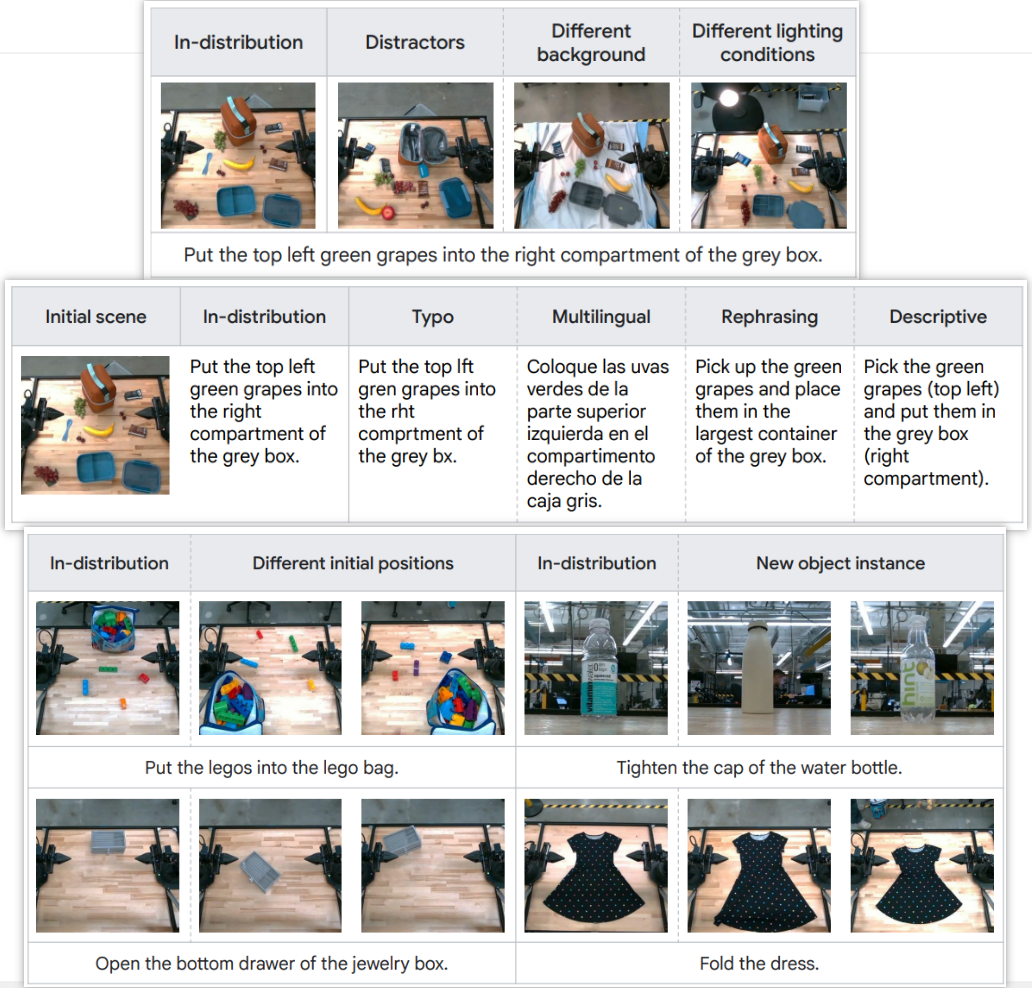

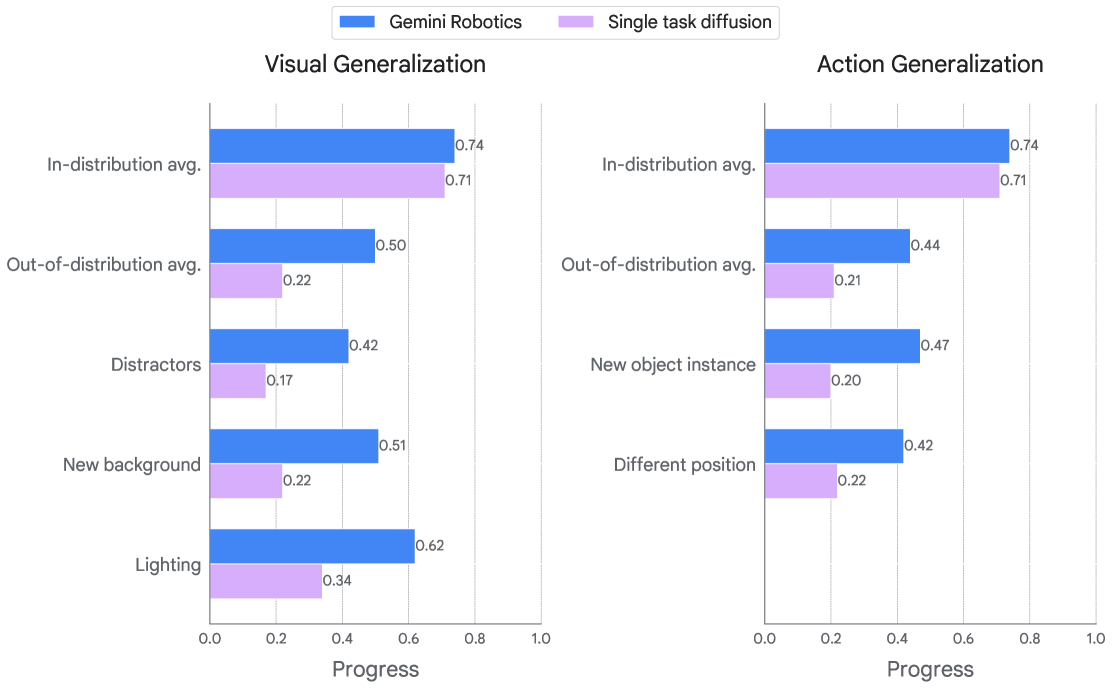

3.4. Gemini Robotics 将 Gemini 的泛化能力带入物理世界

缺乏鲁棒的泛化能力是机器人在家庭和工业场景大规模部署的关键瓶颈。在最后一组实验中,我们评估了 Gemini Robotics 在三个关键维度上的泛化能力:

-

视觉泛化:模型应对不影响任务操作的场景的视觉变化保持不变,如背景、光照、干扰物或纹理的改变;

-

指令泛化:模型应理解自然语言指令中的等价性和不变性,不仅能处理拼写错误、语言差异,还能理解不同表达方式和抽象程度的语言;

-

动作泛化:模型应能适应已学动作或合成新动作,例如推广到训练中未见过的初始条件(如物体位置)或物体实例(如形状或物理属性)。

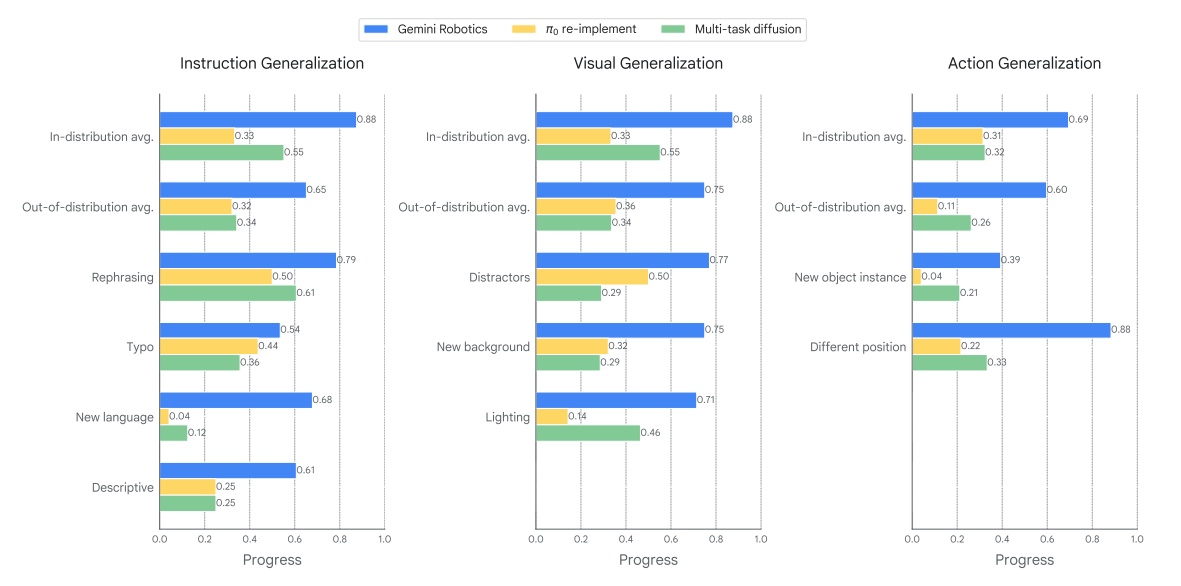

我们使用一个多样化任务集评估 Gemini Robotics 及基线模型的泛化能力,该任务集共包含85项任务,其中20%为训练分布内任务,28%用于测试视觉泛化 ,28%用于测试指令泛化 ,24%用于测试动作泛化 。图18至图20展示了三类泛化任务的示例。图21展示了平均进度得分,相比二值任务成功率,该指标提供更细粒度的评估,有助于观察各任务(尤其是困难任务)的执行进展。

图18至图20:三类泛化任务的示例

图 21:Gemini Robotics 泛化能力的细分。

如图21所示,Gemini Robotics 在应对所有三类泛化挑战方面始终优于基线模型。即使在基线模型完全失效的情况下(如遇到新语言指令),Gemini Robotics 仍能保持非零性能。我们认为,这一提升得益于更强大、规模更大的视觉-语言模型主干网络(包括Gemini 2.0中使用的最先进视觉编码器)与多样化训练数据的结合。

.

.

4. Gemini Robotics 的专业化与适配:提升灵巧性、推理能力与新形态适应

Gemini Robotics 是一个强大的通用机器人模型,可开箱即用解决多种高精度任务并具备良好泛化能力。本节进一步探索其极限,并研究未来提升其通用能力的路径:

-

(1)测试模型通过专业化训练掌握更复杂的长距离高精度任务的能力;

-

(2)通过语义驱动的具身推理,优化其泛化能力;

-

(3)探索其对新任务与环境的快速适应能力;

-

(4)研究其对新型机器人形态的适配能力。

其中,第(1)和(2)点为未来模型改进提供方向,第(3)和(4)点则是实际部署中所需的重要特性。

.

4.1. 长距离高精度操作

在第3.2节中,我们展示了Gemini Robotics可直接解决多种短距离高精度任务。本节进一步表明,通过使用少量高质量数据对模型进行微调 ,可使其专业化,从而解决更复杂、长距离的高精度任务,这些任务的难度已超出通用模型的原始能力范围。

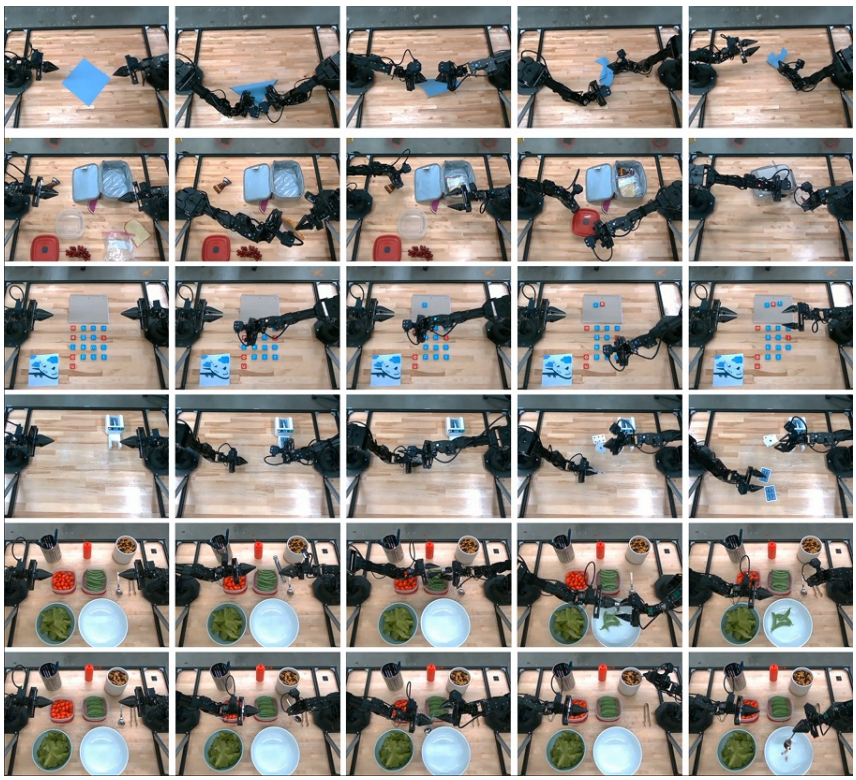

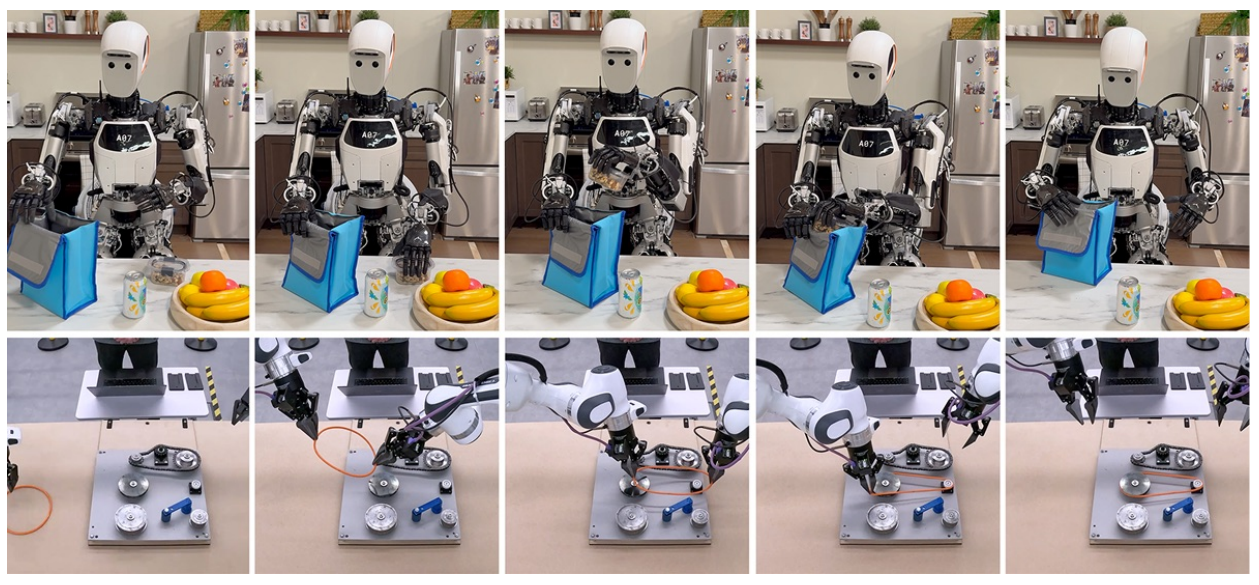

我们选取了六项任务(见图22),以展示专业化训练后模型在不同方面的能力表现。

图 22:Gemini Robotics 在 ALOHA 上成功完成了各种长视距灵巧任务。

专业化任务示例:

-

折纸狐狸(Make an origami fox)

-

打包午餐盒(Pack a lunch-box)

-

拼字桌游(Spelling board game)

-

玩纸牌游戏(Play a game of cards)

-

在沙拉中加入豌豆(Add snap peas to salad)

-

沙拉中加入坚果(Add nuts to salad)

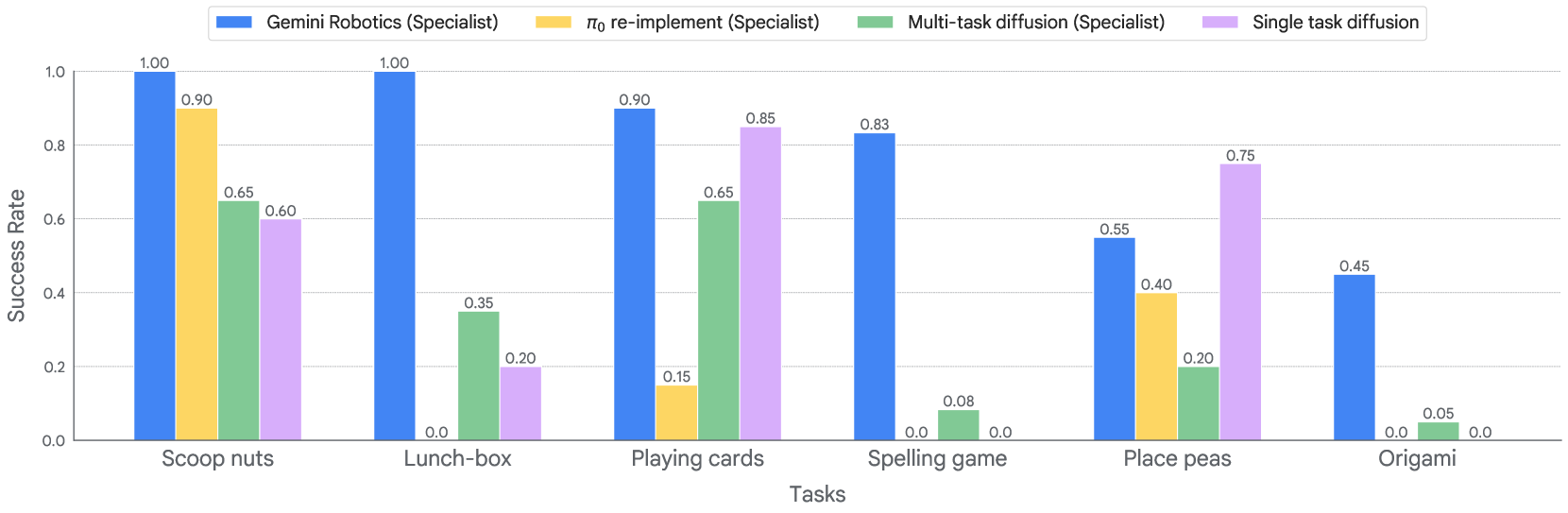

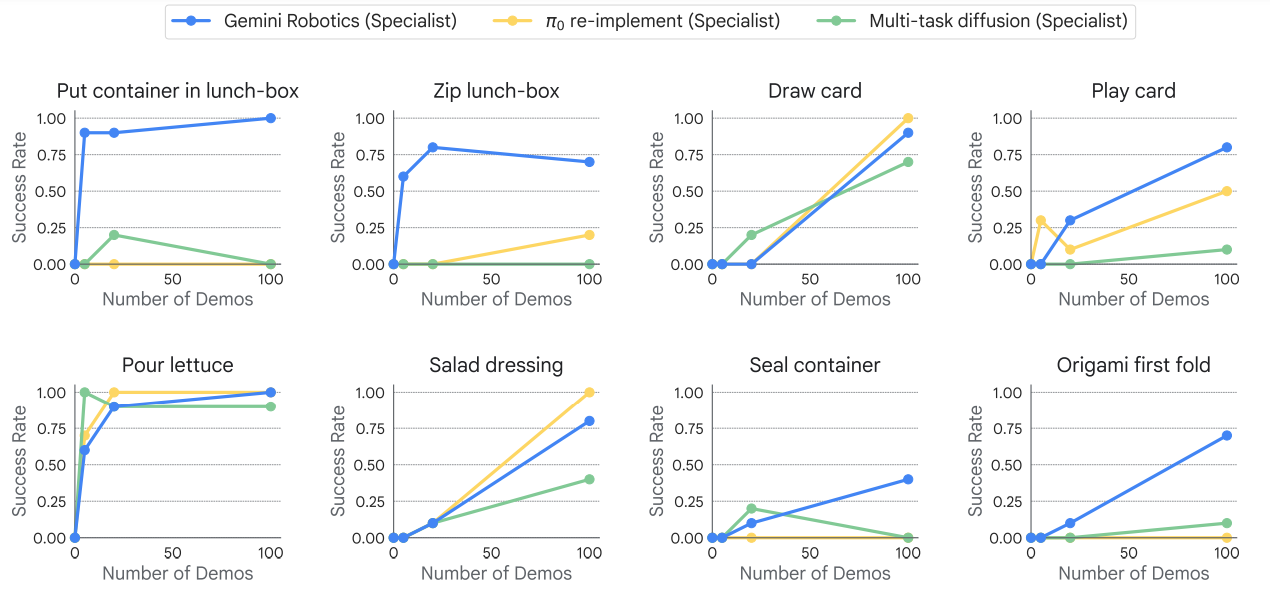

图 23:专业化后在新的、灵巧的和长期任务上的表现。

我们为每项任务整理了2000至5000条高质量演示数据,并基于第3节中的Gemini Robotics检查点进行微调,训练出专业化模型。我们将这些模型与基于相同数据训练的专业化基线模型(π₀ re-implement specialist 和 Multi-task diffusion specialist)进行对比。

此外,为评估第3节中多样化训练数据的重要性,我们还从零开始训练了一个单任务扩散策略模型和一个Gemini Robotics专业化模型(不使用第3节的检查点)。所有模型均在真实机器人上进行广泛测试,任务成功率见图23。除拼字游戏任务进行12次测试外,其余每项任务对每个模型均进行20次测试。

实验结果表明 ,我们的专业化模型在所有任务上的平均成功率达到了79% ,其中午餐盒打包这一耗时超过2分钟的长时程任务 达到了100%成功率。

在拼字游戏中,模型能够正确识别打印图像并拼出对应单词,对6个未见过的手绘图也能正确拼出4个。相比之下,所有基线模型都无法稳定识别图像并正确拼写。

对于较简单的高精度任务,从零开始训练的单任务扩散模型 表现尚可,与当前最优结果一致(Zhao等,2025)。但在拼字、折纸和午餐盒打包等长距离任务中表现较差。同样使用相同数据微调的 Multi-task diffusion 和 π₀ re-implement 也未能达到我们的模型性能,再次表明Gemini Robotics的强大多模态主干网络是关键优势。

更重要的是,当我们从零开始训练Gemini Robotics专业化模型 时,其在所有任务上表现均为0%成功率(图23未展示),说明除了高容量模型结构外,从多样化机器人动作数据中学到的表示能力或物理常识,是模型能够专业化处理高精度、长时程任务的另一关键因素。

.

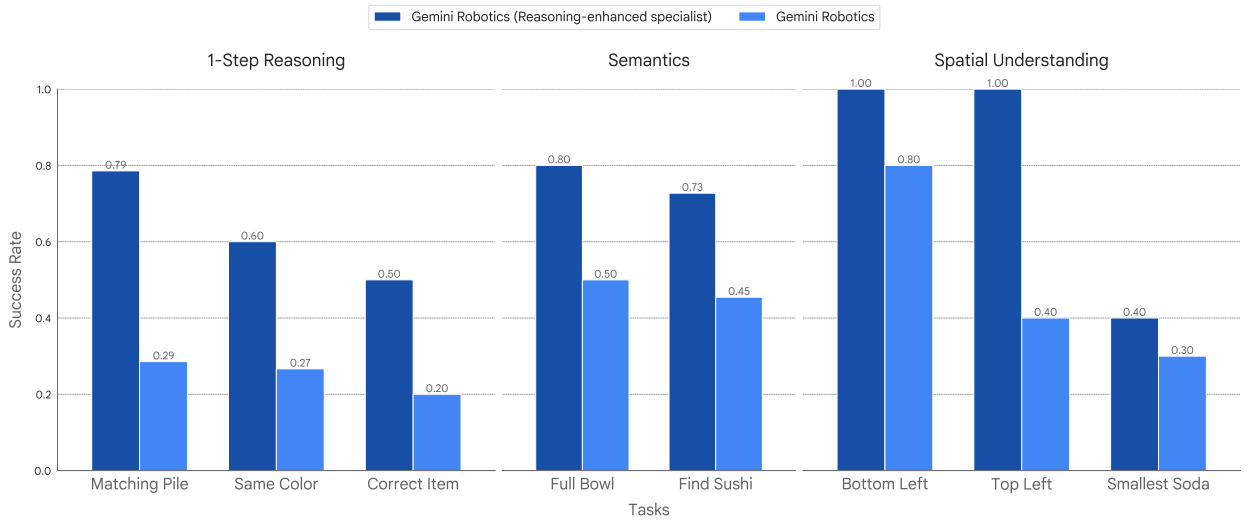

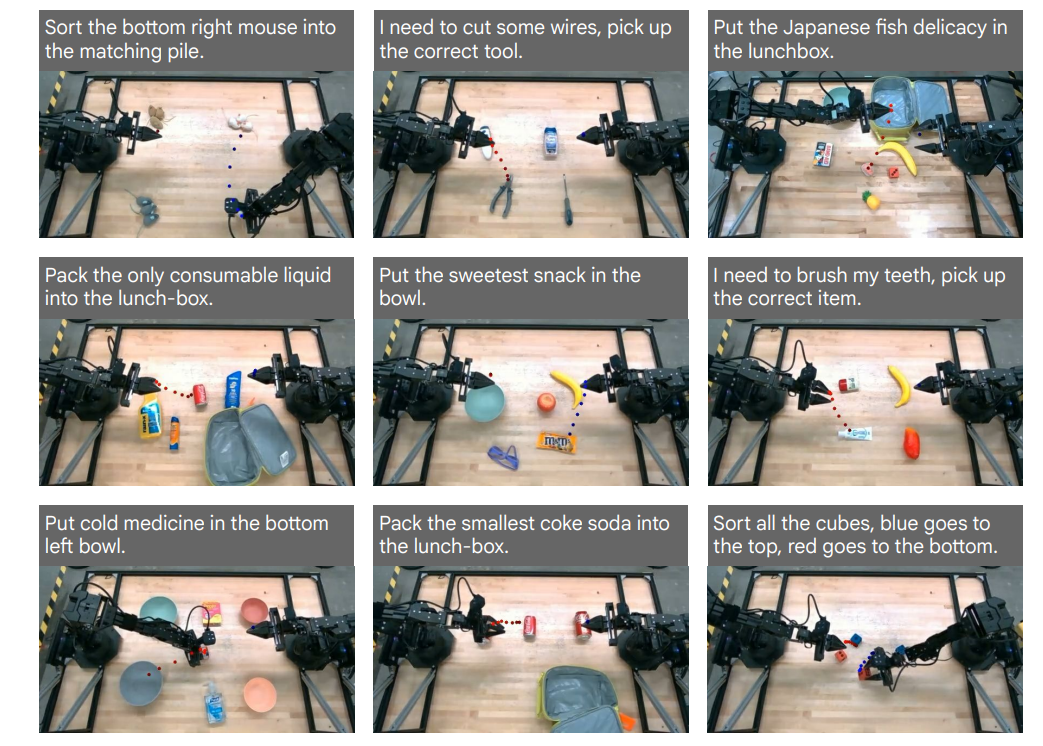

4.2. 增强的推理和泛化

我们探索如何充分利用 Gemini Robotics-ER 中新增的具身推理能力(如空间与物理理解、世界知识),以指导需要更强推理和泛化能力的低层机器人动作。尽管已有方法在视觉鲁棒性上取得进展,但当前视觉-语言-动作模型(VLAs)在保留抽象推理并用于行为泛化方面仍面临挑战。

为此,我们对第3.1节中的机器人动作数据集进行重标注 ,并在此基础上微调模型,使其动作预测更贴近新引入的轨迹理解与生成能力(见第2.2节)。同时扩展本地动作解码器,将推理中间结果转化为连续低层动作。

我们将这一增强推理能力的模型与基础版 Gemini Robotics(第3节)在多个不在训练分布内的真实任务上进行对比。这些任务综合了第3.4节中的多种分布偏移,要求模型能同时应对指令、视觉和动作的多重变化。

-

单步推理:此类任务中,指令通过物体属性或功能间接指定目标对象或操作。例如,"将右下角的老鼠归类到匹配的堆中",模型需识别右下角的白色玩具鼠,并将其归类到同色鼠堆中,而忽略棕色和灰色鼠堆。所有这类物体及按颜色归类的任务在训练数据中均未出现。

-

语义泛化:这些任务要求模型具备比第3.4节更强的语义与视觉理解能力。例如,"将日本鱼生放入午餐盒",模型需从多个干扰物中识别出寿司并将其装入午餐盒。

-

空间理解:此类任务要求理解相对与绝对空间关系。例如,"将最小的可乐罐放入午餐盒",模型需识别出迷你尺寸的罐子而非标准尺寸的罐子,并将其放入午餐盒。描述"最小"这一空间概念的语言在训练数据中未出现。

图24展示了基础版 Gemini Robotics 模型及其增强推理版本在真实世界评估中的成功率。尽管基础模型表现尚可,但在需要单步推理、语义理解 和空间认知 的分布外任务中,增强推理版本显著提升了成功率。

此外,除了在新场景中更强的泛化能力,增强版本还具备更高的可解释性,能够输出类似人类可理解的推理过程,类似于 Gemini Robotics-ER 的具身推理轨迹。这一优势在多个先前研究中也被强调。

例如,图25展示了模型内部"思维链"中使用的关键点轨迹可视化,体现了其推理过程的可解释性提升。

图 24:需要具体推理的真实机器人任务的性能。在对将动作预测与具身推理能力联系起来的重新标记的动作数据集进行微调后,该模型可以推广到结合多种类型分布偏移的新情况。

图 25:预测轨迹的可视化,用作推理增强的 Gemini Robotics 模型内部思维链的一部分。轨迹表示模型预测的运动路径,利用隐含推理知识,用于左臂(红色)和右臂(蓝色)在接下来的 1 秒内。

.

4.3. 快速适应新任务

机器人基础模型有望通过已有的物理交互常识,实现对新任务的快速学习。与第4.1节聚焦长时程高精度任务不同,本节研究模型在短时程任务上的快速适配能力。

我们从此前的长时程任务中选取8个子任务),并使用不同数量的演示数据对第3节的模型检查点进行微调。图26展示了不同演示数量下各任务的平均成功率。

图 26:通过有限数量的演示快速适应新任务。微调 Gemini Robotics 在 8 项任务中的 7 项中取得了超过70%的成功率,最多 100 次演示,达到100%成功完成两项任务。虽然基线在较简单的任务上表现良好,但 Gemini Robotics 在具有挑战性的任务上表现出色,例如折纸第一次折叠和午餐盒作,演示次数少于 100 次。

结果表明,在8个任务中的7个上,使用最多100次演示 (相当于15分钟至1小时的演示数据),模型微调后的成功率即可超过70%。其中有两项任务的成功率甚至达到100%。

基线模型在简单任务上表现尚可,例如"倒生菜"效率较高,在"加沙拉酱"和"抽牌"任务中,π₀ re-implement 的成功率略高。但在"折纸狐狸第一折"和午餐盒打包等较难任务上,基线模型在演示数据有限的情况下表现不佳。

这进一步说明,一个强大的视觉-语言模型主干网络,能更有效地从多样化机器人动作数据中学习物理交互细节,是实现快速任务适配的关键。

.

4.4. 适配新机器人形态

我们初步探索了在 ALOHA 2 机器人上训练的 Gemini Robotics 模型,如何仅需少量目标平台数据即可适配控制新型机器人形态。

实验中,我们将其适配至双臂 Franka 机器人(配备平行夹爪)和 Apptronik 公司的全尺寸人形机器人 Apollo(具备五指灵巧手)。图27展示了两种机器人上的任务示例。

图 27:Gemini Robotics 模型可以微调以控制不同的机器人。上图:Apollo 人形机器人打包一个午餐袋。下图:双臂工业机器人在滑轮系统周围组装工业橡皮筋。

微调后,Gemini Robotics 在分布内任务上的成功率与当前最先进的单任务扩散策略相当甚至更优。例如,适配至 Franka 双臂机器人后,模型在所有测试任务上的平均成功率为 63%。

我们还测试了该模型在视觉干扰、初始条件扰动和物体形状变化下的鲁棒性。如图28所示,Gemini Robotics 在视觉与动作泛化测试中显著优于单任务扩散基线模型。

图 28:当 Gemini Robotics 模型适应新的实施例,即双臂 Franka 机器人时,泛化指标的细分。它在视觉和动作泛化轴上始终优于扩散基线。我们不分析指令泛化,因为单任务扩散基线不以指令为条件。

这一结果表明,Gemini Robotics 在适配新机器人形态后,仍能保持其鲁棒性与泛化能力,展现出跨形态迁移的强大潜力。

.

.

其他

以上就是该论文对模型部分的相关内容,后面还有一些安全、讨论、引用等方面的内容,如需要了解请参考原文。

.

论文《Gemini Robotics: Bringing AI into the Physical World》

.

声明:资源可能存在第三方来源,若有侵权请联系删除!