Claude Code能够支持的格式是Anthropic公司独有的API格式,和OPENAI并不兼容,但是claude-code-router的出现,则很好的解决了这个问题。 加上qwen3-coder的强大编码能力,使Claude Code工具的强大加上国内大模型方便访问,二者结合成为可能。 我以windows环境为例说明:

1 安装node.js

1)访问node.js官网,下载安装包,npmmirror.com/mirrors/nod... 2)点击运行安装包,安装好,之后,打开命令行输入,显示如下信息,安装成功

cmd

node

Welcome to Node.js v22.15.0.

Type ".help" for more information.

>2 安装Claude Code

在node.js command prompt命令行窗口输入,注意建议采用带参数 -g,表示全局安装。这样安装好之后的Claude Code可以在任意目录下运行。

cmd

npm install -g @anthropic-ai/claude-code安装完成后可以使用

cmd

claude --version

1.0.68 (Claude Code)进行检查。成功出现版本号即可。

3 Claude Code访问qwen3 code大模型

1)修改系统环境变量,在windows系统下,为保证每次运行不需要单独设置,可以在系统的"设置",修改环境变量中添加如下两个变量(建议设置为用户级,不需要重启机器,只需要重启node.js command prompt命令行):

cmd

ANTHROPIC_BASE_URL=https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxyexport

ANTHROPIC_AUTH_TOKEN=这里用你的阿里云百炼api-key替换阿里云百炼大模型平台的api-key申请,请自行到官网申请,这里就不再写教程了,相信大家都会。 官网地址:大模型服务平台百炼_企业级大模型开发平台_百炼AI应用构建-阿里云

2)环境变量设置好之后,重新启动node.js command prompt命令行。运行

cmd

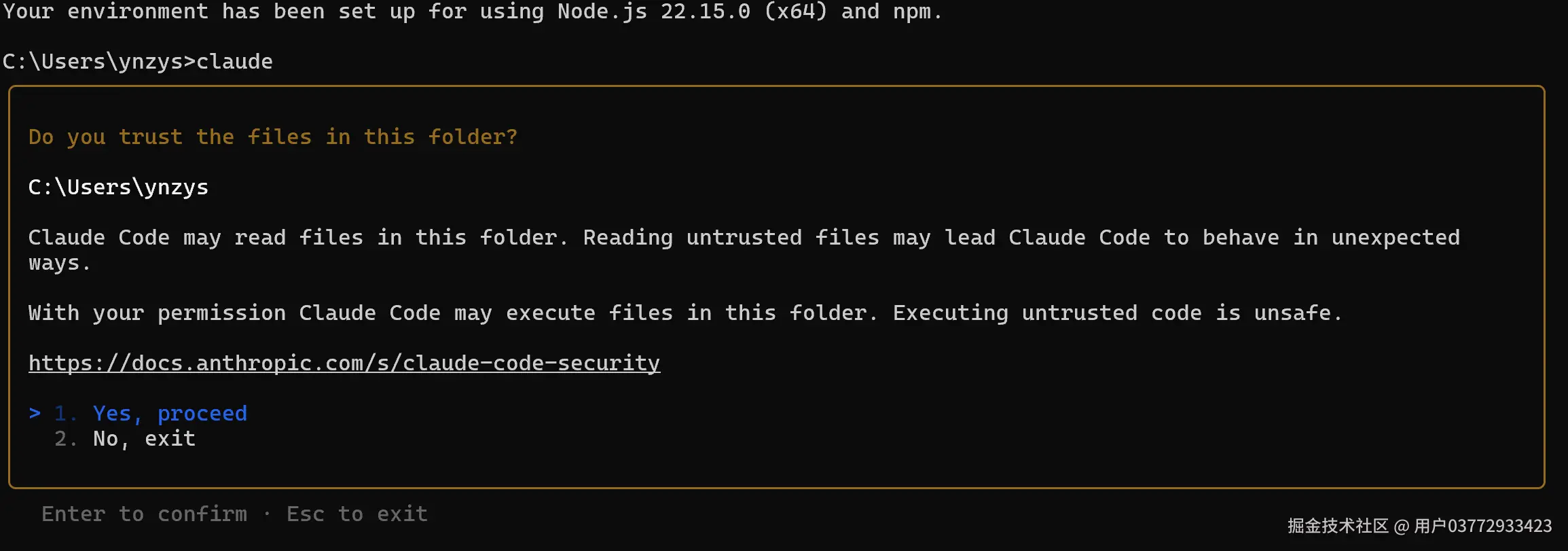

claude 选择yes

选择yes

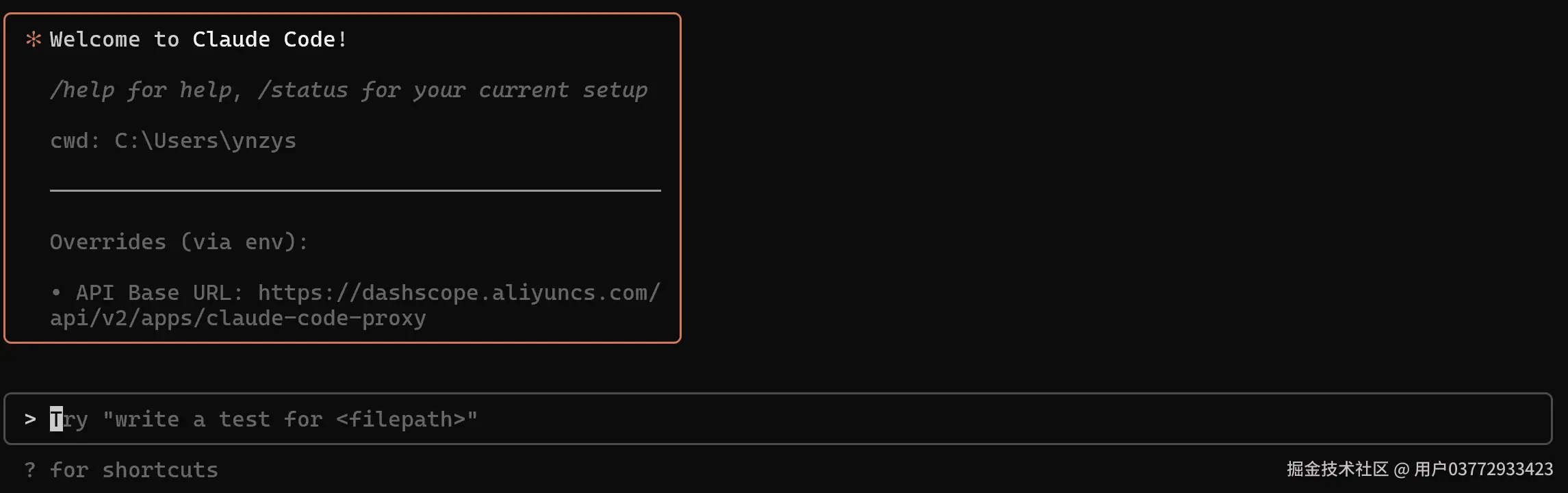

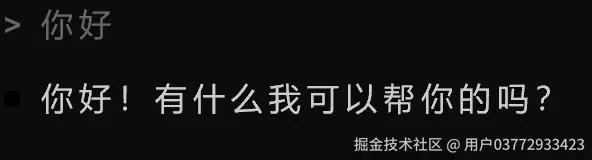

试着在窗口中打入"你好"

试着在窗口中打入"你好"

成功!如果出现API的提示错误等信息,可能是环境变量错误,或者你的百炼api没有充值,没有额度。 <math xmlns="http://www.w3.org/1998/Math/MathML"> 友情提醒,百炼大模型没有包月,用起来 R M B 也是刷刷的流走。 \color{red}友情提醒,百炼大模型没有包月,用起来RMB也是刷刷的流走。 </math>友情提醒,百炼大模型没有包月,用起来RMB也是刷刷的流走。

4 使用claude-code-router访问OPENAI兼容的大模型

上面直接采用claude命令访问阿里云百炼qwen3 code大模型简单直接好用,但是阿里云百炼的大模型没有免费白嫖的机会,所以我们考虑找一些国内的有免费额度的服务来使用,降低成本。最好用的莫过于魔搭社区了。 魔搭社区友好的提供了qwen3 code的500次免费访问,当然是不二之选。我自己用下来性能平替百炼无差别,时间上的话,顶大半天没问题。请继续看如何搞定。 去魔搭社区申请api-key,记下来,后面要用

js

OPENAI_API_KEY=your-api-key

OPENAI_BASE_URL=https://api-inference.modelscope.cn/v1

OPENAI_MODEL=Qwen/Qwen3-Coder-480B-A35B-Instruct1)安装claude-code-router 老办法:

cmd

npm install @musistudio/claude-code-router -g2)安装一个配置工具(我这块没怎么研究,照抄别人的)

cmd

npm install @leason/claude-code-config -g3)查看并修改配置文件 在C:\users\用户名.claude-code-router有一个名字叫config.json的文件,内容如下:

js

{

"LOG": false,

"OPENAI_API_KEY": "",

"OPENAI_BASE_URL": "",

"OPENAI_MODEL": "",

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1",

"api_key": "ms-252d4f3f-f047-44fc-affc-c7c01d398ccb",

"models": [

"Qwen/Qwen3-Coder-480B-A35B-Instruct"

]

}

],

"Router": {

"default": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct"

}

}内容替换为

js

{

"LOG": false,

"OPENAI_API_KEY": "",

"OPENAI_BASE_URL": "",

"OPENAI_MODEL": "",

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1/chat/completions",

"api_key": "your-api-key这里是你自己的key",

"models": ["Qwen/Qwen3-Coder-480B-A35B-Instruct", "Qwen/Qwen3-235B-A22B-Thinking-2507"],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

],

"enhancetool"

],

"Qwen/Qwen3-235B-A22B-Thinking-2507": {

"use": ["reasoning"]

}

}

}

],

"Router": {

"default": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct",

"background": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct",

"think": "modelscope,Qwen/Qwen3-235B-A22B-Thinking-2507",

"longContext": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct",

"longContextThreshold": 60000,

"webSearch": "gemini,gemini-2.5-flash"

}

}主要修改你自己的api-key,添加推理模型,这个很重要,默认要加载推理模型,不配置的话,会出现推理模型连接错误,无法运行。

4)运行ccr start,初始化配置并启动服务

cmd

ccr start

Enter Provider Name: modelscope

Enter Provider API KEY: 这里用你自己的魔搭api-key替换

Enter Provider URL: https://api-inference.modelscope.cn/v1

Enter MODEL Name: Qwen/Qwen3-Coder-480B-A35B-Instruct

undefined

Loaded JSON config from: C:\Users\ynzys\.claude-code-router\config.json

register transformer: Anthropic (endpoint: /v1/messages)

register transformer: gemini (endpoint: /v1beta/models/:modelAndAction)

register transformer: vertex-gemini (endpoint: /v1/projects/:projectId/locations/:location/publishers/google/models/:modelAndAction)

register transformer: vertex-claude (endpoint: /v1/projects/:projectId/locations/:location/publishers/anthropic/models/:modelAndAction)

register transformer: deepseek (no endpoint)

register transformer: tooluse (no endpoint)

register transformer: openrouter (no endpoint)

register transformer: maxtoken (no endpoint)

register transformer: groq (no endpoint)

register transformer: cleancache (no endpoint)

register transformer: enhancetool (no endpoint)

register transformer: reasoning (no endpoint)

register transformer: sampling (no endpoint)

register transformer: maxcompletiontokens (no endpoint)

modelscope provider registered

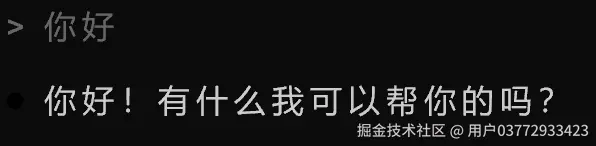

🚀 LLMs API server listening on http://127.0.0.1:3456启动成功后,打开另外一个nodejs command prompt,运行ccr code 还是出现一样的界面:  选择yes

选择yes

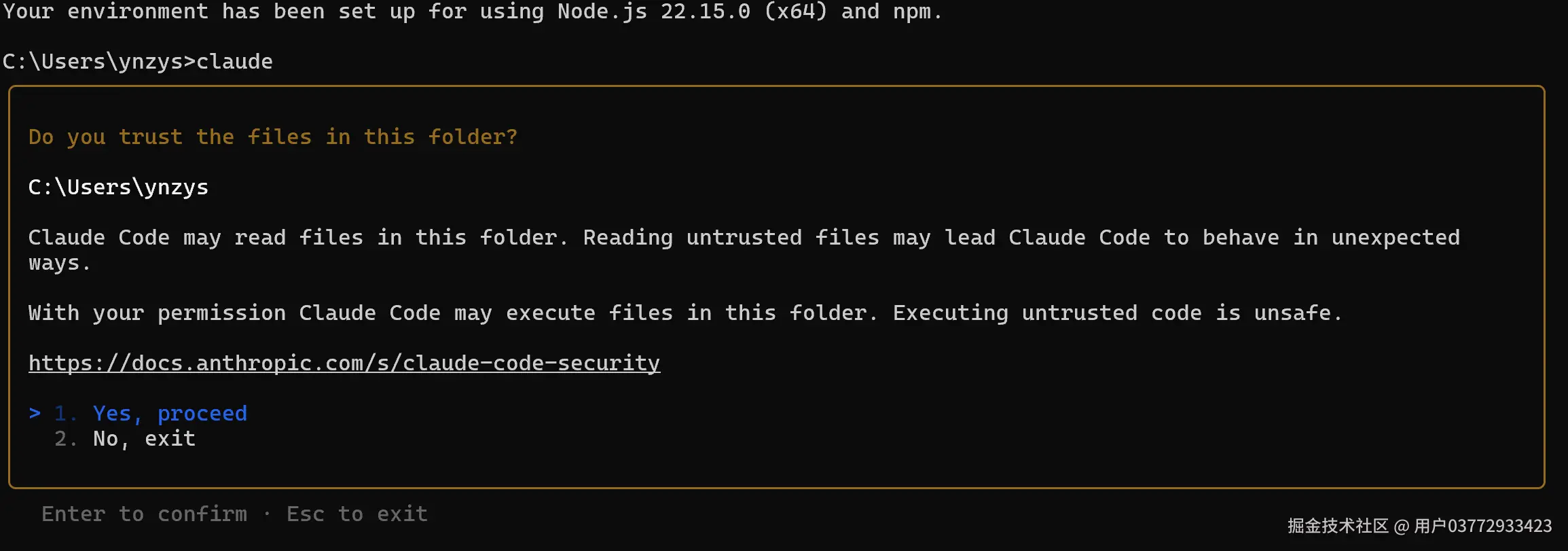

和上面不同的是代理为 http://127.0.0.1:3456

和上面不同的是代理为 http://127.0.0.1:3456

试着在窗口中打入"你好",熟悉的窗口来了。

这样一来,claude code可以通过两种方式访问阿里qwen3 code大模型集成了,好用的工具加国内的低成本模型方案大功告成。当然你还可以使用国内目前爆火的Kimi K2,以及吹上天的GLM4.5,直接去官网申请即可。这里就不在描述了。当然魔搭社区也有免费额度,具体模型接入名称如下: #OPENAI_MODEL=ZhipuAI/GLM-4.5 #OPENAI_MODEL=Kimi-K2-Instruct

5 文末福利,国内可以访问claude大模型的代理服务

众所周知的原因,我们国内访问claude限制很多,因此有大量的镜像站涌现,然后大多数并不稳定,用不了多久就会被封号,服务持续性很差。 给大家推荐一个好用的,胜算云的服务,自称是由长三角国家技术创新中心支持的公司,和Cline官方合作。我用下来感觉稳定没问题,但是费用确实也高。大家自选,我觉得作为尝试原装Claude服务,也是可以的。 官网地址:所有模型 - 胜算云 Claude模型参数举例:

js

OPENAI_API_KEY=your-api-key

#OPENAI_BASE_URL=https://router.shengsuanyun.com/api/v1

#OPENAI_MODEL=anthropic/claude-sonnet-4这个也可以配置到上面的config.json中使用。 记得config.json修改后,记得运行ccr start重启后然后运行ccr code。