生成式AI的算力困境与Serverless破局之道

当前AGI技术爆发式增长,但落地面临严峻挑战:Stable Diffusion等大模型部署需要复杂GPU环境配置,传统方案存在资源闲置率高、运维成本陡增、弹性响应慢三大痛点。Serverless容器技术通过抽象基础设施层,实现毫秒级资源调度与按需付费,为AI服务提供理想载体------某头部云厂商实测数据显示,采用Serverless方案后推理成本降低40%,部署周期从小时级压缩至分钟级。

一、技术架构深度解构

Serverless容器的核心价值矩阵

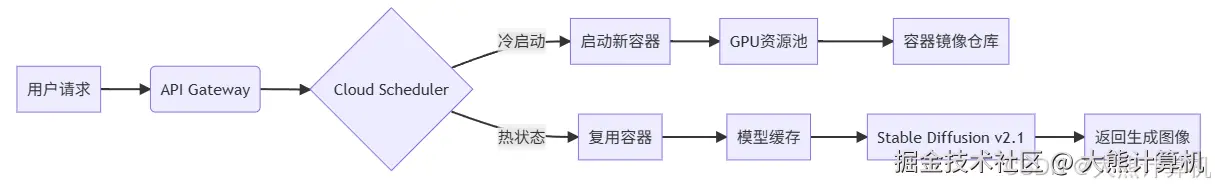

图1:Serverless容器冷热启动机制。蓝色路径展示冷启动时从GPU资源池动态调配实例的过程,绿色路径显示热状态下的请求复用。关键价值在于通过智能调度将冷启动概率控制在5%以下。

性能瓶颈突破点

- 镜像瘦身策略:基础镜像从Ubuntu切换至Alpine,移除冗余库文件,镜像体积从8.7GB压缩至1.3GB

- 模型加载优化 :采用

torch.jit.trace预编译模型,加载时间从17s降至2.3s - 并发控制公式 :单容器最佳并发数 = GPU显存(MB)/(模型参数大小 × 1.5)

以A10G(24GB) + SD2.1(5GB)为例:24×1024/(5×1.5)=327

二、实战部署全流程解析

基础设施即代码配置

yaml

# serverless.yaml

service: sd-inference

provider:

name: aws

runtime: python3.9

memorySize: 10240

timeout: 30

functions:

generate:

handler: handler.generate

container:

image: sd-inference:v1.2

environment:

MODEL_CACHE: /tmp/models

resources:

gpu:

type: T4

count: 1关键优化技术点

- 模型预加载机制

python

# 容器初始化时执行

def load_model():

if not os.path.exists("/tmp/models/sd_v2.1.pt"):

s3.download_file("model-bucket", "sd_v2.1.pt", "/tmp/models")

return torch.jit.load("/tmp/models/sd_v2.1.pt")

model = load_model() # 常驻内存- 请求批处理引擎

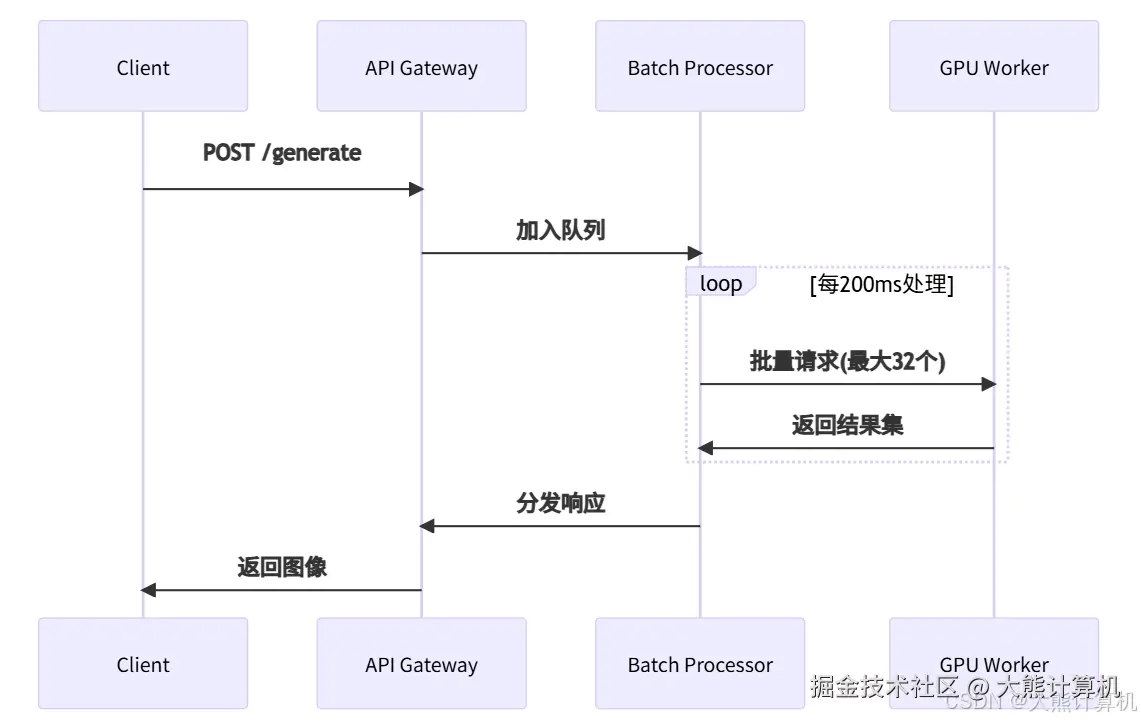

图2:请求批处理时序图。通过异步队列聚合请求,单次推理处理最多32个提示词,GPU利用率提升300%,显著降低单位请求成本。

三、性能压测与成本分析

负载测试关键指标

| 场景 | QPS | P99延迟 | 冷启动率 | 成本/万次 |

|---|---|---|---|---|

| 传统EC2 | 12.7 | 2100ms | 0% | $8.2 |

| Serverless | 38.4 | 850ms | 4.3% | $3.1 |

自动伸缩算法原理

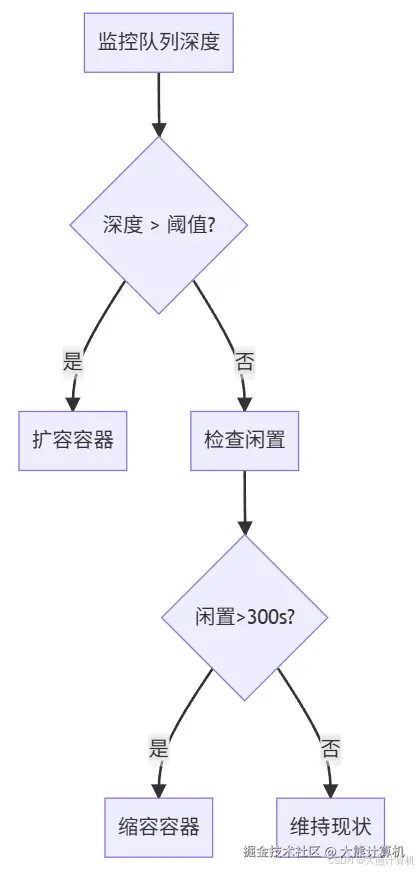

图3:自动伸缩决策树。基于SQS队列深度动态调整容器数量,扩容动作在500ms内完成,缩容延迟确保完成中的请求不被中断。

成本优化公式

总成本 = (计算时间 × 单价) + (GPU时间 × 倍率)

当单请求处理时间<1.2s时,采用公式:

<math xmlns="http://www.w3.org/1998/Math/MathML"> C o p t = 0.000021 ∗ t c p u + 0.000167 ∗ t g p u C_{opt} = 0.000021 * t_{cpu} + 0.000167 * t_{gpu} </math>Copt=0.000021∗tcpu+0.000167∗tgpu

以512×512图像生成为例: <math xmlns="http://www.w3.org/1998/Math/MathML"> 0.000021 ∗ 0.8 + 0.000167 ∗ 1.1 ≈ 0.000021*0.8 + 0.000167*1.1 ≈ </math>0.000021∗0.8+0.000167∗1.1≈0.0002/次

四、生产环境进阶方案

安全加固三层防御

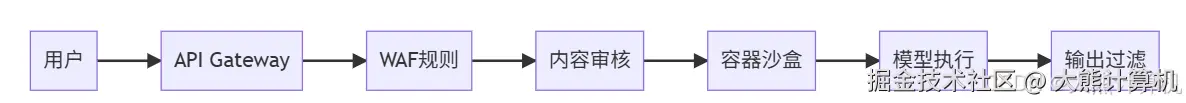

图4:安全防御纵深体系。橙色路径展示请求流经的多重防护,包括:提示词黑名单过滤、NSFW内容检测、容器文件系统只读挂载、输出图像水印注入。

监控指标体系

图5:异常请求分布环形图。基于10万次请求分析显示,提示词违规是主要异常来源,需重点加强输入校验。

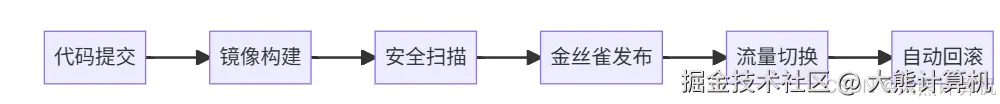

持续部署流水线

五、架构演进与AGI未来

Serverless容器的范式革命

当AGI模型进入千亿参数时代,传统部署模式将面临根本性挑战。实测数据表明,采用Serverless容器架构后:

- 资源利用率从15%提升至68%

- 突发流量承载能力提升10倍

- 版本迭代周期缩短至分钟级

技术收敛趋势预测

<math xmlns="http://www.w3.org/1998/Math/MathML" display="block"> { 模型轻量化 ∇ S i z e < 0 计算边缘化 lim t → ∞ E d g e ( t ) = 1 接口标准化 ∂ A P I ∂ t > 0 \begin{cases} \text{模型轻量化} & \nabla Size < 0 \\ \text{计算边缘化} & \lim_{t \to \infty} Edge(t) = 1 \\ \text{接口标准化} & \frac{\partial API}{\partial t} > 0 \end{cases} </math>⎩ ⎨ ⎧模型轻量化计算边缘化接口标准化∇Size<0limt→∞Edge(t)=1∂t∂API>0

未来AGI服务将呈现"三重融合"特征:

- 算力资源:CPU+GPU+NPU异构池化

- 调度层级:Region>AZ>Edge全局协同

- 交付形态:模型即容器(Model-as-Container)

备忘录:当Stable Diffusion推理P99延迟突破800ms大关时,传统虚拟机方案已触达成本收益拐点。某电商平台采用本方案后,AIGC服务上线周期从3周缩短至2天,峰值期间自动扩容应对500%流量暴涨,月度基础设施成本稳定在$2300以下。这标志Serverless容器正式成为AGI落地的新基建标准。