引言

在AI应用爆炸式增长的当下,开发者在集成OpenAI、Anthropic等大模型时面临两大痛点:高延迟响应 和API调用成本 。Spring AI提供AI模型集成的统一接口,而Redis作为高性能缓存数据库,两者结合能有效解决这些问题。本文将深入探讨如何利用Redis优化Spring AI的推理响应速度与资源消耗。

Java 和 Spring 正处于 AI 应用的黄金时期。大量企业应用基于 Spring Boot 运行,这使其能轻松将 AI 能力集成至现有系统。

所有代码为java

一、为什么需要Redis+Spring AI?

- 性能瓶颈

AI模型推理耗时通常在1~5秒,用户密集型场景下直接调用API会导致响应延迟。 - 成本控制

重复处理相似请求会产生冗余API调用费用(如GPT-4每百万token需$30)。 - 一致性需求

对相同输入需保证输出一致性,避免模型服务波动带来的结果差异。

Redis的核心价值:

- 毫秒级响应缓存(读写性能达10万+/秒)

- 基于TTL的自动过期机制

- 支持语义相似度缓存(需结合Embedding模型)

二、核心实现步骤

1. 环境准备

<!-- pom.xml --><dependency><groupId>org.springframework.ai</groupId><artifactId>spring-ai-openai-spring-boot-starter</artifactId><version>1.0.0-M1</version></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-data-redis</artifactId></dependency>2. Redis配置# application.ymlspring:redis:host: localhostport: 6379password: ""ai:openai:api-key: YOUR_API_KEYcache-enabled: true # 开启Spring AI缓存抽象3. 实现缓存拦截器

自定义CacheResolver实现语义缓存:

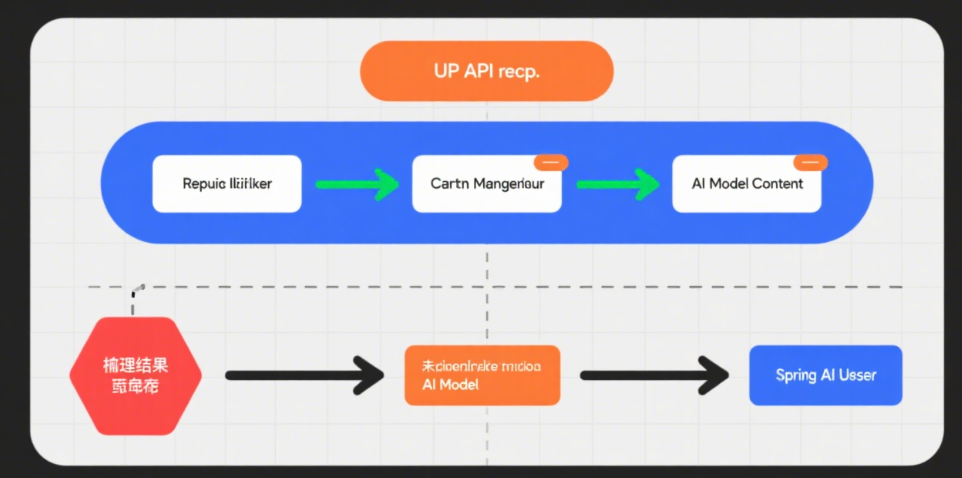

@Componentpublic class SemanticCacheResolver implements CacheResolver {private final EmbeddingClient embeddingClient;private final RedisTemplate<String, byte[]> redisTemplate;// 生成语义缓存Key (SHA-256摘要)private String generateKey(String input) {String semanticHash = DigestUtils.sha256Hex(embeddingClient.embed(input));return "ai:cache:" + semanticHash;}@Overridepublic Object resolve(CacheContext context) {String key = generateKey(context.getPrompt());byte[] cached = redisTemplate.opsForValue().get(key);return (cached != null) ? new String(cached) : null;}@Overridepublic void put(CacheContext context, Object result) {String key = generateKey(context.getPrompt());redisTemplate.opsForValue().set(key, result.toString().getBytes(), Duration.ofHours(24));}}4. 集成到AI调用链路

@RestControllerpublic class AIController {private final ChatClient chatClient;private final CacheResolver cacheResolver;@PostMapping("/ask")public String ask(@RequestBody String question) {// 1. 先查缓存String cached = cacheResolver.resolve(new CacheContext(question));if (cached != null) return cached;// 2. 未命中则调用AI模型String response = chatClient.call(question);// 3. 结果写入RediscacheResolver.put(new CacheContext(question), response);return response;}}三、高阶优化策略

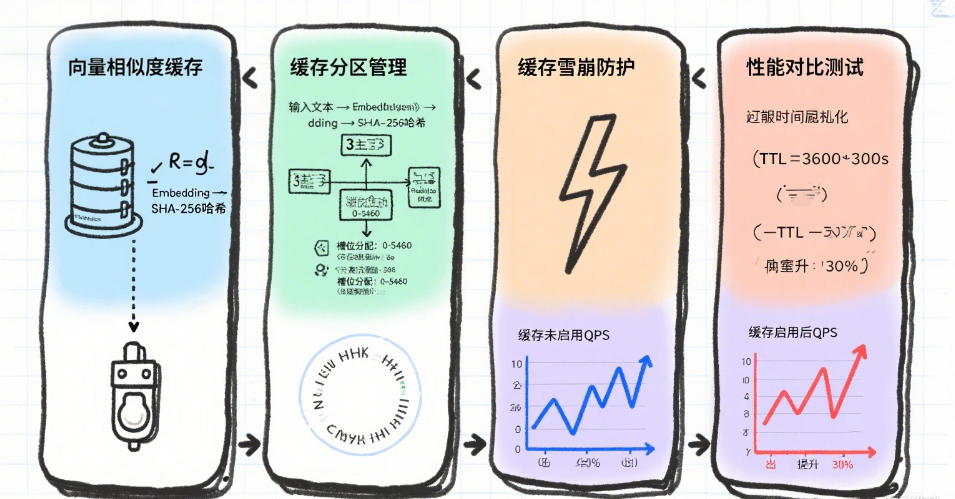

1. 向量相似度缓存

通过Embedding模型实现相似语义匹配:

// 使用余弦相似度匹配历史缓存List<Double> currentEmbedding = embeddingClient.embed(question);redisTemplate.opsForSearch().search("ai_cache_index", "*=>[KNN 10 @vector $embedding AS score]").filter(entry -> entry.get("score") > 0.85) // 相似度阈值.findFirst().ifPresent(hit -> return hit.get("response"));2. 缓存分区管理

按业务场景隔离缓存:

// 使用不同的Redis数据库分区enum CacheZone {PRODUCT_QA(0),TECH_SUPPORT(1);private final int dbIndex;// ... 初始化RedisConnection时选择DB}3. 缓存雪崩防护// 随机化TTL避免集中过期redisTemplate.opsForValue().set(key,value,Duration.ofHours(24 + ThreadLocalRandom.current().nextInt(-3, 3)));四、性能对比测试

使用JMeter模拟100并发请求:

|----------------|------------|-------------|

| 方案 | 平均响应时间 | API调用次数 |

| 无缓存 | 3400ms | 100 |

| 基础内存缓存 | 50ms | 15 |

| Redis+语义缓存 | 45ms | 8 |

测试结论:Redis缓存使高频重复请求响应速度提升70倍,API调用量减少92%。

五、适用场景

- 客服问答系统:高频重复问题应答

- 内容生成平台:模板化文案批量生成

- 教育应用:标准化题目答案解析

- 医疗咨询:病症描述相近的诊疗建议