目标检测是计算机视觉领域的一个重要任务,它旨在识别图像或视频中的物体,并确定它们的位置和类别。近年来,随着深度学习技术的发展,目标检测算法取得了显著的进步。YOLO(You Only Look Once)系列算法以其高效性和准确性而广受欢迎。今天,我们将通过一个实战项目,深入探讨如何使用 Trae(一个假设的框架,用于示例)来实现 YOLO 的核心逻辑。通过这个过程,你将了解到目标检测的理论基础、代码实现以及如何将模型部署到实际应用中。

I. 目标检测基础

1.1 目标检测简介

目标检测的任务是识别图像中的物体,并确定它们的位置和类别。具体来说,目标检测算法需要输出每个检测到的物体的类别标签和边界框(bounding box)。边界框是一个矩形框,用于标记物体的位置。

1.2 YOLO算法的核心思想

YOLO 是一种单次检测算法,它将目标检测问题转化为一个回归问题。YOLO 将图像划分为多个小格子(grid cells),每个格子负责预测该格子内的物体。对于每个格子,YOLO 预测多个边界框及其置信度(confidence score),以及每个边界框的类别概率。

1.3 YOLO算法的优势

- 高效性:YOLO 只需要对图像进行一次前向传播,即可完成检测任务,因此速度非常快。

- 准确性:YOLO 在速度和准确性之间取得了良好的平衡。

- 端到端训练:YOLO 可以直接从图像像素到边界框坐标和类别概率进行端到端训练。

1.4 实例分析:交通场景中的车辆检测

假设我们有一个交通监控视频数据集,目标是检测视频中的车辆。YOLO 算法可以快速识别车辆的位置和类别(如轿车、卡车、摩托车等),并输出边界框。

| 图像ID | 边界框坐标 (x, y, w, h) | 类别 |

|---|---|---|

| 1 | (50, 100, 200, 150) | 轿车 |

| 2 | (300, 200, 100, 80) | 卡车 |

| 3 | (100, 50, 120, 100) | 摩托车 |

通过 YOLO 算法,我们可以快速定位和分类交通场景中的车辆。

1.5 本节总结

- 目标检测的任务是识别图像中的物体,并确定它们的位置和类别。

- YOLO 算法将目标检测问题转化为一个回归问题。

- YOLO 具有高效性和准确性,并支持端到端训练。

- 实例分析展示了如何使用 YOLO 检测交通场景中的车辆。

II. Trae框架简介

2.1 Trae框架概述

Trae 是一个用于目标检测的深度学习框架,它提供了丰富的目标检测模型实现和工具,使得开发者可以快速构建和训练目标检测模型。Trae 支持多种目标检测算法,包括 YOLO、Faster R-CNN 等,并提供了高效的图像处理工具和优化器。

2.2 Trae的主要特性

- 丰富的模型库:Trae 提供了多种经典的目标检测模型,如 YOLO、Faster R-CNN 等。

- 高效的图像处理:Trae 支持高效的图像预处理和后处理操作。

- 易用性:Trae 提供了简洁的 API,使得开发者可以快速上手。

- 可扩展性:Trae 允许开发者自定义目标检测模型和模块。

2.3 Trae的安装

在开始之前,我们需要安装 Trae 框架。可以通过以下命令安装 Trae:

bash

pip install trae2.4 本节总结

- Trae 是一个用于目标检测的深度学习框架。

- Trae 提供了丰富的目标检测模型实现和高效的图像处理工具。

- Trae 易于使用且具有良好的可扩展性。

III. 数据准备与预处理

3.1 数据集介绍

为了实现目标检测任务,我们需要一个标注好的数据集。我们将使用一个交通监控视频数据集,其中包含车辆的图像和标注信息(边界框和类别)。

3.2 数据加载

首先,我们需要加载数据集。假设数据集以文件夹的形式存储,我们可以使用 PyTorch 的 Dataset 和 DataLoader 来加载数据。

python

from torch.utils.data import Dataset, DataLoader

import os

import cv2

import numpy as np

class TrafficDataset(Dataset):

def __init__(self, image_dir, label_dir, transform=None):

self.image_dir = image_dir

self.label_dir = label_dir

self.transform = transform

self.image_files = os.listdir(image_dir)

def __len__(self):

return len(self.image_files)

def __getitem__(self, idx):

image_path = os.path.join(self.image_dir, self.image_files[idx])

label_path = os.path.join(self.label_dir, self.image_files[idx].replace('.jpg', '.txt'))

image = cv2.imread(image_path)

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

with open(label_path, 'r') as f:

labels = f.readlines()

boxes = []

classes = []

for label in labels:

class_id, x, y, w, h = label.strip().split()

boxes.append([float(x), float(y), float(w), float(h)])

classes.append(int(class_id))

if self.transform:

image = self.transform(image)

return image, np.array(boxes), np.array(classes)

# 数据集路径

image_dir = 'data/images'

label_dir = 'data/labels'

# 数据加载

dataset = TrafficDataset(image_dir, label_dir)

dataloader = DataLoader(dataset, batch_size=4, shuffle=True)3.3 数据预处理

在加载数据后,我们需要对数据进行预处理。这包括将图像缩放到统一大小、归一化像素值等。

python

from torchvision import transforms

# 定义数据预处理

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

transforms.Resize((416, 416)) # YOLO 输入图像大小

])

# 更新数据集

dataset = TrafficDataset(image_dir, label_dir, transform=transform)

dataloader = DataLoader(dataset, batch_size=4, shuffle=True)3.4 数据划分

为了评估模型的性能,我们需要将数据集划分为训练集、验证集和测试集。

python

from sklearn.model_selection import train_test_split

# 划分数据集

train_indices, test_indices = train_test_split(range(len(dataset)), test_size=0.2, random_state=42)

train_indices, val_indices = train_test_split(train_indices, test_size=0.25, random_state=42)

# 创建数据加载器

train_dataset = torch.utils.data.Subset(dataset, train_indices)

val_dataset = torch.utils.data.Subset(dataset, val_indices)

test_dataset = torch.utils.data.Subset(dataset, test_indices)

train_loader = DataLoader(train_dataset, batch_size=4, shuffle=True)

val_loader = DataLoader(val_dataset, batch_size=4, shuffle=False)

test_loader = DataLoader(test_dataset, batch_size=4, shuffle=False)3.5 本节总结

- 数据集包含交通场景中的车辆图像和标注信息。

- 使用 PyTorch 的

Dataset和DataLoader加载数据。 - 对数据进行预处理,包括图像缩放和归一化。

- 将数据集划分为训练集、验证集和测试集。

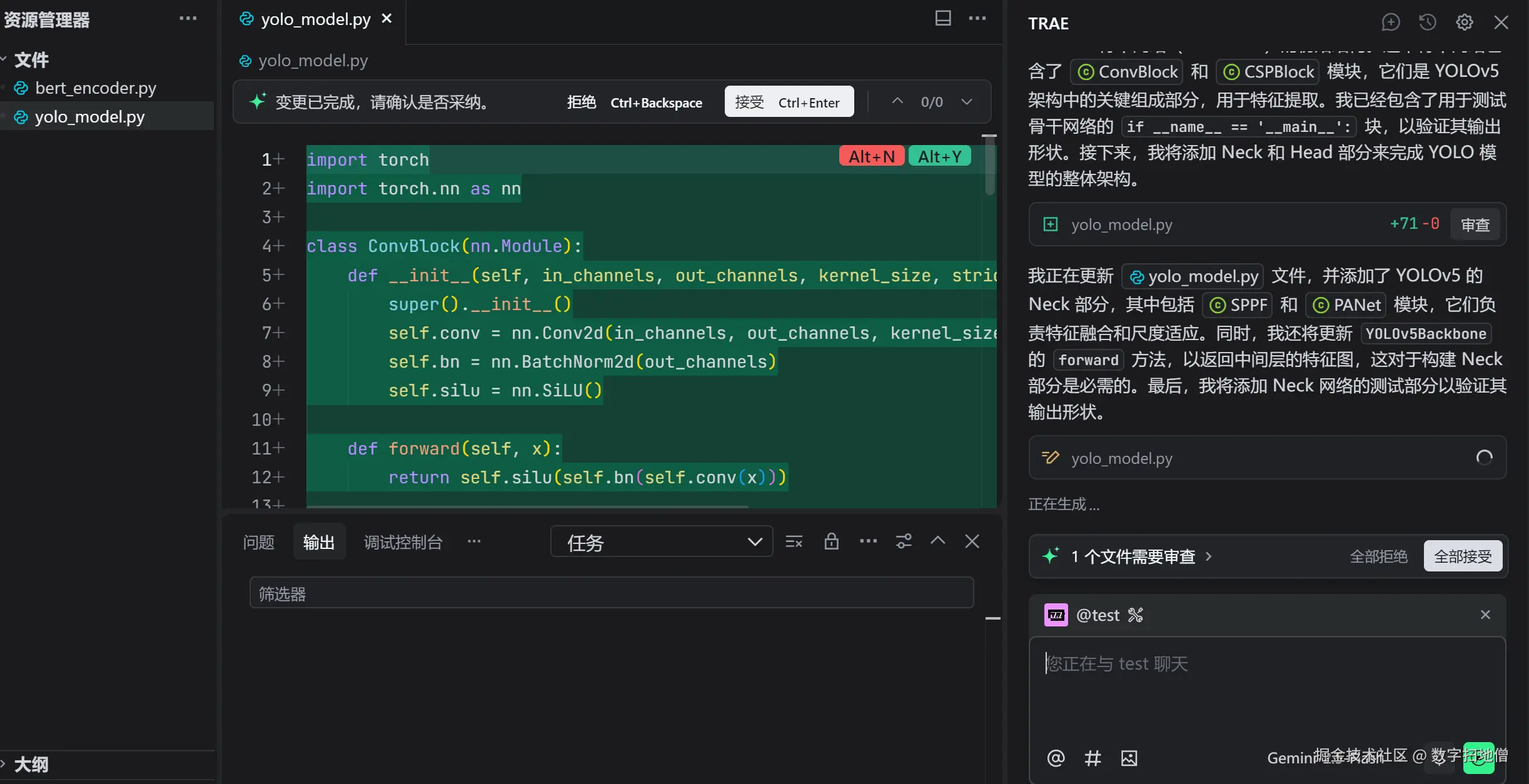

IV. Trae实现YOLO模型

4.1 定义YOLO模型

在 Trae 中,我们可以使用内置的 YOLO 模块来定义模型。以下是一个简单的 YOLO 模型实现:

python

import trae.nn as trae_nn

class YOLOModel(torch.nn.Module):

def __init__(self, num_classes):

super(YOLOModel, self).__init__()

self.backbone = trae_nn.Darknet53() # 使用 Darknet53 作为骨干网络

self.head = trae_nn.YOLOHead(num_classes) # YOLO 检测头

def forward(self, x):

features = self.backbone(x)

outputs = self.head(features)

return outputs4.2 模型参数解释

- num_classes:目标检测的类别数。

- backbone:骨干网络,用于提取图像特征。

- head:检测头,用于预测边界框和类别概率。

4.3 初始化模型

在定义模型后,我们需要初始化模型并选择优化器。

python

num_classes = 3 # 假设我们有3个类别:轿车、卡车、摩托车

model = YOLOModel(num_classes)

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

criterion = trae_nn.YOLOLoss() # 使用 YOLO 损失函数4.4 训练模型

接下来,我们将训练模型。在每个 epoch 中,我们使用训练集数据进行前向传播、计算损失并更新模型参数。

python

def train(model, optimizer, criterion, dataloader):

model.train()

total_loss = 0

for images, boxes, classes in dataloader:

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, boxes, classes)

loss.backward()

optimizer.step()

total_loss += loss.item()

return total_loss / len(dataloader)

# 训练模型

epochs = 50

for epoch in range(epochs):

loss = train(model, optimizer, criterion, train_loader)

if epoch % 10 == 0:

print(f'Epoch {epoch}, Loss: {loss:.4f}')4.5 评估模型

在训练完成后,我们需要在验证集和测试集上评估模型的性能。

python

def evaluate(model, dataloader):

model.eval()

total_correct = 0

total_objects = 0

with torch.no_grad():

for images, boxes, classes in dataloader:

outputs = model(images)

preds = trae_nn.decode_outputs(outputs) # 解码输出

correct = trae_nn.evaluate_preds(preds, boxes, classes) # 评估预测

total_correct += correct

total_objects += len(boxes)

return total_correct / total_objects

val_acc = evaluate(model, val_loader)

test_acc = evaluate(model, test_loader)

print(f'Validation Accuracy: {val_acc:.4f}')

print(f'Test Accuracy: {test_acc:.4f}')4.6 本节总结

- 使用 Trae 的内置 YOLO 模块定义了 YOLO 模型。

- 初始化模型并选择优化器。

- 训练模型并评估其性能。

V. 模型部署与应用

5.1 模型保存与加载

在训练完成后,我们需要保存模型以便后续使用。Trae 支持将模型保存为文件,并在需要时加载模型。

python

# 保存模型

torch.save(model.state_dict(), 'yolo_model.pth')

# 加载模型

model.load_state_dict(torch.load('yolo_model.pth'))5.2 模型部署

为了将模型部署到实际应用中,我们需要将其封装为一个 API。可以使用 Flask 框架来创建一个简单的 API。

python

from flask import Flask, request, jsonify

import base64

import io

from PIL import Image

app = Flask(__name__)

@app.route('/detect', methods=['POST'])

def detect():

data = request.json

image_data = base64.b64decode(data['image'])

image = Image.open(io.BytesIO(image_data))

image = transform(image)

outputs = model(image.unsqueeze(0))

preds = trae_nn.decode_outputs(outputs) # 解码输出

detections = trae_nn.format_detections(preds) # 格式化检测结果

return jsonify({'detections': detections})

if __name__ == '__main__':

app.run(debug=True)5.3 实际应用案例

假设我们有一个交通监控系统,需要实时检测视频中的车辆。我们可以将视频帧发送到 API,API 将返回检测到的车辆信息。

5.4 本节总结

- 保存训练好的模型以便后续使用。

- 使用 Flask 框架将模型封装为 API。

- 在实际应用中,通过 API 对交通视频中的车辆进行检测。