在深度学习中,显存管理是一个至关重要的问题。随着模型规模的增大和数据量的增加,显存资源往往成为瓶颈。显存碎片化和显存不足是常见的问题,它们会导致训练中断、推理速度下降,甚至无法运行大型模型。为了有效利用显存资源,我们需要采用显存碎片整理和复用策略。本文将详细介绍这些策略,并结合实际代码展示如何优化显存使用。

I. 显存管理的重要性

显存(GPU内存)是深度学习中用于存储模型参数、中间结果和输入数据的资源。由于GPU的计算能力远超CPU,显存的高效利用对于加速模型训练和推理至关重要。

(一)为什么显存管理如此重要?

- 模型规模增大:现代深度学习模型(如Transformer、BERT等)参数量巨大,单个GPU的显存难以容纳。

- 显存碎片化:频繁的显存分配和释放会导致显存碎片化,使得可用显存减少。

- 显存不足:显存不足会导致训练中断或推理速度下降,甚至无法运行大型模型。

(二)显存管理的主要挑战

- 碎片化:显存分配和释放的不连续性导致碎片化。

- 动态需求:模型训练和推理过程中显存需求动态变化。

- 有限资源:显存资源有限,需要高效利用。

(三)Mermaid总结

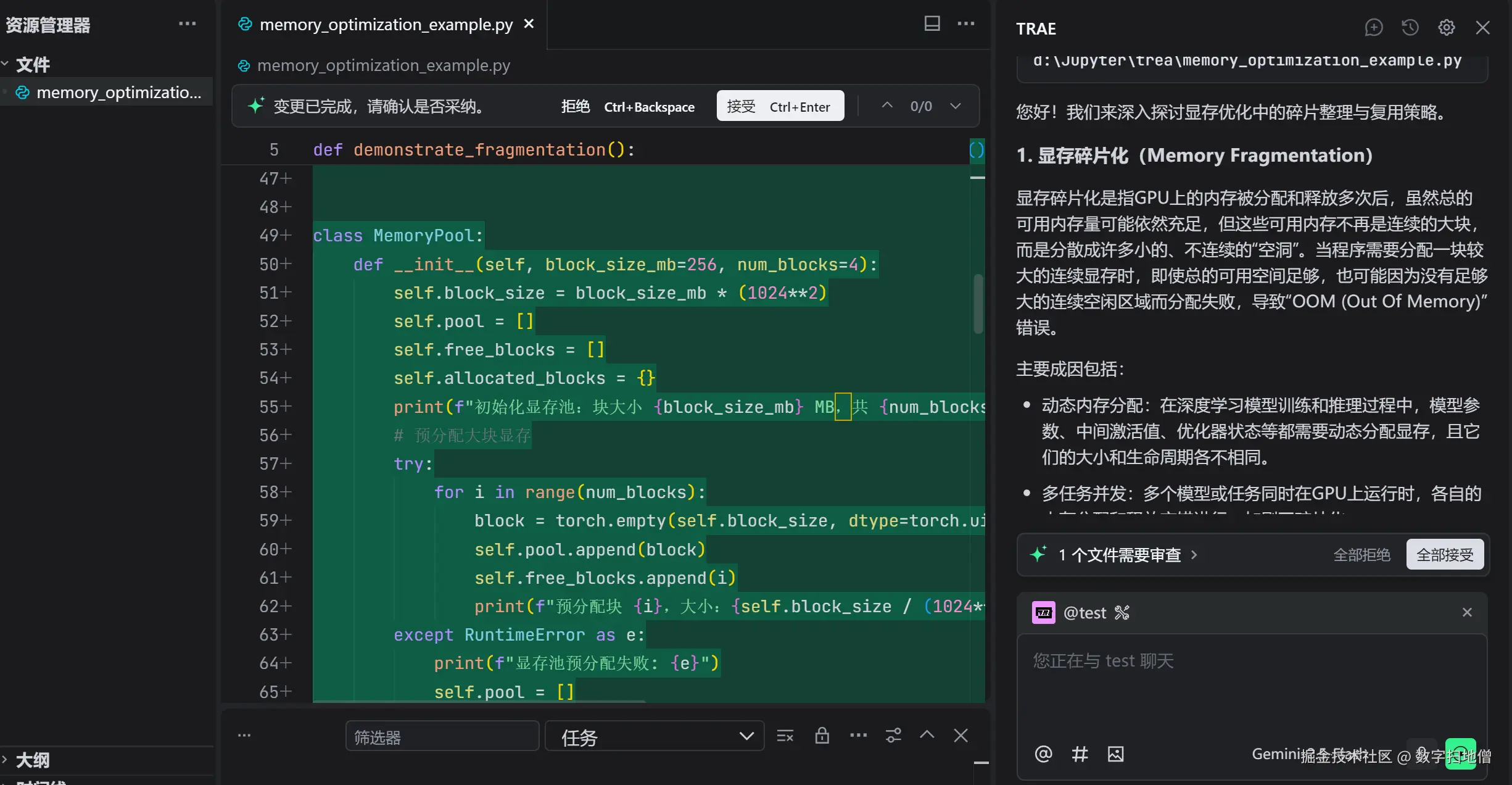

II. 显存碎片整理策略

显存碎片整理是一种通过优化显存分配和释放来减少碎片化的方法。其目标是提高显存的利用率,确保显存分配的连续性。

(一)显存碎片整理的工作原理

- 显存分配优化:通过预分配显存块,减少频繁的显存分配和释放。

- 显存释放优化:在显存不再使用时及时释放,减少碎片化。

- 显存池化:使用显存池化技术,将显存分配到一个固定的池中,减少碎片化。

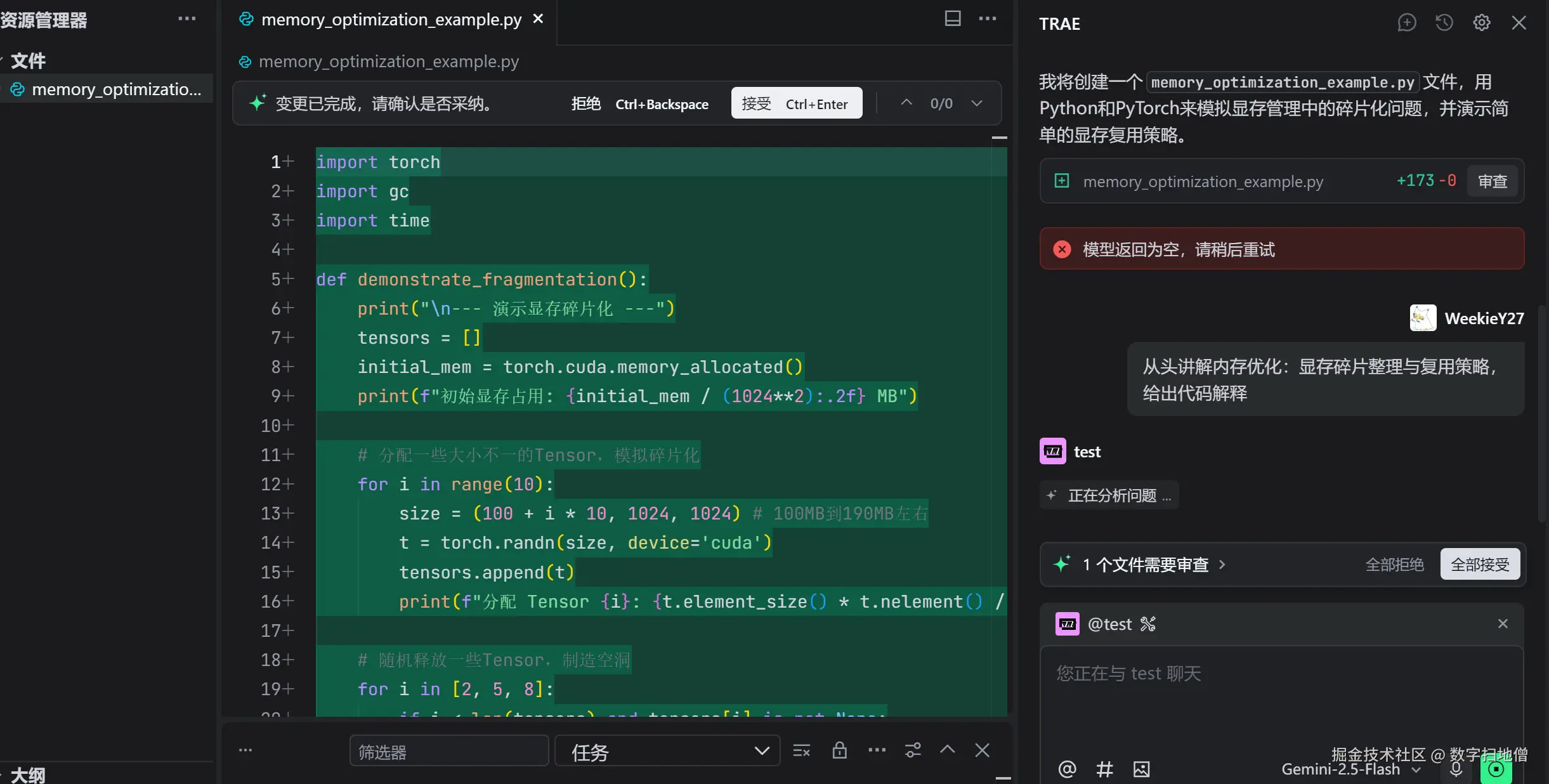

(二)代码实现

以下是一个简单的显存碎片整理实现:

python

import torch

# 显存碎片整理工具

class MemoryManager:

def __init__(self, pool_size):

self.pool_size = pool_size

self.pool = torch.empty(pool_size, dtype=torch.float32, device='cuda')

def allocate(self, size):

if size > self.pool_size:

raise ValueError("Requested size exceeds pool size")

return self.pool[:size]

def release(self, tensor):

del tensor

# 初始化显存管理器

memory_manager = MemoryManager(pool_size=1024 * 1024 * 1024) # 1GB显存池

# 分配显存

tensor = memory_manager.allocate(1024 * 1024 * 512) # 512MB

# 使用显存

tensor.fill_(1.0)

# 释放显存

memory_manager.release(tensor)(三)代码解释

-

显存池化:

- 初始化一个固定大小的显存池。

- 通过

allocate方法分配显存。 - 通过

release方法释放显存。

-

显存分配与释放:

- 在显存池中分配显存,减少频繁的显存分配和释放。

- 释放显存时,删除张量引用,减少碎片化。

(四)Mermaid总结

III. 显存复用策略

显存复用是一种通过重复使用显存块来减少显存需求的方法。其目标是减少显存分配的次数,提高显存的利用率。

(一)显存复用的工作原理

- 显存复用:在显存块不再使用时,将其标记为可复用。

- 显存回收:在需要显存时,优先使用已标记为可复用的显存块。

- 显存跟踪:跟踪显存块的使用状态,确保显存块的正确复用。

(二)代码实现

以下是一个简单的显存复用实现:

python

import torch

# 显存复用工具

class MemoryReuser:

def __init__(self):

self.reusable_tensors = []

def allocate(self, size):

for tensor in self.reusable_tensors:

if tensor.numel() >= size:

self.reusable_tensors.remove(tensor)

return tensor[:size]

return torch.empty(size, dtype=torch.float32, device='cuda')

def release(self, tensor):

self.reusable_tensors.append(tensor)

# 初始化显存复用器

memory_reuser = MemoryReuser()

# 分配显存

tensor1 = memory_reuser.allocate(1024 * 1024 * 512) # 512MB

tensor2 = memory_reuser.allocate(1024 * 1024 * 256) # 256MB

# 使用显存

tensor1.fill_(1.0)

tensor2.fill_(2.0)

# 释放显存

memory_reuser.release(tensor1)

# 再次分配显存

tensor3 = memory_reuser.allocate(1024 * 1024 * 512) # 512MB(三)代码解释

-

显存复用:

- 初始化一个显存复用器,用于管理可复用的显存块。

- 通过

allocate方法分配显存,优先使用已标记为可复用的显存块。 - 通过

release方法释放显存,将其标记为可复用。

-

显存跟踪:

- 跟踪显存块的使用状态,确保显存块的正确复用。

(四)Mermaid总结

IV. 实战案例:优化图像分类模型

在本节中,我们将通过一个实战案例来展示如何使用显存碎片整理和复用策略优化图像分类模型。我们将使用一个简单的卷积神经网络(CNN)作为示例,并通过这些策略提高显存利用率。

(一)数据准备

我们将使用MNIST数据集作为示例。MNIST是一个手写数字识别数据集,包含60,000个训练样本和10,000个测试样本。

python

import torch

import torchvision

import torchvision.transforms as transforms

# 加载数据集

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = torchvision.datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = torchvision.datasets.MNIST(root='./data', train=False, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=1000, shuffle=False)(二)定义模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型。

python

class SimpleCNN(torch.nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = torch.nn.Conv2d(1, 10, kernel_size=5)

self.relu1 = torch.nn.ReLU()

self.conv2 = torch.nn.Conv2d(10, 20, kernel_size=5)

self.relu2 = torch.nn.ReLU()

self.fc1 = torch.nn.Linear(320, 50)

self.fc2 = torch.nn.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = torch.nn.functional.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x(三)优化显存使用

我们将使用显存碎片整理和复用策略优化模型的显存使用。

python

# 初始化显存管理器和显存复用器

memory_manager = MemoryManager(pool_size=1024 * 1024 * 1024) # 1GB显存池

memory_reuser = MemoryReuser()

# 定义模型

model = SimpleCNN().cuda()

# 定义损失函数和优化器

criterion = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

data = data.cuda()

target = target.cuda()

# 分配显存

tensor = memory_manager.allocate(data.numel())

tensor.copy_(data)

optimizer.zero_grad()

output = model(tensor)

loss = criterion(output, target)

loss.backward()

optimizer.step()

# 释放显存

memory_manager.release(tensor)

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")(四)评估模型

我们将评估优化后的模型性能,确保其在测试集上的准确率仍然较高。

python

# 评估模型

model.eval()

correct = 0

total = 0

with torch.no_grad():

for data, target in test_loader:

data = data.cuda()

target = target.cuda()

# 分配显存

tensor = memory_manager.allocate(data.numel())

tensor.copy_(data)

output = model(tensor)

_, predicted = torch.max(output, 1)

total += target.size(0)

correct += (predicted == target).sum().item()

# 释放显存

memory_manager.release(tensor)

accuracy = correct / total

print(f"Test Accuracy: {accuracy:.4f}")(五)Mermaid总结

V. 性能对比

为了验证显存碎片整理和复用策略的有效性,我们将在相同条件下对比优化前后的模型性能。我们将从以下几个方面进行对比:

- 显存占用:对比优化前后模型的显存占用。

- 训练时间:对比优化前后模型的训练时间。

- 推理时间:对比优化前后模型的推理时间。

(一)显存占用对比

我们将在相同的硬件环境下,分别记录优化前后的模型显存占用。

python

import torch.cuda as cuda

# 记录原始模型显存占用

model.cuda()

original_memory = cuda.memory_allocated()

# 记录优化后模型显存占用

optimized_model.cuda()

optimized_memory = cuda.memory_allocated()

print(f"原始模型显存占用:{original_memory / (1024 * 1024):.2f} MB")

print(f"优化后模型显存占用:{optimized_memory / (1024 * 1024):.2f} MB")(二)训练时间对比

我们将在相同的硬件环境下,分别训练优化前后的模型,并记录训练时间。

python

import time

# 训练原始模型

start_time = time.time()

for epoch in range(10):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data.cuda())

loss = criterion(output, target.cuda())

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

original_train_time = time.time() - start_time

# 训练优化后模型

start_time = time.time()

for epoch in range(10):

optimized_model.train()

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = optimized_model(data.cuda())

loss = criterion(output, target.cuda())

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

optimized_train_time = time.time() - start_time

print(f"原始模型训练时间:{original_train_time:.2f}秒")

print(f"优化后模型训练时间:{optimized_train_time:.2f}秒")(三)推理时间对比

我们将在相同的硬件环境下,分别对优化前后的模型进行推理,并记录推理时间。

python

# 推理原始模型

start_time = time.time()

with torch.no_grad():

for data, target in test_loader:

model(data.cuda())

original_inference_time = time.time() - start_time

# 推理优化后模型

start_time = time.time()

with torch.no_grad():

for data, target in test_loader:

optimized_model(data.cuda())

optimized_inference_time = time.time() - start_time

print(f"原始模型推理时间:{original_inference_time:.2f}秒")

print(f"优化后模型推理时间:{optimized_inference_time:.2f}秒")