- [1 图像拼接基础知识](#1 图像拼接基础知识)

-

- [1.1 特征匹配 原理及代码示例](#1.1 特征匹配 原理及代码示例)

- [1.2 单应性矩阵 原理及代码示例](#1.2 单应性矩阵 原理及代码示例)

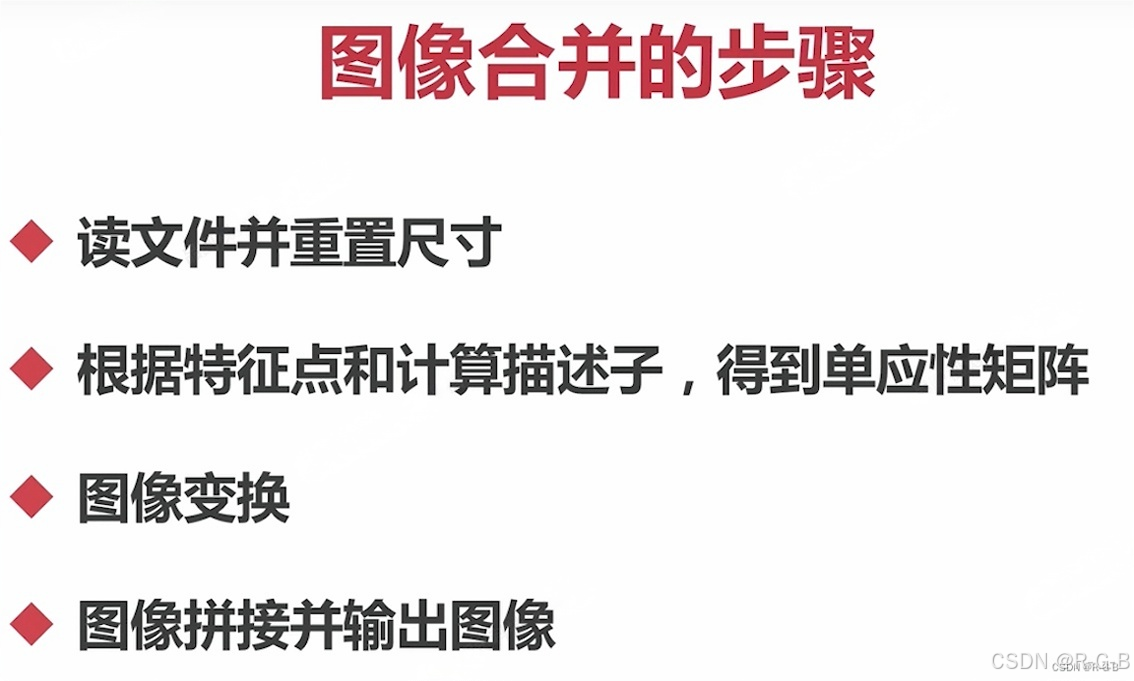

- [2 图像拼接(一)(直接拼接)](#2 图像拼接(一)(直接拼接))

- [3 图像拼接(二)(单应性矩阵 + 图像变换 + 拼接)](#3 图像拼接(二)(单应性矩阵 + 图像变换 + 拼接))

-

- [3.1 单应性矩阵函数](#3.1 单应性矩阵函数)

- [3.2 拼接函数 实现 及细节测试验证](#3.2 拼接函数 实现 及细节测试验证)

- [3.3 图像拼接](#3.3 图像拼接)

- [4 后续完善(拼接缝隙过度、裁剪)](#4 后续完善(拼接缝隙过度、裁剪))

-

- [4.1 输入图像大小一致 优化](#4.1 输入图像大小一致 优化)

- [4.2 后续完善](#4.2 后续完善)

- [5 进阶实战--图像拼接 (实战项目)](#5 进阶实战--图像拼接 (实战项目))

1 图像拼接基础知识

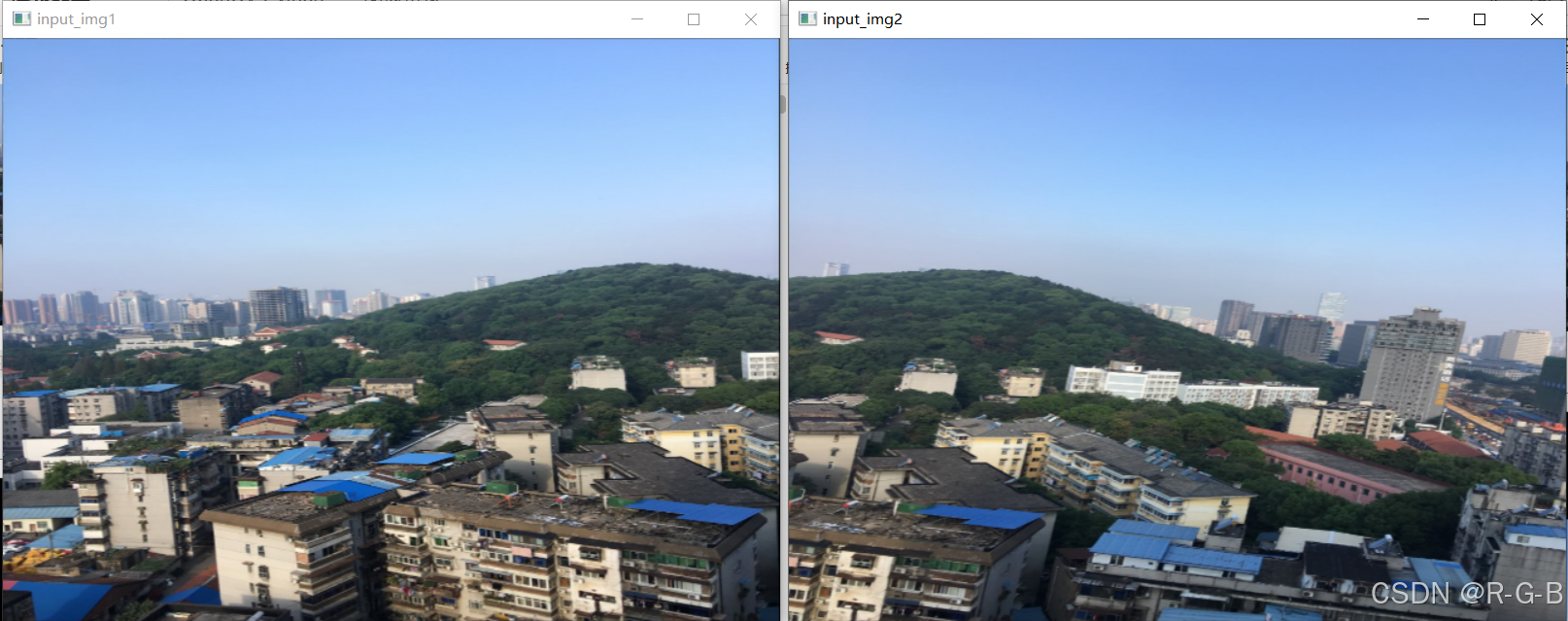

图像关系,有重叠部分

原始图像

拼接结果

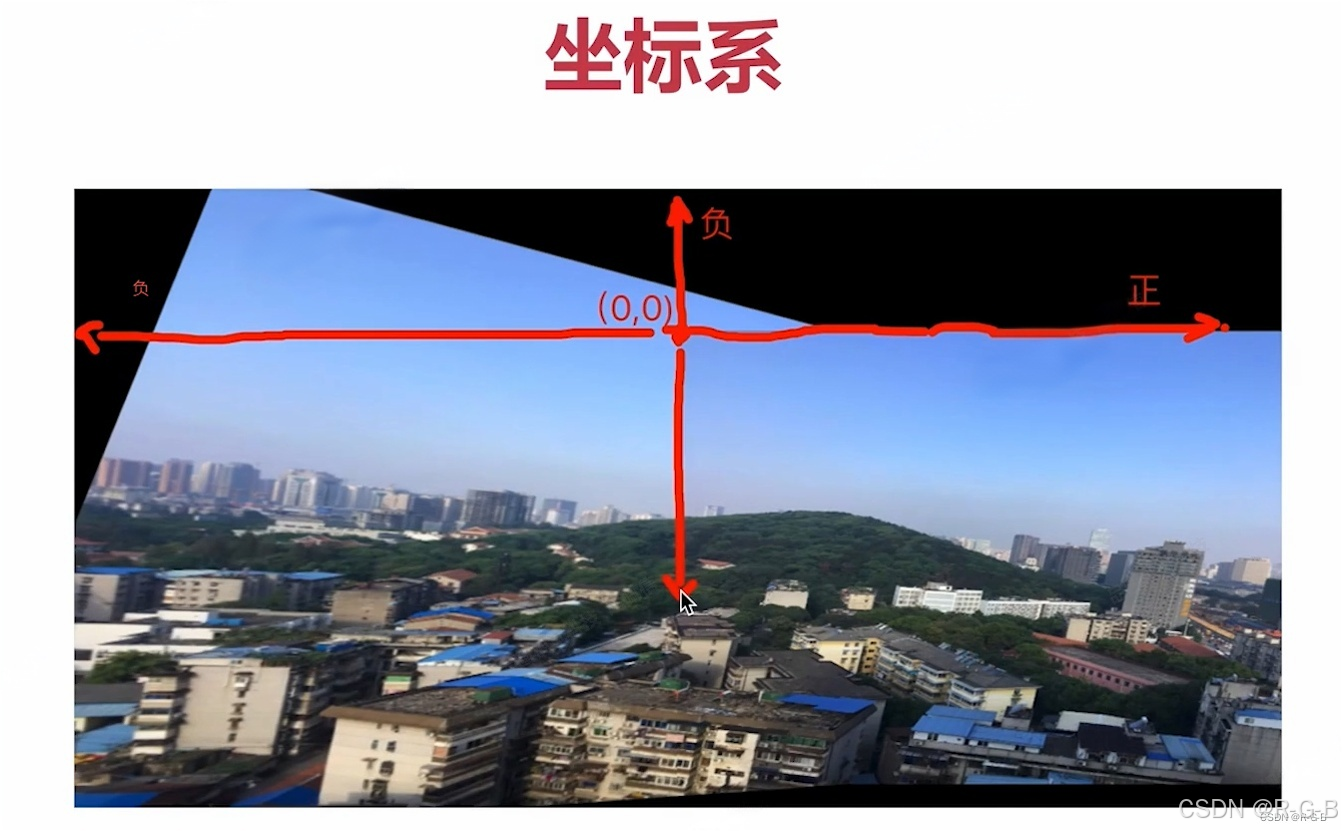

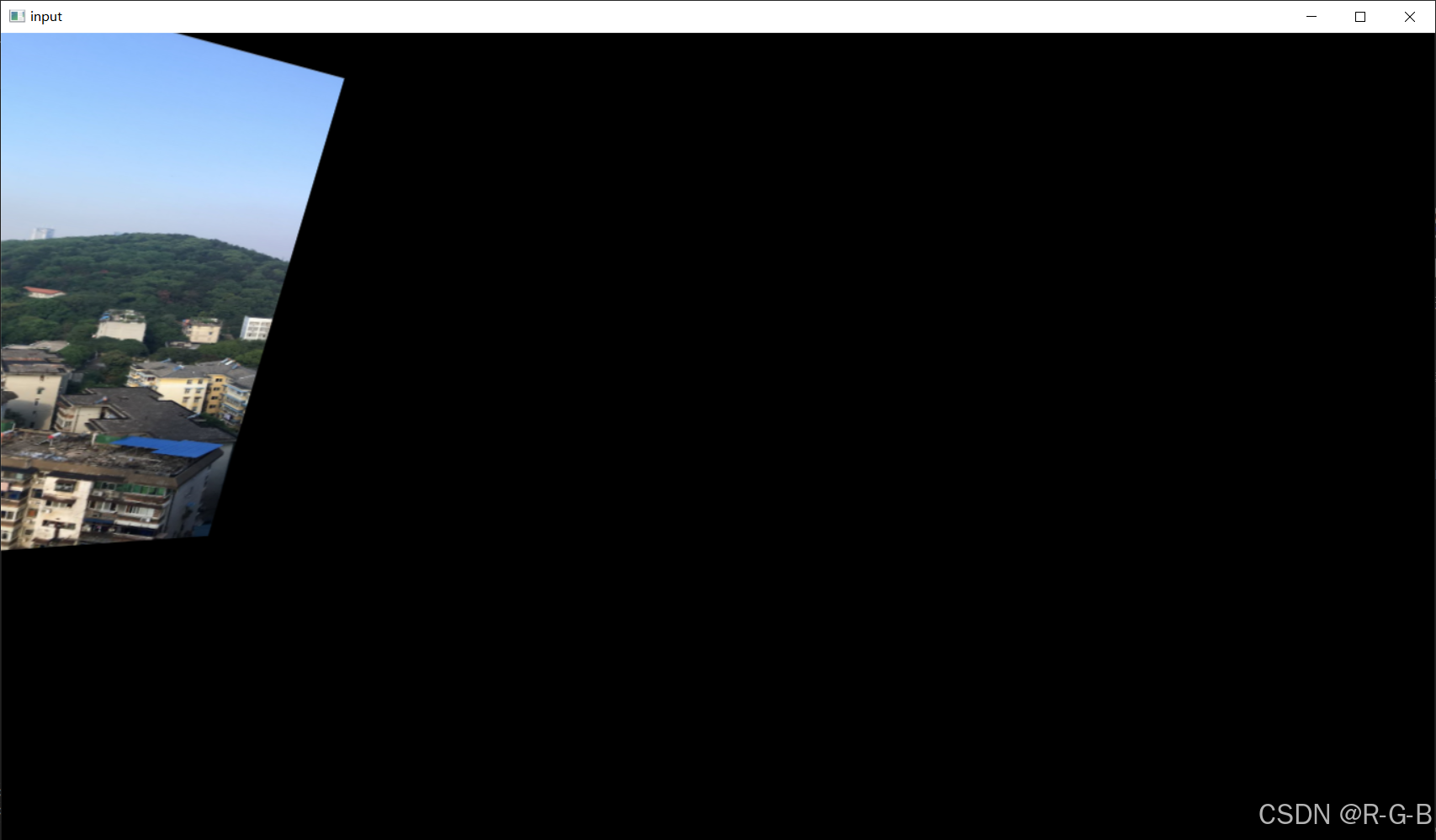

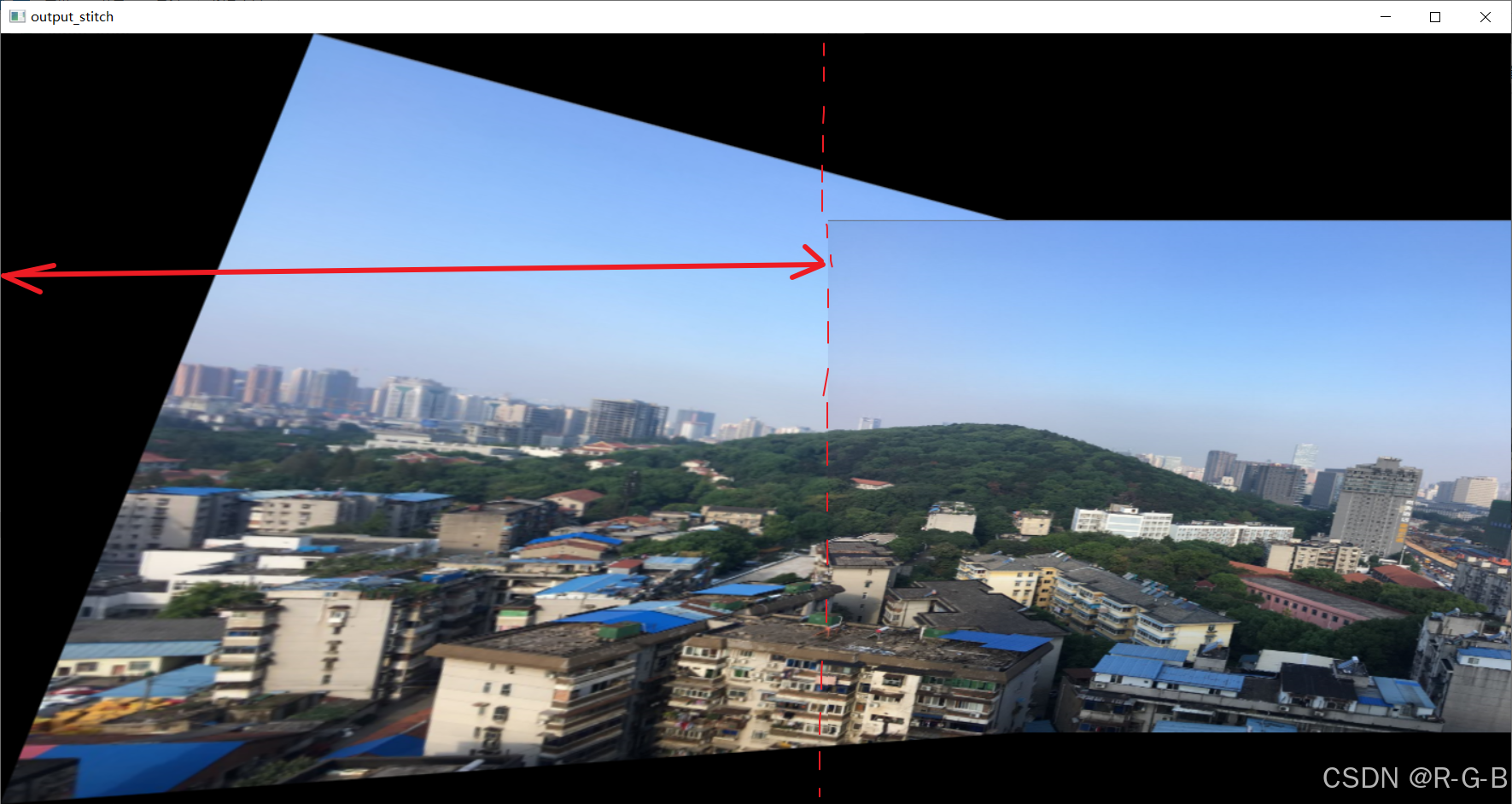

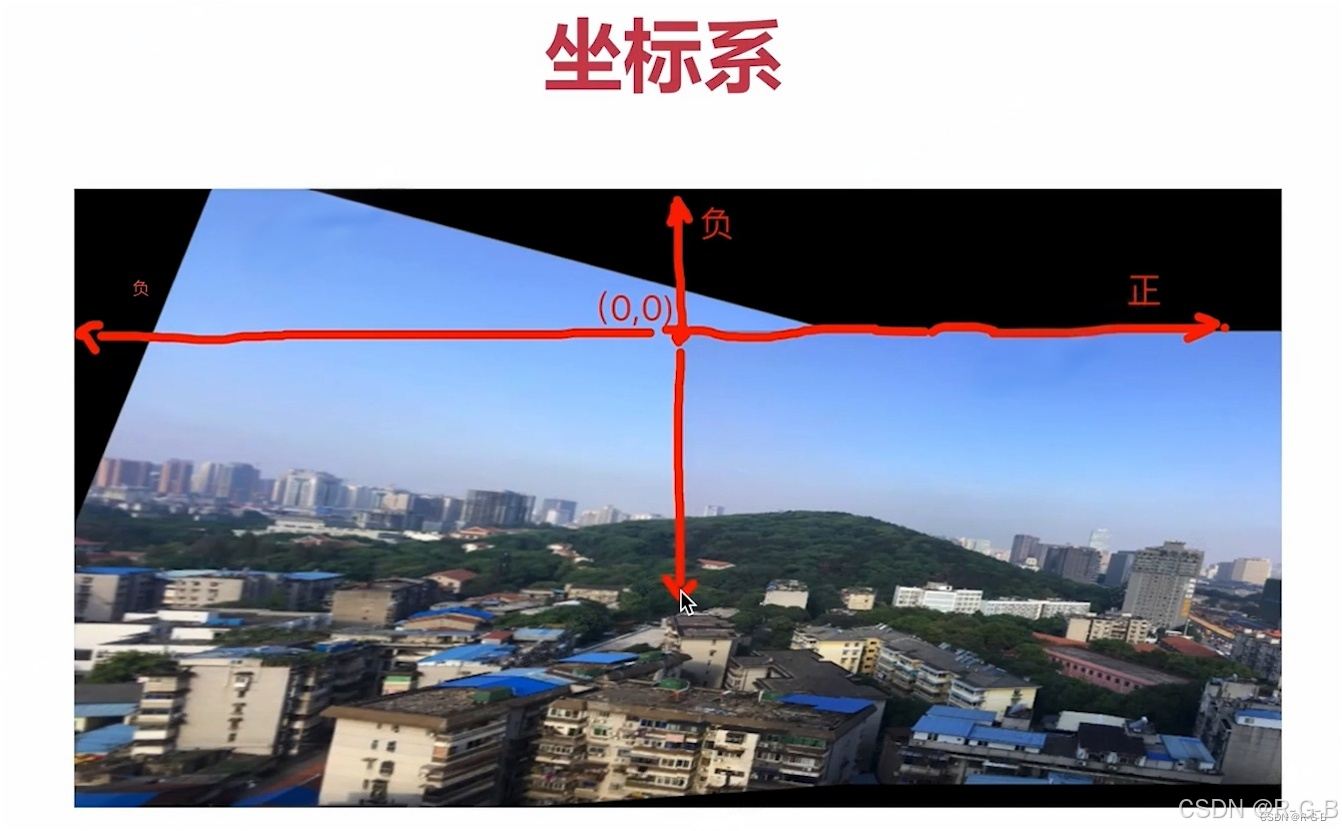

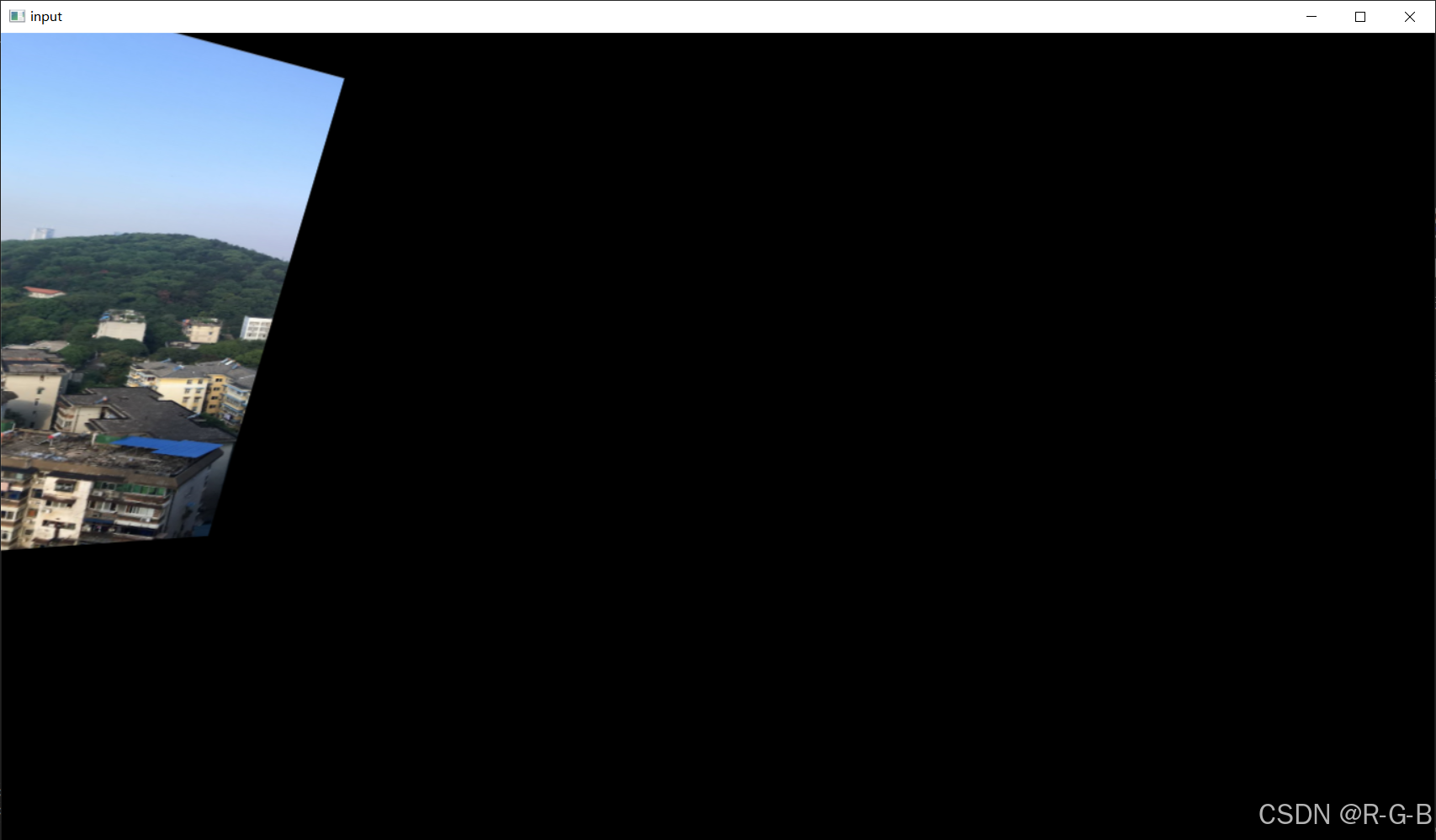

第二张图像的左上角是原点(0,0),左边和上边的都是负值,不显示

左边的图片变换后,超出尺寸的就不显示了,

事实上显示出来的那一部分,是与第二张图重叠的部分

放大窗口

从左上往右下拉

之后将右边的图,平移过来

1.1 特征匹配 原理及代码示例

超详细教程:特征点检测与匹配(Harris角点检测、Shi-Tomasi角点检测、SIFT关键点检测、SURF特征检测、 ORB特征检测、暴力特征匹配、FLANN特)

1.2 单应性矩阵 原理及代码示例

2 图像拼接(一)(直接拼接)

python

import cv2

import numpy as np

#第一步,读取文件,将图片设置成一样大小640*480

#第二步,找特征点,描述子,计算单应性矩阵

#第三部,根据单应性矩阵对图像进行变换,然后平移

#第四部,拼接并输出结果

img1=cv2.imread('map1.png')

img2=cv2.imread('map2.png')

#设置成一样大小640*480

img1=cv2.resize(img1,(640,480))

img2=cv2.resize(img2,(640,480))

#将两图横向压入栈中,即直接拼接

inputs=np.hstack((img1,img2))

cv2.imshow('input',inputs)

cv2.waitKey(0)可见,直接拼接只是简单的把两个图像拼在一起,不可用

3 图像拼接(二)(单应性矩阵 + 图像变换 + 拼接)

3.1 单应性矩阵函数

python

def get_homo(img1,img2):

#1 创建特征转换对象

#2 通过特征转换获得特征点和描述子

#3 创建特征匹配器

#4 进行特征匹配

#5 验证过滤特征,找出有效的特征匹配点

sift = cv2.xfeatures2d.SIFT_create()

k1,d1=sift.detectAndCompute(img1,None)

k2,d2=sift.detectAndCompute(img2,None)

#创建特征匹配器

bf=cv2.BFMatcher()

matches=bf.knnMatch(d1,d2,k=2)

verify_matches=[]

verify_ratio = 0.8 #过滤器阈值

for m1,m2 in matches:

if m1.destance < 0.8*m2.distance:

verify_matches.append(m1)

min_matches=8

if len(verify_matches)>=min_matches:

img1_pts=[] #img1特征坐标点

img2_pts=[]

for m in verify_matches:

img1_pts.append(k1[m.queryIdx].pt)

img2_pts.append(k2[m.trainIdx].pt)

#img_pt数组格式 [(x1,y2),(x2,y2)....]

#findHomography需要的数组坐标[[x1,y1],[x2,y2]...]

img1_pts=np.float(img1_pts).reshape(-1,1,2)

img2_pts=np.float(img2_pts).reshape(-1,1,2)

H,mask=cv2.findHomography(img1_pts,img2_pts,cv2.RANSAC,5.0)

return H

else :

print('err: Not enough matches')

exit()3.2 拼接函数 实现 及细节测试验证

python

#定义拼接函数

def stitch_image(img1,img2,H):

#1 获得每张图片的四个角点

#2 对图片进行变换(单应性矩阵使图进行旋转,平移)

#3 创建一张大图,将两张图拼接到一起

#4 输出结果

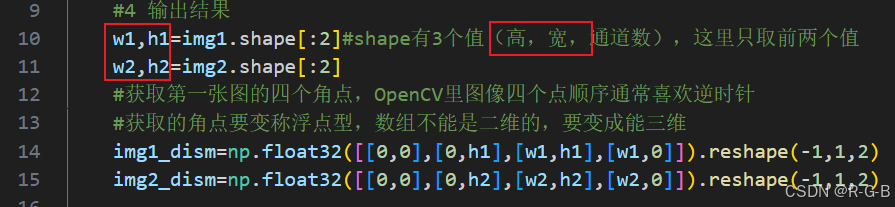

w1,h1=img1.shape[:2]#shape有3个值(高,宽,通道数),这里只取前两个值

w2,h2=img2.shape[:2]

#获取第一张图的四个角点,OpenCV里图像四个点顺序通常喜欢逆时针

#获取的角点要变称浮点型,数组不能是二维的,要变成能三维

img1_dism=np.float32([[0,0],[0,h1-1],[w1-1,h1-1],[w1-1,0]]).reshape(-1,1,2)

img2_dism=np.float32([[0,0],[0,h2-1],[w2-1,h2-1],[w2-1,0]]).reshape(-1,1,2)

img1_transform=cv2.perspectiveTransform(img1_dism,H)

print(img1_dism)

print(img2_dism)

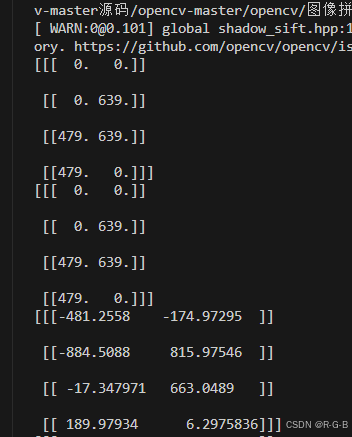

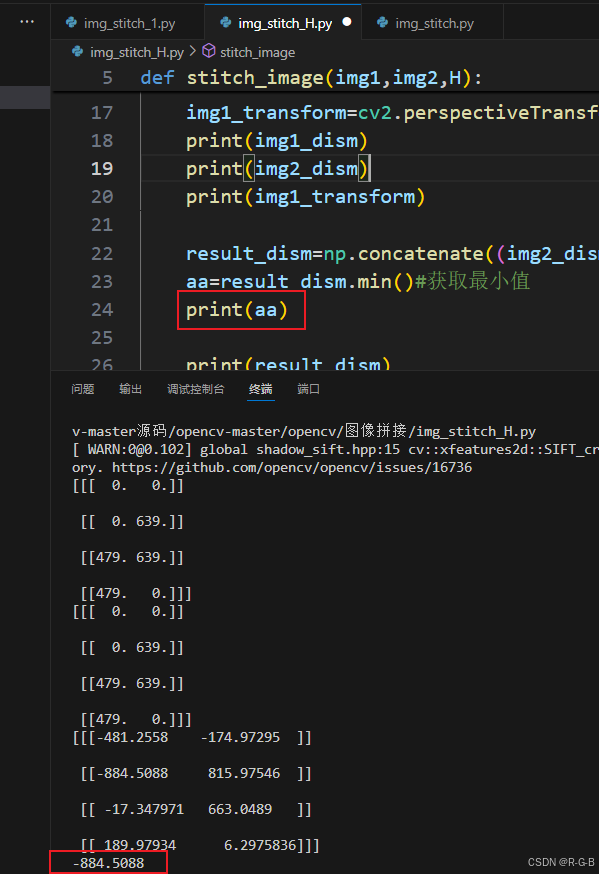

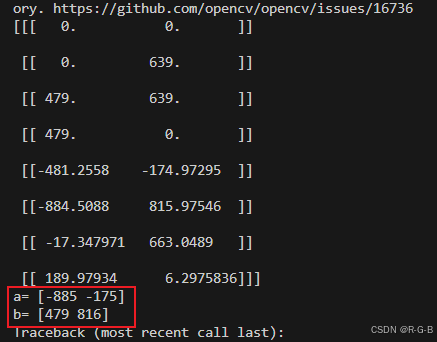

print(img1_transform)输出img1,img2和变换后img1的四个角点

python

print(img1_dism)

print(img2_dism)

print(img1_transform)变换后img1_transform的四个角点,坐标有负值,原因超出了边界,超出的部分不显示;

python

result_dism=np.concatenate((img2_dism,img1_transform),axis=0)

aa=result_dism.min()#获取最小值

print(aa)

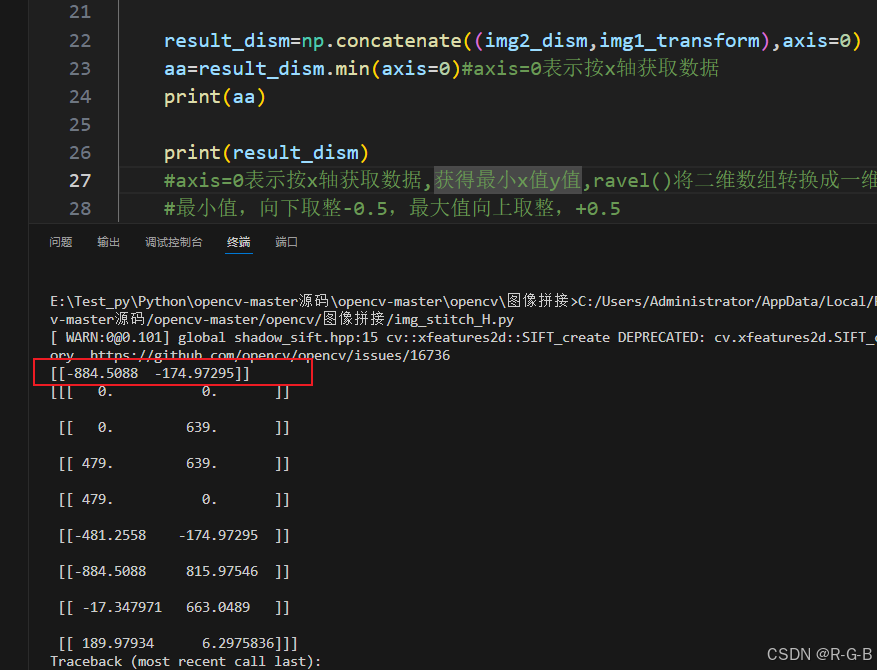

只输出了一个数,是所有数据的最小值;

要输出最小的x值和最小y值,axis=0表示按x轴获取数据

python

aa=result_dism.min(axis=0)#axis=0表示按x轴获取数据

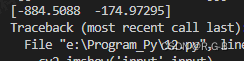

ravel()将二维数组转换成一维

可以看到双括号,变成了单括号

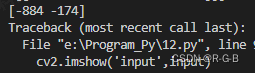

转换为整形,

python

aa=np.int32(result_dism.min(axis=0).ravel())

python

#最小值,向下取整-0.5,最大值向上取整,+0.5

a=np.int32(result_dism.min(axis=0).ravel()-0.5)

b=np.int32(result_dism.max(axis=0).ravel()+0.5)

print(a)

print(b)

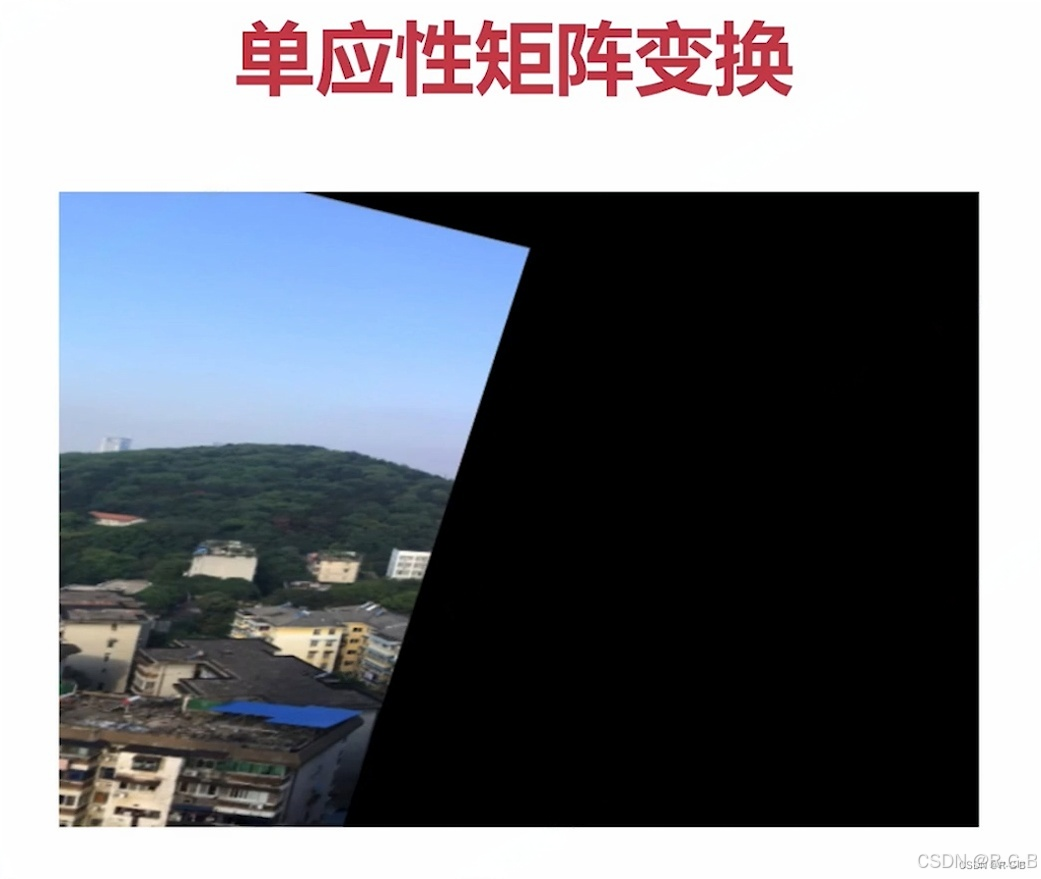

变换之后的图,需要平移

python

#单应性矩阵变换,未平移

result_img=cv2.warpPerspective(img1,H,(max_x-min_x,max_y-min_y))#min是负值,减号,就相当于加

#平移,即乘以一个齐次坐标

#[1,0,dx]

#[0,1,dy]

#[0,0,1 ]

python

transform_array=np.array([[1,0,transform_dist[0]],

[0,1,transform_dist[1]],

[0,0,1]])

#单应性矩阵变换

result_img=cv2.warpPerspective(img1,transform_array.dot(H),(max_x-min_x,max_y-min_y))#min是负值,减号,就相当于加

return result_img至此,图像一的变换与平移完成

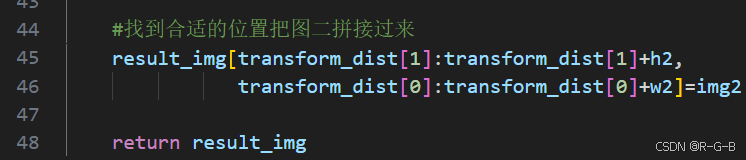

3.3 图像拼接

python

#找到合适的位置把图二拼接过来

result_img[transform_dist[1]:transform_dist[1]+h2,

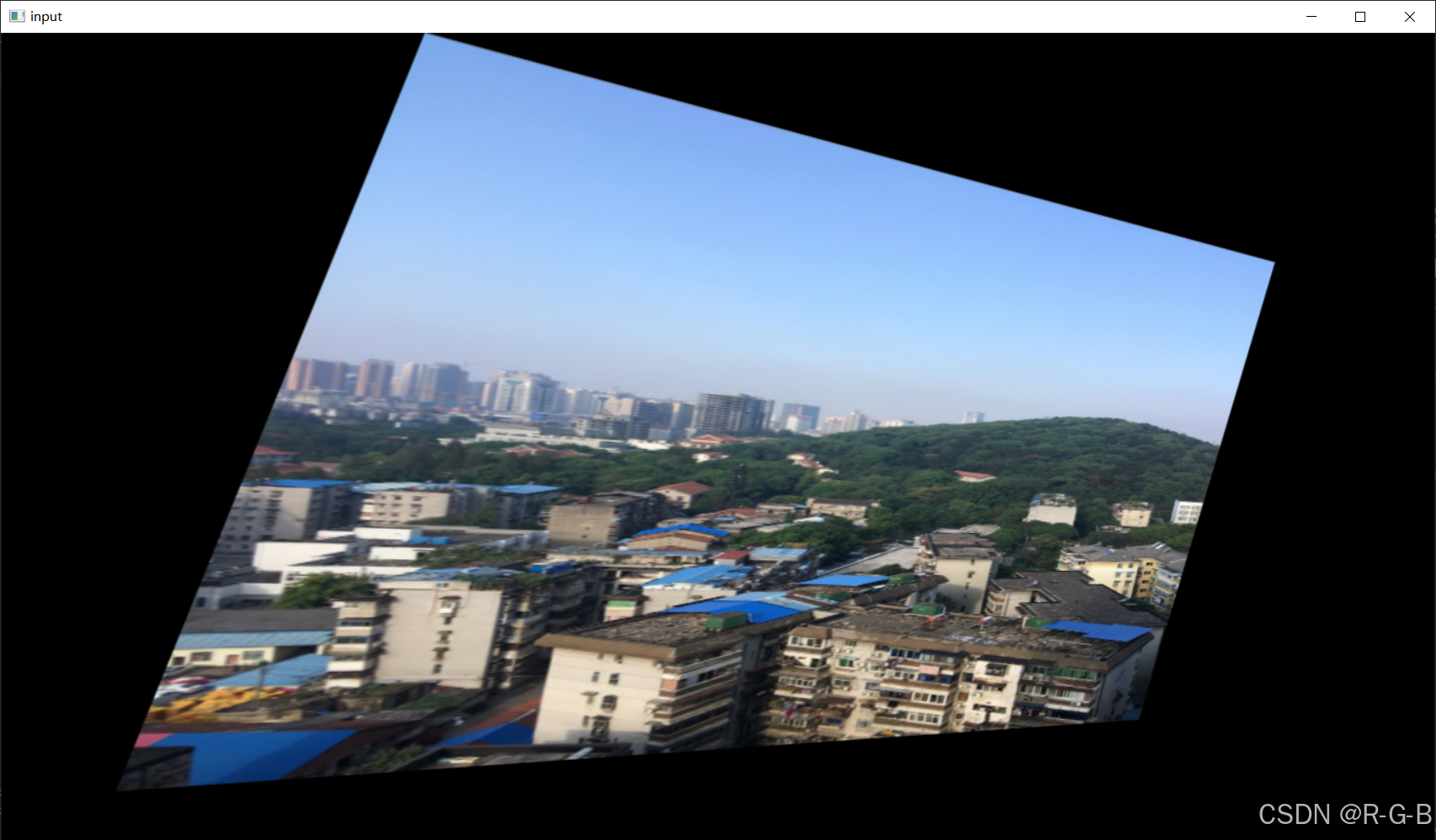

transform_dist[0]:transform_dist[0]+w2]=img2到此处,拼过工作已经完后,证情况下运行出拼接结果。

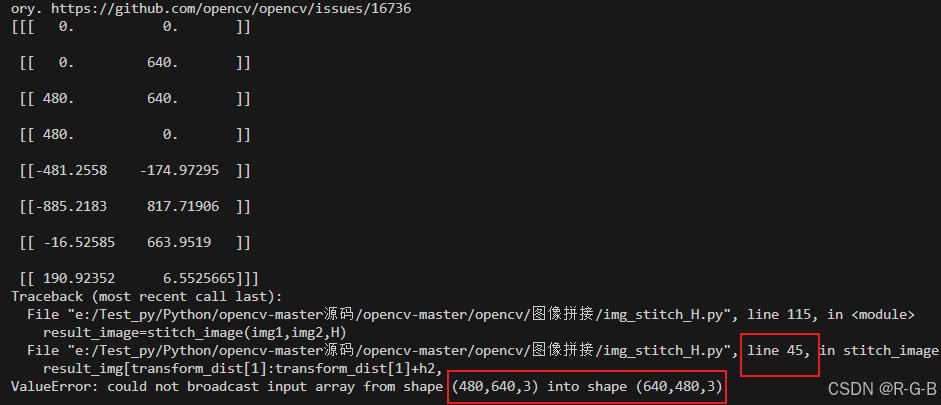

但是结果却出错了,图像的宽高颠倒了 。

跳转到45行,是最后写的一个拼接位置,,好像也没有什么毛病。

反复的全文检查了好几遍,也没发现问题。

最后发现这里,不一致;

shape数据存储顺序为:高,宽,通道数;

而写的是w,h,颠倒了,调换过来问题解决!

python

#获取原始图像的高宽

h1,w1=img1.shape[:2]#shape有3个值(高,宽,通道数),这里只取前两个值

h2,w2=img2.shape[:2]运行结果;

完整代码:

python

import cv2

import numpy as np

#根据单应性矩阵对图像进行变换,及拼接

def stitch_image(img1,img2,H):

#1 获得每张图片的四个角点

#2 对第二张图片进行变换(单应性矩阵使图进行旋转,平移)

#3 创建一张大图,将两张图拼接到一起

#4 输出结果

#获取原始图像的高宽

h1,w1=img1.shape[:2]#shape有3个值(高,宽,通道数),这里只取前两个值

h2,w2=img2.shape[:2]

#获取第一张图的四个角点,OpenCV里图像四个点顺序通常喜欢逆时针

#获取的角点要变称浮点型,数组不能是二维的,要变成能三维

img1_dism=np.float32([[0,0],[0,h1],[w1,h1],[w1,0]]).reshape(-1,1,2)

img2_dism=np.float32([[0,0],[0,h2],[w2,h2],[w2,0]]).reshape(-1,1,2)

img1_transform=cv2.perspectiveTransform(img1_dism,H)

#print(img1_dism)

#print(img2_dism)

#print(img1_transform)

result_dism=np.concatenate((img2_dism,img1_transform),axis=0)

print(result_dism)

#axis=0表示按x轴获取数据,获得最小x值y值,ravel()将二维数组转换成一维,转换为整形,

#最小值,向下取整-0.5,最大值向上取整,+0.5

[min_x,min_y]=np.int32(result_dism.min(axis=0).ravel()-0.5)

[max_x,max_y]=np.int32(result_dism.max(axis=0).ravel()+0.5)

#图像变换之后,部分数均已经超出显示范围,需要平移到大窗口中

#平移的距离

transform_dist = [-min_x,-min_y] #加负号,变成正值

#平移,即乘以一个齐次坐标

#[1,0,dx]

#[0,1,dy]

#[0,0,1 ]

transform_array=np.array([[1,0,transform_dist[0]],

[0,1,transform_dist[1]],

[0,0,1]])

#单应性矩阵变换

#到此处图像一的变换与平移完成

result_img=cv2.warpPerspective(img1,transform_array.dot(H),(max_x-min_x,max_y-min_y))#min是负值,减号,就相当于加

#到此处图像一的变换与平移完成

#找到合适的位置把图二拼接过来

result_img[transform_dist[1]:transform_dist[1]+h2,

transform_dist[0]:transform_dist[0]+w2]=img2

return result_img

#定义单应性矩阵函数

def get_homo(img1,img2):

#1 创建特征转换对象

#2 通过特征转换获得特征点和描述子

#3 创建特征匹配器

#4 进行特征匹配

#5 验证过滤特征,找出有效的特征匹配点

sift = cv2.xfeatures2d.SIFT_create()

k1,d1=sift.detectAndCompute(img1,None)

k2,d2=sift.detectAndCompute(img2,None)

#创建特征匹配器

bf=cv2.BFMatcher()

matches=bf.knnMatch(d1,d2,k=2)

#过滤特征,找出有效的特征匹配点

verify_matches=[]

verify_ratio = 0.8 #过滤器阈值

for m1,m2 in matches:

if m1.distance < 0.8 * m2.distance:

verify_matches.append(m1)

min_matches=8

if len(verify_matches)>min_matches:

img1_pts=[] #img1特征坐标点

img2_pts=[]

for m in verify_matches:

img1_pts.append(k1[m.queryIdx].pt)

img2_pts.append(k2[m.trainIdx].pt)

#img_pt数组格式 [(x1,y2),(x2,y2)....]

#findHomography需要的数组坐标[[x1,y1],[x2,y2]...]

img1_pts=np.float32(img1_pts).reshape(-1,1,2)

img2_pts=np.float32(img2_pts).reshape(-1,1,2)

H,mask=cv2.findHomography(img1_pts,img2_pts,cv2.RANSAC,5.0)

return H

else :

print('err: Not enough matches')

exit()

#第一步,读取文件,将图片设置成一样大小640*480

#第二步,找特征点,描述子,计算单应性矩阵

#第三部,根据单应性矩阵对图像进行变换,然后平移

#第四部,拼接并输出结果

img1=cv2.imread('map1.png')

img2=cv2.imread('map2.png')

#设置成一样大小640*480

img1=cv2.resize(img1,(640,480))

img2=cv2.resize(img2,(640,480))

#将两图横向压入栈中,即直接拼接

inputs=np.hstack((img1,img2))

#获得单应性矩阵

H=get_homo(img1,img2)

#根据单应性矩阵对图像进行变换,及拼接

result_image=stitch_image(img1,img2,H)

cv2.imshow('input',result_image)

cv2.waitKey(0)4 后续完善(拼接缝隙过度、裁剪)

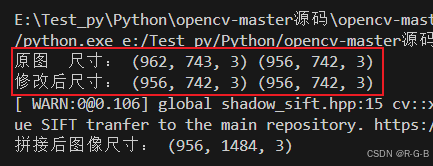

4.1 输入图像大小一致 优化

上面的代码示例,手动设置img1,和img的尺寸

python

#设置成一样大小640*480

img1=cv2.resize(img1,(640,480))

img2=cv2.resize(img2,(640,480))现在改为,自动确定尺寸。

判断图片尺寸是否一致,

如果 一样大,不做resize;

如果不一样大,就要resize,选择两幅图中最小的宽高作为resize后的尺寸。

python

#判断图片尺寸是否一致,如果不一样大,就要resize,这里选择两幅图中最小的宽高

if (imageA.shape[0]==imageB.shape[0] and imageA.shape[1]==imageB.shape[1])!=1:

h=min(imageA.shape[1],imageB.shape[1])

w=min(imageA.shape[0],imageB.shape[0])

imageA=cv2.resize(imageA,(h,w))#注意这里尺寸(高,宽),和平时的习惯宽高有点不一样

imageB=cv2.resize(imageB,(h,w))

print('修改后尺寸:',imageA.shape,imageB.shape)#输出调整后的尺寸下图输出信息分别为:

两张图片原始尺寸;

resize后的尺寸;

拼接后的尺寸;

4.2 后续完善

5 进阶实战--图像拼接 (实战项目)

上面的图像拼接,重在展示基本原理,但存在拼接缝隙过度等一些问题。只用于实验,不能满足实际项目要求。

下面是,实战项目,实现。