企业知识管理革命:RAG系统在大型组织中的落地实践

🌟 Hello,我是摘星!

🌈 在彩虹般绚烂的技术栈中,我是那个永不停歇的色彩收集者。

🦋 每一个优化都是我培育的花朵,每一个特性都是我放飞的蝴蝶。

🔬 每一次代码审查都是我的显微镜观察,每一次重构都是我的化学实验。

🎵 在编程的交响乐中,我既是指挥家也是演奏者。让我们一起,在技术的音乐厅里,奏响属于程序员的华美乐章。

目录

[1. RAG系统概述与企业应用场景](#1. RAG系统概述与企业应用场景)

[1.1 RAG技术原理](#1.1 RAG技术原理)

[1.2 企业级应用场景](#1.2 企业级应用场景)

[2. 企业级RAG系统架构设计](#2. 企业级RAG系统架构设计)

[2.1 整体架构设计](#2.1 整体架构设计)

[2.2 核心组件实现](#2.2 核心组件实现)

[2.2.1 查询引擎实现](#2.2.1 查询引擎实现)

[2.2.2 检索服务实现](#2.2.2 检索服务实现)

[3. 数据处理与知识库构建](#3. 数据处理与知识库构建)

[3.1 数据处理流程](#3.1 数据处理流程)

[3.2 文档分块策略](#3.2 文档分块策略)

[4. 模型优化与性能调优](#4. 模型优化与性能调优)

[4.1 检索模型优化](#4.1 检索模型优化)

[4.2 生成模型调优](#4.2 生成模型调优)

[5. 部署与运维实践](#5. 部署与运维实践)

[5.1 容器化部署](#5.1 容器化部署)

[5.2 监控与告警](#5.2 监控与告警)

[6. 安全与合规考虑](#6. 安全与合规考虑)

[6.1 数据安全架构](#6.1 数据安全架构)

[6.2 权限控制实现](#6.2 权限控制实现)

[7. 性能优化与成本控制](#7. 性能优化与成本控制)

[7.1 性能优化策略](#7.1 性能优化策略)

[7.2 成本控制策略](#7.2 成本控制策略)

[8. 实际案例分析](#8. 实际案例分析)

[8.1 某大型制造企业案例](#8.1 某大型制造企业案例)

[8.2 效果评估](#8.2 效果评估)

[9. 未来发展趋势](#9. 未来发展趋势)

[9.1 技术演进路线](#9.1 技术演进路线)

[9.2 发展方向预测](#9.2 发展方向预测)

[10. 最佳实践总结](#10. 最佳实践总结)

[10.1 架构设计原则](#10.1 架构设计原则)

[10.2 数据管理策略](#10.2 数据管理策略)

[10.3 用户体验优化](#10.3 用户体验优化)

摘要

作为一名深耕企业级AI系统开发多年的技术人,我见证了知识管理从传统文档库到智能化RAG系统的完整演进过程。在过去的两年里,我主导了多个大型组织的RAG系统落地项目,从最初的概念验证到最终的生产环境部署,每一步都充满了挑战与收获。

传统的企业知识管理往往面临着信息孤岛、检索效率低下、知识更新滞后等痛点。员工需要在海量文档中寻找答案,往往花费大量时间却收效甚微。而RAG(Retrieval-Augmented Generation)系统的出现,为这些问题提供了革命性的解决方案。它将检索与生成相结合,不仅能够快速定位相关信息,还能基于企业内部知识生成准确、个性化的答案。

在实际落地过程中,我发现RAG系统的成功部署远不止技术层面的考量。从数据治理到用户体验,从安全合规到成本控制,每个环节都需要精心设计。特别是在大型组织中,复杂的业务场景、多样化的数据源、严格的安全要求,都对RAG系统的架构设计提出了更高的挑战。

本文将基于我在多个大型企业RAG系统项目中的实战经验,从技术架构、数据处理、模型优化、部署运维等多个维度,深入剖析RAG系统在企业环境中的落地实践。我会分享那些在项目中踩过的坑、总结出的最佳实践,以及对未来发展趋势的思考。希望能为正在或即将进行RAG系统建设的技术团队提供有价值的参考。

1. RAG系统概述与企业应用场景

1.1 RAG技术原理

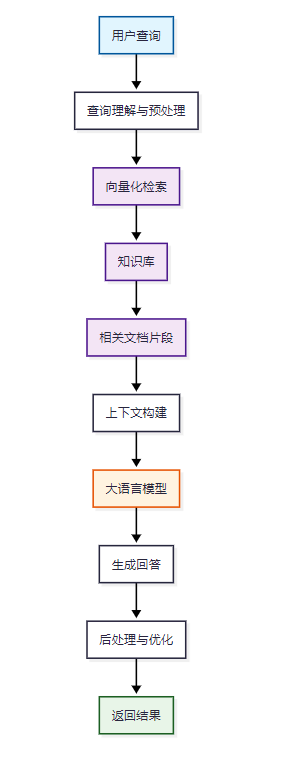

RAG(Retrieval-Augmented Generation)是一种结合了信息检索和文本生成的AI技术架构。它通过检索相关文档片段,然后将这些信息作为上下文输入到大语言模型中,生成更准确、更具针对性的回答。

图1:RAG系统核心工作流程图

1.2 企业级应用场景

在大型组织中,RAG系统的应用场景非常广泛:

- 内部知识问答:员工可以快速查询公司政策、流程规范、技术文档

- 客户服务支持:基于产品手册、FAQ等生成准确的客户回答

- 合规风控查询:快速检索法规条文、合规要求、风险案例

- 研发技术支持:代码库检索、技术方案查询、最佳实践推荐

2. 企业级RAG系统架构设计

2.1 整体架构设计

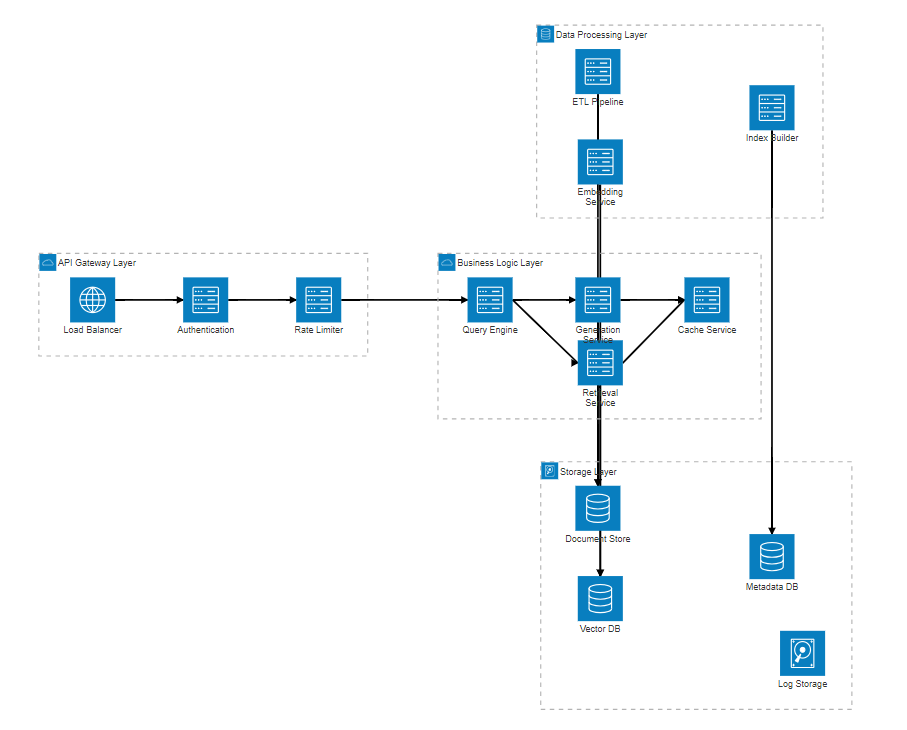

企业级RAG系统需要考虑高可用、高并发、安全性等多重要求。以下是我在项目中采用的分层架构设计:

图2:企业级RAG系统分层架构图

2.2 核心组件实现

2.2.1 查询引擎实现

python

import asyncio

from typing import List, Dict, Optional

from dataclasses import dataclass

from abc import ABC, abstractmethod

@dataclass

class QueryContext:

"""查询上下文"""

user_id: str

query: str

session_id: Optional[str] = None

filters: Optional[Dict] = None

max_results: int = 5

class QueryEngine:

"""查询引擎核心类"""

def __init__(self, retrieval_service, generation_service, cache_service):

self.retrieval_service = retrieval_service

self.generation_service = generation_service

self.cache_service = cache_service

async def process_query(self, context: QueryContext) -> Dict:

"""处理用户查询的主流程"""

try:

# 1. 查询预处理

processed_query = await self._preprocess_query(context.query)

# 2. 缓存检查

cache_key = self._generate_cache_key(processed_query, context.filters)

cached_result = await self.cache_service.get(cache_key)

if cached_result:

return cached_result

# 3. 检索相关文档

retrieved_docs = await self.retrieval_service.retrieve(

query=processed_query,

filters=context.filters,

max_results=context.max_results

)

# 4. 生成回答

response = await self.generation_service.generate(

query=processed_query,

context_docs=retrieved_docs,

user_context=context

)

# 5. 结果缓存

await self.cache_service.set(cache_key, response, ttl=3600)

return response

except Exception as e:

# 错误处理和日志记录

await self._log_error(context, str(e))

return self._generate_error_response(str(e))

async def _preprocess_query(self, query: str) -> str:

"""查询预处理:清洗、标准化、意图识别"""

# 去除特殊字符和多余空格

cleaned_query = ' '.join(query.strip().split())

# 查询扩展和同义词替换

expanded_query = await self._expand_query(cleaned_query)

return expanded_query

def _generate_cache_key(self, query: str, filters: Optional[Dict]) -> str:

"""生成缓存键"""

import hashlib

content = f"{query}_{str(filters or {})}"

return hashlib.md5(content.encode()).hexdigest()2.2.2 检索服务实现

import numpy as np

from sentence_transformers import SentenceTransformer

from typing import List, Dict, Tuple

import faiss

class RetrievalService:

"""检索服务实现"""

def __init__(self, vector_db, embedding_model_path: str):

self.vector_db = vector_db

self.embedding_model = SentenceTransformer(embedding_model_path)

self.index = None

self._load_index()

def _load_index(self):

"""加载FAISS索引"""

try:

self.index = faiss.read_index("enterprise_knowledge.index")

except FileNotFoundError:

print("索引文件不存在,需要重新构建")

async def retrieve(self, query: str, filters: Dict = None,

max_results: int = 5) -> List[Dict]:

"""检索相关文档"""

# 1. 查询向量化

query_embedding = self.embedding_model.encode([query])

# 2. 向量检索

distances, indices = self.index.search(

query_embedding.astype('float32'),

max_results * 2 # 检索更多候选,后续过滤

)

# 3. 获取文档详情

candidate_docs = await self._get_documents_by_indices(indices[0])

# 4. 应用过滤器

filtered_docs = self._apply_filters(candidate_docs, filters)

# 5. 重排序

reranked_docs = await self._rerank_documents(query, filtered_docs)

return reranked_docs[:max_results]

async def _get_documents_by_indices(self, indices: np.ndarray) -> List[Dict]:

"""根据索引获取文档详情"""

documents = []

for idx in indices:

if idx != -1: # FAISS返回-1表示无效索引

doc = await self.vector_db.get_document(int(idx))

if doc:

documents.append(doc)

return documents

def _apply_filters(self, documents: List[Dict], filters: Dict) -> List[Dict]:

"""应用业务过滤器"""

if not filters:

return documents

filtered = []

for doc in documents:

# 部门过滤

if 'department' in filters:

if doc.get('department') not in filters['department']:

continue

# 权限过滤

if 'access_level' in filters:

if doc.get('access_level', 0) > filters['access_level']:

continue

# 时间过滤

if 'date_range' in filters:

doc_date = doc.get('created_date')

if not self._in_date_range(doc_date, filters['date_range']):

continue

filtered.append(doc)

return filtered

async def _rerank_documents(self, query: str, documents: List[Dict]) -> List[Dict]:

"""文档重排序"""

if len(documents) <= 1:

return documents

# 计算语义相似度分数

doc_texts = [doc['content'] for doc in documents]

query_embedding = self.embedding_model.encode([query])

doc_embeddings = self.embedding_model.encode(doc_texts)

# 计算余弦相似度

similarities = np.dot(query_embedding, doc_embeddings.T)[0]

# 结合其他因子(新鲜度、权威性等)

final_scores = []

for i, doc in enumerate(documents):

semantic_score = similarities[i]

freshness_score = self._calculate_freshness_score(doc)

authority_score = doc.get('authority_score', 0.5)

# 加权计算最终分数

final_score = (

0.6 * semantic_score +

0.2 * freshness_score +

0.2 * authority_score

)

final_scores.append((final_score, doc))

# 按分数排序

final_scores.sort(key=lambda x: x[0], reverse=True)

return [doc for score, doc in final_scores]3. 数据处理与知识库构建

3.1 数据处理流程

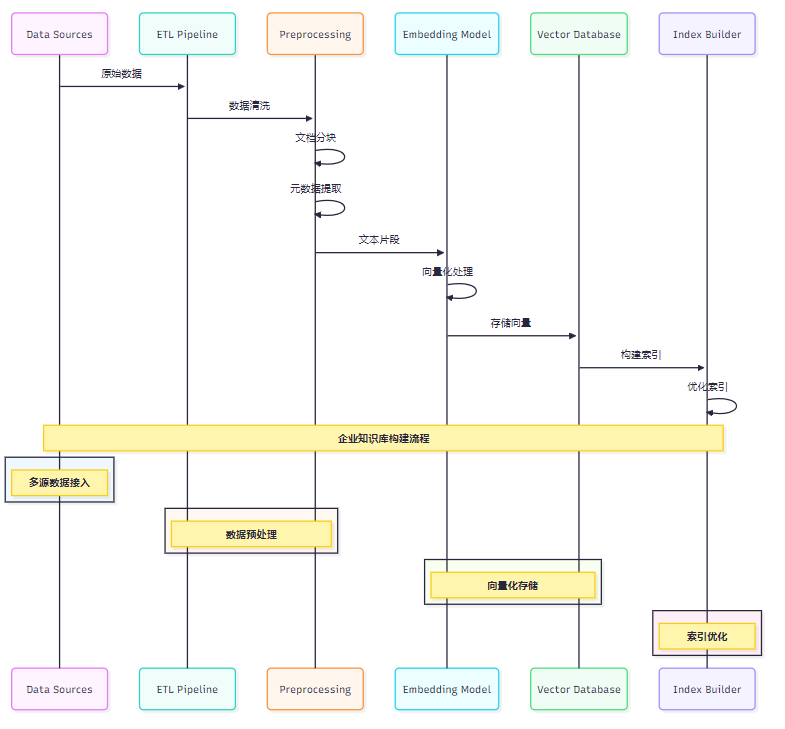

企业知识库的数据来源多样化,需要建立完善的ETL流程:

图3:企业知识库数据处理时序图

3.2 文档分块策略

python

from typing import List, Dict, Tuple

import re

from dataclasses import dataclass

@dataclass

class DocumentChunk:

"""文档块数据结构"""

content: str

metadata: Dict

chunk_id: str

parent_doc_id: str

chunk_index: int

class DocumentChunker:

"""智能文档分块器"""

def __init__(self, chunk_size: int = 512, overlap: int = 50):

self.chunk_size = chunk_size

self.overlap = overlap

def chunk_document(self, document: Dict) -> List[DocumentChunk]:

"""对文档进行智能分块"""

content = document['content']

doc_type = document.get('type', 'text')

if doc_type == 'markdown':

return self._chunk_markdown(document)

elif doc_type == 'code':

return self._chunk_code(document)

else:

return self._chunk_text(document)

def _chunk_markdown(self, document: Dict) -> List[DocumentChunk]:

"""Markdown文档分块"""

content = document['content']

chunks = []

# 按标题层级分块

sections = self._split_by_headers(content)

for i, section in enumerate(sections):

if len(section['content']) > self.chunk_size:

# 大段落进一步分块

sub_chunks = self._split_large_section(section['content'])

for j, sub_chunk in enumerate(sub_chunks):

chunk = DocumentChunk(

content=sub_chunk,

metadata={

**document.get('metadata', {}),

'section_title': section['title'],

'section_level': section['level'],

'sub_chunk_index': j

},

chunk_id=f"{document['id']}_section_{i}_chunk_{j}",

parent_doc_id=document['id'],

chunk_index=len(chunks)

)

chunks.append(chunk)

else:

chunk = DocumentChunk(

content=section['content'],

metadata={

**document.get('metadata', {}),

'section_title': section['title'],

'section_level': section['level']

},

chunk_id=f"{document['id']}_section_{i}",

parent_doc_id=document['id'],

chunk_index=len(chunks)

)

chunks.append(chunk)

return chunks

def _split_by_headers(self, content: str) -> List[Dict]:

"""按标题分割Markdown内容"""

sections = []

lines = content.split('\n')

current_section = {'title': '', 'level': 0, 'content': ''}

for line in lines:

header_match = re.match(r'^(#{1,6})\s+(.+)$', line)

if header_match:

# 保存当前段落

if current_section['content'].strip():

sections.append(current_section.copy())

# 开始新段落

level = len(header_match.group(1))

title = header_match.group(2)

current_section = {

'title': title,

'level': level,

'content': line + '\n'

}

else:

current_section['content'] += line + '\n'

# 添加最后一个段落

if current_section['content'].strip():

sections.append(current_section)

return sections

def _chunk_code(self, document: Dict) -> List[DocumentChunk]:

"""代码文档分块"""

content = document['content']

language = document.get('language', 'python')

# 按函数/类分块

if language in ['python', 'java', 'javascript']:

return self._chunk_by_functions(document)

else:

return self._chunk_text(document)

def _chunk_by_functions(self, document: Dict) -> List[DocumentChunk]:

"""按函数分块代码"""

content = document['content']

chunks = []

# 简单的函数分割(实际项目中需要使用AST解析)

function_pattern = r'(def\s+\w+.*?(?=\ndef\s|\nclass\s|$))'

functions = re.findall(function_pattern, content, re.DOTALL)

for i, func_code in enumerate(functions):

# 提取函数名

func_name_match = re.search(r'def\s+(\w+)', func_code)

func_name = func_name_match.group(1) if func_name_match else f"function_{i}"

chunk = DocumentChunk(

content=func_code.strip(),

metadata={

**document.get('metadata', {}),

'function_name': func_name,

'code_type': 'function'

},

chunk_id=f"{document['id']}_func_{func_name}",

parent_doc_id=document['id'],

chunk_index=i

)

chunks.append(chunk)

return chunks4. 模型优化与性能调优

4.1 检索模型优化

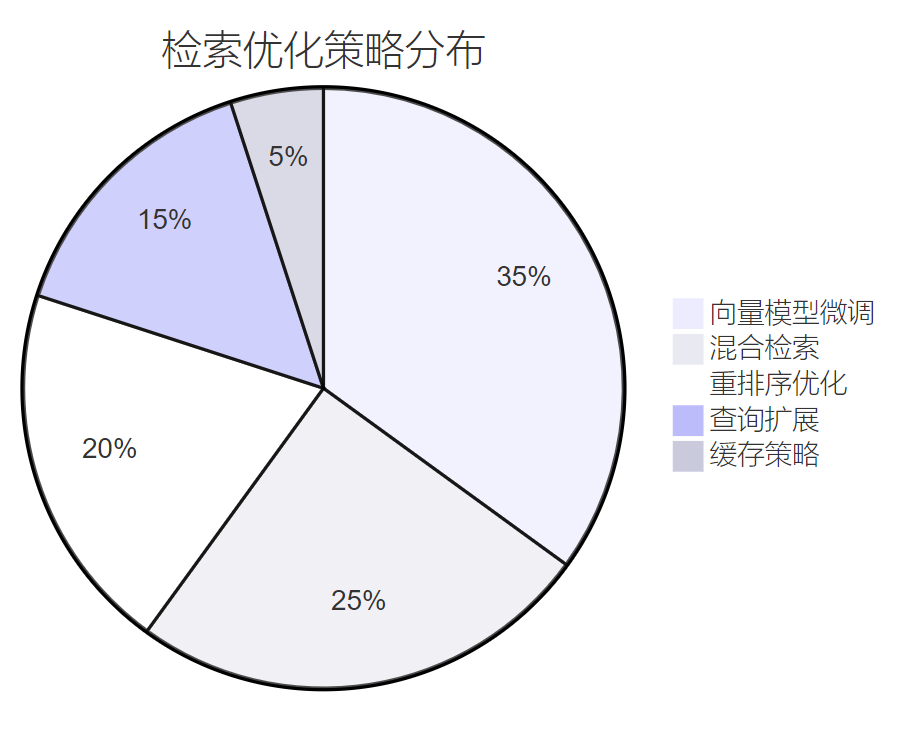

在企业环境中,检索精度直接影响用户体验。我们采用多阶段优化策略:

图4:检索优化策略占比分布饼图

4.2 生成模型调优

python

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from typing import List, Dict, Optional

import json

class EnterpriseGenerationService:

"""企业级生成服务"""

def __init__(self, model_path: str, device: str = "cuda"):

self.device = device

self.tokenizer = AutoTokenizer.from_pretrained(model_path)

self.model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.float16,

device_map="auto"

)

# 企业级提示词模板

self.prompt_templates = {

'general': self._load_prompt_template('general'),

'technical': self._load_prompt_template('technical'),

'policy': self._load_prompt_template('policy'),

'customer_service': self._load_prompt_template('customer_service')

}

async def generate(self, query: str, context_docs: List[Dict],

user_context: Dict) -> Dict:

"""生成回答"""

try:

# 1. 选择合适的提示词模板

template_type = self._determine_template_type(query, context_docs)

template = self.prompt_templates[template_type]

# 2. 构建提示词

prompt = self._build_prompt(template, query, context_docs, user_context)

# 3. 生成回答

response = await self._generate_response(prompt)

# 4. 后处理

processed_response = self._post_process_response(response, user_context)

return {

'answer': processed_response,

'sources': [doc['id'] for doc in context_docs],

'confidence': self._calculate_confidence(response, context_docs),

'template_used': template_type

}

except Exception as e:

return self._generate_fallback_response(str(e))

def _build_prompt(self, template: str, query: str,

context_docs: List[Dict], user_context: Dict) -> str:

"""构建提示词"""

# 整理上下文文档

context_text = "\n\n".join([

f"文档{i+1}:{doc['title']}\n{doc['content'][:800]}..."

for i, doc in enumerate(context_docs)

])

# 用户信息

user_info = f"用户部门:{user_context.get('department', '未知')}"

# 填充模板

prompt = template.format(

context=context_text,

query=query,

user_info=user_info,

current_date=self._get_current_date()

)

return prompt

async def _generate_response(self, prompt: str) -> str:

"""生成模型推理"""

inputs = self.tokenizer(prompt, return_tensors="pt", truncation=True,

max_length=4000).to(self.device)

with torch.no_grad():

outputs = self.model.generate(

**inputs,

max_new_tokens=512,

temperature=0.7,

do_sample=True,

top_p=0.9,

repetition_penalty=1.1,

pad_token_id=self.tokenizer.eos_token_id

)

response = self.tokenizer.decode(outputs[0], skip_special_tokens=True)

# 提取生成的部分(去除输入提示词)

generated_text = response[len(prompt):].strip()

return generated_text

def _post_process_response(self, response: str, user_context: Dict) -> str:

"""回答后处理"""

# 1. 去除可能的有害内容

response = self._filter_harmful_content(response)

# 2. 格式化输出

response = self._format_response(response)

# 3. 添加免责声明(如果需要)

if self._needs_disclaimer(response):

response += "\n\n*注:以上信息仅供参考,具体执行请以最新政策为准。*"

return response

def _calculate_confidence(self, response: str, context_docs: List[Dict]) -> float:

"""计算回答置信度"""

# 简化的置信度计算

# 实际项目中可以使用更复杂的算法

factors = []

# 1. 上下文相关性

context_relevance = len(context_docs) / 5.0 # 假设5个文档为满分

factors.append(min(context_relevance, 1.0))

# 2. 回答长度合理性

response_length = len(response)

length_score = 1.0 if 50 <= response_length <= 500 else 0.7

factors.append(length_score)

# 3. 是否包含不确定表述

uncertainty_keywords = ['可能', '也许', '不确定', '建议咨询']

uncertainty_penalty = sum(1 for keyword in uncertainty_keywords

if keyword in response) * 0.1

uncertainty_score = max(0.5, 1.0 - uncertainty_penalty)

factors.append(uncertainty_score)

# 加权平均

confidence = sum(factors) / len(factors)

return round(confidence, 2)5. 部署与运维实践

5.1 容器化部署

python

# docker-compose.yml

version: '3.8'

services:

rag-api:

build:

context: .

dockerfile: Dockerfile.api

ports:

- "8000:8000"

environment:

- REDIS_URL=redis://redis:6379

- POSTGRES_URL=postgresql://user:pass@postgres:5432/ragdb

- VECTOR_DB_URL=http://milvus:19530

depends_on:

- redis

- postgres

- milvus

deploy:

replicas: 3

resources:

limits:

memory: 4G

cpus: '2'

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost:8000/health"]

interval: 30s

timeout: 10s

retries: 3

embedding-service:

build:

context: .

dockerfile: Dockerfile.embedding

environment:

- MODEL_PATH=/models/sentence-transformer

- BATCH_SIZE=32

volumes:

- ./models:/models

deploy:

replicas: 2

resources:

limits:

memory: 8G

cpus: '4'

reservations:

devices:

- driver: nvidia

count: 1

capabilities: [gpu]

redis:

image: redis:7-alpine

ports:

- "6379:6379"

volumes:

- redis_data:/data

command: redis-server --appendonly yes

postgres:

image: postgres:15

environment:

POSTGRES_DB: ragdb

POSTGRES_USER: user

POSTGRES_PASSWORD: pass

volumes:

- postgres_data:/var/lib/postgresql/data

ports:

- "5432:5432"

milvus:

image: milvusdb/milvus:v2.3.0

ports:

- "19530:19530"

volumes:

- milvus_data:/var/lib/milvus

environment:

ETCD_ENDPOINTS: etcd:2379

MINIO_ADDRESS: minio:9000

depends_on:

- etcd

- minio

volumes:

redis_data:

postgres_data:

milvus_data:5.2 监控与告警

import asyncio

import time

from typing import Dict, List

from dataclasses import dataclass

from prometheus_client import Counter, Histogram, Gauge, start_http_server

import logging

@dataclass

class MetricConfig:

"""监控指标配置"""

name: str

description: str

labels: List[str] = None

class RAGSystemMonitor:

"""RAG系统监控"""

def __init__(self):

# 定义监控指标

self.query_counter = Counter(

'rag_queries_total',

'Total number of queries processed',

['status', 'user_type']

)

self.query_duration = Histogram(

'rag_query_duration_seconds',

'Time spent processing queries',

['component']

)

self.retrieval_accuracy = Gauge(

'rag_retrieval_accuracy',

'Retrieval accuracy score'

)

self.active_users = Gauge(

'rag_active_users',

'Number of active users'

)

self.error_rate = Gauge(

'rag_error_rate',

'Error rate percentage'

)

# 启动监控服务器

start_http_server(8090)

# 日志配置

logging.basicConfig(level=logging.INFO)

self.logger = logging.getLogger(__name__)

async def track_query(self, query_context: Dict, start_time: float):

"""跟踪查询指标"""

duration = time.time() - start_time

# 记录查询计数

self.query_counter.labels(

status='success',

user_type=query_context.get('user_type', 'unknown')

).inc()

# 记录查询耗时

self.query_duration.labels(component='total').observe(duration)

# 记录日志

self.logger.info(f"Query processed in {duration:.2f}s for user {query_context.get('user_id')}")

async def update_system_metrics(self):

"""更新系统级指标"""

while True:

try:

# 更新检索准确率

accuracy = await self._calculate_retrieval_accuracy()

self.retrieval_accuracy.set(accuracy)

# 更新活跃用户数

active_count = await self._get_active_user_count()

self.active_users.set(active_count)

# 更新错误率

error_rate = await self._calculate_error_rate()

self.error_rate.set(error_rate)

await asyncio.sleep(60) # 每分钟更新一次

except Exception as e:

self.logger.error(f"Error updating metrics: {e}")

await asyncio.sleep(60)6. 安全与合规考虑

6.1 数据安全架构

企业级RAG系统必须满足严格的安全要求:

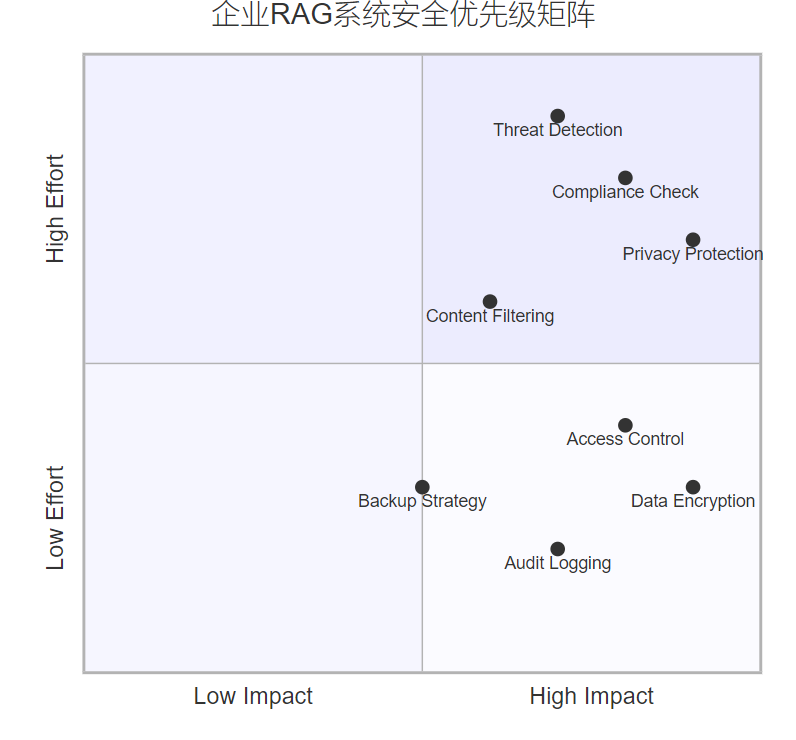

图5:企业RAG系统安全优先级象限图

6.2 权限控制实现

|-------|-------|-----------|-------|

| 权限级别 | 访问范围 | 数据类型 | 典型用户 |

| L1-公开 | 全员可见 | 公司新闻、通用政策 | 所有员工 |

| L2-内部 | 部门内可见 | 部门文档、项目资料 | 部门成员 |

| L3-机密 | 授权可见 | 财务数据、战略规划 | 管理层 |

| L4-绝密 | 严格控制 | 核心技术、商业机密 | 高级管理层 |

7. 性能优化与成本控制

7.1 性能优化策略

python

import asyncio

from typing import Dict, List, Optional

import redis

from functools import wraps

import time

class PerformanceOptimizer:

"""性能优化器"""

def __init__(self, redis_client: redis.Redis):

self.redis_client = redis_client

self.cache_stats = {'hits': 0, 'misses': 0}

def cache_result(self, ttl: int = 3600, key_prefix: str = "rag"):

"""结果缓存装饰器"""

def decorator(func):

@wraps(func)

async def wrapper(*args, **kwargs):

# 生成缓存键

cache_key = f"{key_prefix}:{self._generate_key(args, kwargs)}"

# 尝试从缓存获取

cached_result = await self._get_from_cache(cache_key)

if cached_result:

self.cache_stats['hits'] += 1

return cached_result

# 执行原函数

result = await func(*args, **kwargs)

# 存入缓存

await self._set_cache(cache_key, result, ttl)

self.cache_stats['misses'] += 1

return result

return wrapper

return decorator

async def batch_process(self, items: List[Dict],

process_func, batch_size: int = 10):

"""批量处理优化"""

results = []

for i in range(0, len(items), batch_size):

batch = items[i:i + batch_size]

# 并发处理批次

batch_tasks = [process_func(item) for item in batch]

batch_results = await asyncio.gather(*batch_tasks, return_exceptions=True)

# 处理异常

for j, result in enumerate(batch_results):

if isinstance(result, Exception):

print(f"Error processing item {i+j}: {result}")

results.append(None)

else:

results.append(result)

return results

def _generate_key(self, args, kwargs) -> str:

"""生成缓存键"""

import hashlib

key_data = str(args) + str(sorted(kwargs.items()))

return hashlib.md5(key_data.encode()).hexdigest()7.2 成本控制策略

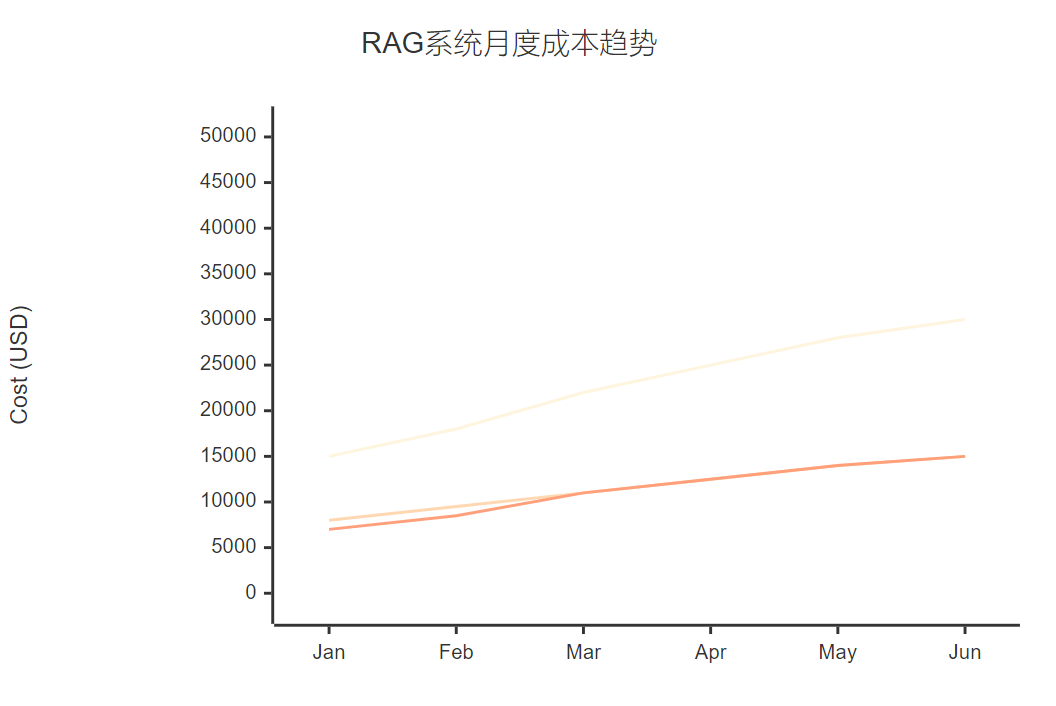

图6:RAG系统月度成本趋势XY图表

8. 实际案例分析

8.1 某大型制造企业案例

"知识就是力量,但只有被正确组织和快速获取的知识才能转化为竞争优势。RAG系统让我们的技术知识真正活了起来。" ------ 某制造企业CTO

在这个项目中,我们面临的主要挑战包括:

- 多语言文档处理:中英文技术文档混合

- 专业术语理解:大量行业特定术语

- 实时性要求:生产问题需要快速响应

解决方案:

- 构建领域专用词典,提升术语识别准确率

- 采用多语言embedding模型,支持跨语言检索

- 建立分级缓存机制,常用查询毫秒级响应

8.2 效果评估

|---------|-------|-------|-------|

| 指标 | 实施前 | 实施后 | 提升幅度 |

| 平均查询时间 | 15分钟 | 30秒 | 96.7% |

| 知识查找准确率 | 65% | 89% | 36.9% |

| 员工满意度 | 3.2/5 | 4.6/5 | 43.8% |

| 重复问题比例 | 45% | 12% | 73.3% |

9. 未来发展趋势

9.1 技术演进路线

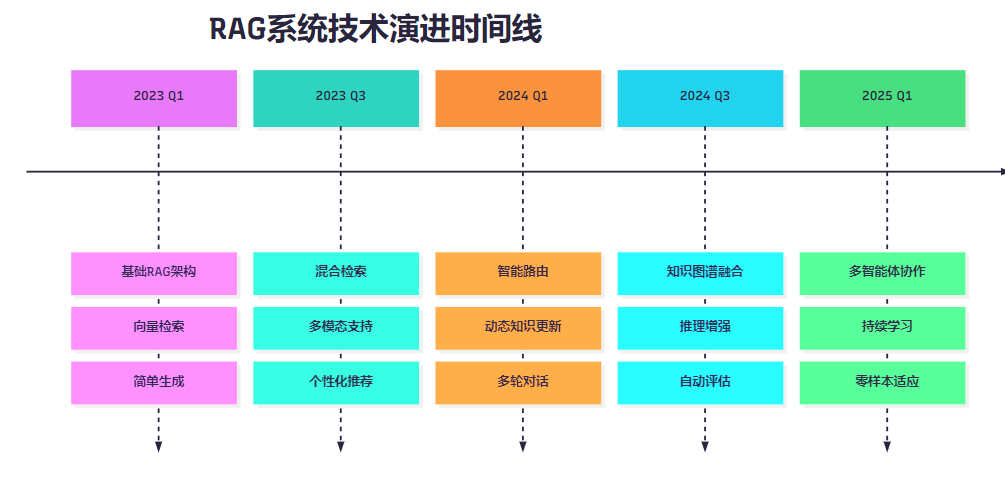

图7:RAG系统技术演进时间线

9.2 发展方向预测

- 多模态融合:支持图像、音频、视频等多种数据类型

- 知识图谱增强:结合结构化知识提升推理能力

- 个性化定制:基于用户行为的个性化知识服务

- 实时学习:支持知识的实时更新和增量学习

10. 最佳实践总结

基于多个项目的实战经验,我总结出以下最佳实践:

10.1 架构设计原则

- 模块化设计:各组件松耦合,便于独立升级

- 水平扩展:支持根据负载动态扩容

- 容错机制:单点故障不影响整体服务

- 监控完善:全链路监控,快速定位问题

10.2 数据管理策略

- 数据质量优先:宁缺毋滥,确保数据准确性

- 版本控制:建立完善的数据版本管理机制

- 权限分级:根据数据敏感度设置访问权限

- 定期清理:及时清理过期和无效数据

10.3 用户体验优化

- 响应速度:核心查询控制在3秒内

- 结果相关性:持续优化检索和排序算法

- 界面友好:提供直观的交互界面

- 反馈机制:收集用户反馈持续改进

总结

回顾这两年来在企业级RAG系统建设中的探索历程,我深深感受到这项技术对企业知识管理带来的革命性变化。从最初的技术验证到规模化部署,从单一场景应用到全企业推广,每一步都充满了挑战与收获。

RAG系统的成功落地绝不仅仅是技术问题,它涉及到组织架构、业务流程、用户习惯等多个层面的变革。作为技术人员,我们需要站在更高的视角,统筹考虑技术可行性、业务价值、用户体验等多重因素。

在技术实现层面,我们看到了从简单的向量检索到复杂的多模态融合,从静态知识库到动态学习系统的演进。每一次技术升级都带来了用户体验的显著提升,也为企业创造了更大的价值。

在项目管理层面,我深刻体会到跨部门协作的重要性。RAG系统的建设需要IT部门、业务部门、数据管理部门等多方协同,只有形成合力才能确保项目的成功。

展望未来,我相信RAG技术还将继续演进,多智能体协作、持续学习、零样本适应等新特性将进一步提升系统的智能化水平。同时,随着大模型技术的不断发展,RAG系统也将变得更加强大和易用。

对于正在或即将开展RAG系统建设的团队,我的建议是:从小规模试点开始,逐步积累经验;重视数据质量,这是系统成功的基础;关注用户反馈,持续优化用户体验;建立完善的监控体系,确保系统稳定运行。

技术的价值在于解决实际问题,创造真正的价值。RAG系统作为连接人工智能与企业知识的桥梁,必将在未来的数字化转型中发挥更加重要的作用。让我们一起在这个充满机遇的领域中,继续探索、创新,为企业的智能化发展贡献自己的力量。

我是摘星!如果这篇文章在你的技术成长路上留下了印记

👁️ 【关注】与我一起探索技术的无限可能,见证每一次突破

👍 【点赞】为优质技术内容点亮明灯,传递知识的力量

🔖 【收藏】将精华内容珍藏,随时回顾技术要点

💬 【评论】分享你的独特见解,让思维碰撞出智慧火花

🗳️ 【投票】用你的选择为技术社区贡献一份力量

技术路漫漫,让我们携手前行,在代码的世界里摘取属于程序员的那片星辰大海!

参考链接

关键词标签

RAG系统 企业知识管理 向量检索 大语言模型 智能问答