CV领域小模型发展

自2012年AlexNet在ImageNet大规模视觉识别挑战赛(ILSVRC)中以显著优势夺冠以来,计算机视觉(CV)领域进入了深度学习驱动的新纪元。AlexNet首次大规模使用卷积神经网络(CNN)进行图像分类,其成功标志着传统手工特征方法的终结,开启了基于数据驱动的深度模型时代。

随后几年,小模型在结构设计上不断优化,追求更高的精度与更低的计算成本。2014年,牛津大学提出的VGG网络通过堆叠3×3小卷积核实现了更深的网络结构,提升了分类性能;同年,Google提出的Inception结构引入多尺度卷积并行处理,显著提高了参数利用效率。

2015年,微软提出的ResNet(残差网络)通过"跳跃连接"解决了深层网络中的梯度消失问题,使得网络可以扩展到上百层,并在ImageNet上取得了超越人类水平的分类准确率。这一突破推动了小模型向更深、更高效的方向演进。

进入2016---2018年,轻量化模型成为研究热点。SqueezeNet证明了在保持精度的同时大幅压缩模型体积的可能性;MobileNet系列(v1/v2/v3)采用深度可分离卷积,在移动端实现了高效的图像分类和目标检测;ShuffleNet则通过通道混洗机制提升轻量模型的表达能力,广泛应用于边缘设备。

在目标检测方面,从Faster R-CNN到SSD,再到YOLO系列(尤其是YOLOv3、v4、v5),小模型逐步实现了从高精度到实时性的跨越。YOLOv5和YOLOv8等版本不仅精度高,且推理速度快,适合部署在摄像头、无人机、机器人等资源受限设备上。

分割任务中,FCN、U-Net、DeepLab系列也不断优化,出现了如BiSeNet、Fast-SCNN等专为实时语义分割设计的小模型,广泛应用于自动驾驶、工业质检等场景。

总体来看,2012---2022年间,CV领域的小模型经历了从"追求精度"到"兼顾效率"的转变,形成了分类、检测、分割三大任务下的成熟轻量级模型体系,为后续边缘智能和实时视频分析奠定了基础。

CV领域小模型瓶颈

尽管小模型在效率和部署便捷性方面表现优异,但在复杂真实场景下的视频分析任务中仍面临诸多挑战:

(1)环境敏感性强

小模型通常依赖于训练数据分布,在光照变化剧烈(如夜间、逆光、雾霾)、天气恶劣或动态背景干扰下,检测与识别性能显著下降。例如,白天表现良好的行人检测模型在夜间可能漏检率上升30%以上。

(2)泛化能力有限

小模型多为单任务专用模型(如仅做人脸识别或车辆检测),对未知类别或新出现的目标类型缺乏识别能力。例如,传统YOLO模型无法识别训练集中未包含的新物体(如新型电动车、特殊工程车辆)。

(3)上下文理解缺失

小模型多基于局部像素信息进行判断,缺乏对场景语义、时空上下文的理解。例如,在拥挤人群中难以区分"正常行走"与"异常聚集",也无法判断某人是否在"徘徊"或"丢弃物品"。

(4)鲁棒性不足

面对遮挡、尺度变化、姿态变化等情况,小模型容易产生误检或漏检。例如,部分遮挡的目标检测准确率可能下降50%以上。

这些局限性使得仅依赖小模型难以满足高安全要求的视频分析场景(如安防监控、交通管理、工业安全)中对准确性、鲁棒性和语义理解的综合需求。

大模型(多模态)优劣势

2022年底OpenAI发布的GPT3.5迅速掀起了全球大模型浪潮,与此同时(2022年前后)以CLIP、Flamingo、BLIP、Qwen-VL、InternVL等为代表的多模态大模型迅速崛起,成为提升视觉理解能力的重要技术路径。

优势:

(1)强大的语义理解能力

大模型通过海量图文对预训练,具备跨模态对齐能力,能理解图像内容与自然语言之间的深层关联。例如,给定查询"一个穿红衣服的人正在翻越护栏",大模型可直接从视频帧中定位并判断该行为是否存在。

(2)零样本/少样本识别能力强

得益于大规模预训练,大模型无需微调即可识别数千类未见过的对象或行为,极大提升了系统灵活性。例如,CLIP可在不重新训练的情况下识别"外卖电动车""共享滑板车"等新兴目标。

(3)上下文与推理能力突出

大模型能结合时间序列、空间关系和语言指令进行逻辑推理。例如,判断"一个人将包留在车站后离开"是否构成可疑遗留物,需结合动作、时间、位置等多维信息。

(4)统一架构支持多任务

一个大模型可同时完成分类、检测、描述生成、问答等多种任务,减少系统复杂度。

劣势:

(1)计算资源消耗巨大

典型多模态大模型参数量达数十亿甚至上百亿,单次推理需高性能GPU(如A100/H100),功耗高、成本大,难以部署在边缘设备。

(2)推理延迟高,难以满足实时性要求

大模型前向推理耗时通常在百毫秒级以上,无法满足视频流每秒30帧的实时分析需求,尤其在高并发场景下性能瓶颈明显。

(3)训练与微调门槛极高

训练大模型需要PB级数据、千卡级算力集群和专业团队,中小企业难以独立完成。

(4)存在"幻觉"风险

大模型可能生成不符合事实的描述或误判,尤其在低质量图像或模糊场景中。

因此,尽管大模型在准确性与智能性上远超小模型,但其高资源消耗与低实时性限制了其在实际视频分析系统中的直接广泛应用。

大小模型联合应用方式

为兼顾效率与智能,"小模型+大模型"协同推理架构逐渐成为视频分析领域的主流解决方案。其核心思想是:由小模型负责高效初筛,大模型负责精准复核与语义理解,实现性能与成本的最优平衡。

常见的联合应用方式包括:

(1)两级级联推理架构

第一级:小模型快速过滤

使用轻量级模型(如YOLOv8、MobileNet-SSD)对视频流进行实时目标检测与初步分类,筛选出感兴趣区域(ROI)或异常事件候选帧。

第二级:大模型精细分析

将候选帧送入多模态大模型(如Qwen-VL、InternVL)进行深度语义解析、行为理解或自然语言问答,确认事件真实性与具体含义。

示例:在地铁监控中,小模型检测到"有人倒地",触发告警;大模型结合上下文(是否有人搀扶、是否有打斗前兆)判断是否为真实跌倒事件,避免误报。

(2)主动学习与增量更新机制

小模型在运行中遇到置信度低或无法识别的样本时,自动提交给大模型进行标注;

大模型输出结果作为"伪标签",用于后续小模型的在线微调或增量训练,形成闭环优化。

(3)知识蒸馏(Knowledge Distillation)

利用大模型作为"教师模型",指导小模型("学生模型")学习其输出分布或中间特征表示;

在保持小模型轻量化的同时,提升其语义理解能力。

(4)任务分工协作

小模型负责结构化任务(如人脸检测、车牌识别、人数统计);

大模型负责非结构化任务(如事件描述、意图推断、开放域问答);

两者通过中间接口(如消息队列、API服务)协同工作。

这种"分工明确、各司其职"的架构既能发挥小模型的实时性优势,又能调用大模型的智能决策能力。

大小模型联合应用案例

近年来,多个行业已成功落地大小模型协同的视频分析系统,取得了显著成效。以下是几个典型案例:

案例一:智慧安防中的异常行为识别(某一线城市地铁系统)

背景:地铁站每日客流量超百万人次,需实时监测跌倒、打架、滞留、逆行等异常行为。

方案:

- 前端摄像头部署YOLOv8 + DeepSort进行实时人体检测与轨迹跟踪;

2.当检测到异常轨迹(如突然倒地、长时间静止)时,截取前后5秒视频片段;

3.视频片段上传至云端大模型(基于Qwen-VL定制)进行语义分析:"此人是否受伤?""是否有同伴施救?""是否为醉酒?"

效果:

1.异常事件识别准确率从72%提升至94%;

2.误报率下降60%,显著减轻人工复核压力;

3.平均每路视频日均仅触发3~5次大模型调用,算力成本可控。

案例二:工业园区安全监管(某化工企业)

背景:需检测工人是否佩戴安全帽、是否进入禁区、是否存在违规操作。

方案:

1.边缘设备部署轻量分割模型(BiSeNet)实时检测人员与装备;

2.若检测到"未戴安全帽"或"进入高危区",则触发告警;

3.告警帧送入本地部署的裁剪版CLIP模型进行二次验证,排除误检(如头盔反光、阴影遮挡);

4.支持自然语言查询:"今天有几个没戴安全帽的人进入了反应车间?"

效果:

1.安全违规识别准确率达96.5%;

2.实现零云依赖本地闭环处理,满足数据安全要求;

3.支持开放语义查询,提升管理人员交互体验。

案例三:零售门店顾客行为分析(连锁便利店)

背景:需分析顾客动线、热区分布、商品关注度,优化陈列。

方案:

1.小模型(MobileNet-SSD)实时检测顾客位置与动作(拿取、放下、停留);

2.每分钟汇总一次结构化数据(如某货架前停留人数);

3.每小时将汇总数据与关键帧发送至大模型(BLIP-2)生成可视化报告:"今日最受欢迎商品是矿泉水,主要购买时段为12:00--13:00";

4.支持语音提问:"昨天下午谁偷拿了商品?" → 大模型结合轨迹与动作分析可疑行为。

效果:

1.数据分析自动化程度提升80%;

2.店长可通过自然语言快速获取洞察,决策效率提高;

3.大模型调用频率低,整体系统稳定高效。

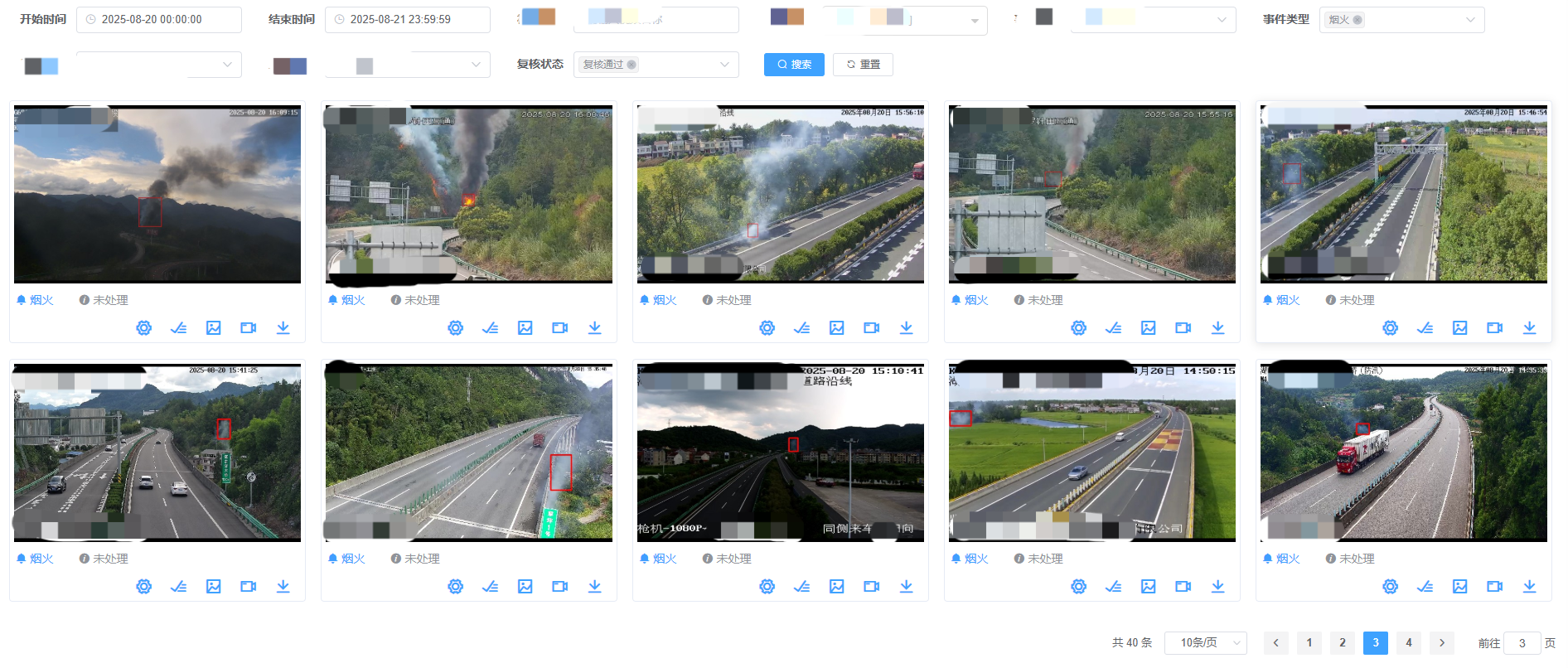

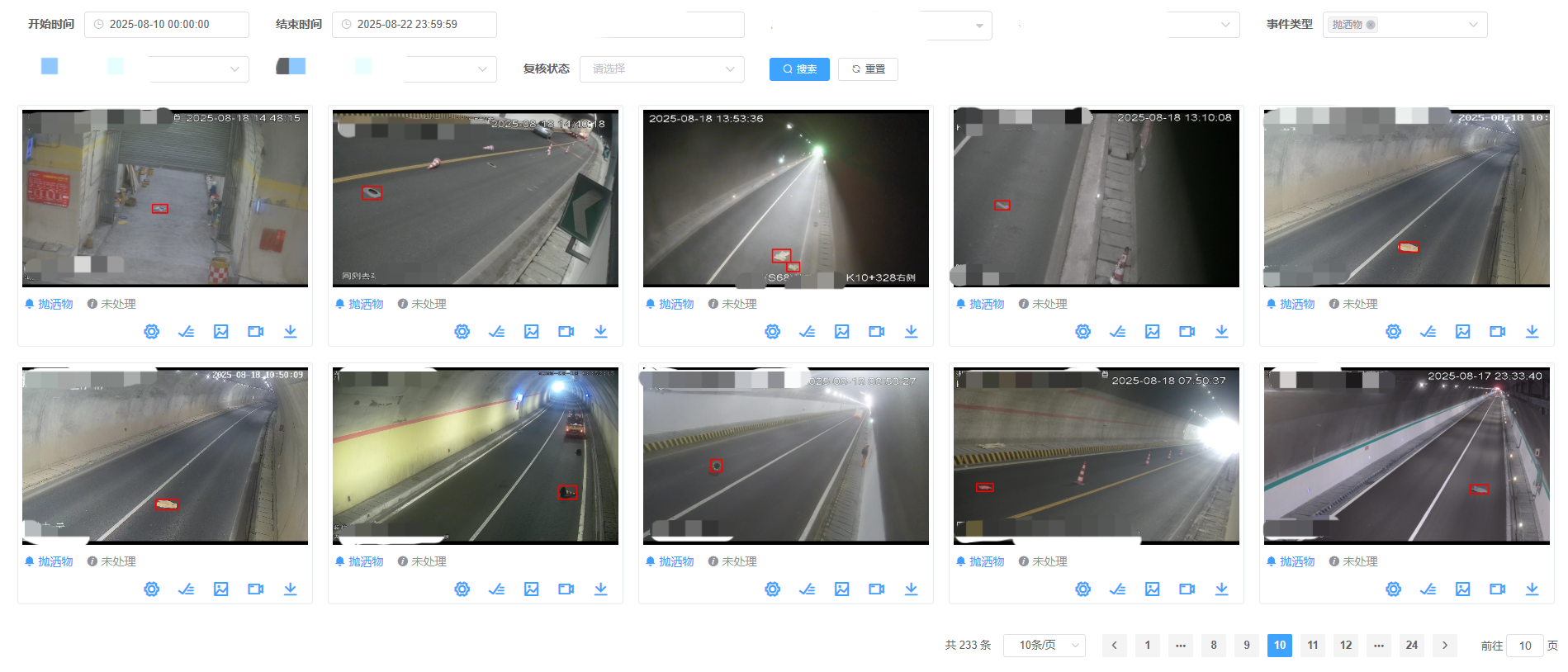

大小模型联合应用效果

某省高速监控视频分析系统累计接入视频路数超过2万路,针对部分传统AI小模型识别难度极大并影响道路安全的突发异常事件(汽车自燃、烟雾、抛洒物、边坡塌方),在引入多模态大模型之后,整体识别效果提升明显。下面是烟雾和道路抛洒物的识别案例(2万路视频样本基数下,准确率趋近99%):

(右键->新标签打开图片查看原图)

结语

大小模型的联合应用正在重塑视频分析的技术范式。小模型以其高效、低延迟的特点承担"哨兵"角色,实现全天候实时监控;大模型则作为"大脑",提供深层次语义理解与智能决策支持。二者协同,既避免了大模型的算力黑洞,又弥补了小模型的认知局限。未来,随着大模型轻量化技术(如MoE架构、量化压缩)、边缘计算能力提升以及多模态推理框架的成熟,大小模型融合将更加紧密,向"端-边-云"一体化智能视频分析系统演进,广泛应用于智慧城市、自动驾驶、工业互联网等领域,真正实现"看得清、看得懂、反应快"的智能视觉感知体系。

更多内容参见VideoPipe视频分析框架。