链接:https://github.com/yunlong10/Awesome-LLMs-for-Video-Understanding

docs:Vid-LLM

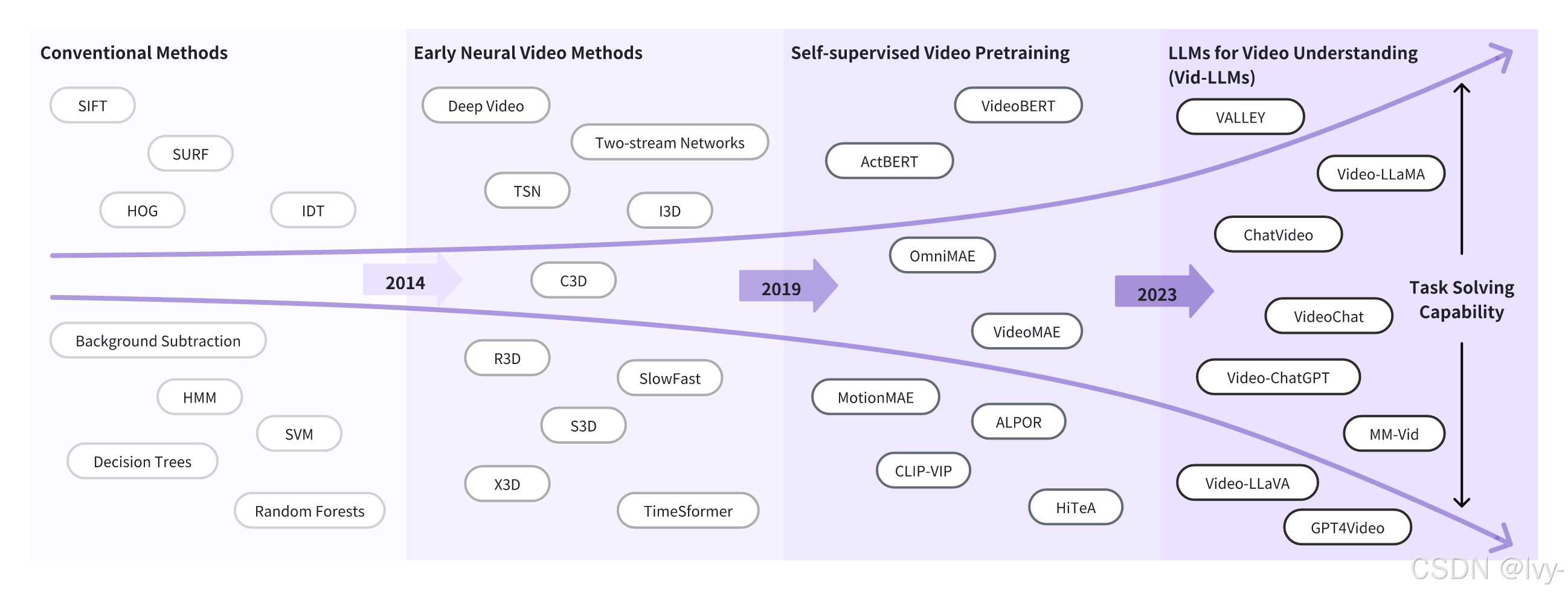

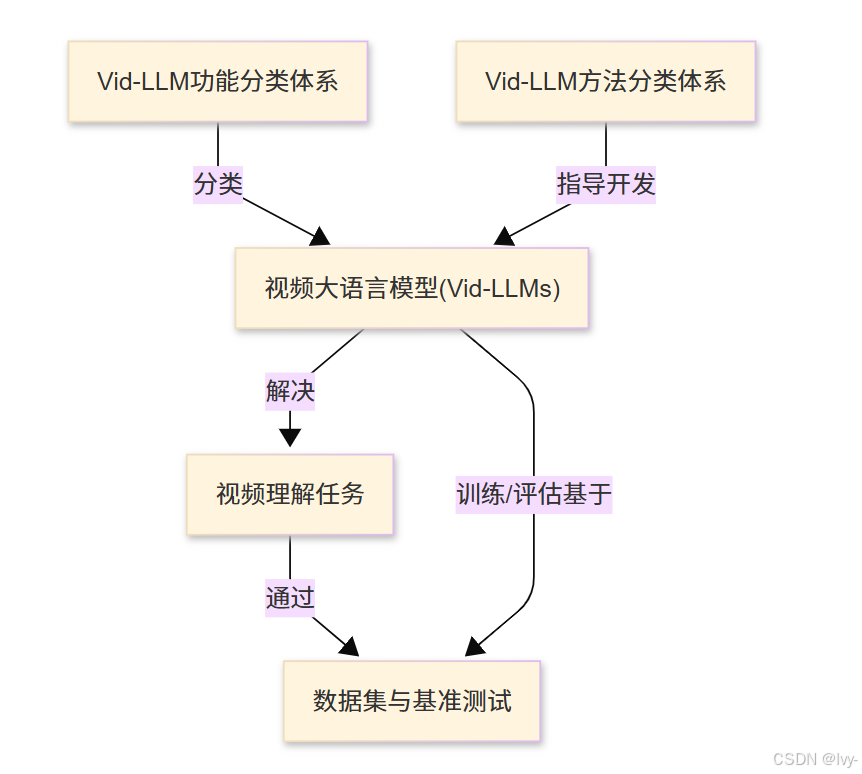

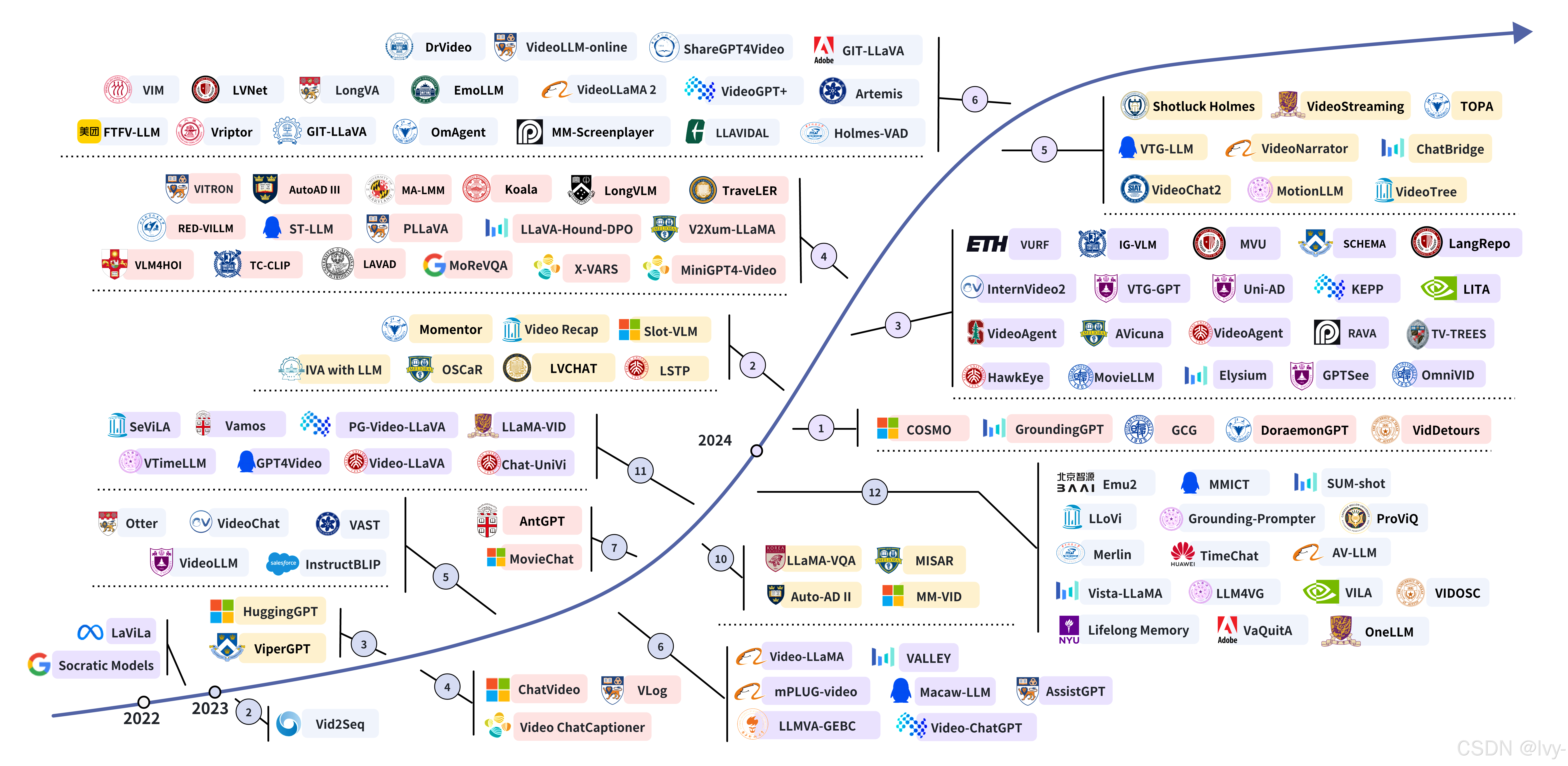

本项目是关于视频大语言模型(Vid-LLMs)的全面综述与精选列表。

探讨了这些智能系统如何处理和理解视频内容,详细介绍了它们多样的架构与训练方法 、旨在完成的特定任务 ,以及用于开发和评估的数据集与基准测试。

可视化

章节列表

Why we need Vid-LLMs?

Vid-LLMs: Models

本文将介绍视频大语言模型(Vid-LLMs)及其应用。

Vid-LLMs通过结合视觉处理和语言理解能力,使AI能够"观看"视频并回答相关问题

-

文章概述了Vid-LLMs的工作原理:将视频分解为关键信息,转化为语言模型可理解的表征,再结合问题生成回答。

-

重点介绍了Vid-LLMs的核心优势和多模态交互能力,并通过烹饪视频示例展示了其问答功能。

-

最后简要提及了视频理解任务分类,包括识别当前内容和预测未来事件等应用场景。

该项目提供了Vid-LLMs的全面技术资料和资源列表。

第1章:视频大语言模型(Vid-LLMs)

是否曾观看视频时,希望能像询问知识渊博的朋友那样直接向视频提问?想象观看烹饪教程时立即知道"主要食材有哪些?",或是看到体育精彩片段时询问"谁进的球?"

这听起来像科幻情节,但得益于视频大语言模型(Vid-LLMs),这正在成为现实~

Vid-LLMs解决什么问题?

我们已经拥有**大语言模型(LLMs)**这类神奇工具,如ChatGPT。

它们是能理解和生成类人文本的智能助手,可以创作故事、回答问题甚至协助编程。

但普通LLM仅能理解文本。对于视频中的视觉和听觉信息,它既"看不见"也"听不到"。这是重大局限,因为世界上大量信息以视频形式存在------从社交媒体片段到教学讲座和安防录像。

Vid-LLMs正是为此而生 。它们赋予LLM"观看"和真正理解视频的能力,将其升级为能同时理解人类语言和动态视频世界的超级智能助手。

Vid-LLMs究竟是什么?

Vid-LLMs是经过升级、具备视频处理与推理能力的大语言模型。

通俗理解:

- 普通LLM如同只会读写的高智商人士

- Vid-LLM则是同一位智者,但获得了眼睛和耳朵,可以看电视了!它能接收视频中的所有视觉信息(发生的事件、场景人物、出现物体)和听觉信息(声音、语音)

这意味着Vid-LLMs能实现:

- 回答关于视频内容的提问

- 总结长视频的关键事件或主题

- 甚至根据观察采取行动或给出指导

它们为视频分析带来类人理解能力,让我们能用自然语言与视频交互。

Vid-LLMs工作原理(简化版)

要让LLM"看见"视频,需将复杂的视听信息转换为LLM能理解的格式:

- 视频分解 :视频是随时间变化的图像序列(

帧),通常伴有声音 - 关键信息提取 :专用"视频理解组件"(

智能视觉和音频处理器)分析这些帧和声音,识别物体、动作、场景和语音 - 语言化转换:提取的视频信息被转化为"类语言"表征,虽非原始文本但能让LLM与人类语言协同处理

- 语言模型接管 :组合信息(您的文本问题+视频"类语言"表征)输入LLM,

由其强大的语言理解能力关联信息并生成相关回答

应用场景实例

回到烹饪节目例子:

场景:有一段厨师做菜的教程视频,您想知道:"这个食谱使用的主要食材是什么?"

Vid-LLM可以帮忙

输入Vid-LLM:

- 视频文件(如

cooking_tutorial.mp4) - 自然语言问题:"这个食谱使用的主要食材是什么?"

虽然实际Vid-LLM代码非常复杂,但我们可以模拟其使用方式:

python

# 此为概念示例,非本项目实际可运行代码

# 展示如何与Vid-LLM交互

class VidLLMModel:

def __init__(self):

# 真实Vid-LLM会加载大型模型

print("视频大语言模型助手已就绪!")

def ask_about_video(self, video_path: str, question: str) -> str:

# 内部进行视频处理和问题解答

print(f"正在处理视频:{video_path}")

print(f"解析问题:'{question}'")

# ...此处进行复杂的视频分析和语言推理...

# 基于视频分析的模拟输出

if "ingredients" in question.lower() and "cooking_tutorial.mp4" in video_path:

return "根据视频分析,主要食材有面粉、鸡蛋、糖、牛奶和巧克力豆。"

elif "goal" in question.lower():

return "视频显示10号球员在比赛0:45时进球。"

else:

return "需要更多视频细节才能确定。"

# 初始化Vid-LLM助手

my_vid_llm = VidLLMModel()

# 询问烹饪视频

video_file = "cooking_tutorial.mp4" # 视频文件路径

question_text = "这个食谱使用的主要食材是什么?"

answer = my_vid_llm.ask_about_video(video_file, question_text)

print(f"\nVid-LLM回答:{answer}")输出:

视频大语言模型助手已就绪!

正在处理视频:cooking_tutorial.mp4

解析问题:'这个食谱使用的主要食材是什么?'

Vid-LLM回答:根据视频分析,主要食材有面粉、鸡蛋、糖、牛奶和巧克力豆。此例中,VidLLMModel会"观看"烹饪教程视频,识别动作和物体(如混合食材),理解问题后给出详细回答,就像有位智能朋友陪您看视频并讲解内容!

原理浅析

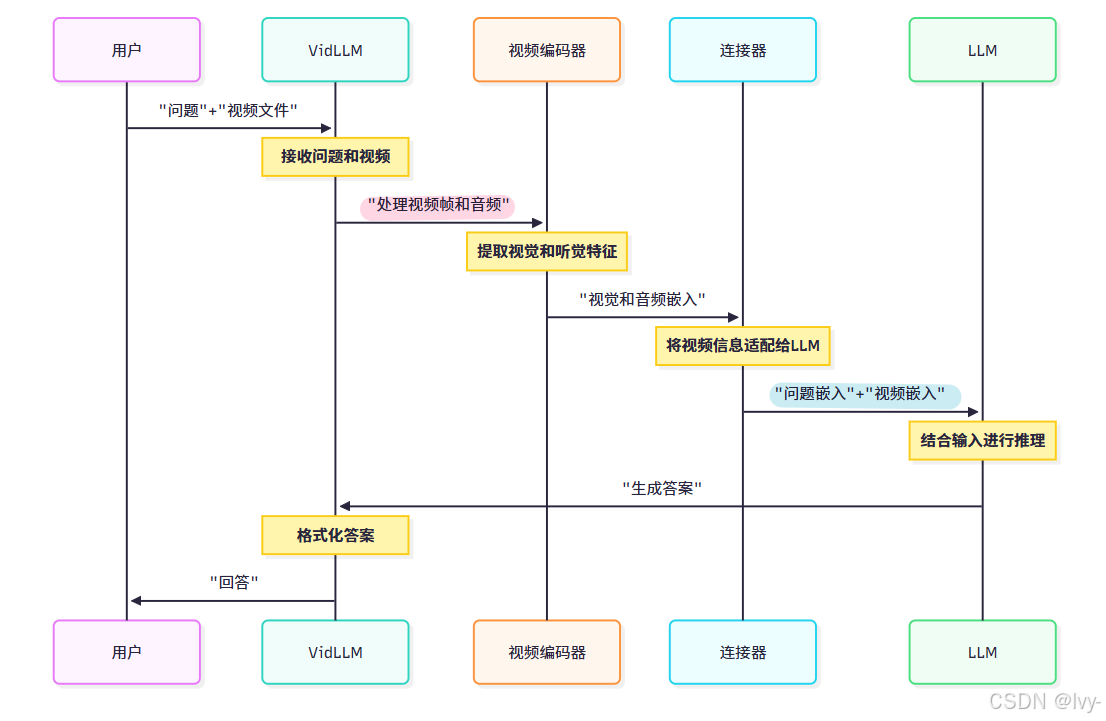

Vid-LLM如何处理视频并关联问题?通过序列图简化说明:

流程解析:

- 用户:提出问题和提供视频

- Vid-LLM:总体协调系统

- 视频编码器:Vid-LLM的"眼睛和耳朵",处理原始视频(像素和声波),提取表征视频内容的"特征"或"嵌入"(数值化表示)

- 连接器:对齐视频嵌入和语言模型能理解的文本嵌入,充当桥梁

- LLM:实际推理的大脑,结合问题和视频信息生成连贯回答

Vid-LLMs核心优势

结合两大领域的优势:

| 特性 | 优势 |

|---|---|

| 多模态理解 | 能处理和理解视频(视觉+听觉)与文本的多源信息 |

| 上下文推理 | 可在动态视频语境中推理事件、物体和动作 |

| 自然语言交互 | 让用户用日常语言与视频互动,简化复杂任务 |

| 多功能任务 | 能执行从摘要生成到问答和内容创作等广泛任务 |

结语

本章介绍了激动人心的视频大语言模型(Vid-LLMs)世界。我们了解到它们是能"观看"、"聆听"和"理解"视频的先进AI模型,弥合了动态视觉内容与强大语言推理间的鸿沟。

这项能力开启了用自然语言与视频信息交互并提取洞察的新纪元。

现在您已了解Vid-LLMs的基础知识,让我们继续探索它们能解决的具体问题和应用场景。

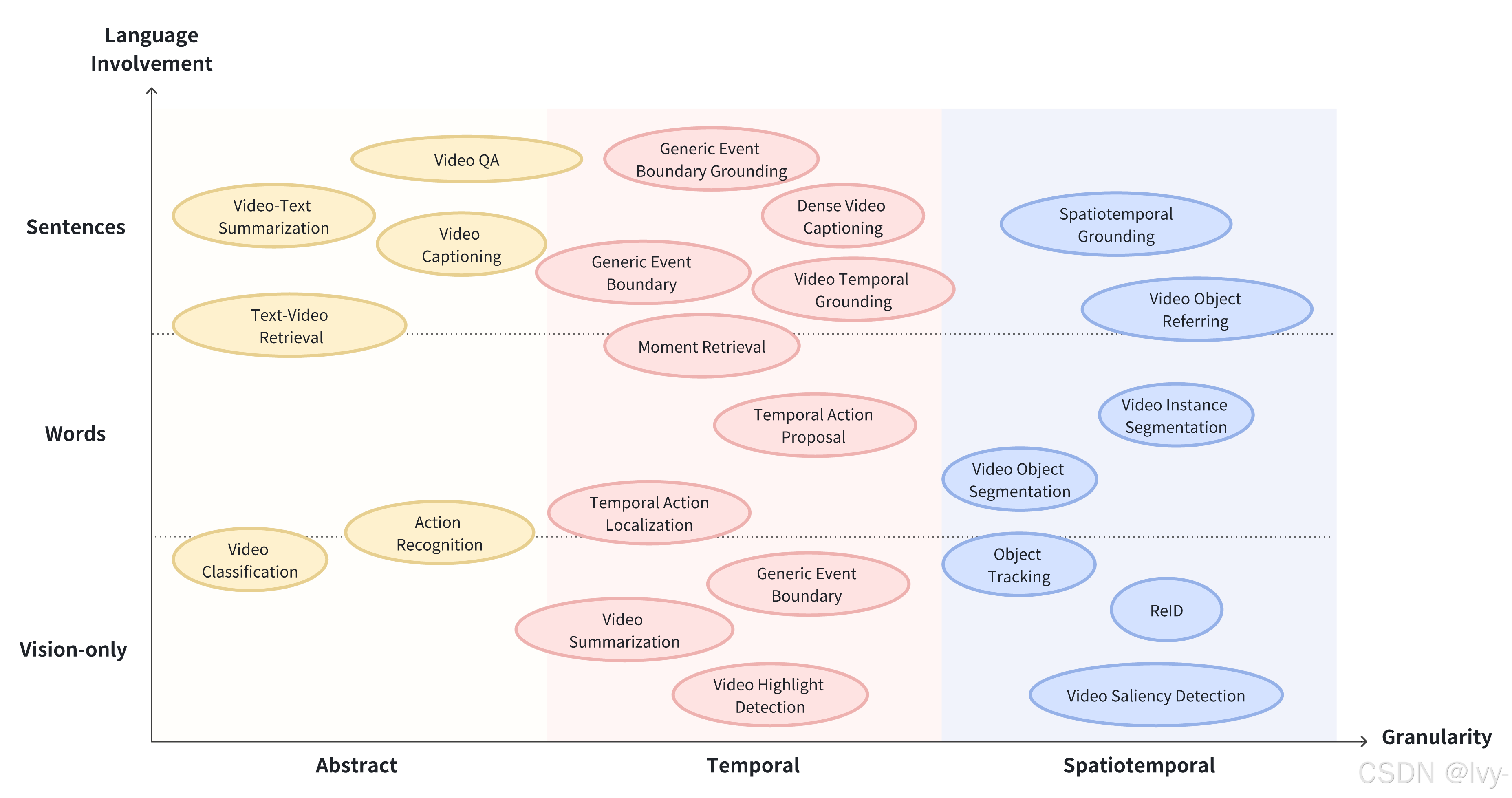

第2章:视频理解任务

在前一章中,我们介绍了视频大语言模型(Vid-LLMs)------这种神奇的AI助手能够像知识渊博的朋友一样"观看"、"聆听"和"理解"视频内容,弥合了动态视觉内容与强大语言推理之间的鸿沟。

但当Vid-LLM具备"视觉"和"听觉"能力后,我们究竟能让它完成哪些具体任务?这些智能系统被设计来解决什么问题?

什么是视频理解任务?

视频理解任务是指Vid-LLMs经过训练后能够应对的具体挑战、问题或疑问。

它们是Vid-LLM用来展示其视频理解能力的各种"测试"。

假设我们拥有数小时的监控录像、冗长的教学讲座或家庭视频集锦。我们不会简单地要求Vid-LLM"理解这个视频",而是会设定具体目标:"找出我的狗什么时候开始吠叫"、"总结这个讲座的要点"或"告诉我视频里我的孩子在搭建什么"。

这些具体目标就是我们所说的视频理解任务。让我们详细解析其中最常见和最重要的几类:

1. 识别:发生了什么?

描述:这项任务涉及识别并标注视频中出现的物体、动作和事件。就像一位细致的观察者,详尽列出所见的所有细节。

类比:想象正在观看一个繁忙的街景。执行"识别"任务的Vid-LLM会告诉你:"有一辆红色汽车驶过,一个人在遛狗,还有一个街头小贩在卖椒盐卷饼。"

概念性输入与输出:

- 输入Vid-LLM:视频片段和通用问题,如"画面中有哪些物体?"或"正在发生什么动作?"

- 预期输出 :检测到的物体列表(如"

汽车"、"行人"、"狗"、"树")或动作列表(如"驾驶"、"行走"、"奔跑"、"交谈")

2. 预测:接下来会发生什么?

描述:这项任务需要根据视频已发生的内容预测未来事件或动作。要求Vid-LLM理解事件模式和逻辑序列。

类比:如果看到有人拿起棒球棒站在本垒板旁,我们可能预测他即将挥棒。Vid-LLM对视频内容进行类似的预测。

概念性输入与输出:

- 输入Vid-LLM:展示当前情境的视频片段和问题,如"这个人接下来会做什么?"或"可能会发生什么后续事件?"

- 预期输出 :对未来动作或事件的预测(如"

这个人可能会往锅里倒水"或"汽车很可能在十字路口左转")

3. 描述与字幕生成:描述这个视频

描述:这项任务专注于生成类人的叙述性文本,用于总结或描述视频内容。输出范围可以从简洁的短字幕到详细的事件段落描述。

类比:想象纪录片旁白或新闻视频的文字记者。Vid-LLM扮演这个叙述者角色,根据画面和声音创作故事。

概念性输入与输出:

- 输入Vid-LLM:视频文件和请求,如"详细描述这个视频"或"为这个片段生成简短字幕"

- 预期输出:描述视频内容的自然语言句子或段落(如"一只金毛寻回犬在郁郁葱葱的公园里欢快地玩接球游戏,捡回主人抛出的红色球"或"视频展示了从混合原料、揉面到最终烘焙的面包制作分步教程")

4. 定位与检索:找到那个瞬间!

描述:这项任务是在视频中查找与给定文本查询匹配的特定时刻或片段。就像拥有一个能在视频内部工作的超级搜索引擎。

类比:想在电影中找到某个角色说特定台词的精确场景。通过描述查找内容,定位与检索功能可以实现这一点。

概念性输入与输出:

- 输入Vid-LLM:视频文件和文本查询,如"展示厨师加盐的时刻"或"找出所有出现蓝色汽车的片段"

- 预期输出 :精确时间戳(如"0:45-0:48")或指向特定视频片段的链接

5. 问答:关于X在Y中的情况?

描述:这是最复杂的任务之一,Vid-LLM需要回答关于视频内容的详细且复杂的问题,要求对事件、物体及其随时间变化的关系进行深度推理和理解。

类比:就像拥有一位真正博学的朋友,他不仅知道"发生了什么",还能回答"为什么会发生"或"两个事件之间的关系是什么"。

概念性输入与输出:

- 输入Vid-LLM:视频文件和复杂问题(如"为什么这个人选择那种特定木材做项目?"或"运动员在最后阶段面临的主要挑战是什么?")

- 预期输出 :基于视频内容的

综合性自然语言回答(如"这个人选择那种木材是因为它以防腐和耐潮湿著称,这对户外家具很重要"或"运动员在最后一英里遭遇强逆风,导致速度略有下降")

视频理解任务总结

以下是讨论任务的快速概览:

| 任务类别 | 功能描述 | 示例交互 |

|---|---|---|

| 识别 | 识别视频中的物体、动作和事件 | "狗在做什么?" -> "狗在接球" |

| 预测 | 根据当前视频事件预测后续发展 | "这个人接下来会烹饪什么?" -> "可能会切菜" |

| 描述与字幕生成 | 生成视频内容的类人文本摘要或描述 | "描述这个视频" -> "湖面日出的宁静景象" |

| 定位与检索 | 查找与文本查询匹配的特定视频片段 | "找出汽车左转的时刻" -> "发生在0:23-0:25" |

| 问答 | 回答需要视频内容推理的复杂问题 | "机器人为什么停止?" -> "检测到障碍物" |

结语

本章我们学习了Vid-LLMs设计用于应对的各种视频理解任务。

实现:识别,预测,描述与字幕生成,定位与检索,问答。

每项任务都代表了我们用自然语言与视频内容交互并提取价值的不同方式。

既然我们已经了解Vid-LLM能做什么 ,接下来让我们深入探讨它们如何被构建和组织以实现这些能力。