腾讯开源OpenTenBase深度实践:企业级分布式HTAP数据库部署全攻略

🌟 Hello,我是摘星!

🌈 在彩虹般绚烂的技术栈中,我是那个永不停歇的色彩收集者。

🦋 每一个优化都是我培育的花朵,每一个特性都是我放飞的蝴蝶。

🔬 每一次代码审查都是我的显微镜观察,每一次重构都是我的化学实验。

🎵 在编程的交响乐中,我既是指挥家也是演奏者。让我们一起,在技术的音乐厅里,奏响属于程序员的华美乐章。

目录

腾讯开源OpenTenBase深度实践:企业级分布式HTAP数据库部署全攻略

[1. OpenTenBase架构概述](#1. OpenTenBase架构概述)

[1.1 核心组件介绍](#1.1 核心组件介绍)

[1.2 分片策略对比](#1.2 分片策略对比)

[2. 环境准备与系统要求](#2. 环境准备与系统要求)

[2.1 硬件资源规划](#2.1 硬件资源规划)

[2.2 操作系统配置](#2.2 操作系统配置)

[3. OpenTenBase安装部署](#3. OpenTenBase安装部署)

[3.1 部署流程概览](#3.1 部署流程概览)

[1. 更新系统并安装依赖包](#1. 更新系统并安装依赖包)

[2. 创建专用用户](#2. 创建专用用户)

[3. 切换到opentenbase用户](#3. 切换到opentenbase用户)

[1. 获取源码](#1. 获取源码)

[2. 编译源码](#2. 编译源码)

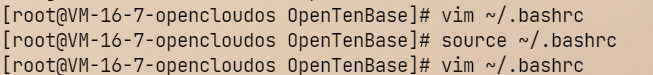

[1. 配置环境变量](#1. 配置环境变量)

[2. 创建集群配置目录](#2. 创建集群配置目录)

[3. 创建集中式配置文件](#3. 创建集中式配置文件)

[4. 部署和初始化集群](#4. 部署和初始化集群)

[5. 验证集群状态](#5. 验证集群状态)

[1. 连接数据库](#1. 连接数据库)

[2. 创建必要的节点组和分片组](#2. 创建必要的节点组和分片组)

[3. 创建数据库和表](#3. 创建数据库和表)

[1. 启动集群](#1. 启动集群)

[2. 停止集群](#2. 停止集群)

[3. 清理集群(重新初始化时使用)](#3. 清理集群(重新初始化时使用))

[1. 查看日志](#1. 查看日志)

[2. 常见问题解决](#2. 常见问题解决)

[1. 内存优化](#1. 内存优化)

[2. 连接优化](#2. 连接优化)

[3. 日志优化](#3. 日志优化)

[4. 集群节点配置](#4. 集群节点配置)

[4.1 Coordinator节点部署](#4.1 Coordinator节点部署)

[4.2 Datanode节点部署](#4.2 Datanode节点部署)

[5. 集群管理与运维](#5. 集群管理与运维)

[5.1 集群健康状态监控](#5.1 集群健康状态监控)

[5.2 性能监控查询](#5.2 性能监控查询)

[5.3 分布式表创建与分片](#5.3 分布式表创建与分片)

[6. 故障排查与优化](#6. 故障排查与优化)

[6.1 常见问题排查流程](#6.1 常见问题排查流程)

[6.2 性能优化实践](#6.2 性能优化实践)

[7. 实战经验总结](#7. 实战经验总结)

摘要

作为一名在分布式数据库领域摸爬滚打多年的技术从业者,我在最近的项目中深度实践了OpenTenBase的部署与运维工作。OpenTenBase作为腾讯开源的分布式HTAP数据库,其强大的分布式能力和对PostgreSQL的高度兼容性让我印象深刻。在实际操作过程中,我发现OpenTenBase不仅继承了PostgreSQL的稳定性和丰富的生态,更重要的是它在分布式场景下展现出了卓越的横向扩展能力。

从安装部署的角度来看,OpenTenBase的架构设计非常清晰,包含Coordinator(CN)、Datanode(DN)和Global Transaction Manager(GTM)三个核心组件。在我的实际部署过程中,最初遇到了节点间通信配置的一些小问题,但通过深入理解其架构原理,很快就解决了这些挑战。特别值得一提的是,OpenTenBase的分片策略和数据分布机制设计得相当优雅,支持Hash、Range、List等多种分片方式,能够很好地适应不同业务场景的需求。

在配置调试环节,我体验到了OpenTenBase在参数调优方面的灵活性。与传统单机数据库不同,分布式数据库的调优需要考虑更多维度的因素,包括网络延迟、数据倾斜、跨节点事务等。OpenTenBase提供了丰富的监控指标和调优参数,让我能够根据具体的业务负载特征进行精细化调优。运维监控方面,我使用了Prometheus + Grafana的监控方案,配合OpenTenBase内置的统计视图,构建了一套完整的监控体系,能够实时掌握集群的健康状态和性能表现。

1. OpenTenBase架构概述

1.1 核心组件介绍

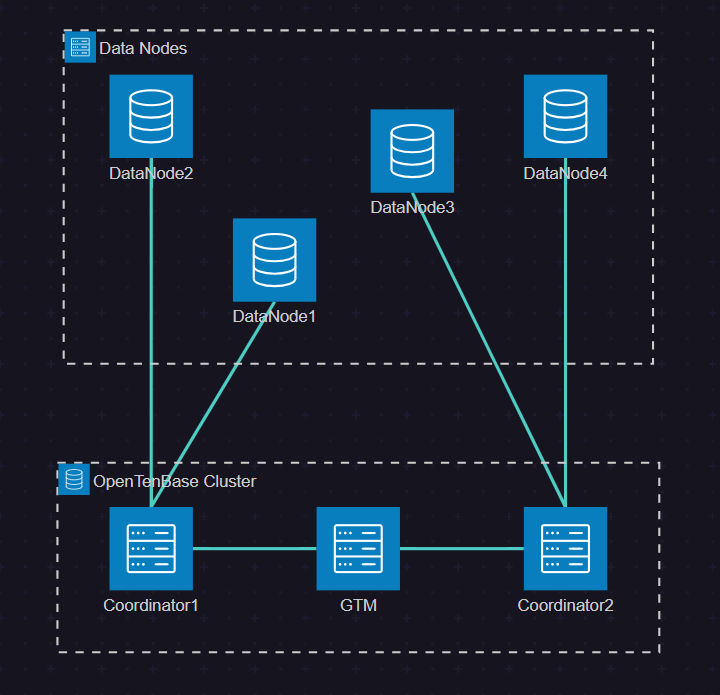

OpenTenBase采用了典型的分布式数据库架构,主要由以下三个核心组件构成:

- Coordinator (CN):协调节点,负责接收客户端请求,制定执行计划,协调分布式事务

- Datanode (DN):数据节点,负责数据存储和本地数据处理

- Global Transaction Manager (GTM):全局事务管理器,负责分布式事务的全局一致性

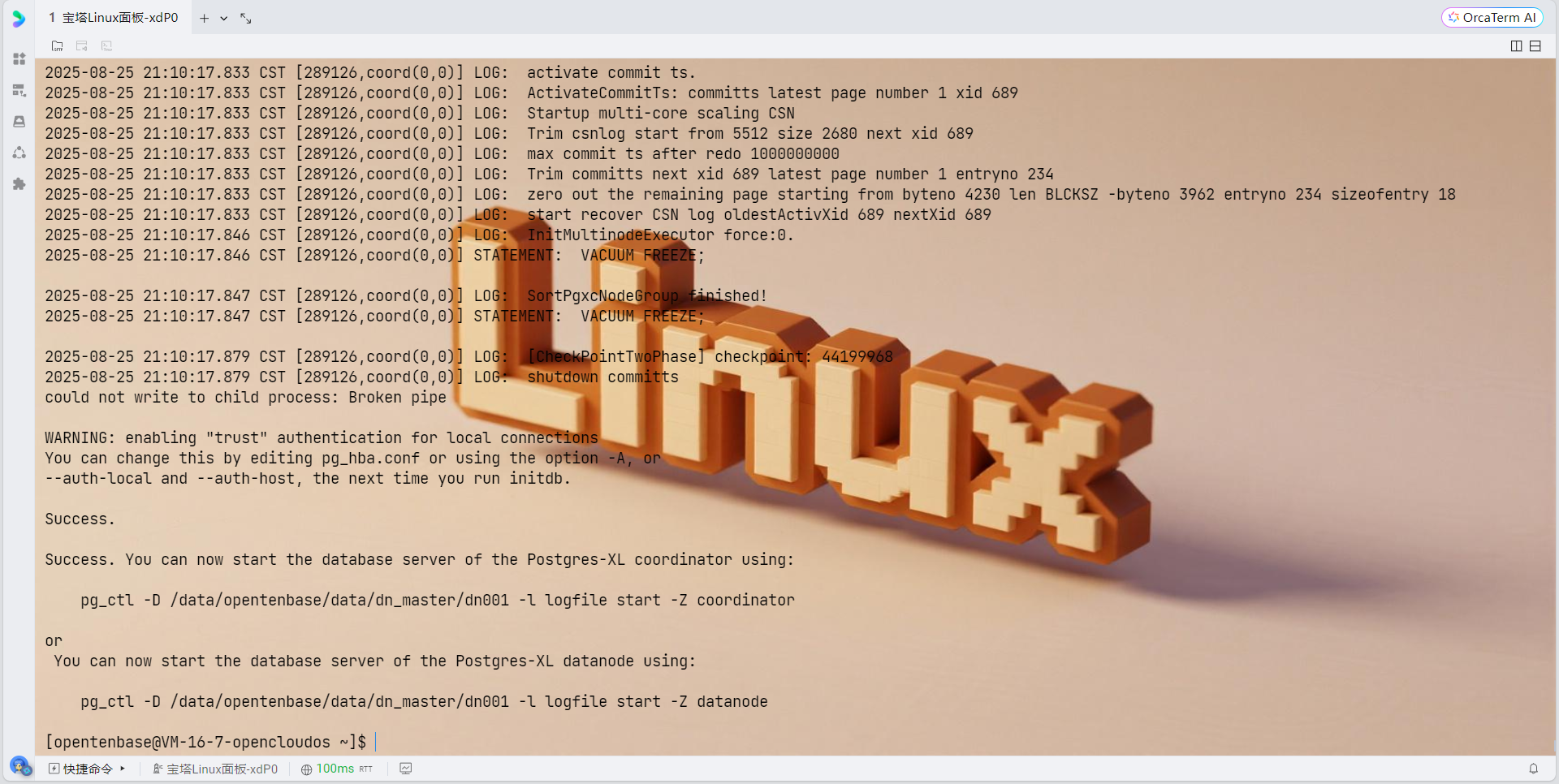

图1:OpenTenBase架构图 - 展示核心组件及其关系

1.2 分片策略对比

OpenTenBase支持多种分片策略,每种策略都有其适用场景:

|---------|-------------|---------------|----------|-------|

| 分片策略 | 适用场景 | 优势 | 劣势 | 推荐指数 |

| Hash分片 | 均匀分布的OLTP负载 | 数据分布均匀,查询性能稳定 | 范围查询性能较差 | ⭐⭐⭐⭐⭐ |

| Range分片 | 时序数据,需要范围查询 | 范围查询性能优秀 | 可能产生热点 | ⭐⭐⭐⭐ |

| List分片 | 按业务维度分片 | 业务逻辑清晰 | 维护复杂度高 | ⭐⭐⭐ |

2. 环境准备与系统要求

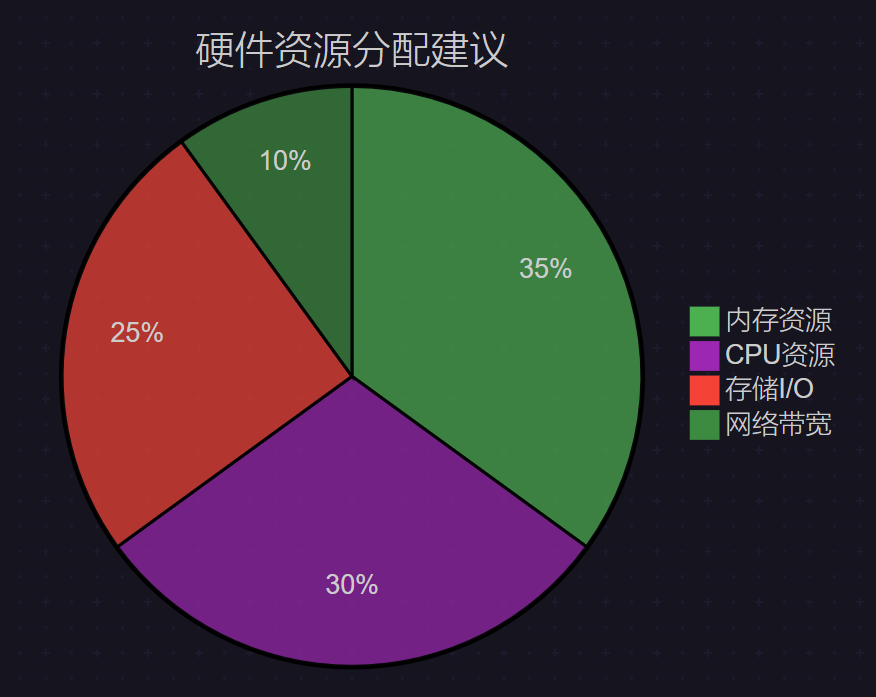

2.1 硬件资源规划

在实际部署过程中,我建议按照以下配置来规划硬件资源:

图2:硬件资源分配饼图 - 各组件资源占比建议

2.2 操作系统配置

基础系统参数优化是确保OpenTenBase稳定运行的关键:

# 系统内核参数优化

cat >> /etc/sysctl.conf << EOF

# 内存管理

vm.swappiness = 10

vm.dirty_background_ratio = 3

vm.dirty_ratio = 10

vm.overcommit_memory = 2

vm.overcommit_ratio = 90

# 网络参数

net.core.rmem_max = 134217728

net.core.wmem_max = 134217728

net.ipv4.tcp_rmem = 4096 87380 134217728

net.ipv4.tcp_wmem = 4096 65536 134217728

# 文件句柄限制

fs.file-max = 6815744

EOF

# 应用系统参数

sysctl -p关键配置说明:

vm.swappiness = 10:减少swap使用,提高数据库性能- 网络缓冲区设置:优化分布式节点间通信

- 文件句柄限制:支持高并发连接

3. OpenTenBase安装部署

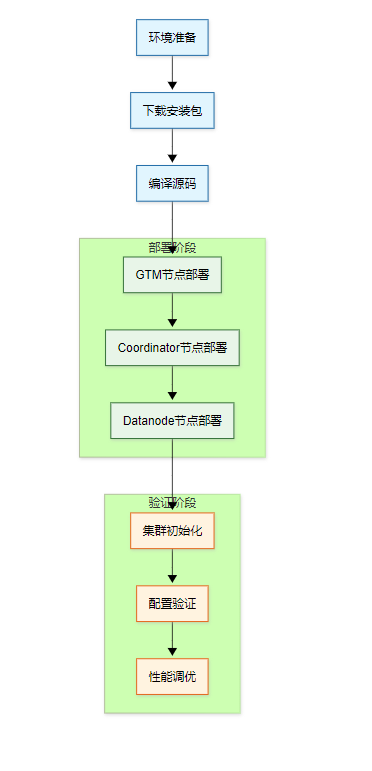

3.1 部署流程概览

图3:部署流程图 - 完整的安装部署流程

OpenTenBase简介

OpenTenBase是一个关系型数据库集群平台,提供写入可靠性和多节点数据同步功能。可以在一台或多台主机上配置OpenTenBase,并将数据存储在多个物理主机上。

OpenTenBase架构组件:

- Coordinator Node (CN):应用程序访问入口,负责数据分布和查询计划。多个节点位于同一位置,每个节点提供相同的数据库视图

- Datanode Node (DN):每个DN存储用户数据的分区。在功能上,DN节点负责完成CN分发的执行请求

- GTM Node (Global Transaction Manager):负责集群事务信息的管理,以及集群的全局对象(如序列)

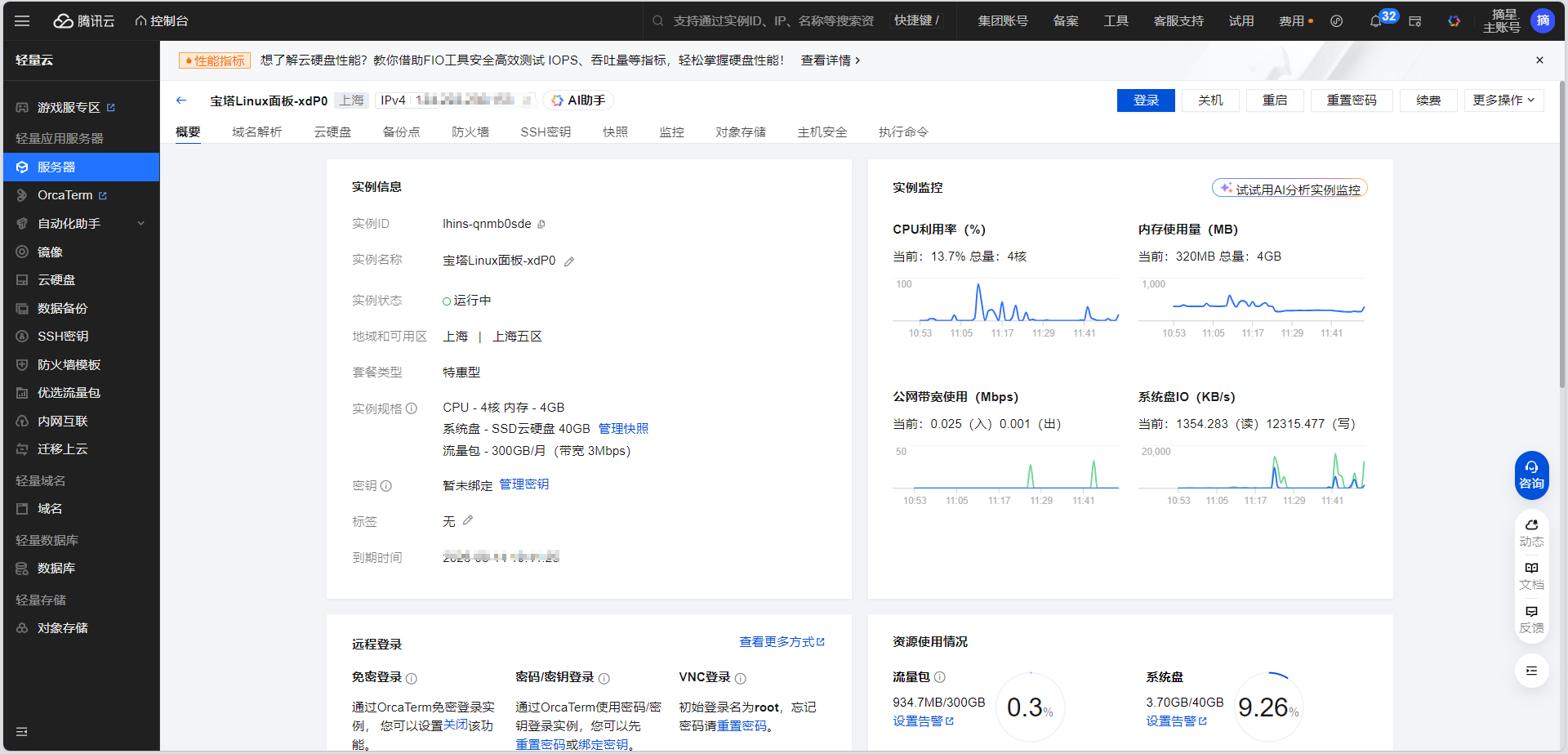

系统要求

硬件要求:

- 内存:最低4GB RAM

- 操作系统:OpenCloudOS 9

- 服务器:腾讯云CVM实例

软件依赖:

gcc make readline-devel zlib-devel openssl-devel uuid-devel bison flex git

环境准备

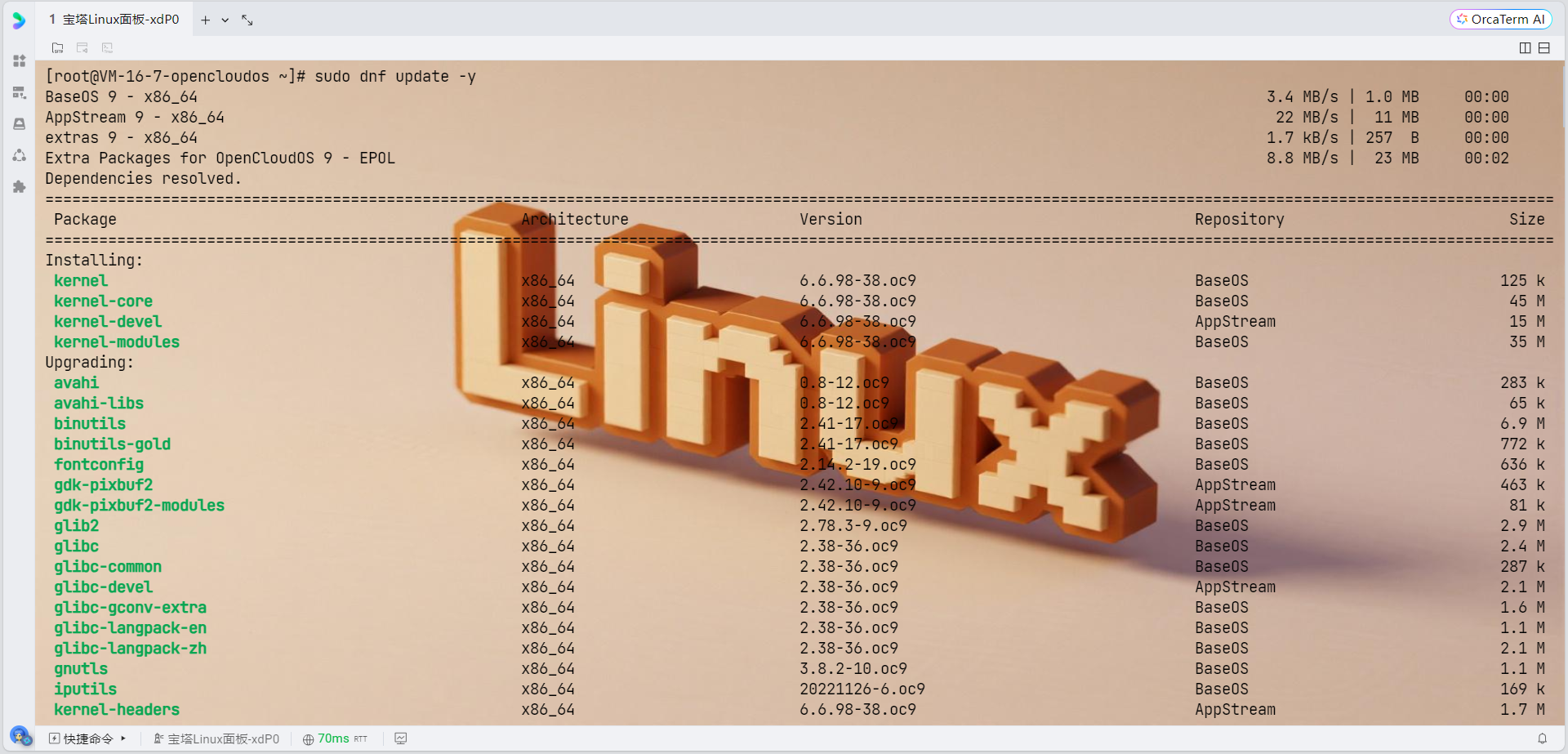

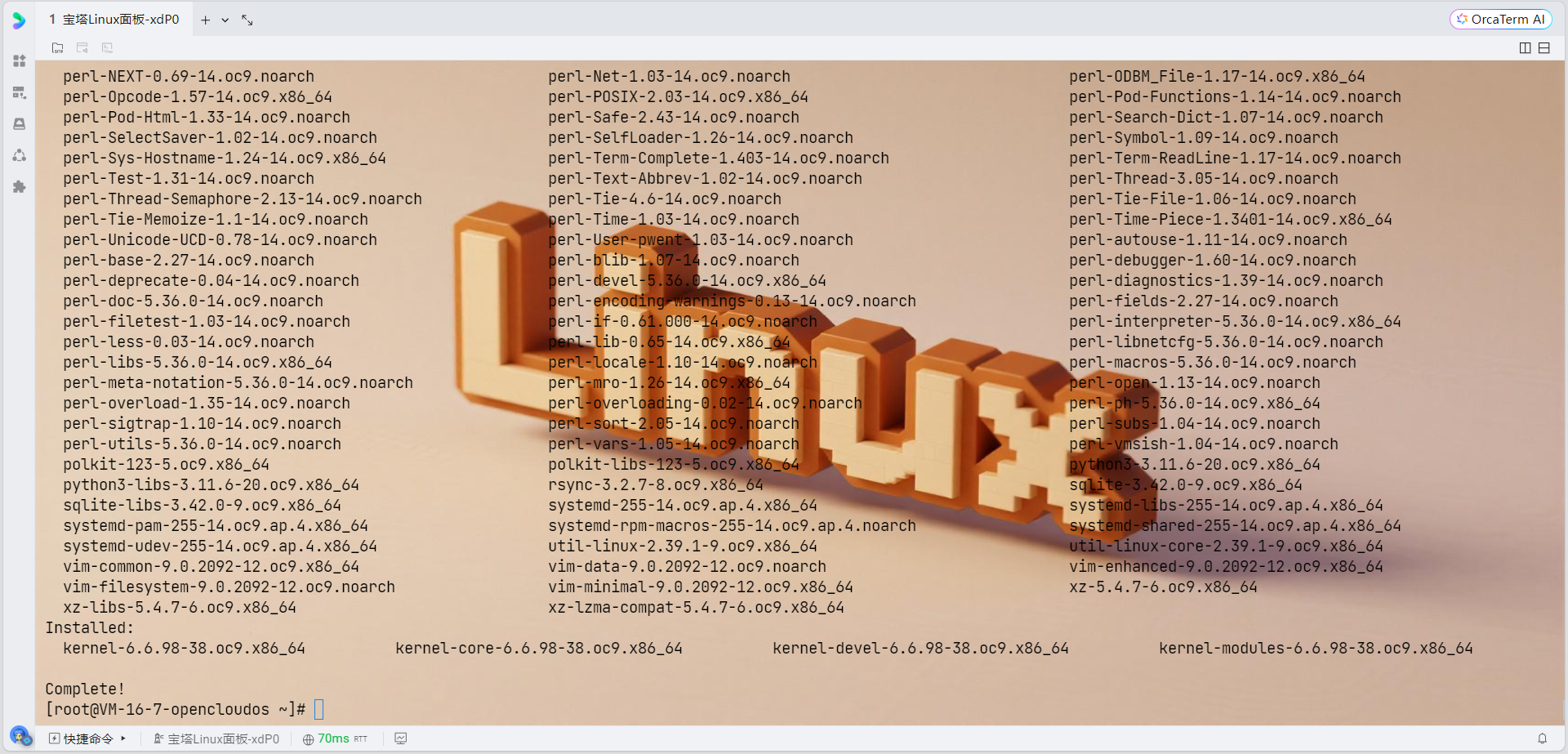

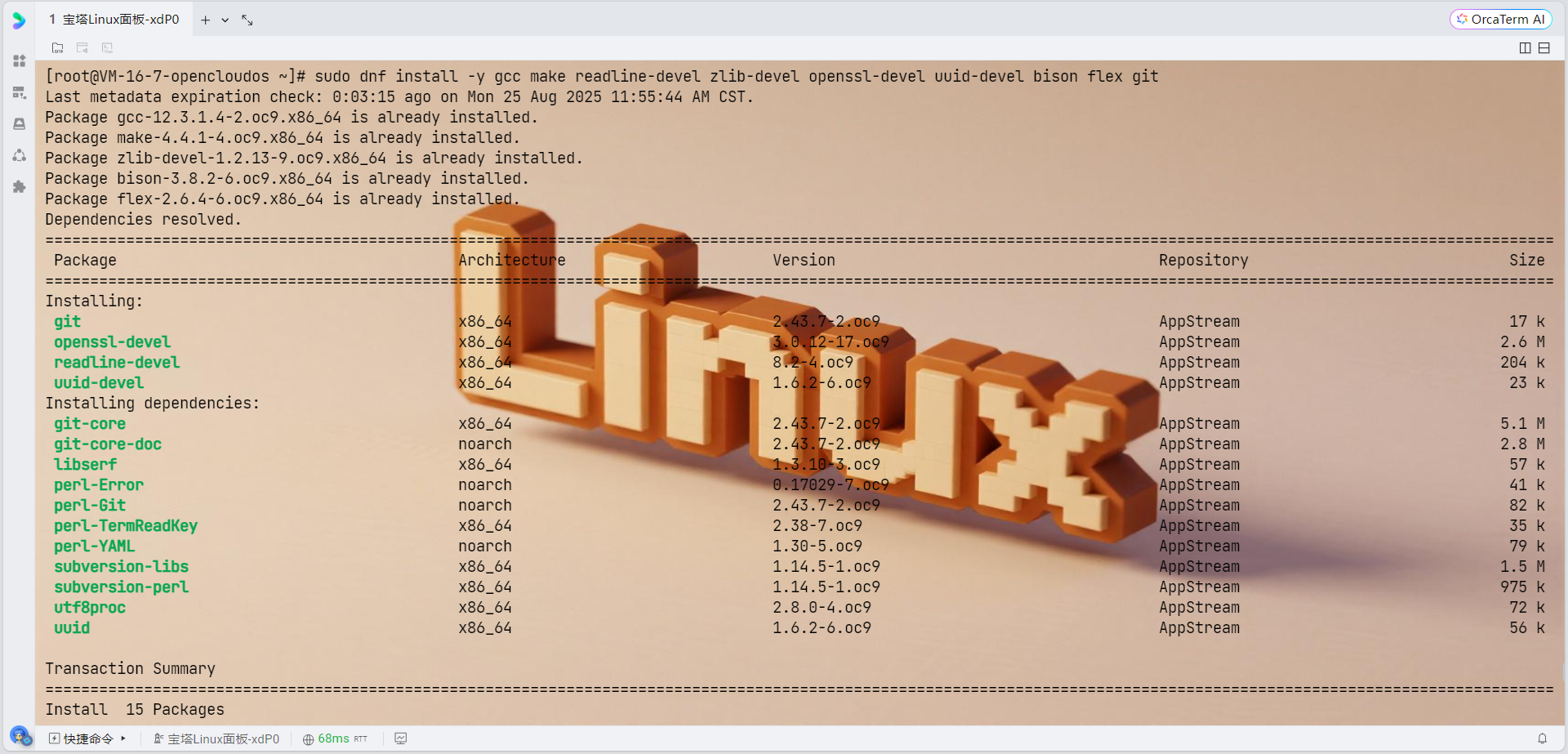

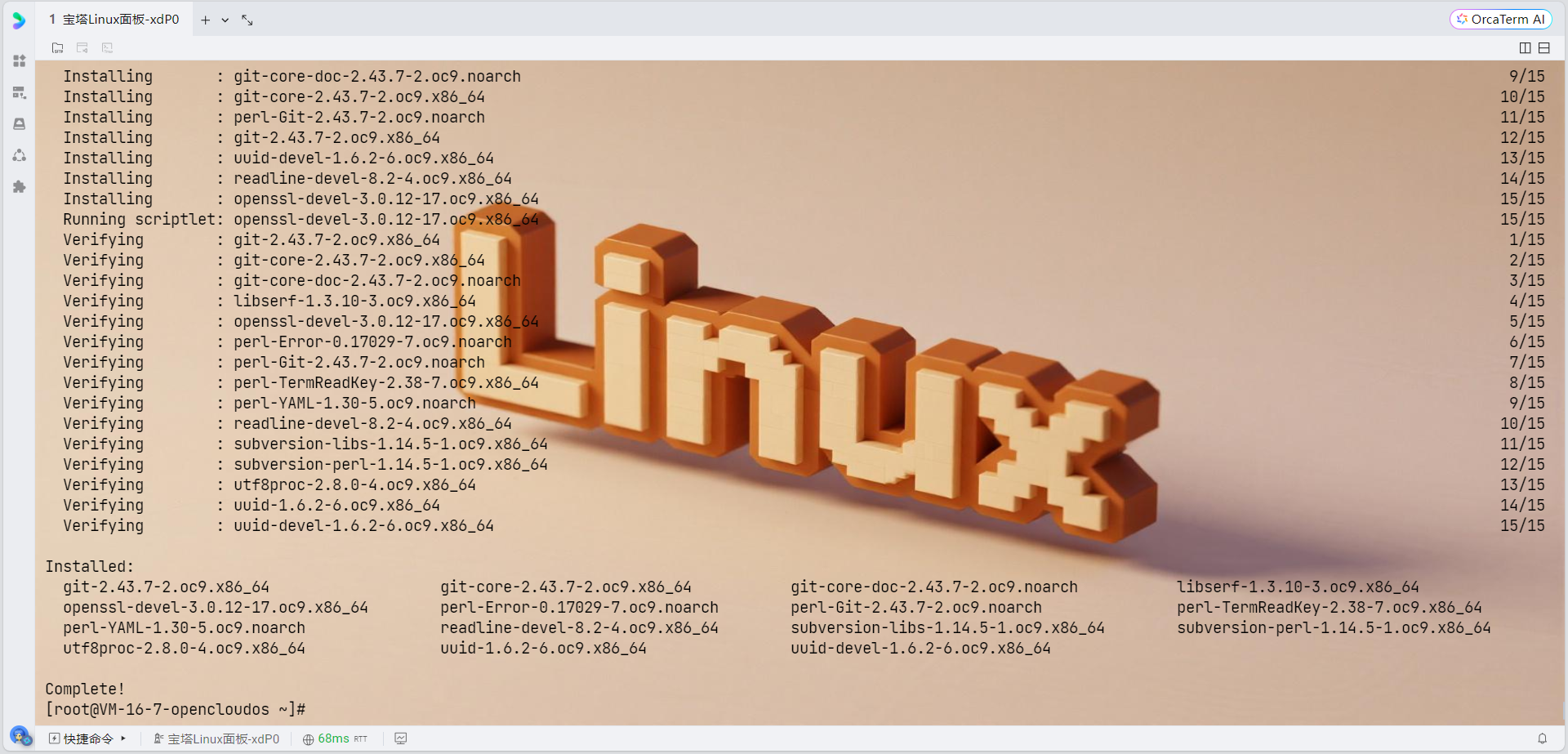

1. 更新系统并安装依赖包

由于OpenCloudOS支持dnf和yum两种包管理软件,强烈推荐用户更多地使用dnf,我们使用dnf来安装依赖:

# 更新系统

sudo dnf update -y

# 安装OpenTenBase编译依赖

sudo dnf install -y \

gcc \

gcc-c++ \

make \

cmake \

readline-devel \

zlib-devel \

openssl-devel \

uuid-devel \

bison \

flex \

git \

libcurl-devel \

libxml2-devel \

libxslt-devel \

perl-IPC-Run \

perl-Test-Simple \

tcl-devel \

python3-devel \

rpm-build \

pkgconfig \

krb5-devel \

openldap-devel

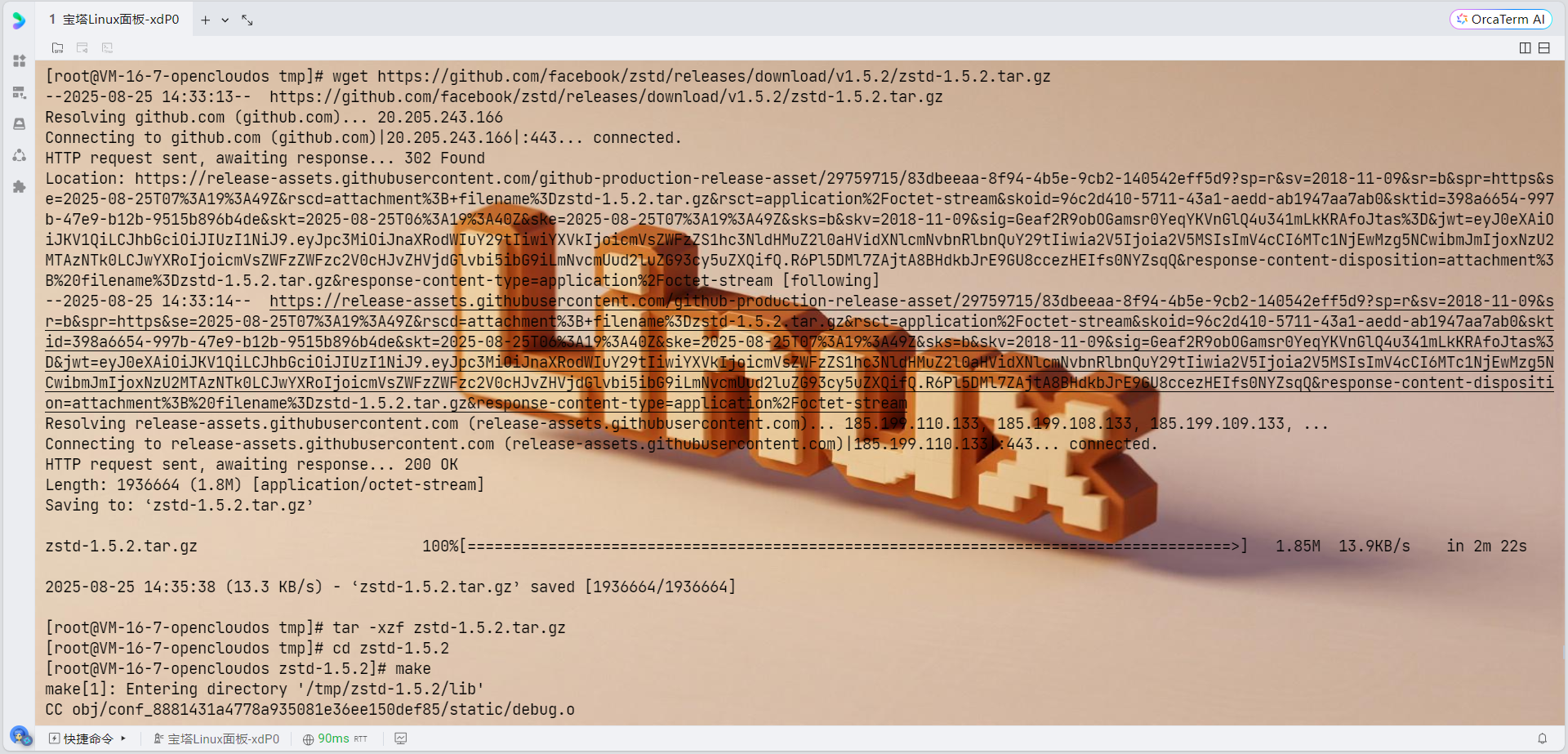

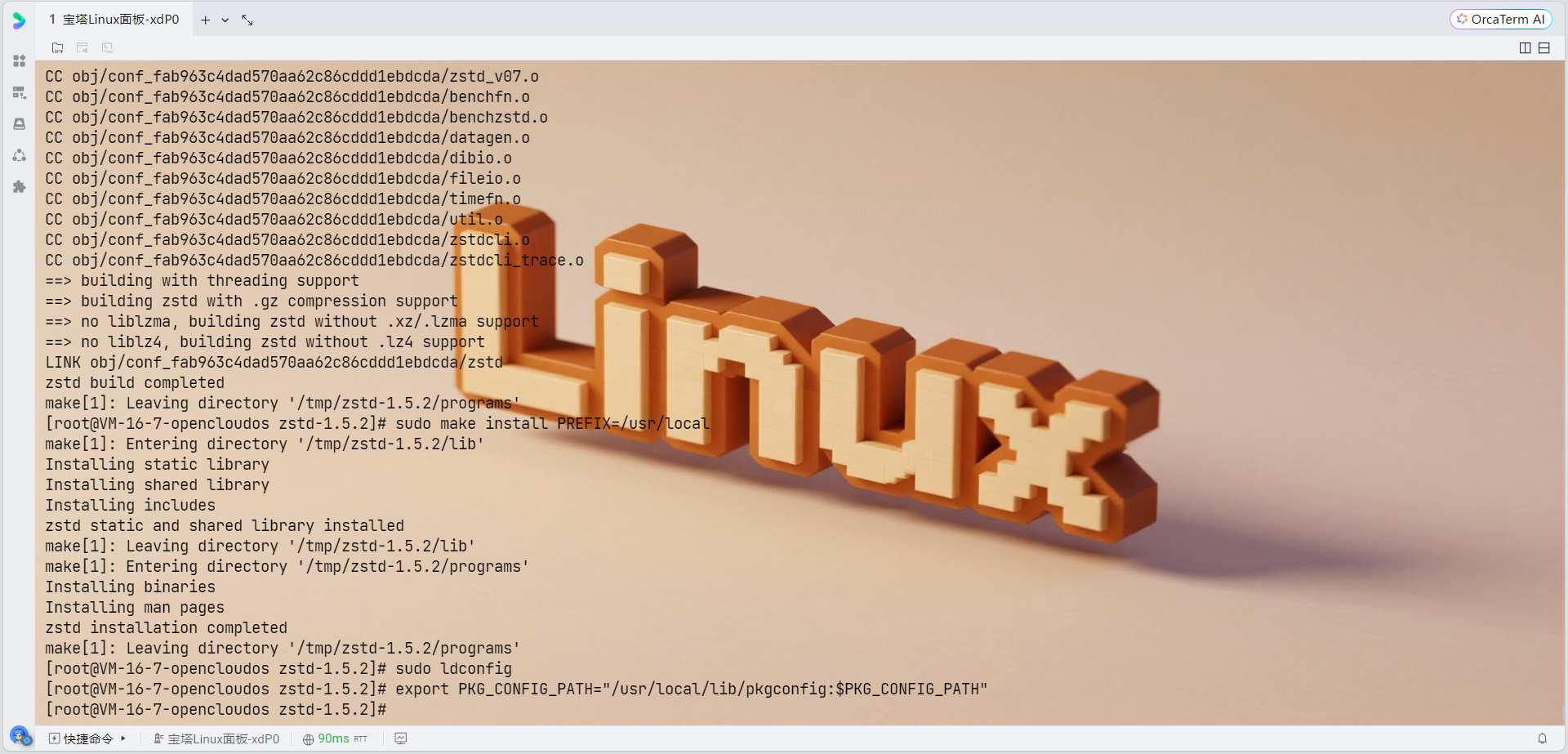

# 下载zstd源码

cd /tmp

wget https://github.com/facebook/zstd/releases/download/v1.5.2/zstd-1.5.2.tar.gz

tar -xzf zstd-1.5.2.tar.gz

cd zstd-1.5.2

# 编译安装

make

sudo make install PREFIX=/usr/local

# 更新库路径

sudo ldconfig

# 设置环境变量

export PKG_CONFIG_PATH="/usr/local/lib/pkgconfig:$PKG_CONFIG_PATH"

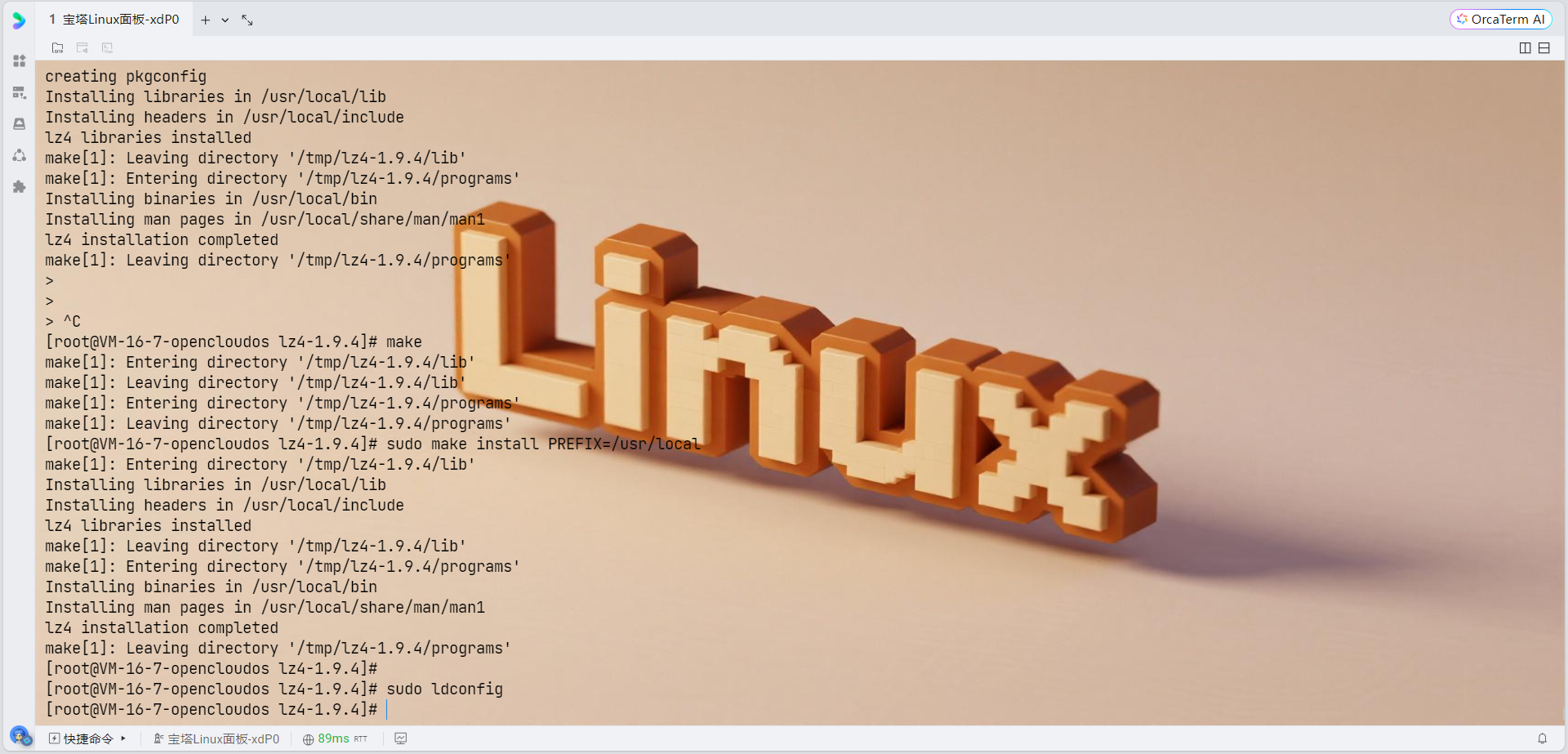

# 下载lz4源码

cd /tmp

wget https://github.com/lz4/lz4/archive/v1.9.4.tar.gz

tar -xzf v1.9.4.tar.gz

cd lz4-1.9.4

# 编译安装

make

sudo make install PREFIX=/usr/local

# 更新库路径

sudo ldconfig

# 设置环境变量

export PKG_CONFIG_PATH="/usr/local/lib/pkgconfig:$PKG_CONFIG_PATH"

export LD_LIBRARY_PATH="/usr/local/lib:$LD_LIBRARY_PATH"

# 首先检查当前的包管理器状态

sudo dnf clean all

# 安装libxml2-devel及其依赖包

sudo dnf install -y \

libxml2-devel \

libxml2 \

cmake-filesystem \

xz-devel \

zlib-devel \

pkgconfig

# 验证安装

rpm -qa | grep libxml2

# 检查xml2-config命令是否可用

which xml2-config

# 检查pkg-config是否能找到libxml-2.0

pkg-config --exists libxml-2.0 && echo "libxml2 found" || echo "libxml2 NOT found"

# 查看libxml2的配置信息

xml2-config --version

xml2-config --cflags

xml2-config --libs

sudo dnf search cli11

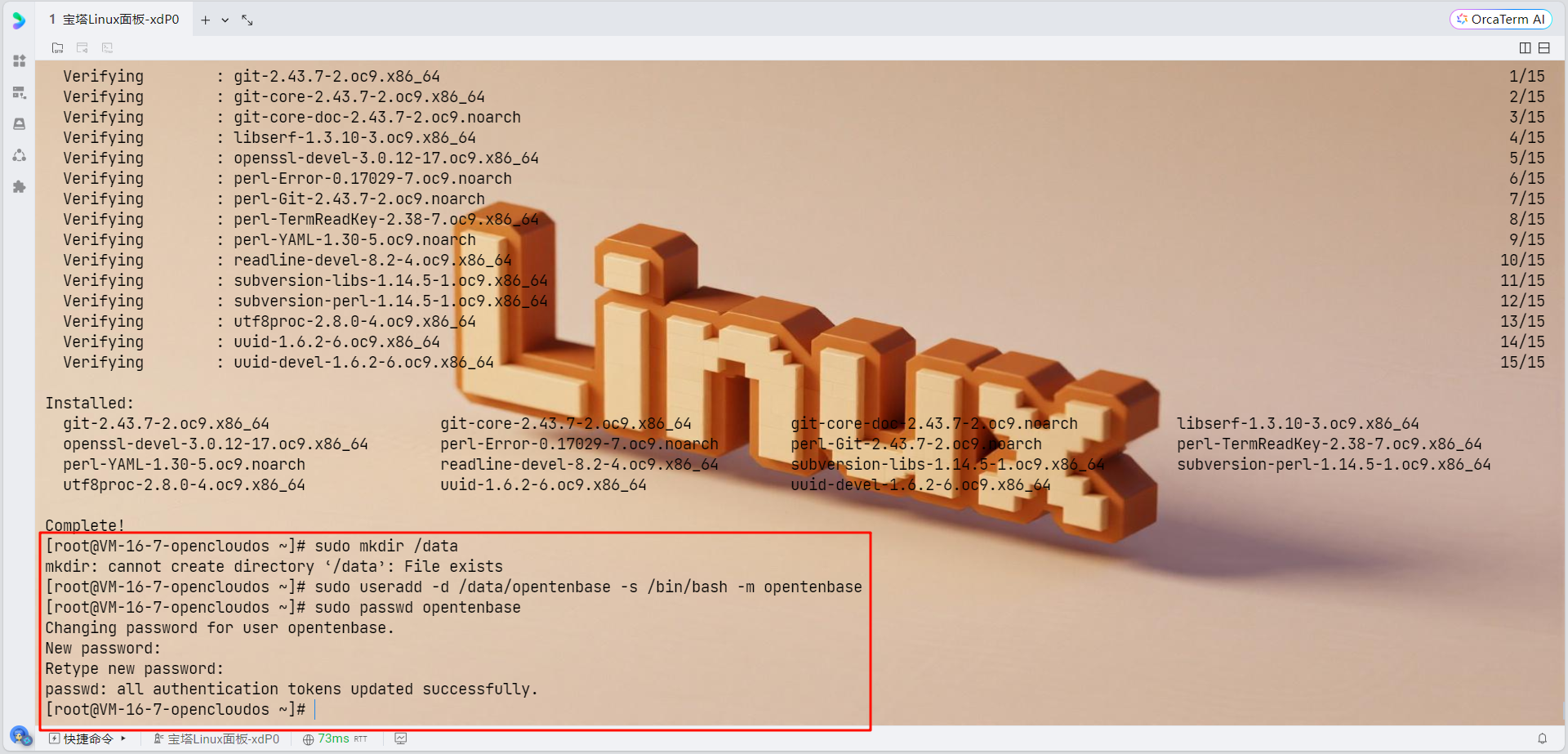

sudo dnf install -y cli11-devel2. 创建专用用户

所有需要安装OpenTenBase集群的机器都需要创建专用用户:

# 创建数据目录

sudo mkdir /data

# 创建opentenbase用户

sudo useradd -d /data/opentenbase -s /bin/bash -m opentenbase

# 设置密码

sudo passwd opentenbase

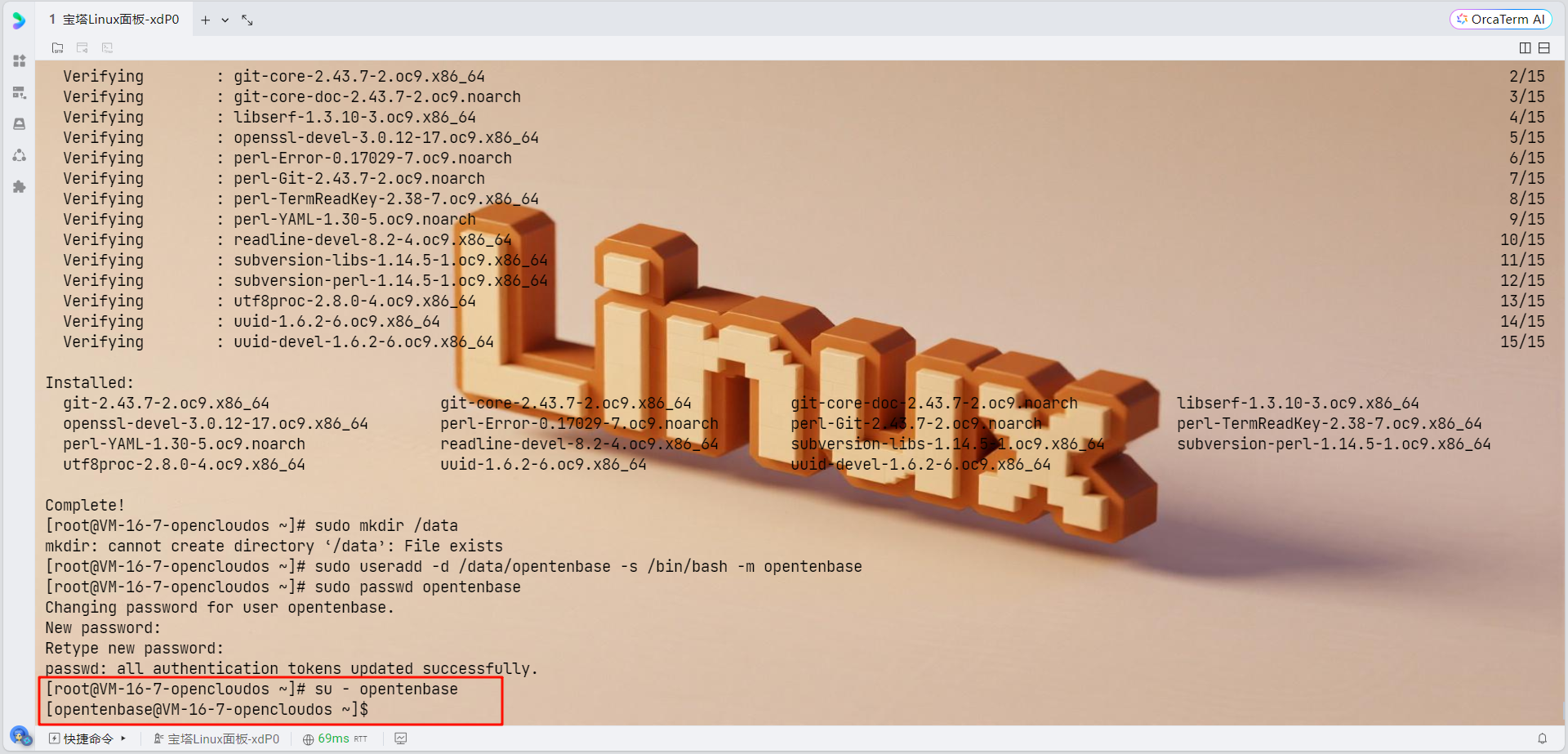

3. 切换到opentenbase用户

su - opentenbase

源码编译安装

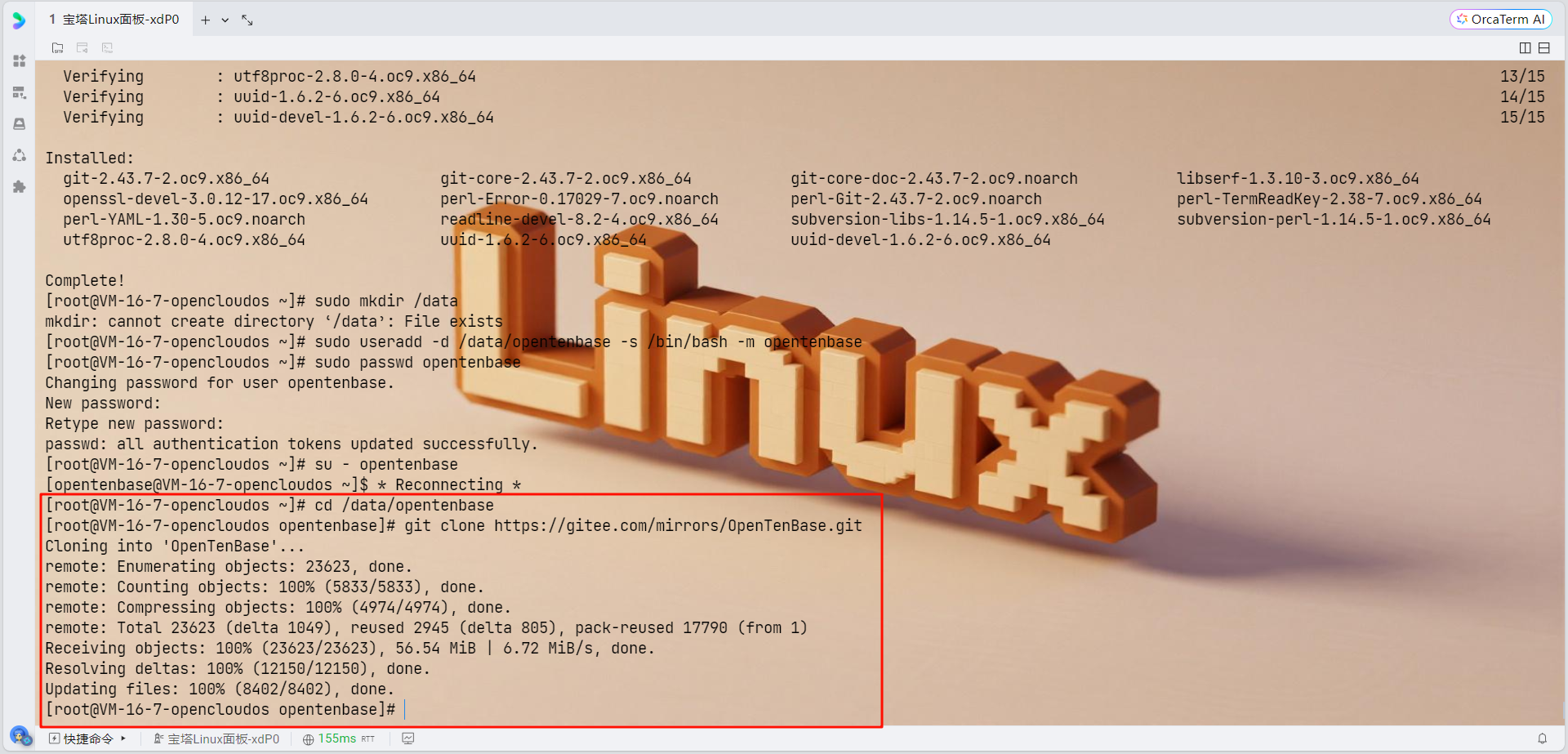

1. 获取源码

cd /data/opentenbase

git clone https://gitee.com/mirrors/OpenTenBase.git

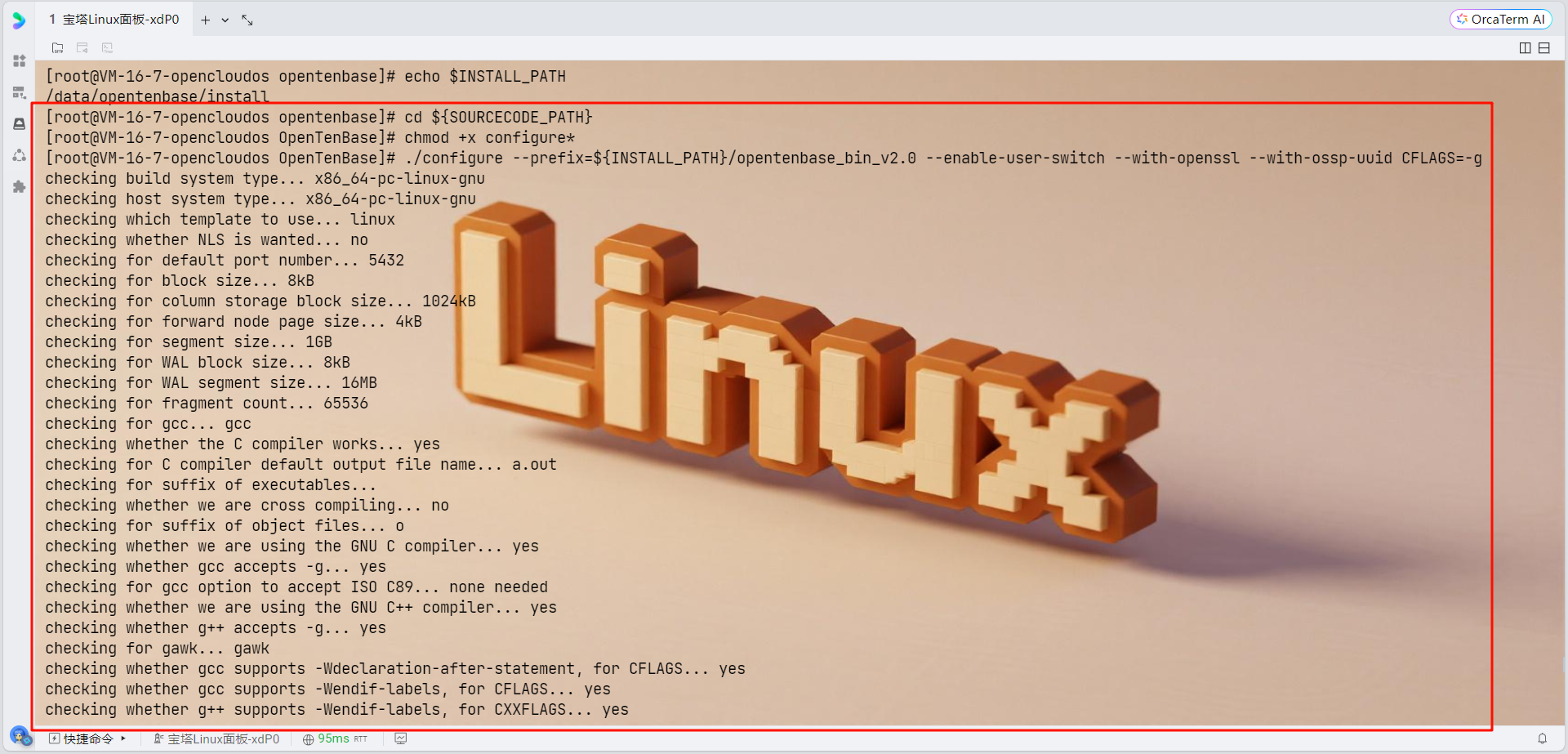

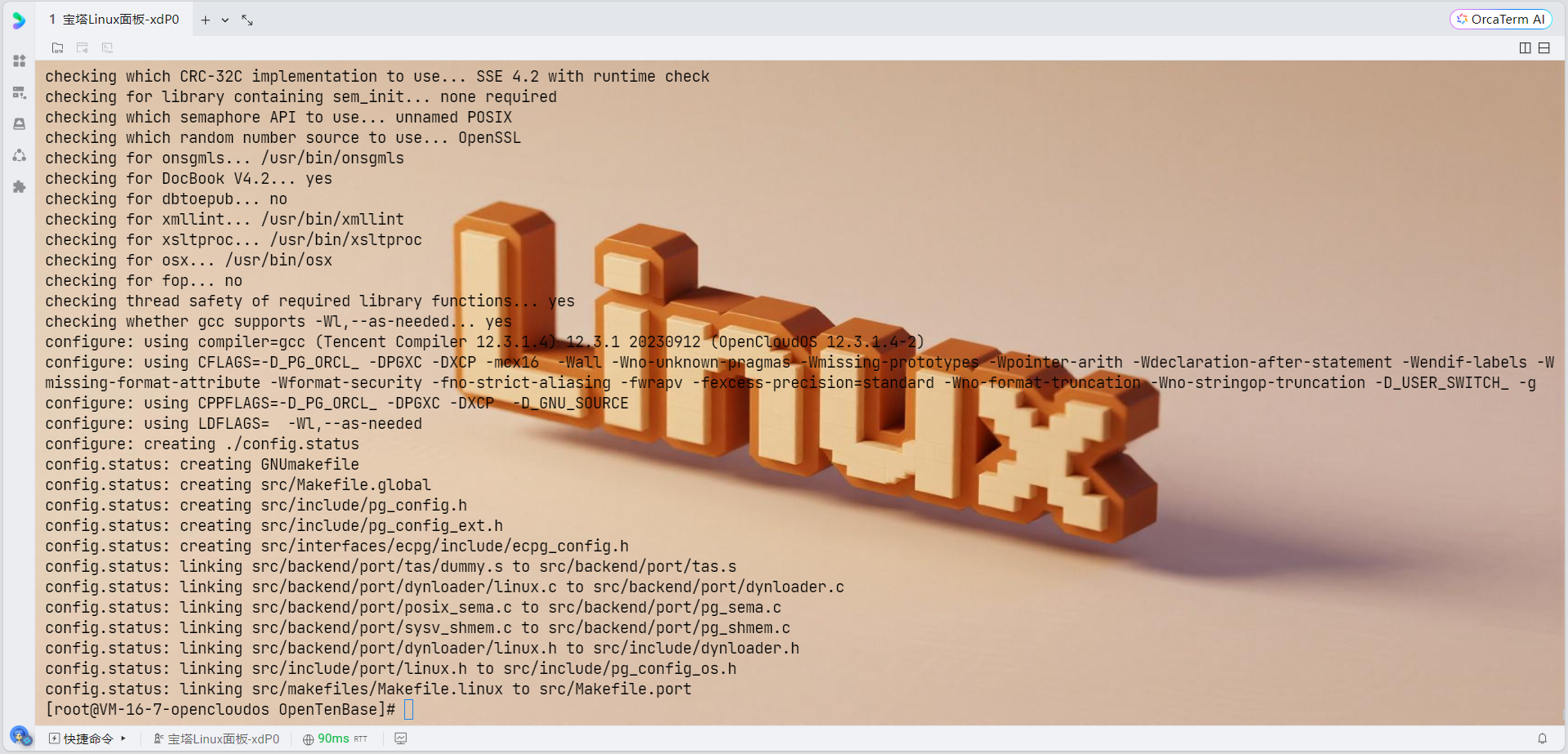

2. 编译源码

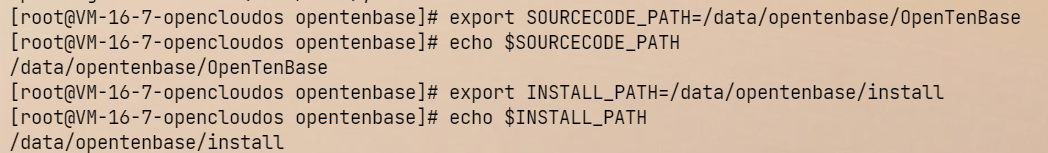

# 设置环境变量

export SOURCECODE_PATH=/data/opentenbase/OpenTenBase

export INSTALL_PATH=/data/opentenbase/install

# 进入源码目录

cd ${SOURCECODE_PATH}

# 配置编译选项

chmod +x configure*

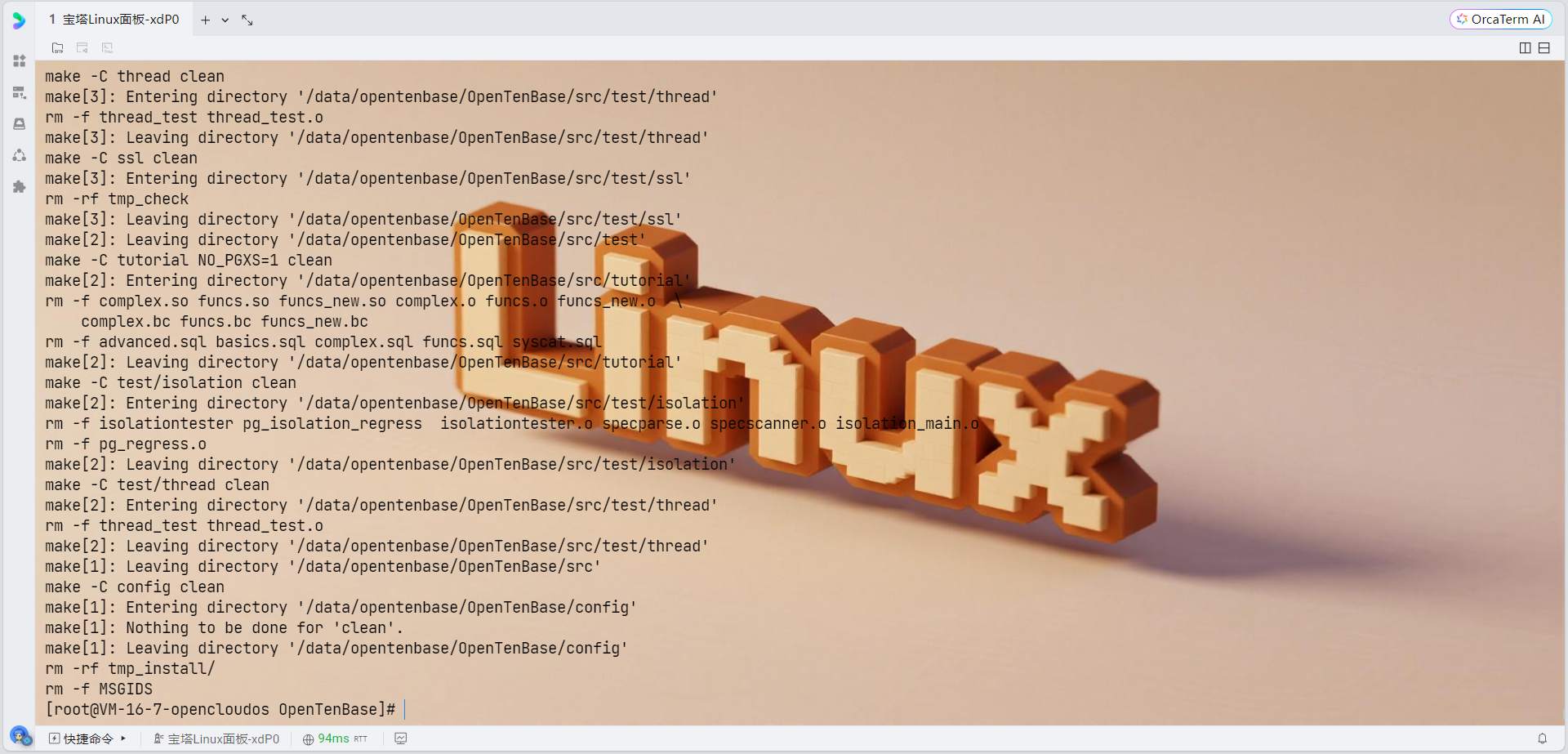

# 编译和安装

make distclean 2>/dev/null || true

rm -rf /data/opentenbase/install/opentenbase_bin_v2.0

rm -f config.status config.log

# 重新配置,添加SSE4.2支持

CFLAGS="-g -O2 -w -msse4.2 -mcrc32" \

CXXFLAGS="-g -O2 -w -msse4.2 -mcrc32" \

./configure --prefix=/data/opentenbase/install/opentenbase_bin_v2.0 \

--enable-user-switch \

--with-openssl \

--with-ossp-uuid \

--with-libxml

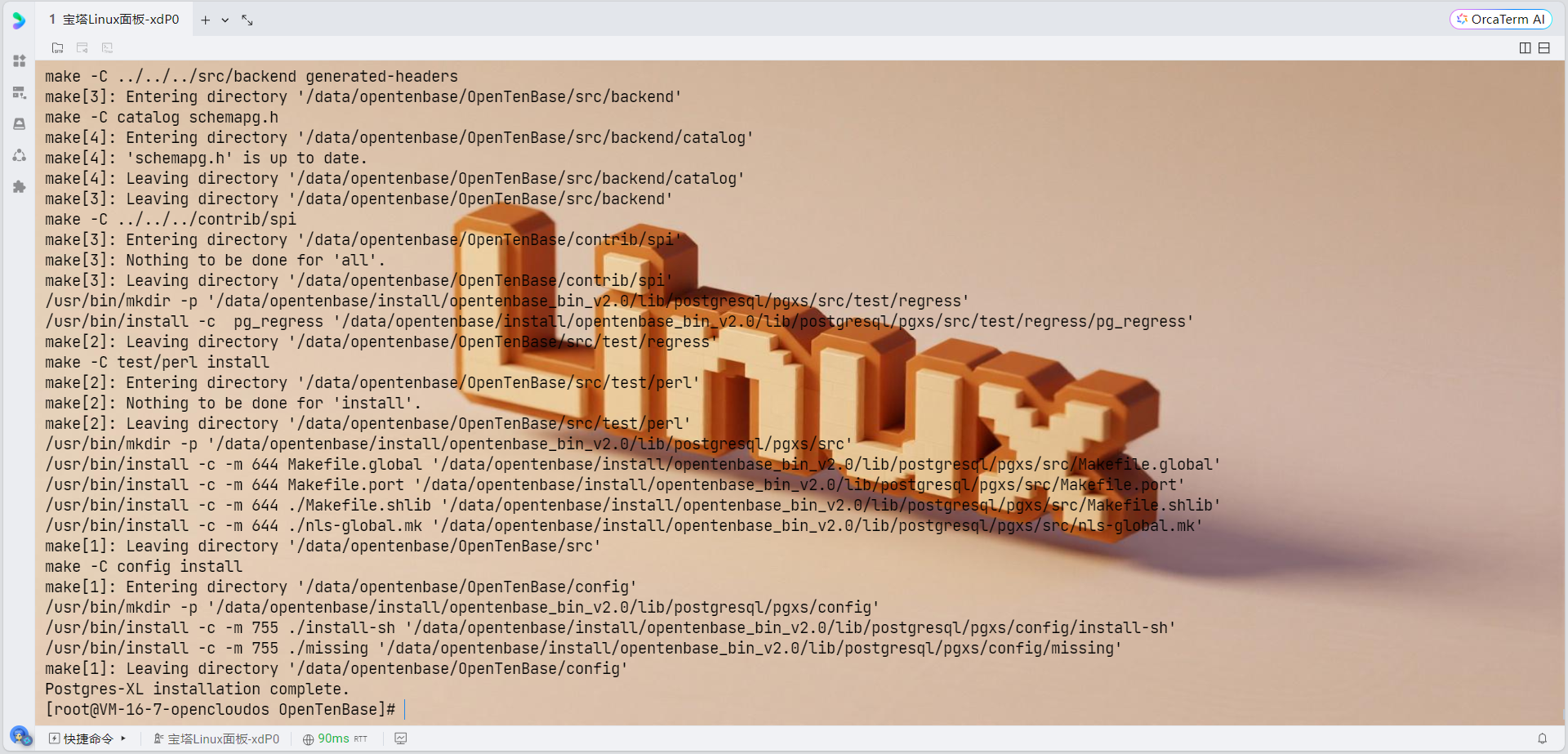

# 编译

make

make install

# 编译contrib模块

chmod +x contrib/pgxc_ctl/make_signature

cd contrib

make

make install

集中式单节点集群配置

1. 配置环境变量

# 编辑bashrc文件

vim ~/.bashrc

# 添加以下内容:

export OPENTENBASE_HOME=/data/opentenbase/install/opentenbase_bin_v2.0

export PATH=$OPENTENBASE_HOME/bin:$PATH

export LD_LIBRARY_PATH=$OPENTENBASE_HOME/lib:${LD_LIBRARY_PATH}

export LC_ALL=C

# 生效环境变量

source ~/.bashrc

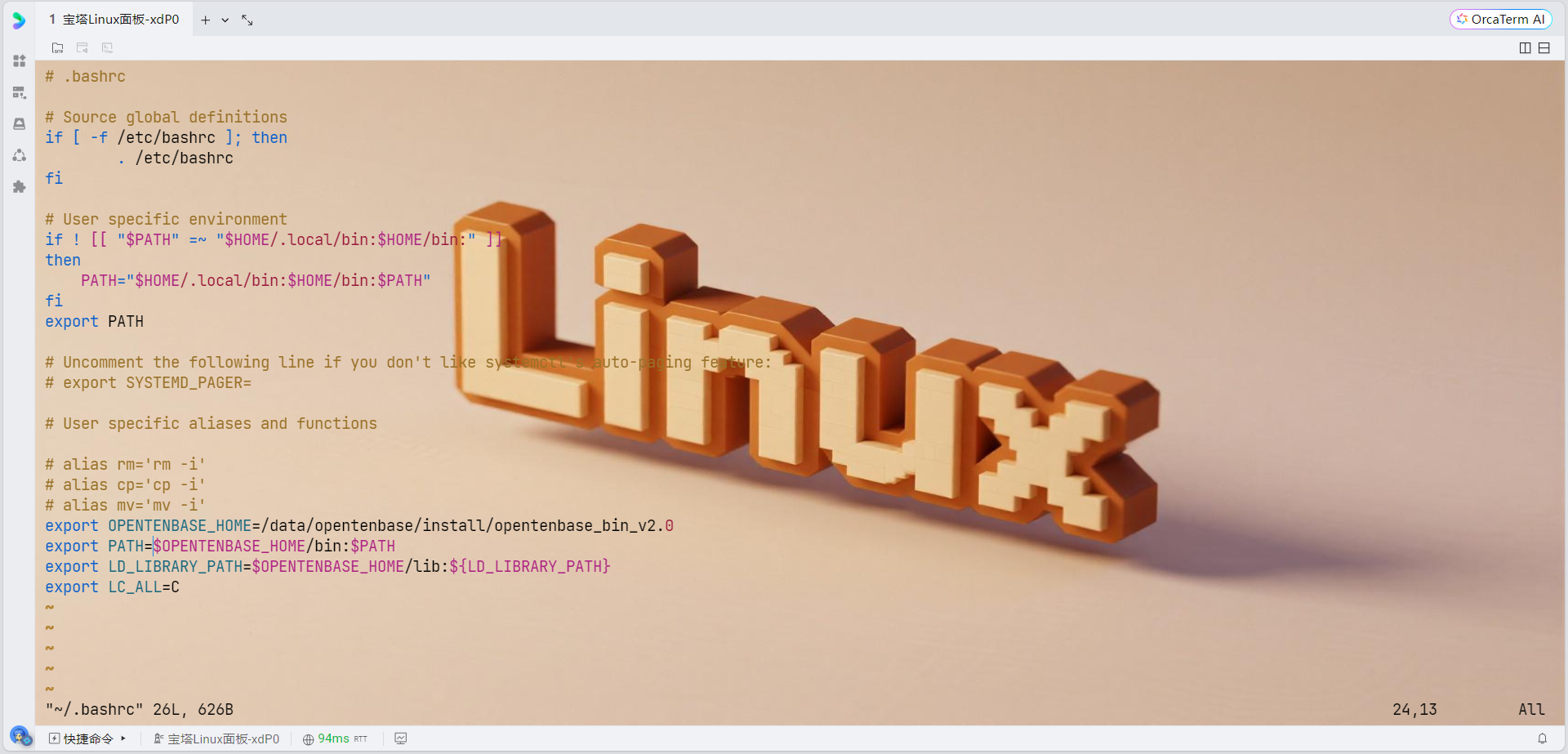

2. 创建集群配置目录

mkdir /data/opentenbase/pgxc_ctl

cd /data/opentenbase/pgxc_ctl

3. 创建集中式配置文件

cat > /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf << 'EOF'

#!/usr/bin/env bash

#---- OVERALL -----------------------------------------------------------------------------

pgxcOwner=opentenbase

pgxcUser=$pgxcOwner

tmpDir=/tmp

localTmpDir=$tmpDir

configBackup=y

configBackupHost=localhost

configBackupDir=$HOME/pgxc

configBackupFile=pgxc_ctl.bak

#---- GTM --------------------------------------------------------------------------------

gtmName=gtm

gtmMasterServer=localhost

gtmMasterPort=6666

gtmMasterDir=/data/opentenbase/data/gtm

gtmExtraConfig=none

gtmMasterSpecificExtraConfig=none

# GTM Slave - disabled

gtmSlave=n

gtmSlaveName=gtmSlave

gtmSlaveServer=none

gtmSlavePort=20001

gtmSlaveDir=none

gtmSlaveSpecificExtraConfig=none

# GTM Proxy - disabled

gtmProxy=n

gtmProxyNames=()

gtmProxyServers=()

gtmProxyPorts=()

gtmProxyDirs=()

gtmPxyExtraConfig=none

gtmPxySpecificExtraConfig=()

#---- Coordinators --------------------------------------------------------------------

coordMasterDir=/data/opentenbase/data/coord_master

coordSlaveDir=/data/opentenbase/data/coord_slave

coordArchLogDir=/data/opentenbase/data/coord_archlog

# 协调器配置数组 - 所有数组必须有相同数量的元素

coordNames=(cn001)

coordPorts=(30004)

poolerPorts=(30014)

coordForwardPorts=(30024)

coordPgHbaEntries=(0.0.0.0/0)

# Master Coordinators

coordMasterServers=(localhost)

coordMasterDirs=(/data/opentenbase/data/coord_master/cn001)

coordMaxWALsender=5

coordMaxWALSenders=(5)

# Coordinator Slave - disabled

coordSlave=n

coordSlaveSync=n

coordSlaveServers=(none)

coordSlavePorts=(30005)

coordSlavePoolerPorts=(30015)

coordSlaveForwardPorts=(30025)

coordSlaveDirs=(none)

coordArchLogDirs=(none)

# Configuration files

coordExtraConfig=none

coordSpecificExtraConfig=(none)

coordSpecificExtraPgHba=(none)

#---- Datanodes -----------------------------------------------------------------------

datanodeMasterDir=/data/opentenbase/data/dn_master

datanodeSlaveDir=/data/opentenbase/data/dn_slave

datanodeArchLogDir=/data/opentenbase/data/datanode_archlog

# 数据节点配置数组 - 所有数组必须有相同数量的元素

primaryDatanode=dn001

datanodeNames=(dn001)

datanodePorts=(20008)

datanodePoolerPorts=(20018)

datanodeForwardPorts=(20028)

datanodePgHbaEntries=(0.0.0.0/0)

# Master Datanodes

datanodeMasterServers=(localhost)

datanodeMasterDirs=(/data/opentenbase/data/dn_master/dn001)

datanodeMaxWalSender=5

datanodeMaxWALSenders=(5)

# Datanode Slave - disabled

datanodeSlave=n

datanodeSlaveServers=(none)

datanodeSlavePorts=(20009)

datanodeSlavePoolerPorts=(20019)

datanodeSlaveForwardPorts=(20029)

datanodeSlaveDirs=(none)

datanodeArchLogDirs=(none)

# Configuration files

datanodeExtraConfig=none

datanodeSpecificExtraConfig=(none)

datanodeSpecificExtraPgHba=(none)

# WAL Archive - disabled

walArchive=n

EOF

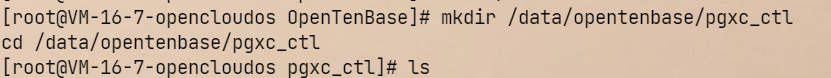

# 检查配置文件语法

bash -n /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf

echo "配置文件语法检查结果: $?"

# 查看文件内容确认

head -20 /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf检查环境变量

# 检查当前环境变量

echo $PATH

echo $OPENTENBASE_HOME

which initdb

which gtm_ctl重新设置环境变量

# 退出pgxc_ctl

quit

# 重新设置环境变量

export OPENTENBASE_HOME=/data/opentenbase/install/opentenbase_bin_v2.0

export PATH=$OPENTENBASE_HOME/bin:$PATH

export LD_LIBRARY_PATH=$OPENTENBASE_HOME/lib:${LD_LIBRARY_PATH}

export LC_ALL=C

# 验证命令是否可用

which initdb

which gtm_ctl

which pg_ctl永久保存环境变量

# 编辑 .bashrc 文件

vim ~/.bashrc

# 添加以下内容到文件末尾:

export OPENTENBASE_HOME=/data/opentenbase/install/opentenbase_bin_v2.0

export PATH=$OPENTENBASE_HOME/bin:$PATH

export LD_LIBRARY_PATH=$OPENTENBASE_HOME/lib:${LD_LIBRARY_PATH}

export LC_ALL=C

# 重新加载环境变量

source ~/.bashrc重新创建完整的配置文件

# 删除不完整的配置文件

rm /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf

# 重新创建完整配置文件

cat > /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf << 'EOF'

#!/usr/bin/env bash

#---- OVERALL -----------------------------------------------------------------------------

pgxcOwner=opentenbase

pgxcUser=$pgxcOwner

tmpDir=/tmp

localTmpDir=$tmpDir

configBackup=y

configBackupHost=localhost

configBackupDir=$HOME/pgxc

configBackupFile=pgxc_ctl.bak

#---- GTM --------------------------------------------------------------------------------

gtmName=gtm

gtmMasterServer=localhost

gtmMasterPort=6666

gtmMasterDir=/data/opentenbase/data/gtm

gtmExtraConfig=none

gtmMasterSpecificExtraConfig=none

gtmSlave=n

gtmSlaveName=gtmSlave

gtmSlaveServer=none

gtmSlavePort=20001

gtmSlaveDir=none

gtmSlaveSpecificExtraConfig=none

gtmProxy=n

gtmProxyNames=()

gtmProxyServers=()

gtmProxyPorts=()

gtmProxyDirs=()

gtmPxyExtraConfig=none

gtmPxySpecificExtraConfig=()

#---- Coordinators --------------------------------------------------------------------

coordMasterDir=/data/opentenbase/data/coord_master

coordSlaveDir=/data/opentenbase/data/coord_slave

coordArchLogDir=/data/opentenbase/data/coord_archlog

coordNames=(cn001)

coordPorts=(30004)

poolerPorts=(30014)

coordForwardPorts=(30024)

coordPgHbaEntries=(0.0.0.0/0)

coordMasterServers=(localhost)

coordMasterDirs=(/data/opentenbase/data/coord_master/cn001)

coordMaxWALsender=5

coordMaxWALSenders=(5)

coordSlave=n

coordSlaveSync=n

coordSlaveServers=(none)

coordSlavePorts=(30005)

coordSlavePoolerPorts=(30015)

coordSlaveForwardPorts=(30025)

coordSlaveDirs=(none)

coordArchLogDirs=(none)

coordExtraConfig=none

coordSpecificExtraConfig=(none)

coordSpecificExtraPgHba=(none)

#---- Datanodes -----------------------------------------------------------------------

datanodeMasterDir=/data/opentenbase/data/dn_master

datanodeSlaveDir=/data/opentenbase/data/dn_slave

datanodeArchLogDir=/data/opentenbase/data/datanode_archlog

primaryDatanode=dn001

datanodeNames=(dn001)

datanodePorts=(20008)

datanodePoolerPorts=(20018)

datanodeForwardPorts=(20028)

datanodePgHbaEntries=(0.0.0.0/0)

datanodeMasterServers=(localhost)

datanodeMasterDirs=(/data/opentenbase/data/dn_master/dn001)

datanodeMaxWalSender=5

datanodeMaxWALSenders=(5)

datanodeSlave=n

datanodeSlaveServers=(none)

datanodeSlavePorts=(20009)

datanodeSlavePoolerPorts=(20019)

datanodeSlaveForwardPorts=(20029)

datanodeSlaveDirs=(none)

datanodeArchLogDirs=(none)

datanodeExtraConfig=none

datanodeSpecificExtraConfig=(none)

datanodeSpecificExtraPgHba=(none)

walArchive=n

EOF验证配置文件

# 检查配置文件语法

bash -n /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf

echo "语法检查结果: $?"

# 查看文件完整性

wc -l /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf

tail -10 /data/opentenbase/install/opentenbase_bin_v2.0/pgxc_ctl.conf配置SSH免密登录

# 生成SSH密钥(如果还没有)

if [ ! -f ~/.ssh/id_rsa ]; then

ssh-keygen -t rsa -N "" -f ~/.ssh/id_rsa

fi

# 配置本地免密登录

ssh-copy-id opentenbase@localhost

# 或者手动添加

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

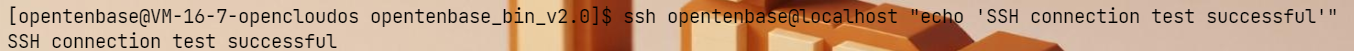

测试SSH连接

# 测试SSH连接是否正常

ssh opentenbase@localhost "echo 'SSH connection test successful'"

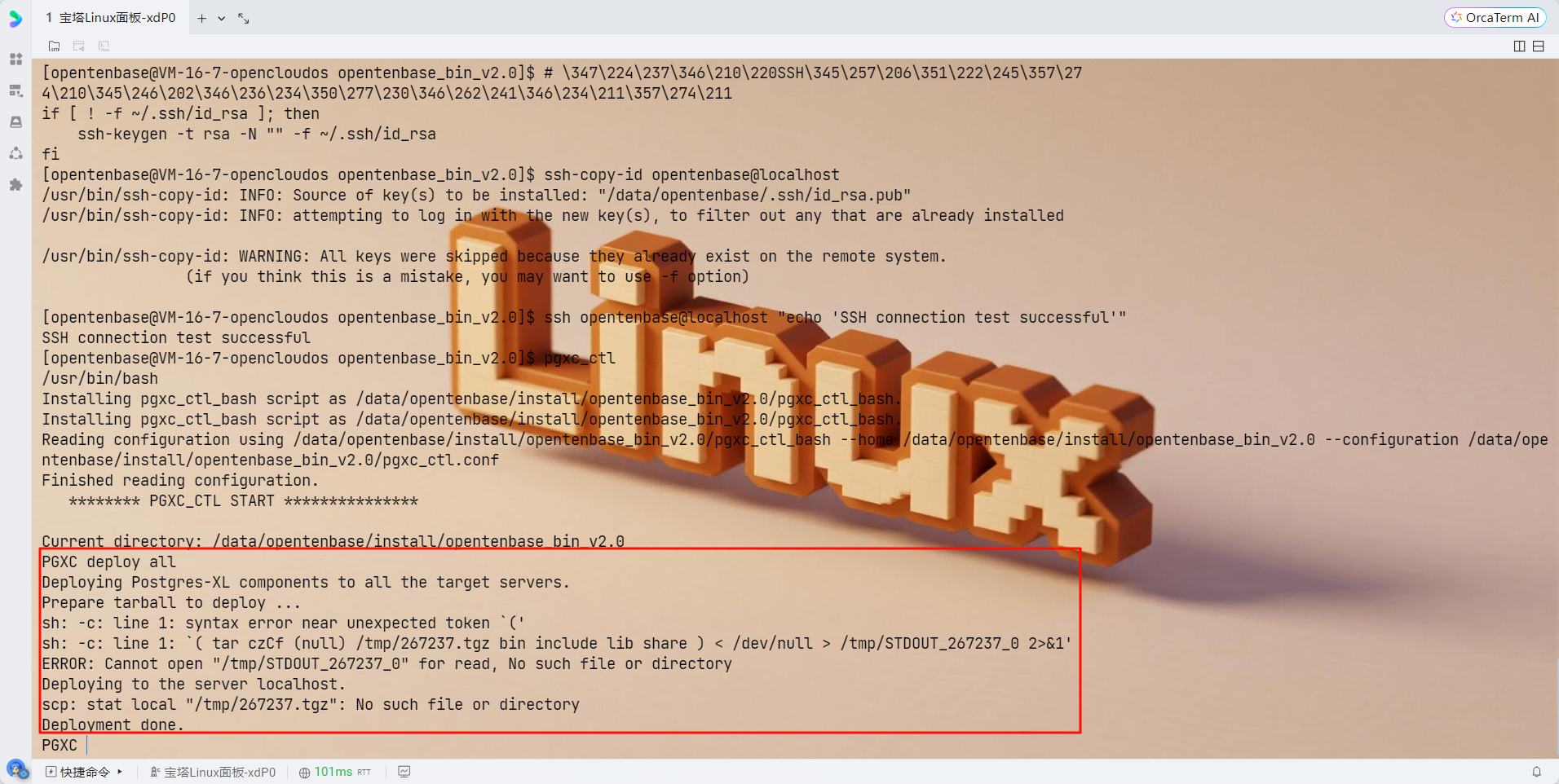

重新运行pgxc_ctl

# 现在重新运行pgxc_ctl

pgxc_ctl

# 在pgxc_ctl中执行:

deploy all

init all

start all

monitor all

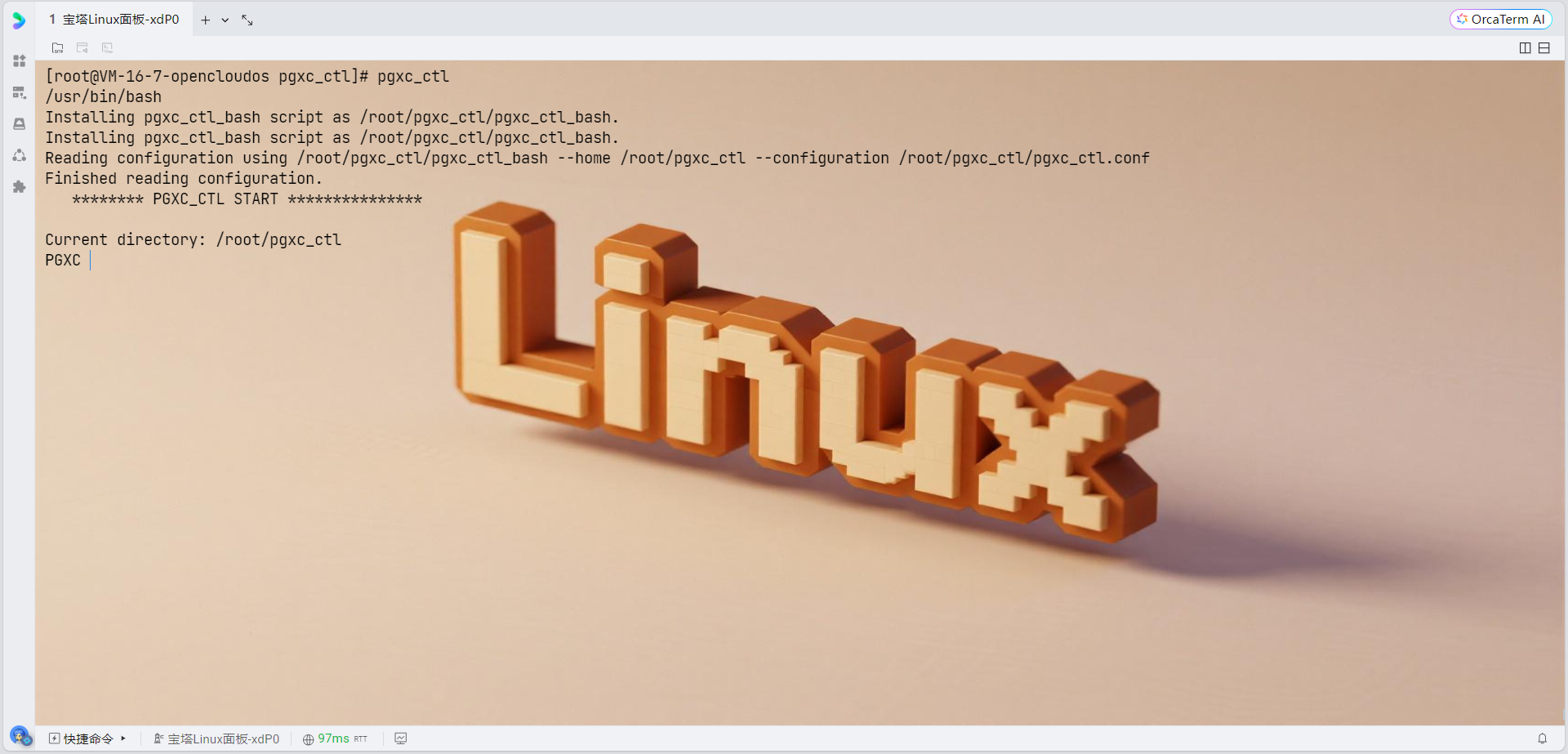

4. 部署和初始化集群

# 启动pgxc_ctl工具

pgxc_ctl

# 在pgxc_ctl命令行中执行:

deploy all

init all

# 退出pgxc_ctl

exit

# 设置opentenbase用户的SSH密钥认证

su - opentenbase

# 生成SSH密钥对

ssh-keygen -t rsa -b 2048 -f ~/.ssh/id_rsa -N ""

# 将公钥添加到authorized_keys

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

chmod 700 ~/.ssh

# 测试SSH连接(应该不需要密码)

ssh opentenbase@127.0.0.1 "echo 'SSH连接测试成功'"

MQgnDKIwotjP9+vkGc9jehXXIzfXSJ2+ZAnFP5IDvIc.

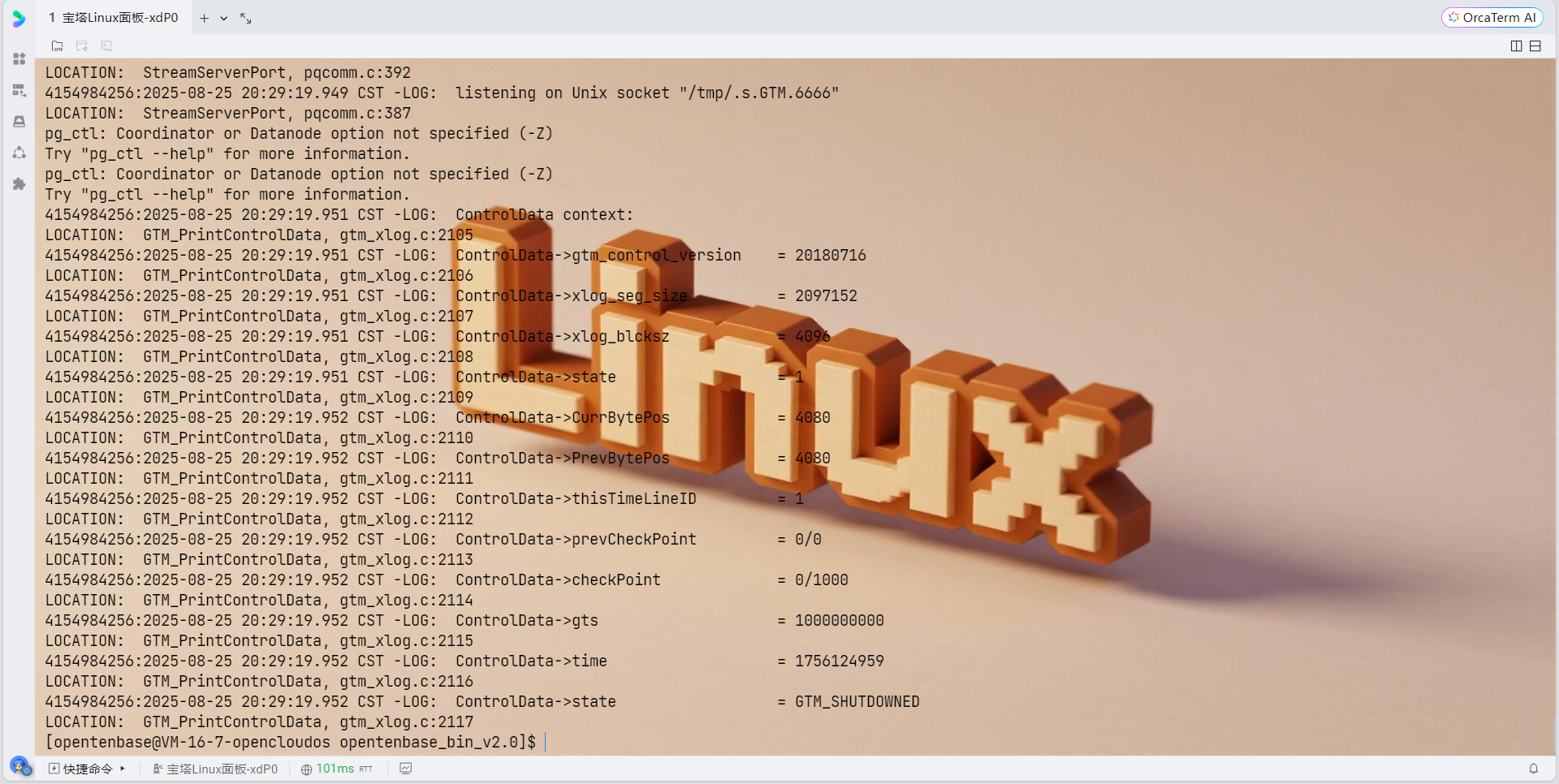

5. 验证集群状态

# 在pgxc_ctl中检查集群状态

monitor all正常情况下应该显示:

Running: gtm master

Running: coordinator master cn001

Running: datanode master dn001

配置防火墙(可选)

如果启用了防火墙,需要开放相应端口:

# 开放GTM端口

sudo firewall-cmd --permanent --add-port=50001/tcp

# 开放Coordinator端口

sudo firewall-cmd --permanent --add-port=30004/tcp

sudo firewall-cmd --permanent --add-port=31110/tcp

# 开放Datanode端口

sudo firewall-cmd --permanent --add-port=40004/tcp

sudo firewall-cmd --permanent --add-port=41110/tcp

# 重新加载防火墙规则

sudo firewall-cmd --reload数据库初始化和使用

1. 连接数据库

psql -h localhost -p 30004 -d postgres -U opentenbase

2. 创建必要的节点组和分片组

OpenTenBase使用数据节点组来增加节点管理的灵活性。需要创建一个默认组来使用,因此需要提前创建。通常,所有数据节点都会被添加到默认组中:

-- 创建默认节点组

CREATE DEFAULT NODE GROUP default_group WITH (dn001);

-- 创建分片组

CREATE SHARDING GROUP TO GROUP default_group;3. 创建数据库和表

-- 创建测试数据库

CREATE DATABASE testdb;

-- 创建用户

CREATE USER testuser WITH PASSWORD 'testpass';

-- 授权

ALTER DATABASE testdb OWNER TO testuser;

-- 切换到测试数据库

\c testdb testuser

-- 创建分片表

CREATE TABLE test_table(

id BIGINT,

name TEXT,

created_time TIMESTAMP DEFAULT NOW()

) DISTRIBUTE BY SHARD(id);

-- 插入测试数据

INSERT INTO test_table(id, name) VALUES

(1, 'OpenTenBase'),

(2, 'TencentCloud'),

(3, 'OpenCloudOS');

-- 查询测试

SELECT * FROM test_table;集群管理

1. 启动集群

pgxc_ctl

start all2. 停止集群

pgxc_ctl

stop all3. 清理集群(重新初始化时使用)

pgxc_ctl

clean all故障排查

1. 查看日志

如果初始化失败,可以查看日志:

# 查看pgxc_ctl日志

ls ~/pgxc_ctl/pgxc_log/

cat ~/pgxc_ctl/pgxc_log/最新的日志文件

# 查看各组件日志

ls /data/opentenbase/data/gtm/pg_log/

ls /data/opentenbase/data/coord/pg_log/

ls /data/opentenbase/data/dn001/pg_log/2. 常见问题解决

- 权限问题:确保opentenbase用户对所有数据目录有读写权限

- 端口冲突:检查配置的端口是否被其他服务占用

- 内存不足:调整shared_buffers等内存参数

- 网络问题:检查防火墙和网络连接

性能优化建议

1. 内存优化

根据服务器配置调整postgresql.conf中的内存参数:

shared_buffers = 25% of RAM # 例如8GB内存设置为2GB

effective_cache_size = 75% of RAM

work_mem = 4MB

maintenance_work_mem = 64MB2. 连接优化

max_connections = 200 # 根据应用需求调整

max_pool_size = 1000 # 连接池大小3. 日志优化

log_min_duration_statement = 1000 # 记录执行时间超过1秒的查询

log_line_prefix = '%t [%p]: [%l-1] user=%u,db=%d,app=%a,client=%h '

log_checkpoints = on

log_connections = on

log_disconnections = on4. 集群节点配置

4.1 Coordinator节点部署

# 初始化Coordinator

/opt/opentenbase/bin/initdb -D /data/opentenbase/coord \

--nodename coord1 \

-E UTF8 \

--locale=en_US.UTF-8

# Coordinator主要配置参数

cat >> /data/opentenbase/coord/postgresql.conf << EOF

# 网络连接

listen_addresses = '*'

port = 5432

max_connections = 500

# 内存配置

shared_buffers = 2GB

work_mem = 256MB

maintenance_work_mem = 512MB

effective_cache_size = 8GB

# GTM连接配置

gtm_host = '192.168.1.100'

gtm_port = 6666

# 分布式配置

pool_number = 4

persistent_datanode_connections = on

EOF4.2 Datanode节点部署

# 批量部署Datanode脚本

#!/bin/bash

NODES=("dn1:192.168.1.101:5433" "dn2:192.168.1.102:5433"

"dn3:192.168.1.103:5433" "dn4:192.168.1.104:5433")

for node_info in "${NODES[@]}"; do

IFS=':' read -r name ip port <<< "$node_info"

# 初始化Datanode

/opt/opentenbase/bin/initdb -D /data/opentenbase/${name} \

--nodename ${name} \

-E UTF8

# 配置Datanode参数

cat >> /data/opentenbase/${name}/postgresql.conf << EOF

listen_addresses = '*'

port = ${port}

gtm_host = '192.168.1.100'

gtm_port = 6666

shared_buffers = 1GB

EOF

echo "Datanode ${name} initialized successfully"

done部署脚本特点:

- 批量化处理,提高部署效率

- 参数化配置,便于扩展维护

- 统一的配置模板,保证一致性

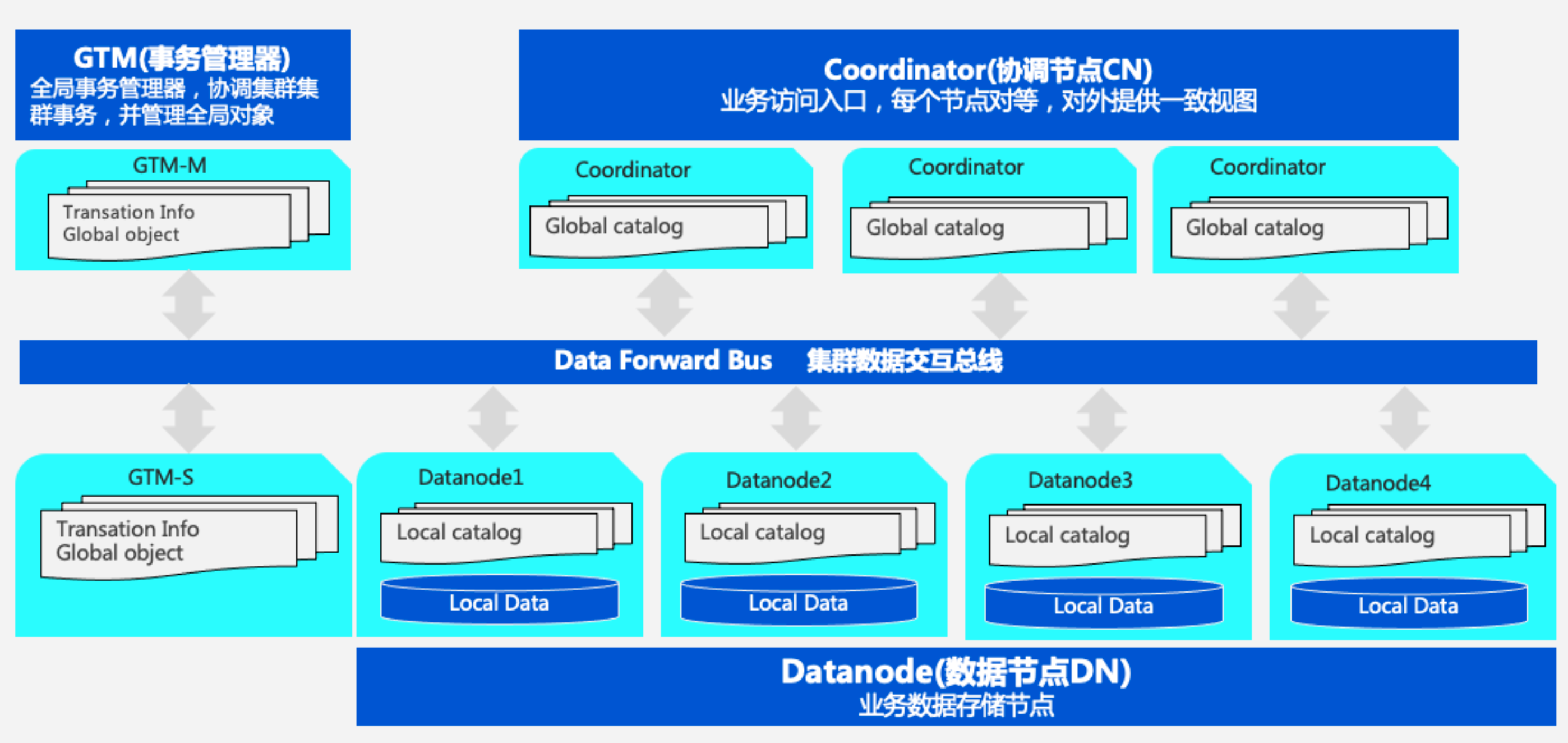

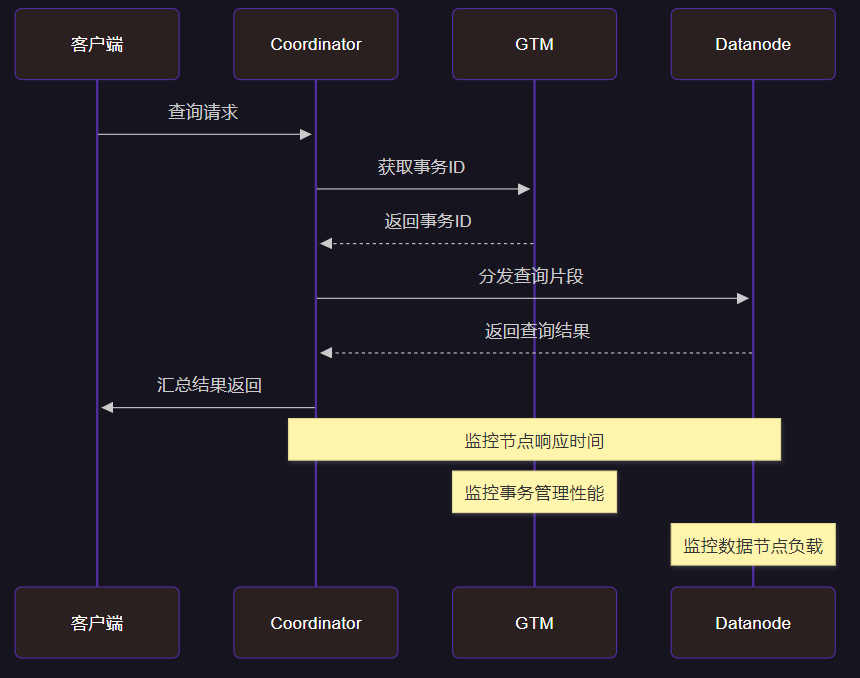

5. 集群管理与运维

5.1 集群健康状态监控

图4:集群交互时序图 - 展示请求处理流程与监控点

5.2 性能监控查询

-- 集群节点状态查询

SELECT

node_name,

node_type,

node_host,

node_port,

CASE

WHEN status = 'N' THEN '正常'

WHEN status = 'D' THEN '下线'

ELSE '未知'

END AS node_status

FROM pgxc_node

ORDER BY node_type, node_name;

-- 分布式表统计信息

SELECT

schemaname,

tablename,

n_tup_ins as "插入行数",

n_tup_upd as "更新行数",

n_tup_del as "删除行数",

last_analyze as "最近分析时间"

FROM pg_stat_user_tables

WHERE schemaname NOT IN ('information_schema', 'pg_catalog')

ORDER BY n_tup_ins DESC LIMIT 10;

-- 数据节点负载分析

WITH node_stats AS (

SELECT

node_name,

pg_stat_get_db_blocks_fetched(oid) as blocks_read,

pg_stat_get_db_blocks_hit(oid) as blocks_hit

FROM pg_database, pgxc_node

WHERE datname = current_database()

)

SELECT

node_name,

blocks_read,

blocks_hit,

CASE

WHEN (blocks_read + blocks_hit) > 0

THEN round(blocks_hit::numeric / (blocks_read + blocks_hit) * 100, 2)

ELSE 0

END as cache_hit_ratio

FROM node_stats

ORDER BY cache_hit_ratio DESC;监控SQL解析:

- 节点状态监控:实时掌握集群拓扑

- 表统计信息:了解数据操作分布

- 缓存命中率:评估内存使用效率

5.3 分布式表创建与分片

-- 创建分布式表(Hash分片)

CREATE TABLE user_orders (

order_id BIGINT PRIMARY KEY,

user_id INTEGER NOT NULL,

product_id INTEGER NOT NULL,

order_amount DECIMAL(10,2),

order_time TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

order_status VARCHAR(20)

) DISTRIBUTE BY HASH(user_id);

-- 创建分布式表(Range分片)

CREATE TABLE sales_data (

sale_id BIGINT,

sale_date DATE NOT NULL,

region VARCHAR(50),

amount DECIMAL(12,2)

) DISTRIBUTE BY RANGE(sale_date);

-- 为Range分片表创建分片规则

SELECT create_distributed_table('sales_data', 'sale_date', 'range');6. 故障排查与优化

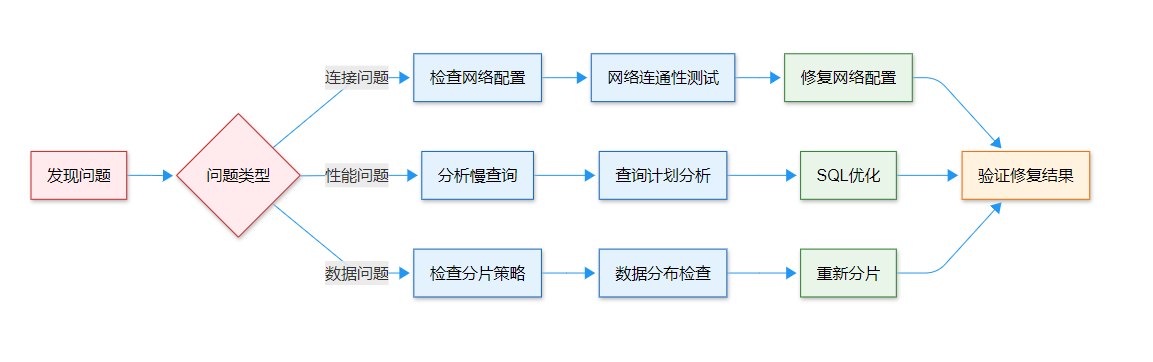

6.1 常见问题排查流程

图5:故障排查流程图 - 系统性问题诊断与解决

6.2 性能优化实践

"分布式数据库的性能优化不仅仅是单节点的调优,更重要的是要理解数据分布和网络通信对整体性能的影响。只有在合适的分片策略基础上,结合精细的参数调优,才能发挥分布式架构的真正优势。"

------ 《分布式数据库架构与实践》

基于实际运维经验,我总结了以下关键优化点:

# 1. 连接池优化

cat >> postgresql.conf << EOF

# 连接池配置

max_pool_size = 100

pool_maintenance_timeout = 30

pool_max_lifetime = 1800

# 查询优化

enable_mergejoin = on

enable_hashjoin = on

enable_nestloop = off # 分布式场景下禁用嵌套循环

# 内存优化

shared_preload_libraries = 'pg_stat_statements'

track_activity_query_size = 2048

EOF

# 2. 系统级优化脚本

#!/bin/bash

echo "开始OpenTenBase性能优化..."

# CPU绑定优化

echo 'performance' > /sys/devices/system/cpu/cpu*/cpufreq/scaling_governor

# I/O调度器优化

echo 'deadline' > /sys/block/*/queue/scheduler

# 网络优化

echo 32768 > /proc/sys/net/core/rps_sock_flow_entries

echo 65536 > /proc/sys/net/core/netdev_max_backlog

echo "优化完成!"7. 实战经验总结

通过这段时间对OpenTenBase的深度使用,我深刻感受到了这款分布式数据库在企业级应用中的巨大潜力。首先是其优秀的PostgreSQL兼容性,让我们的迁移工作变得相对简单,大部分现有的SQL语句和应用程序都能无缝迁移。特别是在处理复杂的OLAP查询时,OpenTenBase展现出了远超传统单机数据库的处理能力。

在分布式弹性扩展方面,我亲身体验了从4个数据节点扩展到8个数据节点的过程。整个扩容过程设计得非常优雅,支持在线扩容,对业务的影响降到了最低。数据重分布的过程虽然需要一定时间,但整体的扩容体验远好于我之前使用过的其他分布式数据库产品。这种弹性扩展能力对于快速增长的业务场景来说是非常宝贵的。

在运维监控方面,我构建了基于Prometheus + Grafana的完整监控体系。通过监控各个节点的CPU、内存、I/O以及数据库特有的指标(如分布式事务延迟、跨节点查询响应时间等),我们能够及时发现性能瓶颈和潜在问题。特别值得一提的是,OpenTenBase提供的统计视图非常详细,为运维工作提供了强有力的支持。

从性能表现来看,在我们的实际业务场景中,OpenTenBase在处理大规模数据查询和高并发写入方面都表现出色。通过合理的分片策略设计,我们成功将单表亿级数据的查询响应时间控制在秒级。在事务处理方面,虽然分布式事务的性能相比单机事务有所下降,但整体性能表现仍然满足我们的业务需求。

在故障处理和高可用性方面,OpenTenBase的设计也比较成熟。节点故障时的自动恢复机制运作良好,数据一致性得到了很好的保障。当然,分布式系统的复杂性也带来了一些挑战,比如跨节点查询的优化、数据倾斜的处理等,这些都需要运维人员具备更深入的分布式系统知识。

总的来说,OpenTenBase作为一个开源的分布式HTAP数据库,在功能完整性、性能表现和运维便利性方面都达到了企业级应用的要求。虽然在某些细节方面还有提升空间,但其强大的PostgreSQL兼容性和优秀的分布式扩展能力,使其成为了企业数字化转型过程中值得考虑的重要选择。我相信,随着社区的不断发展和完善,OpenTenBase将在分布式数据库领域发挥更大的作用。

参考链接

关键词标签

#OpenTenBase #分布式数据库 #PostgreSQL兼容 #HTAP #数据库运维

我是摘星!如果这篇文章在你的技术成长路上留下了印记

👁️ 【关注】与我一起探索技术的无限可能,见证每一次突破

👍 【点赞】为优质技术内容点亮明灯,传递知识的力量

🔖 【收藏】将精华内容珍藏,随时回顾技术要点

💬 【评论】分享你的独特见解,让思维碰撞出智慧火花

🗳️ 【投票】用你的选择为技术社区贡献一份力量

技术路漫漫,让我们携手前行,在代码的世界里摘取属于程序员的那片星辰大海!