一、引言

在 Python 的发展历程中,异步编程是一个极其重要的里程碑。它解决了传统同步阻塞模型在 I/O 密集型任务中的性能瓶颈,使得单机就能高效处理海量并发请求。许多高性能框架(FastAPI、aiohttp、Scrapy、Celery)都构建在异步编程之上。本文将从底层原理到架构实践,系统介绍 Python 异步编程。

二、为什么需要异步?

在同步阻塞模型中,代码执行流程是线性的:遇到 I/O(如网络请求、磁盘读写)就会停下来等待。对于 Web 服务或爬虫来说,大量时间浪费在等待上,CPU 利用率极低。 异步编程的核心思想是 不要等待:当任务被 I/O 阻塞时,立即切换去执行其他任务,从而提高整体吞吐量。

三、事件循环与协程

1. 协程 (Coroutine)

协程是一种比线程更轻量级的并发单元。它可以在特定的挂起点(await)主动让出执行权,从而让事件循环去调度其他任务。

python

import asyncio

async def fetch_data(x):

await asyncio.sleep(1) # 模拟IO

return x * 2

async def main():

results = await asyncio.gather(*(fetch_data(i) for i in range(5)))

print(results)

asyncio.run(main())在这个例子中,5 个任务几乎同时运行,耗时 ≈ 1 秒,而不是 5 秒。

2. 事件循环 (Event Loop)

事件循环是异步编程的核心调度器,负责:

- 管理任务队列

- 处理 I/O 事件

- 执行回调与任务切换

在 asyncio 中,事件循环由 loop.run_until_complete() 驱动。

python

import asyncio

async def say_hello(name, delay):

await asyncio.sleep(delay)

print(f"Hello, {name}! (after {delay}s)")

async def main():

# 使用 create_task 并发执行

task1 = asyncio.create_task(say_hello("Alice", 1))

task2 = asyncio.create_task(say_hello("Bob", 2))

await task1

await task2

asyncio.run(main())运行结果(约 2s 完成,而不是 3s 顺序执行)。

四、底层 I/O 多路复用机制

异步能高效运行,靠的就是操作系统提供的 I/O 多路复用。常见实现有:

- epoll(Linux):基于事件通知,适合高并发。

- kqueue(BSD/macOS):类似 epoll,功能更强。

- IOCP(Windows):完成端口模型,线程池配合内核事件队列。

asyncio 会根据操作系统自动选择最佳机制。高性能库 uvloop 就是用 Cython 封装了 libuv(跨平台事件驱动库),比默认 asyncio 更快。

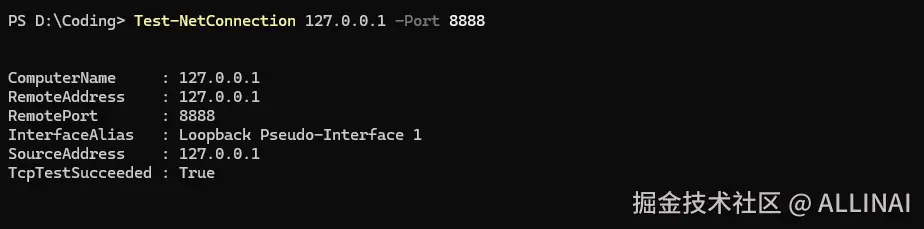

示例:一个简单的 TCP Echo Server

python

import asyncio

# 定义处理单个客户端连接的协程

# reader: StreamReader,用来接收客户端发送的数据

# writer: StreamWriter,用来向客户端发送数据

async def handle_client(reader: asyncio.StreamReader, writer: asyncio.StreamWriter):

addr = writer.get_extra_info('peername') # 获取客户端的地址信息 (IP, 端口)

print(f"新连接来自 {addr}")

try:

while True:

# 异步读取客户端发送的一行数据(以换行符分隔)

data = await reader.readline()

if not data: # 如果客户端断开连接,则 data 为空

print(f"客户端 {addr} 已断开连接")

break

message = data.decode().strip()

print(f"收到 {addr} 的消息: {message}")

# 将原样消息回送给客户端(Echo)

writer.write(data)

await writer.drain() # 确保数据被刷新到网络中

except asyncio.CancelledError:

print(f"连接 {addr} 被强制关闭")

finally:

writer.close() # 关闭连接(半关闭,TCP FIN)

await writer.wait_closed() # 等待底层资源完全释放

print(f"与 {addr} 的连接关闭")

# 主协程:启动 TCP 服务器

async def main():

# 启动一个异步 TCP 服务,监听在 127.0.0.1:8888

server = await asyncio.start_server(

handle_client, # 新连接建立时调用的回调协程

host='127.0.0.1',

port=8888

)

addr = server.sockets[0].getsockname() # 获取实际监听的地址

print(f"服务器已启动,监听 {addr}")

# 使用 async context manager 保证 server 的生命周期管理

async with server:

# serve_forever 会阻塞,直到 Ctrl+C 或任务被取消

await server.serve_forever()

# 运行事件循环

if __name__ == "__main__":

try:

asyncio.run(main())

except KeyboardInterrupt:

print("服务器手动停止")

五、asyncio 核心机制

1. Future:一个"未来结果"的容器

-

定义 :

asyncio.Future是一个 低层级的对象 ,表示某个操作的结果还没就绪,但未来某个时刻会有。 -

类比 :就像一个 空快递盒子,快递员稍后会把东西放进去。你只能等待它变"已完成"。

-

特点:

- Future 自己 不会运行任务,只是一个结果的占位符。

- 别的代码(或事件循环)负责"填充"它的结果或异常。

python

import asyncio

async def main():

loop = asyncio.get_running_loop()

# 手动创建一个 Future

fut = loop.create_future()

# 模拟后台任务,2秒后设置结果

loop.call_later(2, fut.set_result, "完成!")

print("等待 Future 完成...")

result = await fut # await 会挂起,直到 Future 被 set_result

print("结果:", result)

asyncio.run(main())输出:

makefile

等待 Future 完成...

结果: 完成!👉 Future 本身只是一个"结果占位符",不会执行任何逻辑。

2. Task:Future 的子类,用来包装协程

-

定义 :

asyncio.Task是Future的一个子类,用来把 协程对象 (async def返回的对象)提交给事件循环调度执行。 -

类比:如果说 Future 是"空快递盒子",那 Task 就是"快递员接到订单,开始配送,最后把东西放进盒子"。

-

特点:

- Task 是自动驱动协程运行的 执行单元。

- Task 的结果就是协程的返回值,异常就是协程抛出的错误。

- 可以

awaitTask,就像等待 Future。

python

import asyncio

async def foo():

await asyncio.sleep(1)

return "foo 完成"

async def main():

# 直接创建 Task(事件循环立即调度 foo() 执行)

task = asyncio.create_task(foo())

print("任务已创建,等待执行...")

result = await task # 等待任务执行完成

print("结果:", result)

asyncio.run(main())输出:

makefile

任务已创建,等待执行...

结果: foo 完成👉 和 Future 的区别在于,Task 会主动驱动 foo() 运行,而 Future 只是"等别人塞结果"。

3. await 与 async

async定义协程函数。await挂起等待另一个协程完成。

4. gather 与 as_completed

asyncio.gather并发运行多个协程/任务。等待全部完成后,一次性返回结果(按输入顺序排列,而不是完成顺序)。

python

import asyncio

import random

async def worker(name: str, delay: int):

await asyncio.sleep(delay)

return f"任务 {name} 完成 (延迟 {delay}s)"

async def main():

print("开始执行 gather 示例...")

results = await asyncio.gather(

worker("A", random.randint(1, 3)),

worker("B", random.randint(1, 3)),

worker("C", random.randint(1, 3)),

)

print("所有任务完成,结果按输入顺序返回:")

for res in results:

print(res)

asyncio.run(main())输出:

scss

开始执行 gather 示例...

所有任务完成,结果按输入顺序返回:

任务 A 完成 (延迟 3s)

任务 B 完成 (延迟 3s)

任务 C 完成 (延迟 2s)asyncio.as_completed并发运行多个协程/任务,按完成顺序返回结果(按完成顺序,而不是输入顺序)。

python

import asyncio

import random

async def worker(name: str, delay: int):

await asyncio.sleep(delay)

return f"任务 {name} 完成 (延迟 {delay}s)"

async def main():

print("开始执行 as_completed 示例...")

tasks = [

worker("A", random.randint(1, 3)),

worker("B", random.randint(1, 3)),

worker("C", random.randint(1, 3)),

]

for coro in asyncio.as_completed(tasks):

result = await coro

print("获得结果:", result)

asyncio.run(main())输出:

makefile

开始执行 as_completed 示例...

获得结果: 任务 C 完成 (延迟 2s)

获得结果: 任务 B 完成 (延迟 2s)

获得结果: 任务 A 完成 (延迟 2s)5. 并发控制:Semaphore

信号量(Semaphore) 是一种并发控制原语,用来限制同时运行的任务数量。在异步编程中,如果你要启动很多并发任务,但外部资源有限(比如数据库连接池、API 请求限流、文件写入句柄数),就需要用 Semaphore 控制。

python

import asyncio, random

async def worker(sem, name):

async with sem:

print(f"{name} is working...")

await asyncio.sleep(random.uniform(0.5, 1.5))

print(f"{name} done")

async def main():

sem = asyncio.Semaphore(2) # 限制同时运行 2 个任务

tasks = [worker(sem, f"Task{i}") for i in range(5)]

await asyncio.gather(*tasks)

asyncio.run(main())6. Queue:生产者-消费者

队列(Queue) 是异步编程中最常见的任务调度结构。生产者负责生成任务(数据/请求),放入队列;消费者从队列中取出任务,执行处理。在高并发环境下,Queue 能让数据流动更有序,避免「一股脑全塞进去」导致资源耗尽。

python

import asyncio

async def producer(queue):

for i in range(5):

await queue.put(i)

print(f"Produced {i}")

await queue.put(None) # 结束标记

async def consumer(queue):

while True:

item = await queue.get()

if item is None:

break

print(f"Consumed {item}")

async def main():

queue = asyncio.Queue()

await asyncio.gather(producer(queue), consumer(queue))

asyncio.run(main())7. 超时与取消

python

import asyncio

async def slow_task():

await asyncio.sleep(5)

return "Finished"

async def main():

try:

result = await asyncio.wait_for(slow_task(), timeout=2)

except asyncio.TimeoutError:

print("Task timed out!")

asyncio.run(main())8. 在异步中执行同步任务:to_thread

如果在异步函数里直接调用同步的阻塞函数,会阻塞整个事件循环,导致所有其他协程都停滞,失去异步并发的意义。为了解决这个问题,Python 提供了把同步任务丢到线程池/进程池执行的方法。

python

import asyncio

import time

def blocking_task(x):

"""这是同步阻塞函数"""

print(f"计算 {x} 中...")

time.sleep(2) # 阻塞

return x * x

async def main():

# 把阻塞任务丢到后台线程执行,不会阻塞事件循环

results = await asyncio.gather(

asyncio.to_thread(blocking_task, 2),

asyncio.to_thread(blocking_task, 3),

)

print("结果:", results)

asyncio.run(main())六、异步编程生态

-

Web 框架:FastAPI、aiohttp、Sanic

-

数据库驱动:asyncpg、aiomysql、motor

-

消息队列:aio-pika、aiokafka

-

爬虫框架:Scrapy(已支持 asyncio)

pip install aiohttp

python

import aiohttp

import asyncio

async def fetch(session, url):

async with session.get(url) as resp:

return await resp.text()

async def main():

urls = ["https://example.com"] * 3

async with aiohttp.ClientSession() as session:

results = await asyncio.gather(*[fetch(session, url) for url in urls])

print([len(r) for r in results])

asyncio.run(main())七、高级机制与性能优化

1. uvloop

替换默认事件循环,性能提升可达数倍:

python

import uvloop, asyncio

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())2. 源码解读:调度核心

BaseEventLoop._run_once() 负责每轮事件循环:

- 从就绪队列取出任务

- 执行其回调或继续协程

- 处理超时/取消

- 等待新的 I/O 事件

理解这一点有助于你分析死锁、阻塞等问题。

3. 现代化库 Trio / Curio

相比 asyncio:

- Trio 提供"structured concurrency",避免悬挂任务。

- Curio 设计简洁,彻底 async/await 化。

八、大规模分布式异步架构设计

在分布式系统中,单机异步只是第一步,还要解决:

- 回压与限流:防止下游过载。

- 超时与重试:避免请求永久挂起。

- 断路器:下游不可用时快速失败。

- 幂等与一致性:结合 Outbox/SAGA 确保数据可靠。

- 事件驱动编排:Kafka + asyncio 消费任务。

- 可观测性:Prometheus 指标 + OpenTelemetry tracing。

- 优雅停机:传播取消信号,确保未完成任务能正确退出。

示例:异步爬虫

python

import aiohttp, asyncio

async def fetch(session, url):

async with session.get(url, timeout=5) as resp:

return await resp.text()

async def main(urls):

async with aiohttp.ClientSession() as session:

tasks = [asyncio.create_task(fetch(session, u)) for u in urls]

for coro in asyncio.as_completed(tasks):

try:

result = await coro

print(len(result))

except Exception as e:

print(f"Error: {e}")

urls = ["https://example.com"] * 100

asyncio.run(main(urls))这个爬虫同时请求 100 个 URL,遇到异常能快速处理,而不会阻塞整个系统。

九、常见陷阱

- 在异步代码中调用阻塞函数 (如

time.sleep())会卡住整个事件循环,必须使用asyncio.sleep()。 - 忘记 await:协程对象未被执行。

- 滥用并发:盲目开太多任务,可能导致内存暴涨。

十、总结

Python 异步编程的精髓在于:

- 利用协程与事件循环调度大量并发任务

- 依托 epoll/kqueue/IOCP 等系统调用高效处理 I/O

- 借助 asyncio、uvloop、Trio 等库实现生产级应用

- 在分布式架构中通过回压、限流、超时、可观测性保证系统健壮

掌握这些原理与实践,你将能设计出 高性能、高并发、可扩展 的 Python 系统。