随着大语言模型(LLM)的快速发展,单纯依赖原始模型已经无法满足复杂的业务需求。如何高效管理模型、构建多轮对话、集成外部工具和知识库、同时保证高性能推理,成为大模型落地的核心挑战。为此,越来越多工程化框架应运而生,如 LangChain、vLLM、LlamaIndex、Haystack 等,它们为大模型应用提供了完整的生态和工具链。

所有相关源码示例、流程图、模型配置与知识库构建技巧,我也将持续更新在Github:LLMHub,欢迎关注收藏!

希望大家带着下面的问题来学习,我会在文末给出答案。

- 大模型工程框架的核心组成和功能是什么?

- 各大框架(LangChain、vLLM、LlamaIndex 等)在生态中各自的定位如何?

- 如何选择合适的框架组合以满足不同的业务需求?

1. 大模型工程框架的核心组成

在大模型应用中,一个完整的工程化框架通常包含以下核心模块:

- 模型管理与推理引擎:负责加载和调度大模型,支持批量推理、流式生成、多模型协作等功能。

- Prompt 管理与执行:将业务逻辑转化为 Prompt,支持模板管理、动态组合、工具调用等。

- 工具与接口集成:封装外部 API、数据库、搜索引擎等资源,让模型可以调用外部知识或功能。

- 记忆与知识管理:长期记忆、多轮对话状态、知识库集成和向量索引。

- 系统与微服务架构:支持高可用、弹性扩展、日志监控和集群管理。

简单来说,工程化框架就是把大模型从单纯的推理工具,升级为可组合、可扩展、可服务化的业务平台。

2. 主要框架生态与定位

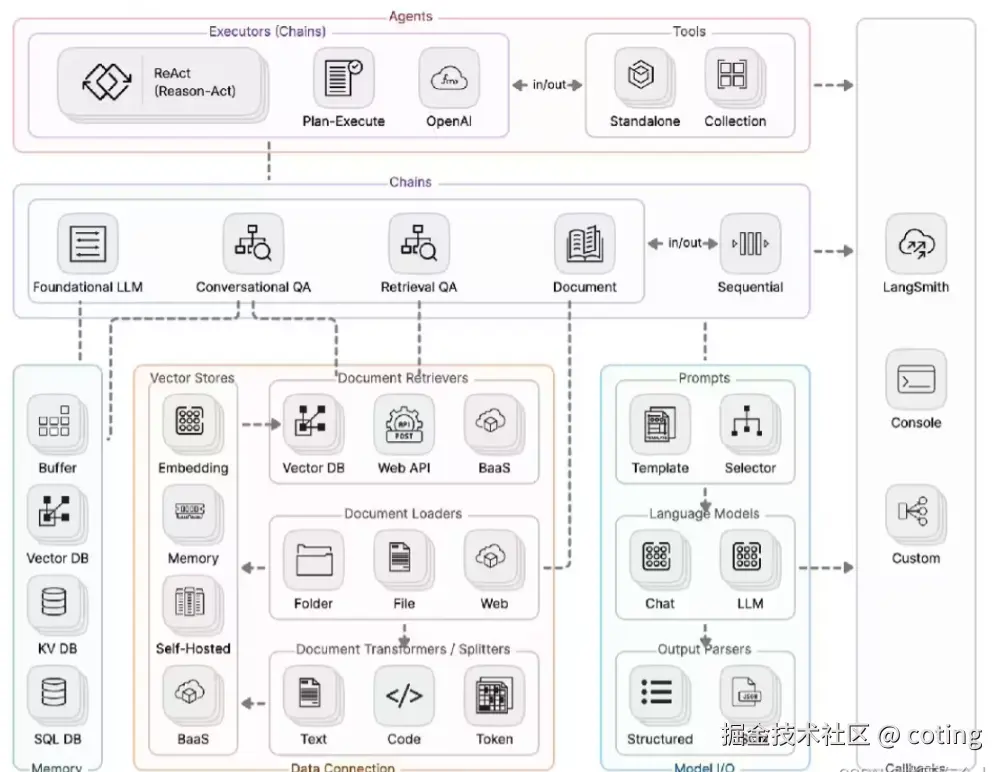

LangChain

- 定位:多模型与工具的"流程编排平台"。

- 核心功能:Chains、Agents、Memory、Tools。

- 优势 :

- 支持复杂任务分解和多模型协作

- 内置多种 Memory 管理模式,方便多轮对话

- 与知识库、搜索引擎等工具集成方便

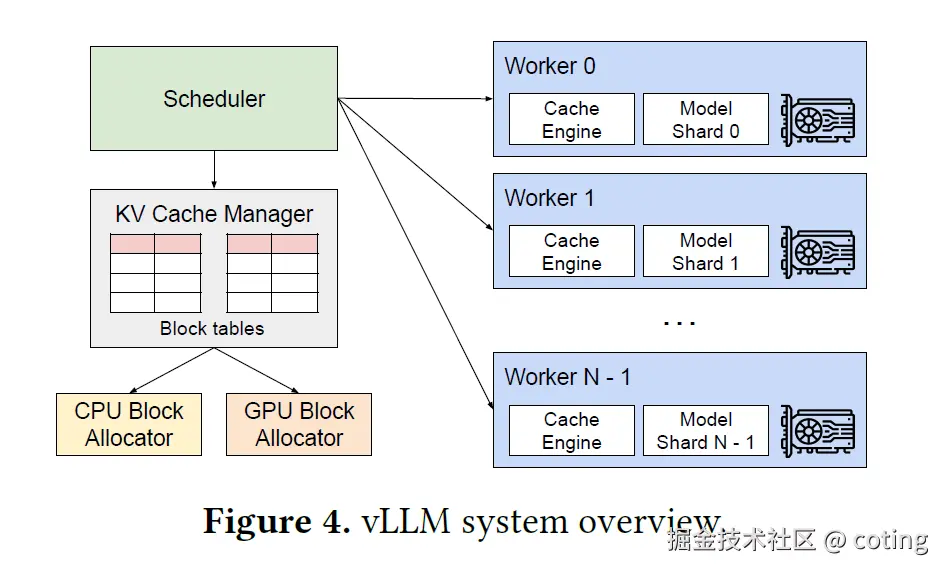

vLLM

- 定位:高性能推理引擎

- 核心功能:流水线化推理、批量调度、异步执行

- 优势 :

- 极大提升吞吐量,适合大规模在线服务

- 支持多模型协作和动态路由

- 与 LangChain 等框架无缝集成

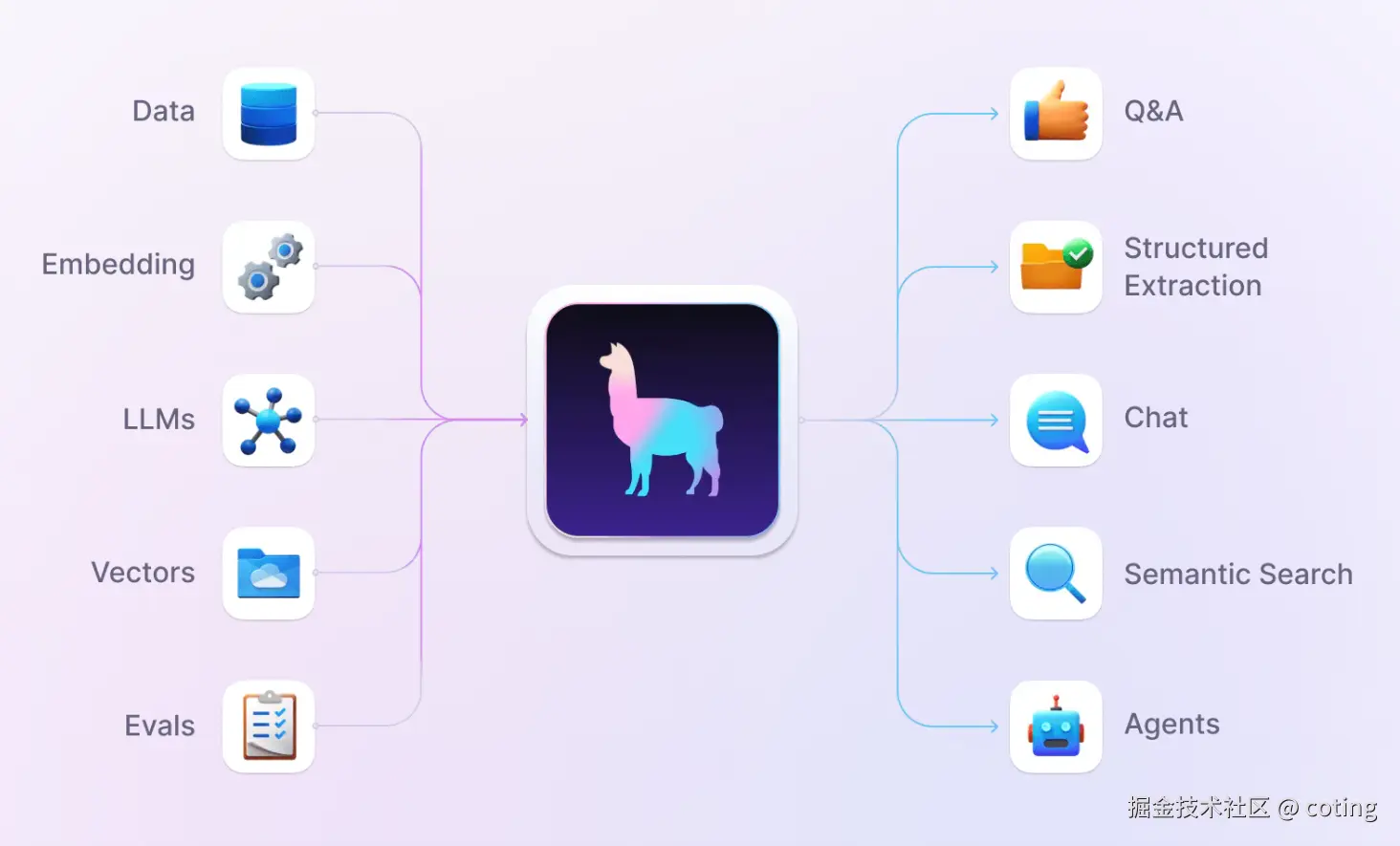

LlamaIndex / Haystack

- 定位:知识管理和检索增强生成(RAG)平台

- 核心功能:向量索引、文档管理、动态更新

- 优势 :

- 高效存储和检索知识库

- 可与 LLM 框架集成,实现知识增强生成

- 支持多数据源、多模态检索

3. 框架组合与应用实践

在实际业务中,通常需要多框架组合才能构建完整的大模型应用:

- LangChain + vLLM:LangChain 负责业务逻辑和 Agent 编排,vLLM 提供高吞吐量推理能力

- LangChain + LlamaIndex / Haystack:LangChain 调用知识检索接口,结合向量索引进行 RAG

- 多框架协作模式 :

- 用户请求到达服务

- LangChain 根据任务分解调用不同模型或工具

- vLLM 进行高性能推理

- 知识库模块提供外部信息

- Memory 模块维持多轮上下文

这种组合方式不仅提高了系统性能,也增强了业务逻辑的灵活性和可扩展性。

最后,我们回答一下文章开头提出的问题

- 大模型工程框架的核心组成是什么?

核心组成包括模型管理与推理引擎、Prompt 管理、工具接口集成、记忆与知识管理、微服务化系统架构。 - 各大框架在生态中的定位如何?

- LangChain:业务流程与多模型编排平台

- vLLM:高性能推理引擎

- LlamaIndex / Haystack:知识管理与 RAG 支持

- 如何选择合适的框架组合以满足业务需求?

- 业务复杂、需要多模型协作 → LangChain + vLLM

- 需要知识增强生成 → LangChain + LlamaIndex / Haystack

- 高吞吐量在线服务 → vLLM + LangChain 流程编排

关于深度学习和大模型相关的知识和前沿技术更新,请关注公众号 coting!

以上内容部分参考了相关开源文档与社区资料。非常感谢,如有侵权请联系删除!

参考链接