在 Elasticsearch(简称 ES)的全文检索能力中,分词器(Analyzer)是当之无愧的 "核心引擎"。它直接决定了文本数据如何被拆解、处理和索引,进而影响查询的准确性与效率。无论是构建电商商品搜索、日志分析系统,还是企业级文档检索平台,理解分词器的作用与选择逻辑,都是实现高效搜索的基础。

一、分词器的核心作用:连接 "文本" 与 "检索" 的桥梁

分词器的本质是将原始文本转化为可被 ES 索引和查询的最小语义单元(Term),整个过程贯穿 "索引建立" 和 "查询匹配" 两大核心环节,具体作用可拆解为以下三点:

1. 文本标准化:消除 "形式差异",实现 "语义统一"

原始文本往往存在大量 "形式不同但语义相同" 的表述,例如 "iPhone 15" 与 "iphone15"、"2024 年" 与 "2024"、"开心" 与 "开开心心"。分词器通过标准化处理(如大小写转换、特殊字符过滤、同义词替换、词干提取),将这些差异统一为相同的 Term,确保查询时不会因格式问题遗漏结果。

举个例子:

当用户输入 "iphone 15" 查询时,若分词器未做大小写转换,索引中存储的 "iPhone 15" 将无法被匹配;而经过标准化后,两者均被处理为 "iphone15",实现精准命中。

2. 语义拆分:适配语言特性,拆解 "有效单元"

不同语言的文本结构差异极大(如中文无空格分隔、英文有明确空格),分词器的核心任务之一是根据语言规则拆分出有实际语义的单元,而非简单按字符或空格切割。

- 英文场景:将 "The quick brown fox" 拆分为 ["the", "quick", "brown", "fox"],同时通过 "词干提取"(Stemming)将 "running""ran" 统一为 "run",确保 "run" 的查询能匹配到所有相关时态的文本。

- 中文场景:若直接按字符拆分 "Elasticsearch 分词器",会得到 ["Elasticsearch", "分", "词", "器"],失去 "分词器" 这一核心语义;而专业中文分词器(如 IK)能精准拆分为 ["elasticsearch", "分词器"],更符合中文检索习惯。

3. 噪声过滤:剔除 "无意义信息",提升索引效率

原始文本中常包含大量对检索无意义的 "噪声",如英文中的 "the""a""is"(停用词)、中文中的 "的""了""在",以及标点符号、特殊符号(如 "@""#")。分词器通过 "停用词过滤""符号清洗" 等操作,剔除这些无效信息,既能减少索引存储占用 ,又能避免无意义 Term 干扰查询结果(例如查询 "Elasticsearch 教程" 时,不会因 "的" 而匹配无关文本)。

二、分词器的场景化选择:匹配业务需求是关键

ES 提供了多种内置分词器(如 Standard、Simple、Whitespace),同时支持集成第三方分词器(如 IK、Pinyin、HanLP)。不同分词器的设计目标不同,选择时需结合语言类型"业务场景""检索精度要求" 三大维度,以下是典型场景的选择建议:

1. 通用英文场景:优先选择 Standard 分词器

- 适用场景:英文文档检索、英文商品标题搜索(如亚马逊英文站)、英文日志分析等。

- 核心优势:默认支持 "大小写转换""标点符号过滤""词干提取"(需配合 Porter Stemmer 过滤器),能满足大部分英文通用检索需求,且配置简单无需额外依赖。

- 示例:输入文本 "Elasticsearch: The Definitive Guide (2nd Edition)",经 Standard 分词器处理后,会得到 ["elasticsearch", "the", "definitive", "guide", "2nd", "edition"](自动去除冒号、括号,转换为小写)。

2. 中文检索场景:必须使用专业中文分词器(以 IK 为例)

- 适用场景:中文新闻检索、中文电商商品搜索(如淘宝、京东)、企业中文文档库(如合同、手册)等。

- 核心原因:ES 内置分词器(如 Standard)对中文仅能按字符拆分,无法处理 "词语" 语义,而 IK 分词器支持 "细粒度" 和 "粗粒度" 两种拆分模式,适配不同检索需求:

-

- IK 细粒度(ik_max_word):最大化拆分语义单元,适合 "精准查询" 场景。例如 " Elasticsearch 中文分词器教程" 会拆分为 ["elasticsearch", "中文", "分词", "分词器", "教程"],能匹配 "中文分词""分词器教程" 等细分查询。

-

- IK 粗粒度(ik_smart):最小化拆分语义单元,适合 "模糊匹配" 或 "减少冗余 Term" 场景。例如同一文本会拆分为 ["elasticsearch", "中文", "分词器", "教程"],避免过多细分 Term 占用存储空间。

- 扩展建议:若需支持 "拼音检索"(如输入 "fenciqi" 匹配 "分词器"),可在 IK 基础上叠加 Pinyin 分词器,实现 "汉字 + 拼音" 双维度检索。

3. 精确匹配场景:选择 Whitespace 或 Keyword 分词器

- 适用场景:身份证号检索、手机号查询、订单号匹配、标签精确搜索(如 "# 技术分享" 必须完整匹配)等。

- 核心逻辑:这类场景不需要语义拆分,只需 "完整保留原始文本" 或 "按空格拆分",避免分词器破坏关键信息。

-

- Whitespace 分词器:仅按空格拆分文本,不做任何大小写转换或符号过滤。例如 "Order-No: 12345 2024" 会拆分为 ["Order-No:", "12345", "2024"],适合需要保留特殊符号的精确匹配。

-

- Keyword 分词器:不做任何拆分,将整个文本作为一个 Term。例如 "110101199001011234"(身份证号)会直接存储为一个 Term,确保只有完整输入时才能匹配,避免部分匹配导致的错误结果。

4. 日志 / 代码检索场景:选择 Simple 或 Pattern 分词器

- 适用场景:服务器日志分析(如 "2024-09-22 10:30: ERROR [API] Timeout")、代码片段检索(如 "function getUser ()")等。

- 核心需求:按 "非字母数字" 字符拆分,保留数字、字母等关键信息,忽略符号干扰。

-

- Simple 分词器:将非字母字符视为分隔符,自动转换为小写。例如日志文本会拆分为 ["2024", "09", "22", "10", "30", "error", "api", "timeout"],便于按 "ERROR""timeout" 等关键词筛选日志。

-

- Pattern 分词器:支持自定义正则表达式拆分规则,适合复杂格式的文本。例如代码检索中,可通过正则 "[a-zA-Z_]+" 仅提取变量名、函数名(如 "getUser""function"),过滤括号、引号等符号。

5. 多语言混合场景:使用 Multi-field + 多分词器组合

- 适用场景:跨国电商平台(如商品标题包含 "iPhone 15 苹果手机")、多语言文档库(如中英文混合手册)等。

- 核心方案:通过 ES 的 "Multi-field" 特性,为同一字段配置多种分词器,实现 "不同语言维度的独立检索"。例如:

-

- 对 "product_title" 字段,同时配置:

-

-

- IK 分词器(处理中文部分,如 "苹果手机");

-

-

-

- Standard 分词器(处理英文部分,如 "iPhone 15");

-

-

-

- Pinyin 分词器(处理中文拼音,如 "pingguo shouji")。

-

-

- 查询时,可根据用户输入语言(中文 / 英文 / 拼音),指定对应的分词器字段进行匹配,兼顾多语言检索需求。

三、总结:分词器选择的核心原则

- 优先匹配语言特性:中文必须用专业中文分词器(IK/HanLP),英文优先用 Standard,避免 "字符级拆分" 导致的语义丢失;

- 紧扣业务检索目标:精确匹配(如身份证号)用 Keyword/Whitespace,模糊语义检索(如中文新闻)用 IK 细粒度,平衡效率与精度;

- 灵活组合扩展:复杂场景(如多语言、拼音检索)可通过 "分词器 + 过滤器"(如 IK+Pinyin)或 "Multi-field" 实现,而非依赖单一分词器;

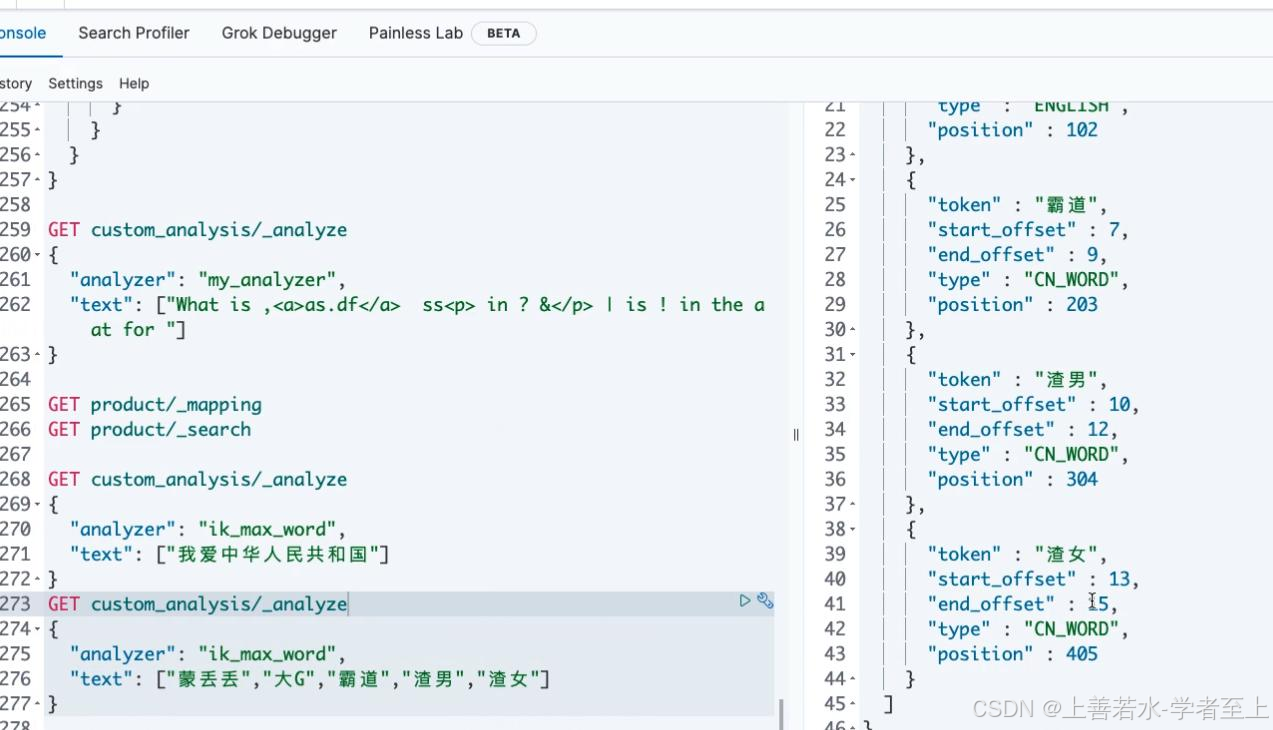

- 测试验证不可少:选择后需通过 ES 的 _analyze API 测试分词结果(如 GET /_analyze { "analyzer": "ik_max_word", "text": " Elasticsearch 分词器" }),确保符合预期。

总之,分词器是 ES 全文检索的 "基石",其选择直接决定了检索体验的优劣。只有结合业务场景精准选型,才能充分发挥 ES 的检索能力,实现 "查得准、查得快" 的目标。