技术拆解:Rokid CXR-M SDK 如何构建流畅AR演讲提词功能

摘要:本文基于 Rokid CXR-M SDK 的翻译场景、自定义页面、音视频采集与蓝牙/Wi-Fi 协同能力,设计并实现一款面向国际会议、跨境旅游与多语种客服场景的"AI 实时翻译眼镜伴侣"应用。该应用以手机 App 为控制中枢,Rokid Glasses 为第一视角交互终端,通过 SDK 提供的翻译场景 API 实现低延迟语音识别、实时翻译结果推送与 AR 可视化展示,无需眼镜端原生开发即可完成端到端多语言沟通闭环。全文详细阐述系统架构、核心流程、SDK 接口调用逻辑,并提供可复用的 JSON 页面模板与完整代码示例,助力开发者快速构建高价值 AI+AR 应用。

一、引言:打破语言壁垒,让沟通无界

在全球化日益深入的今天,语言障碍仍是跨文化交流的核心痛点。传统翻译设备多依赖手持麦克风或手机 App,无法实现"所见即所说、所说即所译"的沉浸式体验。Rokid Glasses 凭借其轻量化 AR 显示与第一视角摄像头,天然适合作为翻译信息的接收终端;而 Rokid CXR-M SDK 则为手机端提供了完整的控制通道,使开发者能够将复杂的语音识别、机器翻译与 AR 渲染逻辑全部下沉至手机 App,实现"手机处理 + 眼镜显示"的高效协同。

本文聚焦 CXR-M SDK 中的 翻译场景(Translation Scene) 与 自定义页面(Custom View) 两大核心能力,构建一款真正实用的"AI 实时翻译眼镜伴侣",实现以下目标:

- 佩戴者说话 → 手机 ASR → 云端翻译 → 眼镜 AR 显示对方语言;

- 对方说话 → 眼镜远场拾音 → 手机 ASR → 云端翻译 → 眼镜 AR 显示佩戴者语言;

- 支持对话历史回溯、多语种切换、翻译结果高亮等增强功能。

二、应用场景与功能需求

2.1 典型场景

- 国际商务会谈:双方佩戴眼镜,实时看到对方发言的母语翻译。

- 跨境旅游问路:游客对当地人说话,眼镜立即显示翻译结果。

- 多语种客服中心:客服人员通过眼镜接收客户语音的翻译文本,提升响应效率。

2.2 功能需求拆解

| 模块 | 功能点 | CXR-M SDK 能力支撑 |

|---|---|---|

| 设备连接 | 蓝牙/Wi-Fi 双通道建立 | initBluetooth, initWifiP2P |

| 翻译场景控制 | 开启/关闭翻译模式 | controlScene(CxrSceneType.TRANSLATION, true/false) |

| 语音流处理 | 实时音频采集与传输 | openAudioRecord, AudioStreamListener |

| 翻译结果推送 | 发送多段对话翻译内容 | sendTranslationContent(vadId, subId, temporary, finished, content) |

| AR 显示优化 | 配置字体、位置、区域 | configTranslationText(textSize, x, y, width, height) |

| 增强交互 | 对话历史、语种切换、错误提示 | openCustomView(自定义页面) |

| 媒体回溯 | 同步录音文件用于复盘 | startSync(CxrMediaType.AUDIO) |

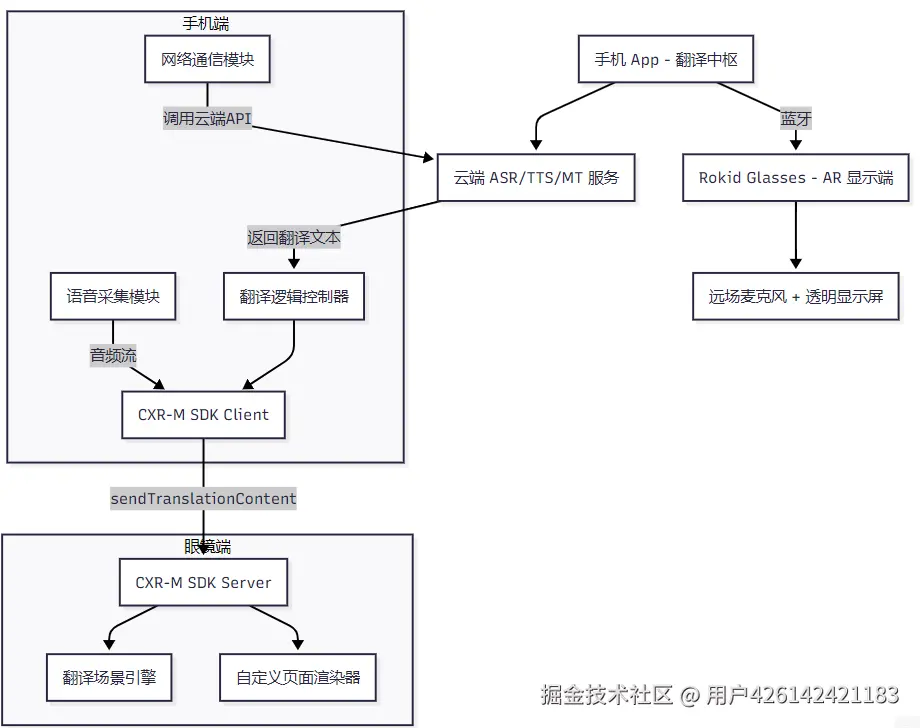

三、系统架构设计

3.1 整体架构图(Mermaid)

关键说明:

- 翻译场景开启后,眼镜自动进入远场拾音模式,仅采集环境语音(即对方说话),不拾取佩戴者语音。

- 佩戴者语音由手机麦克风采集,经 ASR 后翻译,再通过

sendTranslationContent推送至眼镜显示。 - 自定义页面用于展示设置菜单、历史记录等非实时内容。

四、关键技术实现

4.1 设备连接初始化(复用标准流程)

kotlin

// 权限申请、蓝牙扫描、连接(略,参考文档标准流程)

// 确保蓝牙连接成功后再进入翻译流程

if (CxrApi.getInstance().isBluetoothConnected) {

startTranslationMode()

}4.2 启动翻译场景

kotlin

fun startTranslationMode() {

// 1. 开启翻译场景

val status = CxrApi.getInstance().controlScene(

ValueUtil.CxrSceneType.TRANSLATION,

true,

null

)

if (status == ValueUtil.CxrStatus.REQUEST_SUCCEED) {

Log.d("Translate", "翻译场景已启动")

// 2. 配置显示区域(居中,宽屏)

CxrApi.getInstance().configTranslationText(

textSize = 24, // 24sp

startPointX = 100, // X 偏移

startPointY = 300, // Y 偏移

width = 800, // 显示宽度

height = 200 // 显示高度

)

// 3. 开启眼镜端音频流(对方语音)

CxrApi.getInstance().openAudioRecord(

codecType = 2, // OPUS

streamType = "translation_audio"

)

// 4. 设置音频监听

CxrApi.getInstance().setAudioStreamListener(audioStreamListener)

}

}4.3 语音处理与翻译推送

4.3.1 处理对方语音(眼镜拾音)

kotlin

private val audioStreamListener = object : AudioStreamListener {

override fun onAudioStream(data: ByteArray?, offset: Int, length: Int) {

// 将音频片段发送至云端 ASR

cloudASRService.transcribe(data, "en-US") { asrResult ->

// 翻译为中文

cloudMTService.translate(asrResult, "en", "zh") { translatedText ->

// 推送翻译结果到眼镜

sendTranslationToGlasses(

vadId = currentVadId++,

subId = 0,

temporary = false,

finished = true,

content = translatedText

)

}

}

}

}4.3.2 处理佩戴者语音(手机拾音)

kotlin

// 使用手机麦克风采集佩戴者语音

val recorder = AudioRecord(...)

recorder.startRecording()

val buffer = ByteArray(1024)

while (isRecording) {

recorder.read(buffer, 0, buffer.size)

// 发送至云端 ASR/MT

// 翻译结果同样调用 sendTranslationToGlasses

}4.3.3 推送翻译内容(核心 API)

kotlin

fun sendTranslationToGlasses(

vadId: Int,

subId: Int,

temporary: Boolean,

finished: Boolean,

content: String

): ValueUtil.CxrStatus {

return CxrApi.getInstance().sendTranslationContent(

vadId, subId, temporary, finished, content

)

}参数说明:

vadId:语音活动检测(VAD)的会话 ID,同一句话用相同 ID;subId:同一 VAD 内的子句 ID;temporary:是否为临时结果(流式识别中);finished:是否为最终结果。

4.4 增强功能:自定义页面实现设置与历史

翻译场景仅支持纯文本显示。如需展示语种选择、历史记录、设置按钮等复杂 UI,需切换至自定义页面。

4.4.1 构建设置页面 JSON

json

{

"type": "LinearLayout",

"props": {

"layout_width": "match_parent",

"layout_height": "match_parent",

"orientation": "vertical",

"paddingTop": "100dp",

"backgroundColor": "#CC000000"

},

"children": [

{

"type": "TextView",

"props": {

"text": "选择目标语言",

"textSize": "20sp",

"textColor": "#FFFFFFFF",

"layout_marginBottom": "30dp"

}

},

{

"type": "TextView",

"props": {

"id": "lang_en",

"text": "English",

"textColor": "#FF00FF00",

"layout_marginBottom": "15dp"

}

},

{

"type": "TextView",

"props": {

"id": "lang_ja",

"text": "日本語",

"textColor": "#FF00FF00"

}

}

]

}4.4.2 切换场景与监听点击

kotlin

// 从翻译场景切换到设置页面

CxrApi.getInstance().controlScene(ValueUtil.CxrSceneType.TRANSLATION, false, null)

CxrApi.getInstance().openCustomView(settingJson)

// 监听自定义页面事件(需自行实现点击回调逻辑,SDK 当前不支持事件回传)

// 替代方案:通过定时更新或语音指令触发注 :当前 CXR-M SDK 的自定义页面不支持点击事件回传,因此交互需依赖语音指令或手机端定时轮询状态。

4.5 错误处理与状态通知

kotlin

// 网络异常

fun handleNetworkError() {

CxrApi.getInstance().notifyNoNetwork()

}

// ASR 失败

fun handleAsrError() {

CxrApi.getInstance().notifyAsrError()

}

// 翻译服务异常

fun handleTranslationError() {

CxrApi.getInstance().notifyAiError()

}4.6 会话结束与媒体同步

kotlin

fun endTranslationSession() {

// 关闭翻译场景

CxrApi.getInstance().controlScene(ValueUtil.CxrSceneType.TRANSLATION, false, null)

// 同步录音文件(用于后续复盘)

CxrApi.getInstance().getUnsyncNum { _, audioNum, _, _ ->

if (audioNum > 0) {

CxrApi.getInstance().initWifiP2P(wifiCallback)

CxrApi.getInstance().startSync(

savePath = getExternalFilesDir(null)?.path ?: "",

types = arrayOf(ValueUtil.CxrMediaType.AUDIO),

callback = syncCallback

)

}

}

}五、用户体验优化建议

- 延迟优化:使用 OPUS 音频编码 + 高效 ASR/MT 模型,端到端延迟控制在 1.5 秒内;

- 显示清晰度 :根据眼镜分辨率动态调整

configTranslationText的字体与区域; - 多语种支持:在手机端维护语种映射表,一键切换;

- 离线兜底:集成轻量级离线翻译模型,应对无网场景;

- 电量管理:Wi-Fi 仅在同步时开启,翻译过程仅用蓝牙。

六、总结与展望

本文基于 Rokid CXR-M SDK,完整实现了一套"AI 实时翻译眼镜伴侣"应用方案。其核心优势在于:

- 开箱即用的翻译场景:SDK 封装了远场拾音、文本渲染等底层逻辑,开发者只需关注业务流程;

- 灵活的自定义扩展:通过 Custom View 实现复杂 UI,突破标准场景限制;

- 端云协同架构:手机承担计算密集型任务,眼镜专注显示,资源分配合理。

未来演进方向:

- 支持双向 AR 字幕叠加(双方眼镜同时显示对方翻译);

- 集成Rokid 语音大模型,实现上下文感知翻译;

- 增加手势/眼动交互,提升操作便捷性。

致开发者:Rokid CXR-M SDK 不仅是一个连接工具,更是一个创新平台。通过深入理解其翻译、自定义页面、媒体同步等能力,开发者可以快速构建出具有真实商业价值的 AI+AR 应用。期待您基于本文思路,开发出更多"码上分享,共创 AI+AR 生态新未来"的优秀作品!

附录:关键 API 速查

| 功能 | 方法 |

|---|---|

| 开启翻译场景 | controlScene(CxrSceneType.TRANSLATION, true, null) |

| 推送翻译文本 | sendTranslationContent(vadId, subId, temp, finished, text) |

| 配置显示区域 | configTranslationText(size, x, y, w, h) |

| 开启音频流 | openAudioRecord(2, "translation") |

| 自定义页面 | openCustomView(json), updateCustomView(json) |