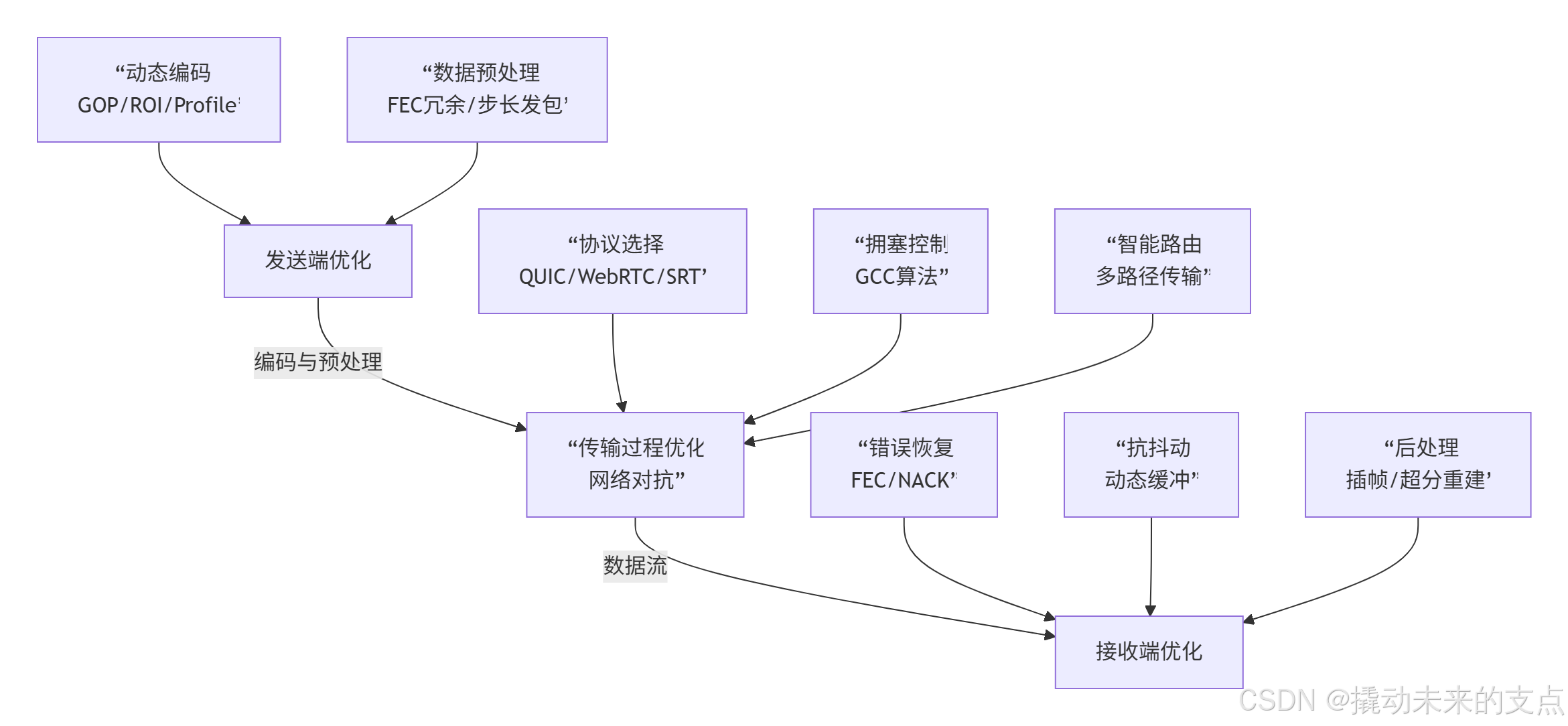

主要从三个角度优化,对应视频传输的三个过程:

- 发送端:优化编码配置,使用动态自适应码率ABR,减少传输数据量

- 传输过程:减少重传与等待,提高传输效率

- 接收端:增加缓冲,切换视频源,提高播放稳定性。

以下是详细技术方案:

在弱网环境下保障视频流畅传输,确实需要从发送端 、传输过程 和接收端三个环节进行系统性优化。下面这张图直观展示了这三个环节如何协同工作,以及其中涉及的核心技术点。

下面,我们就按照这三个环节,详细拆解其中的关键技术。

发送端优化

发送端是视频数据的源头,其优化重点在于**"聪明的压缩"和"稳健的发送"**,力求在源头减少数据量并提升其对抗网络波动的韧性。

-

智能视频编码与参数动态调整

编码器需要根据实时的网络状况动态调整参数,以实现压缩效率与画质间的平衡。

- GOP(图像组)结构优化 :适当缩短GOP长度(如1-2秒),增加I帧频率。这虽然会略微降低压缩效率,但能让接收端在丢包后更快地获得完整参考帧(I帧),加速画面恢复,减少花屏持续时间。

- ROI(感兴趣区域)编码 :利用人眼视觉特性,对画面中关键区域(如人脸、文本)采用更低量化参数(QP) 以保留更多细节,同时对非关键背景区域进行较强压缩。这样可在总码率不变的情况下,显著提升主观视觉清晰度。

- H.264 Profile选择 :在弱网且对延迟极度敏感的场景(如视频会议),优先使用 Baseline Profile ,因为它编解码更简单,延迟更低。若对画质要求高且网络有一定保障,可选用压缩效率更高的 High Profile。

-

数据预处理与发送控制

在数据打包发送前,通过一系列技术增强其抗丢包能力并平滑网络流量。

- 前向纠错(FEC):在发送原始数据包的同时,按一定比例(如10%)生成并发送冗余数据包。这样,接收端在部分丢包(如丢包率在10%以下)时,可直接利用冗余包恢复数据,无需请求重传,从而避免延迟。

- 步长发送器(Paced Sender) :避免编码后立即将所有数据爆发式发送到网络,而是根据评估的可用带宽,将数据包均匀地分布在微小时间片(如5ms)内发送。这能有效平滑网络流量,避免瞬时高峰冲击本已脆弱的网络,从而降低丢包和抖动。

传输过程优化

传输过程优化核心在于路径选择 和流量控制,旨在为数据寻找最稳定、最高效的传输路径。

-

高效传输协议的选择

- QUIC/WebRTC协议 :基于UDP,可实现0-RTT/1-RTT快速连接,有效降低握手延迟。其内置的多路复用和前向纠错能力,使其在对抗丢包和网络抖动方面表现优异,非常适合实时互动场景。

- SRT协议:专为不稳定网络设计,通过ARQ(自动重传请求)和FEC混合机制,在保障可靠性的同时控制延迟,尤其适合跨境直播等场景。

-

动态带宽评估与拥塞控制

- GCC算法 :这是WebRTC默认使用的核心算法。它通过延时梯度估计 (测量数据包到达时间间隔的变化)和丢包率相结合的方式来综合评估当前可用带宽。一旦检测到网络拥塞迹象(延时增加),发送端会主动降低发送码率,从而避免更严重的丢包,实现"未雨绸缪"式的流量控制。

-

多路径与智能路由

- 系统可同时监测多条网络路径(如Wi-Fi和4G/5G)的状态(带宽、延迟、丢包率)。当主路径质量下降时,可自动、平滑地将数据流切换至更优的备用路径,从而提升整体连接的稳定性。参考MPTCP技术,多路径互补传输或冗余传输方案。

接收端优化

接收端是保障最终用户体验的最后一道防线,其核心任务是修复损伤 和平滑播放。

-

错误恢复与丢包处理

- FEC解码:当发生丢包时,首先尝试利用发送端附加的FEC冗余包进行恢复。

- 选择性重传(NACK) :如果FEC无法修复(如丢包过多),接收端会通过RTCP协议向发送端有选择性地请求重传丢失的关键数据包(如I帧),而非全部重传,以兼顾效率和延迟。

-

抗抖动与平滑播放

- 动态抖动缓冲(Jitter Buffer) :接收端会设置一个缓冲区,其大小可根据网络抖动的严重程度动态调整 。公式可简化为:

buffer_size = base_delay + α × jitter。这能有效吸收数据包到达时间的波动,将其转换为均匀的视频帧输出,显著减少卡顿。

- 动态抖动缓冲(Jitter Buffer) :接收端会设置一个缓冲区,其大小可根据网络抖动的严重程度动态调整 。公式可简化为:

-

后处理与图像增强

- 智能插帧(Frame Interpolation) :在弱网导致帧率过低(如低于10fps)时,插帧处理器会基于前后帧的内容,智能地生成并插入中间帧,从而提升视觉上的流畅度。

- 超分辨率重建 :当接收到的视频因带宽不足而分辨率大幅缩减时,可利用深度学习算法对图像进行超分辨率重建 ,尽可能恢复细节,提升主观清晰度。这个技术比较新潮,主要原理是利用神经网络将低分辨率图像重建为高分辨率图像,支持单图像重建和多图像重建,参考《图像超分辨率重建综述》。

总结与协同

总而言之,弱网视频传输优化是一个环环相扣的系统工程。发送端 负责"强筋健骨"(高效编码和冗余),传输过程 负责"找对路"(智能选路和控速),接收端则负责"疗伤复原"(纠错和平滑)。这三者紧密协作,共同确保了用户在恶劣网络条件下也能获得相对流畅、清晰的视频体验。

希望这份从三个环节入手的梳理,能帮助您更系统地理解弱网优化的技术全貌。