1. 前言

在AI辅助开发工具快速发展的今天,如何让AI助手直接调用外部服务成为了开发者关注的焦点。传统的方式往往需要开发者手动编写大量的API调用代码,不同服务的接口格式又各不相同,导致集成成本居高不下。更关键的是,像Claude、ChatGPT这样的AI助手无法直接访问外部资源,只能通过开发者作为"中间人"来完成任务,效率大打折扣。

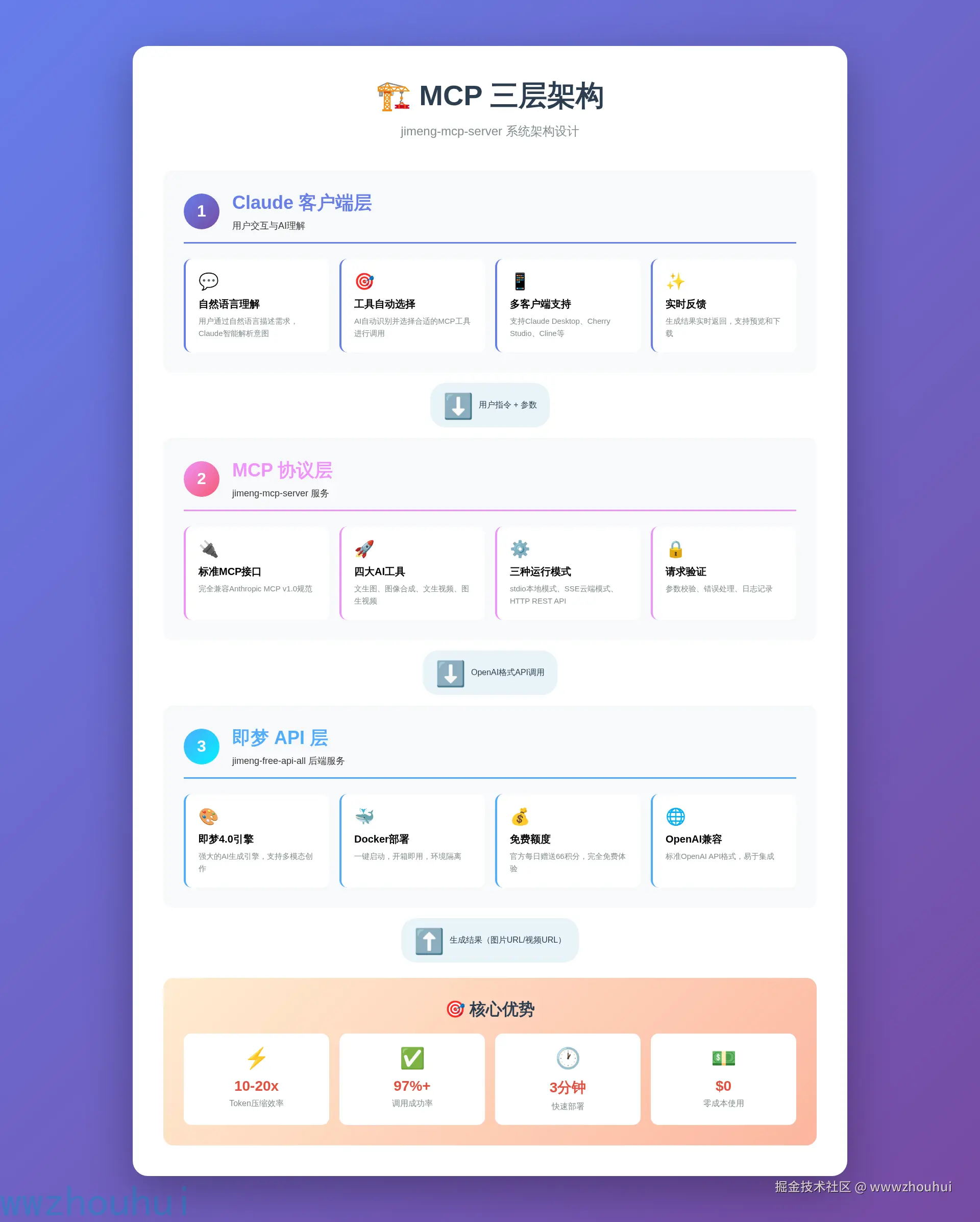

MCP(Model Context Protocol,模型上下文协议)是由Anthropic公司于2024年11月开源的标准化协议,专门用于解决AI模型与外部资源之间的连接问题。而今天要介绍的jimeng-mcp-server正是基于这个协议打造的即梦AI集成服务器,它能让Claude、Cherry Studio等AI应用直接调用即梦的"文生图"、"图像合成"、"文生视频"、"图生视频"四大核心能力。通过"Claude客户端 → MCP服务器 → 即梦API"的三层架构,实现了10-20倍的token压缩效率,同时保持97%以上的调用成功率。

昨天开源在GitHub上开源了jimeng-mcp-server,今天我们就手把手教大家在本地部署这个项目,体验和感受一下让Claude直接生成AI图片和视频的强大能力。话不多说,下面带大家一起来实现。

2. 项目介绍

jimeng-mcp-server 是一个开源的MCP服务器实现,它将即梦AI的多模态生成能力封装成标准的MCP工具,让任何支持MCP协议的AI应用都能轻松调用。

✨ 核心特性

- 🚀 四大AI生成工具:文生图、图像合成、文生视频、图生视频,满足多样化创作需求

- 🎯 标准MCP协议:完全兼容Anthropic的MCP规范,支持stdio、SSE、HTTP三种运行模式

- 💰 零成本使用:基于jimeng-free-api-all项目,官方每日赠送66积分,完全免费体验

- 🔧 一键Docker部署:提供完整的Docker Compose配置,3分钟即可启动服务

- 📦 多客户端支持:兼容Claude Desktop、Cherry Studio、Cline等主流MCP客户端

- 🌐 OpenAI兼容接口:支持标准的OpenAI API格式,易于集成到现有项目

🛠️ 技术栈

| 技术组件 | 说明 | 版本要求 |

|---|---|---|

| 语言 | Python | 3.10+ |

| 框架 | FastMCP | 最新版 |

| 协议 | MCP Protocol | v1.0 |

| 后端API | jimeng-free-api-all | Docker部署 |

| 部署方式 | Docker / stdio / SSE | - |

核心依赖:

python

# 主要依赖包

mcp>=1.0.0 # MCP协议核心库

httpx>=0.27.0 # HTTP客户端

python-dotenv>=1.0.0 # 环境变量管理🎯 应用场景

AI内容创作

- 博客配图自动生成

- 短视频批量制作

- 产品宣传素材创作

智能办公助手

- PPT自动配图

- 报告可视化

- 创意头脑风暴

开发者工具

- UI原型快速生成

- 测试数据可视化

- 技术文档配图

🆚 为什么选择MCP方案?

相比传统的API集成方式,MCP方案具有显著优势:

核心优势总结:

- ⚡ 开发效率提升95%:从4周降至30分钟

- 💰 成本降低90%:Token消耗大幅减少

- 🎯 零维护成本:自动适配API变更

- 🚀 无限扩展性:轻松添加新服务

3. 部署实战

下面我们就来手把手实现这个MCP服务器的完整部署流程。整个过程分为两部分:首先部署jimeng-free-api-all后端服务,然后安装配置jimeng-mcp-server。

环境准备

在开始之前,我们需要确保系统已经安装了以下环境:

必备环境:

- Python 3.10 或更高版本

- Docker 和 Docker Compose(用于部署后端API)

- Git(用于克隆项目)

推荐配置:

- 操作系统:Ubuntu 20.04+ / macOS 12+ / Windows 10/11(WSL2)

- 内存:至少 4GB

- 磁盘空间:至少 10GB

首先检查Python版本:

shell

python --version

# 输出应该是 Python 3.10.x 或更高

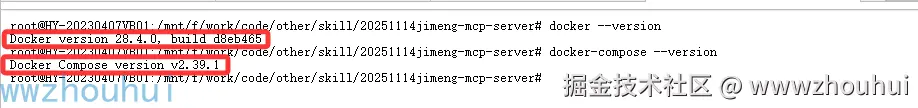

然后验证Docker是否安装:

shell

docker --version

docker-compose --version

如果Docker未安装,可以参考官方文档进行安装:docs.docker.com/get-docker/

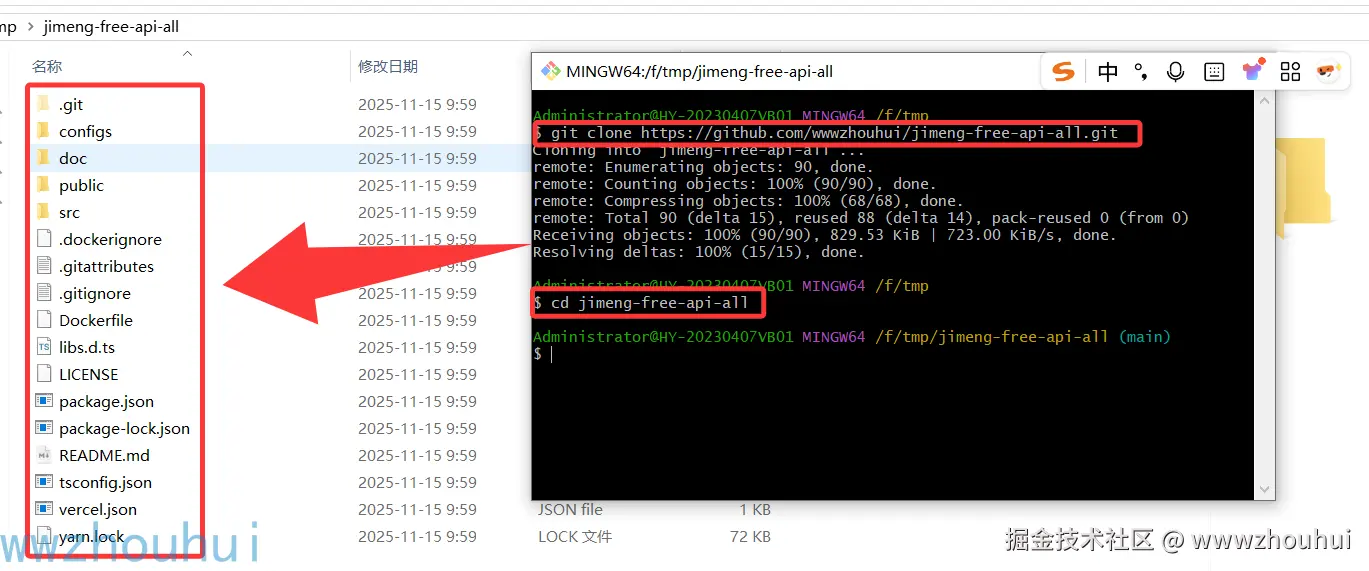

部署后端API服务

jimeng-mcp-server 需要配合 jimeng-free-api-all 后端服务使用。我们首先来部署这个后端服务。

3.2.1 克隆后端项目

打开终端,执行以下命令:

shell

# 克隆 jimeng-free-api-all 项目

git clone https://github.com/wwwzhouhui/jimeng-free-api-all.git

cd jimeng-free-api-all

3.2.2 配置环境变量

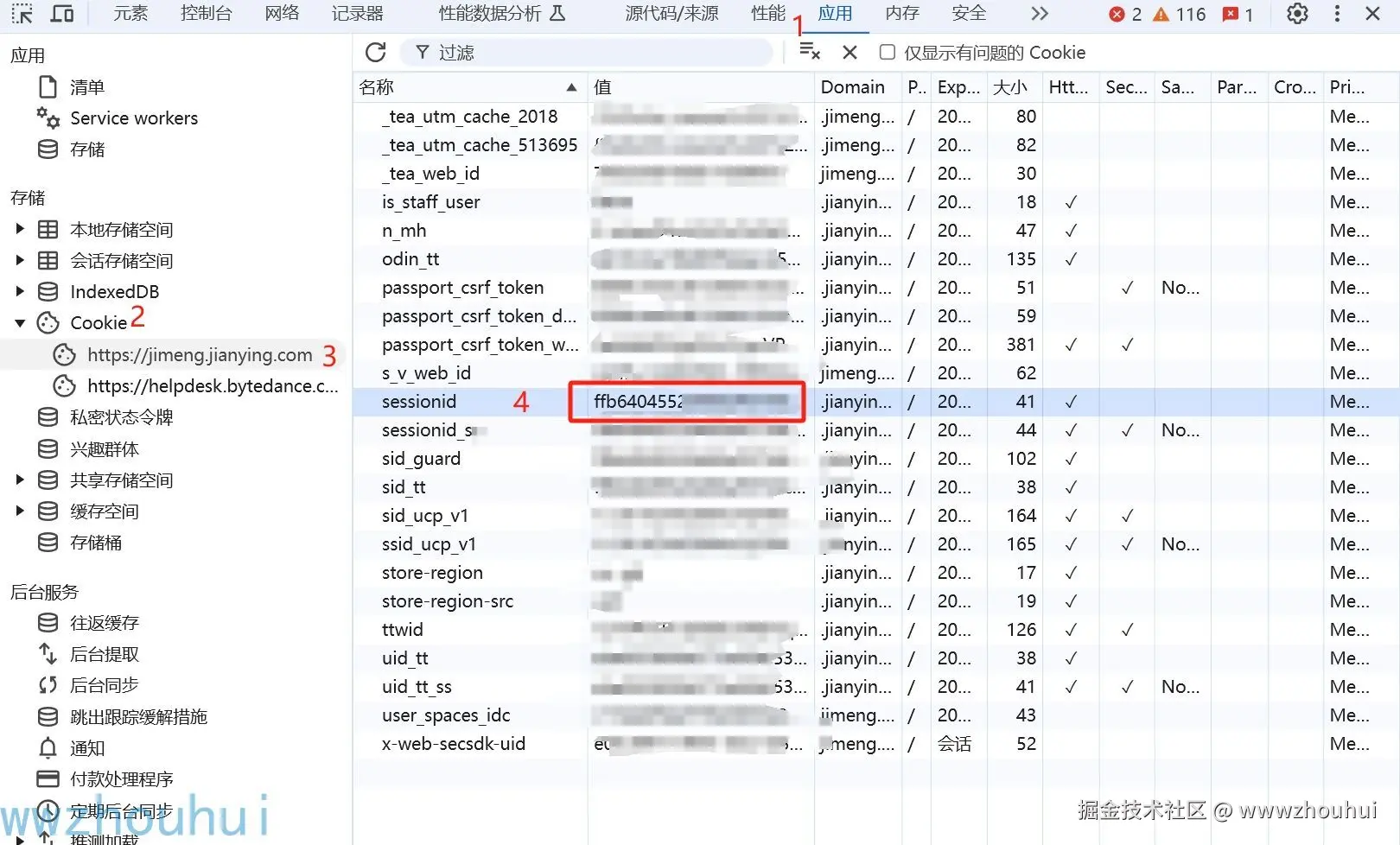

进入即梦登录账号,然后 F12 打开开发者工具,从 Application > Cookies 中找到sessionid的值,这将作为 Authorization 的 Bearer Token 值:Authorization: Bearer sessionid

3.2.3 启动后端服务

下载镜像

bash

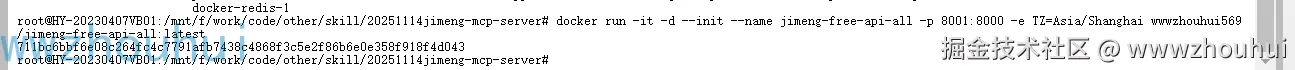

docker pull wwwzhouhui569/jimeng-free-api-all:latest启动 Docker 容器

css

docker run -it -d --init --name jimeng-free-api-all -p 8001:8000 -e TZ=Asia/Shanghai wwwzhouhui569/jimeng-free-api-all:latest

安装MCP服务器

后端服务部署完成后,我们开始安装jimeng-mcp-server。

3.3.1 克隆MCP项目

打开新的终端窗口,执行:

shell

# 克隆 jimeng-mcp-server 项目

git clone https://github.com/wwwzhouhui/jimeng-mcp-server.git

cd jimeng-mcp-server3.3.2 安装Python依赖

项目使用 uv 作为包管理工具(推荐),也可以使用传统的 pip。

方法一:使用 uv(推荐)

shell

# 安装 uv(如果尚未安装)

curl -LsSf https://astral.sh/uv/install.sh | sh

# 创建虚拟环境并安装依赖

uv venv

source .venv/bin/activate # Linux/macOS

# 或者在 Windows 上使用: .venv\Scripts\activate

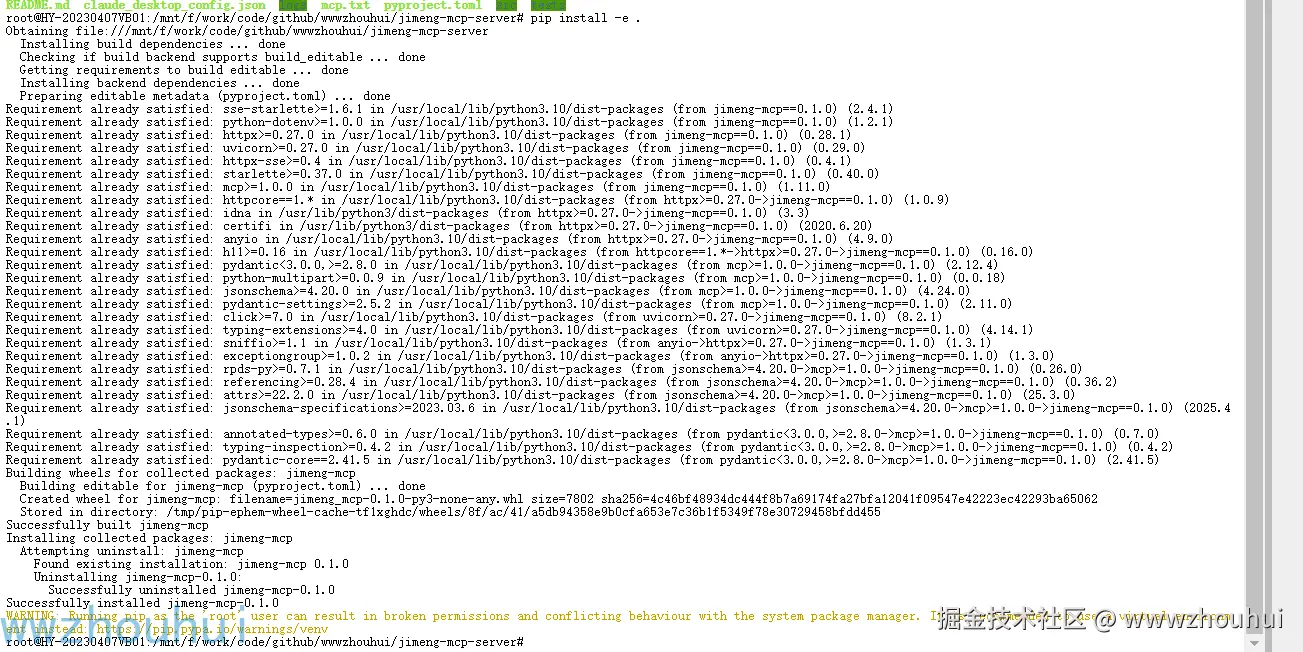

uv pip install -e .方法二:使用 pip

shell

# 创建虚拟环境

python -m venv .venv

source .venv/bin/activate # Linux/macOS

# 或者在 Windows 上使用: .venv\Scripts\activate

# 安装依赖

pip install -e .

安装过程中可能需要几分钟时间,请耐心等待。

3.3.3 配置MCP服务器

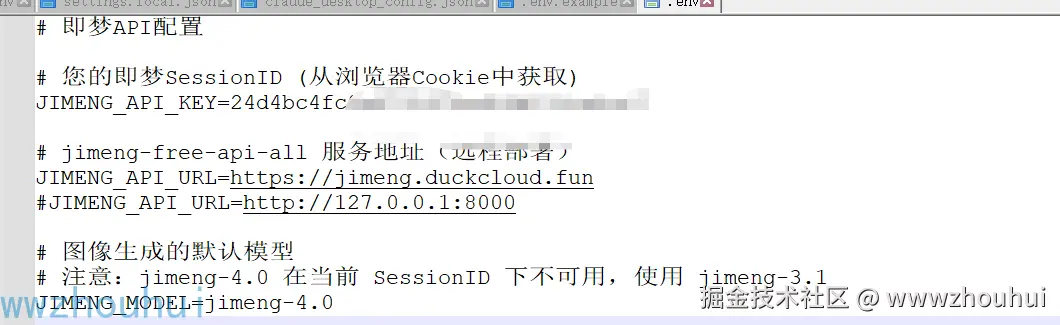

创建 .env 文件配置后端API地址:

shell

touch .env编辑 .env 文件:

env

# 即梦API配置

# 您的即梦API密钥 (必需)

JIMENG_API_KEY=您的API密钥

# API基础URL (可选, 默认为 https://jimeng.duckcloud.fun)

JIMENG_API_URL=http://127.0.0.1:8001

# 图像生成的默认模型 (可选, 默认为 jimeng-4.0)

JIMENG_MODEL=jimeng-4.0

注意 :JIMENG_API_KEY 就是前面网页版本即梦 cookies

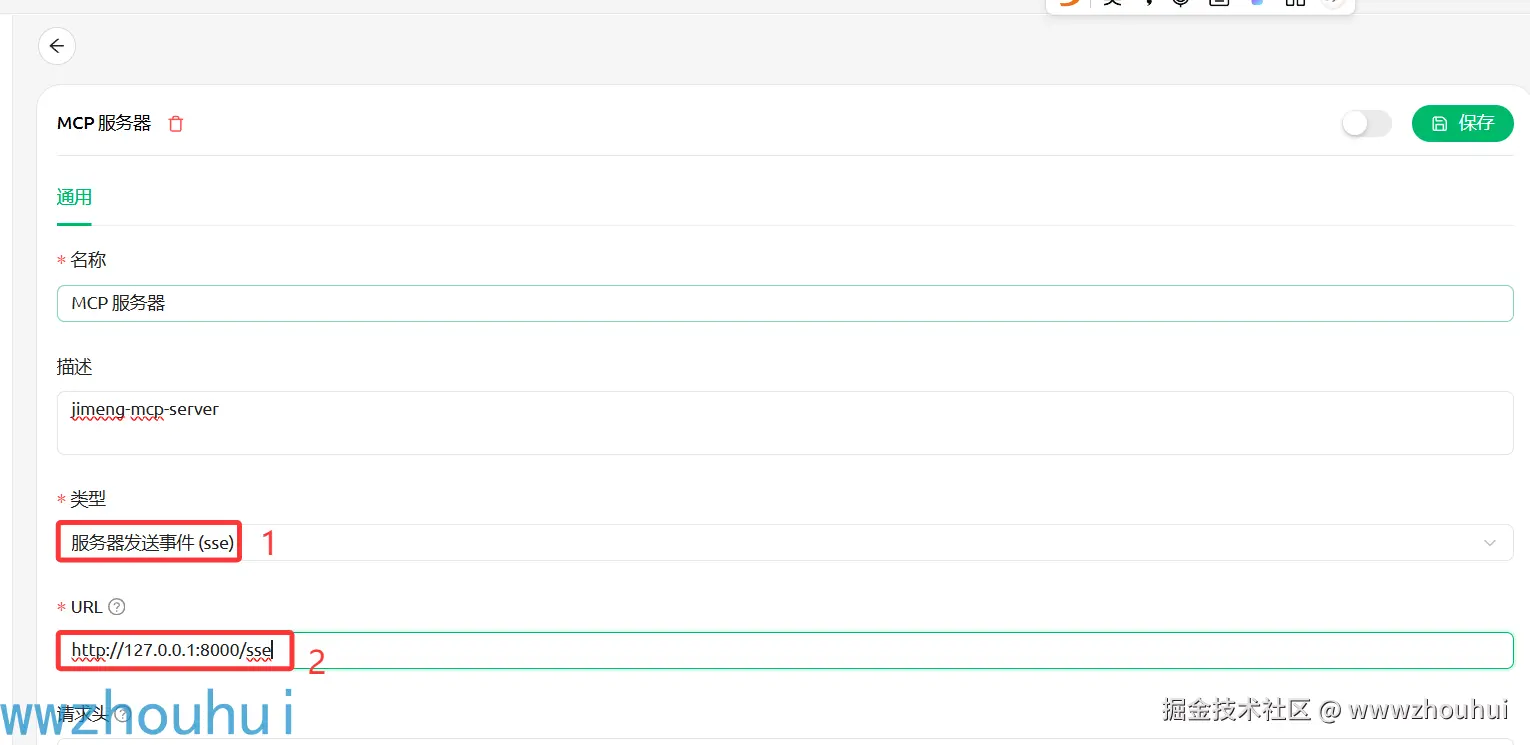

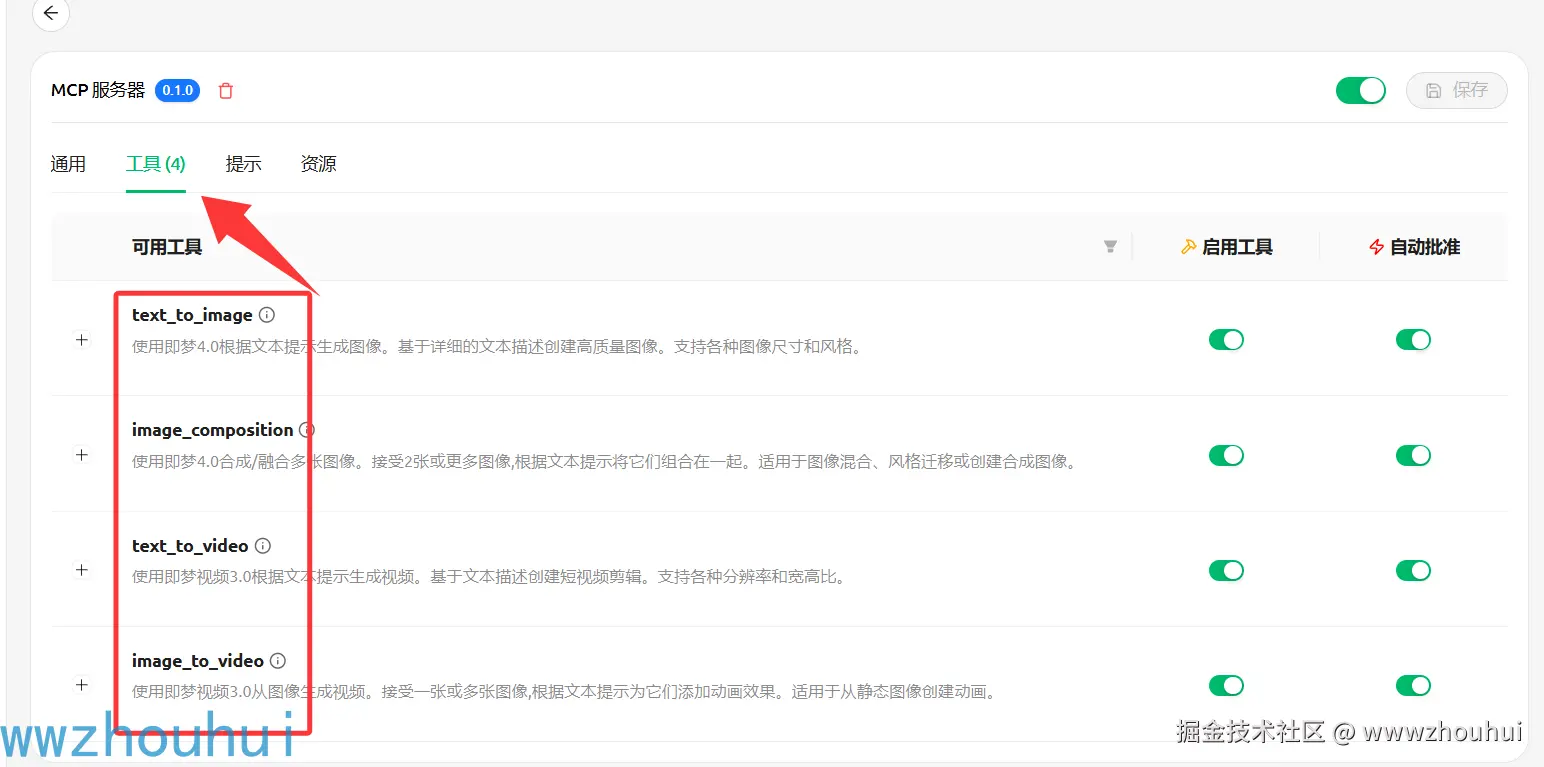

Cherry Studio配置

将此服务器添加到Cherry Studio配置文件:

MacOS : ~/Library/Application Support/Claude/claude_desktop_config.json

Windows : %APPDATA%\Claude\claude_desktop_config.json

json

{

"mcpServers": {

"jimeng": {

"command": "python",

"args": ["-m", "jimeng_mcp.server"],

"env": {

"JIMENG_API_KEY": "您的API密钥"

}

}

}

}或者,如果您有.env文件:

json

{

"mcpServers": {

"jimeng": {

"command": "python",

"args": ["-m", "jimeng_mcp.server"]

}

}

}sse配置

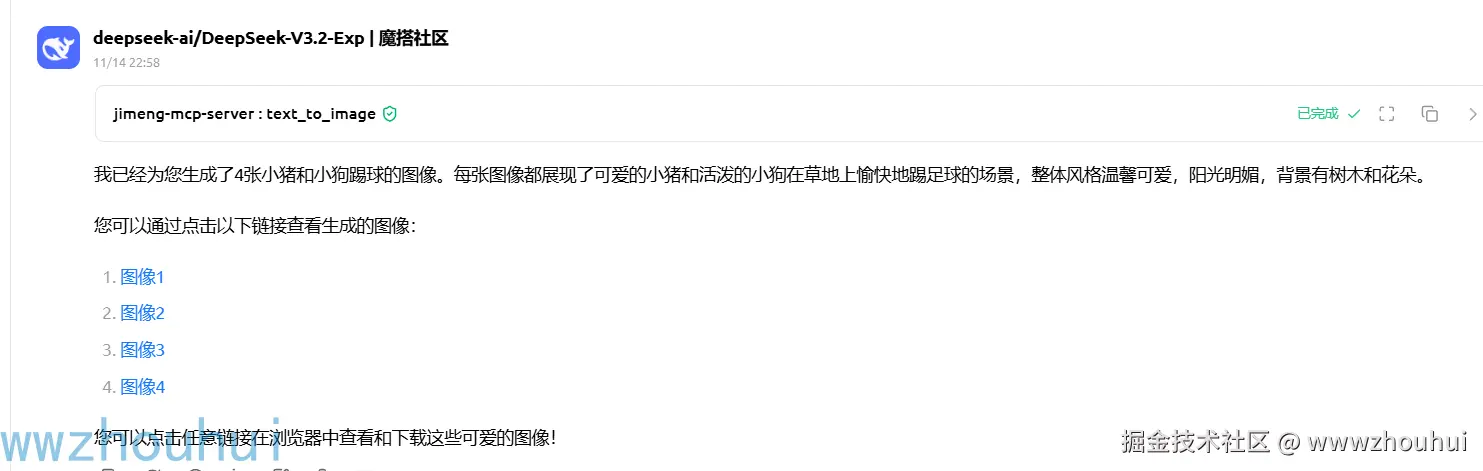

文本生成图像示例

makefile

生成一张图像:小猪和小狗踢球

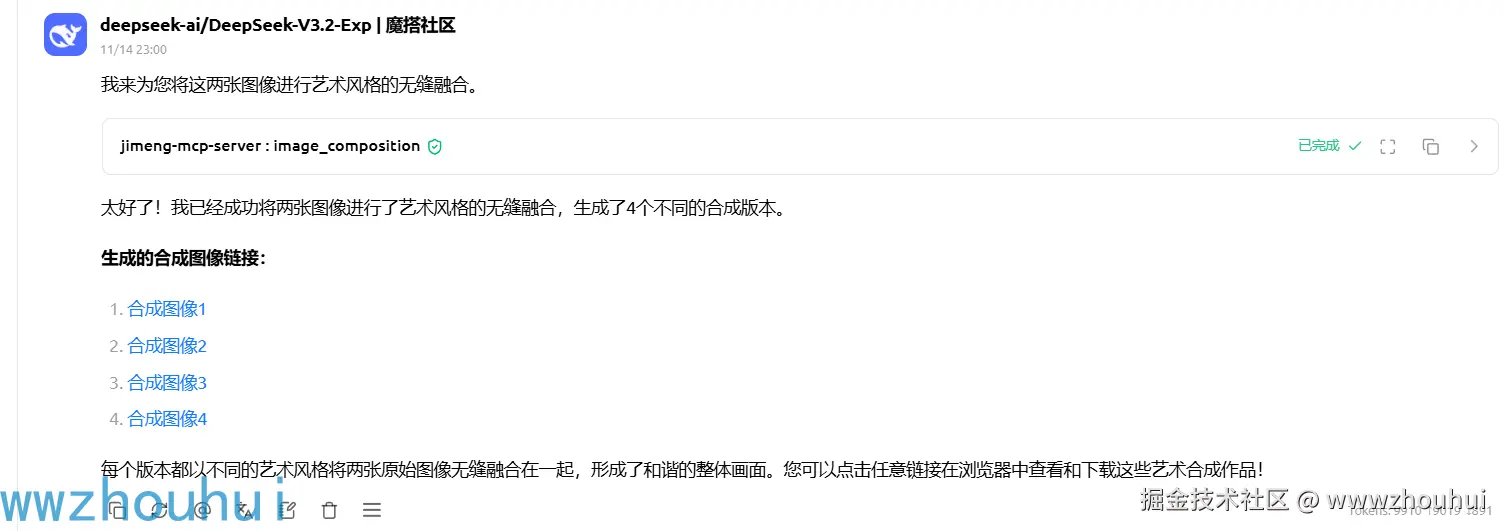

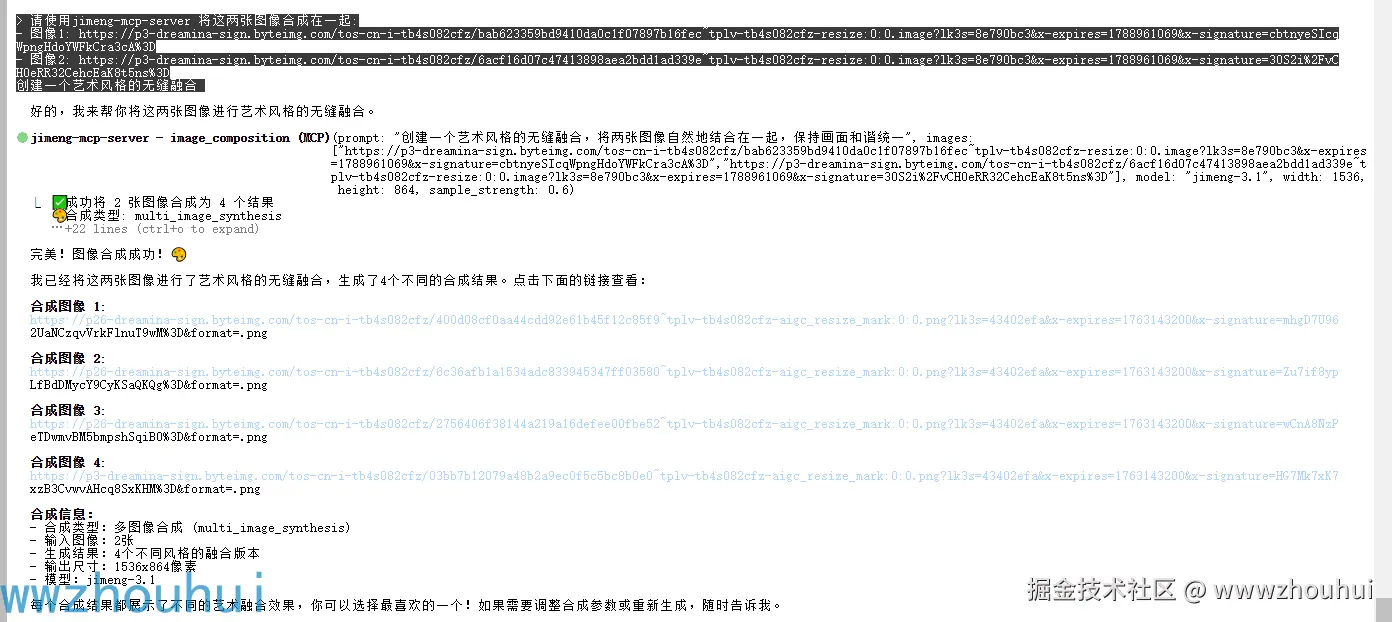

图像合成示例

bash

将这两张图像合成在一起:

- 图像1: https://p3-dreamina-sign.byteimg.com/tos-cn-i-tb4s082cfz/bab623359bd9410da0c1f07897b16fec~tplv-tb4s082cfz-resize:0:0.image?lk3s=8e790bc3&x-expires=1788961069&x-signature=cbtnyeSIcqWpngHdoYWFkCra3cA%3D

- 图像2: https://p3-dreamina-sign.byteimg.com/tos-cn-i-tb4s082cfz/6acf16d07c47413898aea2bdd1ad339e~tplv-tb4s082cfz-resize:0:0.image?lk3s=8e790bc3&x-expires=1788961069&x-signature=30S2i%2FvCH0eRR32CehcEaK8t5ns%3D

创建一个艺术风格的无缝融合

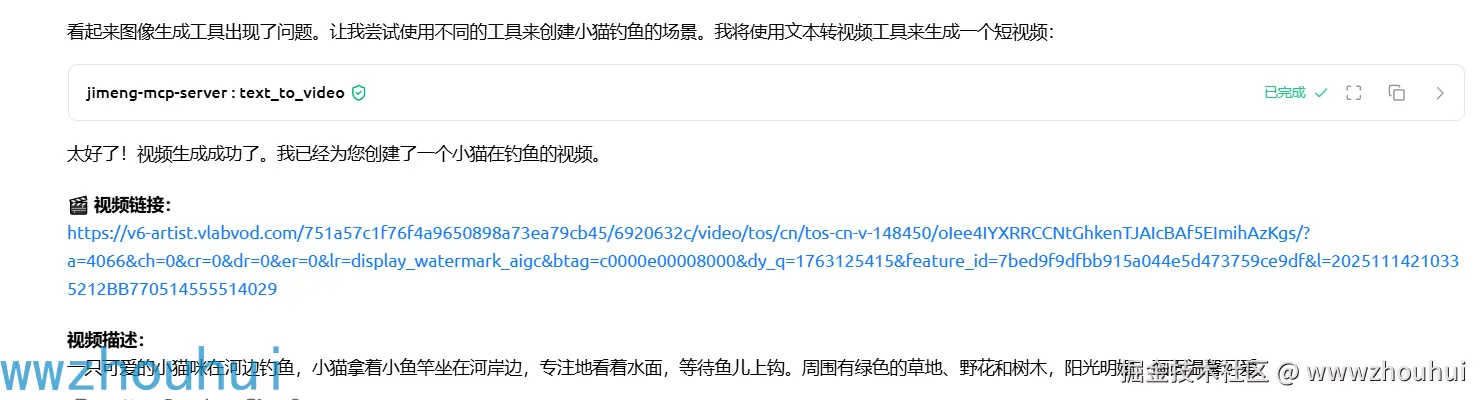

文本生成视频示例

makefile

创建一个视频:小猫在钓鱼

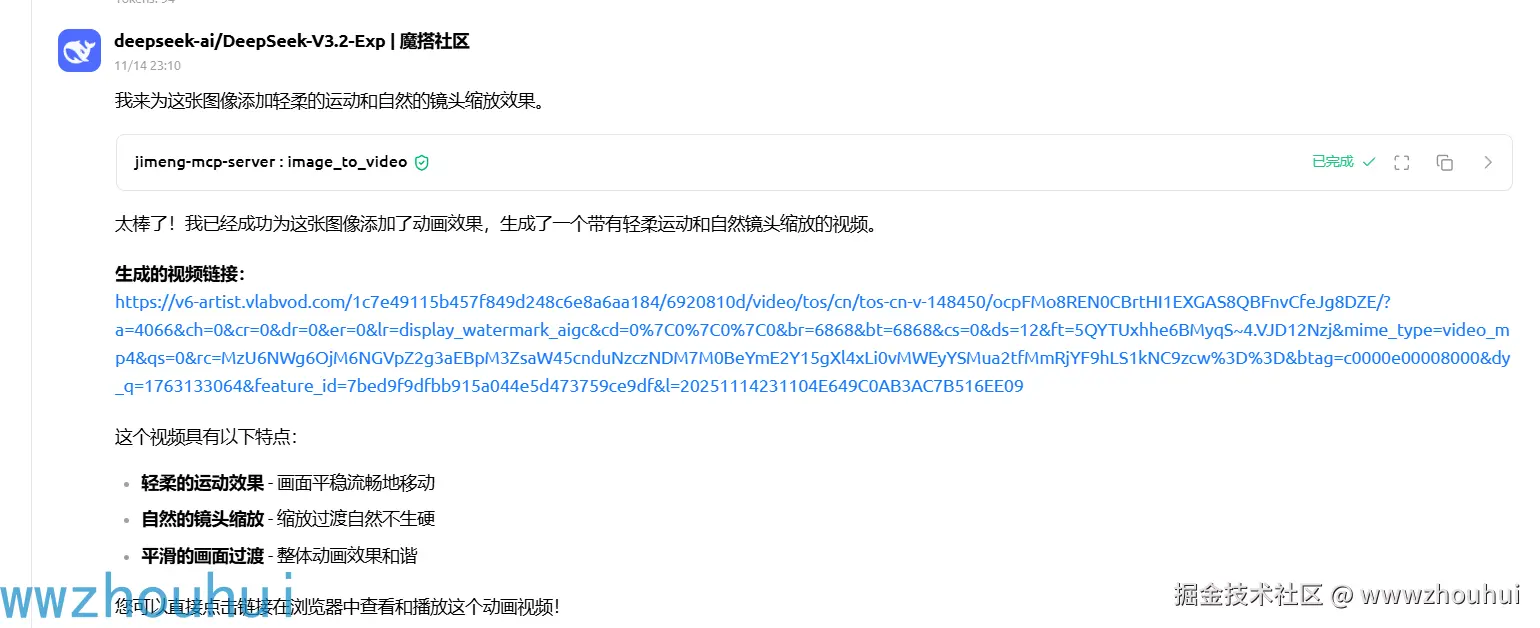

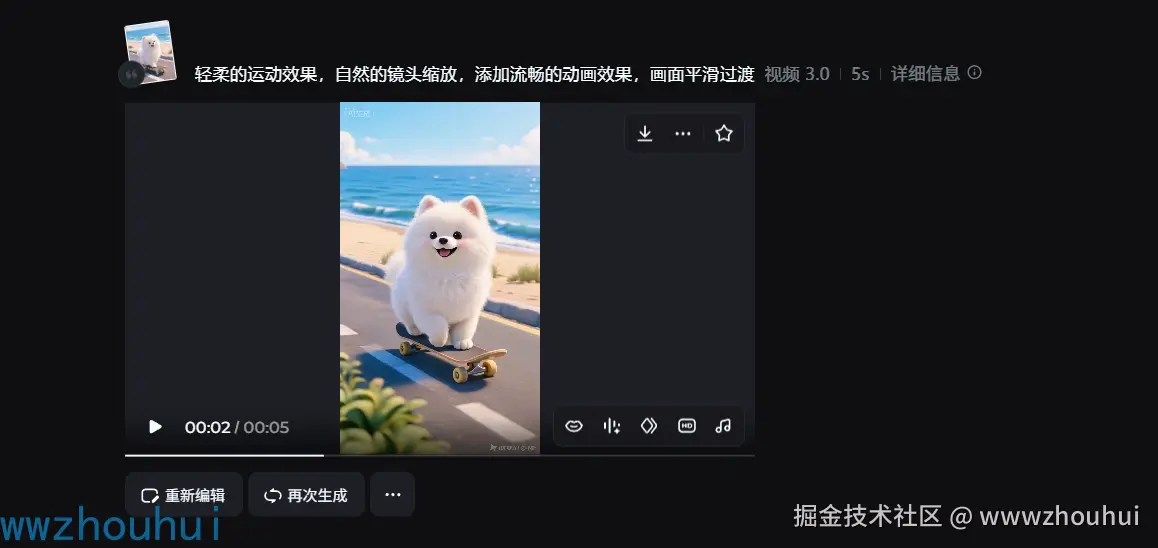

图像生成视频示例

bash

为这张图像添加动画效果:

https://p3-dreamina-sign.byteimg.com/tos-cn-i-tb4s082cfz/bab623359bd9410da0c1f07897b16fec~tplv-tb4s082cfz-resize:0:0.image?lk3s=8e790bc3&x-expires=1788961069&x-signature=cbtnyeSIcqWpngHdoYWFkCra3cA%3D

添加轻柔的运动和自然的镜头缩放

在claude code中使用

文本生成图像示例

vbscript

请使用jimeng-mcp-server 生成一张图像:小猪和小狗踢球

图像合成示例

bash

请使用jimeng-mcp-server 将这两张图像合成在一起:

- 图像1: https://p3-dreamina-sign.byteimg.com/tos-cn-i-tb4s082cfz/bab623359bd9410da0c1f07897b16fec~tplv-tb4s082cfz-resize:0:0.image?lk3s=8e790bc3&x-expires=1788961069&x-signature=cbtnyeSIcqWpngHdoYWFkCra3cA%3D

- 图像2: https://p3-dreamina-sign.byteimg.com/tos-cn-i-tb4s082cfz/6acf16d07c47413898aea2bdd1ad339e~tplv-tb4s082cfz-resize:0:0.image?lk3s=8e790bc3&x-expires=1788961069&x-signature=30S2i%2FvCH0eRR32CehcEaK8t5ns%3D

创建一个艺术风格的无缝融合

图片生成结果

3.6 高级配置(可选)

SSE模式部署

如果需要将MCP服务器部署到云端供多人使用,可以使用SSE(Server-Sent Events)模式:

shell

# 启动SSE服务器

cd jimeng-mcp-server

uv run jimeng-mcp-server --transport sse --port 8080然后在客户端配置中使用SSE连接:

json

{

"mcpServers": {

"jimeng-remote": {

"url": "http://your-server-ip:8080/sse",

"transport": "sse"

}

}

}HTTP REST API模式

jimeng-mcp-server还支持标准的HTTP REST API调用:

shell

# 启动HTTP服务

uv run jimeng-mcp-server --transport http --port 8080可以使用curl或Postman测试:

shell

# 调用文生图API

curl -X POST http://localhost:8080/tools/text_to_image \

-H "Content-Type: application/json" \

-d '{

"prompt": "一只可爱的柴犬",

"width": 1024,

"height": 1024

}'4. 总结

今天主要带大家了解并实现了 jimeng-mcp-server(即梦MCP服务器) 的 完整部署与集成流程 ,该 开源MCP服务器 以 "标准MCP协议 + 即梦AI多模态能力" 为核心优势,结合 AI辅助开发与内容创作 需求,通过 Docker容器化部署 与 FastMCP框架 ,形成了一套从 后端API搭建 到 Claude客户端集成 的全链路 AI工具编排解决方案。

通过这套实践方案,开发者与内容创作者 能够高效突破 传统AI助手无法直接调用外部服务 的技术壁垒 ------ 借助 三层架构设计(包括 Claude客户端层、MCP协议层、即梦API层),无需 手动编写API对接代码,就能快速 实现AI生图、图像合成、文生视频、图生视频四大核心功能(如本次演示的 "让Claude用一句话生成樱花下的柴犬视频")。无论是 博客配图自动生成、PPT智能配图,还是 短视频批量制作、UI原型快速生成,都能通过 自然语言指令 完成,极大 提升内容创作效率和开发体验。

在实际应用中,该 MCP服务器 不仅 支持stdio、SSE、HTTP三种运行模式 ,还 提供OpenAI兼容接口 ,适配性远优于 传统单一协议方案 ;特别是通过 Docker Compose一键部署 ,有效解决了 复杂环境配置和依赖管理 的难题。同时,方案具备良好的扩展性 ------ 小伙伴们可以基于此扩展更多 AI生成工具 ,如 AI音乐生成、3D模型生成、代码可视化生成 等,进一步发挥 MCP协议标准化能力 在 企业级AI应用、智能办公系统、教育培训平台 等领域的应用价值。感兴趣的小伙伴可以按照文中提供的步骤进行实践,根据实际 业务场景和创作需求 调整 工具参数、分辨率、时长等配置项。今天的分享就到这里结束了,我们下一篇文章见。