升腾异构计算架构 CANN 详解:从底层到应用的全栈解析

一、CANN 架构概述

CANN(Compute Architecture for Neural Networks)是华为面向 AI 场景打造的端云一致异构计算架构,其设计目标是通过软硬件协同优化,最大化释放昇腾 AI 硬件性能。架构自顶向下分为五大层级:

-

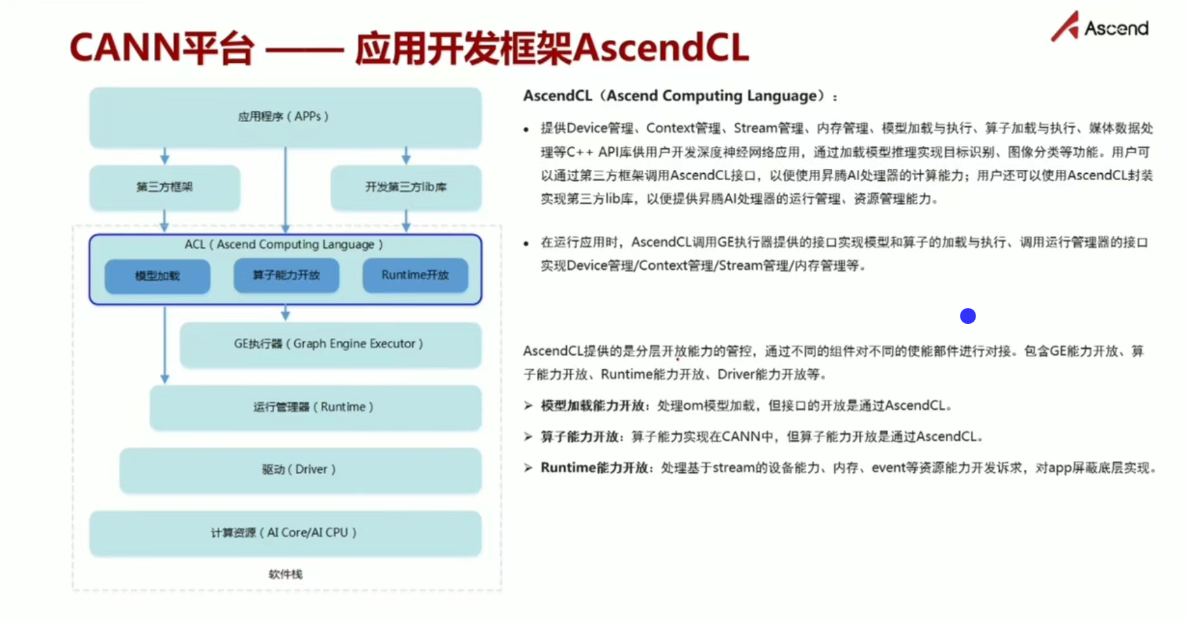

计算语言层(AscendCL)

提供设备管理、上下文管理、流管理、内存管理、模型加载与执行等核心 API,封装底层硬件接口,支持 C/C++ 开发者快速构建 AI 应用。

-

计算服务层

包含:

- AOL 算子加速库:预置 1500+ 基础算子及 100+ 融合算子

- AOE 调优引擎:支持 OPAT(算子调优)、SGAT(子图调优)、GDAT(梯度调优)

- Framework Adaptor:适配 TensorFlow/PyTorch/MindSpore 等主流框架

-

计算编译层

核心组件:

- 图编译器:将 IR 中间表示编译为硬件可执行模型

- TBE 张量加速引擎:自动调度机制实现算子高效编译

-

计算执行层

包含:

- Runtime 运行时:硬件资源管理 API

- GE 图引擎:图优化/编译/执行全流程管理

- HCCL 集合通信库:优化网络资源利用率

-

计算基础层

达芬奇架构硬件支撑,包含 NPU 核心、内存控制器、PCIe 接口等物理单元。

二、核心组件深度解析

2.1 Ascend C 编程语言

- 低阶 API:支持细粒度硬件控制,适用于高性能算子开发

- 高阶 API:简化复杂算子开发流程

- Tile 块编程范式:兼容 Triton/TileLang 等开发语言

- IR 开放:支持快速接入多种算子开发工具链

2.2 GE 图引擎工作流

原始模型 图优化 图编译 图执行 硬件执行结果

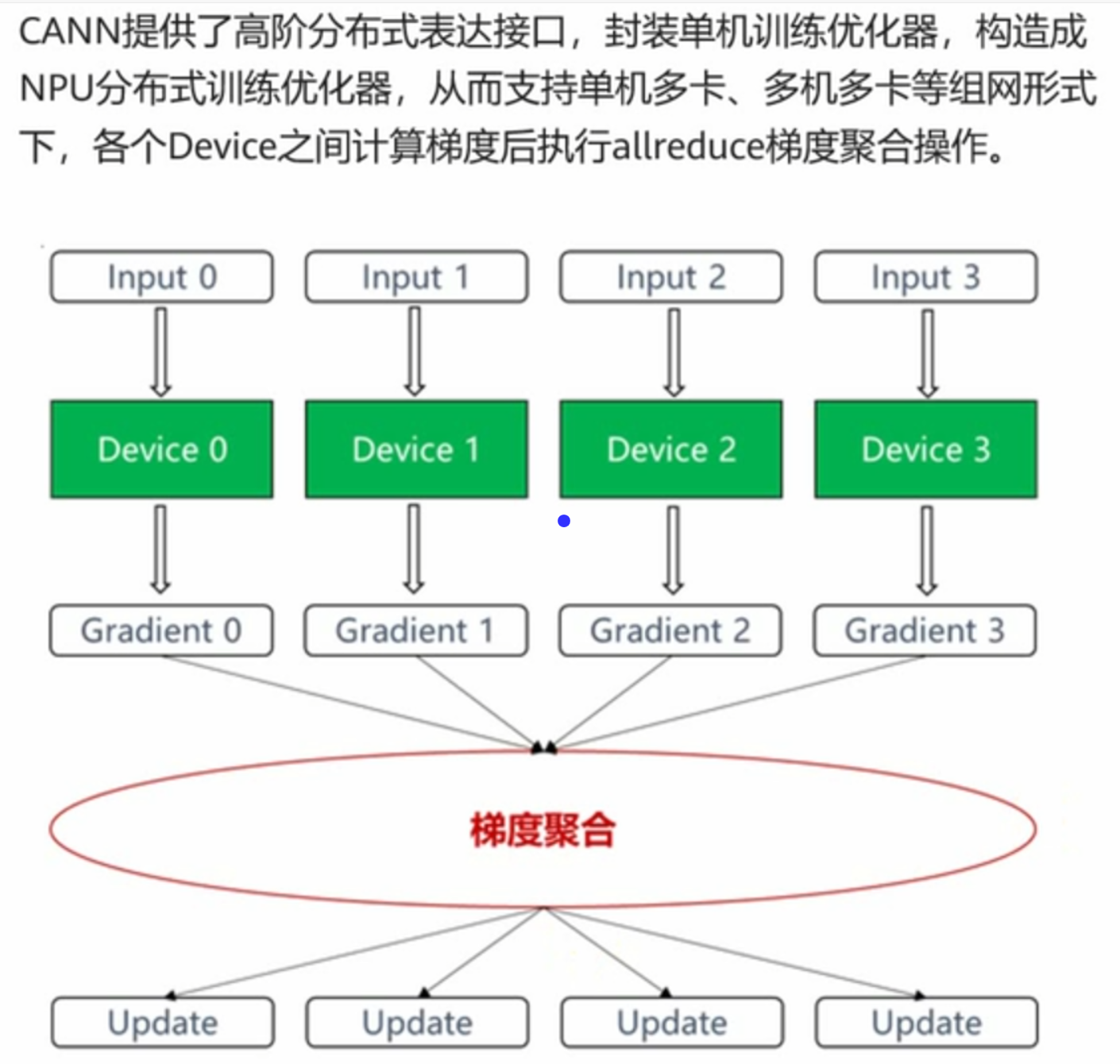

2.3 HCCL 集合通信优化

- 支持 AllReduce/AllGather 等 12 种通信原语

- 提供带宽感知的拓扑感知算法

- 降低跨节点通信延迟 40%+

三、开发环境配置指南

3.1 硬件环境要求

| 设备类型 | 推荐配置 |

|---|---|

| 升腾 AI 处理器 | Ascend 310/910 |

| CPU | x86 架构,16 核以上 |

| 内存 | 64GB DDR4 及以上 |

| 存储 | NVMe SSD 500GB+ |

3.2 云环境安装步骤(Ubuntu 22.04)

bash

# 依赖安装

sudo apt update && sudo apt install -y \

gcc g++ cmake make python3-dev python3-pip \

libstdc++6 libgomp1

# 驱动验证(昇腾实例)

npu-smi info

# 安装 CANN 开发包

tar -zxvf cann_8.1.RC1_linux-aarch64.tar.gz

cd cann_8.1.RC1

./install.sh --install-path=/usr/local/Ascend四、典型应用场景

4.1 大模型训练优化

- AOL 融合算子:将 LayerNorm + GELU 融合为单算子,提升 35% 吞吐量

- 图级优化:通过 SGAT 实现子图级内存复用

- 分布式训练:HCCL 优化后跨节点带宽利用率提升 50%

4.2 边缘推理部署

python

# 使用 AscendCL 实现图像分类

import ascendcl as ac

# 初始化设备

device_id = 0

context = ac.Context()

ac.set_context(context)

# 加载模型

model = ac.Model("resnet50.om")

input_data = ac.Tensor(np.random.randn(1,3,224,224).astype(np.float32))

output = model.execute(input_data)五、未来演进方向

-

全面开源计划

- 2025Q4 完成驱动/运行时/编程语言全量代码开源

- 开放昇腾虚拟指令集架构

-

生态共建策略

- 认证开发者突破 10,000 人

- 行业伙伴算子贡献量达 500+

- MindSpore 深度集成 CANN 新特性

-

技术突破方向

- 动态图编译优化(Dynamic Graph Compilation)

- 异构内存统一管理(UMA)

- AI for Science 专用算子库

六、总结

CANN 通过分层解耦架构设计,实现了从硬件加速到应用开发的完整闭环。其开放的 API 生态和持续演进的调优引擎,正在推动 AI 开发从"硬件适配"向"算法驱动"的范式转变。随着全栈开源战略的推进,CANN 正在成为全球 AI 开发者的创新底座。