在2025年AWS re:Invent大会的主会场,AWS CEO Matt Garman抛出的观点精准概括了行业转折:"当大模型的参数竞赛进入尾声,真正的价值战场已转向落地工程化------让AI在企业真实场景中安全、经济、高效地创造价值。"

AWS人工智能副总裁Swami Sivasubramania

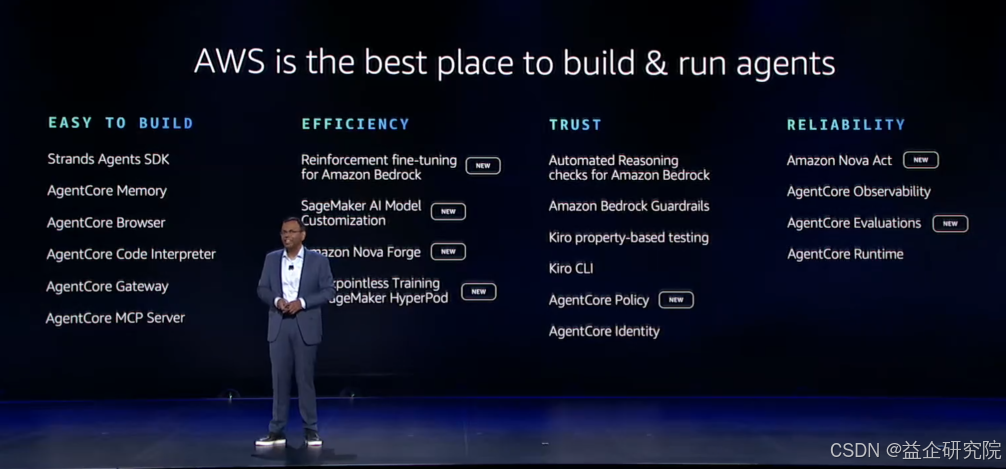

从自研芯片到模型平台,从智能体工具到治理体系,这场大会通过Matt Garman与AWS人工智能副总裁Swami Sivasubramania主导的一系列发布,清晰展现了AWS推动AI从技术演示走向核心生产力的全栈布局。

算力基建:自研与生态双轮驱动的成本革命

AI落地的第一道关卡,是算力成本与供给的双重挑战。对此,AWS给出了"自研芯片+生态合作"的双线解决方案。Matt Garman在 keynote 中披露,AWS自研Trainium系列芯片已部署超100万颗,业务规模达数十亿美元,成为支撑AI成本优化的核心支柱。

本次大会重点发布的Trainium3芯片与UltraServer服务器,将工程化优化推向新高度。基于3nm制程的Trainium3实现了性能4倍、内存带宽4倍的跨越式提升,每单位功耗处理的token数量更是提升5倍------这意味着企业训练同规模模型的能源成本可降低80%。而支持144颗芯片全连接的UltraServer集群,通过NeuronSwitch-v1技术将芯片间延迟控制在10微秒内,完美适配混合专家(MoE)等大模型架构的分布式训练需求。

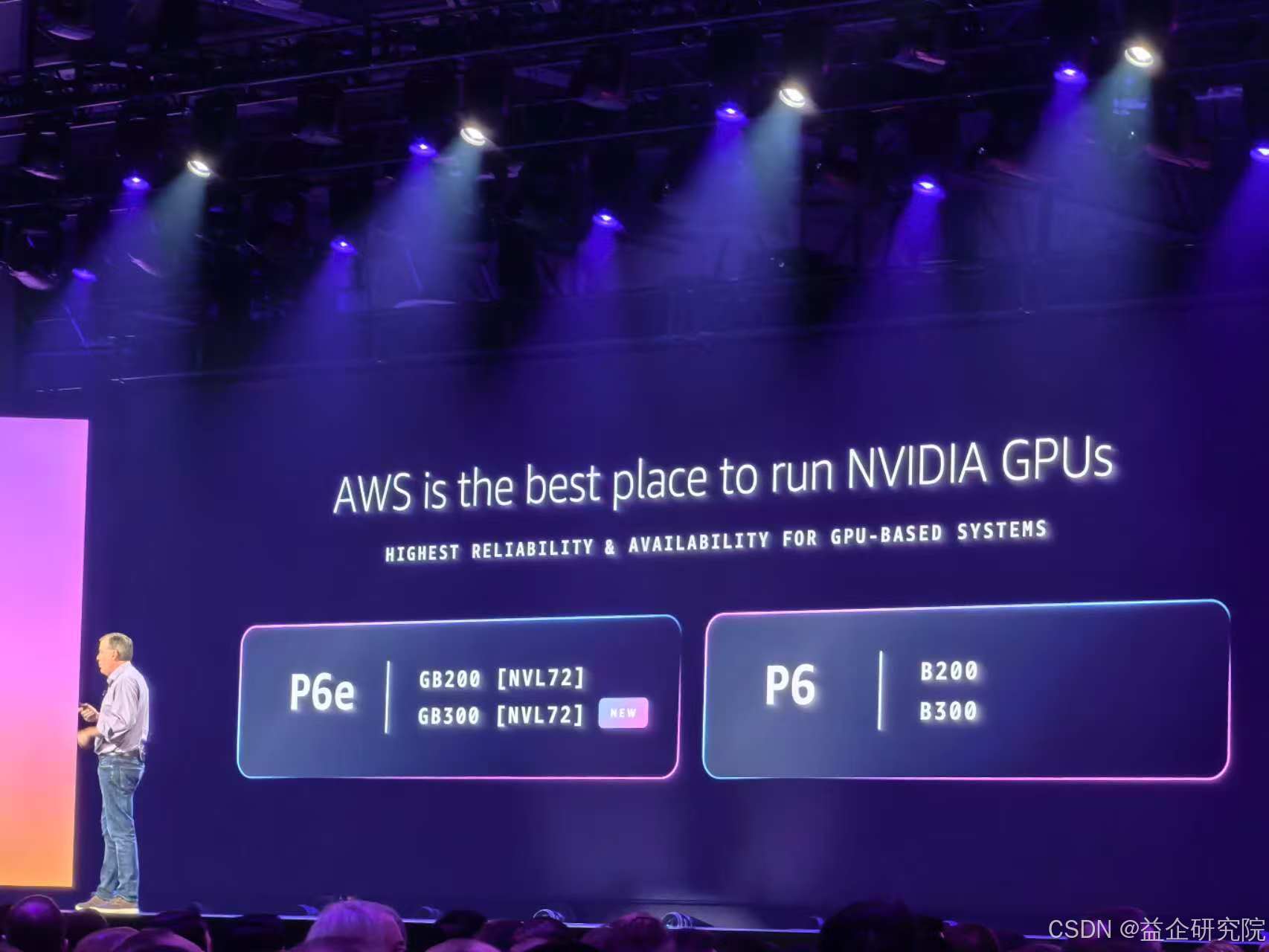

在生态端,AWS同时推出基于英伟达Blackwell Ultra架构的P6e-GB300实例,不仅获得英伟达自用集群"Project Ceiba"的背书,更成为OpenAl数十万颗芯片集群的承载平台。

这种"自研兜底+生态领先"的策略,既通过Trainium3保障了成本可控性,又借助英伟达最新GPU满足了尖端训练需求,为不同规模企业提供了阶梯式算力选择。

模型生产:从通用能力到专属价值的安全转化

"企业需要的不是通用大模型,而是懂自己业务的专属AI。" Swami在模型专场发布中强调的这一理念,贯穿于Nova 2模型家族与Nova Forge平台的设计逻辑。不同于单纯追求基准测试分数的模型迭代,AWS此次发布直指企业定制化的核心痛点:如何在安全合规前提下,将专有数据转化为模型能力。

Nova 2系列模型通过场景细分实现效率优化:Lite版本聚焦低延迟通用问答,Pro版本专攻复杂推理与知识蒸馏,Sonic与Omni则分别强化长上下文语音交互和多模态处理能力。

而真正突破行业瓶颈的是Nova Forge平台首创的"开放式训练"计划------企业可将专有数据安全注入预训练过程,无需传统微调即可获得兼具通用泛化能力与行业知识的专属模型。因为Nova Forge是一个具备前沿智能、专为企业的行业和用例量身定制的模型,同时保留Amazon Nova的基础知识、安全性和可靠性------无需承担完整训练生命周期的成本和精力。

数据安全是企业定制化的底线。Swami特别强调,Nova Forge采用"数据不离开企业边界"的训练架构,结合AWS KMS加密与隐私计算技术,确保专有数据既不泄露又能发挥价值。这种"安全优先"的工程化设计,让金融、医疗等敏感行业的模型定制成为可能。

更多精彩内容请关注现场报道