Open-AutoGLM 完整部署运行笔记

✅ 一、前置环境要求

1. Python 环境配置

- 版本要求:Python 3.10 及以上版本

- 必配系统环境变量(解决中文编码/运行报错核心):

① 变量名:PYTHONIOENCODING| 变量值:utf-8

② 变量名:PYTHONUTF8| 变量值:1

2. Android 设备要求

- 系统版本:Android 7.0 及以上版本

- 设备需开启调试模式,可正常连接电脑的ADB服务

3. ADB (Android Debug Bridge) 配置

- 下载地址:https://developer.android.com/tools/releases/platform-tools

- 配置步骤:解压下载包得到

platform-tools文件夹,将该文件夹的完整路径添加到系统环境变量的Path中 - 作用:实现电脑与安卓设备的指令通信、应用安装、文本输入调用

✅ 二、核心依赖安装与配置(按顺序执行)

1. 克隆项目源码

bash

git clone https://github.com/zai-org/Open-AutoGLM.git2. 安卓设备必装输入法(ADB调用输入核心):ADBKeyboard

作用:唯一支持ADB命令调用文本输入的输入法,必须安装启用,无需设为默认输入法

-

下载安装包命令:

powershellInvoke-WebRequest -Uri https://github.com/senzhk/ADBKeyBoard/blob/master/ADBKeyboard.apk -OutFile ADBKeyboard.apk -

执行ADB安装命令(设备已连接电脑):

bashadb install ADBKeyboard.apk -

验证安装是否成功:

bashadb shell pm list packages | findstr adbkeyboard -

收尾操作:打开手机【设置】→【系统/语言和输入法】→ 找到

ADBKeyboard并启用

3. Ollama 模型部署平台安装配置(Windows专用方案)

官方推荐的 vLLM、SGLang 部署方式不支持Windows系统,本方案为Windows最优替代方案,部署GGUF轻量化量化模型

-

官网下载:https://ollama.com/ (傻瓜式安装,一路下一步即可)

-

环境变量配置:将Ollama安装目录(例:D:\Ollama)添加到系统环境变量的

Path中 -

验证安装成功:命令行输入以下指令,能输出版本号即生效

bashollama -v -

核心作用:轻量化部署大模型,提供本地API服务,默认占用端口运行

✅ 三、大模型下载与Ollama模型构建(核心步骤)

1. 下载指定量化模型

- 模型名称:

AutoGLM-Phone-9B-GGUF(AutoGLM-Phone-9B的量化版本,适配Windows,轻量化高性能) - 下载地址:https://hf-mirror.com/mradermacher/AutoGLM-Phone-9B-GGUF/tree/main [速度非常快]

- 存放路径:在

Open-AutoGLM项目根目录下新建models文件夹,将下载好的AutoGLM-Phone-9B.Q8_0.gguf模型文件放入该目录

2. 创建模型配置文件 Modelfile

-

在

models文件夹内,新建无后缀名的文件,命名为Modelfile -

文件内写入以下配置代码(直接复制):

shell# 指定GGUF模型文件的本地路径 FROM ./AutoGLM-Phone-9B.Q8_0.gguf # 模型参数配置(固定最优参数) PARAMETER temperature 0.1 # 生成文本的随机性,0.1为低随机性,精准输出 PARAMETER num_ctx 4096 # 上下文窗口大小,支持长文本处理 PARAMETER num_gpu 99 # GPU显存占用最大化,提升推理速度

3. 构建Ollama本地模型

-

命令行进入项目的

models文件夹:bashcd Open-AutoGLM/models -

执行构建命令,创建自定义模型名称:

bashollama create autoglm-phone-9b -f Modelfile

-

验证模型构建成功:命令行输入以下指令,列表中显示

autoglm-phone-9b即成功bashollama list

✅ 四、服务启动指令(按顺序执行,先开服务再运行项目)

🔹 服务1:启动ADB桥接服务(电脑连接安卓设备)

启动ADB服务

bash

adb start-server停止ADB服务(如需断开/重启)

bash

adb kill-server🔹 服务2:启动Ollama模型本地服务

初始化+启动模型服务(核心指令)

bash

# 进入模型文件夹

cd Open-AutoGLM/models

# 初始化模型(已构建过可跳过,首次必执行)

ollama create autoglm-phone-9b -f Modelfile

# 启动Ollama服务(常驻运行,不要关闭该命令窗口)

ollama serve

# 运行模型

ollama run autoglm-phone-9bOllama服务相关补充说明

- 默认运行地址:

127.0.0.1:11434(本地回环地址+固定端口) - 停止服务方式:打开电脑【任务管理器】→ 进程中找到

ollama.exe→ 结束进程即可 - 端口号查询方式(按需核对):

- 步骤1:任务管理器找到

ollama.exe,记录对应的PID值 - 步骤2:执行命令查询端口占用:

netstat -ano | findstr "你的PID值" - 步骤3:启动日志核对:命令行启动时会显示

msg="Listening on 127.0.0.1:11434"

- 步骤1:任务管理器找到

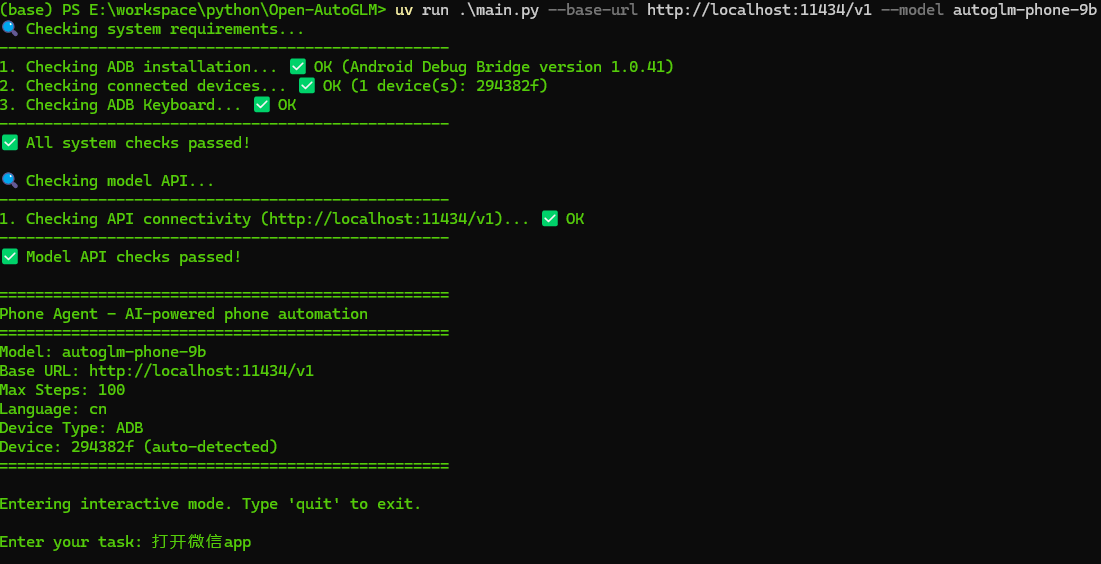

✅ 五、最终运行 Open-AutoGLM 项目(核心启动命令)

1. 切换到项目根目录

bash

cd Open-AutoGLM2. 完整启动命令

bash

uv run main.py --base-url http://localhost:11434/v1 --model autoglm-phone-9b

# 我是用uv来管理项目的,以下是默认的pyproject.toml文件内容:

[project]

name = "your-project-name" # 请替换为实际项目名称

version = "0.1.0" # 请替换为实际版本号

authors = [

{ name = "Your Name", email = "your.email@example.com" } # 请替换为实际作者信息

]

description = "Your project description" # 请替换为实际项目描述

requires-python = ">=3.12" # 根据项目需求调整Python版本要求

dependencies = [

"Pillow>=12.0.0",

"openai>=2.9.0",

# For iOS Support

"requests>=2.31.0",

]

[project.optional-dependencies]

# For Model Deployment (需手动安装,如: pip install .[model-deployment])

# model-deployment = [

# "sglang>=0.5.6.post1",

# "vllm>=0.12.0",

# "transformers>=5.0.0rc0",

# 备注:安装sglang或vLLM后,请执行 pip install -U transformers 升级到5.0.0rc0

# 可忽略任何与Transformers相关的依赖冲突

# ]

# Optional: for development (安装方式: pip install .[dev])

dev = [

"pytest>=7.0.0",

"pre-commit>=4.5.0",

"black>=23.0.0",

"mypy>=1.0.0",

]

# 可选:如果需要指定工具配置(如black、mypy),可补充以下内容

[tool.black]

line-length = 88

target-version = ['py38']

include = '\.pyi?$'

exclude = '''

/(

\.git

| \.venv

| build

| dist

)/

'''

[tool.mypy]

python_version = "3.12"

warn_return_any = true

warn_unused_configs = true

disallow_untyped_defs = false # 根据项目需求调整3. 命令参数说明(通俗易懂)

--base-url:指定Ollama模型的API服务地址,端口11434为Ollama默认端口,无需修改--model:指定Ollama构建的模型名称,必须和ollama create定义的名称一致(本文为autoglm-phone-9b)

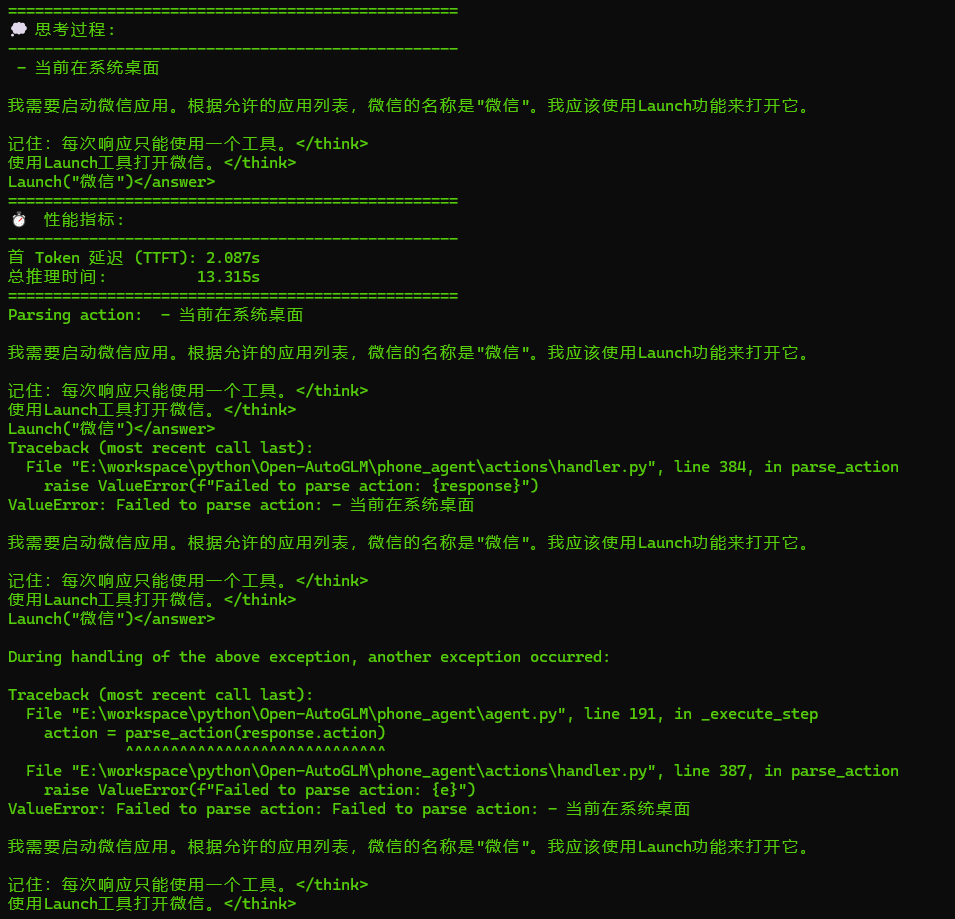

六,总结

1,按上述步骤,可以将项目跑起来,如有疑问,留言

2,输入的任务,执行结果很差强人意,我想主要原因是:输入的中文和手机上的应用包名不同; 所使用的大模型性能有限的原因.

3,目前已经有类似于豆包手机的这样的app了: 肉包,还有OpenAutogml APP