总结概述

Dify 的工作流引擎展现了 事件驱动架构 + 领域驱动设计 的工业级实践:

- DAG 拓扑 通过邻接表 + 动态入度检查实现高效调度

- 变量池 采用双层哈希 + 命名空间隔离保证并发安全

- 持久化层 使用 PostgreSQL 存储完整 DSL + 执行日志,支持精确回溯

- 并发控制 通过 Worker 并行 + Dispatcher 串行写入避免分布式锁开销

- 资源管控 依赖 Layer 系统实现步数/时间/内存三重限制

工作流架构对比表

| 维度 | Airflow (传统) | Temporal (现代) | Dify Workflow (本设计) |

|---|---|---|---|

| 调度算法 | Kahn 拓扑排序 | Event-Driven DAG | Event-Driven + Ready Queue |

| 变量传递 | XCom (DB 序列化) | Workflow Context | Variable Pool (内存 + PostgreSQL) |

| 并行模型 | 多进程 + Celery | 多 Worker 协程 | 动态线程池 (min=1, max=CPU) |

| 状态持久化 | 每个 Task 独立记录 | Event Sourcing | GraphRuntimeState 序列化 |

| 原子性保障 | DB 事务 | SAGA 模式 | 单线程 Dispatcher 写入 |

| 断点续传 | Task 级别 | Workflow 级别 | 全局状态快照(变量池+就绪队列) |

| 资源限制 | 外部调度器控制 | Worker 级别限制 | Layer 系统三重限制 |

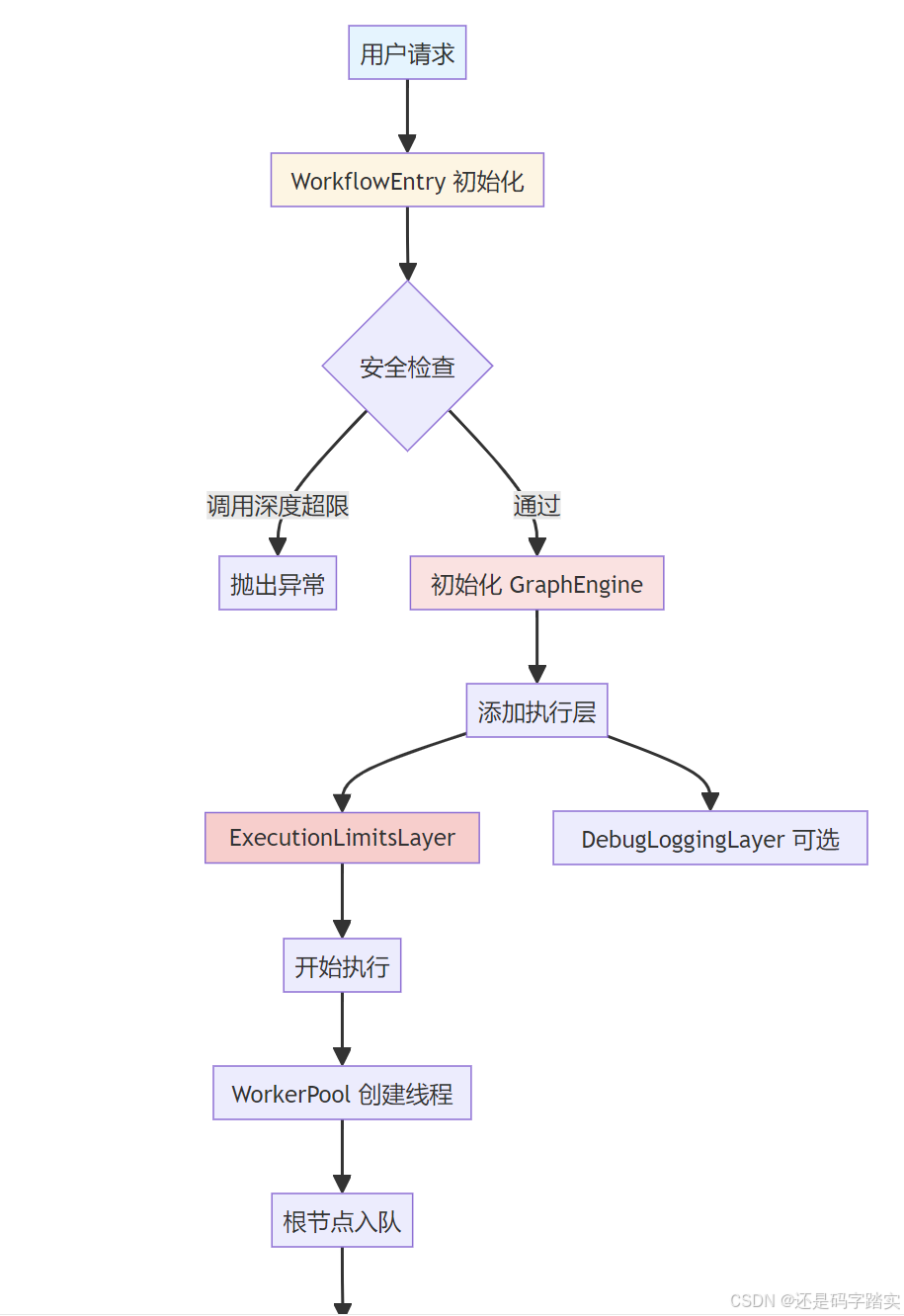

总结流程图

工作流执行:从 DSL 到 DAG 执行

整体流程概览

简单理解:

- 输入:用户配置的工作流 DSL(JSON 格式)

- 解析:将 DSL 解析为 DAG(有向无环图)

- 执行:多线程并行执行节点

- 输出:返回执行结果和事件流

完整链路:

- DSL 输入 → JSON 配置

- Graph.init() → 解析为 DAG(节点、边、拓扑)

- WorkflowEntry → 创建 GraphEngine

- GraphEngine.init() → 初始化 10+ 子系统

- GraphEngine.run() → 启动执行

- root 节点入队 → 放入 ReadyQueue

- Worker 取节点 → 执行 node.run()

- 事件入队 → 放入 EventQueue

- Dispatcher 取事件 → 分发给 EventHandler

- EventHandler 处理 → 根据事件类型执行逻辑

- EdgeProcessor → 找到下游就绪节点

- 下游节点入队 → 放入 ReadyQueue

- 不断循环直到ReadyQueue、EventQueue队列空 → 执行完成

- 返回结果 → GraphRunSucceededEvent

核心优势:

- ✅ 并行执行:多个 Worker 同时处理节点

- ✅ 事件驱动:解耦节点执行和流程控制

- ✅ 模块化:每个子系统职责单一

- ✅ 可扩展:Layer 机制支持插件

- ✅ 可暂停/恢复:通过命令通道控制

完整执行流程图

JSON配置

Graph对象

创建

初始化子系统

启动

从ReadyQueue取节点

生成事件

分发

成功

失败

其他

找到下游节点

重试

终止

队列空且无运行节点

- DSL输入

用户工作流配置 2. Graph.init

解析DSL为DAG 3. WorkflowEntry初始化

创建执行入口 4. GraphEngine

执行引擎 5. 初始化执行组件 WorkerPool

工作线程池

ReadyQueue

就绪队列

EventQueue

事件队列

Dispatcher

调度器

EventHandler

事件处理器

EdgeProcessor

边处理器

6. GraphEngine.run

启动执行 7. 将root节点入队 8. Worker循环 9. Worker执行节点 10. 事件放入EventQueue 11. Dispatcher处理事件 12. EventHandler处理 NodeRunSucceededEvent

NodeRunFailedEvent

其他事件类型

13. EdgeProcessor

处理出边 14. 下游节点入队 错误处理

结束执行

15. 输出结果

GraphRunSucceededEvent

关键步骤详细解析

步骤 1-2:DSL 解析为 DAG

位置 :api/core/workflow/graph/graph.py

python

# 输入示例:DSL 配置

graph_config = {

"nodes": [

{

"id": "start",

"type": "custom",

"data": {

"type": "start",

"title": "开始"

}

},

{

"id": "llm_node",

"type": "custom",

"data": {

"type": "llm",

"title": "LLM节点"

}

}

],

"edges": [

{

"source": "start",

"target": "llm_node",

"sourceHandle": "source"

}

]

}

python

# Graph.init() 关键代码解析

@classmethod

def init(cls, *, graph_config: Mapping[str, object],

node_factory: NodeFactory,

root_node_id: str | None = None) -> Graph:

"""

【核心功能】将 DSL 配置解析为 Graph 对象

参数:

graph_config: 用户的工作流配置(JSON)

node_factory: 节点工厂,用于创建具体节点实例

root_node_id: 可选的起始节点ID

返回:

Graph: 包含节点、边、拓扑关系的图对象

"""

# ========== 步骤 1:提取配置 ==========

edge_configs = graph_config.get("edges", []) # 获取边配置列表

node_configs = graph_config.get("nodes", []) # 获取节点配置列表

# ========== 步骤 2:解析节点配置 ==========

# 将节点列表转为字典:{node_id: node_config}

node_configs_map = cls._parse_node_configs(node_configs)

# ========== 步骤 3:找到根节点 ==========

# 根节点:没有入边的节点,优先选择 START 类型

root_node_id = cls._find_root_node_id(

node_configs_map, edge_configs, root_node_id

)

# ========== 步骤 4:构建边和拓扑关系 ==========

# 返回三个字典:

# - edges: {edge_id: Edge对象}

# - in_edges: {node_id: [入边ID列表]}

# - out_edges: {node_id: [出边ID列表]}

edges, in_edges, out_edges = cls._build_edges(edge_configs)

# ========== 步骤 5:创建节点实例 ==========

# 使用 node_factory 将配置转为实际的 Node 对象

nodes = cls._create_node_instances(node_configs_map, node_factory)

# ========== 步骤 6:特殊处理 ==========

# 将失败分支节点提升为分支执行类型

cls._promote_fail_branch_nodes(nodes)

# 获取根节点实例

root_node = nodes[root_node_id]

# 标记非活跃的根分支为跳过状态

cls._mark_inactive_root_branches(

nodes, edges, in_edges, out_edges, root_node_id

)

# ========== 步骤 7:创建 Graph 对象 ==========

graph = cls(

nodes=nodes, # 所有节点

edges=edges, # 所有边

in_edges=in_edges, # 入边映射

out_edges=out_edges, # 出边映射

root_node=root_node # 根节点

)

# ========== 步骤 8:验证图结构 ==========

get_graph_validator().validate(graph)

return graph关键注释:

_parse_node_configs: 将节点列表转为字典,方便通过 ID 查找_find_root_node_id: 找到执行入口(START 节点或无入边的节点)_build_edges: 构建 DAG 的拓扑结构(入边、出边映射)_create_node_instances: 根据节点类型创建具体实例(LLM、Tool 等)

步骤 3-4:创建执行引擎

位置 :api/core/workflow/workflow_entry.py

python

class WorkflowEntry:

"""

【核心功能】工作流执行入口

作用:连接 Graph(静态结构)和 GraphEngine(动态执行)

"""

def __init__(self, tenant_id: str, app_id: str, workflow_id: str,

graph_config: Mapping[str, Any], graph: Graph,

user_id: str, user_from: UserFrom, invoke_from: InvokeFrom,

call_depth: int, variable_pool: VariablePool,

graph_runtime_state: GraphRuntimeState,

command_channel: CommandChannel | None = None) -> None:

"""

初始化工作流入口

重要参数:

graph: 已解析的 DAG 图

graph_runtime_state: 运行时状态(变量池、执行状态等)

command_channel: 命令通道(用于暂停、终止等外部控制)

"""

# ========== 检查调用深度(防止无限递归) ==========

workflow_call_max_depth = dify_config.WORKFLOW_CALL_MAX_DEPTH

if call_depth > workflow_call_max_depth:

raise ValueError(f"达到最大调用深度 {workflow_call_max_depth}")

# ========== 创建命令通道(用于外部控制) ==========

if command_channel is None:

command_channel = InMemoryChannel() # 默认内存通道

self.command_channel = command_channel

# ========== 创建 GraphEngine(核心执行引擎) ==========

self.graph_engine = GraphEngine(

workflow_id=workflow_id,

graph=graph, # 传入 DAG 图

graph_runtime_state=graph_runtime_state, # 运行时状态

command_channel=command_channel, # 命令通道

)

# ========== 添加执行层(Layers) ==========

# Layer 是插件式扩展,用于增强功能

# 1. Debug 日志层(开发模式)

if dify_config.DEBUG:

debug_layer = DebugLoggingLayer(

level="DEBUG",

include_inputs=True,

include_outputs=True,

)

self.graph_engine.layer(debug_layer)

# 2. 执行限制层(防止超时/步骤过多)

limits_layer = ExecutionLimitsLayer(

max_steps=dify_config.WORKFLOW_MAX_EXECUTION_STEPS, # 最大步骤数

max_time=dify_config.WORKFLOW_MAX_EXECUTION_TIME # 最大执行时间

)

self.graph_engine.layer(limits_layer)

# 3. 可观测性层(追踪和监控)

if dify_config.ENABLE_OTEL:

self.graph_engine.layer(ObservabilityLayer())

def run(self) -> Generator[GraphEngineEvent, None, None]:

"""

【核心功能】执行工作流

返回:事件生成器(流式返回执行过程)

"""

graph_engine = self.graph_engine

try:

# 运行工作流,返回事件流

generator = graph_engine.run()

yield from generator # 流式返回事件

except GenerateTaskStoppedError:

pass # 用户主动停止

except Exception as e:

logger.exception("工作流执行时发生未知错误")

yield GraphRunFailedEvent(error=str(e))步骤 5:GraphEngine 初始化子系统

位置 :api/core/workflow/graph_engine/graph_engine.py

python

class GraphEngine:

"""

【核心功能】基于队列的图执行引擎

架构特点:

- 模块化:职责分离到各个子系统

- 多线程:Worker 并行执行节点

- 事件驱动:通过事件队列协调

"""

def __init__(self, workflow_id: str, graph: Graph,

graph_runtime_state: GraphRuntimeState,

command_channel: CommandChannel,

min_workers: int | None = None,

max_workers: int | None = None) -> None:

"""

初始化执行引擎及所有子系统

"""

# ========== 核心数据 ==========

self._stop_event = threading.Event() # 停止信号

self._graph = graph # DAG 图

self._graph_runtime_state = graph_runtime_state # 运行时状态

self._command_channel = command_channel # 命令通道

# 配置运行时状态

self._graph_runtime_state.stop_event = self._stop_event

self._graph_runtime_state.configure(graph=graph)

# ========== 执行队列 ==========

# 1. 就绪队列:存放可以执行的节点 ID

self._ready_queue = graph_runtime_state.ready_queue

# 2. 事件队列:存放节点执行产生的事件

self._event_queue: queue.Queue[GraphNodeEventBase] = queue.Queue()

# ========== 状态管理器 ==========

# 统一管理节点状态转换和队列操作

self._state_manager = GraphStateManager(

self._graph, self._ready_queue

)

# ========== 事件管理器 ==========

# 收集和发送事件

self._event_manager = EventManager()

# ========== 错误处理器 ==========

# 处理节点执行失败

self._error_handler = ErrorHandler(

self._graph, self._graph_execution

)

# ========== 图遍历组件 ==========

# 1. 跳过传播器:传播节点跳过状态

self._skip_propagator = SkipPropagator(

graph=self._graph,

state_manager=self._state_manager,

)

# 2. 边处理器:处理边的遍历和下游节点触发

self._edge_processor = EdgeProcessor(

graph=self._graph,

state_manager=self._state_manager,

response_coordinator=self._response_coordinator,

skip_propagator=self._skip_propagator,

)

# ========== 命令处理器 ==========

# 处理外部命令(暂停、终止等)

self._command_processor = CommandProcessor(

command_channel=self._command_channel,

graph_execution=self._graph_execution,

)

# 注册命令处理器

self._command_processor.register_handler(

AbortCommand, AbortCommandHandler()

)

self._command_processor.register_handler(

PauseCommand, PauseCommandHandler()

)

# ========== Worker 线程池 ==========

# 捕获 Flask 上下文(用于多线程)

flask_app = None

try:

app = current_app._get_current_object()

if isinstance(app, Flask):

flask_app = app

except RuntimeError:

pass

# 捕获上下文变量

context_vars = contextvars.copy_context()

# 创建 Worker 线程池

self._worker_pool = WorkerPool(

ready_queue=self._ready_queue, # 从这里取节点

event_queue=self._event_queue, # 放事件到这里

graph=self._graph,

layers=self._layers,

flask_app=flask_app,

context_vars=context_vars,

min_workers=min_workers, # 最小线程数

max_workers=max_workers, # 最大线程数

stop_event=self._stop_event,

)

# ========== 执行协调器 ==========

# 协调整体执行生命周期

self._execution_coordinator = ExecutionCoordinator(

graph_execution=self._graph_execution,

state_manager=self._state_manager,

command_processor=self._command_processor,

worker_pool=self._worker_pool,

)

# ========== 事件处理注册器 ==========

# 处理所有节点执行事件

self._event_handler_registry = EventHandler(

graph=self._graph,

graph_runtime_state=self._graph_runtime_state,

graph_execution=self._graph_execution,

response_coordinator=self._response_coordinator,

event_collector=self._event_manager,

edge_processor=self._edge_processor,

state_manager=self._state_manager,

error_handler=self._error_handler,

)

# ========== 调度器 ==========

# 从事件队列取事件并分发处理

self._dispatcher = Dispatcher(

event_queue=self._event_queue,

event_handler=self._event_handler_registry,

execution_coordinator=self._execution_coordinator,

event_emitter=self._event_manager,

stop_event=self._stop_event,

)子系统职责说明:

| 子系统 | 职责 |

|---|---|

| ReadyQueue | 存储可执行的节点 ID(FIFO 队列) |

| EventQueue | 存储节点产生的事件 |

| WorkerPool | 管理多个 Worker 线程并行执行节点 |

| StateManager | 管理节点状态和队列操作 |

| EventManager | 收集和发送事件 |

| EdgeProcessor | 处理边遍历,找到下游节点 |

| ErrorHandler | 处理节点失败(重试、降级等) |

| Dispatcher | 从事件队列取事件并分发 |

| EventHandler | 根据事件类型执行相应逻辑 |

步骤 6-7:启动执行

位置 :api/core/workflow/graph_engine/graph_engine.py

python

def run(self) -> Generator[GraphEngineEvent, None, None]:

"""

【核心功能】执行图

返回:事件生成器(流式返回)

"""

try:

# ========== 初始化层 ==========

self._initialize_layers()

# ========== 判断是否恢复执行 ==========

is_resume = self._graph_execution.started

if not is_resume:

self._graph_execution.start() # 首次执行

else:

self._graph_execution.paused = False # 恢复执行

# ========== 发送启动事件 ==========

start_event = GraphRunStartedEvent()

self._event_manager.notify_layers(start_event)

yield start_event

# ========== 启动执行子系统 ==========

self._start_execution(resume=is_resume)

# ========== 流式返回事件 ==========

yield from self._event_manager.emit_events()

# ========== 处理完成状态 ==========

if self._graph_execution.is_paused:

# 暂停

yield GraphRunPausedEvent(...)

elif self._graph_execution.aborted:

# 终止

yield GraphRunAbortedEvent(...)

elif self._graph_execution.has_error:

# 失败

if self._graph_execution.error:

raise self._graph_execution.error

else:

# 成功

outputs = self._graph_runtime_state.outputs

yield GraphRunSucceededEvent(outputs=outputs)

except Exception as e:

yield GraphRunFailedEvent(error=str(e))

raise

finally:

self._stop_execution()

def _start_execution(self, *, resume: bool = False) -> None:

"""

【核心功能】启动执行子系统

"""

self._stop_event.clear()

# ========== 启动 Worker 线程池 ==========

self._worker_pool.start()

# ========== 注册响应节点 ==========

for node in self._graph.nodes.values():

if node.execution_type == NodeExecutionType.RESPONSE:

self._response_coordinator.register(node.id)

if not resume:

# ========== 首次执行:将根节点入队 ==========

root_node = self._graph.root_node

self._state_manager.enqueue_node(root_node.id) # 放入就绪队列

self._state_manager.start_execution(root_node.id) # 标记为执行中

else:

# ========== 恢复执行:将暂停的节点入队 ==========

paused_nodes = self._graph_runtime_state.consume_paused_nodes()

for node_id in paused_nodes:

self._state_manager.enqueue_node(node_id)

self._state_manager.start_execution(node_id)

# ========== 启动调度器 ==========

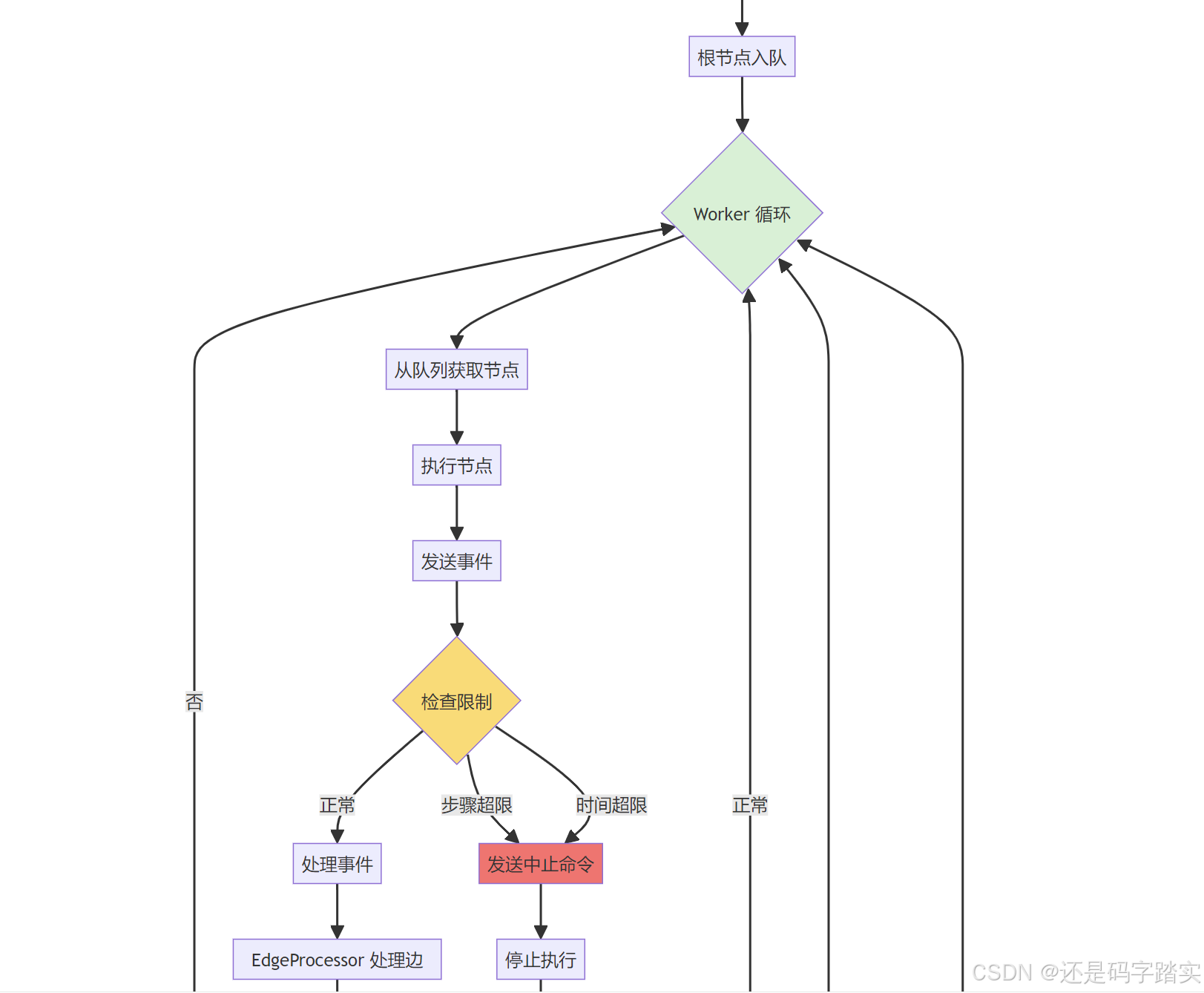

self._dispatcher.start()步骤 8-10:Worker 执行节点

位置 :api/core/workflow/graph_engine/worker.py

python

class Worker(threading.Thread):

"""

【核心功能】Worker 线程,从就绪队列取节点并执行

"""

def run(self) -> None:

"""

Worker 主循环

"""

while not self._stop_event.is_set():

# ========== 从就绪队列获取节点 ID ==========

try:

node_id = self._ready_queue.get(timeout=0.1)

except queue.Empty:

continue # 队列空,继续等待

# ========== 记录任务时间 ==========

self._last_task_time = time.time()

# ========== 获取节点实例 ==========

node = self._graph.nodes[node_id]

try:

# ========== 执行节点 ==========

self._execute_node(node)

self._ready_queue.task_done() # 标记任务完成

except Exception as e:

# ========== 执行失败,生成错误事件 ==========

error_event = NodeRunFailedEvent(

id=str(uuid4()),

node_id=node.id,

node_type=node.node_type,

error=str(e),

start_at=datetime.now(),

)

self._event_queue.put(error_event)

def _execute_node(self, node: Node) -> None:

"""

【核心功能】执行单个节点

流程:

1. 调用 Layer 的 on_node_run_start 钩子

2. 调用 node.run() 执行节点逻辑

3. 将节点产生的事件放入事件队列

4. 调用 Layer 的 on_node_run_end 钩子

"""

node.ensure_execution_id()

error: Exception | None = None

# ========== 执行前钩子 ==========

self._invoke_node_run_start_hooks(node)

try:

# ========== 执行节点,获取事件生成器 ==========

node_events = node.run() # 返回生成器

# ========== 将所有事件放入事件队列 ==========

for event in node_events:

self._event_queue.put(event)

# 事件示例:

# - NodeRunStartedEvent: 节点开始执行

# - NodeRunStreamChunkEvent: 流式输出块

# - NodeRunSucceededEvent: 节点成功

# - NodeRunFailedEvent: 节点失败

except Exception as exc:

error = exc

raise

finally:

# ========== 执行后钩子 ==========

self._invoke_node_run_end_hooks(node, error)节点执行示例:

假设执行一个 LLM 节点:

python

# node.run() 返回的事件流:

[

NodeRunStartedEvent(node_id="llm_1", ...),

NodeRunStreamChunkEvent(chunk="Hello", ...),

NodeRunStreamChunkEvent(chunk=" world", ...),

NodeRunSucceededEvent(

node_id="llm_1",

outputs={"output": "Hello world"},

...

)

]步骤 11-12:Dispatcher 调度和 EventHandler 处理

位置 :api/core/workflow/graph_engine/orchestration/dispatcher.py

python

class Dispatcher:

"""

【核心功能】调度器,从事件队列取事件并分发处理

"""

def _dispatcher_loop(self) -> None:

"""

调度器主循环

"""

try:

self._process_commands() # 处理命令

# ========== 主循环 ==========

while not self._stop_event.is_set():

# 检查是否应该停止

if (self._execution_coordinator.aborted or

self._execution_coordinator.paused or

self._execution_coordinator.execution_complete):

break

# 检查是否需要扩缩容 Worker

self._execution_coordinator.check_scaling()

try:

# ========== 从事件队列获取事件 ==========

event = self._event_queue.get(timeout=0.1)

# ========== 分发事件到 EventHandler ==========

self._event_handler.dispatch(event)

self._event_queue.task_done()

# ========== 处理命令(如暂停、终止) ==========

self._process_commands(event)

except queue.Empty:

time.sleep(0.1) # 队列空,短暂休眠

# ========== 处理剩余事件 ==========

self._process_commands()

while True:

try:

event = self._event_queue.get(block=False)

self._event_handler.dispatch(event)

self._event_queue.task_done()

except queue.Empty:

break

except Exception as e:

logger.exception("Dispatcher 错误")

self._execution_coordinator.mark_failed(e)

finally:

self._execution_coordinator.mark_complete()

if self._event_emitter:

self._event_emitter.mark_complete()位置 :api/core/workflow/graph_engine/event_management/event_handlers.py

python

class EventHandler:

"""

【核心功能】事件处理注册器

根据事件类型调用相应的处理逻辑

"""

@singledispatchmethod

def _dispatch(self, event: GraphNodeEventBase) -> None:

"""默认处理器"""

self._event_collector.collect(event)

logger.warning(f"未处理的事件类型: {type(event).__name__}")

@_dispatch.register

def _(self, event: NodeRunStartedEvent) -> None:

"""

【处理】节点开始事件

"""

# 记录执行

node_execution = self._graph_execution.get_or_create_node_execution(

event.node_id

)

node_execution.mark_started(event.id)

# 增加步骤计数

self._graph_runtime_state.increment_node_run_steps()

# 追踪节点执行(用于流式响应排序)

self._response_coordinator.track_node_execution(

event.node_id, event.id

)

# 收集事件(返回给用户)

self._event_collector.collect(event)

@_dispatch.register

def _(self, event: NodeRunSucceededEvent) -> None:

"""

【处理】节点成功事件(最重要)

流程:

1. 更新执行状态

2. 存储节点输出到变量池

3. 处理出边,找到下游节点

4. 将下游节点入队

5. 收集事件

"""

# ========== 1. 更新执行状态 ==========

node_execution = self._graph_execution.get_or_create_node_execution(

event.node_id

)

node_execution.mark_taken() # 标记为已执行

# 累计 token 使用量

self._accumulate_node_usage(event.node_run_result.llm_usage)

# ========== 2. 存储节点输出到变量池 ==========

self._store_node_outputs(

event.node_id,

event.node_run_result.outputs

)

# 示例:outputs = {"output": "Hello world"}

# 存储为:variable_pool["llm_1.output"] = "Hello world"

# ========== 3. 处理响应流 ==========

streaming_events = self._response_coordinator.intercept_event(event)

for stream_event in streaming_events:

self._event_collector.collect(stream_event)

# ========== 4. 处理出边,找到下游节点 ==========

node = self._graph.nodes[event.node_id]

if node.execution_type == NodeExecutionType.BRANCH:

# 分支节点:只激活选中的分支

ready_nodes, edge_events = self._edge_processor.handle_branch_completion(

event.node_id,

event.node_run_result.edge_source_handle

)

else:

# 普通节点:激活所有下游节点

ready_nodes, edge_events = self._edge_processor.process_node_success(

event.node_id

)

# 收集边事件

for edge_event in edge_events:

self._event_collector.collect(edge_event)

# ========== 5. 将下游节点入队 ==========

for node_id in ready_nodes:

self._state_manager.enqueue_node(node_id) # 放入就绪队列

self._state_manager.start_execution(node_id) # 标记执行中

# ========== 6. 标记当前节点完成 ==========

self._state_manager.finish_execution(event.node_id)

# ========== 7. 更新响应输出 ==========

if node.execution_type == NodeExecutionType.RESPONSE:

self._update_response_outputs(event.node_run_result.outputs)

# ========== 8. 收集事件 ==========

self._event_collector.collect(event)

@_dispatch.register

def _(self, event: NodeRunFailedEvent) -> None:

"""

【处理】节点失败事件

流程:

1. 记录失败

2. 调用错误处理器(重试、降级等)

3. 根据策略决定:重试、继续、终止

"""

# 更新状态

node_execution = self._graph_execution.get_or_create_node_execution(

event.node_id

)

node_execution.mark_failed(event.error)

self._graph_execution.record_node_failure()

# 调用错误处理器

result = self._error_handler.handle_node_failure(event)

if result:

# 返回了新事件(如重试事件),递归处理

self.dispatch(result)

else:

# 终止执行

self._graph_execution.fail(RuntimeError(event.error))

self._event_collector.collect(event)

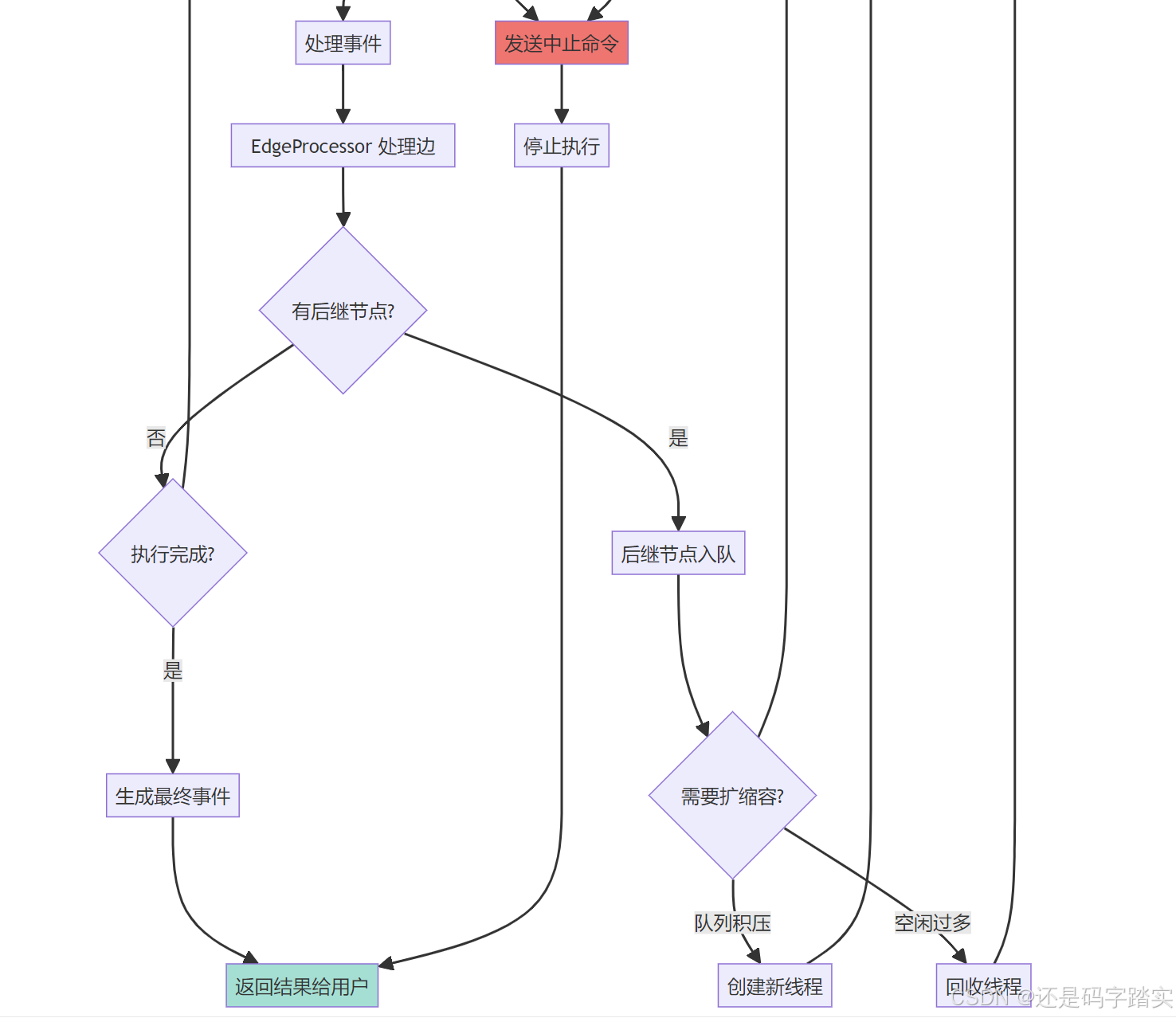

self._state_manager.finish_execution(event.node_id)步骤 13-14:EdgeProcessor 处理边和下游节点

位置 :api/core/workflow/graph_engine/graph_traversal/edge_processor.py

python

class EdgeProcessor:

"""

【核心功能】处理边的遍历和下游节点的触发

"""

def process_node_success(self, node_id: str,

selected_handle: str | None = None

) -> tuple[Sequence[str], Sequence[NodeRunStreamChunkEvent]]:

"""

【核心功能】处理节点成功后的出边

返回:

- ready_nodes: 可以执行的下游节点列表

- streaming_events: 边产生的流式事件

"""

node = self._graph.nodes[node_id]

if node.execution_type == NodeExecutionType.BRANCH:

# 分支节点:只处理选中的分支

return self._process_branch_node_edges(node_id, selected_handle)

else:

# 普通节点:处理所有出边

return self._process_non_branch_node_edges(node_id)

def _process_non_branch_node_edges(self, node_id: str):

"""

处理普通节点的出边

"""

ready_nodes: list[str] = []

all_streaming_events: list[NodeRunStreamChunkEvent] = []

# ========== 获取所有出边 ==========

outgoing_edges = self._graph.get_outgoing_edges(node_id)

# ========== 处理每条边 ==========

for edge in outgoing_edges:

nodes, events = self._process_taken_edge(edge)

ready_nodes.extend(nodes)

all_streaming_events.extend(events)

return ready_nodes, all_streaming_events

def _process_taken_edge(self, edge: Edge):

"""

【核心功能】处理一条被选中的边

流程:

1. 标记边为已选中

2. 通知响应协调器

3. 检查下游节点是否就绪

"""

# ========== 1. 标记边为已选中 ==========

self._state_manager.mark_edge_taken(edge.id)

# ========== 2. 通知响应协调器(用于流式响应) ==========

streaming_events = self._response_coordinator.on_edge_taken(edge.id)

# ========== 3. 检查下游节点是否就绪 ==========

ready_nodes: list[str] = []

if self._state_manager.is_node_ready(edge.head):

# 下游节点的所有入边都已完成,可以执行

ready_nodes.append(edge.head)

return ready_nodes, streaming_events就绪条件判断示例:

edge1

edge2

节点A

节点C

节点B

节点 C 的就绪条件:

edge1和edge2都被标记为TAKEN- 即:A 和 B 都执行成功后,C 才会进入就绪队列

完整示例演示

示例工作流 DSL

json

{

"nodes": [

{

"id": "start",

"data": {"type": "start", "title": "开始"}

},

{

"id": "llm_1",

"data": {

"type": "llm",

"title": "LLM节点1",

"prompt": "你好"

}

},

{

"id": "llm_2",

"data": {

"type": "llm",

"title": "LLM节点2",

"prompt": "世界"

}

},

{

"id": "code_1",

"data": {

"type": "code",

"title": "合并结果",

"code": "return llm_1.output + llm_2.output"

}

}

],

"edges": [

{"source": "start", "target": "llm_1"},

{"source": "start", "target": "llm_2"},

{"source": "llm_1", "target": "code_1"},

{"source": "llm_2", "target": "code_1"}

]

}执行流程图

edge1

edge2

edge3

edge4

开始节点

LLM节点1

LLM节点2

代码节点

!!!执行时序图

EdgeProcessor EventHandler Dispatcher EventQueue Worker2 Worker1 ReadyQueue GraphEngine WorkflowEntry 用户 EdgeProcessor EventHandler Dispatcher EventQueue Worker2 Worker1 ReadyQueue GraphEngine WorkflowEntry 用户 队列: ["start"] 队列: ["llm_1", "llm_2"] par [并行执行] edge3=TAKEN, edge4=WAITING code_1 未就绪 edge3=TAKEN, edge4=TAKEN code_1 就绪! 队列空,执行完成 调用 run() graph_engine.run() enqueue("start") 启动 Worker1 启动 Worker2 启动 Dispatcher get() "start" 执行 start 节点 put(NodeRunStartedEvent) put(NodeRunSucceededEvent) get() NodeRunStartedEvent dispatch(event) 收集事件 get() NodeRunSucceededEvent dispatch(event) process_node_success("start") ["llm_1", "llm_2"] enqueue("llm_1") enqueue("llm_2") get() "llm_1" 执行 llm_1 put(NodeRunSucceededEvent) get() "llm_2" 执行 llm_2 put(NodeRunSucceededEvent) get() NodeRunSucceededEvent(llm_1) dispatch(event) process_node_success("llm_1") 检查 code_1 是否就绪 get() NodeRunSucceededEvent(llm_2) dispatch(event) process_node_success("llm_2") 检查 code_1 是否就绪 ["code_1"] enqueue("code_1") get() "code_1" 执行 code_1 put(NodeRunSucceededEvent) get() NodeRunSucceededEvent(code_1) dispatch(event) process_node_success("code_1") [] mark_complete() yield GraphRunSucceededEvent

关键时间点的状态快照

T1: 执行 start 节点后

python

# 就绪队列

ready_queue = ["llm_1", "llm_2"]

# 边状态

edges = {

"edge1": EdgeState.TAKEN,

"edge2": EdgeState.TAKEN,

"edge3": EdgeState.WAITING,

"edge4": EdgeState.WAITING,

}

# 节点状态

nodes = {

"start": NodeState.SUCCEEDED,

"llm_1": NodeState.PENDING,

"llm_2": NodeState.PENDING,

"code_1": NodeState.WAITING,

}T2: llm_1 执行完成,llm_2 还在执行

python

# 就绪队列

ready_queue = [] # llm_2 还在执行

# 边状态

edges = {

"edge1": EdgeState.TAKEN,

"edge2": EdgeState.TAKEN,

"edge3": EdgeState.TAKEN, # ✓

"edge4": EdgeState.WAITING, # ✗ 还在等待

}

# 节点状态

nodes = {

"start": NodeState.SUCCEEDED,

"llm_1": NodeState.SUCCEEDED,

"llm_2": NodeState.RUNNING, # 还在运行

"code_1": NodeState.WAITING, # 等待 edge4

}T3: llm_2 也执行完成

python

# 就绪队列

ready_queue = ["code_1"] # ✓ code_1 可以执行了

# 边状态

edges = {

"edge1": EdgeState.TAKEN,

"edge2": EdgeState.TAKEN,

"edge3": EdgeState.TAKEN, # ✓

"edge4": EdgeState.TAKEN, # ✓ 所有入边都完成

}

# 节点状态

nodes = {

"start": NodeState.SUCCEEDED,

"llm_1": NodeState.SUCCEEDED,

"llm_2": NodeState.SUCCEEDED,

"code_1": NodeState.PENDING, # 可以执行

}

# 变量池

variable_pool = {

("llm_1", "output"): "你好回复",

("llm_2", "output"): "世界回复",

}核心概念总结

队列模型

plain

┌─────────────┐

│ ReadyQueue │ 存储可执行的节点 ID

└──────┬──────┘

│ get()

▼

┌────────┐

│ Worker │ 执行节点

└────┬───┘

│ put(event)

▼

┌──────────────┐

│ EventQueue │ 存储节点产生的事件

└──────┬───────┘

│ get()

▼

┌───────────┐

│Dispatcher │ 分发事件

└─────┬─────┘

│ dispatch()

▼

┌────────────────┐

│ EventHandler │ 处理事件逻辑

└────────────────┘节点就绪条件

普通节点: 所有入边都为 TAKEN 状态

分支节点: 选中分支的边为 TAKEN,其他边为 SKIPPED

示例代码:

python

def is_node_ready(self, node_id: str) -> bool:

"""判断节点是否就绪"""

incoming_edges = self._graph.get_incoming_edges(node_id)

if not incoming_edges:

return False # 没有入边,不应该在这里

for edge in incoming_edges:

if edge.state not in (NodeState.TAKEN, NodeState.SKIPPED):

return False # 有边还未处理

return True # 所有入边都已处理事件类型

| 事件类型 | 触发时机 | 处理逻辑 |

|---|---|---|

NodeRunStartedEvent |

节点开始执行 | 记录开始时间、执行 ID |

NodeRunStreamChunkEvent |

流式输出 | 转发给用户 |

NodeRunSucceededEvent |

节点成功 | 存储输出、处理出边、触发下游 |

NodeRunFailedEvent |

节点失败 | 错误处理、重试或终止 |

NodeRunRetryEvent |

节点重试 | 重新入队 |

NodeRunExceptionEvent |

节点异常(有降级策略) | 使用默认值或走失败分支 |

变量池

python

# 变量池是一个字典,key 是 (node_id, variable_name)

variable_pool = {

("start", "query"): "用户输入",

("llm_1", "output"): "LLM输出",

("code_1", "result"): {"data": 123},

}

# 节点可以通过变量选择器访问其他节点的输出

# 例如:llm_1.output 会被解析为 variable_pool[("llm_1", "output")]关键设计模式

- 生产者-消费者模式

- Worker(生产者)→ EventQueue → Dispatcher(消费者)

- ** 单例分发模式**

- 使用

@singledispatchmethod根据事件类型分发

- 使用

- 责任链模式

- Layer 机制:Debug → Limits → Observability

- 状态机模式

- 节点状态:WAITING → PENDING → RUNNING → SUCCEEDED/FAILED

- 观察者模式

- EventManager 收集事件并通知订阅者(Layers)

变量池实现详解:基于 Node ID 的双层索引结构

要点总结

操作总结

- 双层索引 :

{node_id: {variable_name: Variable}} - 选择器机制 :

[node_id, variable_name, ...]灵活访问 - 自动类型转换:任意值 → Segment → Variable

- 嵌套访问支持:对象属性、数组索引、文件属性

- 特殊节点 :

sys,env,conversation等预定义 ID - O(1) 查询:双重哈希定位,性能优异

- 深拷贝保护 :

get_by_prefix()返回副本,避免意外修改

变量池的优势

- **解耦节点:**节点间不直接传递数据,通过变量池中转

- **支持并行:**多个节点可同时读取变量池(只要依赖满足)

- **易于调试:**可以随时查看变量池状态

- **支持暂停恢复:**变量池可序列化保存

全流程的时序图

Dispatcher EventQueue VariablePool Node节点 Worker线程 WorkerPool GraphEngine WorkflowEntry 用户 Dispatcher EventQueue VariablePool Node节点 Worker线程 WorkerPool GraphEngine WorkflowEntry 用户 loop [执行循环] run() 启动工作流 run() 执行图引擎 start() 启动线程池 创建工作线程 start() 启动调度器 将Start节点入队 get() 取节点ID run() 执行节点 get([upstream_node, var]) 读取输入 返回变量值 执行业务逻辑(LLM/API等) add([node_id, output], result) 写入结果 返回事件 put(event) 放入事件队列 get() 取事件 处理事件,计算下游节点 将下游节点入队 执行完成 提取最终输出 返回结果事件 返回翻译结果

全流程的流程图

是

否

用户输入: 翻译 Hello

WorkflowEntry.init

创建 VariablePool

初始化用户输入

创建 GraphEngine

加载工作流图

WorkflowEntry.run

GraphEngine.run

启动 WorkerPool

创建工作线程

根节点入队

ReadyQueue.put

Dispatcher 启动

监听事件

Worker 取节点执行

ReadyQueue.get

Node.run

执行节点逻辑

从 VariablePool

读取输入变量

执行业务逻辑

如调用 LLM

结果写入 VariablePool

variable_pool.add

发送事件到

EventQueue

Dispatcher 处理事件

EventHandler.dispatch

EdgeProcessor

计算下游节点

还有下游节点?

GraphEngine 完成

生成最终输出

从 VariablePool 提取

返回给用户: Hello的翻译

核心数据结构

双层字典架构

python

# 变量池的核心数据结构

variable_dictionary: defaultdict[

str, # 第一层 key:node_id

dict[str, VariableUnion] # 第二层:{variable_name: Variable对象}

]可视化结构

plain

VariablePool

│

├─ variable_dictionary (双层字典)

│ │

│ ├─ "start" (Node ID - 第一层)

│ │ ├─ "query": StringVariable(value="用户输入")

│ │ └─ "files": ArrayFileVariable(value=[...])

│ │

│ ├─ "llm_1" (Node ID - 第一层)

│ │ ├─ "output": StringVariable(value="LLM输出内容")

│ │ └─ "usage": ObjectVariable(value={tokens: 100})

│ │

│ ├─ "code_1" (Node ID - 第一层)

│ │ └─ "result": ObjectVariable(value={data: [...]})

│ │

│ ├─ "sys" (系统变量 - 特殊 Node ID)

│ │ ├─ "user_id": StringVariable(value="user_123")

│ │ ├─ "app_id": StringVariable(value="app_456")

│ │ └─ "workflow_id": StringVariable(value="wf_789")

│ │

│ ├─ "env" (环境变量 - 特殊 Node ID)

│ │ └─ "api_key": StringVariable(value="sk-...")

│ │

│ └─ "conversation" (对话变量 - 特殊 Node ID)

│ └─ "history": ArrayObjectVariable(value=[...])

│

├─ user_inputs: {"query": "你好", "temperature": 0.7}

├─ system_variables: SystemVariable(...)

├─ environment_variables: [...]

└─ conversation_variables: [...]

plain

┌─────────────────────────────────────────────────────────┐

│ VariablePool │

├─────────────────────────────────────────────────────────┤

│ │

│ variable_dictionary (defaultdict) │

│ │ │

│ ├─ "sys" ──────────────────────┐ │

│ │ ├─ "user_id": Variable │ 系统变量 │

│ │ ├─ "app_id": Variable │ │

│ │ └─ "workflow_id": Variable │ │

│ │ │ │

│ ├─ "env" ──────────────────────┤ │

│ │ ├─ "API_KEY": Variable │ 环境变量 │

│ │ └─ "MODEL": Variable │ │

│ │ │ │

│ ├─ "start" ────────────────────┤ │

│ │ ├─ "query": Variable │ START节点输出 │

│ │ └─ "files": Variable │ │

│ │ │ │

│ ├─ "llm_1" ────────────────────┤ │

│ │ ├─ "output": Variable │ LLM节点输出 │

│ │ └─ "usage": Variable │ │

│ │ │ │

│ └─ "code_1" ───────────────────┤ │

│ └─ "result": Variable │ CODE节点输出 │

│ │ │

└──────────────────────────────────┴──────────────────────┘

访问路径示例:

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

pool.get(["llm_1", "output"])

└─┬──┘ └──┬───┘

│ └─ 第二层索引:variable_name

└────────── 第一层索引:node_id

pool.get(["code_1", "result", "keywords", "0"])

└──┬───┘ └──┬───┘ └───┬────┘ └┬┘

│ │ │ └─ 数组索引

│ │ └───────── 对象属性

│ └───────────────────第二层索引

└────────────────────────────第一层索引变量选择器(Selector)机制

Selector 的定义

Selector 是一个序列(通常是 tuple 或 list),用于定位变量:

python

# 基本选择器格式

selector = [node_id, variable_name]

# 示例

selector = ["llm_1", "output"] # 定位到 llm_1 节点的 output 变量

selector = ["sys", "user_id"] # 定位到系统变量 user_id扩展选择器(支持嵌套访问)

python

# 访问对象属性

selector = ["llm_1", "metadata", "model"]

# 等价于:variable_pool["llm_1"]["metadata"].value["model"]

# 访问文件属性

selector = ["start", "file", "name"]

# 等价于:variable_pool["start"]["file"].name

# 访问深层嵌套

selector = ["code_1", "result", "data", "items", "0"]

# 等价于:variable_pool["code_1"]["result"]["data"]["items"][0]核心方法详解

add() - 添加变量

python

def add(self, selector: Sequence[str], value: Any, /):

"""

【核心功能】添加变量到变量池

参数:

selector: 变量选择器 [node_id, variable_name]

value: 变量值(支持多种类型)

步骤:

1. 验证 selector 长度(必须为 2)

2. 将 value 转换为 Variable 对象

3. 分解 selector 为 (node_id, name)

4. 存入双层字典

"""

# ========== 步骤 1:验证选择器长度 ==========

if len(selector) != SELECTORS_LENGTH: # SELECTORS_LENGTH = 2

raise ValueError(

f"Invalid selector: expected 2 elements (node_id, variable_name), "

f"got {len(selector)} elements"

)

# ========== 步骤 2:值类型转换 ==========

# 2.1 如果已经是 Variable 对象,直接使用

if isinstance(value, Variable):

variable = value

# 2.2 如果是 Segment 对象,转换为 Variable

elif isinstance(value, Segment):

variable = variable_factory.segment_to_variable(

segment=value,

selector=selector

)

# 2.3 普通值(str, int, dict, list 等),先转为 Segment,再转为 Variable

else:

segment = variable_factory.build_segment(value)

variable = variable_factory.segment_to_variable(

segment=segment,

selector=selector

)

# ========== 步骤 3:分解选择器 ==========

node_id, name = self._selector_to_keys(selector)

# 例如:["llm_1", "output"] -> node_id="llm_1", name="output"

# ========== 步骤 4:存入双层字典 ==========

self.variable_dictionary[node_id][name] = variable

# 结果:variable_dictionary["llm_1"]["output"] = StringVariable(...)示例:

python

# 示例 1:添加字符串

pool.add(["llm_1", "output"], "Hello world")

# 内部转换流程:

# "Hello world"

# -> StringSegment(value="Hello world")

# -> StringVariable(name="output", value="Hello world", selector=["llm_1", "output"])

# 示例 2:添加对象

pool.add(["code_1", "result"], {"score": 95, "status": "success"})

# 内部转换流程:

# {"score": 95, "status": "success"}

# -> ObjectSegment(value={...})

# -> ObjectVariable(name="result", value={...})

# 示例 3:添加文件

file = File(filename="doc.pdf", ...)

pool.add(["start", "file"], file)

# 内部转换流程:

# File对象

# -> FileSegment(value=File(...))

# -> FileVariable(name="file", value=File(...))get() - 获取变量

python

def get(self, selector: Sequence[str], /) -> Segment | None:

"""

【核心功能】从变量池获取变量值

支持:

- 简单访问:[node_id, variable_name]

- 嵌套访问:[node_id, variable_name, attr1, attr2, ...]

返回:

Segment 对象或 None

"""

# ========== 步骤 1:验证选择器长度 ==========

if len(selector) < SELECTORS_LENGTH: # 至少 2 个元素

return None

# ========== 步骤 2:分解选择器并查找节点 ==========

node_id, name = self._selector_to_keys(selector)

# 例如:["llm_1", "output", "text"] -> node_id="llm_1", name="output"

# 获取节点字典

node_map = self.variable_dictionary.get(node_id)

if node_map is None:

return None # 节点不存在

# 获取变量

segment: Segment | None = node_map.get(name)

if segment is None:

return None # 变量不存在

# ========== 步骤 3:简单访问(selector 长度为 2) ==========

if len(selector) == 2:

return segment # 直接返回整个 Segment

# ========== 步骤 4:文件属性访问 ==========

if isinstance(segment, FileSegment):

attr = selector[2]

# 验证是否为有效的文件属性(name, url, size, type 等)

if attr not in {item.value for item in FileAttribute}:

return None

attr = FileAttribute(attr)

# 使用文件管理器获取属性值

attr_value = file_manager.get_attr(file=segment.value, attr=attr)

return variable_factory.build_segment(attr_value)

# ========== 步骤 5:嵌套对象访问 ==========

# 遍历剩余的选择器路径

result: Any = segment

for attr in selector[2:]:

# 提取实际值(如果是 ObjectSegment,提取 .value)

result = self._extract_value(result)

# 获取嵌套属性

result = self._get_nested_attribute(result, attr)

if result is None:

return None # 路径中断

# ========== 步骤 6:返回结果 ==========

# 确保返回的是 Segment 对象

return result if isinstance(result, Segment) else variable_factory.build_segment(result)

def _extract_value(self, obj: Any):

"""提取 ObjectSegment 的实际值"""

return obj.value if isinstance(obj, ObjectSegment) else obj

def _get_nested_attribute(self, obj: Mapping[str, Any], attr: str) -> Segment | None:

"""从字典中获取嵌套属性"""

if not isinstance(obj, dict) or attr not in obj:

return None

return variable_factory.build_segment(obj.get(attr))示例:

python

# 准备数据

pool.add(["llm_1", "output"], "Hello world")

pool.add(["code_1", "result"], {

"score": 95,

"details": {

"accuracy": 0.98,

"items": ["item1", "item2"]

}

})

pool.add(["start", "file"], File(filename="doc.pdf", url="http://..."))

# 示例 1:简单访问

segment = pool.get(["llm_1", "output"])

# 返回:StringSegment(value="Hello world")

print(segment.value) # "Hello world"

# 示例 2:对象属性访问

segment = pool.get(["code_1", "result", "score"])

# 访问路径:variable_dictionary["code_1"]["result"].value["score"]

# 返回:IntegerSegment(value=95)

print(segment.value) # 95

# 示例 3:深层嵌套访问

segment = pool.get(["code_1", "result", "details", "accuracy"])

# 访问路径:

# 1. variable_dictionary["code_1"]["result"] -> ObjectSegment

# 2. .value["details"] -> {"accuracy": 0.98, "items": [...]}

# 3. ["accuracy"] -> 0.98

# 返回:FloatSegment(value=0.98)

print(segment.value) # 0.98

# 示例 4:文件属性访问

segment = pool.get(["start", "file", "name"])

# 特殊处理:FileSegment 支持属性访问

# 返回:StringSegment(value="doc.pdf")

print(segment.value) # "doc.pdf"

segment = pool.get(["start", "file", "url"])

# 返回:StringSegment(value="http://...")

print(segment.value) # "http://..."

# 示例 5:不存在的路径

segment = pool.get(["code_1", "result", "non_exist"])

# 返回:Noneremove() - 移除变量

python

def remove(self, selector: Sequence[str], /):

"""

【核心功能】从变量池移除变量

支持两种模式:

1. 移除整个节点:selector = [node_id]

2. 移除特定变量:selector = [node_id, variable_name]

"""

if not selector:

return

# ========== 模式 1:移除整个节点 ==========

if len(selector) == 1:

# 清空该节点的所有变量

self.variable_dictionary[selector[0]] = {}

return

# ========== 模式 2:移除特定变量 ==========

node_id, name = self._selector_to_keys(selector)

self.variable_dictionary[node_id].pop(name, None)示例:

python

# 准备数据

pool.add(["llm_1", "output"], "Hello")

pool.add(["llm_1", "usage"], {"tokens": 100})

pool.add(["llm_2", "output"], "World")

# 示例 1:移除特定变量

pool.remove(["llm_1", "output"])

# 结果:variable_dictionary["llm_1"] 只剩下 {"usage": ...}

# 示例 2:移除整个节点

pool.remove(["llm_1"])

# 结果:variable_dictionary["llm_1"] = {}get_by_prefix() - 按节点前缀获取所有变量

python

def get_by_prefix(self, prefix: str, /) -> Mapping[str, object]:

"""

【核心功能】获取某个节点的所有变量

参数:

prefix: 节点 ID

返回:

字典:{variable_name: value} (深拷贝)

"""

# ========== 步骤 1:获取节点字典 ==========

nodes = self.variable_dictionary.get(prefix)

if not nodes:

return {}

# ========== 步骤 2:提取所有变量值 ==========

result: dict[str, object] = {}

for key, variable in nodes.items():

value = variable.value # 提取 Variable 的实际值

result[key] = deepcopy(value) # 深拷贝,避免外部修改

return result示例:

python

# 准备数据

pool.add(["llm_1", "output"], "Hello world")

pool.add(["llm_1", "usage"], {"tokens": 100, "cost": 0.002})

pool.add(["llm_1", "model"], "gpt-4")

# 获取 llm_1 节点的所有变量

all_vars = pool.get_by_prefix("llm_1")

# 返回:

# {

# "output": "Hello world",

# "usage": {"tokens": 100, "cost": 0.002},

# "model": "gpt-4"

# }

print(all_vars["output"]) # "Hello world"

print(all_vars["usage"]["tokens"]) # 100特殊节点 ID

Dify 使用一些预定义的特殊节点 ID 来存储系统级变量:

python

# 常量定义

SYSTEM_VARIABLE_NODE_ID = "sys"

ENVIRONMENT_VARIABLE_NODE_ID = "env"

CONVERSATION_VARIABLE_NODE_ID = "conversation"

RAG_PIPELINE_VARIABLE_NODE_ID = "rag_pipeline"系统变量(sys)

python

# 系统变量在初始化时自动添加

def _add_system_variables(self, system_variable: SystemVariable):

"""将系统变量添加到变量池"""

sys_var_mapping = system_variable.to_dict()

for key, value in sys_var_mapping.items():

if value is None:

continue

selector = (SYSTEM_VARIABLE_NODE_ID, key) # ("sys", key)

if self._has(selector):

continue # 已存在,不覆盖

self.add(selector, value)

# 使用示例

user_id = pool.get(["sys", "user_id"])

app_id = pool.get(["sys", "app_id"])

workflow_id = pool.get(["sys", "workflow_id"])系统变量列表:

sys.user_id: 用户 IDsys.app_id: 应用 IDsys.workflow_id: 工作流 IDsys.workflow_run_id: 工作流执行 IDsys.query: 用户查询(聊天模式)sys.conversation_id: 对话 IDsys.dialogue_count: 对话轮数sys.files: 上传的文件列表

环境变量(env)

python

# 环境变量在初始化时自动添加

for var in self.environment_variables:

self.add((ENVIRONMENT_VARIABLE_NODE_ID, var.name), var)

# 使用示例

api_key = pool.get(["env", "OPENAI_API_KEY"])

db_url = pool.get(["env", "DATABASE_URL"])对话变量(conversation)

python

# 对话变量在初始化时自动添加

for var in self.conversation_variables:

self.add((CONVERSATION_VARIABLE_NODE_ID, var.name), var)

# 使用示例

history = pool.get(["conversation", "chat_history"])

context = pool.get(["conversation", "context"])完整示例流程:变量池的生命周期

python

from core.workflow.runtime import VariablePool

from core.workflow.system_variable import SystemVariable

# ========== 1. 初始化变量池 ==========

system_vars = SystemVariable(

user_id="user_123",

app_id="app_456",

workflow_id="wf_789",

query="解释量子计算",

)

env_vars = [

StringVariable(name="API_KEY", value="sk-xxx"),

StringVariable(name="MODEL", value="gpt-4"),

]

pool = VariablePool(

system_variables=system_vars,

environment_variables=env_vars,

user_inputs={"temperature": 0.7, "max_tokens": 1000}

)

# 此时变量池结构:

# {

# "sys": {

# "user_id": StringVariable("user_123"),

# "app_id": StringVariable("app_456"),

# "workflow_id": StringVariable("wf_789"),

# "query": StringVariable("解释量子计算"),

# },

# "env": {

# "API_KEY": StringVariable("sk-xxx"),

# "MODEL": StringVariable("gpt-4"),

# }

# }

# ========== 2. 执行 START 节点 ==========

# START 节点通常会添加用户输入到变量池

pool.add(["start", "query"], "解释量子计算")

pool.add(["start", "files"], [])

# ========== 3. 执行 LLM 节点 ==========

# LLM 节点从变量池读取输入

query = pool.get(["start", "query"])

model = pool.get(["env", "MODEL"])

# 模拟 LLM 调用

llm_output = "量子计算是利用量子力学原理进行计算的技术..."

llm_usage = {"tokens": 150, "cost": 0.003}

# LLM 节点将输出写入变量池

pool.add(["llm_1", "output"], llm_output)

pool.add(["llm_1", "usage"], llm_usage)

# ========== 4. 执行 CODE 节点 ==========

# CODE 节点读取 LLM 输出

llm_result = pool.get(["llm_1", "output"])

# 处理逻辑

code_result = {

"summary": llm_result.value[:50] + "...",

"word_count": len(llm_result.value),

"keywords": ["量子", "计算", "量子力学"]

}

# 写入结果

pool.add(["code_1", "result"], code_result)

# ========== 5. 访问嵌套数据 ==========

# 获取关键词列表的第一个元素

first_keyword = pool.get(["code_1", "result", "keywords", "0"])

print(first_keyword.value) # "量子"

# 获取字数统计

word_count = pool.get(["code_1", "result", "word_count"])

print(word_count.value) # 整数

# ========== 6. 批量获取节点输出 ==========

llm_outputs = pool.get_by_prefix("llm_1")

# 返回:

# {

# "output": "量子计算是...",

# "usage": {"tokens": 150, "cost": 0.003}

# }

# ========== 7. 清理(可选) ==========

pool.remove(["llm_1", "output"]) # 移除单个变量

pool.remove(["code_1"]) # 移除整个节点索引性能分析

时间复杂度

| 操作 | 时间复杂度 | 说明 |

|---|---|---|

add(selector, value) |

O(1) | 直接哈希定位 |

get(selector) |

O(1) + O(k) | O(1) 定位 + O(k) 嵌套访问 |

remove(selector) |

O(1) | 直接哈希删除 |

get_by_prefix(node_id) |

O(n) | n = 该节点的变量数 |

其中 k 是嵌套访问的深度。

空间复杂度

- 双层字典 :O(N × M)

- N = 节点数量

- M = 每个节点的平均变量数

为什么使用双层索引?

优势:

✅ 局部性好:同一节点的变量聚集在一起,缓存友好

✅ 查询高效:两次哈希查找即可定位变量(O(1))

✅ 按节点管理:可以快速获取/删除整个节点的所有变量

✅ 避免冲突 :不同节点可以有同名变量(如多个 LLM 节点都有 output)

✅ 扩展性强:支持嵌套访问,无需修改底层结构

对比单层字典:

python

# ❌ 单层字典(不推荐)

variable_dictionary = {

"start.query": Variable(...),

"llm_1.output": Variable(...),

"llm_1.usage": Variable(...),

}

# 问题:

# - 字符串拼接性能差

# - 不支持按节点批量操作

# - 嵌套访问困难

# ✅ 双层字典(当前实现)

variable_dictionary = {

"start": {"query": Variable(...)},

"llm_1": {"output": Variable(...), "usage": Variable(...)},

}

# 优势:

# - 哈希查找快

# - 支持 get_by_prefix("llm_1")

# - 结构清晰状态持久化详解:PostgreSQL + 事件驱动持久化

架构概览

Dify 采用事件驱动的持久化架构,通过监听工作流执行过程中的事件来增量持久化状态。

plain

┌──────────────────────────────────────────────────────────┐

│ GraphEngine │

│ │

│ ┌─────────────┐ ┌──────────────┐ │

│ │ Worker │─────→│ EventQueue │ │

│ └─────────────┘ └──────┬───────┘ │

│ │ │

│ ▼ │

│ ┌──────────────┐ │

│ │ Dispatcher │ │

│ └──────┬───────┘ │

│ │ │

│ ▼ │

│ ┌──────────────────┐ │

│ │ EventManager │ │

│ │ (通知所有 Layers)│ │

│ └──────┬───────────┘ │

└──────────────────────────────┼──────────────────────────┘

│

▼

┌──────────────────────┐

│ WorkflowPersistence │ ← GraphEngineLayer

│ Layer │

└──────────┬───────────┘

│

┌──────────────┴─────────────┐

▼ ▼

┌──────────────────────┐ ┌──────────────────────┐

│ WorkflowExecution │ │ WorkflowNodeExecution│

│ Repository │ │ Repository │

└──────────┬───────────┘ └──────────┬───────────┘

│ │

▼ ▼

┌─────────────┐ ┌─────────────────┐

│ WorkflowRun │ │WorkflowNodeExec │

│ (表) │ │ Model (表) │

└─────────────┘ └─────────────────┘

│ │

└────────────┬───────────────┘

▼

┌──────────────────┐

│ PostgreSQL │

└──────────────────┘架构图

plain

┌──────────────────────────────────────────────────┐

│ GraphEngine (事件驱动引擎) │

└──────────────────┬───────────────────────────────┘

│

┌─────────┴─────────┐

│ EventManager │

│ (事件管理器) │

└─────────┬─────────┘

│

│ notify_layers(event)

│

↓

┌─────────────────────┐

│ PersistenceLayer │

│ (持久化层) │

└─────────┬───────────┘

│

│ on_event(event)

│

┌─────────┴─────────┐

│ │

↓ ↓

WorkflowExecution WorkflowNodeExecution

Repository Repository

│ │

│ │

┌────┴────┐ ┌────┴────┐

│ │ │ │

↓ ↓ ↓ ↓

SQLAlchemy Logstore Celery ...

Repository Repository Repository

│ │ │

└────┬────┴────┬────┘

│ │

↓ ↓

PostgreSQL Aliyun SLS执行流程可视化

plain

时刻T0: 用户请求

↓

时刻T1: WorkflowEntry.run() 被调用

├─ GraphEngine 初始化

├─ PersistenceLayer 初始化

└─ GraphEngine.run() 启动

↓

时刻T2: GraphRunStartedEvent

├─ EventManager 收集事件

├─ PersistenceLayer 监听到事件

└─ PostgreSQL 写入: WorkflowRun (status=running)

↓

时刻T3: start节点入队

├─ ReadyQueue.put("start")

└─ Worker线程从队列取出"start"

↓

时刻T4: start节点开始执行

├─ NodeRunStartedEvent

├─ PersistenceLayer 写入: WorkflowNodeExecution (node_id=start, status=running)

└─ start.run() 执行

↓

时刻T5: start节点执行成功

├─ NodeRunSucceededEvent

├─ PersistenceLayer 更新: WorkflowNodeExecution (status=succeeded)

├─ EdgeProcessor 处理边: start → llm

└─ ReadyQueue.put("llm")

↓

时刻T6: llm节点开始执行

├─ NodeRunStartedEvent

├─ PersistenceLayer 写入: WorkflowNodeExecution (node_id=llm, status=running)

└─ llm.run() 调用GPT-3.5

↓

... (等待LLM响应) ...

↓

时刻T7: llm节点流式输出

├─ NodeRunStreamChunkEvent (多次)

└─ 前端实时显示生成的文本

↓

时刻T8: llm节点执行成功

├─ NodeRunSucceededEvent

├─ PersistenceLayer 更新: WorkflowNodeExecution (status=succeeded, outputs={text: "..."})

├─ EdgeProcessor 处理边: llm → end

└─ ReadyQueue.put("end")

↓

时刻T9: end节点开始执行

├─ NodeRunStartedEvent

├─ PersistenceLayer 写入: WorkflowNodeExecution (node_id=end, status=running)

└─ end.run() 执行

↓

时刻T10: end节点执行成功

├─ NodeRunSucceededEvent

├─ PersistenceLayer 更新: WorkflowNodeExecution (status=succeeded)

└─ EdgeProcessor: 没有更多边

↓

时刻T11: 工作流执行完成

├─ GraphRunSucceededEvent

├─ PersistenceLayer 更新: WorkflowRun (status=succeeded, outputs={answer: "..."})

└─ EventManager.mark_complete()

↓

时刻T12: 返回最终结果给用户持久化详细流程

PostgreSQL Repository PersistenceLayer EventManager 事件产生 PostgreSQL Repository PersistenceLayer EventManager 事件产生 节点执行产生事件 收集事件 通知Layer 创建领域实体 调用Repository 转换模型 数据库操作 节点执行完成 NodeRunStartedEvent collect(event) on_event(event) WorkflowNodeExecution.new() save(execution) _to_db_model(execution) session.merge(db_model) commit success saved handled NodeRunSucceededEvent on_event(event) save(execution) session.merge(db_model) commit success

!!!核心组件职责总结

| 组件 | 职责 | 输入 | 输出 |

|---|---|---|---|

| WorkflowEntry | 调度入口 | 用户请求 | 事件流 |

| GraphEngine | 协调引擎 | 图结构+状态 | 事件流 |

| WorkerPool | 并行执行 | 节点ID | 节点事件 |

| Dispatcher | 事件调度 | 事件队列 | 分发给EventHandler |

| EventHandler | 事件处理 | 事件 | 状态更新+触发下一个节点 |

| EventManager | 事件管理 | 事件 | 通知Layer+发射事件 |

| PersistenceLayer | 状态持久化 | 事件 | 数据库写入 |

| Repository | 数据访问 | 领域实体 | 数据库操作 |

设计模式总结

| 模式 | 应用位置 | 作用 |

|---|---|---|

| 门面模式 | WorkflowEntry | 简化外部调用 |

| 生产者-消费者 | ReadyQueue + Worker | 解耦节点执行 |

| 观察者模式 | EventManager + Layer | 事件通知 |

| 单分派模式 | EventHandler._dispatch | 事件路由 |

| Repository模式 | Repository | 抽象数据访问 |

| Layer模式 | GraphEngineLayer | 扩展功能 |

| 事件溯源 | 全局 | 状态管理 |

| 领域驱动设计 | 领域实体 | 业务逻辑与数据分离 |

数据库模型

WorkflowRun(工作流执行记录)

python

class WorkflowRun(Base):

"""

工作流执行的主记录表

存储:工作流执行的元数据和最终结果

"""

__tablename__ = "workflow_runs"

# ========== 核心字段 ==========

id: str # UUID - 执行 ID

tenant_id: str # 租户 ID(多租户隔离)

app_id: str # 应用 ID

workflow_id: str # 工作流 ID

# ========== 执行信息 ==========

type: str # 工作流类型:workflow / chatflow

triggered_from: str # 触发源:debugging / app-run

version: str # 工作流版本号

graph: str | None # 工作流 DSL 配置(JSON 字符串)

# ========== 输入输出 ==========

inputs: str | None # 输入参数(JSON 字符串)

outputs: str | None # 输出结果(JSON 字符串)

# ========== 状态信息 ==========

status: str # 状态:running / succeeded / failed / stopped / paused

error: str | None # 错误信息

# ========== 统计信息 ==========

elapsed_time: float # 执行耗时(秒)

total_tokens: int # 总 token 数

total_steps: int # 总执行步骤数

exceptions_count: int # 异常节点数

# ========== 时间信息 ==========

created_at: datetime # 创建时间(开始时间)

finished_at: datetime | None # 完成时间

# ========== 创建者信息 ==========

created_by_role: str # 创建者角色:account / end_user

created_by: str # 创建者 ID示例数据:

json

{

"id": "09b3e04c-f9ae-404c-ad82-290b8d7bd382",

"tenant_id": "tenant_123",

"app_id": "app_456",

"workflow_id": "wf_789",

"type": "workflow",

"triggered_from": "app-run",

"version": "2024-01-14T10:30:00",

"graph": "{\"nodes\": [...], \"edges\": [...]}",

"inputs": "{\"query\": \"解释量子计算\"}",

"outputs": "{\"answer\": \"量子计算是...\"}",

"status": "succeeded",

"error": null,

"elapsed_time": 3.45,

"total_tokens": 150,

"total_steps": 3,

"exceptions_count": 0,

"created_at": "2024-01-14 10:30:00",

"finished_at": "2024-01-14 10:30:03",

"created_by_role": "account",

"created_by": "user_abc"

}WorkflowNodeExecutionModel(节点执行记录)

python

class WorkflowNodeExecutionModel(Base):

"""

节点执行的详细记录表

存储:每个节点执行的详细信息(输入、输出、过程数据)

"""

__tablename__ = "workflow_node_executions"

# ========== 核心字段 ==========

id: str # UUID - 记录 ID

node_execution_id: str | None # 节点执行 ID(用于引用)

tenant_id: str # 租户 ID

app_id: str # 应用 ID

workflow_id: str # 工作流 ID

# ========== 关联关系 ==========

workflow_run_id: str | None # 所属工作流执行 ID

triggered_from: str # 触发源:single-step / workflow-run

index: int # 执行序号(用于排序)

predecessor_node_id: str | None # 前驱节点 ID

# ========== 节点信息 ==========

node_id: str # 节点 ID(如:llm_1)

node_type: str # 节点类型(如:llm, code, tool)

title: str # 节点标题

# ========== 执行数据 ==========

inputs: str | None # 输入数据(JSON 字符串,可能被截断)

process_data: str | None # 过程数据(JSON 字符串,可能被截断)

outputs: str | None # 输出数据(JSON 字符串,可能被截断)

# ========== 状态信息 ==========

status: str # 状态:running / succeeded / failed / retry

error: str | None # 错误信息

elapsed_time: float # 执行耗时(秒)

# ========== 元数据 ==========

execution_metadata: str | None # 执行元数据(JSON),如:

# - total_tokens

# - total_price

# - currency

# - iteration_id

# - loop_id

# ========== 时间信息 ==========

created_at: datetime # 创建时间(节点开始时间)

finished_at: datetime | None # 完成时间

# ========== 创建者信息 ==========

created_by_role: str # 创建者角色

created_by: str # 创建者 ID

# ========== 关联关系(ORM) ==========

offload_data: list[WorkflowNodeExecutionOffload] # 卸载数据(大数据)索引设计:

python

# 索引 1:按工作流执行查询

Index("workflow_node_execution_workflow_run_idx",

"tenant_id", "app_id", "workflow_id",

"triggered_from", "workflow_run_id")

# 索引 2:按节点查询历史

Index("workflow_node_execution_node_run_idx",

"tenant_id", "app_id", "workflow_id",

"triggered_from", "node_id")

# 索引 3:按执行 ID 查询

Index("workflow_node_execution_id_idx",

"tenant_id", "app_id", "workflow_id",

"triggered_from", "node_execution_id")WorkflowNodeExecutionOffload(大数据卸载表)

python

class WorkflowNodeExecutionOffload(Base):

"""

大数据卸载表

用途:当节点的 inputs/outputs/process_data 超过阈值时,

完整数据存储到对象存储(如 S3),数据库只保存截断版本

"""

__tablename__ = "workflow_node_execution_offload"

id: str # UUID - 卸载记录 ID

created_at: datetime # 创建时间

tenant_id: str # 租户 ID

app_id: str # 应用 ID

node_execution_id: str | None # 关联的节点执行 ID

type_: ExecutionOffLoadType # 卸载类型:INPUTS / OUTPUTS / PROCESS_DATA

file_id: str # 对象存储中的文件 ID

# 关联关系(ORM)

file: UploadFile # 文件记录

execution: WorkflowNodeExecutionModel # 节点执行记录卸载策略:

python

# 配置阈值(来自 dify_config)

WORKFLOW_VARIABLE_TRUNCATION_MAX_SIZE = 1024 * 1024 # 1MB

WORKFLOW_VARIABLE_TRUNCATION_ARRAY_LENGTH = 100 # 数组最大 100 个元素

WORKFLOW_VARIABLE_TRUNCATION_STRING_LENGTH = 10000 # 字符串最大 10000 字符

# 判断是否需要卸载

if data_size > MAX_SIZE:

# 1. 截断数据(保留摘要)

truncated_data = truncator.truncate(original_data)

# 2. 完整数据上传到对象存储

file = upload_to_storage(original_data)

# 3. 数据库存储截断版本

db_model.inputs = json.dumps(truncated_data)

# 4. 创建卸载记录

offload = WorkflowNodeExecutionOffload(

type_=ExecutionOffLoadType.INPUTS,

file_id=file.id

)事件驱动持久化层

工作流持久化层 WorkflowPersistenceLayer

python

class WorkflowPersistenceLayer(GraphEngineLayer):

"""

【核心功能】工作流持久化层

作用:

1. 监听 GraphEngine 产生的事件

2. 根据事件类型更新数据库状态

3. 实现增量持久化,避免阻塞执行

特点:

- 事件驱动:不主动查询,被动响应事件

- 增量更新:只在状态变化时写入

- 异步友好:在独立线程中处理

"""

def __init__(

self,

*,

application_generate_entity,

workflow_info: PersistenceWorkflowInfo,

workflow_execution_repository: WorkflowExecutionRepository,

workflow_node_execution_repository: WorkflowNodeExecutionRepository,

trace_manager: TraceQueueManager | None = None,

) -> None:

"""

初始化持久化层

参数:

workflow_info: 工作流静态信息(ID、版本、DSL)

workflow_execution_repository: 工作流执行仓库

workflow_node_execution_repository: 节点执行仓库

trace_manager: 追踪管理器(用于 OTel)

"""

self._workflow_info = workflow_info

self._workflow_execution_repository = workflow_execution_repository

self._workflow_node_execution_repository = workflow_node_execution_repository

self._trace_manager = trace_manager

# ========== 内存缓存 ==========

self._workflow_execution: WorkflowExecution | None = None

self._node_execution_cache: dict[str, WorkflowNodeExecution] = {}

self._node_snapshots: dict[str, _NodeRuntimeSnapshot] = {}

self._node_sequence: int = 0

def on_event(self, event: GraphEngineEvent) -> None:

"""

【核心方法】事件处理分发器

根据事件类型调用相应的处理方法

"""

# ========== 工作流级别事件 ==========

if isinstance(event, GraphRunStartedEvent):

self._handle_graph_run_started()

return

if isinstance(event, GraphRunSucceededEvent):

self._handle_graph_run_succeeded(event)

return

if isinstance(event, GraphRunFailedEvent):

self._handle_graph_run_failed(event)

return

if isinstance(event, GraphRunAbortedEvent):

self._handle_graph_run_aborted(event)

return

if isinstance(event, GraphRunPausedEvent):

self._handle_graph_run_paused(event)

return

# ========== 节点级别事件 ==========

if isinstance(event, NodeRunStartedEvent):

self._handle_node_started(event)

return

if isinstance(event, NodeRunSucceededEvent):

self._handle_node_succeeded(event)

return

if isinstance(event, NodeRunFailedEvent):

self._handle_node_failed(event)

return

if isinstance(event, NodeRunRetryEvent):

self._handle_node_retry(event)

return

if isinstance(event, NodeRunExceptionEvent):

self._handle_node_exception(event)

return工作流级别事件处理

python

def _handle_graph_run_started(self) -> None:

"""

【事件】工作流开始

动作:

1. 创建 WorkflowExecution 领域对象

2. 持久化到数据库

3. 缓存到内存

"""

execution_id = self._get_execution_id() # 从系统变量获取

# ========== 创建领域对象 ==========

workflow_execution = WorkflowExecution.new(

id_=execution_id,

workflow_id=self._workflow_info.workflow_id,

workflow_type=self._workflow_info.workflow_type,

workflow_version=self._workflow_info.version,

graph=self._workflow_info.graph_data, # 工作流 DSL

inputs=self._prepare_workflow_inputs(), # 输入参数

started_at=naive_utc_now(),

)

# 此时状态: status = WorkflowExecutionStatus.RUNNING

# ========== 持久化 ==========

self._workflow_execution_repository.save(workflow_execution)

# ========== 缓存 ==========

self._workflow_execution = workflow_execution

# 数据库记录示例:

# INSERT INTO workflow_runs (

# id, tenant_id, app_id, workflow_id, status, inputs, created_at

# ) VALUES (

# 'exec_123', 'tenant_1', 'app_1', 'wf_1',

# 'running', '{"query": "..."}', NOW()

# );

def _handle_graph_run_succeeded(self, event: GraphRunSucceededEvent) -> None:

"""

【事件】工作流成功完成

动作:

1. 更新输出结果

2. 更新状态为 SUCCEEDED

3. 更新统计信息(tokens、steps、耗时)

4. 持久化

5. 触发追踪任务

"""

execution = self._get_workflow_execution()

# ========== 更新状态 ==========

execution.outputs = event.outputs # 最终输出

execution.status = WorkflowExecutionStatus.SUCCEEDED

# ========== 更新统计信息 ==========

self._populate_completion_statistics(execution)

# 内部逻辑:

# - execution.finished_at = now()

# - execution.total_tokens = runtime_state.total_tokens

# - execution.total_steps = runtime_state.node_run_steps

# ========== 持久化 ==========

self._workflow_execution_repository.save(execution)

# ========== 触发追踪 ==========

self._enqueue_trace_task(execution) # 发送到 OTel

# 数据库更新示例:

# UPDATE workflow_runs SET

# status = 'succeeded',

# outputs = '{"answer": "..."}',

# finished_at = NOW(),

# elapsed_time = 3.45,

# total_tokens = 150,

# total_steps = 3

# WHERE id = 'exec_123';

def _handle_graph_run_failed(self, event: GraphRunFailedEvent) -> None:

"""

【事件】工作流执行失败

动作:

1. 更新状态为 FAILED

2. 记录错误信息

3. 标记所有运行中的节点为失败

4. 持久化

"""

execution = self._get_workflow_execution()

execution.status = WorkflowExecutionStatus.FAILED

execution.error_message = event.error

execution.exceptions_count = event.exceptions_count

self._populate_completion_statistics(execution)

# ========== 处理运行中的节点 ==========

self._fail_running_node_executions(error_message=event.error)

# ========== 持久化 ==========

self._workflow_execution_repository.save(execution)

self._enqueue_trace_task(execution)节点级别事件处理

python

def _handle_node_started(self, event: NodeRunStartedEvent) -> None:

"""

【事件】节点开始执行

动作:

1. 创建 WorkflowNodeExecution 领域对象

2. 立即持久化(状态=RUNNING)

3. 缓存到内存

"""

execution = self._get_workflow_execution()

# ========== 准备元数据 ==========

metadata = {

WorkflowNodeExecutionMetadataKey.ITERATION_ID: event.in_iteration_id,

WorkflowNodeExecutionMetadataKey.LOOP_ID: event.in_loop_id,

}

# ========== 创建领域对象 ==========

domain_execution = WorkflowNodeExecution(

id=event.id, # 执行 ID

node_execution_id=event.id,

workflow_id=execution.workflow_id,

workflow_execution_id=execution.id_,

predecessor_node_id=event.predecessor_node_id, # 前驱节点

index=self._next_node_sequence(), # 自增序号

node_id=event.node_id, # 节点 ID(如:llm_1)

node_type=event.node_type, # 节点类型

title=event.node_title, # 节点标题

status=WorkflowNodeExecutionStatus.RUNNING, # 状态:运行中

metadata=metadata,

created_at=event.start_at, # 开始时间

)

# ========== 持久化 ==========

self._node_execution_cache[event.id] = domain_execution

self._workflow_node_execution_repository.save(domain_execution)

# ========== 缓存快照 ==========

snapshot = _NodeRuntimeSnapshot(

node_id=event.node_id,

title=event.node_title,

predecessor_node_id=event.predecessor_node_id,

iteration_id=event.in_iteration_id,

loop_id=event.in_loop_id,

created_at=event.start_at,

)

self._node_snapshots[event.id] = snapshot

# 数据库插入示例:

# INSERT INTO workflow_node_executions (

# id, workflow_run_id, node_id, node_type,

# title, status, index, created_at

# ) VALUES (

# 'node_exec_1', 'exec_123', 'llm_1', 'llm',

# 'LLM节点', 'running', 1, NOW()

# );

def _handle_node_succeeded(self, event: NodeRunSucceededEvent) -> None:

"""

【事件】节点执行成功

动作:

1. 更新状态为 SUCCEEDED

2. 存储输入、输出、过程数据

3. 计算耗时

4. 持久化(包括大数据卸载)

"""

domain_execution = self._get_node_execution(event.id)

self._update_node_execution(

domain_execution,

event.node_run_result, # 包含 inputs, outputs, process_data

WorkflowNodeExecutionStatus.SUCCEEDED

)

def _update_node_execution(

self,

domain_execution: WorkflowNodeExecution,

node_result: NodeRunResult,

status: WorkflowNodeExecutionStatus,

*,

error: str | None = None,

update_outputs: bool = True,

) -> None:

"""

【核心方法】更新节点执行记录

"""

# ========== 计算耗时 ==========

finished_at = naive_utc_now()

snapshot = self._node_snapshots.get(domain_execution.id)

start_at = snapshot.created_at if snapshot else domain_execution.created_at

domain_execution.elapsed_time = (finished_at - start_at).total_seconds()

# ========== 更新状态 ==========

domain_execution.status = status

domain_execution.finished_at = finished_at

if error:

domain_execution.error = error

# ========== 更新执行数据 ==========

if update_outputs:

domain_execution.update_from_mapping(

inputs=node_result.inputs, # 节点输入

process_data=node_result.process_data, # 过程数据

outputs=node_result.outputs, # 节点输出

metadata=node_result.metadata, # 元数据(tokens等)

)

# ========== 两阶段持久化 ==========

# 阶段 1:保存基本信息

self._workflow_node_execution_repository.save(domain_execution)

# 阶段 2:保存执行数据(可能触发大数据卸载)

self._workflow_node_execution_repository.save_execution_data(domain_execution)

# 数据库更新示例:

# UPDATE workflow_node_executions SET

# status = 'succeeded',

# inputs = '{"query": "..."}',

# outputs = '{"output": "..."}',

# finished_at = NOW(),

# elapsed_time = 1.23

# WHERE id = 'node_exec_1';Repository 模式实现

SQLAlchemyWorkflowExecutionRepository

python

class SQLAlchemyWorkflowExecutionRepository(WorkflowExecutionRepository):

"""

工作流执行仓库(SQLAlchemy 实现)

职责:

- 领域对象与数据库模型之间的转换

- 数据库CRUD操作

- 内存缓存管理

- 多租户隔离

"""

def __init__(

self,

session_factory: sessionmaker | Engine,

user: Union[Account, EndUser],

app_id: str | None,

triggered_from: WorkflowRunTriggeredFrom | None,

):

self._session_factory = session_factory

self._tenant_id = extract_tenant_id(user)

self._app_id = app_id

self._triggered_from = triggered_from

self._creator_user_id = user.id

self._creator_user_role = (

CreatorUserRole.ACCOUNT

if isinstance(user, Account)

else CreatorUserRole.END_USER

)

# ========== 内存缓存 ==========

self._execution_cache: dict[str, WorkflowRun] = {}

def save(self, execution: WorkflowExecution):

"""

【核心方法】保存工作流执行记录

步骤:

1. 领域对象 → 数据库模型

2. 使用 SQLAlchemy merge(自动判断 INSERT/UPDATE)

3. 更新内存缓存

"""

# ========== 步骤 1:转换模型 ==========

db_model = self._to_db_model(execution)

# ========== 步骤 2:持久化 ==========

with self._session_factory() as session:

# merge 方法会自动判断是插入还是更新

# - 如果 ID 存在:UPDATE

# - 如果 ID 不存在:INSERT

session.merge(db_model)

session.commit()

# ========== 步骤 3:更新缓存 ==========

self._execution_cache[db_model.id] = db_model

def _to_db_model(self, domain_model: WorkflowExecution) -> WorkflowRun:

"""

【转换】领域对象 → 数据库模型

"""

db_model = WorkflowRun()

# 基本字段

db_model.id = domain_model.id_

db_model.workflow_id = domain_model.workflow_id

db_model.type = domain_model.workflow_type

db_model.version = domain_model.workflow_version

# JSON 字段(序列化)

db_model.graph = json.dumps(domain_model.graph)

db_model.inputs = json.dumps(domain_model.inputs)

db_model.outputs = json.dumps(

WorkflowRuntimeTypeConverter().to_json_encodable(domain_model.outputs)

)

# 状态字段

db_model.status = domain_model.status

db_model.error = domain_model.error_message or None

# 统计字段

db_model.total_tokens = domain_model.total_tokens

db_model.total_steps = domain_model.total_steps

db_model.exceptions_count = domain_model.exceptions_count

# 时间字段

db_model.created_at = domain_model.started_at

db_model.finished_at = domain_model.finished_at

if domain_model.finished_at:

db_model.elapsed_time = (

domain_model.finished_at - domain_model.started_at

).total_seconds()

# 多租户字段(从构造函数注入)

db_model.tenant_id = self._tenant_id

db_model.app_id = self._app_id

db_model.triggered_from = self._triggered_from

db_model.created_by_role = self._creator_user_role

db_model.created_by = self._creator_user_id

return db_modelSQLAlchemyWorkflowNodeExecutionRepository

python

class SQLAlchemyWorkflowNodeExecutionRepository(WorkflowNodeExecutionRepository):

"""

节点执行仓库(SQLAlchemy 实现)

特殊功能:

- 大数据截断和卸载

- 并发数据加载

- 重试机制(处理 UUID 冲突)

"""

def save(self, execution: WorkflowNodeExecution) -> None:

"""

【核心方法】保存节点执行记录(基本信息)

注意:此方法只保存基本字段,不处理大数据

大数据由 save_execution_data() 处理

"""

db_model = self._to_db_model(execution)

# ========== 重试机制(处理 UUID 冲突) ==========

@retry(

stop=stop_after_attempt(3),

retry=retry_if_exception(self._is_duplicate_key_error),

reraise=True,

)

def _save_with_retry():

try:

self._persist_to_database(db_model)

except IntegrityError as e:

if self._is_duplicate_key_error(e):

# 生成新的 UUID v7 并重试

self._regenerate_id_on_duplicate(execution, db_model)

raise

else:

raise

_save_with_retry()

# 更新缓存

if db_model.node_execution_id:

self._node_execution_cache[db_model.node_execution_id] = db_model

def save_execution_data(self, execution: WorkflowNodeExecution):

"""

【核心方法】保存节点执行数据(inputs, outputs, process_data)

特点:

1. 检查数据大小

2. 超过阈值则截断并卸载到对象存储

3. 数据库只保存截断版本

"""

domain_model = execution

# ========== 加载现有记录 ==========

with self._session_factory(expire_on_commit=False) as session:

query = WorkflowNodeExecutionModel.preload_offload_data(

select(WorkflowNodeExecutionModel)

).where(WorkflowNodeExecutionModel.id == domain_model.id)

db_model = session.execute(query).scalars().first()

if db_model is None:

db_model = self._to_db_model(domain_model)

offload_data = db_model.offload_data or []

# ========== 处理 inputs ==========

if domain_model.inputs is not None:

result = self._truncate_and_upload(

domain_model.inputs,

domain_model.id,

ExecutionOffLoadType.INPUTS,

)

if result is not None:

# 数据被截断,需要卸载

db_model.inputs = self._json_encode(result.truncated_value)

domain_model.set_truncated_inputs(result.truncated_value)

offload_data = _replace_or_append_offload(offload_data, result.offload)

else:

# 数据未超阈值,直接存储

db_model.inputs = self._json_encode(domain_model.inputs)

# ========== 处理 outputs(同理) ==========

if domain_model.outputs is not None:

result = self._truncate_and_upload(

domain_model.outputs,

domain_model.id,

ExecutionOffLoadType.OUTPUTS,

)

if result is not None:

db_model.outputs = self._json_encode(result.truncated_value)

domain_model.set_truncated_outputs(result.truncated_value)

offload_data = _replace_or_append_offload(offload_data, result.offload)

else:

db_model.outputs = self._json_encode(domain_model.outputs)

# ========== 处理 process_data(同理) ==========

if domain_model.process_data is not None:

result = self._truncate_and_upload(

domain_model.process_data,

domain_model.id,

ExecutionOffLoadType.PROCESS_DATA,

)

if result is not None:

db_model.process_data = self._json_encode(result.truncated_value)

domain_model.set_truncated_process_data(result.truncated_value)

offload_data = _replace_or_append_offload(offload_data, result.offload)

else:

db_model.process_data = self._json_encode(domain_model.process_data)

# ========== 更新卸载数据 ==========

db_model.offload_data = offload_data

# ========== 持久化 ==========

with self._session_factory() as session, session.begin():

session.merge(db_model)

session.flush()

def _truncate_and_upload(

self,

values: Mapping[str, Any] | None,

execution_id: str,

type_: ExecutionOffLoadType,

) -> _InputsOutputsTruncationResult | None:

"""

【核心方法】截断并上传大数据

返回:

None:数据未超阈值

Result:包含截断版本、文件、卸载记录

"""

if values is None:

return None

# ========== 步骤 1:JSON 序列化 ==========

converter = WorkflowRuntimeTypeConverter()

json_encodable_value = converter.to_json_encodable(values)

# ========== 步骤 2:截断检查 ==========

truncator = self._create_truncator()

truncated_values, truncated = truncator.truncate_variable_mapping(

json_encodable_value

)

if not truncated:

return None # 未超阈值,无需卸载

# ========== 步骤 3:上传完整数据到对象存储 ==========

value_json = json.dumps(json_encodable_value, sort_keys=True)

upload_file = self._file_service.upload_file(

filename=f"node_execution_{execution_id}_{type_.value}.json",

content=value_json.encode("utf-8"),

mimetype="application/json",

user=self._user,

)

# ========== 步骤 4:创建卸载记录 ==========

offload = WorkflowNodeExecutionOffload(

id=uuidv7(),

tenant_id=self._tenant_id,

app_id=self._app_id,

node_execution_id=execution_id,

type_=type_,

file_id=upload_file.id,

)

return _InputsOutputsTruncationResult(

truncated_value=truncated_values,

file=upload_file,

offload=offload,

)完整执行流程示例

场景:执行一个包含 3 个节点的工作流

plain

工作流:START → LLM → CODE时序图

ObjectStorage PostgreSQL NodeExecRepo WorkflowExecRepo PersistenceLayer GraphEngine ObjectStorage PostgreSQL NodeExecRepo WorkflowExecRepo PersistenceLayer GraphEngine 工作流开始 START 节点开始 START 节点成功 LLM 节点开始 LLM 节点成功 CODE 节点开始 CODE 节点成功 工作流成功 GraphRunStartedEvent save(WorkflowExecution) INSERT INTO workflow_runs OK NodeRunStartedEvent(start) save(NodeExecution) INSERT INTO workflow_node_executions OK NodeRunSucceededEvent(start) save_execution_data(start) 检查数据大小 UPDATE workflow_node_executions OK NodeRunStartedEvent(llm_1) save(NodeExecution) INSERT INTO workflow_node_executions OK NodeRunSucceededEvent(llm_1) save_execution_data(llm_1) 数据超过1MB!需要卸载 上传完整数据 file_id: abc123 UPDATE workflow_node_executions (保存截断版本) INSERT INTO workflow_node_execution_offload OK NodeRunStartedEvent(code_1) save(NodeExecution) INSERT INTO workflow_node_executions OK NodeRunSucceededEvent(code_1) save_execution_data(code_1) UPDATE workflow_node_executions OK GraphRunSucceededEvent save(WorkflowExecution) UPDATE workflow_runs (status=succeeded) OK

数据库记录快照

T1: 工作流开始后

sql

-- workflow_runs 表

SELECT id, status, inputs, outputs, created_at, finished_at

FROM workflow_runs

WHERE id = 'exec_123';

/*

id | status | inputs | outputs | created_at | finished_at

-----------+---------+---------------------------+---------+---------------------+------------

exec_123 | running | {"query": "解释量子计算"} | NULL | 2024-01-14 10:30:00 | NULL

*/

-- workflow_node_executions 表(空)

SELECT COUNT(*) FROM workflow_node_executions WHERE workflow_run_id = 'exec_123';

-- 结果:0T2: START 节点执行完成后

sql

SELECT id, node_id, status, inputs, outputs, created_at, finished_at

FROM workflow_node_executions

WHERE workflow_run_id = 'exec_123'

ORDER BY index;

/*

id | node_id | status | inputs | outputs | created_at | finished_at

-------------+---------+-----------+-----------------------------+-----------------------------+---------------------+---------------------

node_exec_1 | start | succeeded | {} | {"query": "解释量子计算"} | 2024-01-14 10:30:00 | 2024-01-14 10:30:00

*/T3: LLM 节点执行完成后(大数据卸载)

sql

-- 节点执行记录(截断版本)

SELECT id, node_id, status,

LENGTH(inputs), LENGTH(outputs),

created_at, finished_at

FROM workflow_node_executions

WHERE workflow_run_id = 'exec_123' AND node_id = 'llm_1';

/*

id | node_id | status | LENGTH(inputs) | LENGTH(outputs) | created_at | finished_at

-------------+---------+-----------+----------------+-----------------+---------------------+---------------------