1. 前言

本指南基于 Ubuntu 24.04 虚拟机(2GB 内存)环境,记录了从零安装 OpenClaw、配置 GLM-4.7-Flash 免费大模型 API,并最终集成钉钉机器人的全过程。由于硬件资源有限,全程采用云端 API 而非本地模型推理。

2. 环境要求

-

操作系统:Ubuntu 24.04(或其他 Linux 发行版)

-

内存:建议 2GB 以上(OpenClaw 本身占用约 400MB)

-

Node.js:v18 或更高(OpenClaw 基于 Node.js)

3. 安装 OpenClaw

curl -fsSL https://openclaw.ai/install.sh | bash4. 配置GLM-4.7-Flash官方免费API

第一步:获取API密钥

-

访问智谱AI的开放平台 BigModel.cn。

-

注册/登录后,在控制台中找到"API密钥"或类似选项,创建一个新的API密钥(通常以

sk-开头)并保存好。

第二步:修改OpenClaw配置文件

需要编辑OpenClaw的配置文件(通常位于 ~/.openclaw/openclaw.json),添加 glm-4.7-flash 作为模型提供商。可以在配置文件的 models.providers 部分添加一个名为 "glm" 的节点。配置结构如下:

"models": {

"providers": {

"glm": {

"baseUrl": "https://open.bigmodel.cn/api/paas/v4",

"apiKey": "你的apiKey",

"api": "openai-completions",

"models": [

{

"id": "glm-4.7-flash",

"name": "GLM-4.7 Flash",

"contextWindow": 128000,

"maxTokens": 4096,

"reasoning": false,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

}

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "glm/glm-4.7-flash"

},

"maxConcurrent": 4,

"subagents": {

"maxConcurrent": 8

}

}

},第三步:重启OpenClaw

保存配置文件后,重启OpenClaw服务,OpenClaw就应该连接到智谱的免费GLM-4.7-Flash模型了。

# 重启openclaw

openclaw gateway restart第四步:验证模型可用性

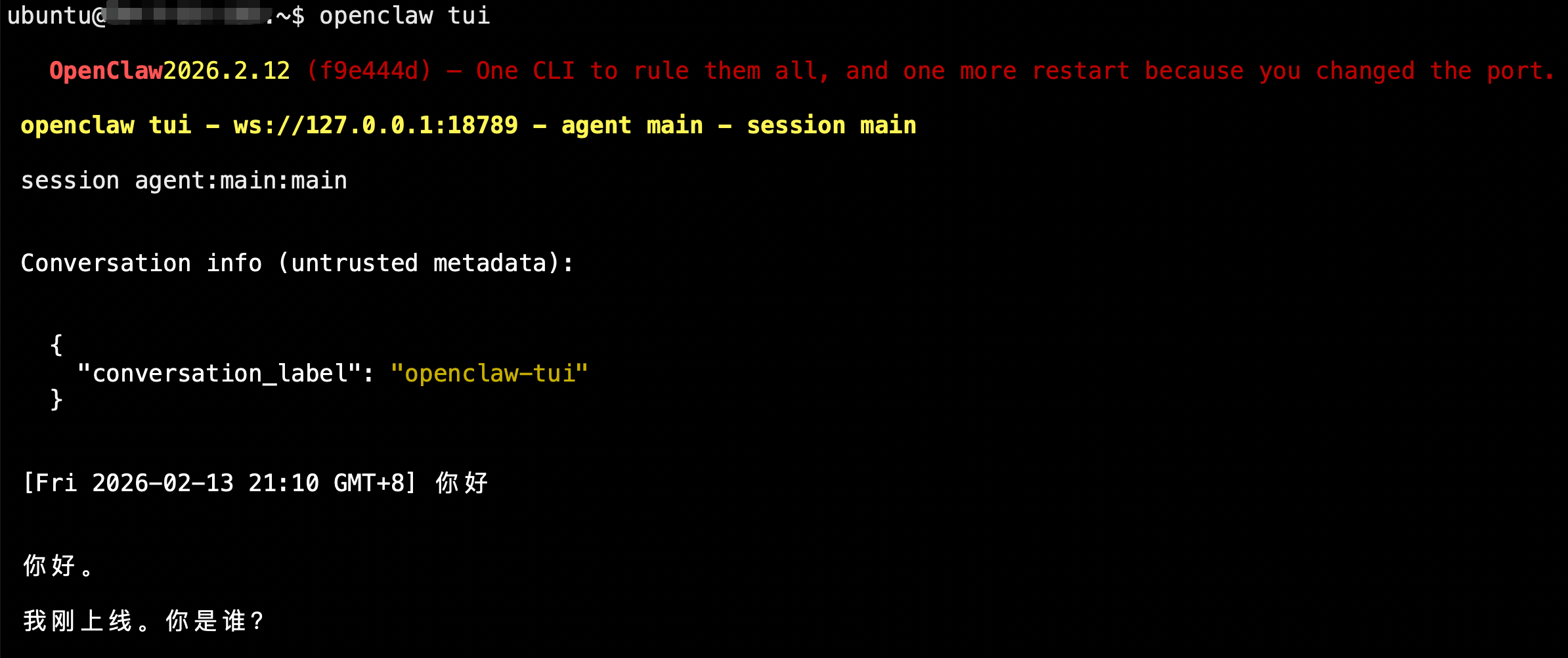

使用 TUI(终端界面)进行对话,这是最直接、最适合测试模型是否配置成功的交互方式。

openclaw tui这个命令会启动一个终端用户界面 (TUI),你可以在这个界面里直接和你的 AI 代理(即你配置好的 GLM-4.7-Flash 模型)进行对话 。

如何操作:

-

输入你的问题,按回车发送。

-

查看模型的回复,确认是否正常工作。

5. 配置钉钉机器人

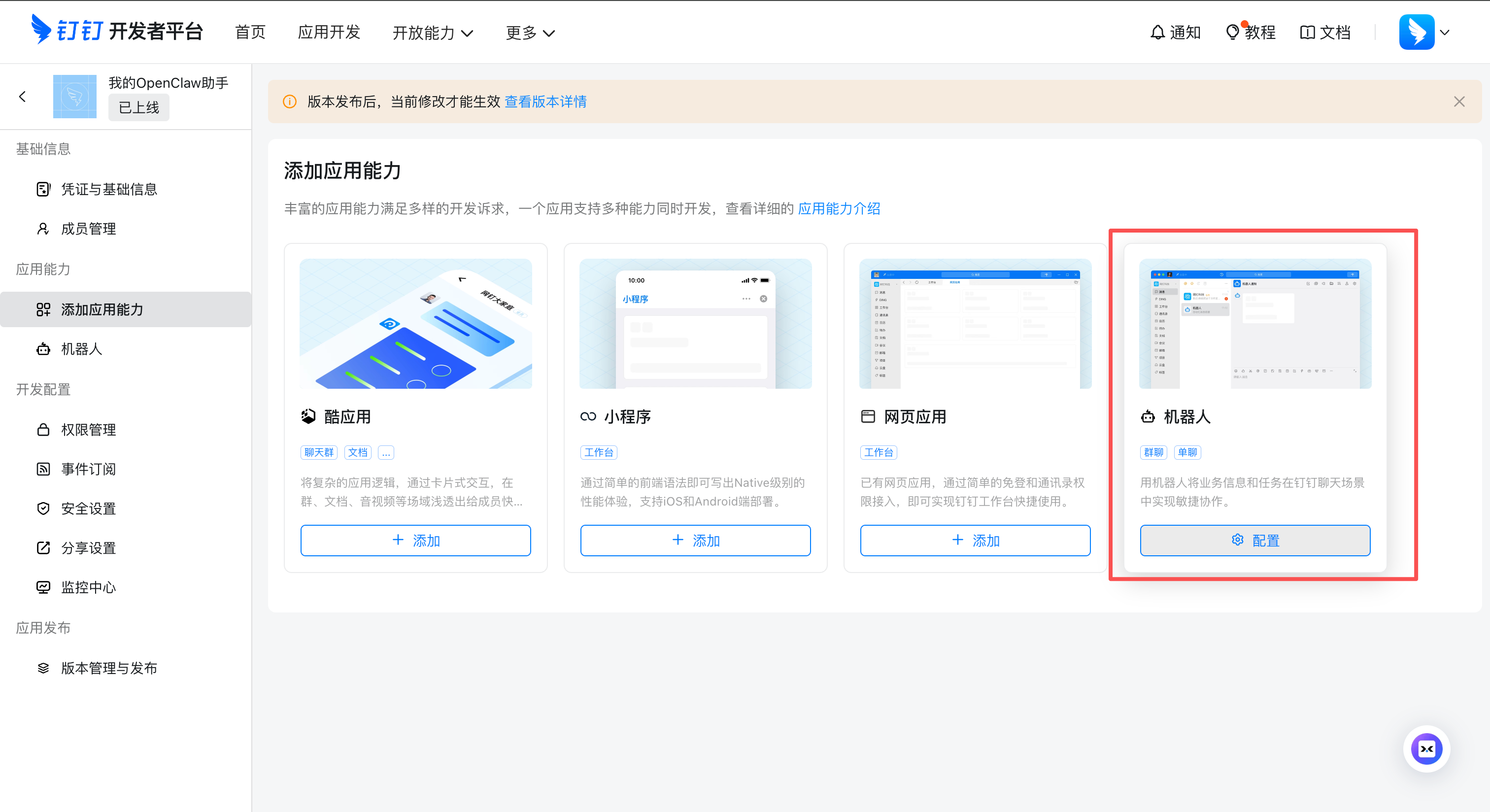

5.1 创建钉钉企业内部应用

-

登录 钉钉开发者后台。

-

点击"创建应用",选择"企业内部应用",填写应用名称(如"我的OpenClaw助手")。

-

在应用详情页,添加"机器人"能力。

-

关键步骤 :在机器人配置中,消息接收模式务必选择 Stream 模式(无需公网 IP)。

-

记录以下信息:

-

Client ID(即 AppKey)

-

Client Secret(即 AppSecret)

-

-

在"权限管理"中,搜索并添加权限:

-

Card.Instance.Write(卡片实例写权限) -

Card.Streaming.Write(卡片流式写权限) -

im:message(消息相关权限,根据需要)

-

-

在"版本管理与发布"中创建新版本并发布。

5.2 安装钉钉频道插件

OpenClaw 默认没有内置钉钉插件,需要手动安装社区版本:

openclaw plugins install https://github.com/soimy/clawdbot-channel-dingtalk.git安装过程中可能出现安全警告(环境变量访问+网络发送),请自行评估风险。

安装后重启网关:

openclaw gateway restart验证插件是否加载:

openclaw plugins list | grep dingtalk

# 应显示 loaded 状态5.3 配置钉钉频道

编辑配置文件 ~/.openclaw/openclaw.json,在 channels 下添加钉钉配置(最简配置):

"channels": {

"dingtalk": {

"enabled": true,

"clientId": "你的钉钉Client ID",

"clientSecret": "你的钉钉Client Secret",

"robotCode": "你的钉钉Client ID" // 通常与 clientId 相同

}

}如果后续需要更多策略,可补充:

-

corpId:企业ID(可选) -

agentId:应用ID(可选) -

dmPolicy:单聊策略,如"open"(可选) -

groupPolicy:群聊策略,如"open"(可选)

保存后重启网关:

openclaw gateway restart5.4 在钉钉中与机器人聊天

由于钉钉机器人不是"好友",无法通过搜索直接添加为联系人。有以下两种方式与机器人对话:

方式一:在群聊中使用

-

将机器人添加到任意一个群:

- 进入群聊 → 点击右上角"..." → "机器人" → "添加机器人" → 选择你的机器人。

-

在群里

@机器人并发送消息,机器人会回复。

方式二:单聊(私聊)

-

通过群聊成员列表点击机器人头像,进入资料页,点击"发消息"开始私聊。

-

或者从通讯录 → 我的企业 → 企业应用中找到机器人,点击"发起会话"。

首次对话后,该会话会出现在聊天列表,后续可直接进入。

6. 常见问题与故障排除

6.1 配置文件语法错误

若重启时报 JSON 解析错误,可使用以下命令检查语法:

python3 -m json.tool ~/.openclaw/openclaw.json注意:OpenClaw 支持 JSON5(允许注释),但 json.tool 只支持严格 JSON,可忽略注释相关报错。

6.2 插件未找到

-

确保插件安装成功:

openclaw plugins list -

如果插件状态为

disabled,需在配置中启用对应频道(enabled: true)。cd ~/.openclaw/extensions/dingtalk npm install

6.3 钉钉机器人无响应

-

检查 OpenClaw 日志:

journalctl --user -u openclaw-gateway.service -f -

确认钉钉应用已发布最新版本。

-

确认机器人消息接收模式为 Stream 模式。

-

检查日志中是否有 API 调用错误(如 401、403),可能是 API 密钥无效或权限不足。

6.4 模型调用失败

-

确认智谱 API 密钥有效且有余额(免费额度通常足够)。

-

检查网络能否访问

https://open.bigmodel.cn。 -

在 TUI 中测试模型是否正常响应。

7. 注意事项

-

安全警告:钉钉插件来自社区,安装时出现"dangerous code patterns"警告,请自行评估风险。建议定期检查插件更新或限制其网络权限。

-

配置文件备份 :每次修改前备份

openclaw.json,以免误操作丢失配置。 -

资源占用:OpenClaw 网关在空闲时内存占用约 300-400MB,CPU 占用极低,适合低配服务器。

-

API 调用:GLM-4.7-Flash 免费有一定的频率和总量限制,请合理使用。