本篇技术博文摘要 🌟

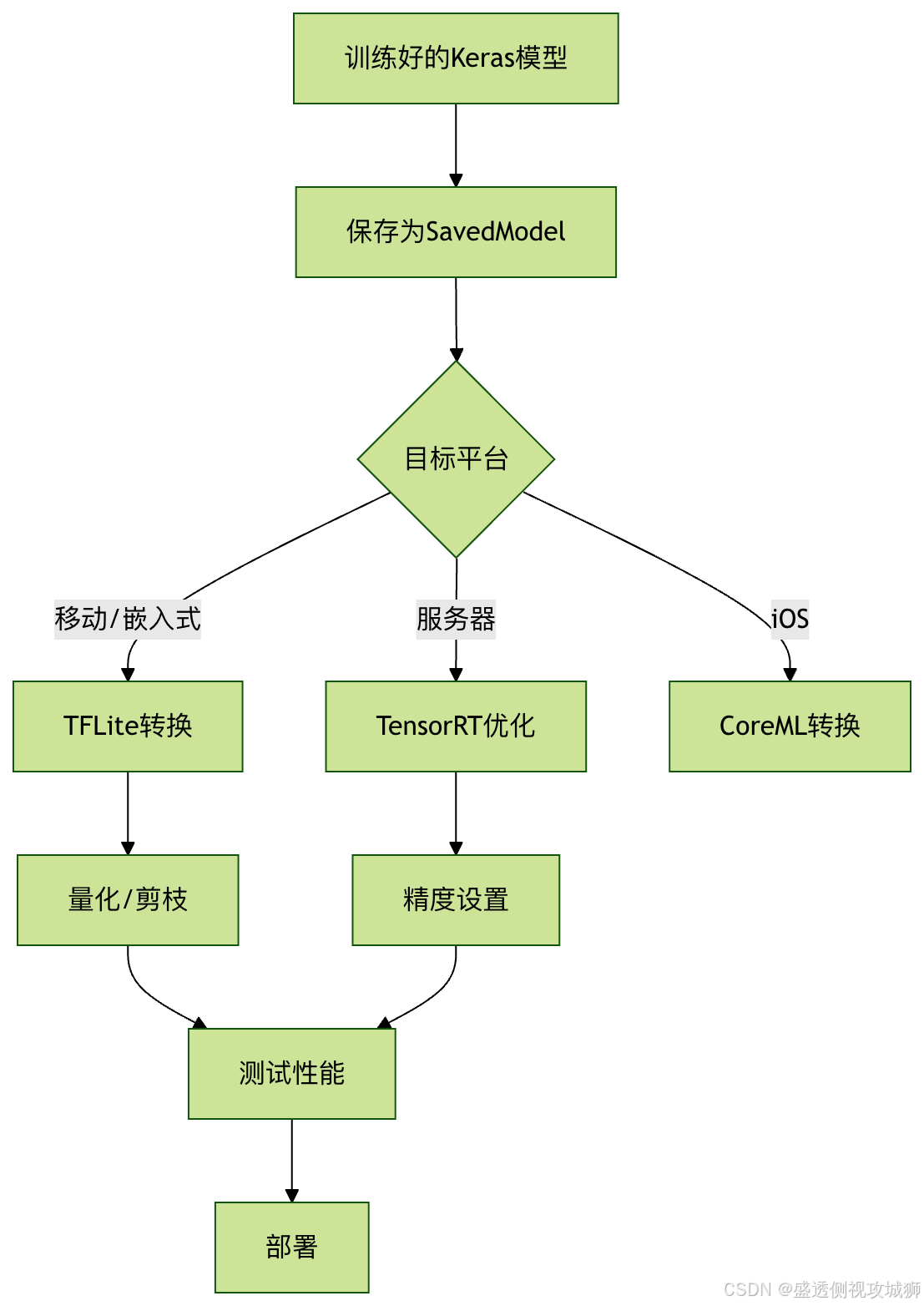

- 文章开篇通过上节回顾 承前启后,并深入探讨了为何需要进行模型转换与优化 ,明确了其在减小模型体积、提升推理速度及适配多样硬件中的关键价值,随后概述了主要的转换与优化技术全景。

- 在模型格式转换 核心章节,文章详细讲解了通用的SavedModel格式 及其关键特点 (如包含完整计算图与变量),并重点介绍了面向移动与边缘设备的TensorFlow Lite转换流程 及丰富的转换选项配置。

- 随后,文章深入模型优化技术 ,通过代码示例生动阐释了量化技术 (Quantization)的原理与多种量化类型对比 ,以及剪枝 (Pruning)如何通过稀疏化来压缩模型。针对特定硬件场景,本文提供了硬件特定优化 指南,包括利用TensorRT对NVIDIA GPU进行极致加速 ,以及将模型转换为Core ML格式以在Apple设备原生运行的完整方案。

- 最后,文章通过清晰的转换优化流程图 梳理了最佳决策路径,并针对实际应用中频发的常见问题给出了切实可行的解决方案,形成从理论到落地的完整闭环。

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.TensorFlow 模型转换与优化](#1.TensorFlow 模型转换与优化)

[2.1SavedModel 格式及示例](#2.1SavedModel 格式及示例)

[2.2TensorFlow Lite 转换](#2.2TensorFlow Lite 转换)

[2.2.1TensorFlow Lite转换选项](#2.2.1TensorFlow Lite转换选项)

[4.1TensorRT 优化(NVIDIA GPU)及代码示例](#4.1TensorRT 优化(NVIDIA GPU)及代码示例)

[4.2Core ML 转换(Apple 设备)及代码示例](#4.2Core ML 转换(Apple 设备)及代码示例)

[4.3Core ML 转换(Apple 设备)及代码示例](#4.3Core ML 转换(Apple 设备)及代码示例)

1.TensorFlow 模型转换与优化

在机器学习项目开发中,模型转换与优化是部署前的重要步骤。

TensorFlow 提供了多种工具和技术来帮助开发者将训练好的模型转换为适合不同部署环境的格式,并对其进行优化以提高性能。

1.1为什么需要模型转换与优化

- 部署需求:训练好的模型需要适配不同平台(移动端、嵌入式设备、服务器等)

- 性能提升:优化可以减少模型大小、降低延迟、提高推理速度

- 资源限制:移动设备和边缘计算设备通常有严格的内存和计算资源限制

- 跨平台兼容:确保模型能在不同硬件架构和操作系统上运行

1.2主要转换与优化技术

| 技术类型 | 主要工具 | 适用场景 |

|---|---|---|

| 模型格式转换 | tf.saved_model, TFLiteConverter |

跨平台部署 |

| 量化 | TFLiteConverter |

减小模型大小,提高推理速度 |

| 剪枝 | tfmot |

减少参数数量 |

| 硬件加速 | TensorRT, Core ML | 特定硬件优化 |

2.模型格式转换

2.1SavedModel 格式及示例

- SavedModel 是 TensorFlow 的标准模型保存格式,包含完整的模型架构、权重和计算图。

python

import tensorflow as tf

# 保存为 SavedModel

model.save('my_model', save_format='tf')

# 加载 SavedModel

loaded_model = tf.keras.models.load_model('my_model')2.1.1SavedModel关键特点

- 包含模型的计算图和变量

- 支持签名定义(输入/输出规范)

- 跨平台兼容(支持 TensorFlow Serving)

2.2TensorFlow Lite 转换

- TensorFlow Lite 是针对移动和嵌入式设备的轻量级解决方案

python

# 转换模型为 TFLite 格式

converter = tf.lite.TFLiteConverter.from_saved_model('my_model')

tflite_model = converter.convert()

# 保存转换后的模型

with open('model.tflite', 'wb') as f:

f.write(tflite_model)2.2.1TensorFlow Lite转换选项

optimizations:设置优化级别(默认、大小优化、延3.迟优化)target_spec:指定目标设备特性representative_dataset:用于量化校准的数据集

3.模型优化技术

3.1量化(Quantization)介绍及代码示例

- 量化通过降低数值精度来减小模型大小和提高推理速度

python

# 动态范围量化(最简单的量化方式)

converter = tf.lite.TFLiteConverter.from_saved_model('my_model')

converter.optimizations = [tf.lite.Optimize.DEFAULT]

tflite_quant_model = converter.convert()3.1.1量化类型对比

| 量化类型 | 权重精度 | 激活精度 | 大小减少 | 精度损失 |

|---|---|---|---|---|

| 无量化 | FP32 | FP32 | 0% | 无 |

| 动态范围 | INT8 | FP32 | ~75% | 小 |

| 全整型 | INT8 | INT8 | ~75% | 中等 |

| FP16 | FP16 | FP16 | ~50% | 很小 |

3.2剪枝(Pruning)介绍及代码示例

- 剪枝通过移除不重要的神经元连接来减少模型参数。

python

import tensorflow_model_optimization as tfmot

# 定义剪枝参数

prune_params = {

'pruning_schedule': tfmot.sparsity.keras.PolynomialDecay(

initial_sparsity=0.50,

final_sparsity=0.90,

begin_step=0,

end_step=1000

)

}

# 应用剪枝

model = tf.keras.Sequential([...]) # 你的模型

model_for_pruning = tfmot.sparsity.keras.prune_low_magnitude(model, **prune_params)

# 训练剪枝模型

model_for_pruning.compile(...)

model_for_pruning.fit(...)

# 去除剪枝包装

model_for_export = tfmot.sparsity.keras.strip_pruning(model_for_pruning)

4.硬件特定优化

4.1TensorRT 优化(NVIDIA GPU)及代码示例

python

# 使用 TF-TRT 转换器

from tensorflow.python.compiler.tensorrt import trt_convert as trt

converter = trt.TrtGraphConverterV2(

input_saved_model_dir='my_model',

precision_mode=trt.TrtPrecisionMode.FP16

)

converter.convert()

converter.save('trt_optimized_model')4.2Core ML 转换(Apple 设备)及代码示例

python

import coremltools as ct

# 从 SavedModel 转换

mlmodel = ct.convert('my_model')

# 保存 Core ML 模型

mlmodel.save('model.mlmodel')

4.3Core ML 转换(Apple 设备)及代码示例

python

import coremltools as ct

# 从 SavedModel 转换

mlmodel = ct.convert('my_model')

# 保存 Core ML 模型

mlmodel.save('model.mlmodel')

5.最佳实践与常见问题

5.1转换优化流程图

5.2常见问题解决

精度下降过多

- 尝试混合量化(部分层保持FP32)

- 使用量化感知训练(QAT)

转换后模型无法运行

- 检查操作兼容性(某些操作可能不被目标平台支持)

- 更新TensorFlow和转换器版本

性能提升不明显

- 确保正确设置了优化选项

- 考虑模型架构本身是否适合目标硬件

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********