Job那块的断点代码截图省略,直接进入切片逻辑

参考:Hadoop3:MapReduce之MapTask的Job任务提交流程原理解读(1)

4、FileInputFormat切片源码解析

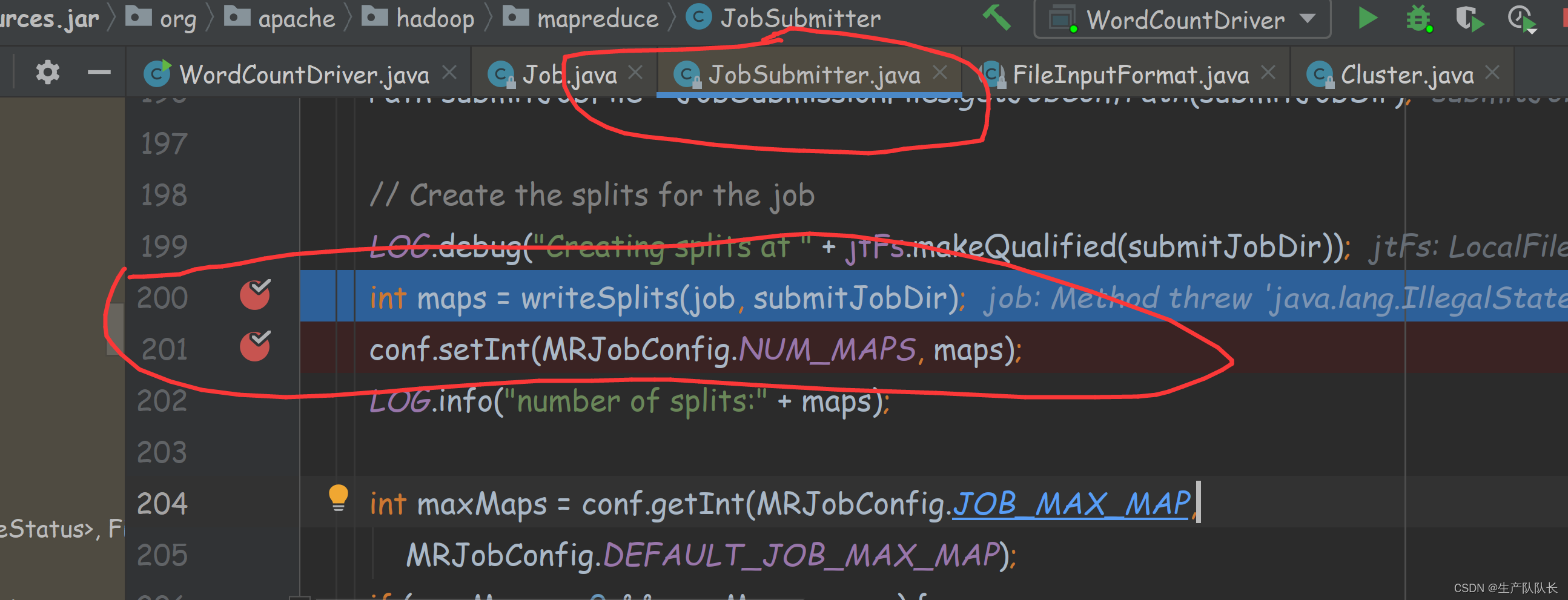

切片入口

获取切片数

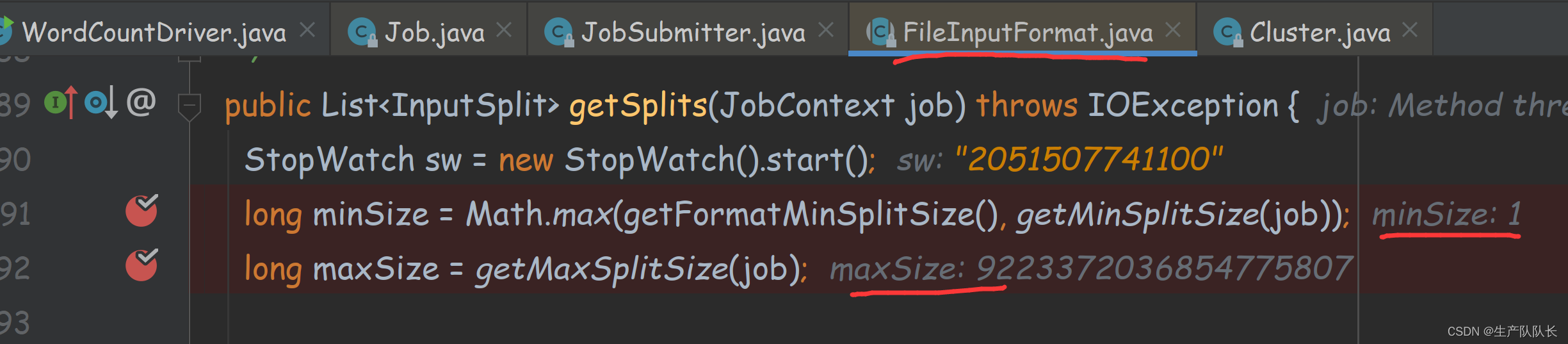

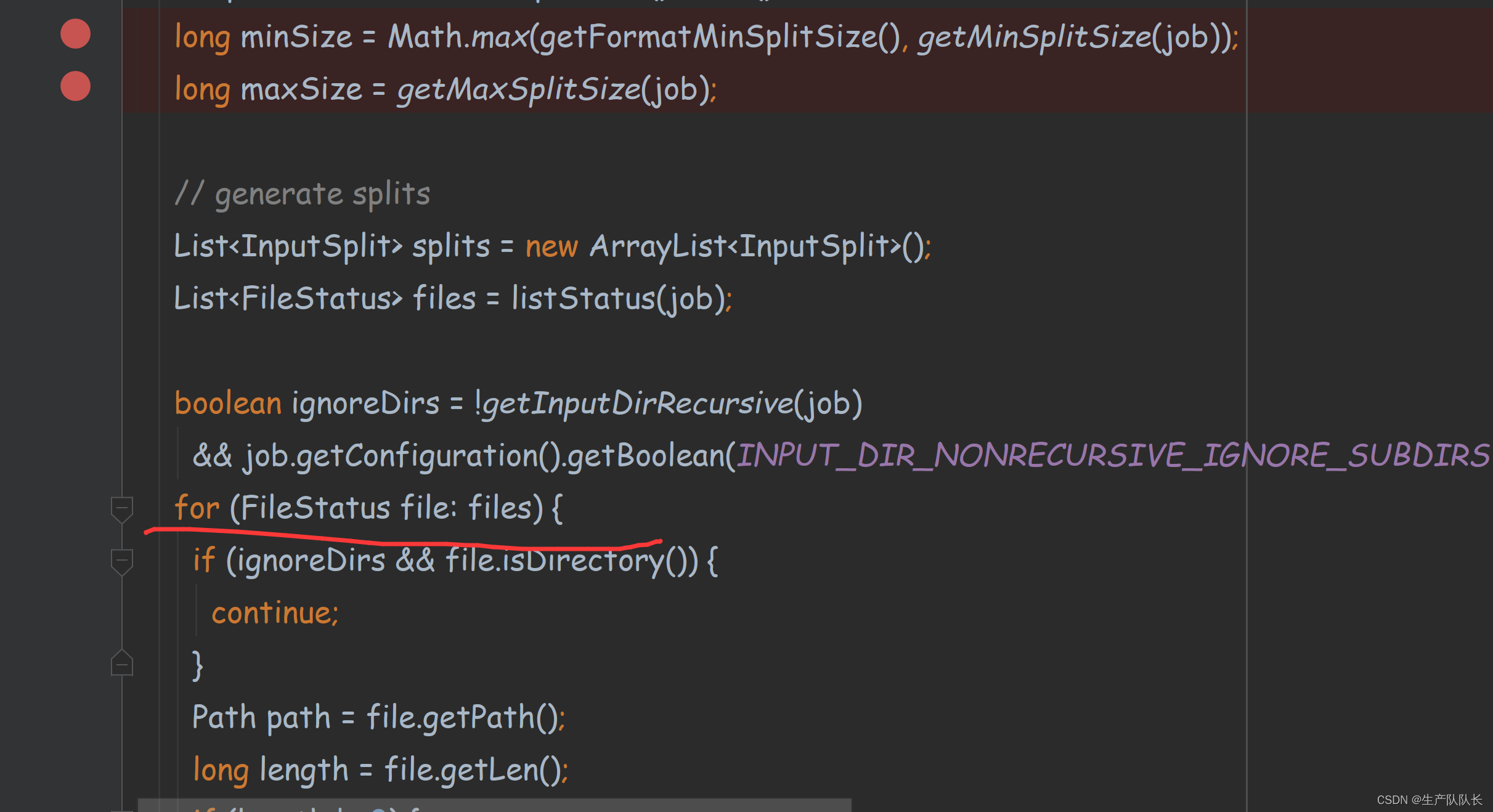

获取最大和最小切片数

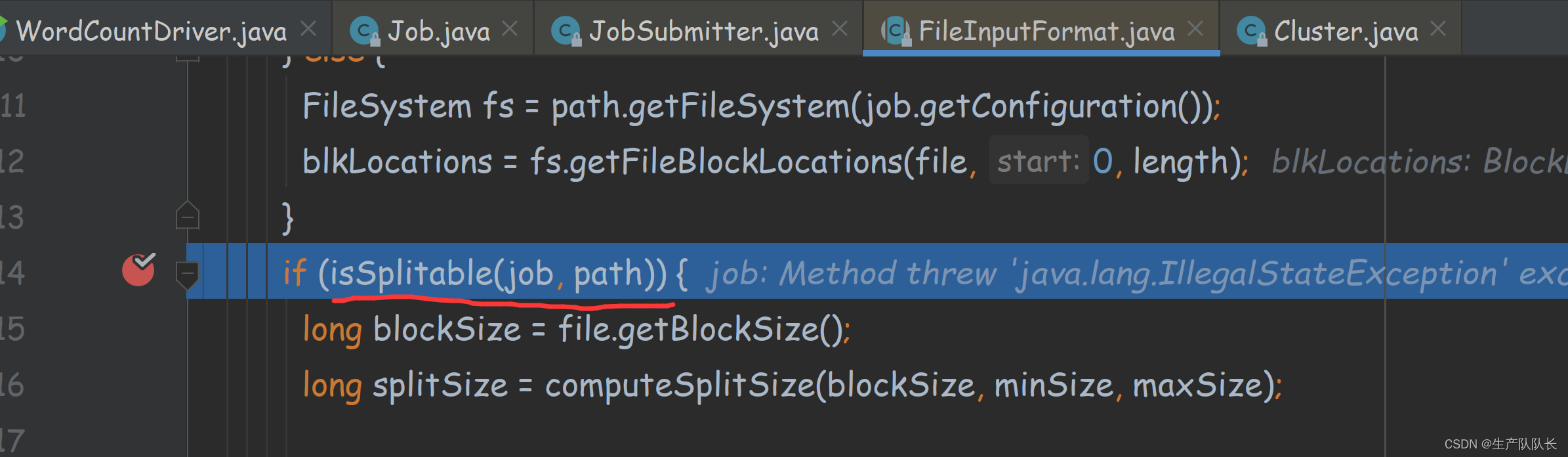

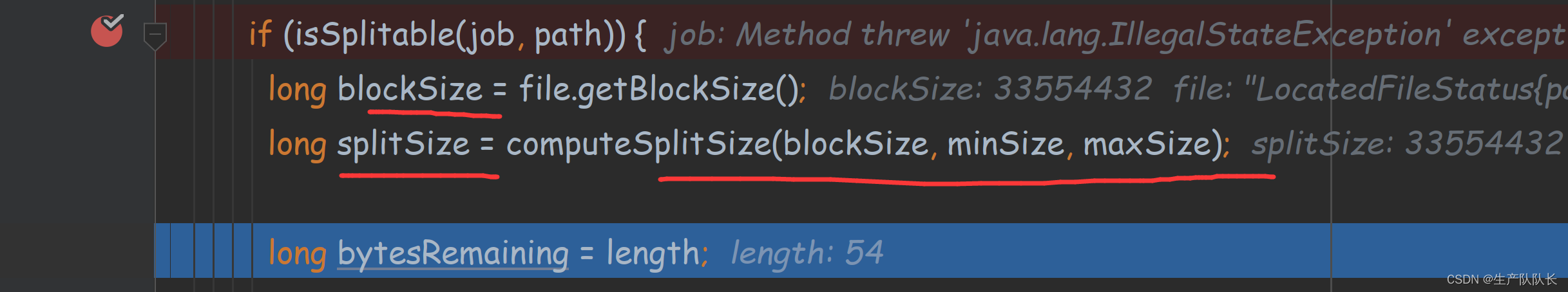

判断文件是否可以切片,如果文件不支持切片,则整体处理

这里只考虑支持切片的代码逻辑

计算切片大小

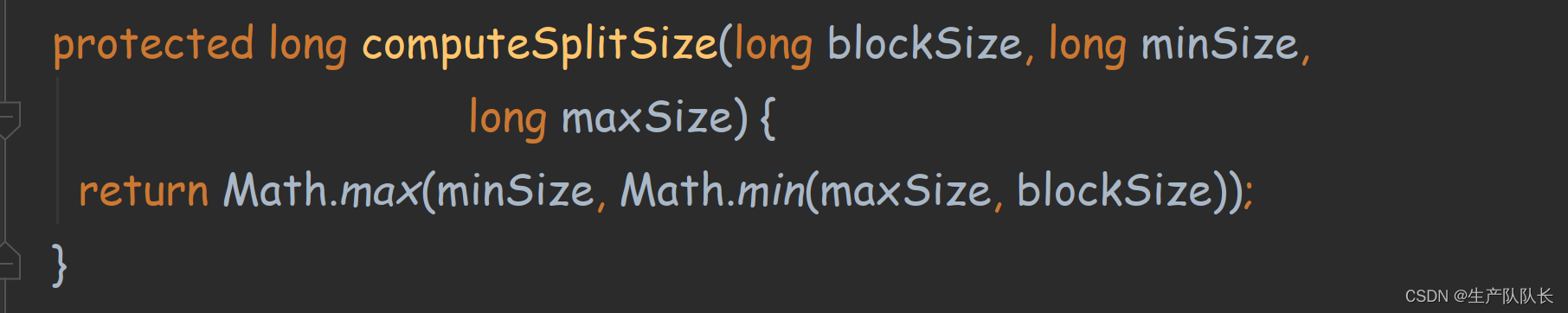

根据切片大小配置,及块大小配置,计算出切片大小

此处可以看出,如果块大小配置在切片大小之间的值,则切片大小取块大小。

这里可以看出,切片是对每一个文件单独计算的,不是把所有文件累加到一起的大小进行计算切片数量。

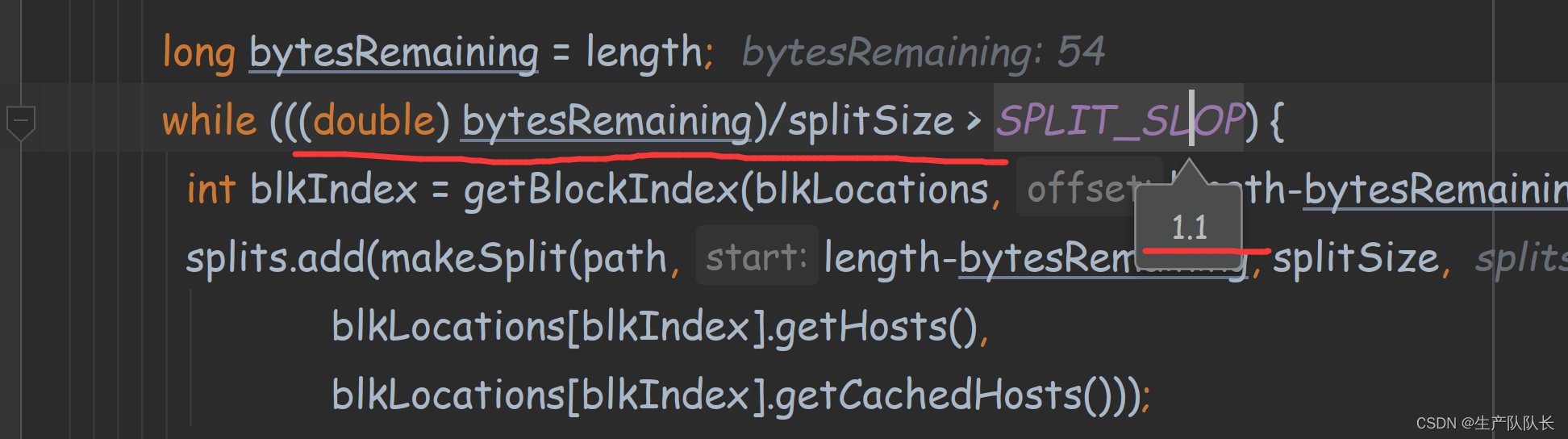

切片的又一个代码限制。

如果,文件大小小于切片大小的1.1倍,则不增加切片。

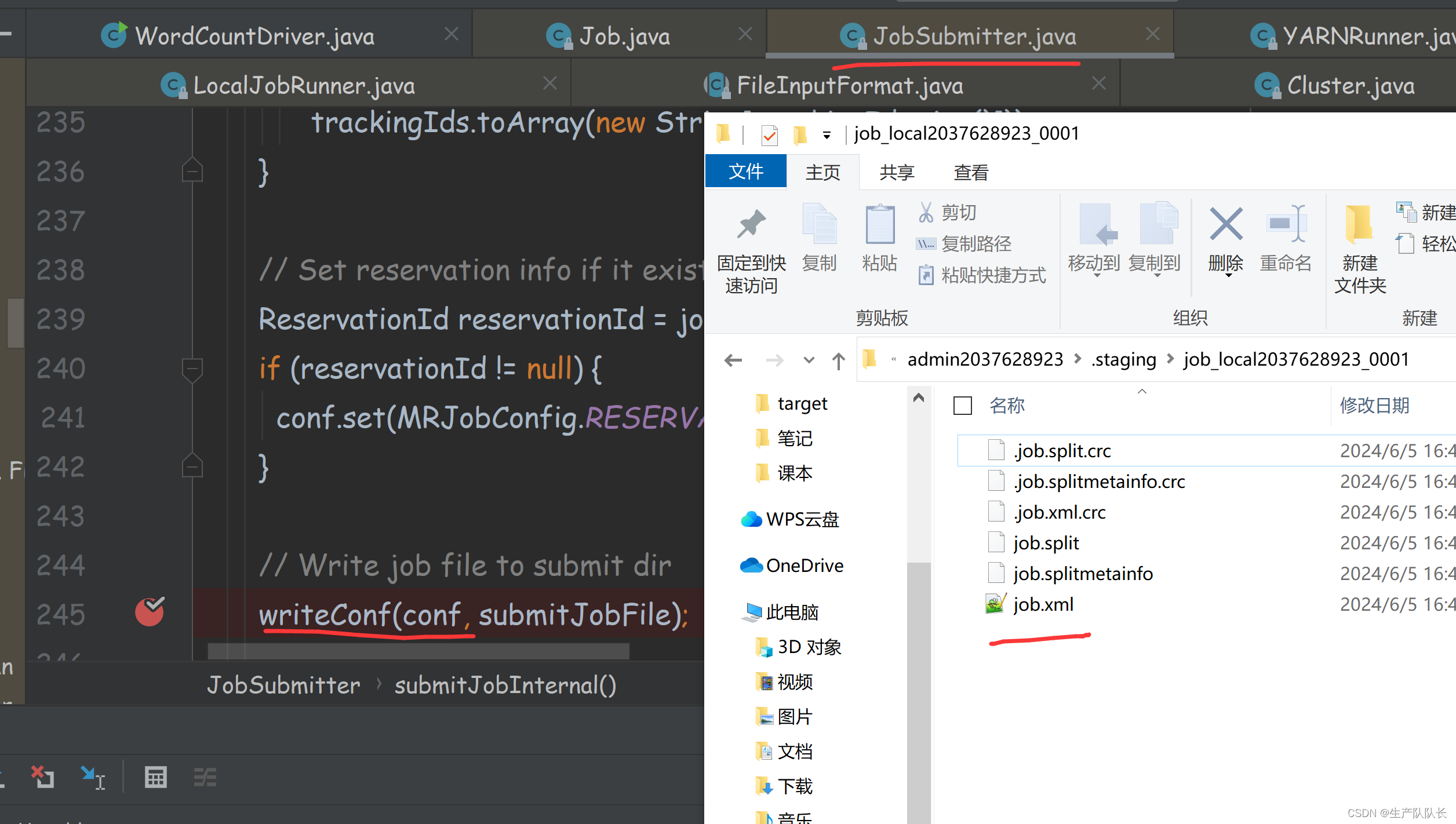

生成临时切片文件

创建配置信息文件到临时文件夹中

总结

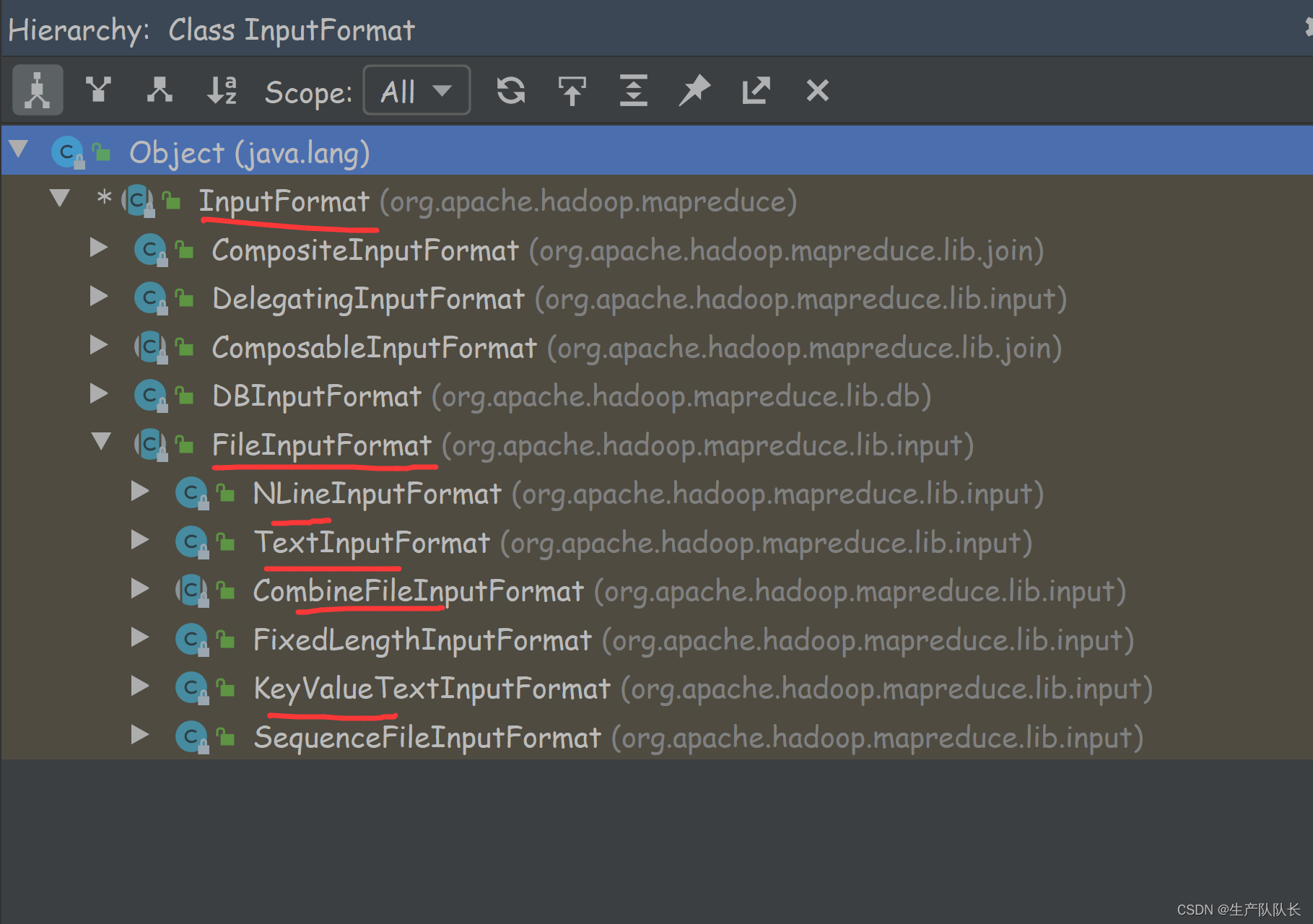

FileInputFormat类的继承关系

主要关注该类里面的getSplits方法

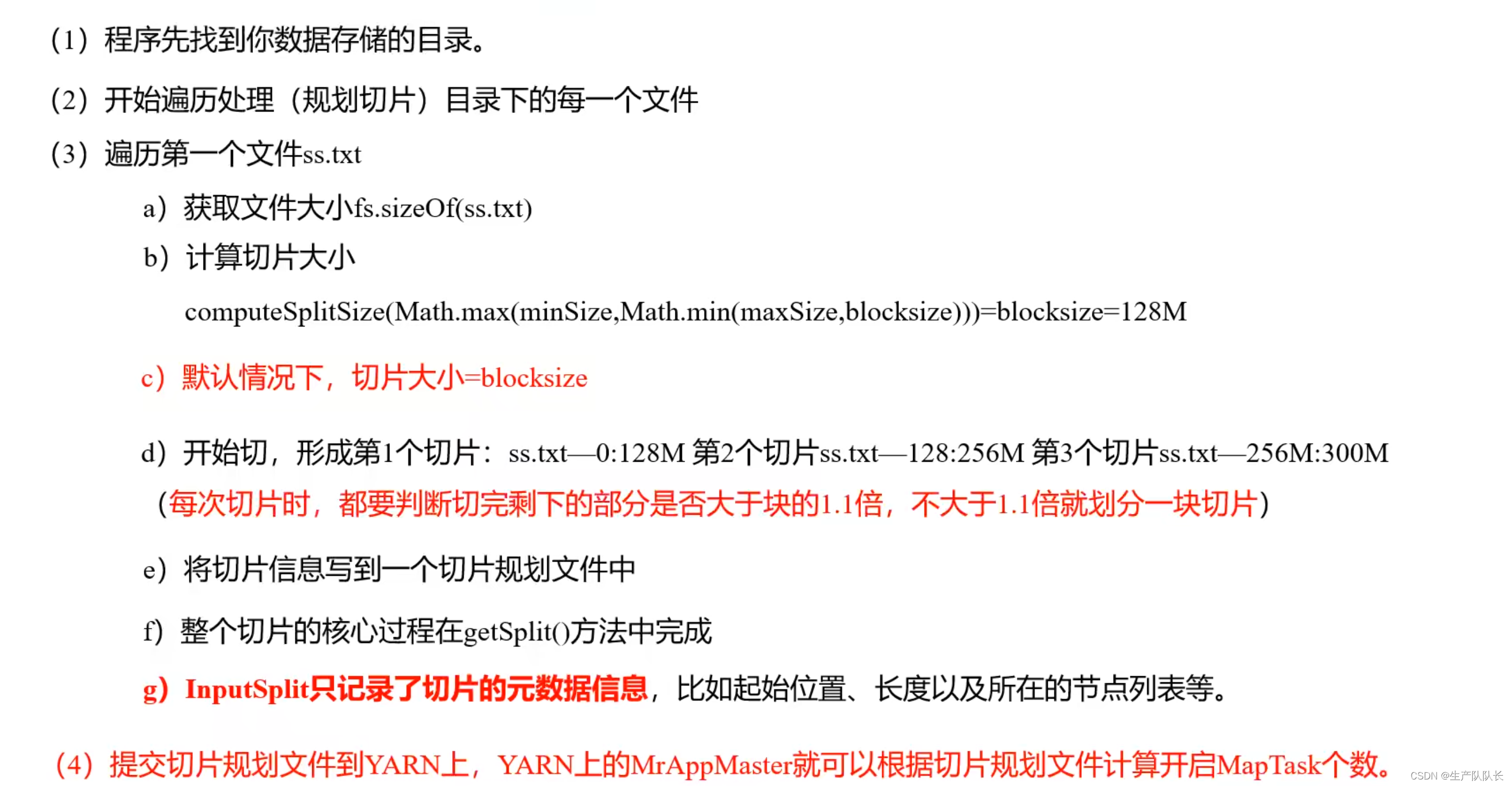

整体流程梳理