文章目录

-

- 1.Ceph集群使用RBD块存储与K8S集成简介

- [2.Ceph集群RBD块存储与K8S PV存储卷集成](#2.Ceph集群RBD块存储与K8S PV存储卷集成)

-

- 2.1.创建K8S集群PV使用的块存储

- 2.2.创建K8S集群访问RBD块存储设备的认证用户

- [2.3.将认证用户的Key存储在K8S Secret资源中](#2.3.将认证用户的Key存储在K8S Secret资源中)

- 2.4.在K8S集群的所有节点中安装Ceph命令

- 2.5.创建PV及PVC资源使用RBD作为底层存储

- 2.6.创建Pod资源挂载PV存储卷并写入数据

1.Ceph集群使用RBD块存储与K8S集成简介

RBD(Reliable Block Device)组件是一种构建在RADOS集群之上为客户端提供块设备存储接口接口的中间层,提供的块存储服务可以形成一个裸磁盘,提供格式化、映射的功能,挂载到服务器中。

这类的客户端包括虚拟化KVM和云计算OpenStack。

RBD组件支持存储空间的动态扩容,也可以借助RADOS实现快照、副本和一致性。

客户端访问RBD的方式:

- 通过内核模块rbd.ko将块存储映射成本地的一块磁盘,例如/dev/vdbx等等,可以进行格式化和分区。

- 通过librbd接口,KVM虚拟化就是使用这种接口。

在K8S集群中为Pod资源提供数据持久化,大致分为三种解决方案:

- Volume

- Volume持久化有三种类型分别是EmptyDir、HostPath、NFS。

- Volume是K8S集群中较为简单的数据持久化方案,无需创建其他资源,直接在Pod资源编排文件中声明Volume卷,即可挂载使用。

- PV、PVC

- PV和PVC是一种高级类型的持久化存储费方案,PV负责与底层存储系统进行对接,PVC从PV中分配一定的资源,最后由PVC挂载到Pod中。

- StorageClass

- 更加高级的一种持久化存储方案,由StorageClass提供一个数据持久化资源池,当Pod需要持久化数据时,直接从StorageClass中自动创建出PV和PVC,最后挂载到Pod资源中。

无论使用哪种持久化方案,最常用的方式是通过NFS或者NAS来实现,今天通过Ceph分布式集群中的RBD块存储来实现Pod数据的持久化。

使用RBD块存储作为Pod资源数据持久化时,只有集群中某一个Node节点可以挂载一块RBD块存储设备,例如当Node1节点挂载了RBD块设备后,Node1节点中的所有Pod都可以共享这块RBD中的数据,但是其余Node节点都无法挂载这块RBD存储了。

RBD块存储设备无法跨节点使用,只有挂载RBD块存储的Node节点中的Pod资源可以使用,其余节点的Pod资源无法使用。

Ceph集群默认开启了CEPHX的认证,任何存储类型想要是有Ceph作为底层存储,都需要通过用户认证才可以正常使用。

2.Ceph集群RBD块存储与K8S PV存储卷集成

PV、PVC高级存储在K8S集群中的应用极多,与Volume集成方案类似。

大致实现步骤:

1)首先在Ceph集群中创建一个Pool资源池,专门为K8S集群创建块存储设备。

2)然后创建一个集群认证用户,用于使K8S连接到Ceph集群的块存储设备。

3)将认证用户的Key以Secret资源控制器的形式创建在集群中。

4)所有的K8S集群都需要去安装Ceph的命令。

5)在集群中创建一个PV存储,在PV的资源编排文件中配置Ceph集群块存储设备的信息。

6)创建PVC存储卷,与PV进行关联。

7)最后编写Pod资源编排文件,使用PVC作为存储卷,将块设备挂载到Pod中,实现数据持久化。

2.1.创建K8S集群PV使用的块存储

sh

1.创建一个Pool资源池

[root@ceph-node-1 ~]# ceph osd pool create kubernetes_data 16 16

pool 'kubernetes_data' created

2.在资源池中创建块存储设备

[root@ceph-node-1 ~]# rbd create --image-feature layering kubernetes_data/rbd_pv_data.img --size 10G

3.查看创建的块存储设备

[root@ceph-node-1 ~]# rbd -p kubernetes_data ls

rbd_pv_data.img

rbd_volume_data.img2.2.创建K8S集群访问RBD块存储设备的认证用户

K8S想要访问Ceph中的RBD块设备,必须通过一个认证用户才可以访问,如果没有认证用户则无法访问Ceph集群中的块设备。

命令格式:ceph auth get-or-create {用户名称} mon '{访问mon的方式}' osd '{访问osd的方式}'

sh

[root@ceph-node-1 ~]# ceph auth get-or-create client.kubernetes mon 'profile rbd' osd 'profile rbd pool=kubernetes_data'

[client.kubernetes]

key = AQBlRVRibbqzJRAAD3lacYaxRloTVTio6e+10A==命令解释:创建了一个client.kubernetes名称的Ceph认证用户,访问mon的方式是以RBD块存储形式访问,访问OSD的方式也是以块存储RBD方式访问Pool资源池。

查看创建的认证用户。

sh

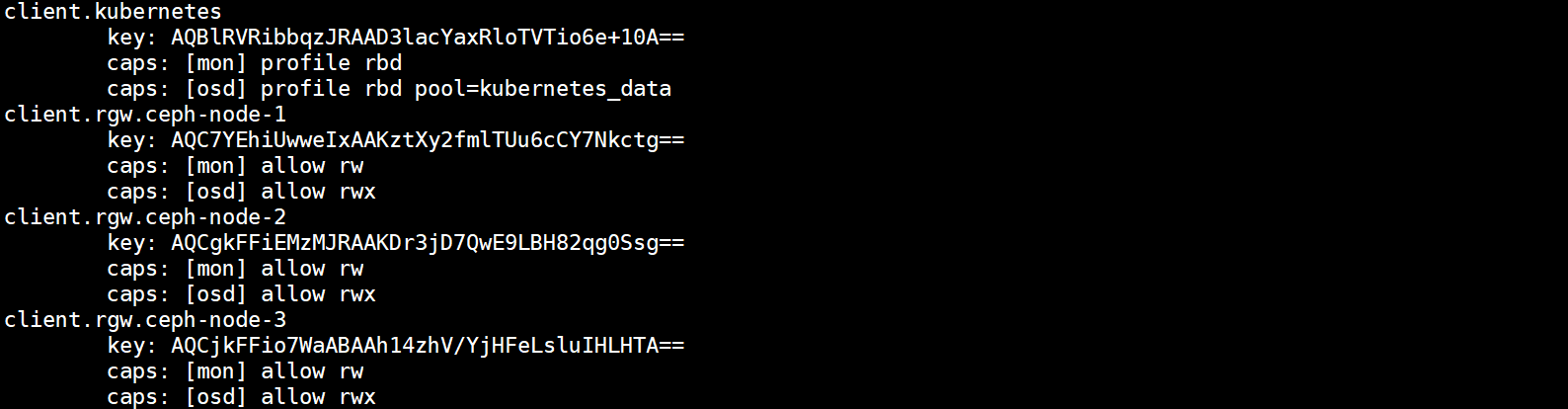

[root@ceph-node-1 ~]# ceph auth list 可以看到Ceph的认证用户都是以client开头,每一个用户都有对mon和osd的访问方式。

2.3.将认证用户的Key存储在K8S Secret资源中

将认证用户的key通过Base64进行加密,存储在K8S的Secret资源中。

1)将key通过Base64进行加密

sh

[root@ceph-node-1 ~]# echo AQBlRVRibbqzJRAAD3lacYaxRloTVTio6e+10A== | base64

QVFCbFJWUmliYnF6SlJBQUQzbGFjWWF4UmxvVFZUaW82ZSsxMEE9PQo=2)将加密后的Key存储在Secret资源中

yaml

[root@k8s-master pv]# vim rbd-volume-secret.yaml

apiVersion: v1

kind: Secret

metadata:

name: rbd-volume-secret

type: "kubernetes.io/rbd"

data:

key: QVFCbFJWUmliYnF6SlJBQUQzbGFjWWF4UmxvVFZUaW82ZSsxMEE9PQo=3)创建Secret资源

RBD的Secret要与Pod在同一Namespace下,如果不同的Namespace的Pod都需要使用RBD进行存储,则需要在每个Namespace下都进行创建。

sh

[root@k8s-master pv]# kubectl apply -f rbd-volume-secret.yaml

secret/rbd-volume-secret created

[root@k8s-master pv]# kubectl get secret

NAME TYPE DATA AGE

rbd-volume-secret kubernetes.io/rbd 1 16s

default-token-fbknq kubernetes.io/service-account-token 3 60d2.4.在K8S集群的所有节点中安装Ceph命令

不安装ceph命令将无法成功挂载块设备。

sh

[root@k8s-master ~]# yum -y install ceph-common

[root@k8s-node1 ~]# yum -y install ceph-common

[root@k8s-node2 ~]# yum -y install ceph-common2.5.创建PV及PVC资源使用RBD作为底层存储

在K8S集群中创建PV及PVC存储资源,主要是对PV进行了一些配置,存储底层采用Ceph集群的RBD块存储设备,PVC资源配置不需要任何变动。

1)编写资源编排文件

yaml

[root@k8s-master pv]# vim rbd-pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: rbd-pv

spec:

capacity:

storage: 10Gi

accessModes:

- ReadWriteMany

rbd: #指定使用rbd块存储类型

monitors: #指定monitor地址

- 192.168.20.20:6789

- 192.168.20.21:6789

- 192.168.20.22:6789

pool: kubernetes_data #指定使用的资源池名称

image: rbd_pv_data.img #指定使用的块存储名称

user: kubernetes #连接块存储设备的用户

secretRef: #存储用户key的secret资源

name: rbd-volume-secret

fsType: ext4 #文件系统类型

persistentVolumeReclaimPolicy: Recycle

storageClassName: rbd #存储类型填写rbd

[root@k8s-master pv]# vim rbd-pvc.yaml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: rbd-pvc

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: 10Gi

storageClassName: rbd2)在集群中创建PV和PVC资源

sh

1.创建资源

[root@k8s-master pv]# kubectl apply -f rbd-pv.yaml

persistentvolume/rbd-pv created

[root@k8s-master pv]# kubectl apply -f rbd-pvc.yaml

persistentvolumeclaim/rbd-pvc created

2.查看资源的状态

[root@k8s-master pv]# kubectl get pv,pvc

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

persistentvolume/rbd-pv 10Gi RWX Recycle Bound default/rbd-pvc rbd 24s

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

persistentvolumeclaim/rbd-pvc Bound rbd-pv 10Gi RWX rbd 24s2.6.创建Pod资源挂载PV存储卷并写入数据

1)编写Pod的资源编排文件

虽然PV底层使用的RBD作为存储,但是Pod使用PVC的方式无任何变化。

yaml

[root@k8s-master pv]# vim rbd-pv-pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: rbd-pv-pod

spec:

containers:

- image: nginx:1.15

name: rbd-pv-pod

ports:

- name: web

containerPort: 80

protocol: TCP

volumeMounts:

- name: rbd-pvc

mountPath: /data

volumes:

- name: rbd-pvc

persistentVolumeClaim:

claimName: rbd-pvc 2)在集群中创建Pod资源

sh

[root@k8s-master pv]# kubectl apply -f rbd-pv-pod.yaml

pod/rbd-pv-pod created

[root@k8s-master pv]# kubectl get pod

NAME READY STATUS RESTARTS AGE

rbd-pv-pod 1/1 Running 0 3m16s3)进入Pod中写入数据

sh

[root@k8s-master pv]# kubectl exec -it rbd-pv-pod bash

root@rbd-pv-pod:/# df -hT /data

Filesystem Type Size Used Avail Use% Mounted on

/dev/rbd0 ext4 9.8G 37M 9.7G 1% /data

root@rbd-pv-pod:/# touch /data/file{1..9}.txt

root@rbd-pv-pod:/# ls /data/

file1.txt file2.txt file3.txt file4.txt file5.txt file6.txt file7.txt file8.txt file9.txt lost+found任何类型的存储卷使用RBD的方式都一样,都会在Pod所在宿主机中挂载RBD块设备映射的磁盘,然后挂载到具体的Pod中,无法跨主机使用。