使用3080ti运行blip2的案例

- 本机环境(==大家主要看GPU,ubuntu版本和cuda版本即可==):

- 安装流程

- [我最后安装的所有包的信息(python 3.9 )以供参考(environment.yml):](#我最后安装的所有包的信息(python 3.9 )以供参考(environment.yml):)

本机环境(大家主要看GPU,ubuntu版本和cuda版本即可):

(注意!我在运行blip2的demo的时候显存用了80G以上,所以虽然这张卡能配好,但为了显存需要多卡运行!)

配置参考blip2的官方github网址。

py

PyTorch : 2.1.0

ubuntu : 22.04

Python : 3.10

Cuda : 12.1

RTX : 3080 Ti(12GB)

CPU : 12 vCPU Intel(R) Xeon(R) Silver 4214R CPU @ 2.40GHz

内存 : 90GB安装流程

在该环境中运行如下代码开始安装:

我发现当我使用python3.8(cuda11.3,cuda11.1)的时候运行不起来,所以这里换成了cuda12.1和python3.9 。

py

conda create -n blip2 python=3.9

conda init bash && source /root/.bashrc

conda activate blip2之后开始安装lavis:

py

pip install salesforce-lavis之后我发现,环境还缺少了相关的opencv-python包,所以又运行:

py

pip install opencv-python好像网上也有帖子说要本地安装salesforce-lavis,但是我不用本地安装就能运行了,大家也可以参考一下他们的安装方法。

接下来就可以运行如下的代码进行测试实验了

py

import torch

from PIL import Image

import requests

from lavis.models import load_model_and_preprocess

# setup device to use

device = torch.device("cuda") if torch.cuda.is_available() else "cpu"

# load sample image

img_url = 'https://storage.googleapis.com/sfr-vision-language-research/LAVIS/assets/merlion.png'

raw_image = Image.open(requests.get(img_url, stream=True).raw).convert('RGB')

raw_image.show() #使用PIL来展示图片,原来的display函数应该是colab里的

#display(raw_image.resize((596, 437)))

model, vis_processors, _ = load_model_and_preprocess(

name="blip2_t5", model_type="pretrain_flant5xxl", is_eval=True, device=device

)

#也可以用其他的模型

# Other available models:

#

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_opt", model_type="pretrain_opt2.7b", is_eval=True, device=device

# )

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_opt", model_type="pretrain_opt6.7b", is_eval=True, device=device

# )

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_opt", model_type="caption_coco_opt2.7b", is_eval=True, device=device

# )

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_opt", model_type="caption_coco_opt6.7b", is_eval=True, device=device

# )

#

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_t5", model_type="pretrain_flant5xl", is_eval=True, device=device

# )

#

# model, vis_processors, _ = load_model_and_preprocess(

# name="blip2_t5", model_type="caption_coco_flant5xl", is_eval=True, device=device

# )

vis_processors.keys()但是运行这个代码,会自动下载blip2t5文件,然后我们直接连接huggingface网站又有一些问题,下载速度非常慢,下载不下来。

因为下载太慢了,我们可以在Salesforce/blip2-flan-t5-xxl · Hugging Face Hugging Face上找到相关的文件并下载。

下载方法:本地下载huggingface模型并在服务器上使用流程

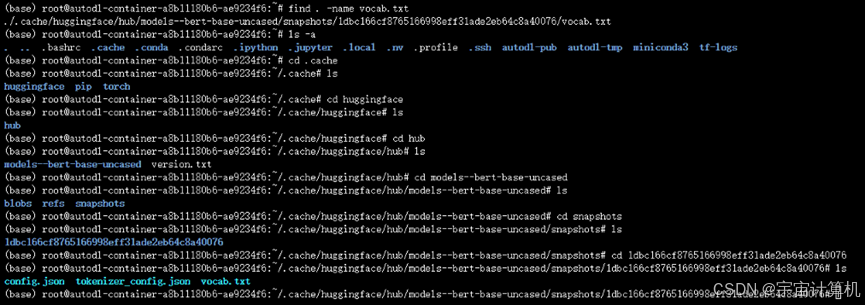

如果不做任何改动,本来默认的下载位置如下(可以从huggingface上手动下载我们需要的模型,之后上传到这个地址下):

但是有时候这个默认路径是在系统盘里,上传到这个系统盘里,系统盘内存容量会不够。所以我们继续探索,找一下如何放到别的盘里。

添加一句export HF_HOME="/root/autodl-tmp/huggingface"

再 source ~/.bashrc 使配置生效。

(因为觉得有点麻烦,我直接把环境变量在下面的代码里改了)

我在目录autodl-tmp下创建两个目录:

/huggingface文件夹

/torch-model文件夹

py

import torch

from PIL import Image

import requests

from lavis.models import load_model_and_preprocess

# setup device to use

device = torch.device("cuda") if torch.cuda.is_available() else "cpu"

# load sample image

img_url = 'https://storage.googleapis.com/sfr-vision-language-research/LAVIS/assets/merlion.png'

raw_image = Image.open(requests.get(img_url, stream=True).raw).convert('RGB')

raw_image.show() #使用PIL来展示图片,原来的display函数应该是colab里的

#display(raw_image.resize((596, 437)))

import os

os.environ['TORCH_HOME']=r"/root/autodl-tmp/torch-model" #更改pytorch断点的默认保存目录

os.environ['TRANSFORMERS_CACHE'] = r'/root/autodl-tmp/huggingface' #更改huggingface 的默认保存目录

model, vis_processors, _ = load_model_and_preprocess(

name="blip2_t5", model_type="pretrain_flant5xxl", is_eval=True, device=device

)

vis_processors.keys()

# 引入环境变量之后,成功解决这个问题。我最后安装的所有包的信息(python 3.9 )以供参考(environment.yml):

我的environment.yml文件内容:

py

# This file may be used to create an environment using:

# $ conda create --name <env> --file <this file>

# platform: linux-64

_libgcc_mutex=0.1=main

_openmp_mutex=5.1=1_gnu

altair=5.4.1=pypi_0

annotated-types=0.7.0=pypi_0

antlr4-python3-runtime=4.9.3=pypi_0

asttokens=2.4.1=pypi_0

attrs=24.2.0=pypi_0

bleach=6.1.0=pypi_0

blinker=1.8.2=pypi_0

blis=1.0.1=pypi_0

braceexpand=0.1.7=pypi_0

ca-certificates=2024.9.24=h06a4308_0

cachetools=5.5.0=pypi_0

catalogue=2.0.10=pypi_0

certifi=2024.8.30=pypi_0

cfgv=3.4.0=pypi_0

charset-normalizer=3.4.0=pypi_0

click=8.1.7=pypi_0

cloudpathlib=0.19.0=pypi_0

confection=0.1.5=pypi_0

contexttimer=0.3.3=pypi_0

contourpy=1.3.0=pypi_0

cycler=0.12.1=pypi_0

cymem=2.0.8=pypi_0

decorator=5.1.1=pypi_0

decord=0.6.0=pypi_0

distlib=0.3.9=pypi_0

einops=0.8.0=pypi_0

exceptiongroup=1.2.2=pypi_0

executing=2.1.0=pypi_0

fairscale=0.4.4=pypi_0

filelock=3.16.1=pypi_0

fonttools=4.54.1=pypi_0

fsspec=2024.9.0=pypi_0

ftfy=6.3.0=pypi_0

gitdb=4.0.11=pypi_0

gitpython=3.1.43=pypi_0

huggingface-hub=0.25.2=pypi_0

identify=2.6.1=pypi_0

idna=3.10=pypi_0

imageio=2.35.1=pypi_0

importlib-resources=6.4.5=pypi_0

iopath=0.1.10=pypi_0

ipython=8.18.1=pypi_0

jedi=0.19.1=pypi_0

jinja2=3.1.4=pypi_0

jsonschema=4.23.0=pypi_0

jsonschema-specifications=2024.10.1=pypi_0

kaggle=1.6.17=pypi_0

kiwisolver=1.4.7=pypi_0

langcodes=3.4.1=pypi_0

language-data=1.2.0=pypi_0

lazy-loader=0.4=pypi_0

ld_impl_linux-64=2.40=h12ee557_0

libffi=3.4.4=h6a678d5_1

libgcc-ng=11.2.0=h1234567_1

libgomp=11.2.0=h1234567_1

libstdcxx-ng=11.2.0=h1234567_1

marisa-trie=1.2.0=pypi_0

markdown-it-py=3.0.0=pypi_0

markupsafe=3.0.1=pypi_0

matplotlib=3.9.2=pypi_0

matplotlib-inline=0.1.7=pypi_0

mdurl=0.1.2=pypi_0

mpmath=1.3.0=pypi_0

murmurhash=1.0.10=pypi_0

narwhals=1.9.2=pypi_0

ncurses=6.4=h6a678d5_0

networkx=3.2.1=pypi_0

nodeenv=1.9.1=pypi_0

numpy=2.0.2=pypi_0

nvidia-cublas-cu12=12.1.3.1=pypi_0

nvidia-cuda-cupti-cu12=12.1.105=pypi_0

nvidia-cuda-nvrtc-cu12=12.1.105=pypi_0

nvidia-cuda-runtime-cu12=12.1.105=pypi_0

nvidia-cudnn-cu12=9.1.0.70=pypi_0

nvidia-cufft-cu12=11.0.2.54=pypi_0

nvidia-curand-cu12=10.3.2.106=pypi_0

nvidia-cusolver-cu12=11.4.5.107=pypi_0

nvidia-cusparse-cu12=12.1.0.106=pypi_0

nvidia-nccl-cu12=2.20.5=pypi_0

nvidia-nvjitlink-cu12=12.6.77=pypi_0

nvidia-nvtx-cu12=12.1.105=pypi_0

omegaconf=2.3.0=pypi_0

opencv-python=4.10.0.84=pypi_0

opencv-python-headless=4.5.5.64=pypi_0

opendatasets=0.1.22=pypi_0

openssl=3.0.15=h5eee18b_0

packaging=24.1=pypi_0

pandas=2.2.3=pypi_0

parso=0.8.4=pypi_0

pexpect=4.9.0=pypi_0

pillow=10.4.0=pypi_0

pip=24.2=py39h06a4308_0

platformdirs=4.3.6=pypi_0

plotly=5.24.1=pypi_0

portalocker=2.10.1=pypi_0

pre-commit=4.0.1=pypi_0

preshed=3.0.9=pypi_0

prompt-toolkit=3.0.48=pypi_0

protobuf=5.28.2=pypi_0

ptyprocess=0.7.0=pypi_0

pure-eval=0.2.3=pypi_0

pyarrow=17.0.0=pypi_0

pycocoevalcap=1.2=pypi_0

pycocotools=2.0.8=pypi_0

pydantic=2.9.2=pypi_0

pydantic-core=2.23.4=pypi_0

pydeck=0.9.1=pypi_0

pygments=2.18.0=pypi_0

pyparsing=3.1.4=pypi_0

python=3.9.20=he870216_1

python-dateutil=2.9.0.post0=pypi_0

python-magic=0.4.27=pypi_0

python-slugify=8.0.4=pypi_0

pytz=2024.2=pypi_0

pyyaml=6.0.2=pypi_0

readline=8.2=h5eee18b_0

referencing=0.35.1=pypi_0

regex=2024.9.11=pypi_0

requests=2.32.3=pypi_0

rich=13.9.2=pypi_0

rpds-py=0.20.0=pypi_0

salesforce-lavis=1.0.2=pypi_0

scikit-image=0.24.0=pypi_0

scipy=1.13.1=pypi_0

sentencepiece=0.2.0=pypi_0

setuptools=75.1.0=py39h06a4308_0

shellingham=1.5.4=pypi_0

six=1.16.0=pypi_0

smart-open=7.0.5=pypi_0

smmap=5.0.1=pypi_0

spacy=3.8.2=pypi_0

spacy-legacy=3.0.12=pypi_0

spacy-loggers=1.0.5=pypi_0

sqlite=3.45.3=h5eee18b_0

srsly=2.4.8=pypi_0

stack-data=0.6.3=pypi_0

streamlit=1.39.0=pypi_0

sympy=1.13.3=pypi_0

tenacity=9.0.0=pypi_0

text-unidecode=1.3=pypi_0

thinc=8.3.2=pypi_0

tifffile=2024.8.30=pypi_0

timm=0.4.12=pypi_0

tk=8.6.14=h39e8969_0

tokenizers=0.13.3=pypi_0

toml=0.10.2=pypi_0

torch=2.4.1=pypi_0

torchvision=0.19.1=pypi_0

tornado=6.4.1=pypi_0

tqdm=4.66.5=pypi_0

traitlets=5.14.3=pypi_0

transformers=4.26.1=pypi_0

triton=3.0.0=pypi_0

typer=0.12.5=pypi_0

typing-extensions=4.12.2=pypi_0

tzdata=2024.2=pypi_0

urllib3=2.2.3=pypi_0

virtualenv=20.26.6=pypi_0

wasabi=1.1.3=pypi_0

watchdog=5.0.3=pypi_0

wcwidth=0.2.13=pypi_0

weasel=0.4.1=pypi_0

webdataset=0.2.100=pypi_0

webencodings=0.5.1=pypi_0

wheel=0.44.0=py39h06a4308_0

wrapt=1.16.0=pypi_0

xz=5.4.6=h5eee18b_1

zipp=3.20.2=pypi_0

zlib=1.2.13=h5eee18b_1