一、测算方式 :参考C刊《统计研究》唐建荣(2021)老师的做法,采用区位熵来衡量产业集聚水平,区位熵可以消除区域规模的差异因素,能真实反应地理要素的空间分布

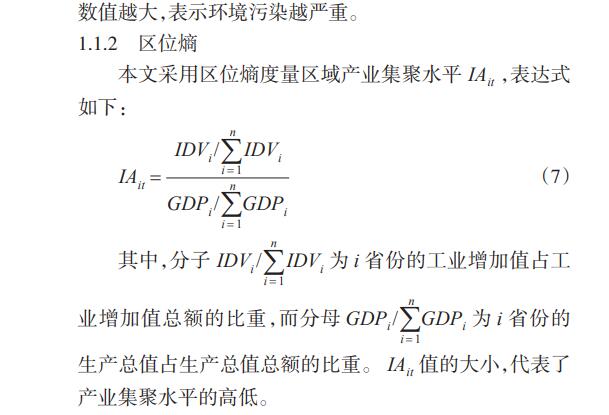

计算公式如下

产业集聚水平=(各省份工业增加值/工业增加值总额)/(各省份生产总值/生产总值总额)

二、资料范围:省级数据,包括原始数据和最终结果,数据来源于《中国统计年鉴》和国家统计局

三、参考文献:唐建荣,郭士康.产业集聚、人口规模与环境污染[J].统计与决策,2021,37(24):46-51

四、包含指标:

|----|----|----|----|-----------|-------------|------------|------------|--------|

| id | 省份 | 年份 | 代码 | 工业增加值(亿元) | 工业增加值总额(亿元) | 地区生产总值(亿元) | 生产总值总额(亿元) | 产业集聚水平 |

五、样例数据:

六、下载链接:

参考文献:https://download.csdn.net/download/samLi0620/90025560

整理好的数据集-xlsx格式:https://download.csdn.net/download/samLi0620/90025561