该文档记录从双目相机标定到点云生成的所有过程,同时会附上代码。

代码直接能跑。https://github.com/stu-yzZ/stereoCamera

目录

六、通过视差图和Q矩阵计算每个二维坐标对应的三维坐标,同时获取颜色。

大致思路如下:

首先标定双目相机,获取每个相机的内参,同时对相机进行标定,获取相机的相对位置参数,也就是外参。

然后通过相机拍图片并对图片进行矫正(畸变矫正和立体矫正)然后通过立体匹配算法计算视差图,通过视差图计算深度图,有了视差图很多问题都可以解决了,通过视差图可以获得点云信息。

点云数据太大了 我电脑跑不动,但大致可以看到将图片像右旋转45°即和图片视角一致。

一、相机标定

相机标定获取相机参数,用来矫正图。并且要使用相机参数对拍摄的图片进行矫正。相机标定非常重要,所有的计算都是基于相机参数进行的,如果误差较大,后面所有步骤都会受到影响。我自己从淘宝上买了个200左右的双目相机,标定之后结果一直很差,非常影响后续的视差图和深度图的计算。

但是标定的过程一定要自己动手做,只有亲自动手,才能知道一些细节。由于硬件限制(姑且认为是吧),我转换思路,用别人标定好的参数和图片进行视差图和深度图的实现。使用https://vision.middlebury.edu/stereo/data/,这个数据集MiddleburyStereoDatasets进行后续步骤。

1、相机参数介绍

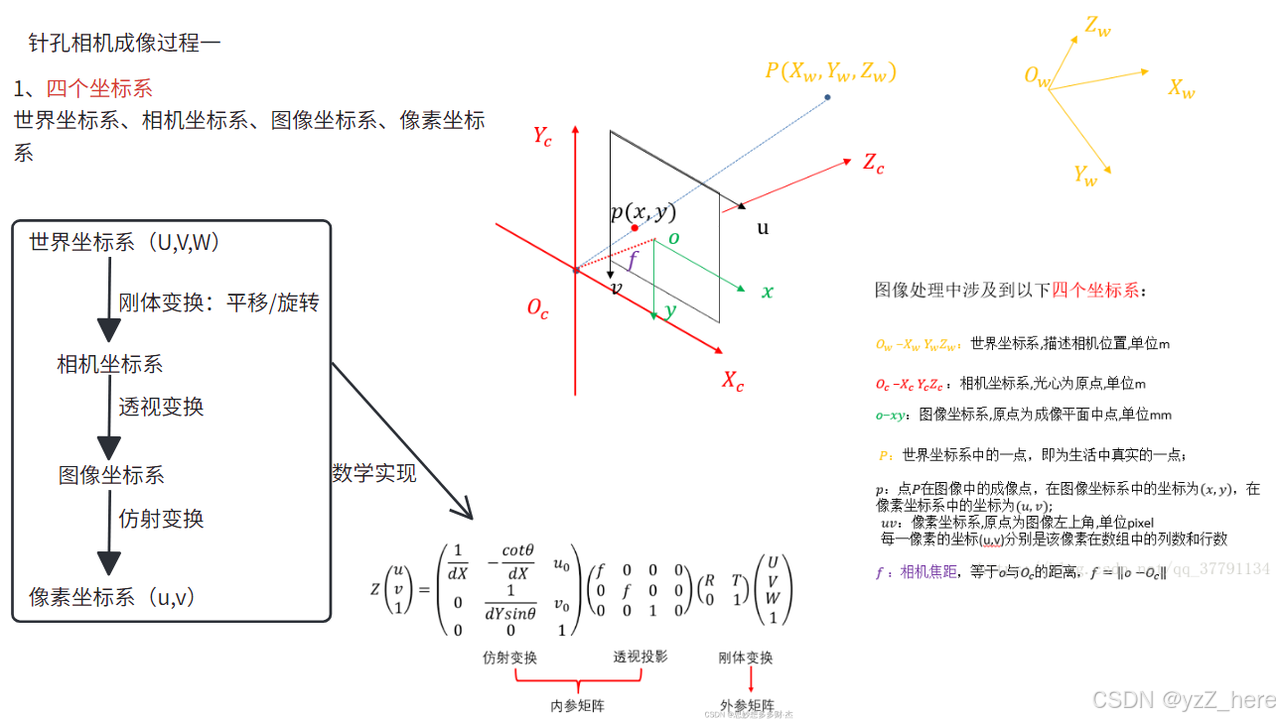

拿单目相机举例,四个坐标系之间需要变换,主要是参数有相机内参和外参。

四个坐标系:世界坐标系->相机坐标系->图像坐标系->像素坐标系

内参:共有11个参数变量。其中,相机的内部参数有5个:焦距,像主点坐标,畸变参数;相机的外部参数有6个:旋转,平移。

2、单目相机标定

需要准备一个标定板,一台相机,尽可能多的拍一下照片,张正友标定法。但是标定出高精度的结果太难了,我还是暂时跳过了这个精度的要求,暂时先把整条思路打通。

3、双目相机标定

双目相机标定除了求解每个摄像头的内参外,还需要求解两个摄像头之间的 相对位置 和 姿态 ,即 外参(旋转矩阵和平移向量)。其中平移矩阵的(以我选择的artroom1的参数为例)是这样的self.T = np.array([[-536.62], [0.0], [0.0]]),其中第一个元素是对应的你自己相机的基线长度,也就是两个相机镜头的距离,单位是mm。如果是自己标定的话也可以通过这个参数判断自己标定误差大小。

二、图片畸变矫正

使用畸变参数对图片进行矫正

cv.undistort该函数可以实现畸变矫正功能。双目相机的话需要对左右两张图像都进行矫正操作。

cpp

void undistort( InputArray src, //输入原图

OutputArray dst,//输出矫正后的图像

InputArray cameraMatrix,//内参矩阵

InputArray distCoeffs,//畸变系数

InputArray newCameraMatrix=noArray() );三、极线矫正

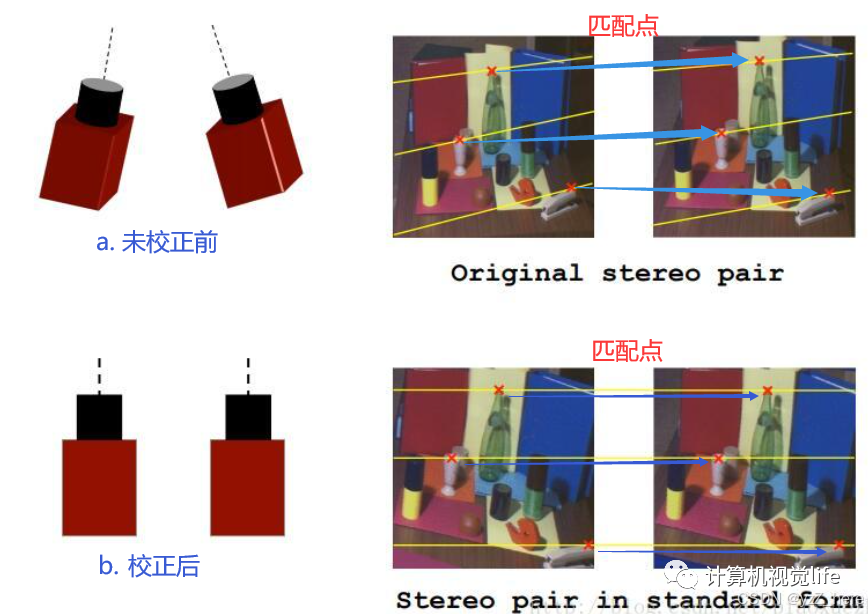

非常重要的一步,将立体匹配从二维降到一维。(对极约束,是将搜索空间约束到像平面内的一条直线上)

1、极线矫正

这篇文章从原理讲的很细,会让人有生畏的感觉https://zhuanlan.zhihu.com/p/466758105。你也可以跳过没懂的地方,首先你要知道匹配的意思就是要从针对左视图中的某一个像素,在右试图中找到对应的匹配像素,如果不做立体矫正的话,需要从右视图的整个图片中搜索,如果做了立体匹配,可以将匹配过程从整张图片(二维空间)降低到一维空间,极线矫正之后空间中点在左右视图中的投影在同一条直线上。

下面代码展示了从读取图片到极线矫正,并检测矫正情况的过程。

python

# 读取图像

imgl = cv.imread('1_L.jpg')

imgr = cv.imread('1_R.jpg')

high, wide = imgl.shape[0:2]

# 读取相机参数

config = stereoCamera()

# 消除图像畸变

imgl_qb = cv.undistort(imgl, config.cam_matrix_l, config.distortion_l)

imgr_qb = cv.undistort(imgr, config.cam_matrix_r, config.distortion_r)

# 极线校正

map1x, map1y, map2x, map2y, Q = getRectifyTransform(high, wide, config)

imgl_jx, imgr_jx = rectifyImage(imgl_qb, imgr_qb, map1x, map1y, map2x, map2y)

# print("Print Q!")

# print(Q)

# 绘制等间距平行线,检查效果

line = draw_line(imgl_jx, imgr_jx)

其中draw_line函数为:

def draw_line(img1, img2):

height = max(img1.shape[0], img2.shape[0])

width = img1.shape[1] + img2.shape[1]

output = np.zeros((height, width, 3), dtype=np.uint8)

output[0:img1.shape[0], 0:img1.shape[1]] = img1

output[0:img2.shape[0], img1.shape[1]:] = img2

line_interval = 50 # 直线间隔

for k in range(height // line_interval):

cv.line(output, (0, line_interval * (k + 1)),

(2 * width, line_interval * (k + 1)),

(0, 255, 0), thickness=2, lineType=cv.LINE_AA)

# plt.imshow(output, 'gray')

# plt.show()

return output2、投影矩阵Q

Q矩阵在后面生成3D点云的时候要用到。暂不多解释。

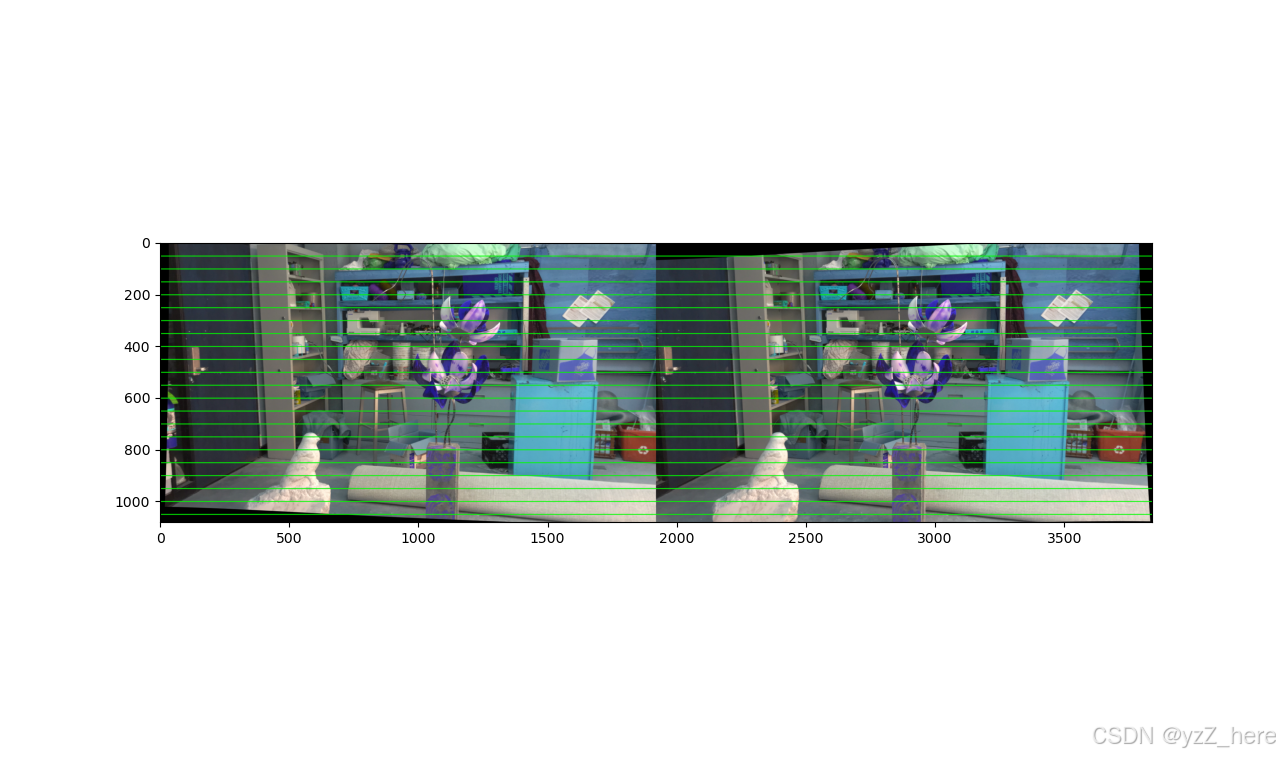

3、图片检查

极线矫正之后的图片进行检查,这个过程很难界定怎么样算是好的,或许肉眼看着在同一个平面但是在像素层面上来看并没有对齐,总的来说这个结果也是和标定结果强相关。我自己标定的结果打印出来感觉没有差很多,但是最后视差图和深度图还是效果很差。下面这是我使用数据集中的参数和图片显示的结果,(数据集中的图片已经是畸变矫正和立体匹配之后的图片,所以他们肯定极线对齐的)

四、SGBM局部匹配算法计算视差图,并填充

通过opencv获取视差图

1、设置立体匹配算法SGBM

SGBM属于局部匹配算法,我调试下来的感觉就是泛化性很低,甚至图片场景变化大的话基本上一张图片对应一套参数,计算量先不谈,我22款拯救者y9000P还能带动,SGBM算法原理我没有太深究,主要的参数调整网上有很多讲解的,可以自己看,比较重要的就是windowssize和最大最小视差,视差值对应图片的深度也就是拍照的距离。窗口大小会影响视差图的平滑与否,可以自己设置调试下。且最大最小视差可以通过拍照的距离计算出来。根据深度计算公式,已知最大最小深度也就是拍照的最近最远距离,可以计算出视差值。我使用的数值来自于数据集中提供的。

同时需要注意视差图的精度问题。

python

def opencv_SGBM(left_img, right_img, use_wls=False):

blockSize = 11

paramL = {"minDisparity": 0, #表示可能的最小视差值。通常为0,但有时校正算法会移动图像,所以参数值也要相应调整

"numDisparities": 170, #表示最大的视差值与最小的视差值之差,这个差值总是大于0。在当前的实现中,这个值必须要能被16整除,越大黑色边缘越多,表示不能计算视差的区域

"blockSize": blockSize,

"P1": 8 * 3 * blockSize * blockSize, #控制视差图平滑度的第一个参数

"P2": 32 * 3 * blockSize * blockSize, #控制视差图平滑度的第二个参数,值越大,视差图越平滑。P1是邻近像素间视差值变化为1时的惩罚值,

#p2是邻近像素间视差值变化大于1时的惩罚值。算法要求P2>P1,stereo_match.cpp样例中给出一些p1和p2的合理取值。

"disp12MaxDiff": 1, #表示在左右视图检查中最大允许的偏差(整数像素单位)。设为非正值将不做检查。

"uniquenessRatio": 10, #表示由代价函数计算得到的最好(最小)结果值比第二好的值小多少(用百分比表示)才被认为是正确的。通常在5-15之间。

"speckleWindowSize": 50, #表示平滑视差区域的最大窗口尺寸,以考虑噪声斑点或无效性。将它设为0就不会进行斑点过滤,否则应取50-200之间的某个值。

"speckleRange": 1, #指每个已连接部分的最大视差变化,如果进行斑点过滤,则该参数取正值,函数会自动乘以16、一般情况下取1或2就足够了。

"preFilterCap": 31,

"mode": cv.STEREO_SGBM_MODE_SGBM_3WAY

}

matcherL = cv.StereoSGBM_create(**paramL)

# 计算视差图

dispL = matcherL.compute(left_img, right_img)

# WLS滤波平滑优化图像

if use_wls:

paramR = paramL

paramR['minDisparity'] = -paramL['numDisparities']

matcherR = cv.StereoSGBM_create(**paramR)

dispR = matcherR.compute(right_img, left_img)

# dispR = np.int16(dispR)

lmbda = 80000

sigma = 1.0

filter = cv.ximgproc.createDisparityWLSFilter(matcher_left=matcherL)

filter.setLambda(lmbda)

filter.setSigmaColor(sigma)

dispL = filter.filter(dispL, left_img, None, dispR)

#双边滤波

dispL = cv2.bilateralFilter(dispL.astype(np.float32), d=9, sigmaColor=75, sigmaSpace=75)

# 除以16得到真实视差(因为SGBM算法得到的视差是×16的)

dispL[dispL < 0] = 1e-6

dispL = dispL.astype(np.int16)

dispL = dispL / 16.0

return dispL2、WLS+视差图空洞填充

wls叫做基于加权最小二乘法的保边缘平滑滤波器。目的是对图像进行平滑处理,代码在上,主要是对视差图进行平滑处理。

这篇文章讲解了基于积分的空洞填充,也包括整个双目视觉的大致流程,也包括一些细节的内容,比如提到了精度相关的知识,我受益匪浅,https://www.cnblogs.com/riddick/p/8486223.html这篇博文是2018年发表的,不得不感慨......

空洞填充可以使得视差图更加的平滑和高质量。但是需要较大算力支持。

五、通过视差图计算深度图并可视化

通过公式计算每个像素(可计算像素)的深度坐标,同时生成深度图并可视化。

1、计算深度图并可视化

直接根据深度计算公式对视差图进行计算,但是要确定深度的单位,z=(f*b)/d,其中f和d的单位是像素,b(baseline)的单位是米,计算出来的z深度单位也是米。

六、通过视差图和Q矩阵计算每个二维坐标对应的三维坐标,同时获取颜色。

1、生成点云信息并保存

看代码即可。没有什么逻辑。

七、点云的显示

1、点云(6d)显示

数据太大了,可以在线展示点云,但是没有颜色信息,看起来不是很直观。

反思:

1、我在这个过程遇到了困扰我很久的问题,就是视差图生成了(虽然差一些),但是深度图一直显示不出来,用颜色映射出来都是红色的。我解决问题的思路一直在视差图转深度图的转换上了,其实最后才意识到源头在于视差图中计算出有大量的无限接近0的数值存在,导致深度无穷远,所以深度图中显示全红,同时也是看到了Middlebury数据集中给出的有效的视差范围,我才意识到这个问题,所以我想说的是如果遇到同样的问题可以将视差图中的数值分布打印成直方图,看看0附近的值是不是非常多,并且确定你自己图像的邮箱视差范围,在深度生成过程中将小于最小有效值的视差值都赋值为最小有效值。这样可以保证视差图转深度图没有问题。