引言

在数字化转型的浪潮中,数据已成为企业最宝贵的资产之一。DataOps作为一种文化、流程和实践的集合,旨在提高数据管道的质量和效率,从而加速数据从源头到消费的过程。白鲸开源科技,作为DataOps领域的领先开源原生公司,由Apache成员成立,80%的员工都是Apache Committer,主导着两个Apache顶级开源项目:Apache DolphinScheduler和Apache SeaTunnel。这些项目在全球6000多家企业中得到实践和使用,展现了DataOps的优势。

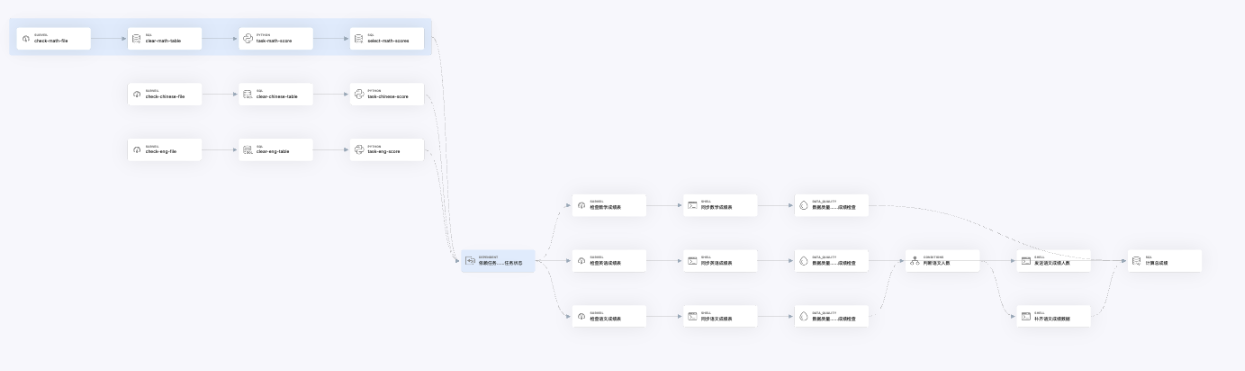

Apache DolphinScheduler:云原生时代的高稳定可视化调度平台

Apache DolphinScheduler是一个云原生的可视化工作流调度平台,它解决了企业级场景中的多个痛点,如任务单元多、执行频率高、数据量和任务量大、存在依赖关系等。与传统的老旧调度引擎相比,DolphinScheduler支持多任务类型、集群化部署与拓展,去中心分布式设计,高稳定可用,开源数据组件更新升级频率高,以及多云异构数据的管理能力。

特点

- 开源数据组件:更新升级频率高,保持技术栈的先进性。

- 多云异构数据管理:适应不同云环境和数据源的需求。

- 任务稳定运行:支持百万数据量级的任务稳定运行。

Apache SeaTunnel:新一代实时多源数据同步工具------大数据高速公路

Apache SeaTunnel是一个实时多源数据同步工具,支持上百种源数据库/地点和目标数据库/地点,包括MySQL、PostgreSQL、Kafka、MongoDB、Elastic、Hive等。SeaTunnel的性能比原有解决方案快50%-2倍,甚至在某些情况下快30倍。它支持批量数据全量、增量集成以及实时数据集成,为大数据提供了高速公路。

特点

- 性能卓越:SeaTunnel性能快50%-2倍,某些情况下快30倍。

- 数据同步与集成:支持批量数据全量、增量集成以及实时数据集成。

WhaleStudio简介

WhaleStudio是白鲸开源科技根据全球最佳实践发布的商业版版本,

调度模块产品功能

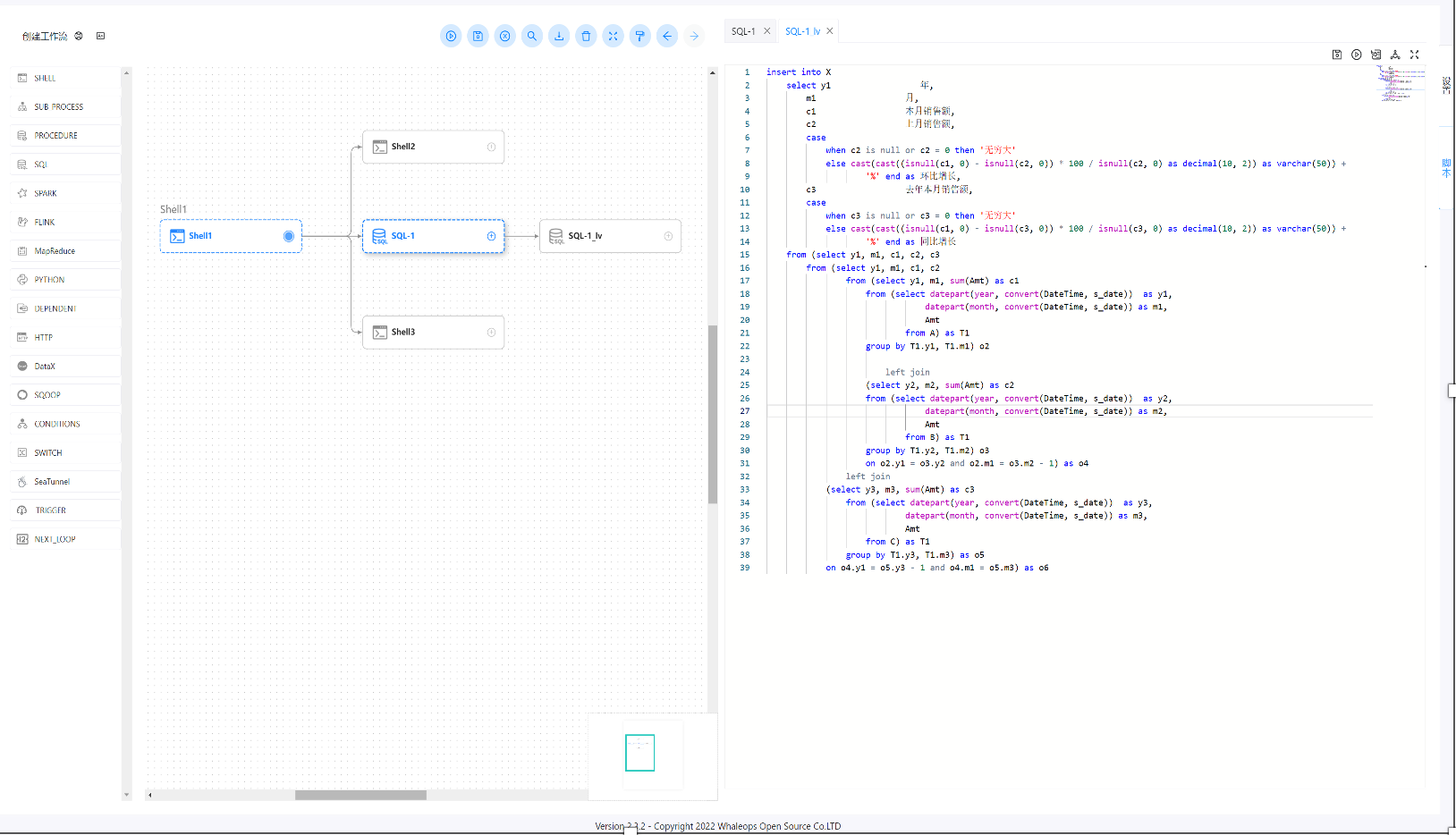

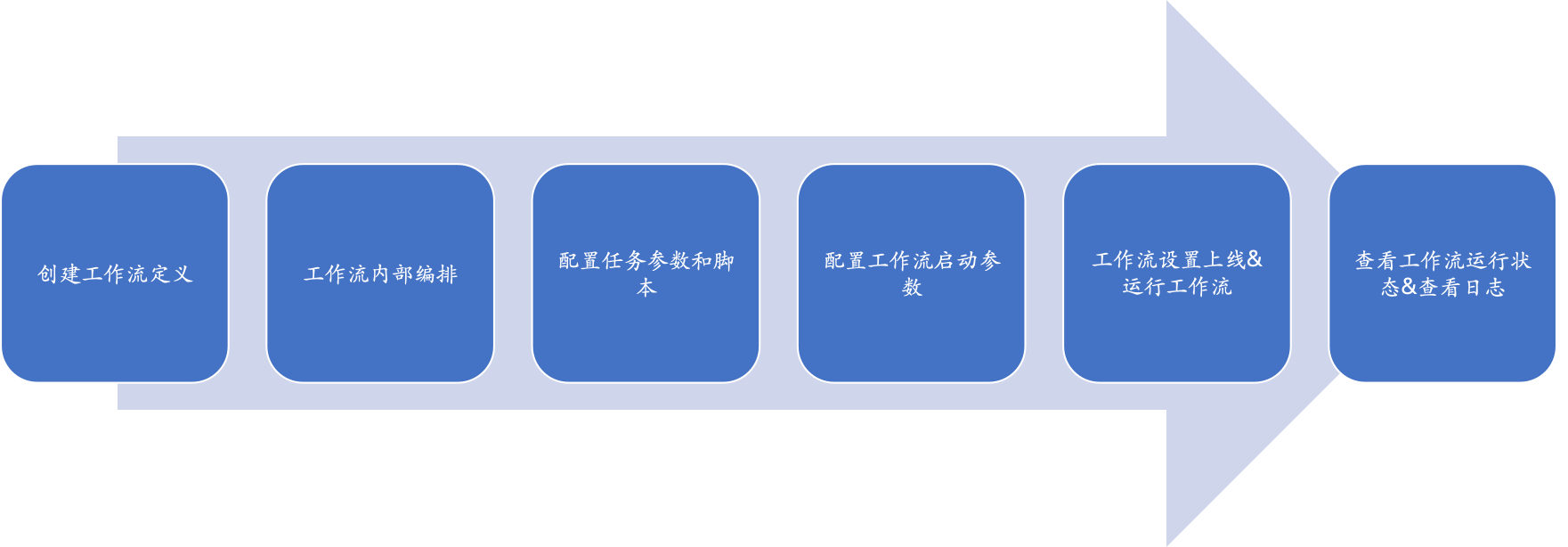

工作流编排能力

它支持各类计算任务组件,如Amazon DMS、Amazon Datasync、Apache Linkis,DataX,Sqoop,SeaTunnel等,以及各类云数据库和计算架构,支持K8S、MLDB。平台采用插件式设计,支持自由扩展数据源支持,可视化的数据源管理,大大减少了配置修改带来的工作量。

- 工作流基本配置:包括标签设置、租户、牌、全局变量和超时告警。

- 执行策略:可以是并行、串行等待或串行优先。

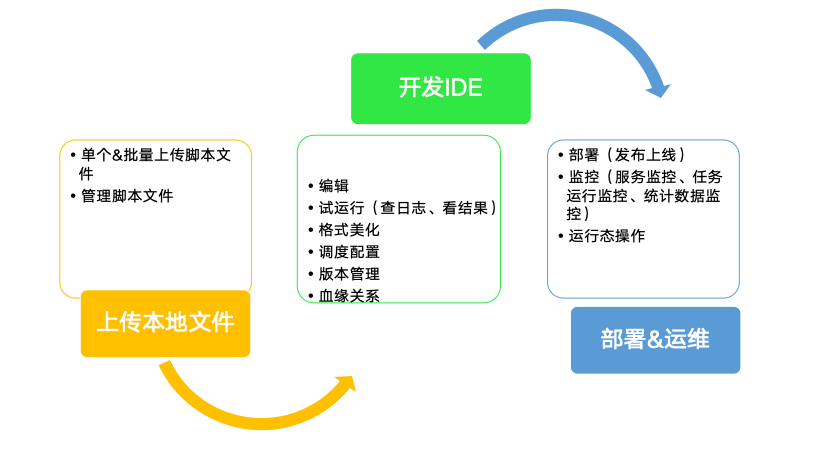

- 数据开发能力:包括在线IDE&集成,实现DataOps。

数据开发能力

WhaleStudio可以实现在线 IDE & 集成 ,实现 DataOps.

产品功能详解

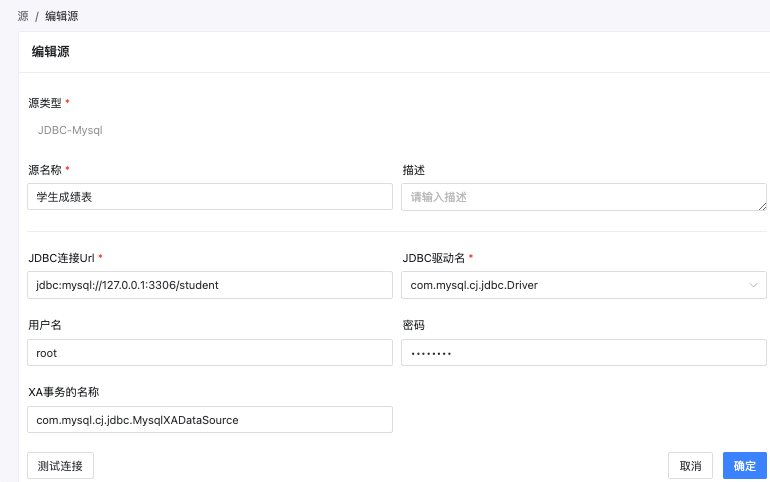

- SQL任务 在源中心创建数据源连接,在任务中指定数据源,在脚本中编写SQL语句,支持读写混合和多行SQL,支持设置多个前置SQL语句,支持调试。

-

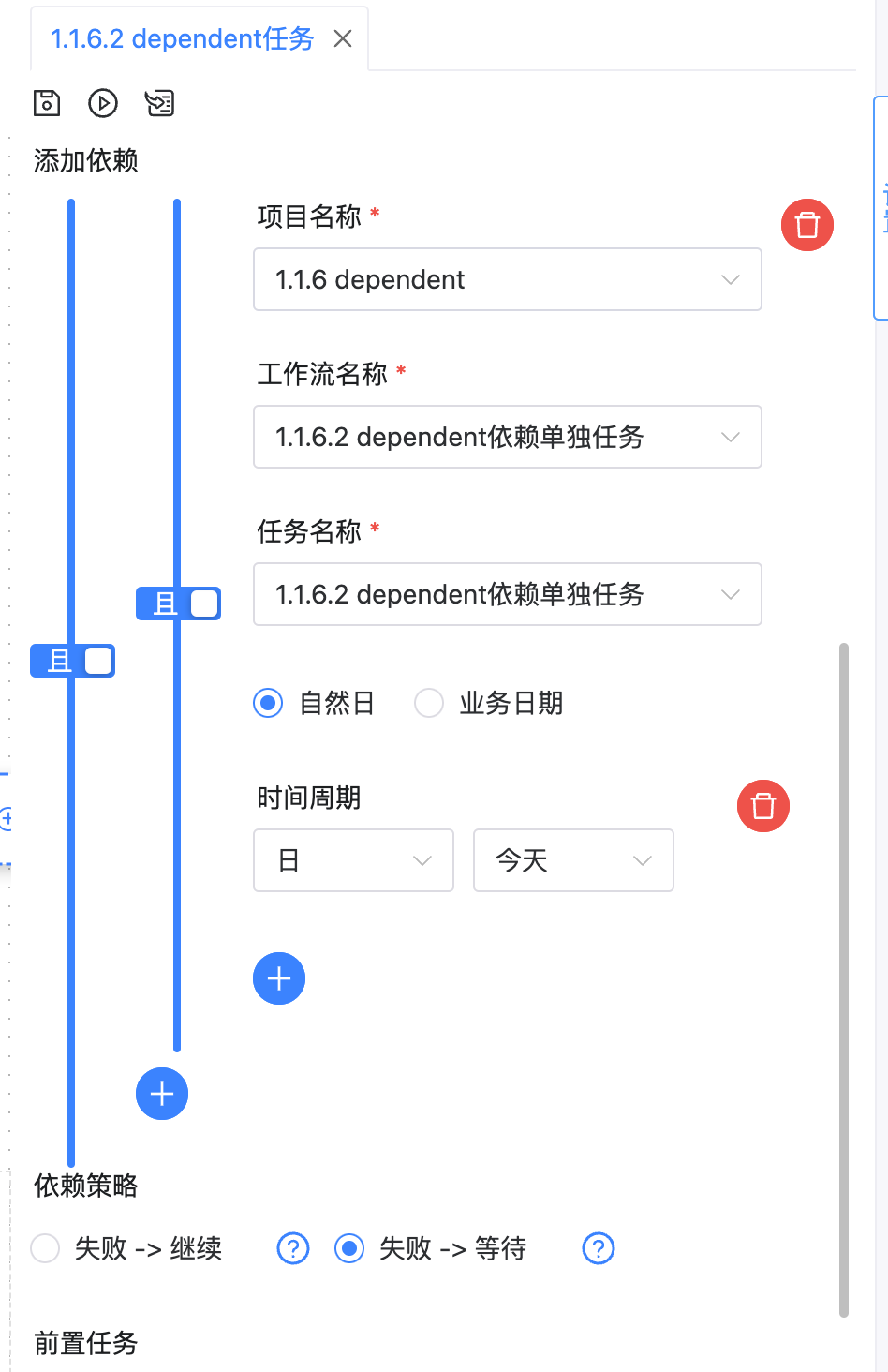

跨项目依赖任务 依赖检查任务,跨工作流检查,支持时间日期检查,支持自循环检查,依赖策略包括失败-继续和失败-等待。

-

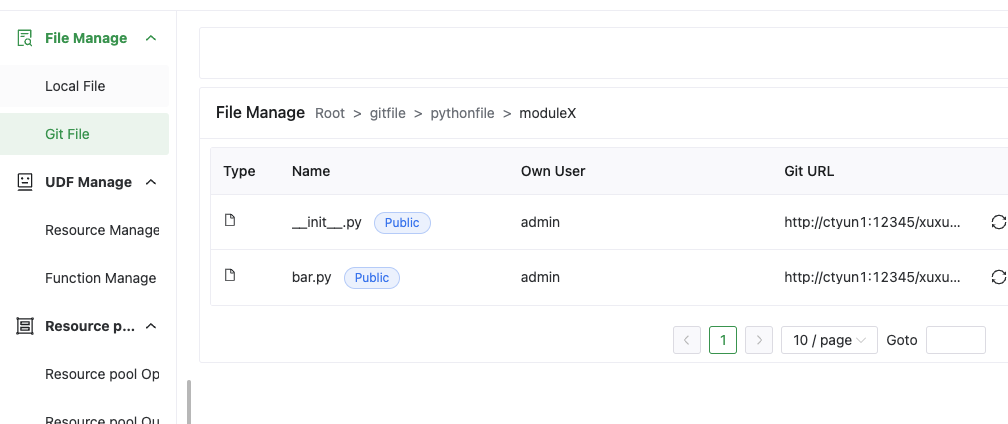

资源中心 -- git打通 Git文件功能允许用户将整个Git仓库作为资源文件上传到资源中心,执行任务时下载脚本文件,并提供更新接口。

- 数据任务血缘关系影响分析 工作流定义和任务定义的影响分析,查看任务加工的影响深度和广度,工作流实例和任务实例的影响分析。

- 源中心 统一管理所有数据源,控制数据源的读写权限,重要信息加密显示,多种使用场景。

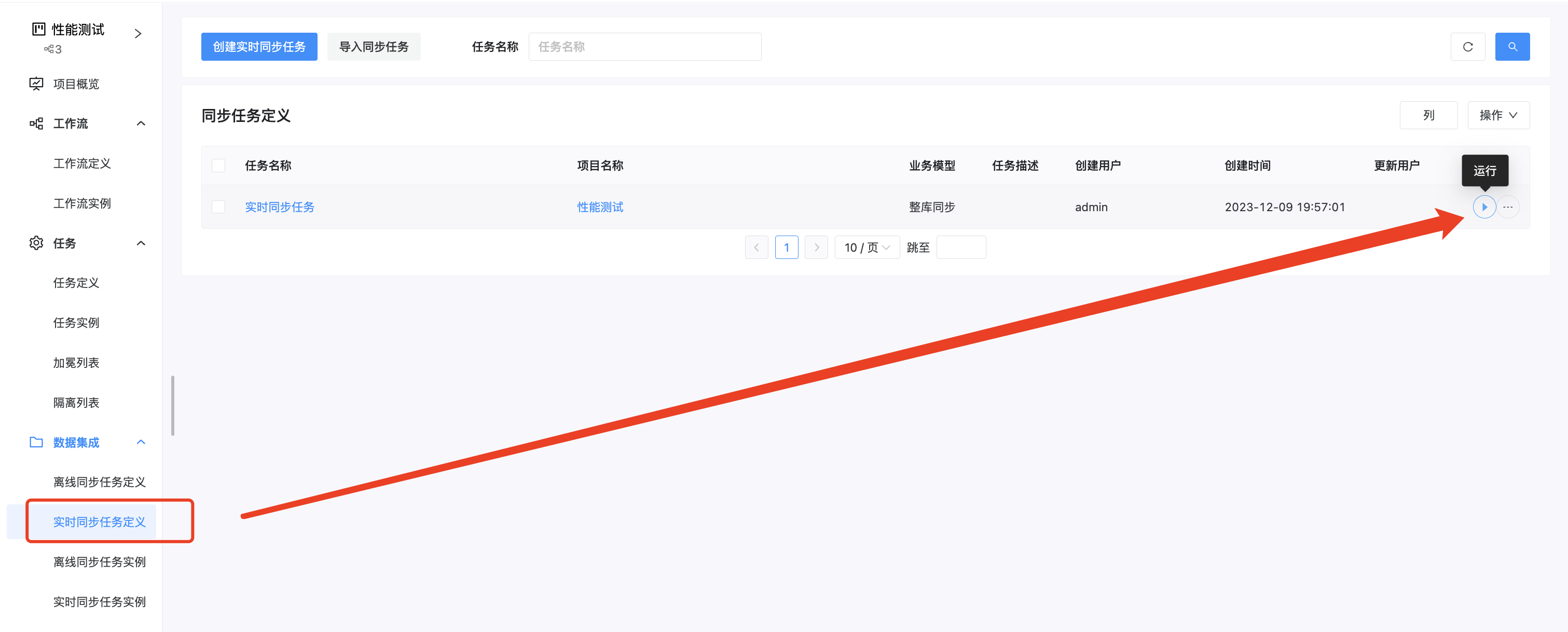

同步模块产品功能

WhaleTunnel支持160种数据源接口,多种数据集成方式,包括批量数据全量、增量集成和实时数据集成。它支持商业数据库实时CDC,包括Mysql cdc、PostgreSQL cdc等。

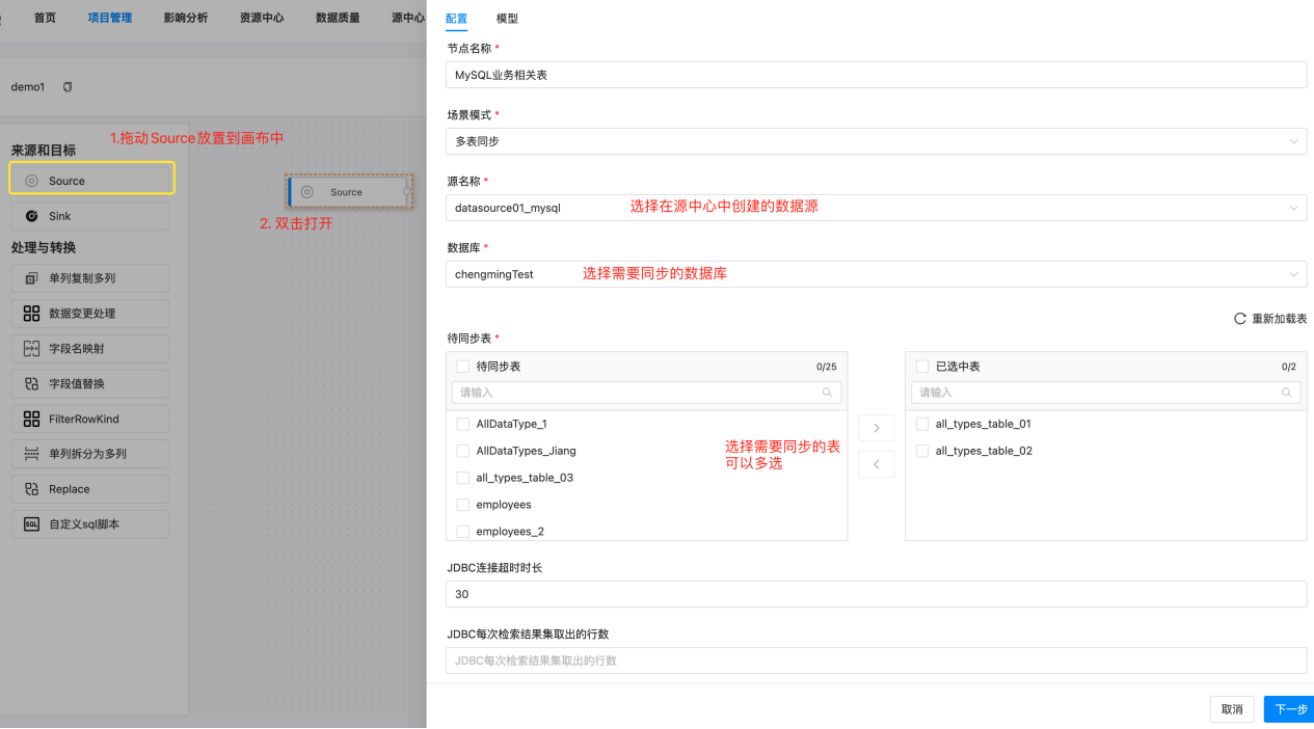

离线同步任务定义

离线同步任务定义包括Source和Sink,Source用来定义数据的来源,Sink用来定义数据同步的目标。支持选择同步字段、全表同步、已有表结构处理、已有数据处理和保障数据一致性。

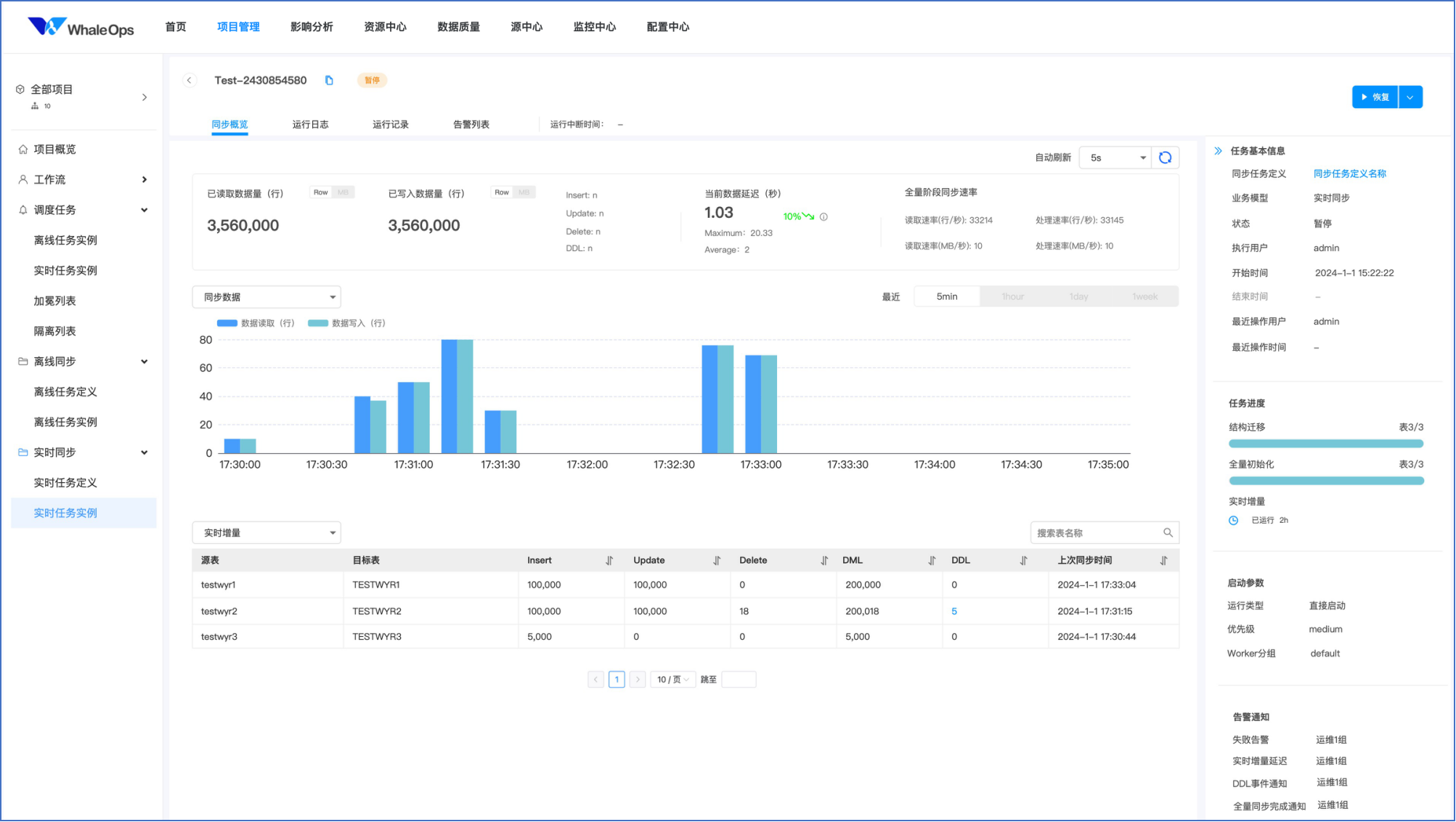

实时同步任务定义

实时同步任务定义包括创建数据源、Source和任务设置。支持历史数据阶段每次读取的行数、作业启动模式、在快照读取阶段读取增量日志并去重数据、并行度设置等。

数据转换及处理--Transform

WhaleTunnel提供多种数据转换节点,可以在数据同步管道中对表属性或数据进行转换处理,包括单列复制多列、单列拆分为多列、字段删除、字段重命名、字段值替换、数据变更处理、自定义sql脚本等。

Transform可适配实时同步中的DDL变更,如根据表达式匹配的transform会自动对新增字段进行处理。

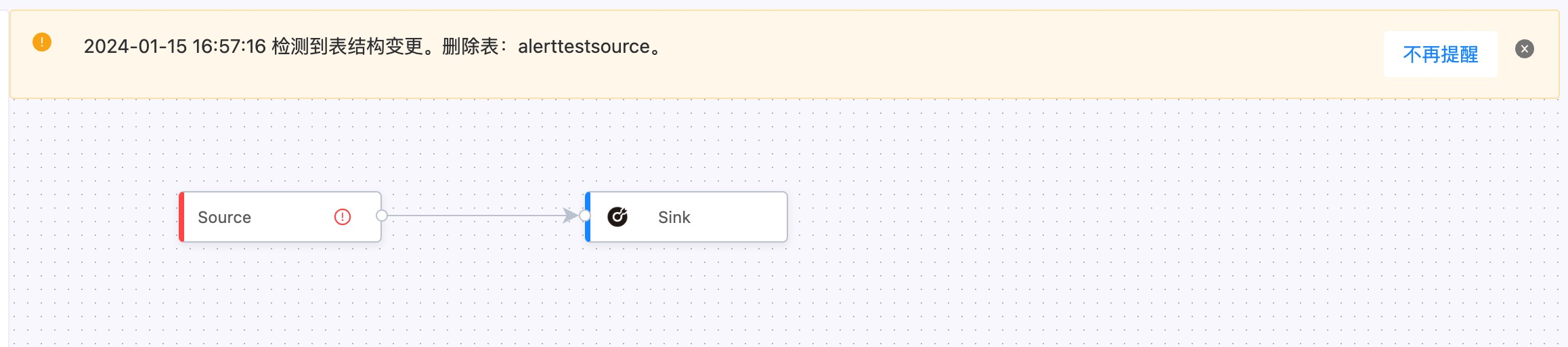

表DDL变更检查--刷新表元数据

WhaleTunnel支持对同步任务中配置的表进行表结构变更检查,以获取尤其是离线同步任务中的表结构变化。支持主动批量检查发现表结构变更和定时批量检查发现表结构变更。

实时数据同步支持DDL变更触发暂停、报警以及延迟告警

实时数据处理支持多种实时数据监测处理,包括DDL变更暂停、DDL变更告警、DDL暂停加表、DDL手工处理等。

产品功能

- 数据质量校验

数据质量支持多种数据源,包括正则表达式、表行数校验、两表值比对、空值检测、使用Spark实现、及时性校验、多表准确性、字段长度校验、枚举值校验、自定义SQL、唯一性校验。

- 数据质量场景

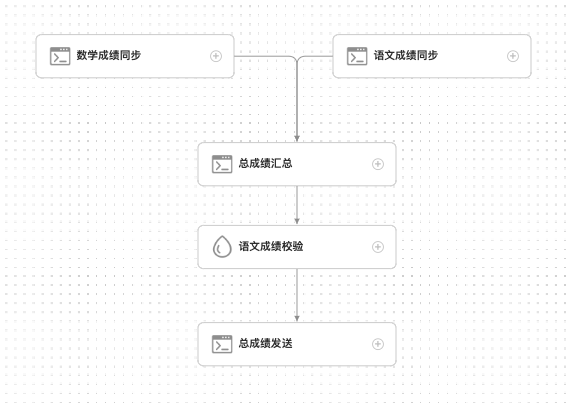

数据质量比对类型包括两表值比对,场景如计算语文成绩详情表yunwen_list所有人的总分和成绩汇总表chengji中语文总成绩,两者差值在1分以内,否则就阻断工作流执行。

Demo

下面是一个Demo,详细演示如何从Aurora CDC实时数据同步到Redshift:

https://www.bilibili.com/video/BV19zq2YpEFd/

src="//player.bilibili.com/player.html?isOutside=true&aid=113632822167469&bvid=BV19zq2YpEFd&cid=27285128673&p=1" scrolling="no" border="0" frameborder="no" framespacing="0" allowfullscreen="true">

结语

Apache DolphinScheduler和Apache SeaTunnel作为全球领先的开源原生DataOps平台,不仅提供了强大的数据集成和调度能力,还通过其商业版本WhaleStudio,帮助企业智能化地完成多数据源、多云及信创环境的数据集成、数据开发、工作流编排运维及部署、数据质量管控、团队敏捷协作等一系列问题。这些工具的全球应用案例证明了它们在数据集成领域的创新和领导地位。随着技术的不断进步和企业需求的日益增长,DataOps将继续引领数据管理的未来。

本文由 白鲸开源科技 提供发布支持!