Sdcb Chats 是一个强大且易于部署的 ChatGPT 前端,旨在帮助用户轻松接入和管理各种主流的大语言模型。

Sdcb Chats 主要特性:

- 广泛的大模型支持: 已支持 15 种不同的大语言模型提供商,只需配置 API Key 等连接信息,即可无缝切换。

- 灵活的数据库选择: 支持 SQLite 、SQL Server 和 PostgreSQL,可根据需求选择合适的数据库。

- 多样化部署: 提供 Docker 镜像 和多操作系统二进制文件,方便快速部署。

- 完善的管理功能: 内置多用户管理 、Token 消耗统计 和付费管理,便于团队协作和成本控制。

早在我首次发布时,Sdcb Chats 就已支持 DeepSeek。随着 DeepSeek-R1 的爆火,我们迅速跟进,在春节期间实现了对 DeepSeek-R1 思维链的两种形式的支持:

-

官方预处理型: 通过

reasoning_content字段显示思维链,与content同级。官网和硅基流动(SiliconFlow)采用此方式。示例:json{"id":"0194e3241b719f91d183976240e08067","object":"chat.completion.chunk","created":1738977581,"model":"Pro/deepseek-ai/DeepSeek-R1","choices":[{"index":0,"delta":{"content":null,"reasoning_content":"嗯","role":"assistant"},"finish_reason":null,"content_filter_results":{"hate":{"filtered":false},"self_harm":{"filtered":false},"sexual":{"filtered":false},"violence":{"filtered":false}}}],"system_fingerprint":"","usage":{"prompt_tokens":17,"completion_tokens":1,"total_tokens":18}} -

开源常见型: 通过

content中的<think>标签展示思维链。Gitee AI、NVIDIA NIM、GitHub Models、Azure AI、Azure AI Foundry 等采用此方式。示例:<think> 好的,用户说......(这一部分是思维链) </think> 总的来说......(这一部分是响应)

在最新发布的 Sdcb Chats r-459 版本中,我们已全面支持这两种 DeepSeek-R1 思维链格式!

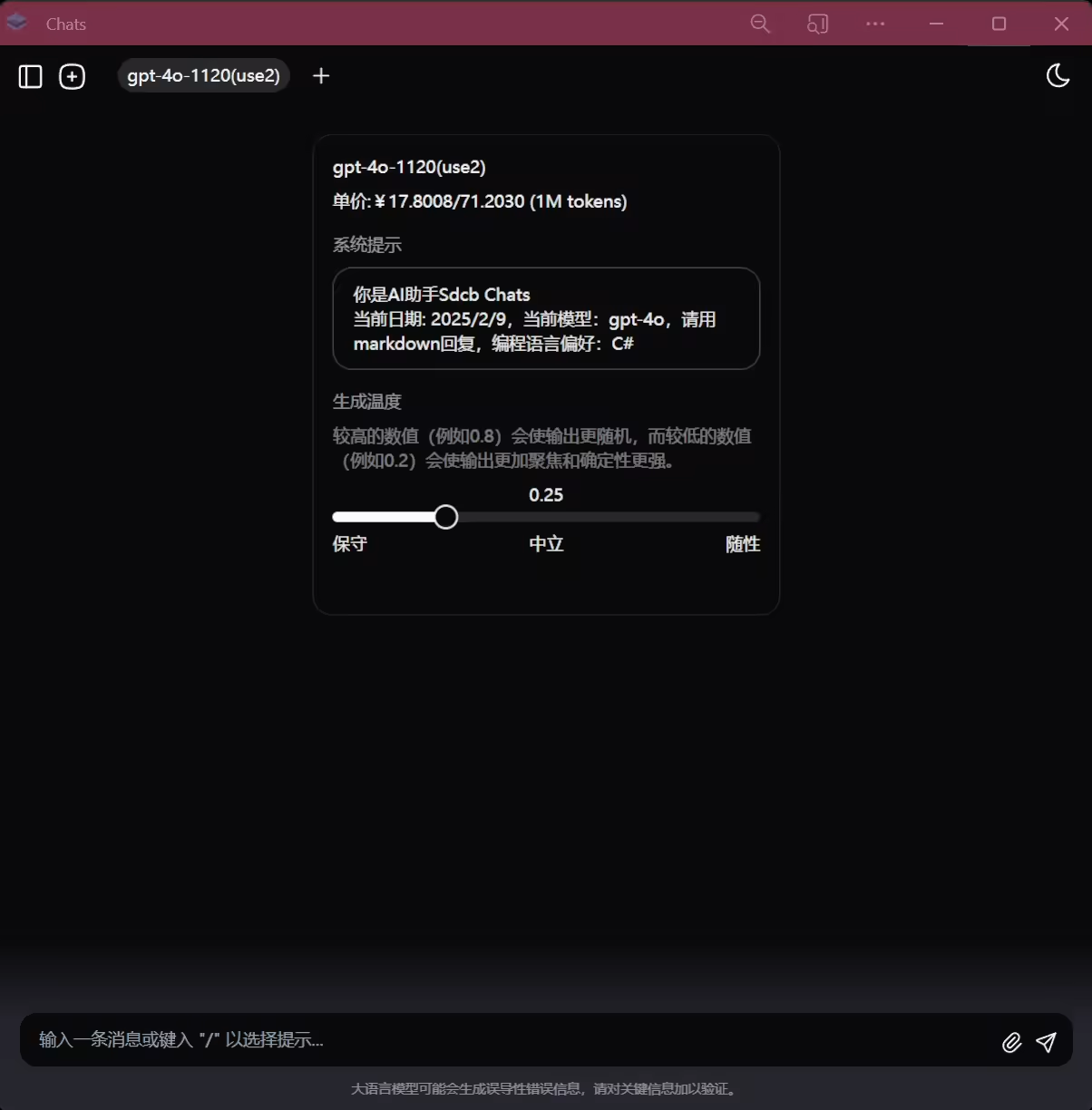

效果图:

如何部署带思维链的 Sdcb Chats?

此前文章已详细介绍了部署过程,此处重点介绍 Windows exe 部署:

Windows exe 部署(国内服务器加速)

考虑到国内访问 Docker 的不便,我们特地将 exe 部署文件上传至国内服务器,方便大家下载:

| 文件 | 下载链接 |

|---|---|

| chats-win-x64.7z | https://io.starworks.cc:88/chats/r459/chats-win-x64.7z |

| chats-linux-x64.7z | https://io.starworks.cc:88/chats/r459/chats-linux-x64.7z |

| chats-linux-arm64.7z | https://io.starworks.cc:88/chats/r459/chats-linux-arm64.7z |

| chats-linux-musl-x64.7z | https://io.starworks.cc:88/chats/r459/chats-linux-musl-x64.7z |

| chats-linux-musl-arm64.7z | https://io.starworks.cc:88/chats/r459/chats-linux-musl-arm64.7z |

| chats-osx-arm64.7z | https://io.starworks.cc:88/chats/r459/chats-osx-arm64.7z |

| chats-osx-x64.7z | https://io.starworks.cc:88/chats/r459/chats-osx-x64.7z |

| chats-fe.7z | https://io.starworks.cc:88/chats/r459/chats-fe.7z |

| chats.7z | https://io.starworks.cc:88/chats/r459/chats.7z |

Windows 用户推荐下载 chats-win-x64.7z,解压后双击 exe 即可运行。

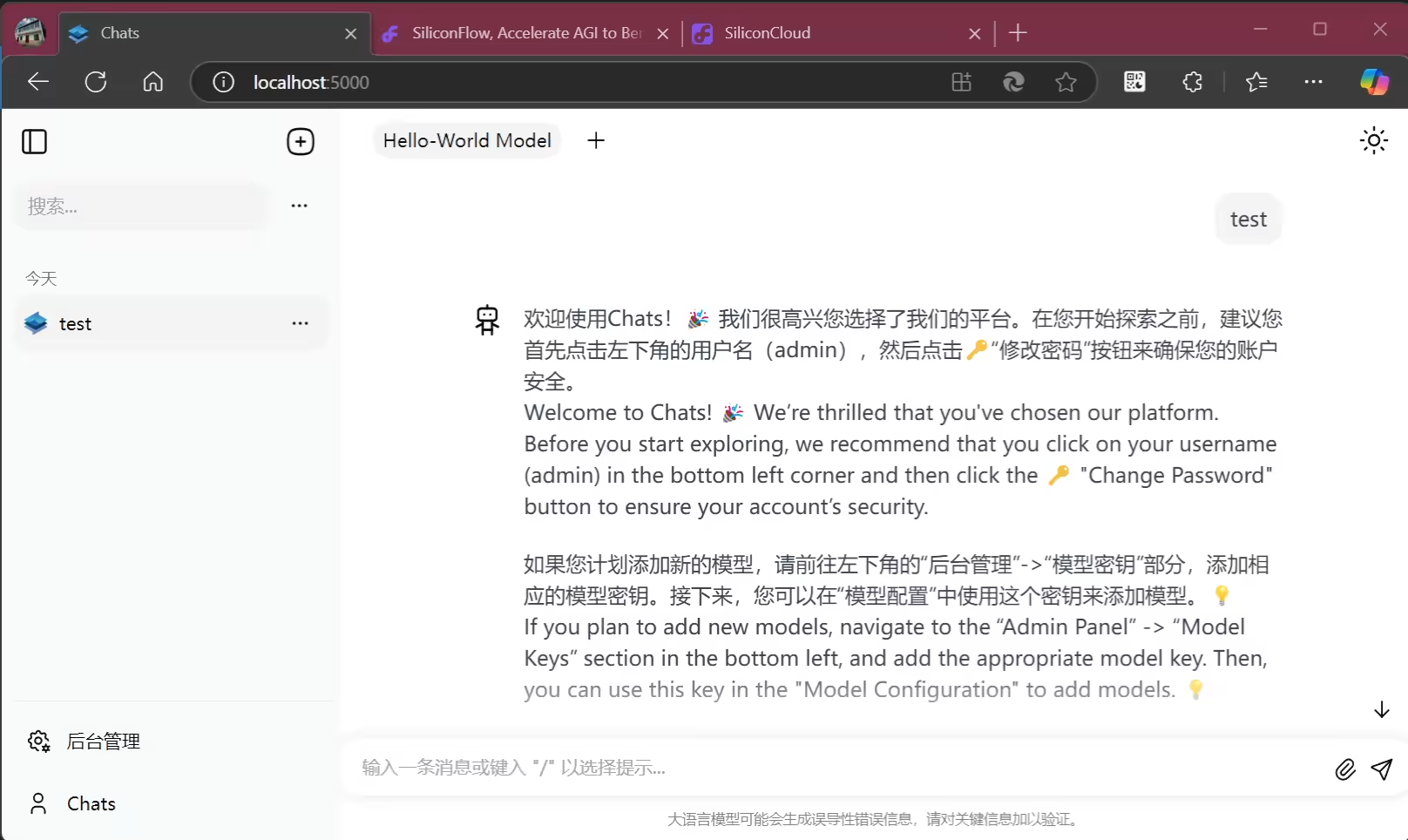

演示:

运行成功后,默认用户:chats,默认密码:RESET!!!(请尽快修改)。

提示: Sdcb Chats 更新频繁,可将链接中的 r459 替换为 latest 下载最新版,例如:https://io.starworks.cc:88/chats/latest/chats-win-x64.7z

Sdcb Chats 支持多平台部署,包括:

- linux-x64

- linux-arm64(适用于 RK3399/RK3588 等国产芯片)

- linux-musl-x64、linux-musl-arm64(适用于 OpenWRT 软路由)

- osx-arm64(适用于 M1 及以上芯片的 Mac)

- osx-x64(适用于 x86 芯片的 Mac)

- chats.7z(适用于已安装 .NET 8 SDK 的电脑)

我们也支持 Docker 部署(我个人生产环境使用 linux-x64 Docker 部署)。

使用 DeepSeek 官网或 SiliconFlow API

由于 DeepSeek-R1 模型爆火,官网 API 极不稳定,甚至目前已暂停充值。我们推荐使用 SiliconFlow(硅基流动) 作为平替:

- 注册链接(含邀请码,赠送约 14 元 token): https://cloud.siliconflow.cn/i/UG2LV9e1

- 直接注册链接(同样赠送 14 元 token): https://cloud.siliconflow.cn

推荐 SiliconFlow 的理由:

- 安全性差异: 我们发现,各厂商部署的开源版 DeepSeek-R1 671B 模型安全性限制更严格,这并非接口层过滤,而是模型层面差异。开源版可能接受了额外的安全性训练。在涉及某些议题时,开源版会立即终止(可能违反直觉,但这是真的),而官网版能输出丰富内容。

- 支持

reasoning_content: SiliconFlow 与官网一样支持reasoning_content格式的思维链,保证了 API 的一致性。

接入 SiliconFlow API 演示:

- 官网创建 API Key。

- Chats 管理后台创建 SiliconFlow API Key 并保存。

- 快速创建模型,选择 DeepSeek-R1,创建并关闭对话框。

- 模型管理页面审阅模型(可调整价格)。

- 用户配置中,为用户增加模型权限。

演示:

演示中创建的是 deepseek-ai/DeepSeek-R1 模型(免费额度),响应较慢(约 70 秒)。Pro/deepseek-ai/DeepSeek-R1 速度更快,但需充值(建议充值 1 元)。

DeepSeek 官网 R1 的接入步骤类似。

使用其他 DeepSeek API 提供商或本地 Ollama

以本地 Ollama 为例:

-

下载 DeepSeek-R1(7B, Q4 量化):

pwshPS C:\Users\Administrator> ollama pull deepseek-r1 pulling manifest pulling 96c415656d37... 100% ▕████████████████████████████████████████████████████████▏ 4.7 GB pulling 369ca498f347... 100% ▕████████████████████████████████████████████████████████▏ 387 B pulling 6e4c38e1172f... 100% ▕████████████████████████████████████████████████████████▏ 1.1 KB pulling f4d24e9138dd... 100% ▕████████████████████████████████████████████████████████▏ 148 B pulling 40fb844194b2... 100% ▕████████████████████████████████████████████████████████▏ 487 B verifying sha256 digest writing manifest success PS C:\Users\Administrator> ollama ls NAME ID SIZE MODIFIED deepseek-r1:latest 0a8c26691023 4.7 GB 9 minutes ago -

配置 Ollama 对外暴露地址: 例如

https://ollama.starworks.cc:88(默认http://localhost:11434,我做了反向代理)。 -

Ollama 的 OpenAI 兼容地址:

https://ollama.starworks.cc:88/v1(密钥可随意填写,但不能为空)。

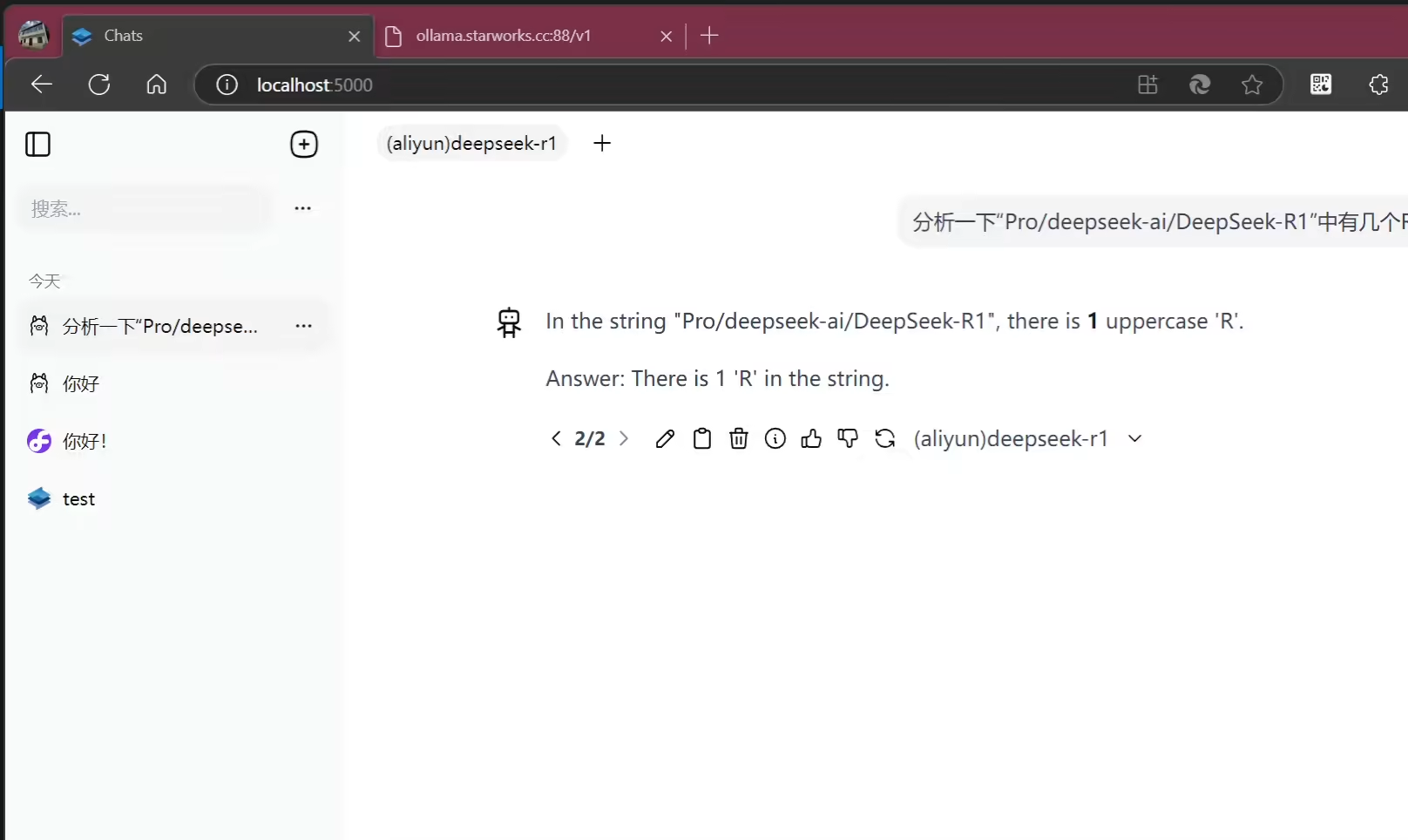

配置步骤与 SiliconFlow 类似:

我使用纯 CPU 运行 Ollama 中的 DeepSeek-R1 7B(Q4),其实速度尚可,虽然结果不完全正确,但可玩性高。

注意: Ollama 的 API 推理响应使用 <think> 标签,Sdcb Chats 支持。

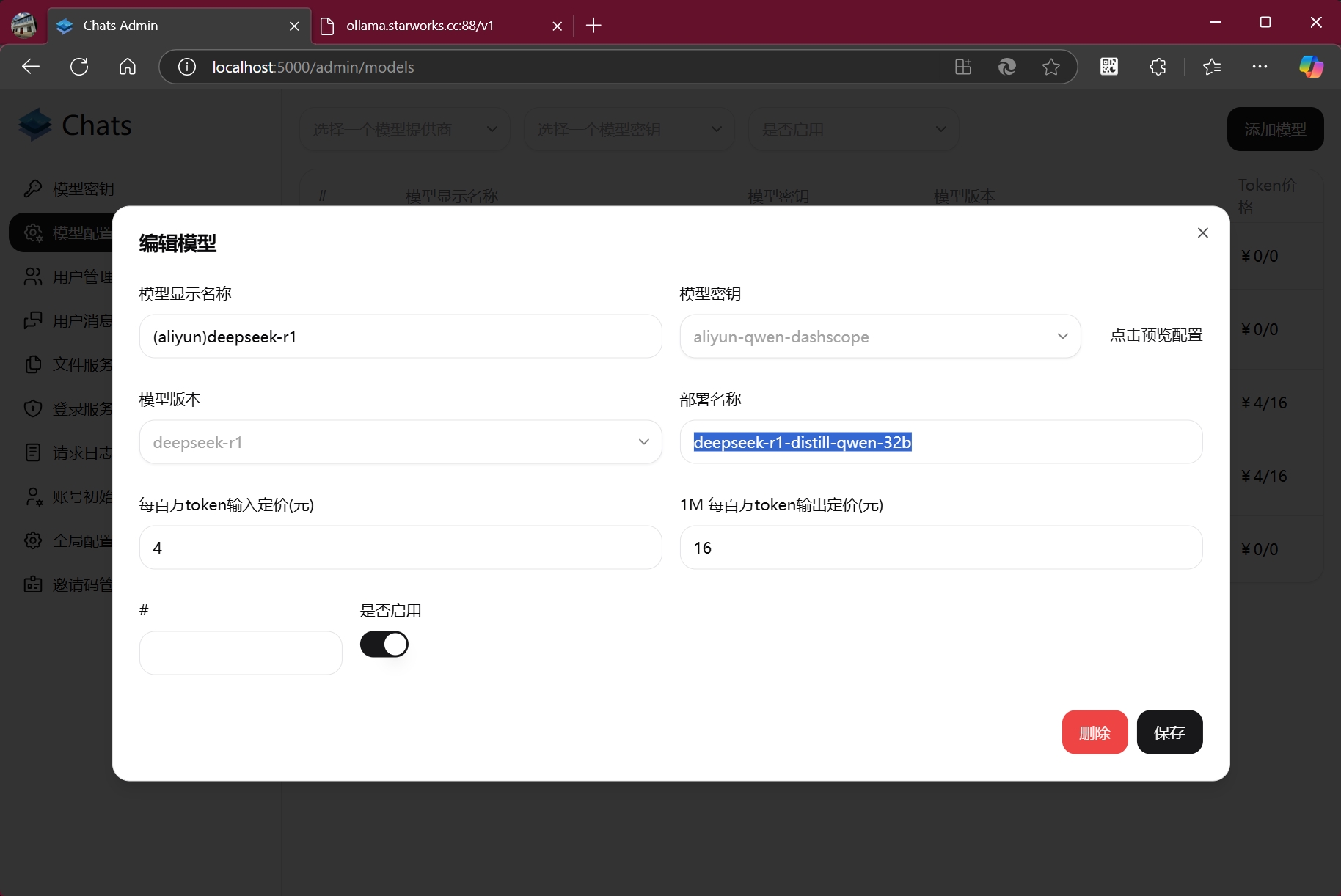

其他模型提供商的 Ollama: 可先指定为 Ollama 创建,然后在模型配置中填入正确的模型部署名称,比如阿里云DashScope,你可能需要这样配置模型(注意模型提供商):

效果相同。

总结

感谢您对 Sdcb Chats 的关注!本次更新深度集成了 DeepSeek-R1 思维链,提升了 AI 透明度。我们全面支持官方及其他提供商的 API,提供灵活配置选项。

更新亮点:

- 支持多种思维链格式: 完美解析

reasoning_content和<think>标签。 - 多样化部署: 提供多平台二进制文件和 Docker 镜像。

- 灵活配置: 支持多种数据库和模型,丰富 AI 体验。

我们特别优化了与 SiliconFlow 的集成,确保您顺畅接入 DeepSeek-R1。

下一步:

如果您尚未体验 Sdcb Chats,现在是最佳时机!我们提供详细的部署文档,助您快速上手。

支持我们!

如果您觉得 Sdcb Chats 有帮助,请在 GitHub 上 Star 我们!您的支持是我们前进的动力。

再次感谢您的支持,期待未来为您带来更多惊喜!