技术背景

在DeepSeek系列文章中,我们已经分别介绍过关于DeepSeek在Ubuntu Linux平台和Windows平台上的本地部署方案,以及Ollama、ChatBox和AnythingLLM等辅助工具的使用。即使不使用DeepSeek-R1的全量模型,在DeepSeek的本地部署的蒸馏模型,结合AnythingLLM已经可以构建本地化的知识库。但是如果在科研过程中要专注于使用PDFChat这样的功能的时候,可能还是需要一个更加场景细化的应用。

Zotero原本经常被用来当作论文数据库,可以导入自己关注的各个领域的文章,还可以云同步到其他设备上。而且因为Zotero强大的PDF处理能力,有时候也会被拿来当科研论文的PDF阅读器。那么如果在读论文的时候直接导入一个大模型AI助手,那么可能会大大提升论文阅读的速度。本文介绍在Zotero中使用DeepSeek进行理解和辅助的方法。

Zotero插件安装

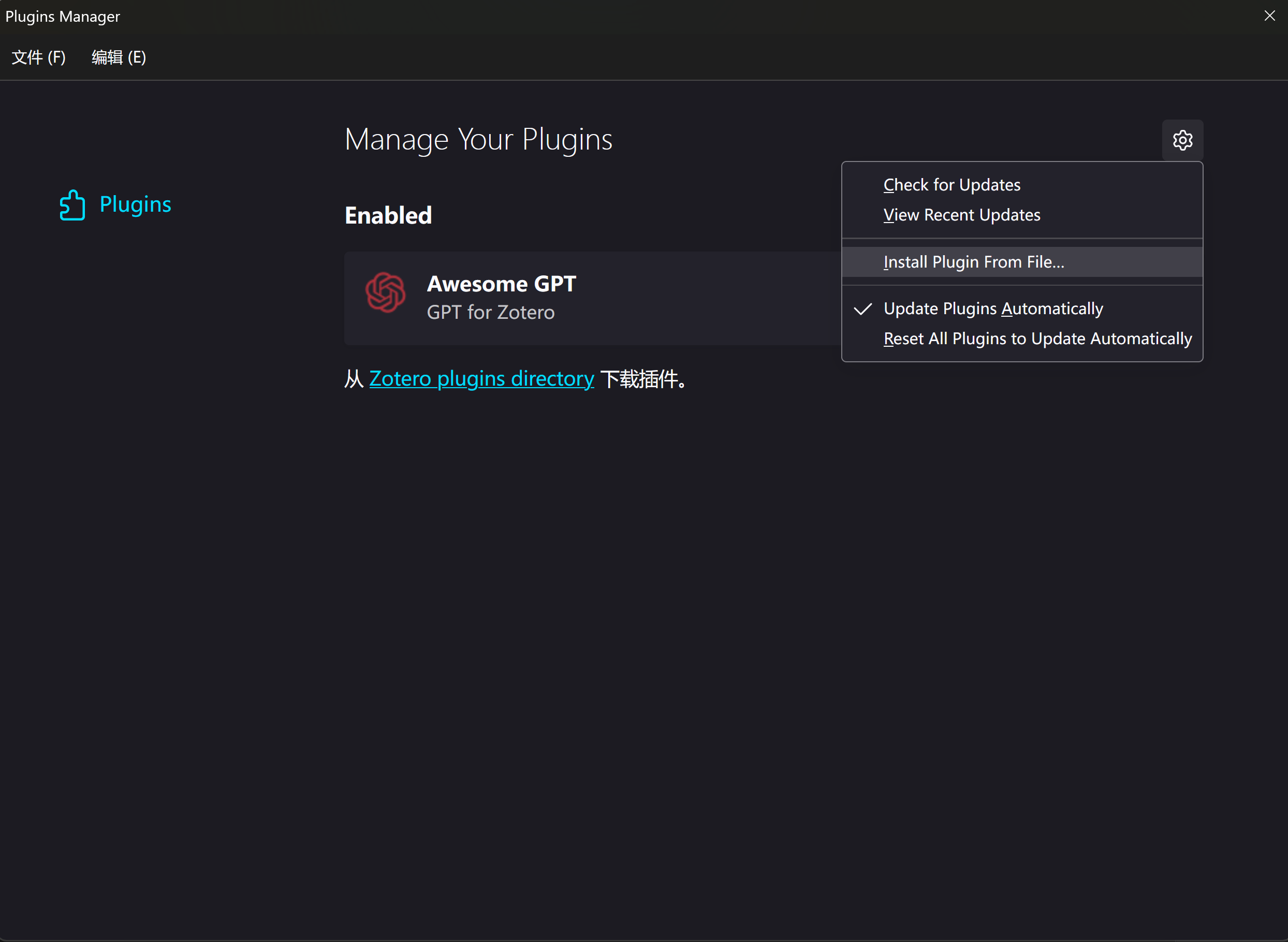

我们需要一个Awesome GPT插件来导入Ollama的本地模型,或者是一些服务商提供的API。下载完成后再Zotero中打开工具-插件-Install From Plugin选项,导入我们下载好的插件:

这样插件就安装完成了。

配置Awesome GPT

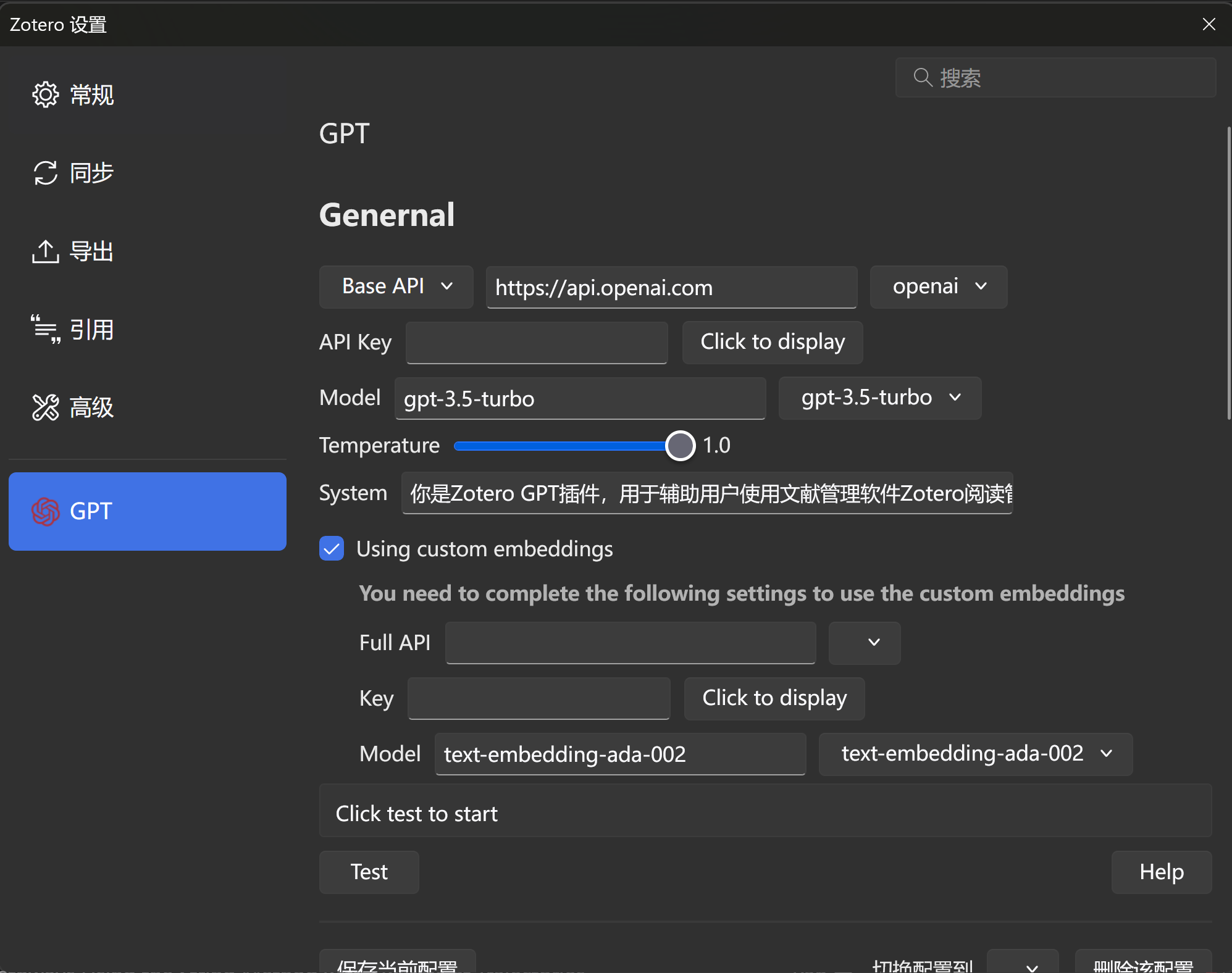

在Zotero中找到编辑-设置-GPT:

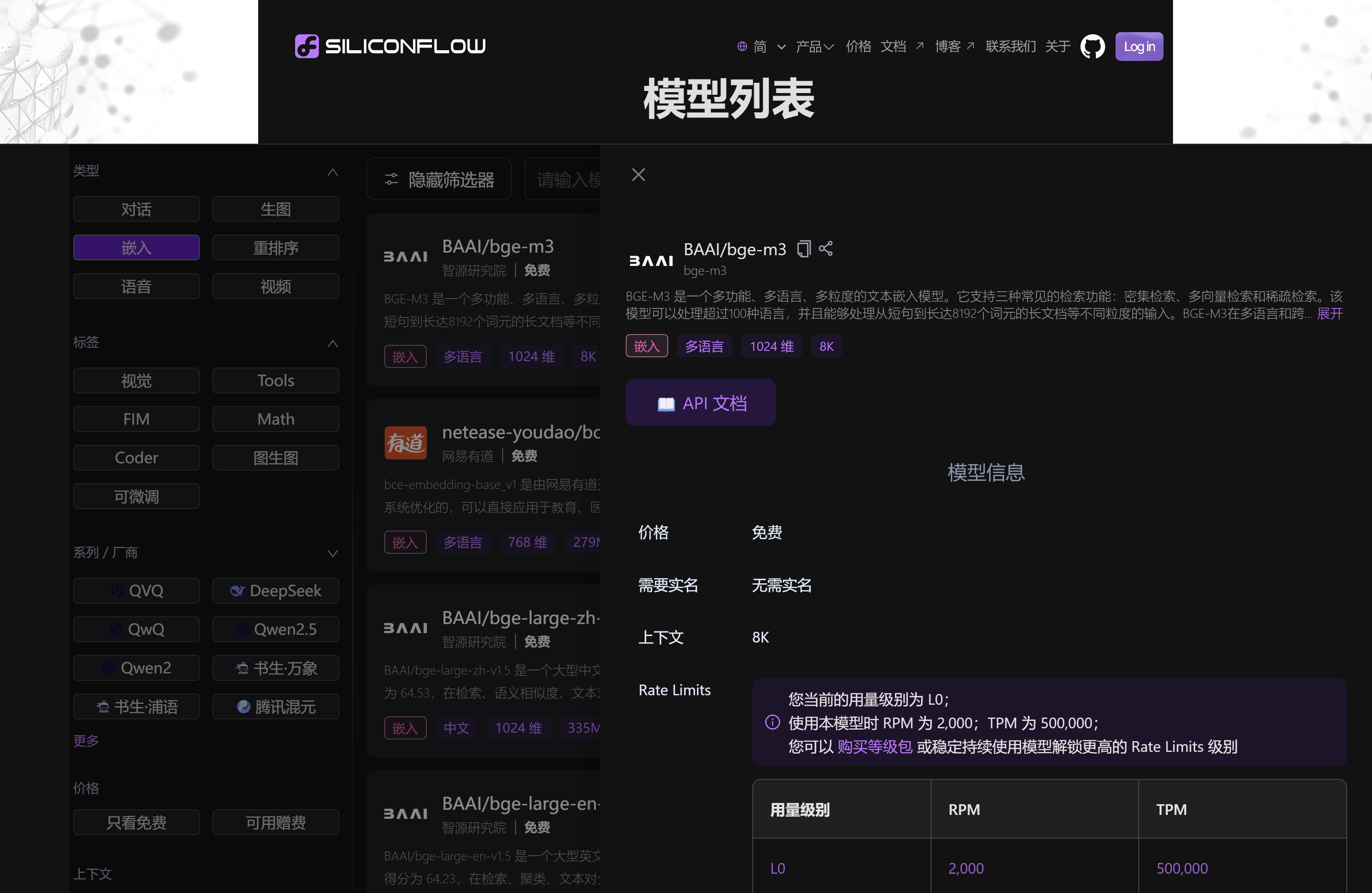

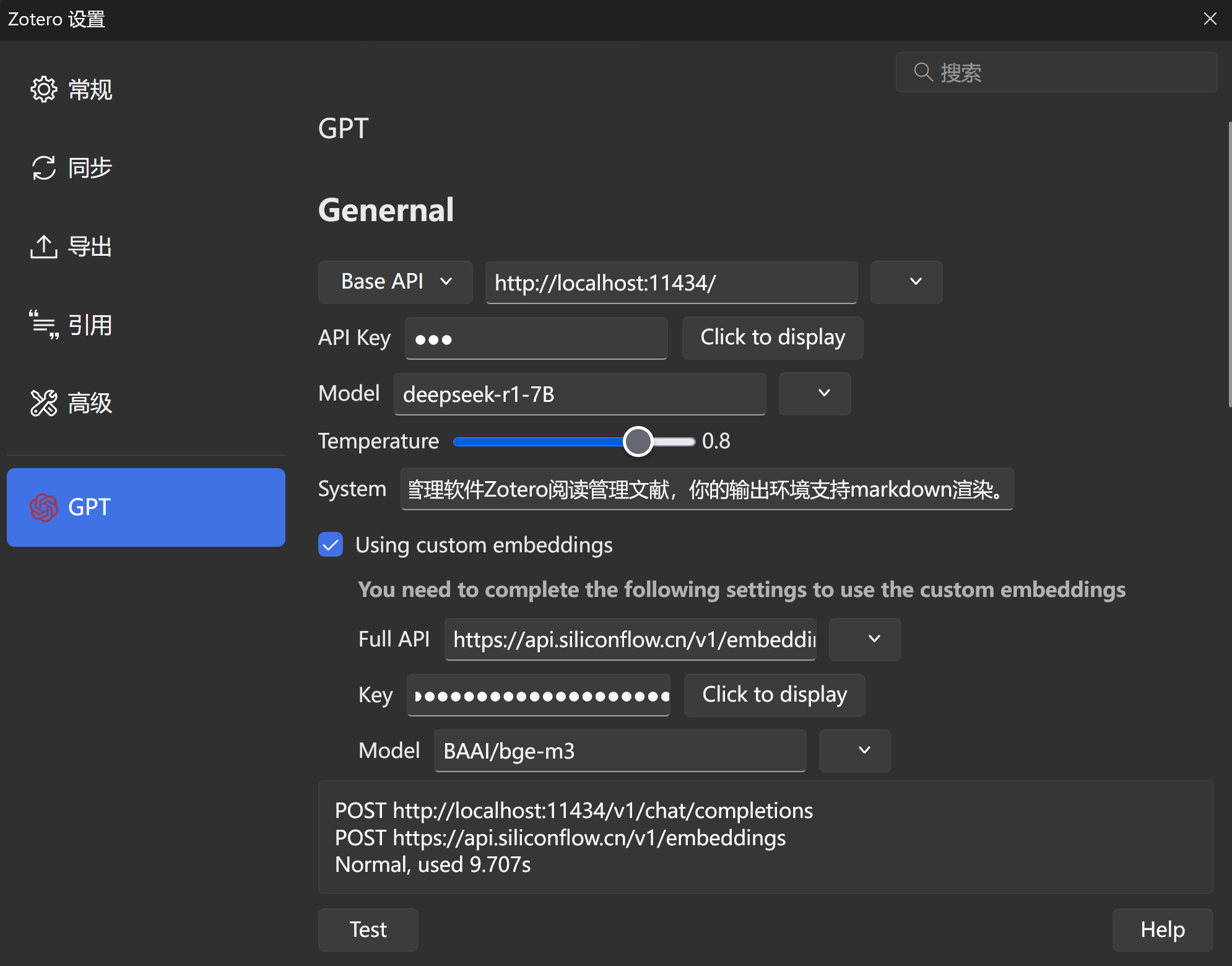

General部分改为本地Ollama的参数,Custom Embedding这个部分建议选中,然后去硅基流动弄一个免费的API,推荐bge-m3:

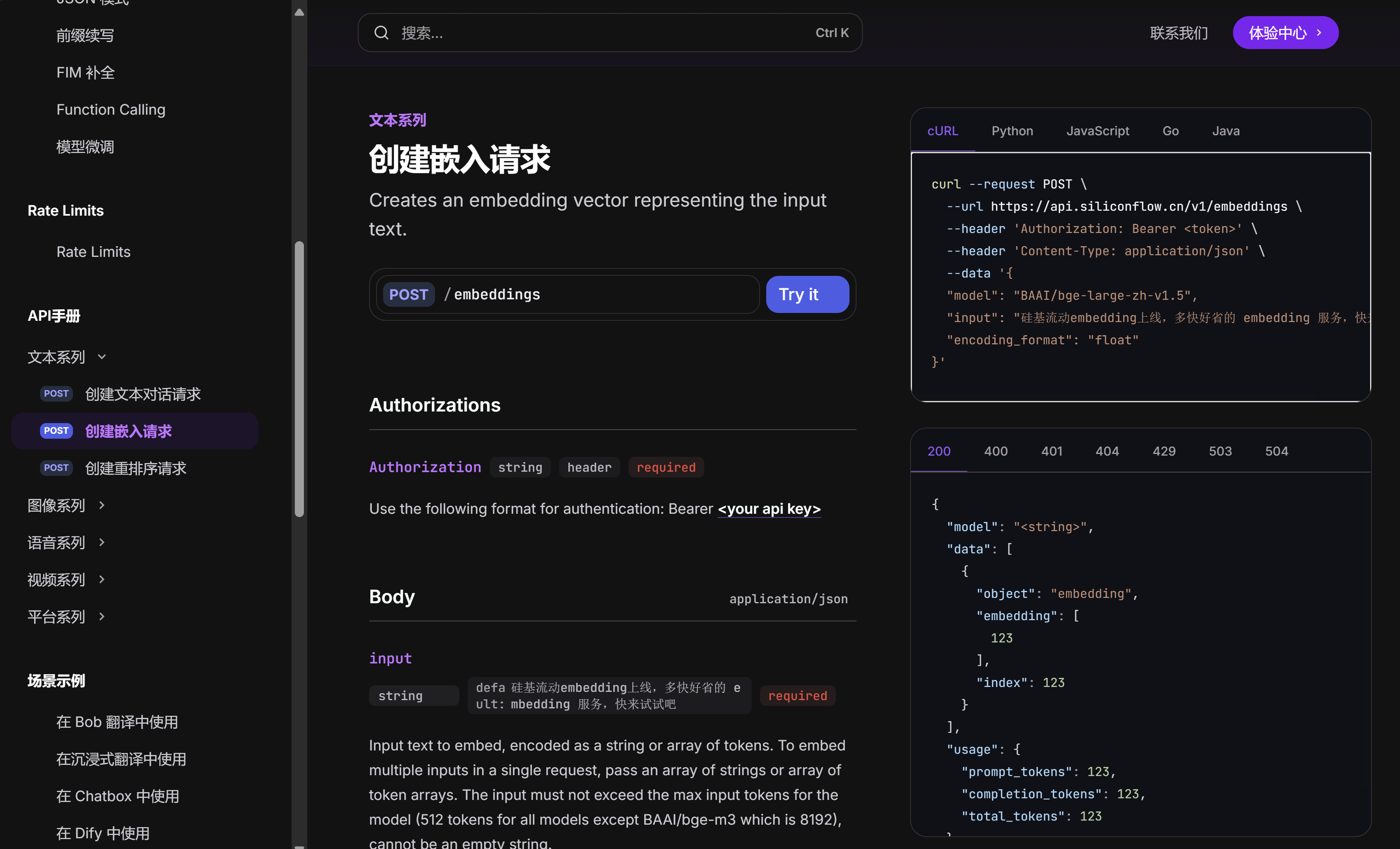

点击这个API文档:

复制框里面的url路径,作为插件的Full API使用,然后再注册一个硅基流动的账号,在账户管理-API密钥新建一个密钥:

点击前面的密钥即可复制,作为插件中的Key使用,模型就选择BAAI/bge-m3:

这样就配置完成了,点击TEST会出现成功POST的字样,没有报错即为配置成功。

使用Awesome GPT

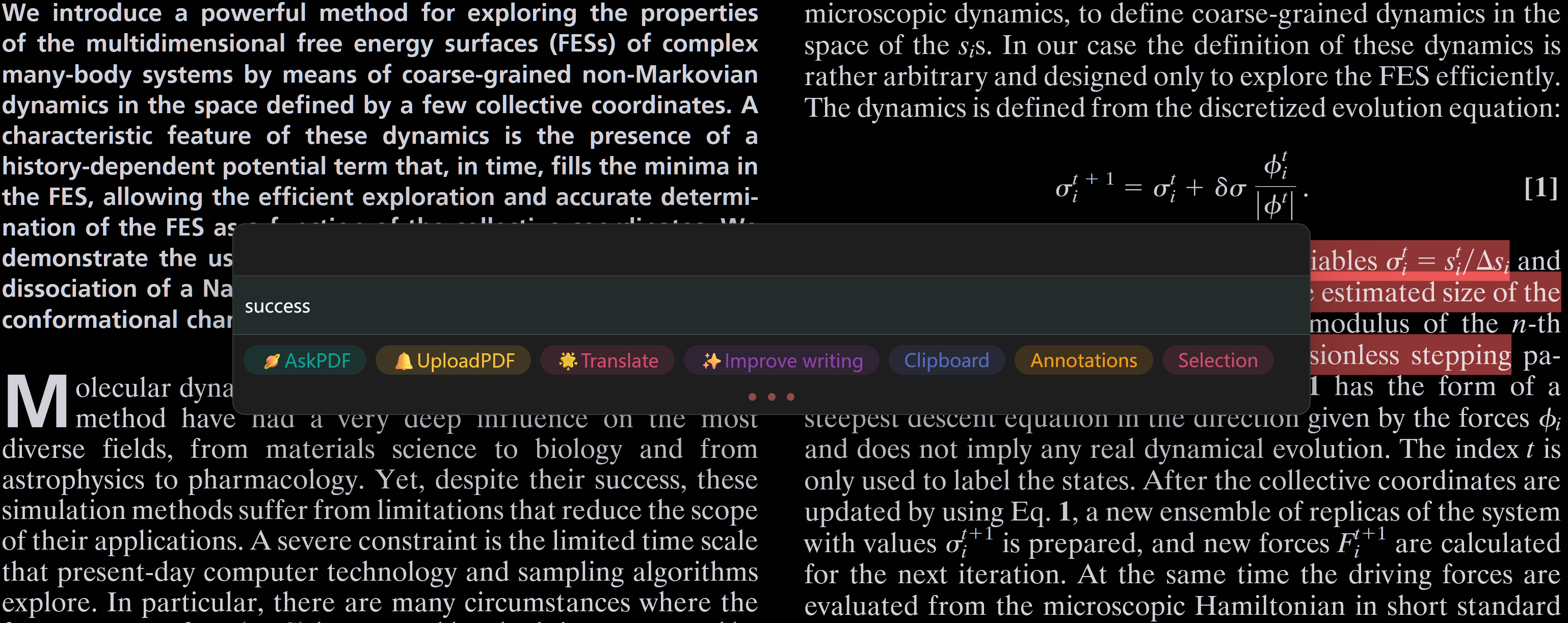

在Zotero中随便打开一个PDF文档,使用快捷键ctrl+/打开Awesome GPT界面,就会弹出这样的一个面板:

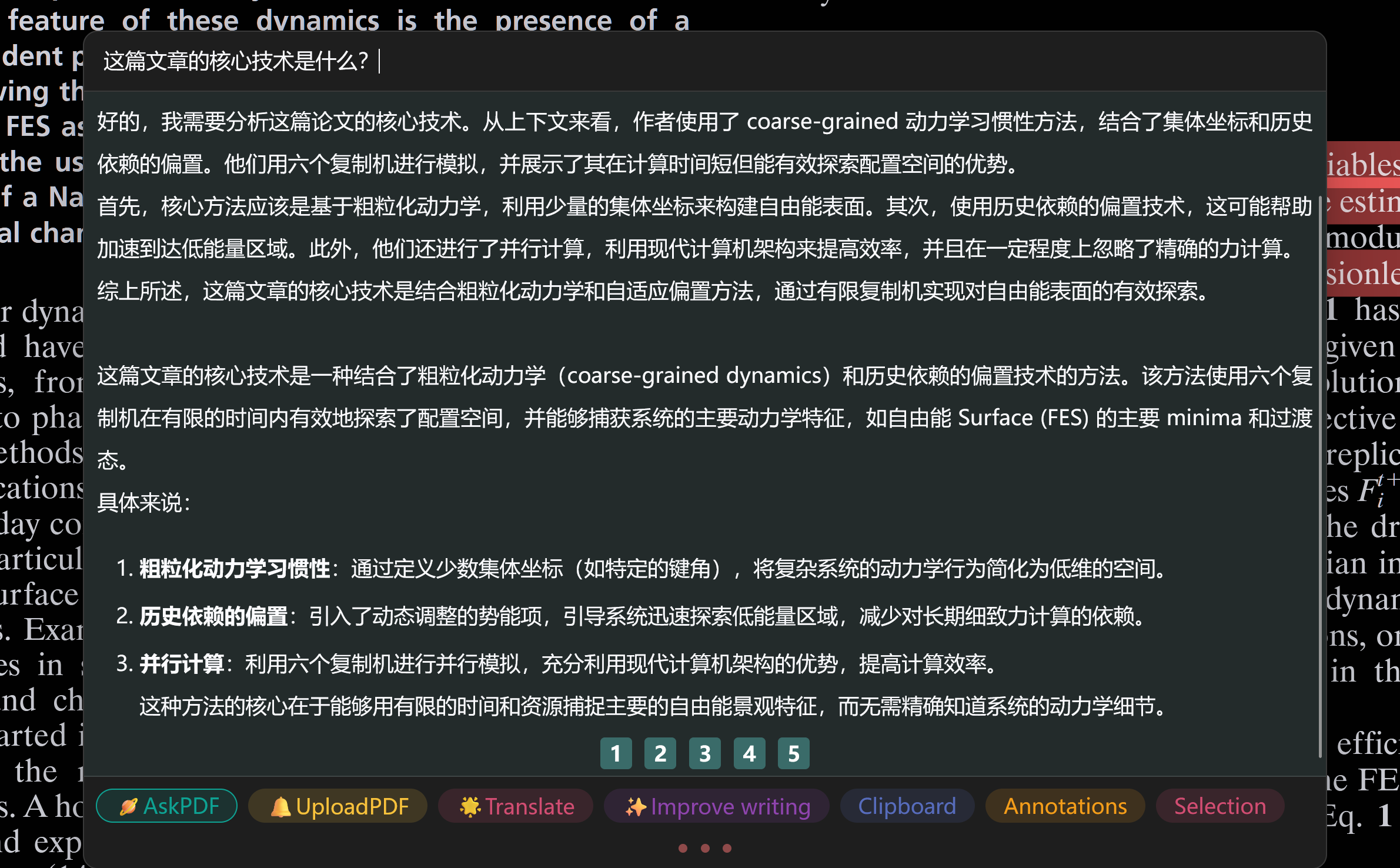

然后就可以在面板上直接输入问题,按Enter或者点击Ask PDF向DeepSeek提问,这里解析PDF使用的就是我们导入的Embedding模型。如下是一个示例:

由于本地使用的是一个7B的模型,还没有展现出比较强大的智能。按照经验来说,32B会有一个显著的提升,很勉强能用,70B开始有一些智能,真要使用的话还是建议上全量模型,现在API其实也不贵。

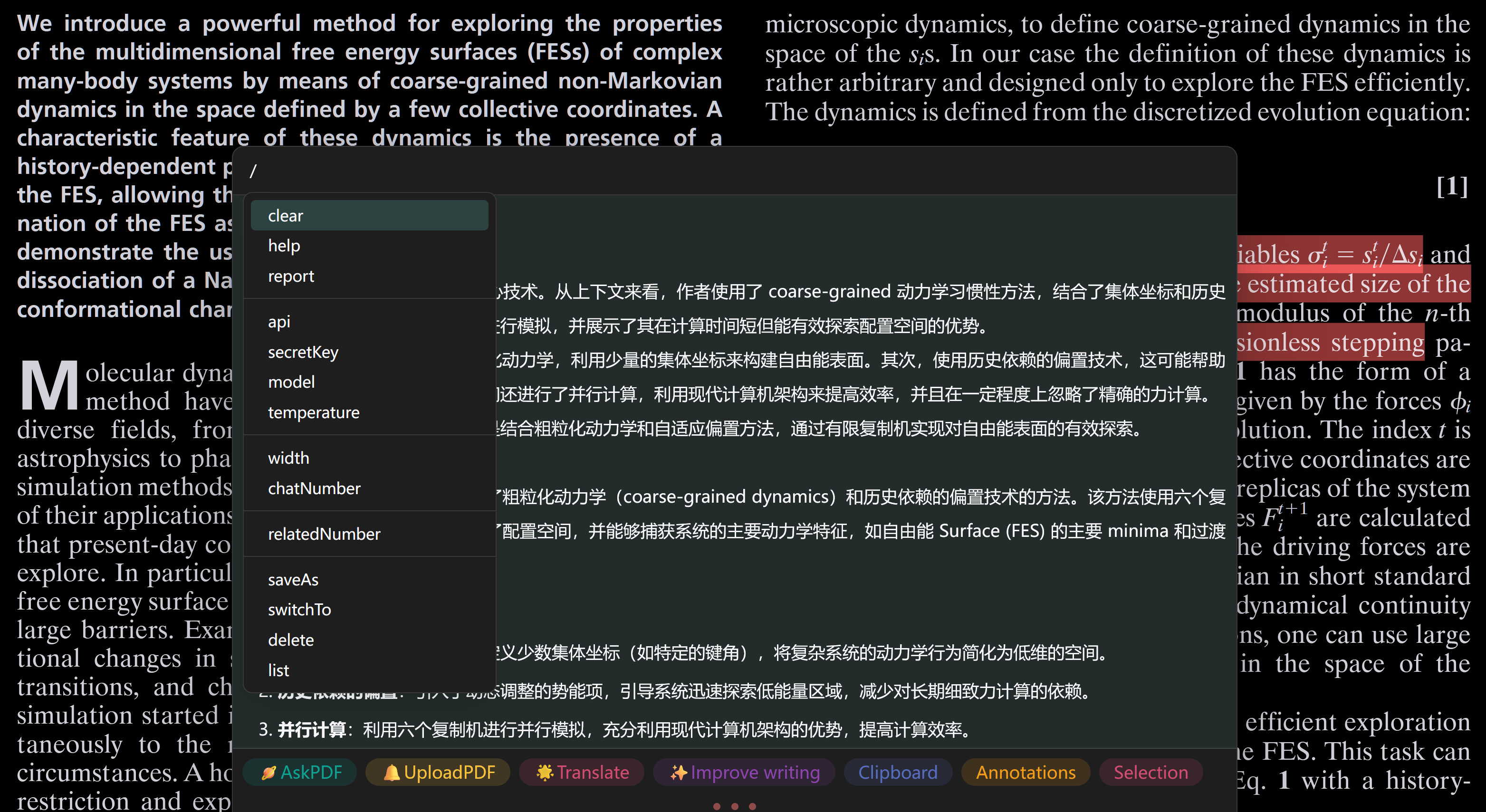

关于插件里面还有一些其他的操作,可以通过输入/调出来:

例如说,这里就可以输入clear清空屏幕输出。

总结概要

这篇文章介绍了一种在Zotero科研文献阅读管理软件中,使用Awesome GPT插件配置Ollama-DeepSeek文本生成模型+BAAI-bgeM3嵌入模型,来解析和理解科研论文的一种方法。借此可以简化一部分繁杂的论文学习过程,也许可以提升科学研究的效率。

版权声明

本文首发链接为:https://www.cnblogs.com/dechinphy/p/ds-zotero.html

作者ID:DechinPhy

更多原著文章:https://www.cnblogs.com/dechinphy/

请博主喝咖啡:https://www.cnblogs.com/dechinphy/gallery/image/379634.html