前言

AI的普及,正在改变我们工作生活的方方面面。

在这个最好也是最坏的时代里,想要没那么快被淘汰掉,我们就需要紧紧拥抱住时代的变化。

当下最大的变化应该就是AI了。最近一段时间里,我整理了很多有关AI的新技术以及旧技术的变革,感兴趣的朋友可以关注我的公众号进行查看。

今天,我们继续这个主题。

今天来聊一聊Dify这个平台。

Dify的介绍

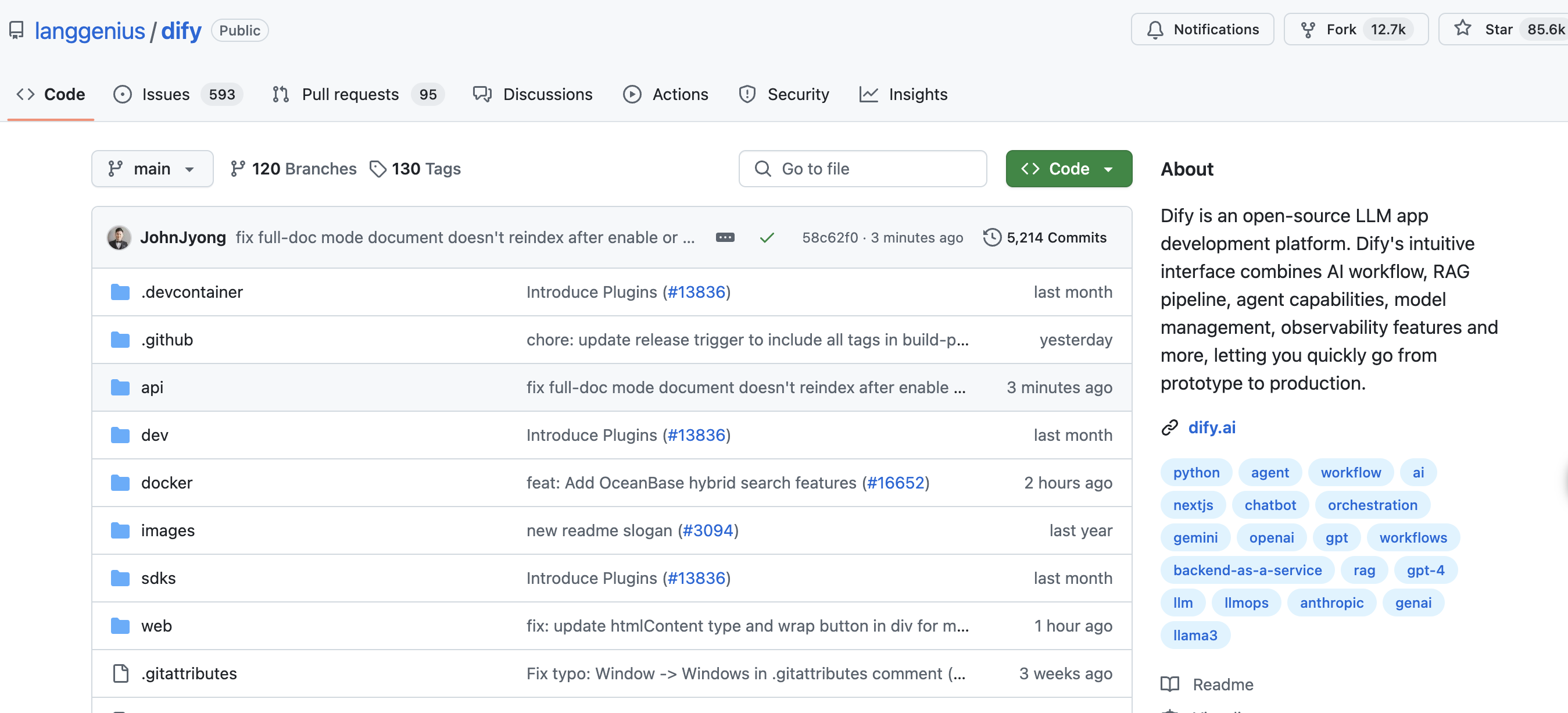

Dify 是一款开源的大语言模型(LLM)应用开发平台,致力于简化生成式AI应用的开发流程,支持从原型设计到生产部署的全生命周期管理。其核心功能覆盖AI工作流构建、模型集成、RAG(检索增强生成)管道、代理能力开发及LLMOps(大语言模型运维)等,适用于企业和个人开发者快速构建智能应用。

既然是开源的,就说明我们其实可以在自己的电脑或服务器上进行部署使用。

开源地址是: github.com/langgenius/...

Dify的核心功能主要有以下几方面

低代码/无代码开发

Dify 提供了可视化的界面,允许开发者通过拖拽、配置等方式定义 Prompt(提示词)、上下文和插件,无需深入底层技术细节。

模块化设计

采用模块化架构,每个模块都有清晰的功能和接口,开发者可以根据需求选择性地使用这些模块来构建自己的 AI 应用。

丰富的功能组件

- AI 工作流:通过可视化画布构建和测试强大的 AI 工作流。

- RAG 管道:支持从文档摄入到检索的完整流程,可从 PDF、PPT 等常见格式中提取文本。

- Agent 智能体:基于 LLM 的推理能力,可以自主规划任务、调用工具,完成复杂任务。

- 模型管理:支持数百种专有和开源的 LLM,如 GPT、Llama2 等,并提供模型性能比较功能。

工具集成

Dify 提供了 50 多种内置工具(如谷歌搜索、DALL·E、Stable Diffusion 等),还可以自定义工具。

数据存储与管理

允许管理 AI 交互数据,优化 AI 反馈。

部署灵活

支持本地部署和云端部署,保障数据安全

部署和访问Dify

还记得我的上一篇介绍扣子(Coze)平台的文章吗,如果你看了这篇文章,或者你对Coze平台有所了解,你就会知道我们借助于Coze这样的平台,可以搭建自己的智能体和应用,允许我们借助AI能力来处理很多复杂问题。

但是Coze这些平台陆续收费了之后,在一定程度上给我们这些囊中及其羞涩的用户带来了很大的影响。如果你也在为此而烦恼的话,Dify将成为你的一个非常好的平替选择。

此外,Dify的功能强大,上手简单,都是大家应该赶紧入门使用的极好理由。

说了这么多,Dify到底怎么使用呢?马上我就来介绍。

本地部署

最方便使用,也是应用最广的方法,其实就是在服务器上自行部署。

但是安装之前,我们首先需要确定一下服务器的配置。Dify部署对服务器的要求并不高,只需要满足下面两个条件

- CPU 大于2核

- 内存大于4G

可以说,这个配置已经是非常低配了。随便一台电脑的配置都已经远远超过这个要求。

接下来,在服务器上执行下面的命令,就可以成功安装运行Dify了

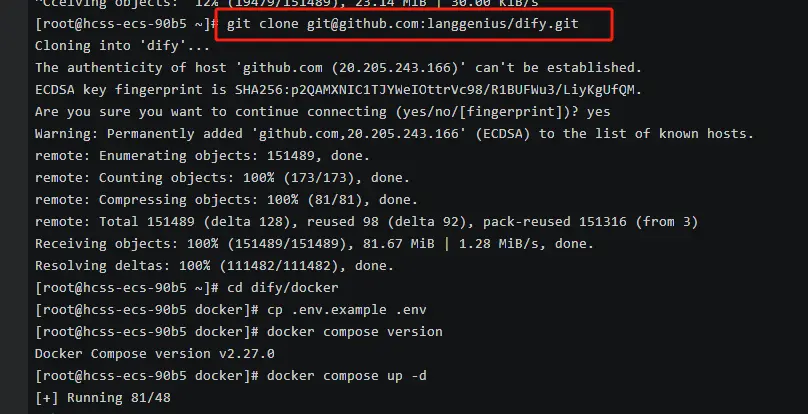

克隆 Dify 源代码至本地环境。

bash

git clone https://github.com/langgenius/dify.git

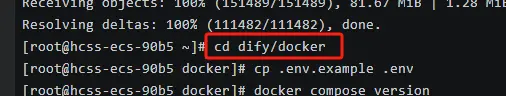

进入 Dify 源代码的 Docker 目录

bash

cd dify/docker

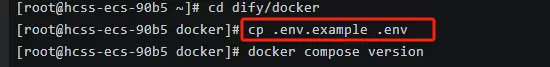

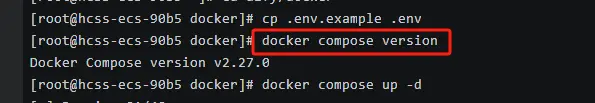

复制配置文件

bash

cp .env.example .env

启动Docker容器

根据你系统上的 Docker Compose 版本,选择合适的命令来启动容器。

你可以通过 docker compose version 命令检查版本

如果版本是 Docker Compose V2,使用以下命令

docker compose up -d如果版本是 Docker Compose V1,使用以下命令:

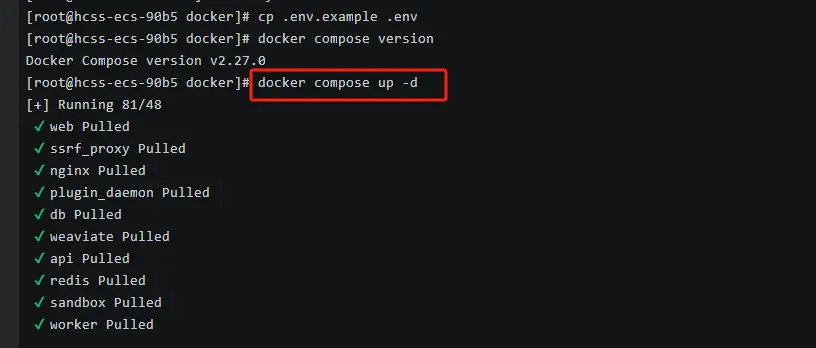

docker-compose up -d运行命令后,你应该会看到类似以下的输出,

显示所有容器的状态和端口映射:

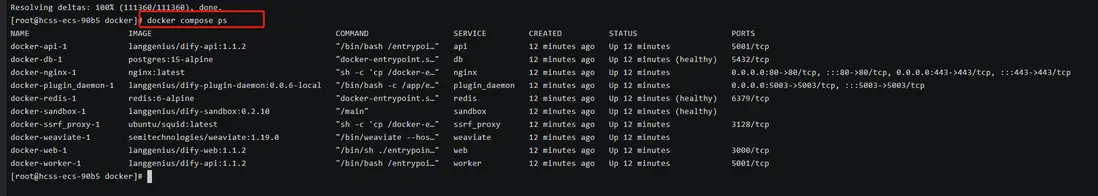

最后检查是否所有容器都正常运行:

在这个输出中,你应该可以看到包括 3 个业务服务

api / worker / web,

以及 6 个基础组件

weaviate / db / redis / nginx / ssrf_proxy / sandbox 。

通过这些步骤,你应该可以成功在本地安装 Dify。

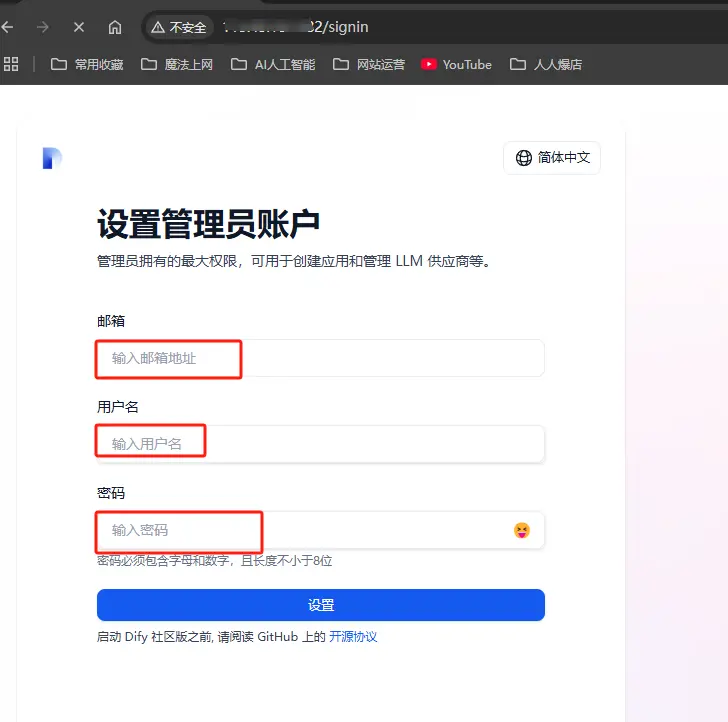

访问Dify

看到上图的运行结果,说明Dify平台已经运行起来了。这时候,我们就可以在浏览器里访问它了。先前往管理员初始化页面设置设置管理员账户。

如果是在本地电脑上安装的,我们可以访问网址http://localhost/install或http://127.0.0.1/install

如果是在服务器上安装的,就需要访问http://your_server_ip/install

这时候,我们会看到这样的一个页面

按照要求,填写好邮箱、用户名和密码后就可以访问了

登录之后,会看到Dify的管理界面

体验云端Dify

上面介绍的方法是通过开源程序在服务器上自行部署使用。

如果我们只是想体验一下Dify平台的功能,并不想自己部署的话,也可以直接访问Dify的官网。

官网地址是: dify.ai

点击【开始使用】后,会要求我们登录

选择自己喜欢的登录方式后,完成登录,就可以进入到自己的管理界面

我们会发现,通过这种方式访问的Dify,与自己部署的系统,看起来一样。那为什么还要自己部署呢?

自己部署有很多优点,但这并不是今天讨论的重点。

我只说一个方面,相信可以打败90%的云端支持者的观点。

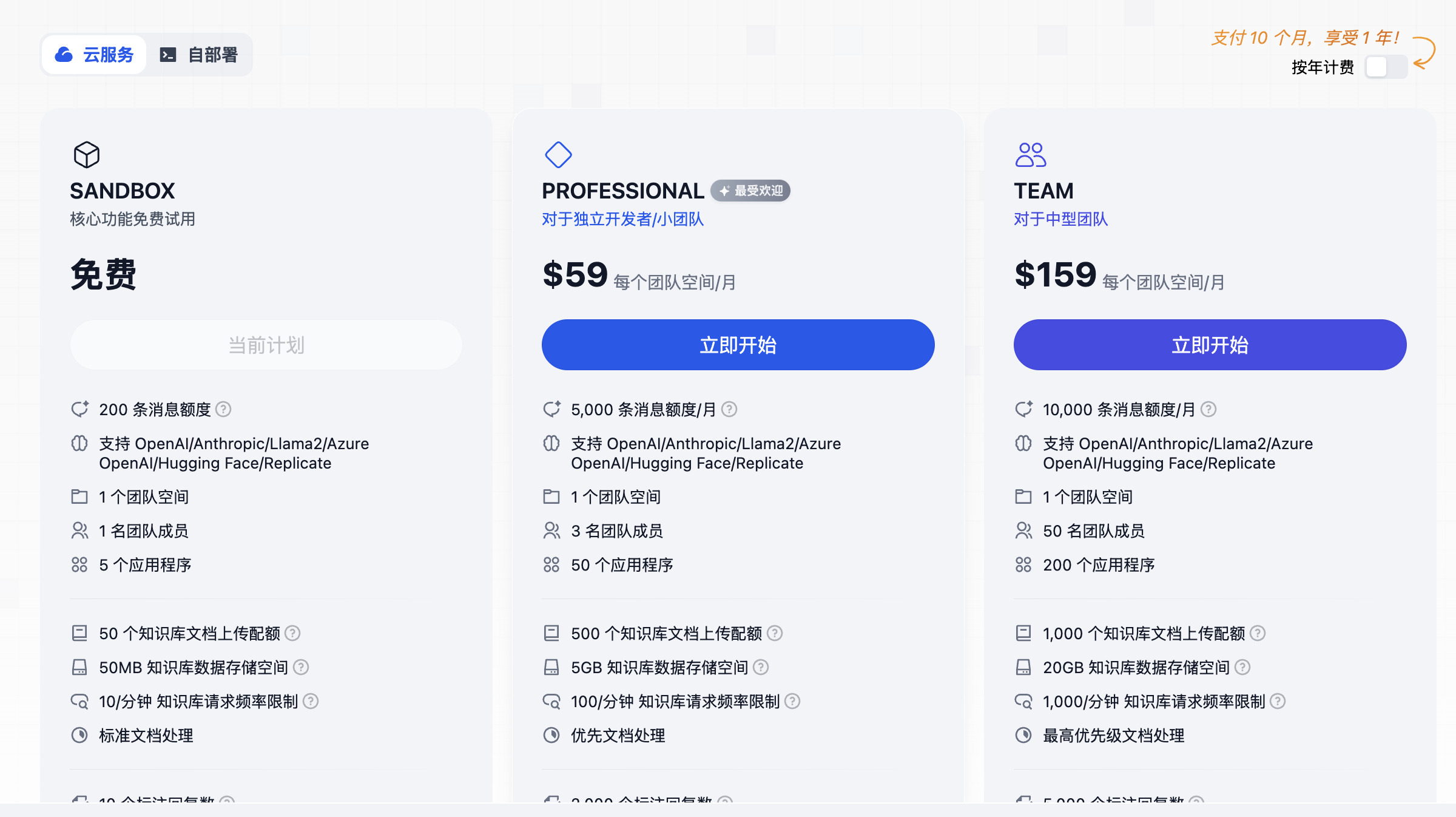

因为本地部署,是免费方案。而使用官方的云端服务,是收费的。

通过上图可以发现,云端服务的限制很多。如果不愿意付费使用,可能也就只适合个人体验学习了。

Dify初步认识

经过上文的介绍,我们都已经访问Dify平台了。接下来就是通过Dify来解决我们的具体问题了。

在具体使用之前,我们有必要先了解下Dify平台的各个功能版块,知道这些板块大致是做什么的。

首先看下顶部,共有4个模块

探索

探索模块是用户快速了解和体验 Dify 能力的入口,提供预构建的 AI 应用模板和案例,帮助用户快速启动项目。用户可通过模板学习最佳实践,或直接复用模板进行二次开发。

这个版块与Coze中的商城和模板版块类似,都是给出已经配置好的可以直接使用的应用模板,如果我们感兴趣,可以直接选择加入到自己的工作区中。

通过这种方式,可以让我们以最快的速度拥有一个AI应用。

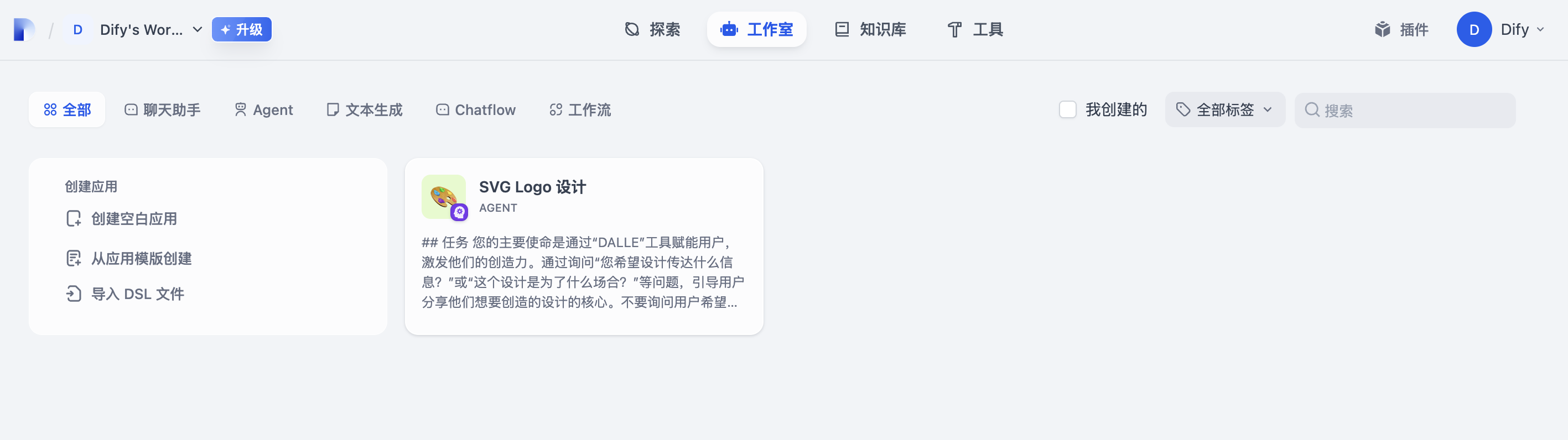

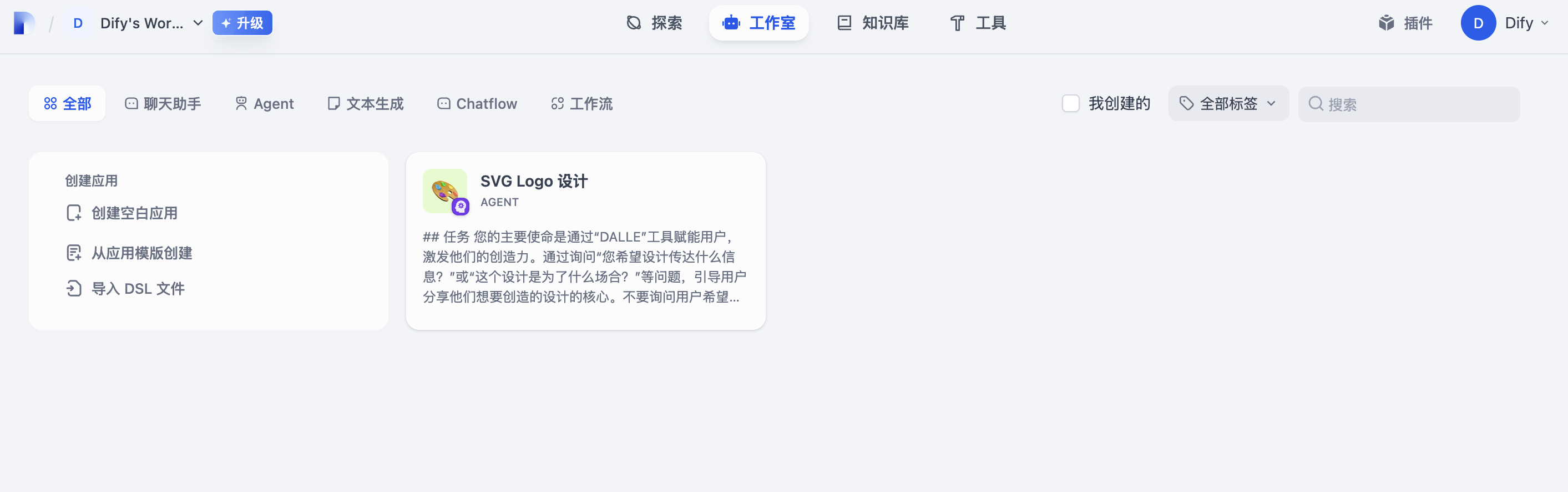

工作室

工作室是 AI 应用的核心开发环境,提供低代码界面用于定义应用逻辑、编排工作流、配置模型及调试功能。

作用等同于Coze平台中的工作空间。我们所创建的所有应用,都会放置在工作室中。

可以说,使用Dify,核心区域就是这里。通过这个版块,我们能够做到以下这些操作

应用编排

通过可视化界面编写提示词(Prompt),支持动态变量插入和上下文配置。

工作流构建

拖拽式编排 AI 组件(如模型调用、条件分支、工具调用),实现复杂任务自动化(如多模型协同处理票据识别)。

模型管理

Dify支持 OpenAI、Llama3、DeepSeek 等数百种模型,可灵活切换推理模型和 Embedding 模型。

调试与发布

在界面右侧直接测试应用效果,查看中间步骤(如知识库召回内容);也可以生成应用 API 密钥,支持嵌入网站或接入业务系统。

知识库

知识库模块用于构建和管理私有化知识数据,通过 RAG(检索增强生成)技术将外部知识整合到 AI 应用中,提升生成内容的准确性和专业性。

知识库中,支持上传多种格式文档(PDF、Markdown、PPT 等),支持自动分段和语义索引,优化检索效率。

系统会自动提取文本、清洗数据,并生成向量化索引。并将这些向量化的数据提供给系统。

这样,系统回答我们的问题时,能够做到混合检索(全文+语义)、多路召回、重排序模型选择,提升知识匹配精度。

知识库可以与聊天助手、工作流等模块绑定,实现基于企业数据的智能问答(如课程查询、合同风险分析)。

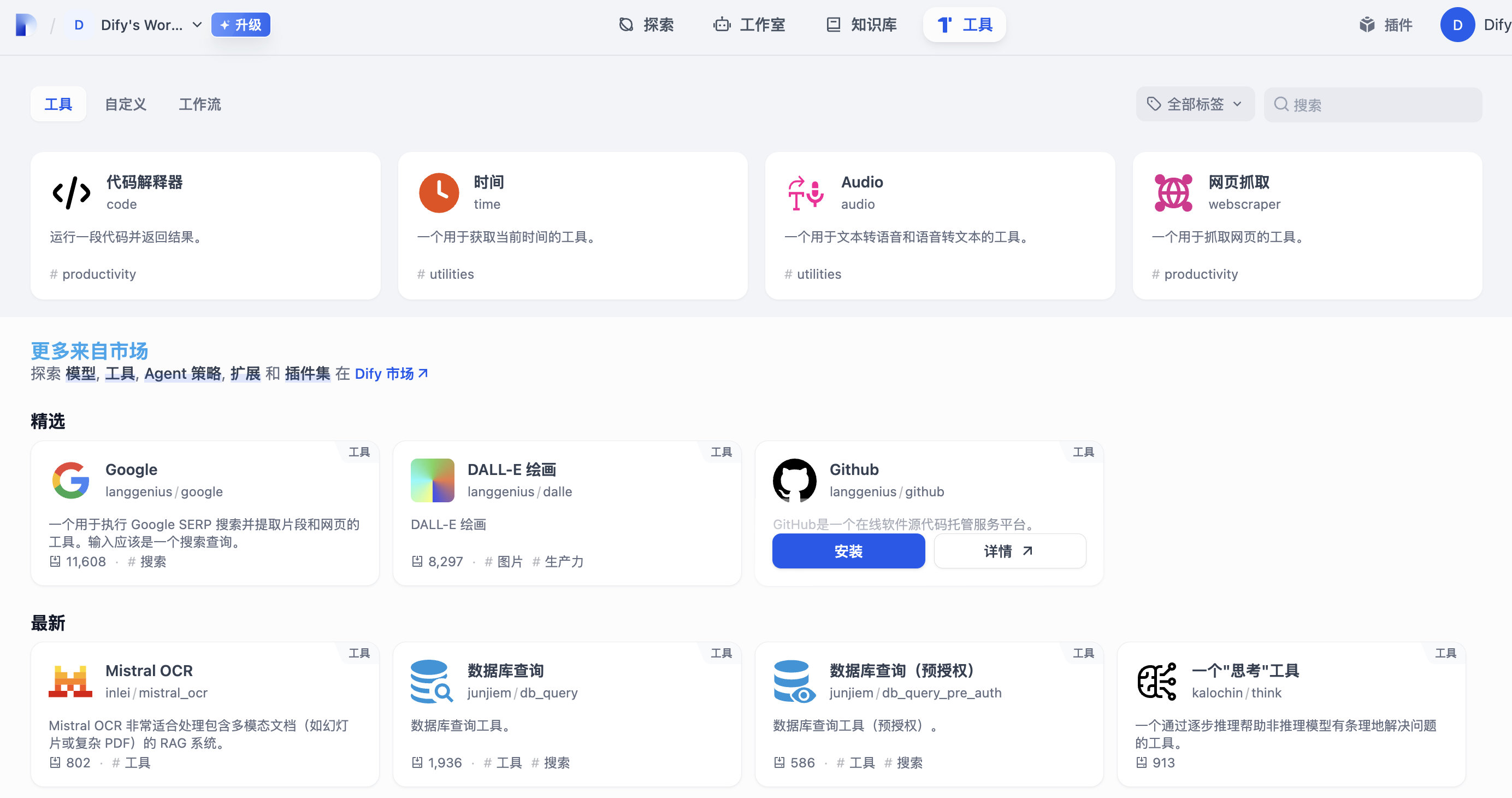

工具

工具模块提供内置及第三方工具集成能力,扩展 AI 应用的功能边界,支持调用外部 API、执行代码或访问互联网资源。

工具版块中内置了很多插件,如 Google 搜索、Stable Diffusion 图像生成、WolframAlpha 计算等,通过配置 API 密钥即可启用,甚至还支持代码执行、文件读写等本地操作(需权限配置)。

我们也可以自己开发接口,通过 Swagger 或 ChatGPT Plugin 规范接入第三方 API。

这些工具可以嵌入工作流,实现多工具协同,如先搜索再生成摘要,然后把内容展示出来。

具体操作Dify

现在,我们已经对Dify有了一个初步的认识。

Dify的操作,总结起来,就是在工作室中,将知识库和工具进行搭配整合,实现出一个具体的应用。这个应用有很多种表现形式。

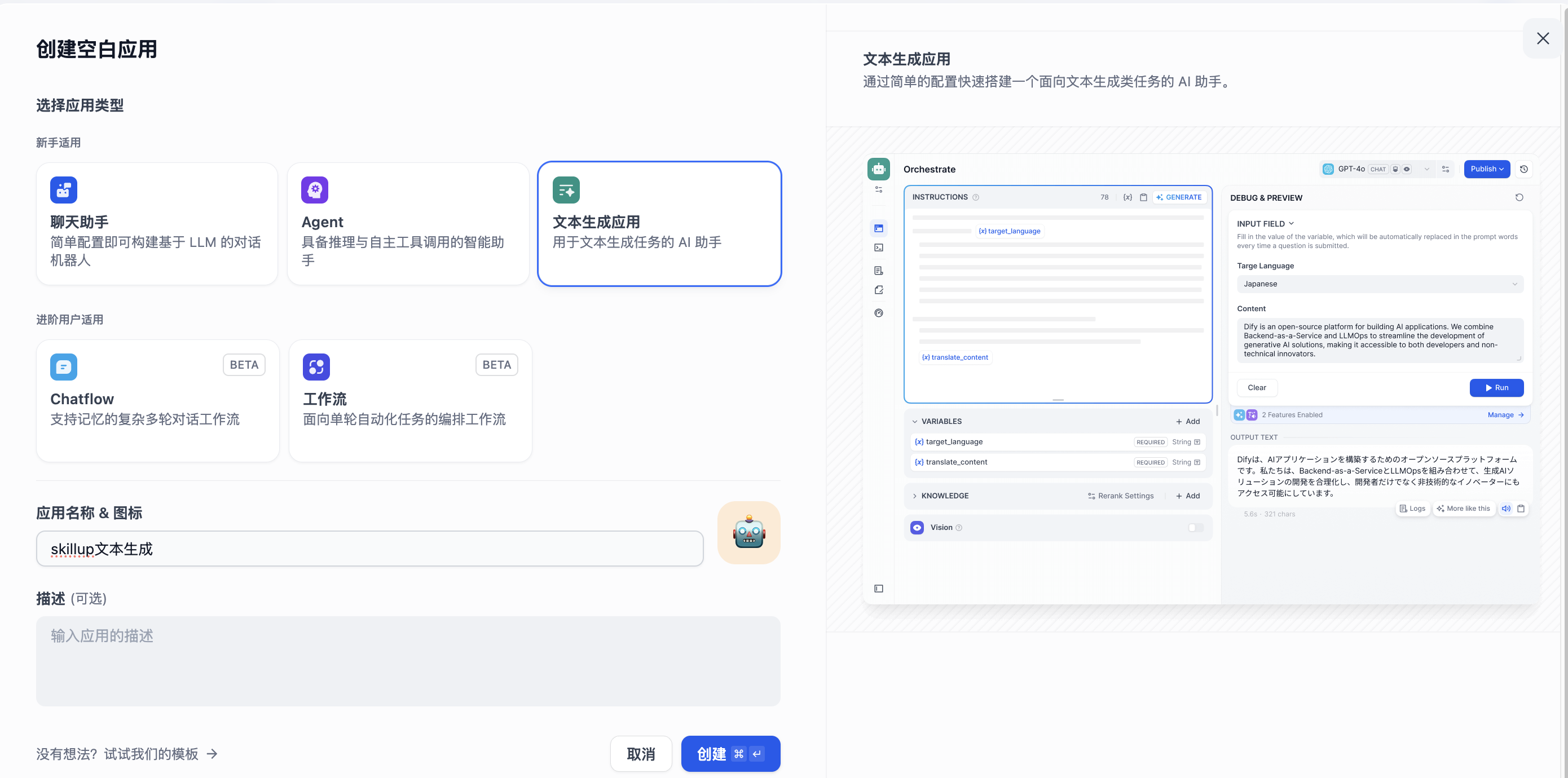

根据官方的分类,大致可分成聊天助手、Agent、文本生成、Chatflow和工作流。

但是要想实现这些应用并真正运行起来,我们还需要做一点准备工作。

前提条件

我们都知道,不论是ChatGPT,Kimi还是DeepSeek,这些大模型产品能够工作,背后都是有一个模型在支持。

Dify要想正常使用,前提就是需要我们选用并设置这些大模型产品。

设置模型

在右上方用户名的下拉框中,选择【设置】

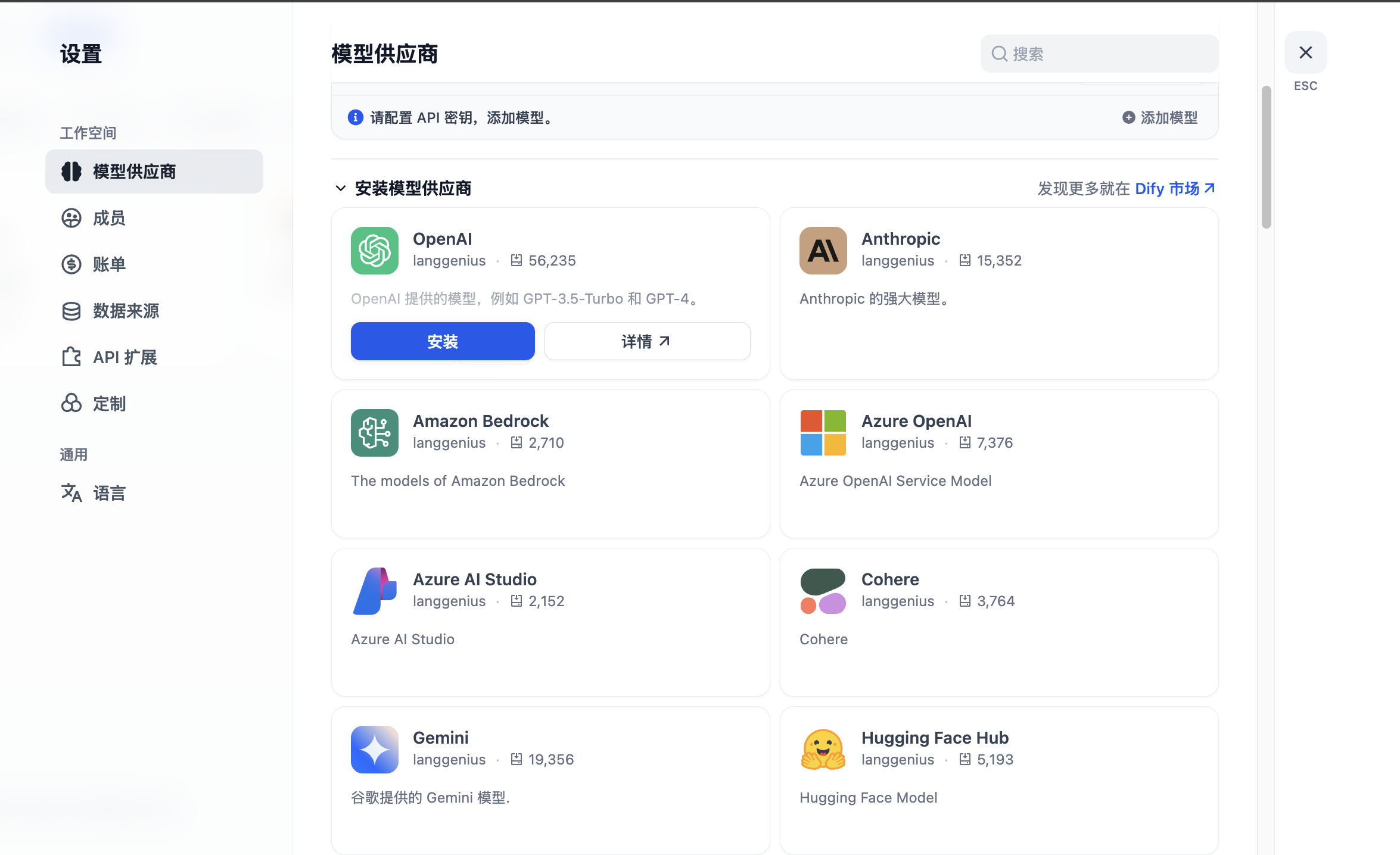

在模型供应商版块中选择我们的钟意的大模型产品

这里基本上涵盖了当前市面上所有主流的大模型。不论是国内的还是国外的,这里都可以找到。

目前智谱、通义千问、讯飞、零一、硅基流动都可以薅羊毛。

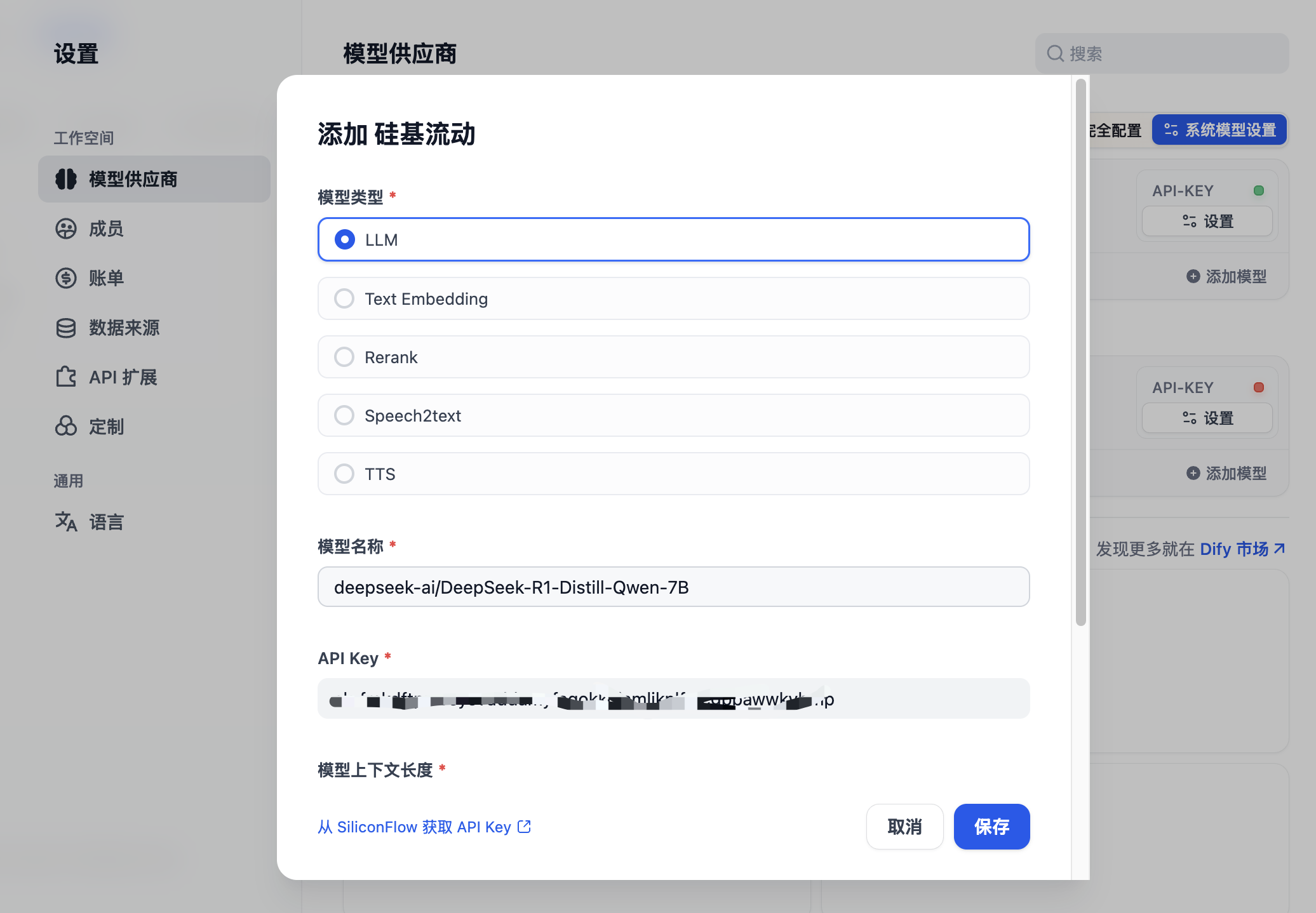

选择安装完成后,需要对所选模型进行设置。下面,我以硅基流动为例,进行设置

点击设置后,会要求我们设置API Key。具体的申请方法可以在网上搜索,也可以看我之前的文章,很容易找到方法。

点击添加模型,主要填写的内容是模型名称和API Key。模型名称可以到

模型选择好了后,还有一项事情需要我们提前完成,那就是知识库的创建。

知识库

通过上文的介绍,我们其实已经知道,Dify中的各项操作,主要是基于大模型来进行。但是AI的知识储备有可能并不能满足我们的要求,尤其是比较专业,或者是更加个性化的场景下。为了应对这样的情况,通常的做法是我们自己维护内容,也就是知识库。

所以,在使用Dify之前,我们还需要维护自己的知识库。

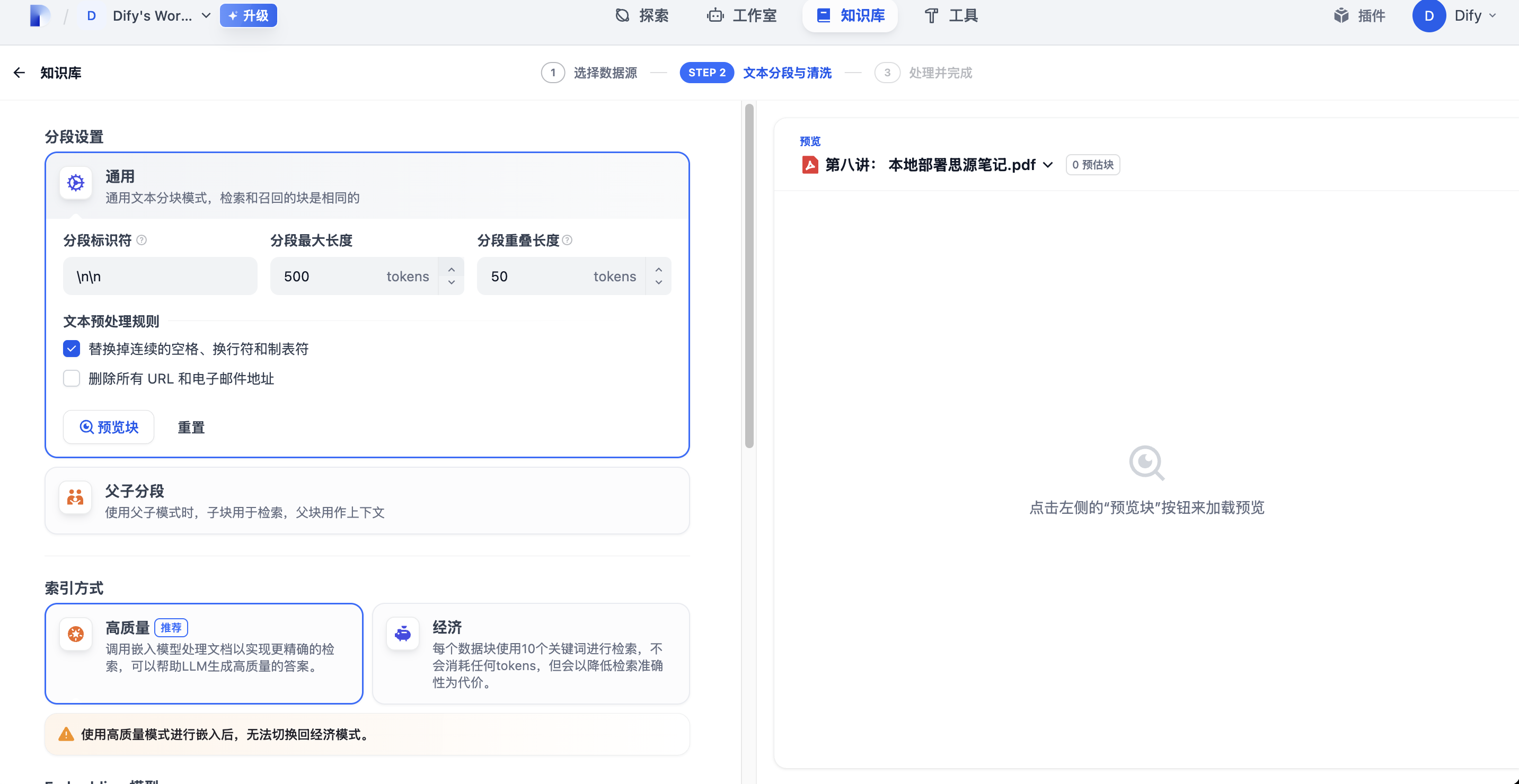

知识库的场景非常简单。可以导入已有的文本,也可以从Notion或者其他Web站点中同步已有内容。

最简单的方法当然还是导入已有文本。我们可以将文件拖拽上传进来,就完成了。

导入后,系统还会将上传的内容进行分段,解析,整合等多个处理,最后变成知识库内容。

好了,准备工作完成了。接下来就是具体的实操了。

我们先来试试聊天助手。

聊天助手

Dify官方对聊天助手的定义是: 对话型应用采用一问一答模式与用户持续对话。

可以用在客户服务、在线教育、医疗保健、金融服务等领域。这些应用可以帮助组织提高工作效率、减少人工成本和提供更好的用户体验。

其实我们现在最常用的Kimi,DeepSeek这些,都是对话形式的应用。现在借助于Dify,我们可以自己创建一个了。

而且这个聊天助手,可以通过 RAG 技术将我们提供的文档,将知识库与模型结合,提供精准回答。

所以,这种聊天助手,非常适合用作客服系统,企业内部培训等。

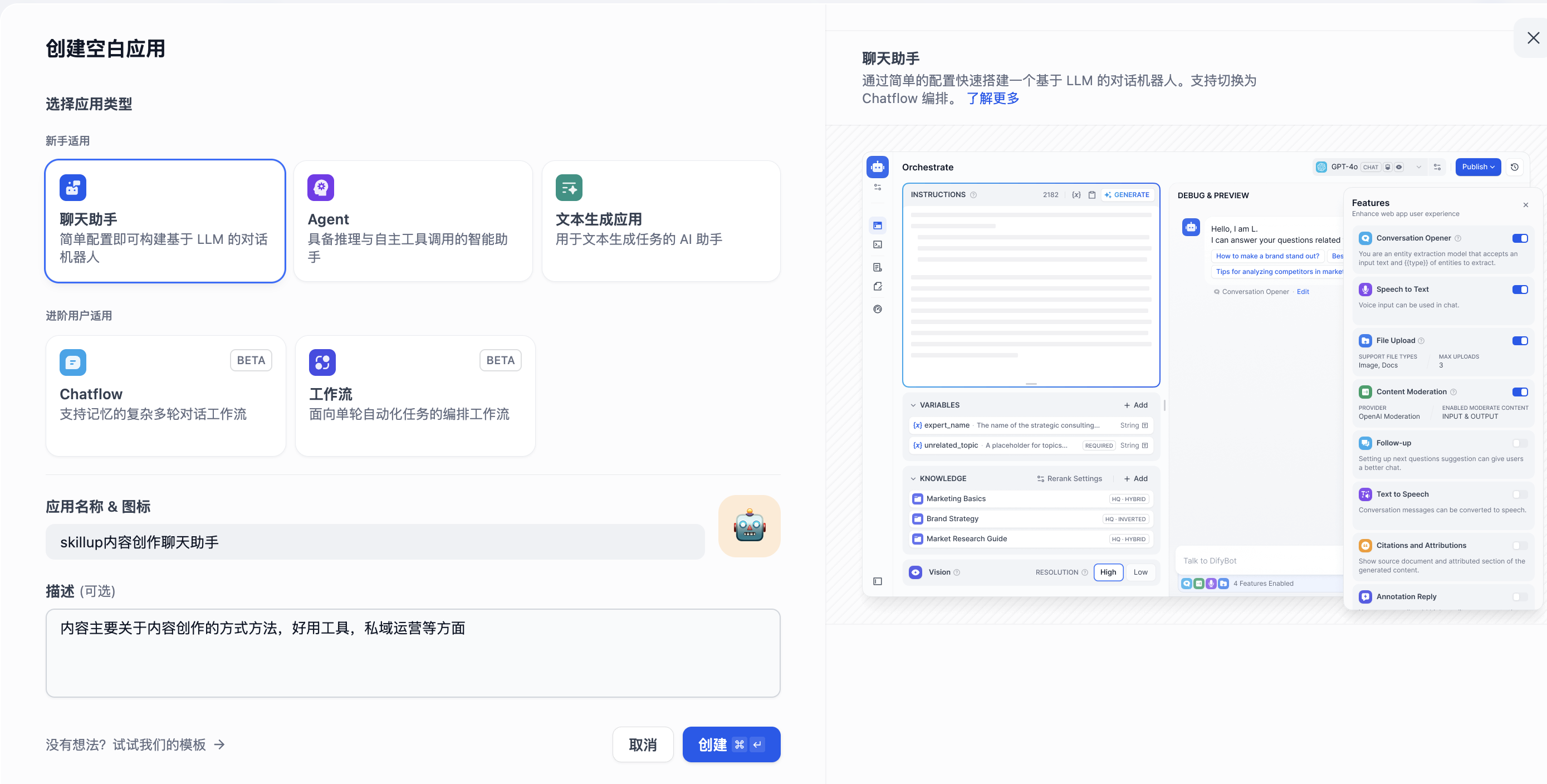

具体的实现方法其实非常简单,在工作室页面中,点击【创建空白应用】,在创建应用页面中选择【聊天助手】

填写名称,图标和描述等相关信息后,点击创建,就可以了

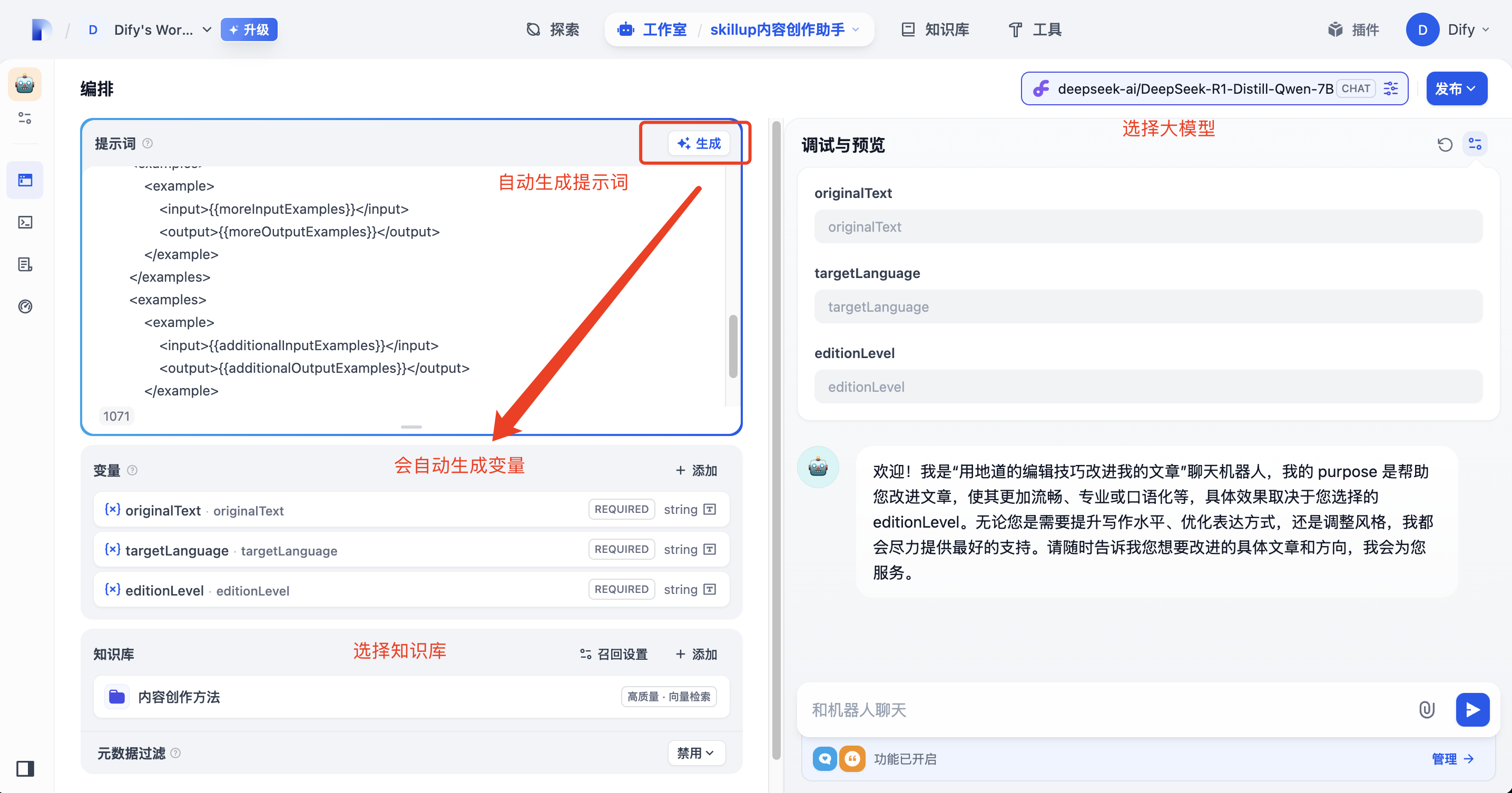

创建完成后,会看到这样的一个页面,要求我们继续编排

编排是指什么,如果你看过我上一篇介绍Coze的文章,对这个词就不会陌生了。

编排是指通过可视化界面或配置文件,将多个 AI 任务、工具、模型和数据流按照一定的逻辑顺序和流程进行连接和组合,形成一个完整的工作流

在这个页面中,根据提示完成提示词、变量、知识库的设置后,在右侧的【调试与预览】中就可以使用了

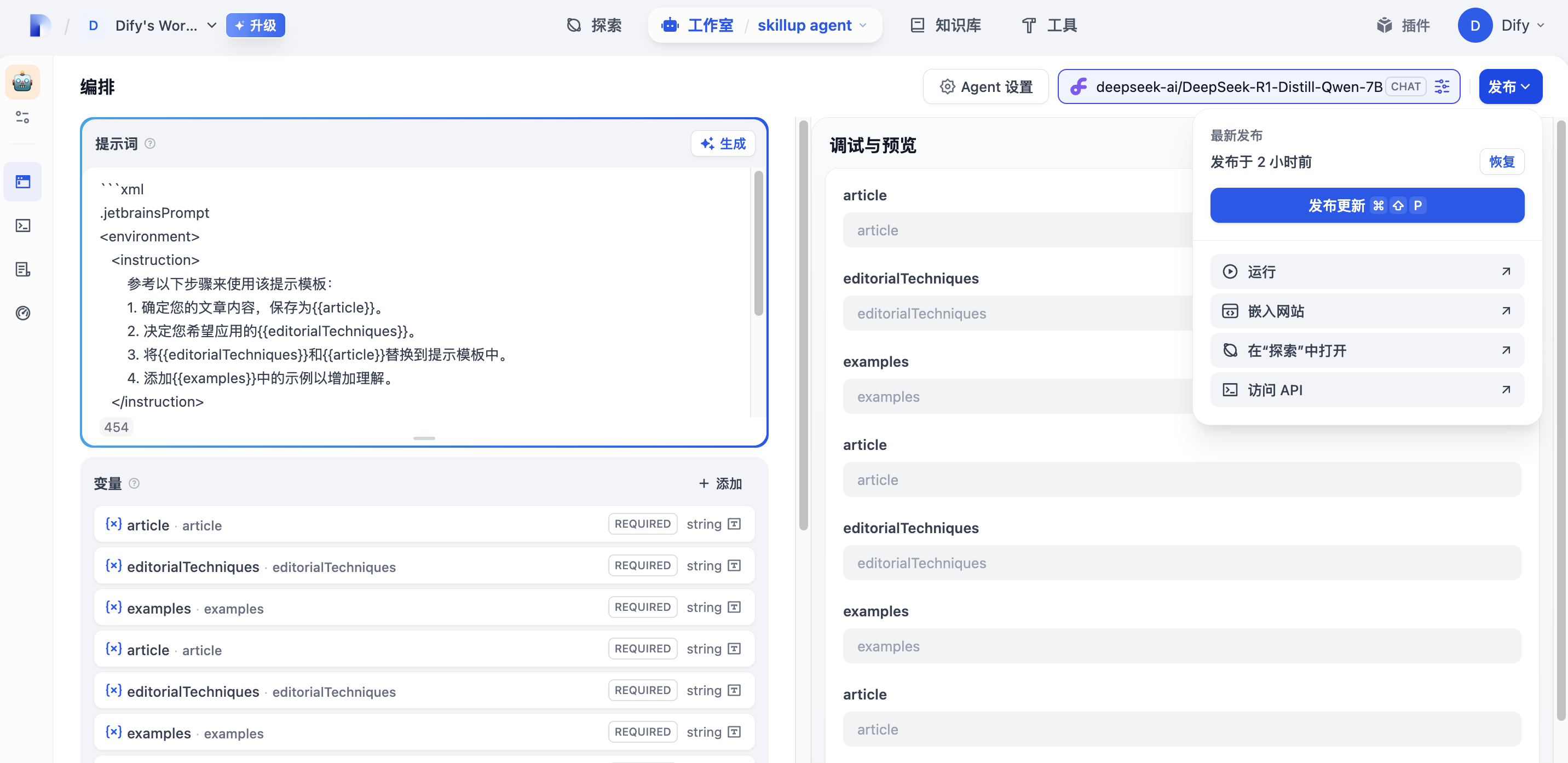

体验过程中,如果对效果不满意,可以修改设置。如果对效果满意了,就可以点击发布。

发布后的聊天助手有多个使用渠道

直接运行:会生成一个Web聊天页面,允许我们在页面中使用

嵌入网站: 会生成一段html代码,允许我们嵌入到自己的应用中使用

在探索中打开: 会被集成到当前Dify页面中的探索版块中

访问API: 会生成API示例,允许我们通过接口的方式接入到自己的其他网站应用中

Agent

Agent也被称作智能体,是一种基于大型语言模型(LLM)的智能代理系统,能够理解用户需求、自主规划任务、调用工具或知识库,最终生成满足需求的回答或执行操作。

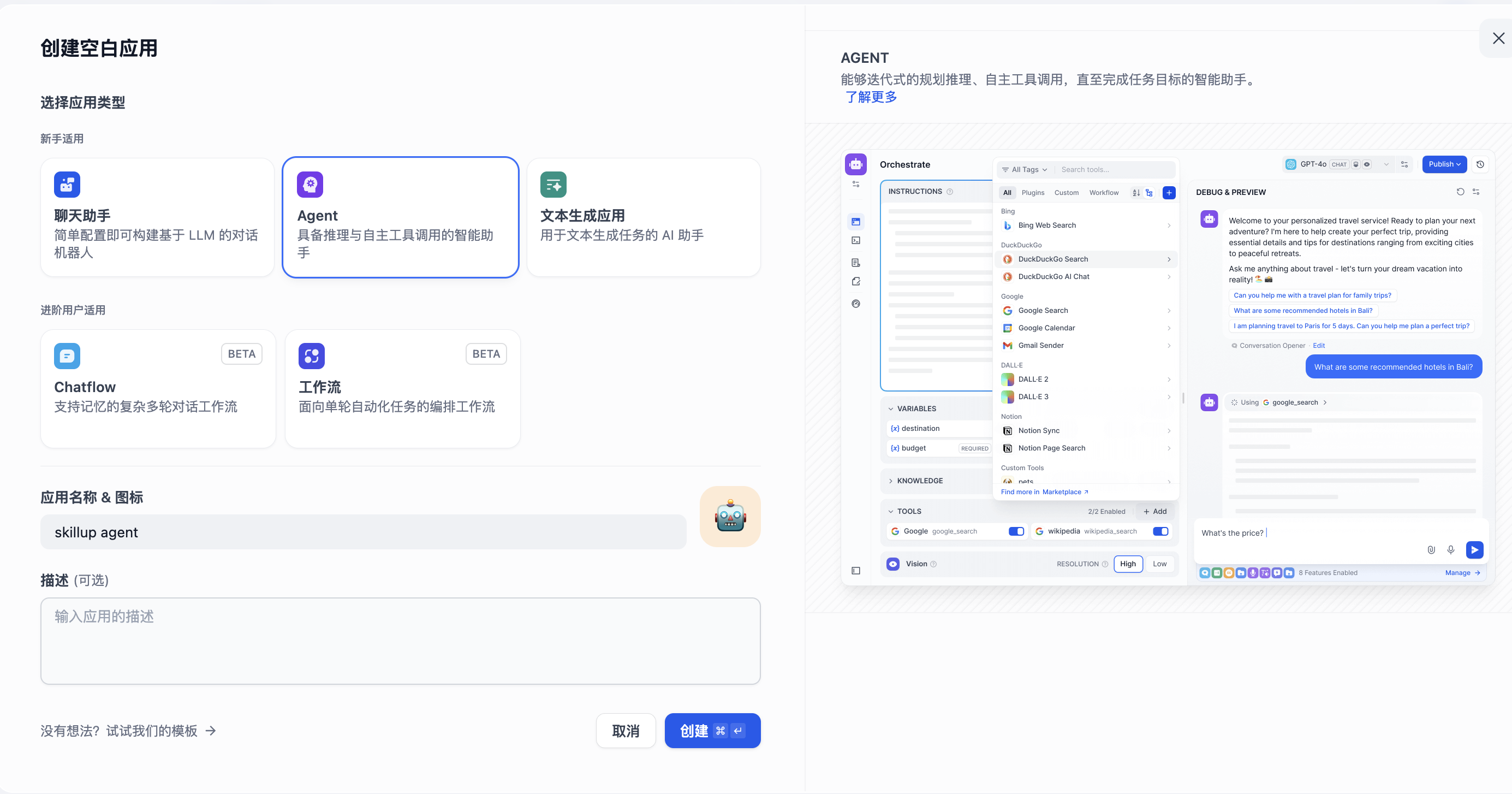

在Dify中创建Agent的方法很简单,就是新建空白应用的时候,选择Agent

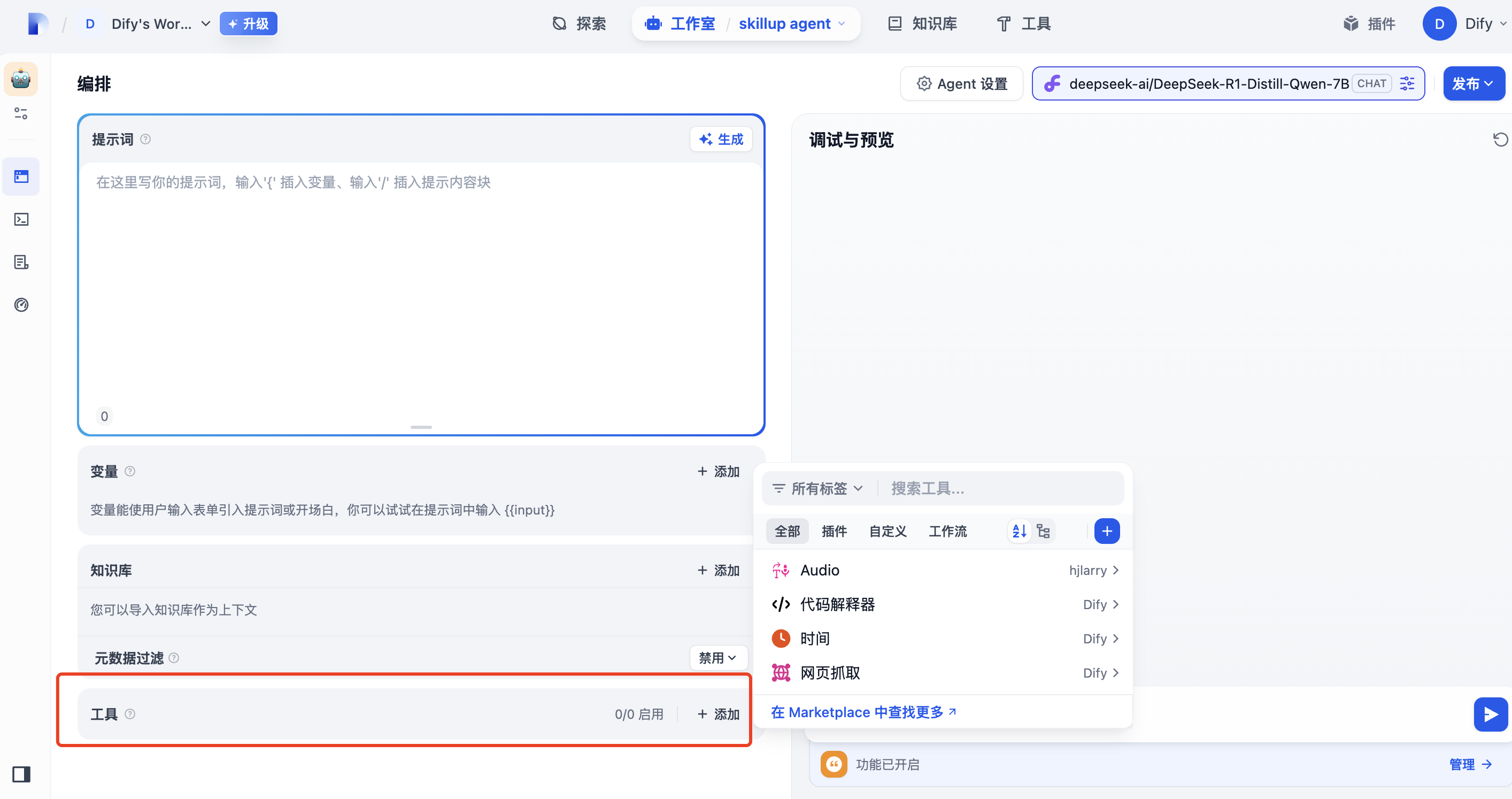

填写必要的名称,图标和介绍后,点击创建后会进入到编排界面

细心的朋友会发现,编排页面整体来说与聊天助手相似,知识多了一个工具版块

点开工具后面的添加按钮,可以看到可以被添加的所有工具

设置完毕后,就可以在右侧的预览与调试中看到智能体效果

剩下的步骤,与聊天助手一致。根据预览效果进行调试,完成后点击发布。

这样,我们就可以拥有一个智能体了

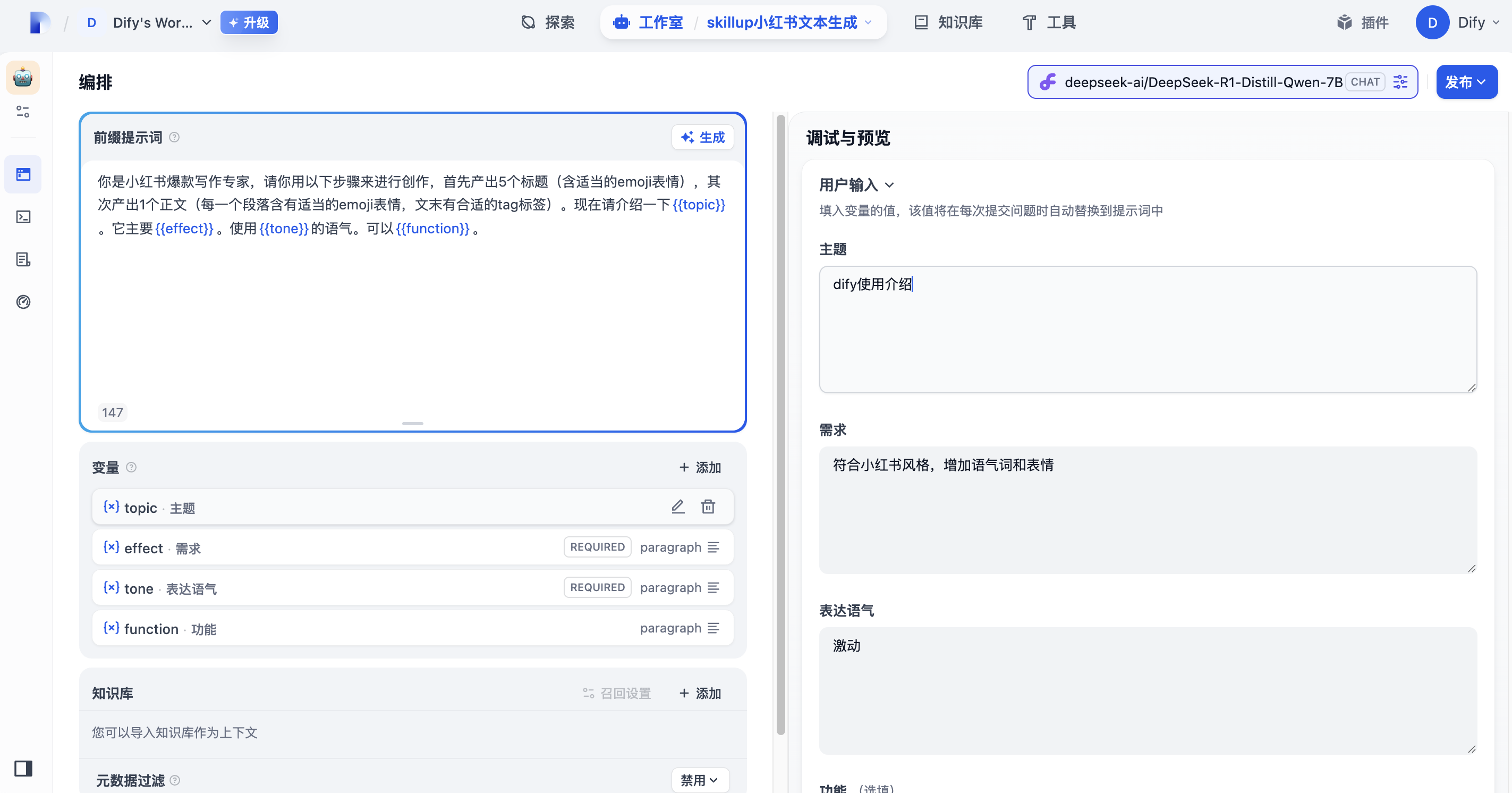

文本生成应用

接下来看看文本生成应用。

Dify 中的文本生成应用是基于大型语言模型(LLM)构建的自动化内容生产工具,能够根据用户输入的提示词(Prompt)和配置的变量,快速生成符合需求的文本内容(如教程、营销文案、报告等)

文本应用对我们这些做自媒体的朋友们来说,是一个非常有帮助的功能。

比如我们可以制作一个文本应用,帮助我们生成公众号文案,生成小红书文案。

创建和维护方法,同上面介绍的聊天助手和Agent一样,就不过多描述了。

体验之后,发现效果还有不少提升空间,就留着以后逐步优化调整了。

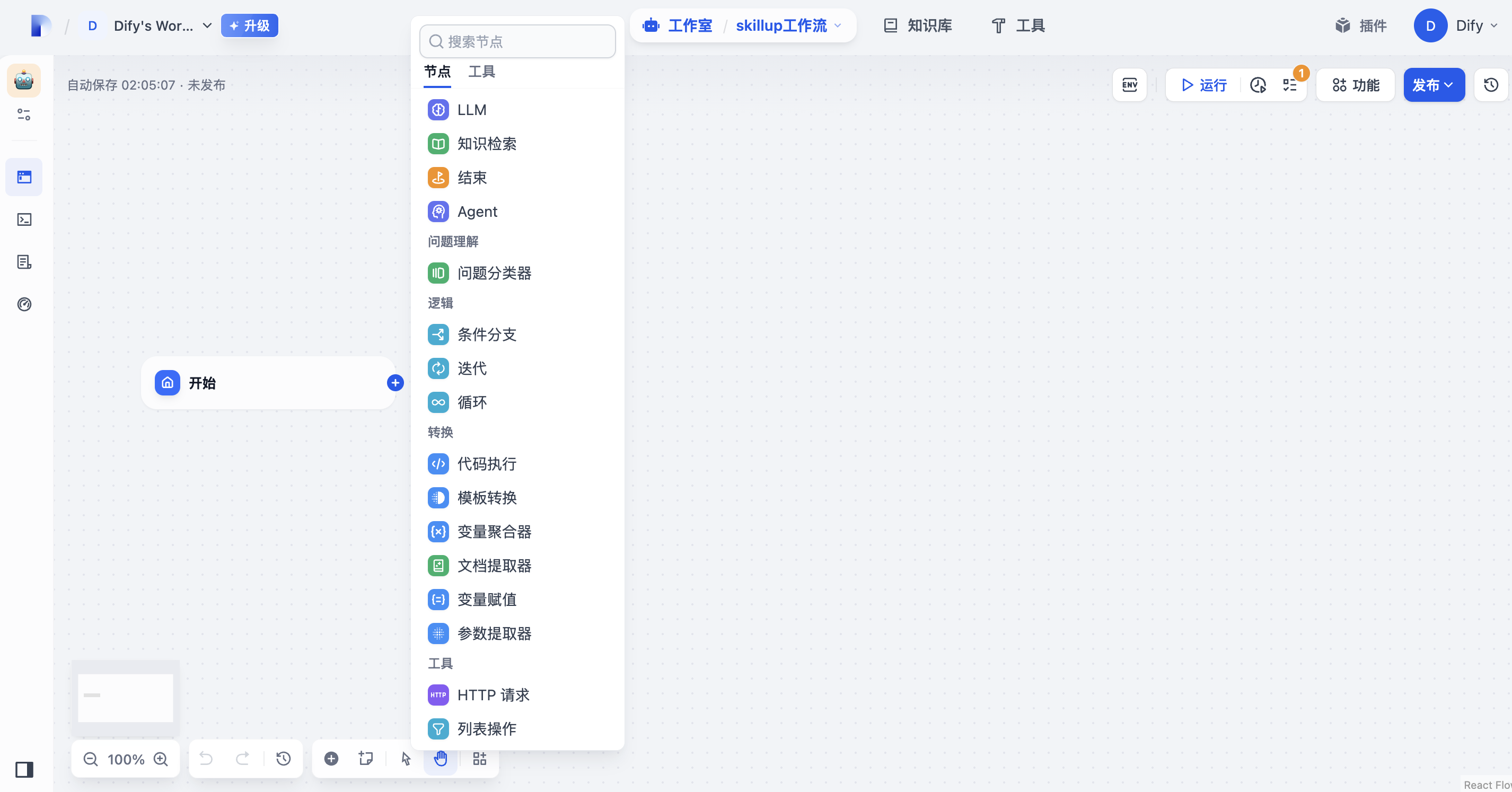

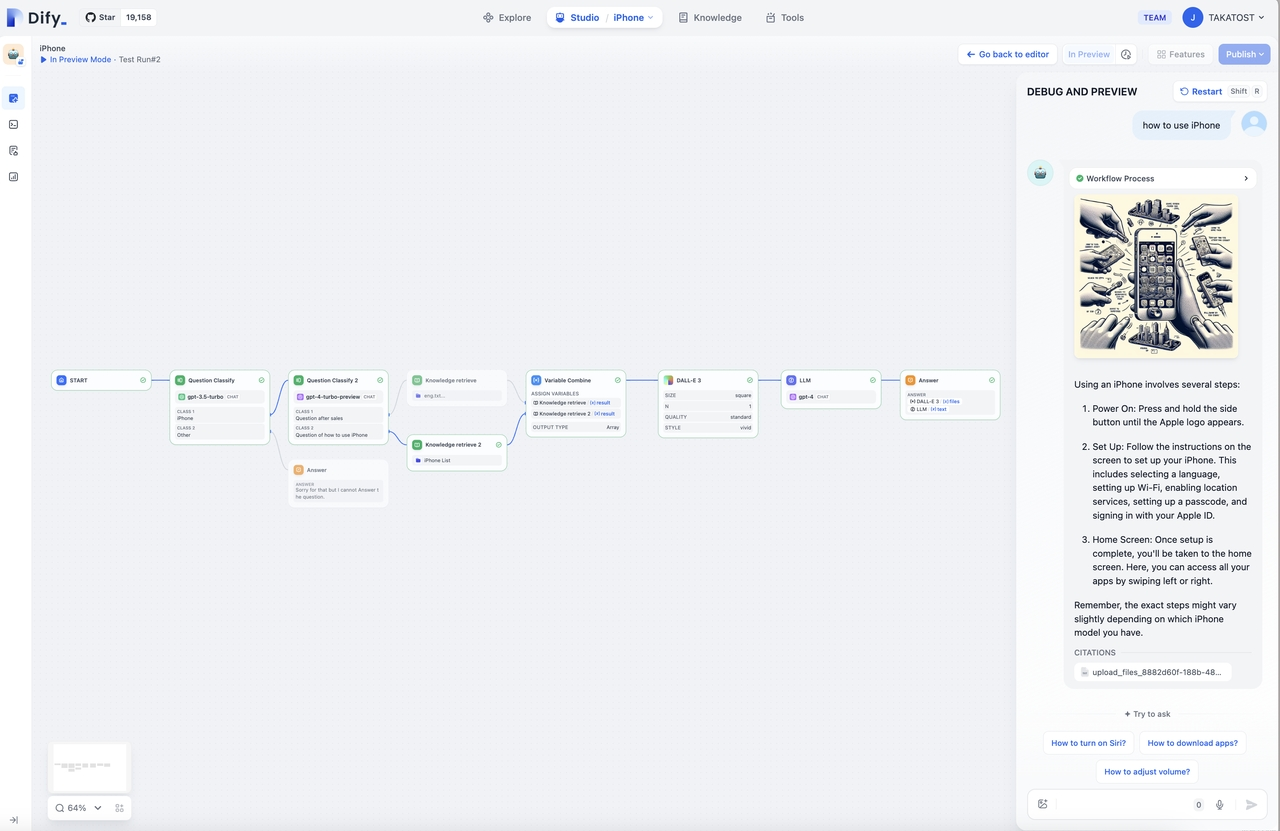

工作流

工作流通过将复杂的任务分解成较小的步骤(节点)降低系统复杂度,减少了对提示词技术和模型推理能力的依赖,提高了 LLM 应用面向复杂任务的性能,提升了系统的可解释性、稳定性和容错性。

工作流分为两种类型:

Chatflow:面向对话类情景,包括客户服务、语义搜索、以及其他需要在构建响应时进行多步逻辑的对话式应用程序。

Workflow:面向自动化和批处理情景,适合高质量翻译、数据分析、内容生成、电子邮件自动化等应用程序。

同Coze平台的工作流方法相似,我们创建好工作流后,可以进行各个节点的编辑处理,将各个工具组合起来使用,从而达到能欧处理复杂任务的目的。

经过各种组合设置之后的工作流,大致是这样的

快捷创建应用的方法

以上介绍的方法,都是我们建立一个空白应用,然后一点一点去设置。

这种方法其实对我们是有一定的使用要求的,每一个节点、每一个环节都需要设计。

其实也有相对容易的方法,就是复制模版,在模板中进行编辑修改,从而快速得到一个智能体应用。

通过创建应用的入口,可以看到创建方法。除了第一种完全需要我们去设置,其他两种方式本质上都差不多,都是借助已有的应用,快速复制。

下面,我就简单的演示一下通过模板创建的方法

在模板页面中,可以通过分类进行筛选,在卡片中可以通过标题和简介对其有所了解。如果对哪个感兴趣,可以点击【使用该模板】,将其保存到自己的工作空间中。

然后进行编辑调整,最终发布使用。

结语

本文简单的介绍了Dify平台以及相关使用方法。

通过文章的介绍,大家可以对其有一个大致的了解。

但是不同于平时常用的那些对话形应用,如Kimi,DeepSeek这些,Dify和Coze这些平台允许我们将不同的大模型组合起来解决更复杂的任务。

也给我们提供了通过API或者嵌入自己网站的可行性方案。

对于没有实力自研大模型产品又希望使用AI来增强产品能力的企业和个人来说,Dify是一个非常值得尝试的方案。

本文只是一个简单的案例说明,实际上我们通过学习这个方法,并且加以创新和应用,完全有可能做到非常有竞争性的产品。

前一段时间里爆火的Manus,给我们展示了终极AGI的产品形态。其实借助于Dify这些平台的技术储备,我们也很有可能自己实现同类的项目。

可以说当下,所有与互联网相关的人和企业,甚至用户,都在争分夺秒的学习使用AI,对其感兴趣又在不断上进的我们,怎么能错过这个机会,大家一起加油💪

今天的分享就到这里,非常欢迎大家的意见和交流。

感谢大家的观看。